0より速い! Meta は、AlphaFold2 を粉砕するために 150 億のパラメーターを備えた大規模なタンパク質モデルを発表しました

これまでで最大のタンパク質言語モデルがリリースされました!

1 年前、DeepMind のオープンソース AlphaFold2 が Nature and Science に掲載され、生物学と AI の学界を圧倒しました。

1 年後、Meta には桁違いに高速な ESMFold が登場しました。

速いだけでなく、モデルには 150 億のパラメーターもあります。

LeCun 氏は、これを Meta-FAIR プロテインチームによる素晴らしい新たな成果として賞賛するツイートをしました。

共著者の Zeming Lin 氏は、30 億パラメータを持つ大規模モデルは 256 GPU で 3 週間トレーニングされたのに対し、ESMfold は 128 GPU で 10 日間かかったと明らかにしました。 150億パラメータバージョンについてはまだ不明です。

彼はまた、コードは将来必ずオープンソース化される予定であると述べたので、乞うご期待!

大きくて速い!

今日の主役は、個々のタンパク質配列から高精度でエンドツーエンドの原子レベルの構造を直接予測するモデルである ESMFold です。

論文アドレス: https://www.biorxiv.org/content/10.1101/2022.07.20.500902v1

150 億パラメータの利点たとえば、今日の大規模モデルは、原子サイズの精度でタンパク質の三次元構造を予測するようにトレーニングできます。

精度の点では、ESMFold は AlphaFold2 や RoseTTAFold と似ています。

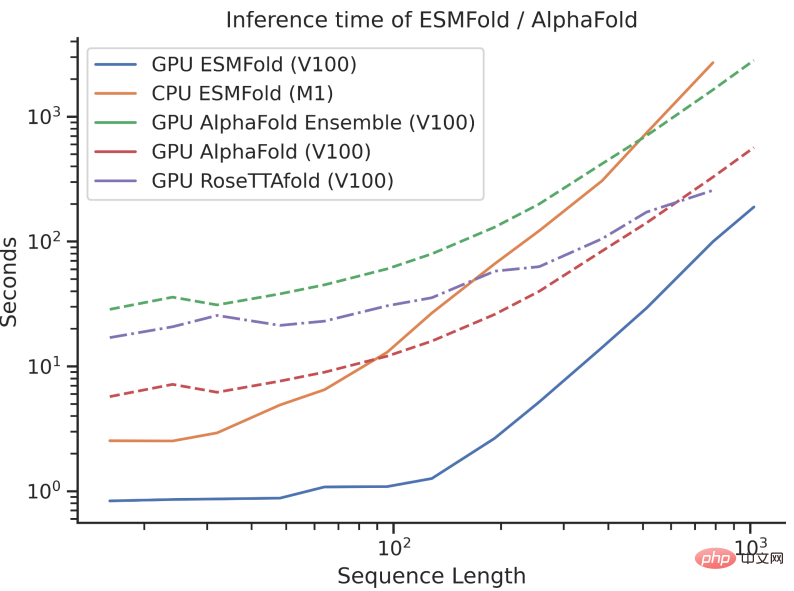

ただし、ESMFold の推論速度は AlphaFold2 よりも桁違いに高速です。

3 つの速度の比較は、桁違いの話で理解するのが難しいかもしれませんが、下の図を見ていただければ理解できます。

違いは何ですか?

AlphaFold2 と RoseTTAFold は原子分解能構造予測の問題において画期的な成功を収めていますが、それらは多重配列アラインメント (MSA) などの使用にも依存しています。最適なパフォーマンスを実現するタンパク質構造テンプレート。

対照的に、ESMFold は言語モデルの内部表現を活用することで、入力として 1 つのシーケンスのみを使用して対応する構造予測を生成できるため、構造予測が大幅に高速化されます。

研究者らは、ESMFold の低複雑性シーケンスの予測が現在の最先端モデルと同等であることを発見しました。

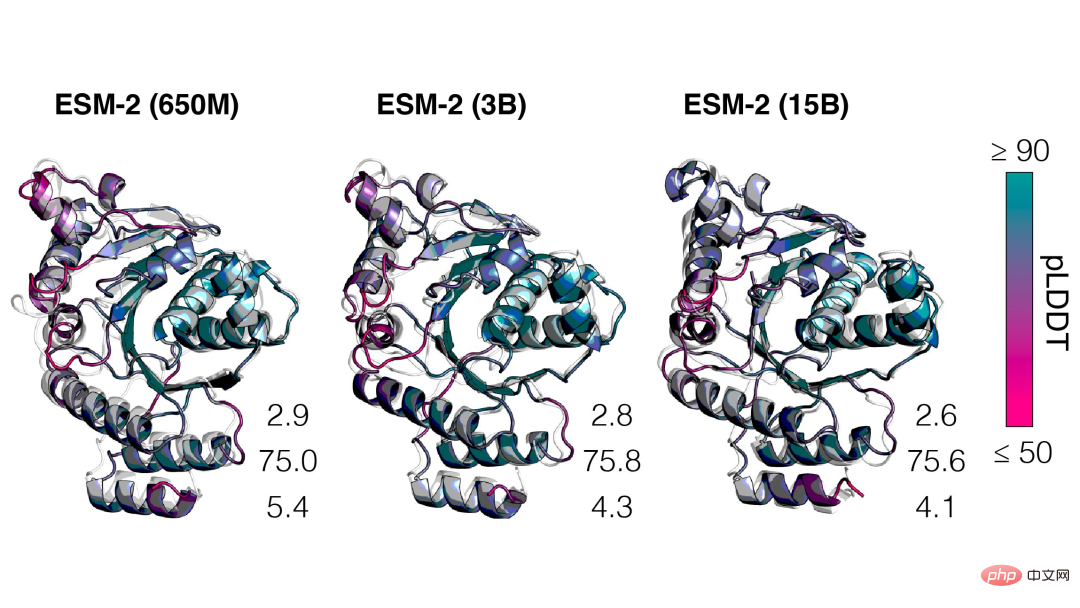

さらに、構造予測の精度は言語モデルの複雑さと密接に関係しており、つまり、言語モデルがシーケンスをよりよく理解できれば、構造もよりよく理解できるようになります。

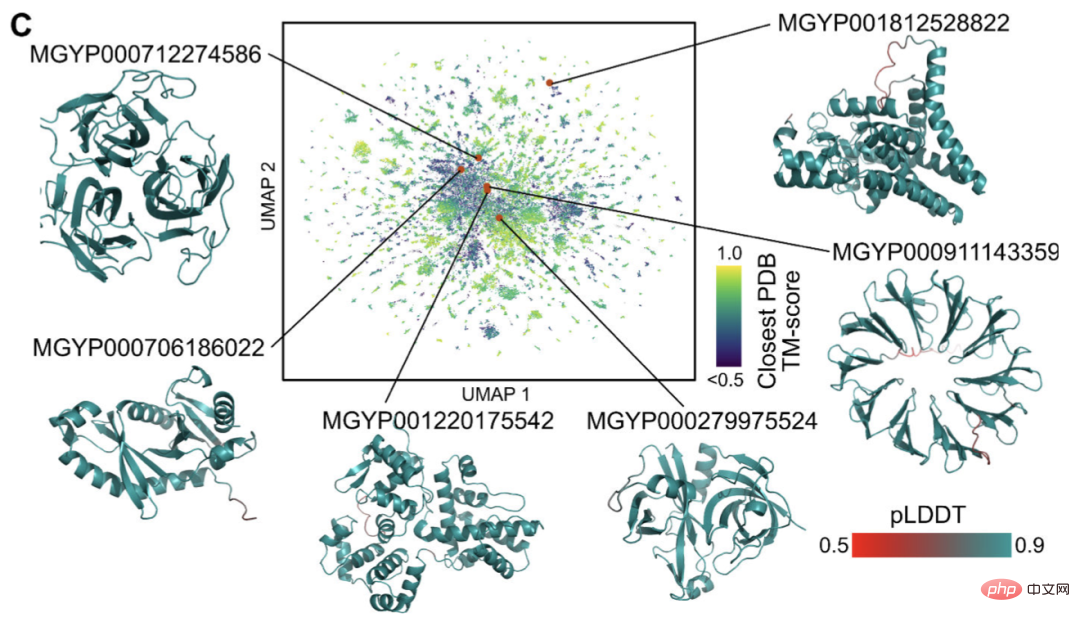

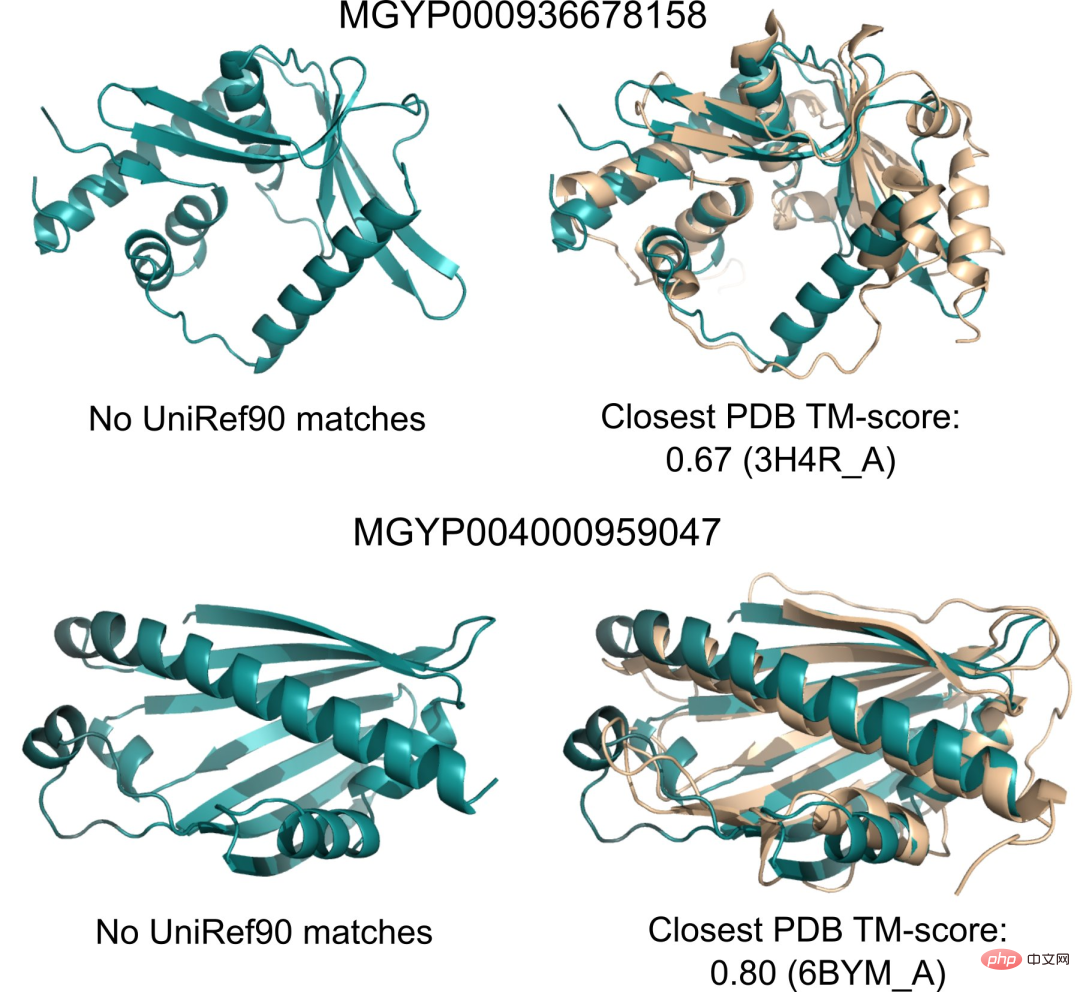

現在、構造や機能が未知のタンパク質配列が数十億存在しており、その多くはメタゲノム配列決定に由来しています。

ESMFold を使用すると、研究者は 100 万個のメタゲノム配列のランダム サンプルをわずか 6 時間でフォールディングできます。

これらの大部分は信頼性が高く、既知の構造とは異なります (データベースに記録がありません)。

研究者らは、ESMFold が現在の理解を超えているタンパク質構造の理解に役立つと信じています。

さらに、ESMFold の予測は既存のモデルよりも桁違いに速いため、研究者は ESMFold を使用して、急速に成長するタンパク質配列データベースを埋め、進歩を遅らせることができます。構造と機能のデータベース。

150 億パラメータのタンパク質言語モデル

次に、Meta の新しい ESMFold について詳しく説明します。

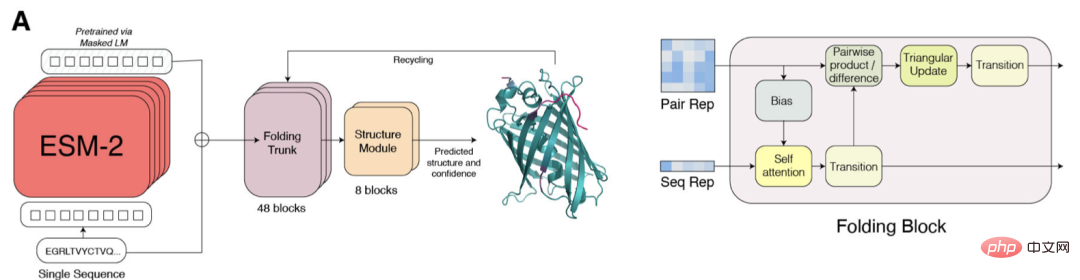

ESM-2 は、Transformer ベースの言語モデルであり、アテンション メカニズムを使用して、入力シーケンス内のアミノ酸のペア間の相互作用パターンを学習します。

前世代モデル ESM-1b と比較して、Meta はモデル構造とトレーニング パラメーターを改善し、コンピューティング リソースとデータを追加しました。同時に、相対位置埋め込みの追加により、モデルを任意の長さのシーケンスに一般化することができます。

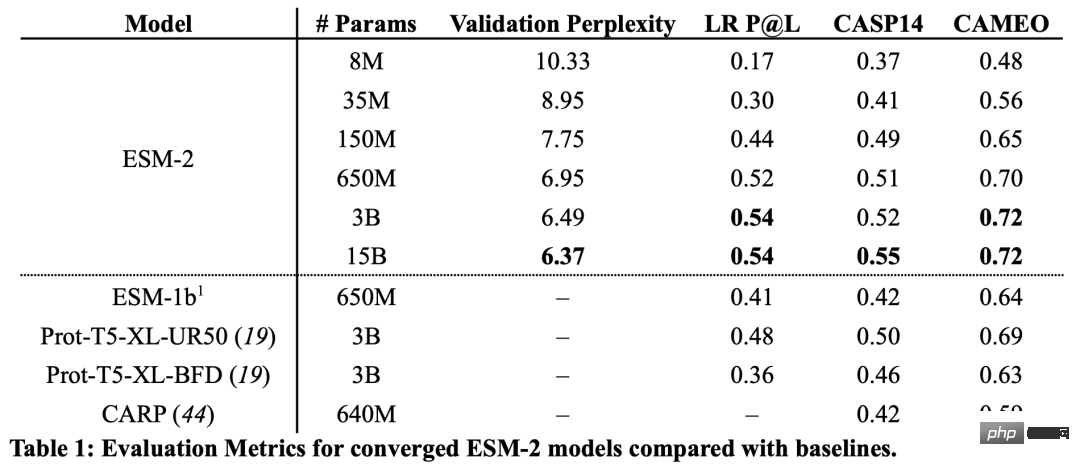

結果から、1 億 5,000 万のパラメータを持つ ESM-2 モデルは、6 億 5,000 万のパラメータを持つ ESM-1b モデルよりも優れたパフォーマンスを示しました。

さらに、ESM-2 は構造予測のベンチマークにおいても他のタンパク質言語モデルを上回っています。このパフォーマンスの向上は、大規模言語モデリング分野で確立されたパターンと一致しています。

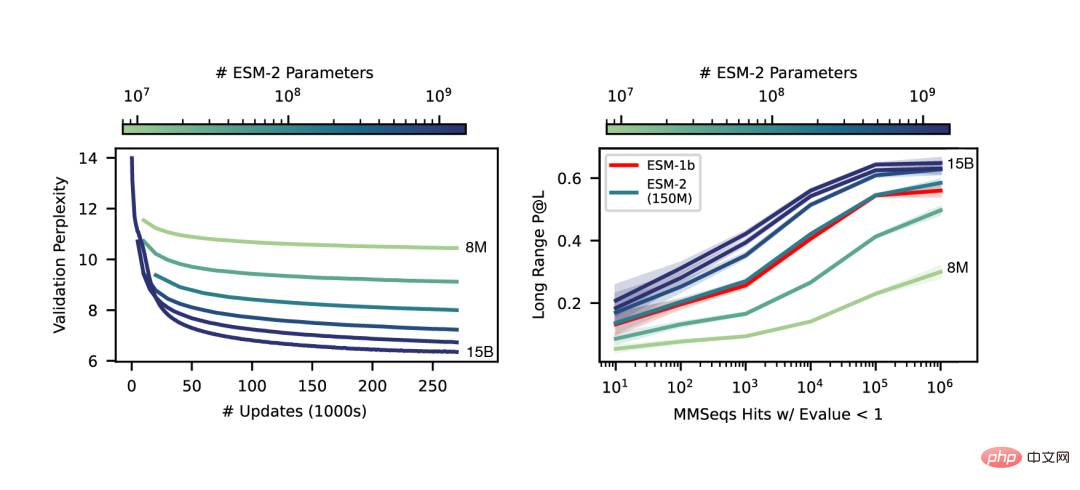

ESM-2 の規模が大きくなるにつれて、言語モデリングの精度が大幅に向上していることがわかります。

エンドツーエンドの単一配列構造予測

SMFold と AlphaFold2 の主な違いは、ESMFold は言語モデル表現を使用するため、明示的な相同性配列 (MSA の形式) が入力として必要です。

ESMFold は、MSA を処理する計算量の多いネットワーク モジュールをシーケンスを処理する Transformer モジュールに置き換えることにより、AlphaFold2 の Evoformer を簡素化します。この単純化は、ESMFold が MSA ベースのモデルよりも大幅に高速であることを意味します。

折り畳まれたバックボーンの出力は、最終的な原子レベルの構造と予測信頼性を出力する役割を担う構造モジュールによって処理されます。

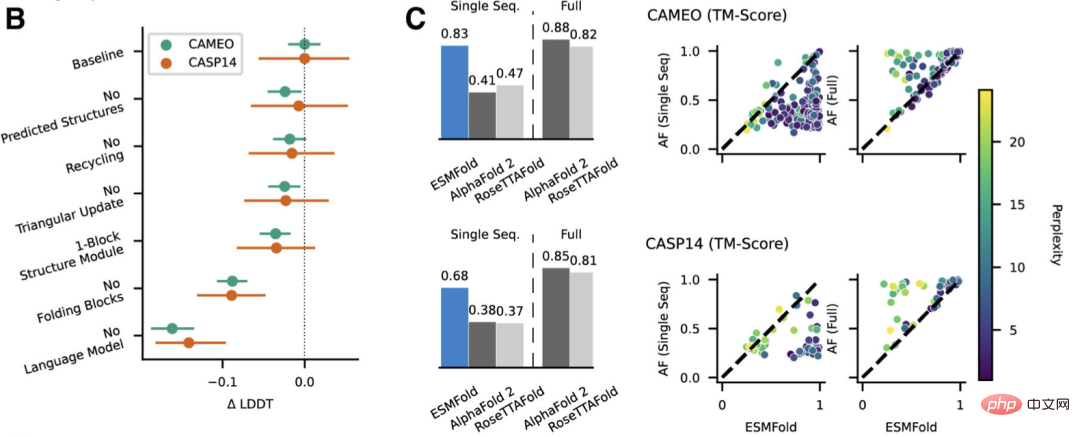

研究者らは、CAMEO (2022 年 4 月から 2022 年 6 月) および CASP14 (2020 年 5 月) のテスト セットで、ESMFold を AlphaFold2 および RoseTTAFold と比較しました。

入力として 1 つのシーケンスのみが与えられた場合、ESMFold は Alphafold 2 よりもはるかに優れたパフォーマンスを発揮します。

完全なパイプラインを使用した場合、AlphaFold2 は CAMEO と CASP14 でそれぞれ 88.3 と 84.7 を達成しました。 ESMFold は、CAMEO 上の RoseTTAfold と同等の精度を達成し、平均 TM スコアは 82.0 です。

結論

研究者らは、教師なし学習を対象とした言語モデルが大規模な学習環境で良好に機能することを発見しました。進化的に多様なタンパク質配列データベースであるため、原子レベルの解像度でタンパク質構造を予測できます。

言語モデルのパラメーターを 15B に拡張することで、タンパク質の構造学習に対するスケールの影響を体系的に研究できます。

私たちは、タンパク質の構造予測の非線形曲線がモデルのサイズの関数であることを確認し、言語モデルが配列をどの程度理解しているかとその構造予測との間に強い関係があることを観察しました。

ESM-2 シリーズのモデルは、これまでにトレーニングされた最大のタンパク質言語モデルであり、最近開発された最大のテキスト モデルよりもパラメーターが 1 桁少ないだけです。

さらに、ESM-2 は以前のモデルに比べて非常に大きな改善が施されており、1 億 5,000 万のパラメータの下でも、ESM-2 は 6 億 5,000 万のパラメータの下で ESM-1 生成言語モデルよりも正確にキャプチャします。

研究者らは、ESMFold のパフォーマンスの最大の要因は言語モデルであると述べています。言語モデルの複雑さと構造予測の精度の間には強い関係があるため、ESM-2 がタンパク質配列をよりよく理解できるようになると、現在の最先端モデルに匹敵する予測を達成できることが判明しました。

ESMFold は正確な原子分解能の構造予測を取得しており、推論時間は AlphaFold2 よりも 1 桁高速です。

実際には、速度の利点はさらに大きくなります。 ESMFold は MSA を構築するために進化的に関連した配列を検索する必要がないためです。

検索時間を短縮するもっと速い方法がありますが、どれだけ短縮しても検索時間が非常に長くなる可能性があります。

推論時間の大幅な短縮によってもたらされる利点は自明です。速度の向上により、大規模なメタゲノミクス配列データベースの構造空間のマッピングが可能になります。

遠位相同性と保存性を特定するための構造ベースのツールに加えて、ESMFold による迅速かつ正確な構造予測も、大規模な新しい配列コレクションの構造および機能解析において重要な役割を果たします。

限られた時間内に何百万もの予測構造を取得することは、天然タンパク質の幅広さと多様性について新たな理解を導き出し、まったく新しいタンパク質構造とタンパク質機能の発見を可能にします。

著者紹介

この記事の共著者は、Meta AI の Zeming Lin です。

彼の個人ホームページによると、Zeming 氏はニューヨーク大学で博士号取得のために学び、Meta AI で研究エンジニア (客員) として働き、主にバックエンドのインフラストラクチャ作業を担当していました。

彼は学士号と修士号の両方をバージニア大学で学び、Yanjun Qi とともに、特にタンパク質の構造予測における機械学習アプリケーションの研究を行いました。

関心のある分野は、深層学習、構造予測、情報生物学です。

以上が0より速い! Meta は、AlphaFold2 を粉砕するために 150 億のパラメーターを備えた大規模なタンパク質モデルを発表しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7491

7491

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

でももしかしたら公園の老人には勝てないかもしれない?パリオリンピックの真っ最中で、卓球が注目を集めています。同時に、ロボットは卓球のプレーにも新たな進歩をもたらしました。先ほど、DeepMind は、卓球競技において人間のアマチュア選手のレベルに到達できる初の学習ロボット エージェントを提案しました。論文のアドレス: https://arxiv.org/pdf/2408.03906 DeepMind ロボットは卓球でどれくらい優れていますか?おそらく人間のアマチュアプレーヤーと同等です: フォアハンドとバックハンドの両方: 相手はさまざまなプレースタイルを使用しますが、ロボットもそれに耐えることができます: さまざまなスピンでサーブを受ける: ただし、ゲームの激しさはそれほど激しくないようです公園の老人。ロボット、卓球用

トークン化を 1 つの記事で理解しましょう!

Apr 12, 2024 pm 02:31 PM

トークン化を 1 つの記事で理解しましょう!

Apr 12, 2024 pm 02:31 PM

言語モデルは、通常は文字列の形式であるテキストについて推論しますが、モデルへの入力は数値のみであるため、テキストを数値形式に変換する必要があります。トークン化は自然言語処理の基本タスクであり、特定のニーズに応じて、連続するテキスト シーケンス (文、段落など) を文字シーケンス (単語、フレーズ、文字、句読点など) に分割できます。その中の単位はトークンまたはワードと呼ばれます。以下の図に示す具体的なプロセスに従って、まずテキスト文がユニットに分割され、次に単一の要素がデジタル化され (ベクトルにマッピングされ)、次にこれらのベクトルがエンコード用のモデルに入力され、最後に下流のタスクに出力され、さらに最終結果を取得します。テキストセグメンテーションは、テキストセグメンテーションの粒度に応じて Toke に分割できます。

大規模言語モデルの効率的なパラメータ微調整 - BitFit/Prefix/Prompt 微調整シリーズ

Oct 07, 2023 pm 12:13 PM

大規模言語モデルの効率的なパラメータ微調整 - BitFit/Prefix/Prompt 微調整シリーズ

Oct 07, 2023 pm 12:13 PM

2018 年に Google が BERT をリリースしました。リリースされると、11 個の NLP タスクの最先端 (Sota) 結果を一気に打ち破り、NLP 界の新たなマイルストーンとなりました。BERT の構造は次のとおりです。下の図では、左側は BERT モデルのプリセット、右側はトレーニング プロセス、右側は特定のタスクの微調整プロセスです。このうち、微調整ステージは、テキスト分類、品詞のタグ付け、質問と回答システムなど、その後のいくつかの下流タスクで使用されるときに微調整するためのものです。BERT はさまざまな上で微調整できます。構造を調整せずにタスクを実行できます。 「事前トレーニング済み言語モデル + 下流タスク微調整」のタスク設計により、強力なモデル効果をもたらします。以来、「言語モデルの事前トレーニング + 下流タスクの微調整」が NLP 分野のトレーニングの主流になりました。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

大規模なモデルをクラウドにデプロイするための 3 つの秘密

Apr 24, 2024 pm 03:00 PM

大規模なモデルをクラウドにデプロイするための 3 つの秘密

Apr 24, 2024 pm 03:00 PM

コンピレーション|Xingxuan によって制作|51CTO テクノロジー スタック (WeChat ID: blog51cto) 過去 2 年間、私は従来のシステムよりも大規模言語モデル (LLM) を使用した生成 AI プロジェクトに多く関与してきました。サーバーレス クラウド コンピューティングが恋しくなってきました。そのアプリケーションは、会話型 AI の強化から、さまざまな業界向けの複雑な分析ソリューションやその他の多くの機能の提供まで多岐にわたります。多くの企業は、パブリック クラウド プロバイダーが既製のエコシステムをすでに提供しており、それが最も抵抗の少ない方法であるため、これらのモデルをクラウド プラットフォームにデプロイしています。ただし、安くはありません。クラウドは、スケーラビリティ、効率、高度なコンピューティング機能 (オンデマンドで利用可能な GPU) などの他の利点も提供します。パブリック クラウド プラットフォームでの LLM の展開については、あまり知られていない側面がいくつかあります

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。

RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

Jan 18, 2024 pm 05:27 PM

RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

Jan 18, 2024 pm 05:27 PM

言語モデルが前例のない規模に拡大するにつれて、下流タスクの包括的な微調整には法外なコストがかかります。この問題を解決するために、研究者はPEFT法に注目し、採用し始めました。 PEFT 手法の主なアイデアは、微調整の範囲を少数のパラメータ セットに制限して、自然言語理解タスクで最先端のパフォーマンスを達成しながら計算コストを削減することです。このようにして、研究者は高いパフォーマンスを維持しながらコンピューティング リソースを節約でき、自然言語処理の分野に新たな研究のホットスポットをもたらします。 RoSA は、一連のベンチマークでの実験を通じて、同じパラメーター バジェットを使用した以前の低ランク適応 (LoRA) および純粋なスパース微調整手法よりも優れたパフォーマンスを発揮することが判明した新しい PEFT 手法です。この記事ではさらに詳しく説明します

史上最大の ViT を便利にトレーニングしましたか? Google、ビジュアル言語モデルPaLIをアップグレード:100以上の言語をサポート

Apr 12, 2023 am 09:31 AM

史上最大の ViT を便利にトレーニングしましたか? Google、ビジュアル言語モデルPaLIをアップグレード:100以上の言語をサポート

Apr 12, 2023 am 09:31 AM

近年の自然言語処理の進歩は主に大規模言語モデルによるものであり、新しいモデルがリリースされるたびにパラメータと学習データの量が新たな最高値に押し上げられ、同時に既存のベンチマーク ランキングが壊滅することになります。たとえば、今年 4 月に Google は、5,400 億パラメータの言語モデル PaLM (Pathways Language Model) をリリースしました。これは、一連の言語および推論テストで人間を超えることに成功し、特に数ショットの小規模サンプル学習シナリオで優れたパフォーマンスを発揮しました。 PaLM は、次世代言語モデルの開発方向であると考えられています。同様に、視覚言語モデルは実際に驚くべき働きをしており、モデルの規模を大きくすることでパフォーマンスを向上させることができます。もちろん、それが単なるマルチタスク視覚言語モデルであれば、