ショックを受けた! 70,000 時間のトレーニングを経て、OpenAI のモデルは「Minecraft」で木材を計画する方法を学習しました

最近、GPT を置き去りにしたように見える OpenAI が新たな人生を歩み始めました。

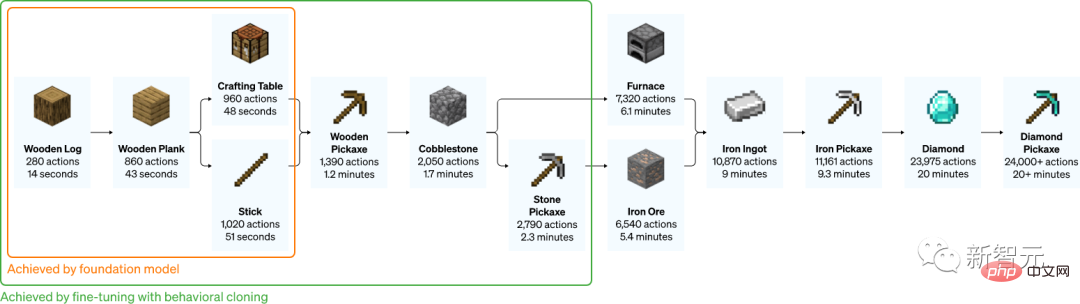

大量のラベルなしビデオと少量のラベル付きデータでトレーニングした後、AI はついに Minecraft でダイヤモンドのつるはしの作り方を学習しました。

このプロセス全体は、ハードコア プレイヤーであれば完了するまでに少なくとも 20 分かかり、合計 24,000 回の操作が必要になります。

#これは簡単なようですが、AI にとっては非常に難しいことです。

#7 歳の子供は 10 分間見れば学習できます

#最も単純な木製のつるはしの場合、人間のプレイヤーにプロセスを一から学ばせる それほど難しくありません。

1 人のオタクは、1 つのビデオで 3 分以内に次のオタクに教えることができます。

#デモビデオの長さは 2 分 52 秒です。

ただし、 , ダイヤモンド つるはしの作成はさらに複雑です。それでも、7 歳の子供は 10 分間のデモンストレーション ビデオを見るだけで学習できます。

#このミッションの難しさは主にダイヤモンド鉱山を掘る方法です。

#このミッションの難しさは主にダイヤモンド鉱山を掘る方法です。

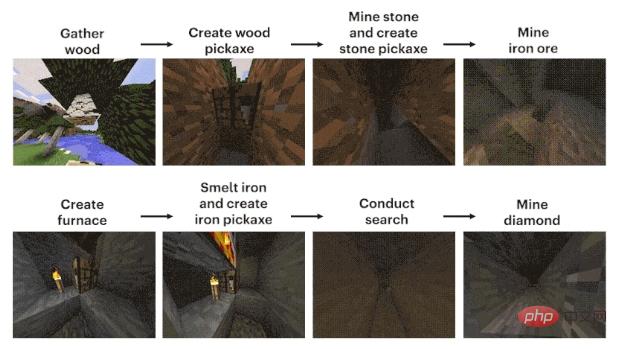

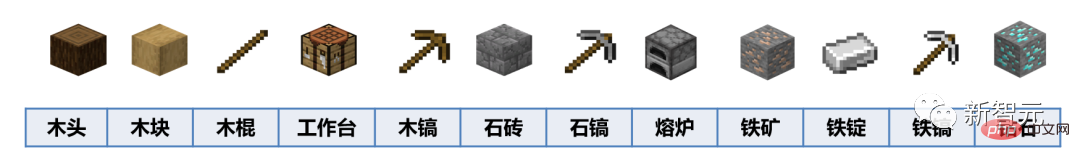

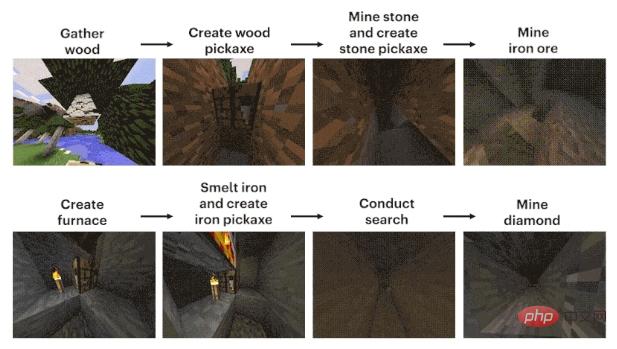

プロセスは大まかに 12 のステップに要約できます。まず、ピクセル ブロックの「木」を素手で計画し、次に丸太から木のブロックを合成し、木の棒から木の棒を作ります。ベンチ、木のつるはしを作る作業台、石をたたくための木のつるはし、石と棒を使って石のつるはしを作る、石のつるはしで炉を作る、鉄鉱石を加工する炉、鉄鉱石を溶かして鋳造する鉄のインゴット、鉄のツルハシを作るための鉄のインゴット、ダイヤモンドを掘るための鉄のツルハシ。

現在、プレッシャーは AI 側にあります。

現在、プレッシャーは AI 側にあります。

偶然にも、CMU、OpenAI、DeepMind、Microsoft Research およびその他の機関は、2019 年から関連コンペティション、MineRL を立ち上げています。

出場者は、「ゼロから独立してツールを作成し、自動的にダイヤモンド鉱山を見つけて採掘する」ことができる人工知能エージェントを開発する必要があります。勝利条件も非常にシンプルで、最も速い人が勝ちです。 。

結果はどうですか?

最初の MineRL コンテストの後、「7 歳の子供は 10 分間のビデオを見て学習しましたが、AI は 8 分間経っても理解できませんでした」 100万歩」 しかし、それはNature誌に掲載されました。

データが大量にあるのに使いこなせない

「Minecraft」はサンドボックス建築ゲームとして、プレイヤーの戦略と自由度が非常に高く、ゲーム仮想環境は、さまざまな AI モデルの学習および意思決定機能のテストの場および試金石として特に適しています。

そして、「国家レベル」のゲームであるため、「Minecraft」に関連するビデオをオンラインで簡単に見つけることができます。

ただし、チュートリアルを構築する場合でも、自分の作品を披露する場合でも、ある程度は画面に表示される結果にすぎません。

言い換えれば、ビデオを見ている人々は、アップリーダーが何をどのように行ったかを知ることしかできず、彼がどのようにそれを行ったかを知る方法はありません。

具体的に言うと、コンピュータの画面に表示されているのは単なる結果であり、操作手順はアップ主がキーボードを押し続けることと、マウスを動かし続けることです。この部分は以下を参照してください。

このプロセスさえも編集されており、AIはおろか、誰が見ても覚えられるはずがありません。

さらに悪いことに、多くのプレイヤーは、ゲーム内で木を削るのは宿題をしたりタスクを完了したりするのと同じで退屈だと不満を抱いています。その結果、更新の波が続いた後、無料で入手できるツールがたくさんありました...今では、データさえ見つけるのが困難です。

OpenAI が AI に「Minecraft」のプレイを学習させたい場合は、これらのラベルのない大量のビデオ データを使用する方法を見つけなければなりません。

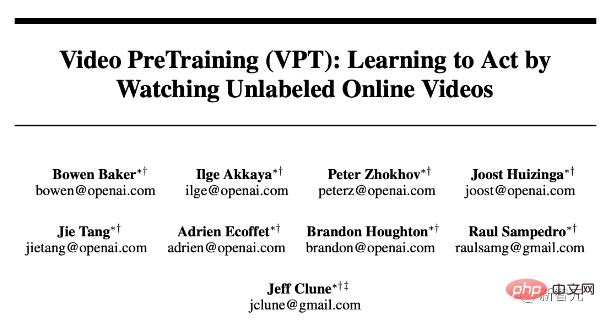

ビデオ事前トレーニング モデル—VPT

そこで、VPT が誕生しました。

#紙のアドレス: https://cdn.openai.com/vpt/Paper.pdf

これは新しいものですが、複雑ではなく、半教師あり模倣学習法です。

まず、データの波を収集して、ゲームをプレイしているアウトソーサーのデータに注釈を付けます。これには、キーボードやマウスの操作のビデオや記録が含まれます。

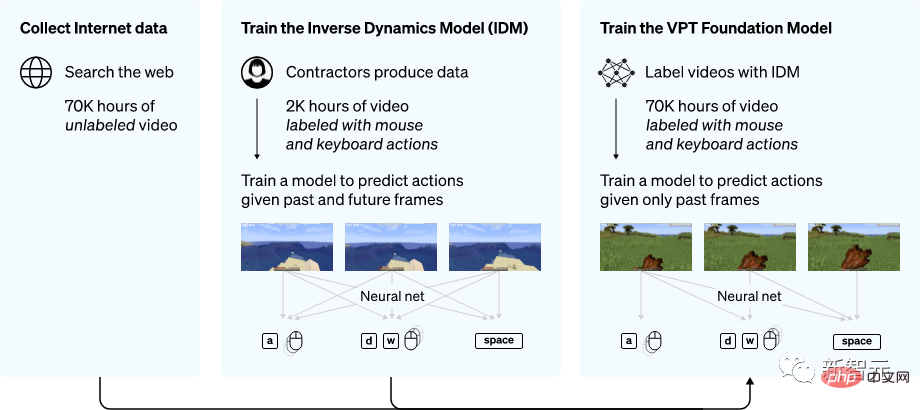

VPT 法の概要

研究者らはデータを使用しました。逆ダイナミクス モデル (IDM) を使用すると、ビデオの各ステップでキーボードとマウスがどのように動くかを推測できます。

このようにして、タスク全体がはるかに単純になり、目標を達成するために必要なデータははるかに少なくなります。

少量のアウトソーシング データで IDM を完了した後、IDM を使用して、より大きなラベルのないデータ セットにラベルを付けることができます。

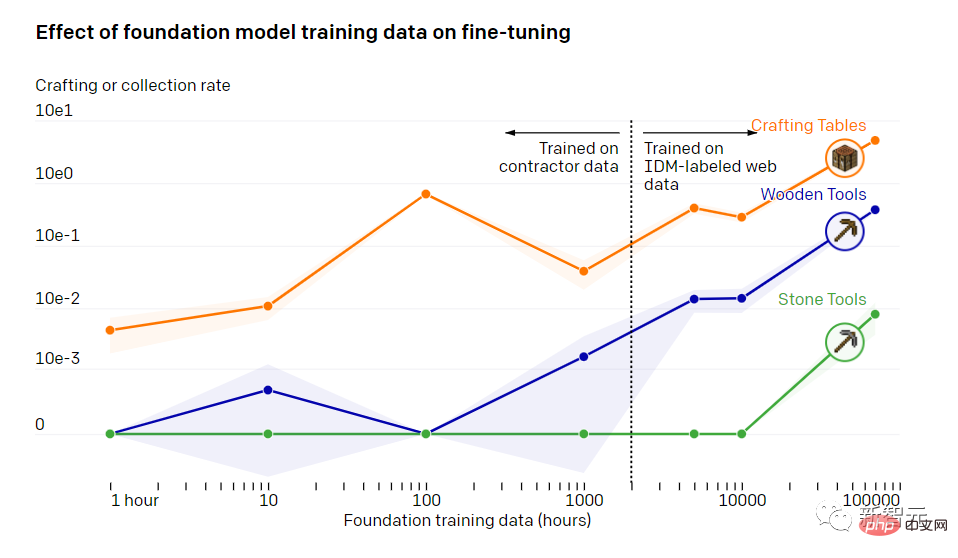

基本モデルのトレーニング データが微調整に及ぼす影響

トレーニング中 70,000 時間後、OpenAI の動作クローン モデルは、他のモデルでは不可能なさまざまなタスクを達成できるようになりました。

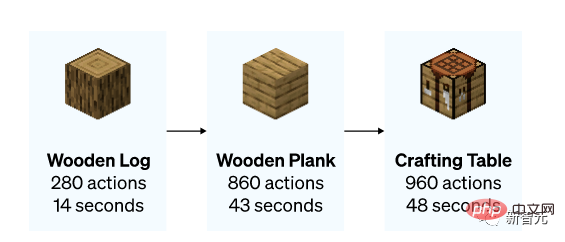

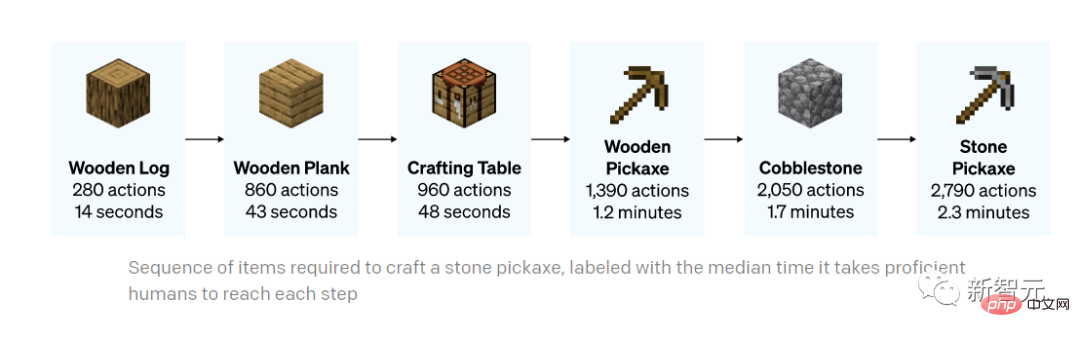

モデルは、木を伐採して木材を集める方法、木を使って木簡を作る方法、木簡を使ってテーブルを作る方法を学びました。この一連の作業は、比較的熟練したプレイヤーであれば 50 秒以内に操作できる必要があります。

テーブルを作ることに加えて、モデルは泳いだり、狩りをしたり、食事をしたりすることもできます。

「走ってジャンプして建てる」というかっこいい操作もあり、ジャンプするときに足元にレンガや木のブロックを置き、ジャンプしながら柱を建てることができます。 。ハードコアプレイヤーには必須のコースです。

テーブルの作成 (0 ショット)

ハンティング (0 ショット)

「走ったり跳んだり」簡易版(0ショット)

モデルがより正確なタスクを完了できるようにするために、データセットは通常、より小さいサイズに微調整され、小さな方向が区別されます。

OpenAI は、VPT でトレーニングされたモデルが微調整後に下流のデータセットにどの程度適応できるかを示す研究を実施しました。

研究者らは、人々に「Minecraft」を 10 分間プレイしてもらい、基本的な材料を使って家を建ててもらいました。彼らは、この方法で、ワークベンチの構築など、ゲーム初期のタスクを実行するモデルの能力を強化できることを期待しています。

データセットを微調整した後、研究者らは、モデルが初期タスクをより効率的に実行できることを発見しただけでなく、モデル自体がデータセットの作成方法を理解していることも発見しました。石製の作業台と石製の道具台。

研究者は、モデルが粗末な避難所を建設し、村を探索し、箱を略奪しているのを目にすることがあります。

石のつるはしを作る全プロセス (以下にマークされている時間は、熟練したプレイヤーが同じ作業を行うのにかかる時間です) task)

石のつるはしを作る

それでは、やってみましょうOpenAI の専門家がどのように微調整したかをご覧ください。

彼らが使用する手法は強化学習 (RL) です。

ほとんどの RL 手法は、事前確率を確率的に探索することでこれらの課題に対処します。つまり、モデルは多くの場合、エントロピーを通じてランダムなアクションに報酬を与えるようインセンティブが与えられます。人間の行動をシミュレートする方がランダムなアクションを実行するよりも役立つ可能性があるため、VPT モデルは RL にとってより優れた事前モデルであるはずです。

研究者らは、ダイヤモンドのつるはしを収集するという困難なタスクのモデルをセットアップしましたが、これは、タスク全体がネイティブのヒューマン マシン インターフェイスを使用して実行されるため、これまで Minecraft では見られなかった機能です。はさらに難しくなります。

ダイヤモンドのつるはしの作成には、長く複雑な一連のサブタスクが必要です。このタスクを扱いやすくするために、研究者らはシーケンス内の項目ごとにエージェントに報酬を与えました。

彼らは、ランダム初期化 (標準的な RL メソッド) からトレーニングされた RL ポリシーはほとんど報酬を獲得せず、ログの収集方法をまったく学習せず、収集能力が非常に高いことを発見しました。スティックが少なくなります。

まったく対照的に、VPT モデルは、ダイヤモンドのつるはしの作り方を学習するだけでなく、すべてのアイテムを収集するという人間レベルの成功も達成できるように微調整されました。

誰かが Minecraft でダイヤモンド ツールを作成できるコンピューター モデルをデモンストレーションしたのはこれが初めてです。

以上がショックを受けた! 70,000 時間のトレーニングを経て、OpenAI のモデルは「Minecraft」で木材を計画する方法を学習しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7540

7540

15

15

1380

1380

52

52

83

83

11

11

21

21

86

86

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

DebianシステムのReadDir関数は、ディレクトリコンテンツの読み取りに使用されるシステムコールであり、Cプログラミングでよく使用されます。この記事では、ReadDirを他のツールと統合して機能を強化する方法について説明します。方法1:C言語プログラムを最初にパイプラインと組み合わせて、cプログラムを作成してreaddir関数を呼び出して結果をinclude#include#include inctargc、char*argv []){dir*dir; structdireant*entry; if(argc!= 2){(argc!= 2){

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Debian OpenSSLでデジタル署名検証を実行する方法

Apr 13, 2025 am 11:09 AM

Debian OpenSSLでデジタル署名検証を実行する方法

Apr 13, 2025 am 11:09 AM

Debianシステムでのデジタル署名検証にOpenSSLを使用すると、次の手順に従うことができます。OpenSSL:Debianシステムがインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoaptupdatesudoaptinInstallopensslslに公開キーを取得できます。デジタル署名検証には、署名者の公開キーが必要です。通常、公開キーは、public_key.peなどのファイルの形で提供されます

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian Systemsでは、OpenSSLは暗号化、復号化、証明書管理のための重要なライブラリです。中間の攻撃(MITM)を防ぐために、以下の測定値をとることができます。HTTPSを使用する:すべてのネットワーク要求がHTTPの代わりにHTTPSプロトコルを使用していることを確認してください。 HTTPSは、TLS(Transport Layer Security Protocol)を使用して通信データを暗号化し、送信中にデータが盗まれたり改ざんされたりしないようにします。サーバー証明書の確認:クライアントのサーバー証明書を手動で確認して、信頼できることを確認します。サーバーは、urlsessionのデリゲート方法を介して手動で検証できます

Debian Hadoopログ管理を行う方法

Apr 13, 2025 am 10:45 AM

Debian Hadoopログ管理を行う方法

Apr 13, 2025 am 10:45 AM

DebianでHadoopログを管理すると、次の手順とベストプラクティスに従うことができます。ログ集約を有効にするログ集約を有効にします。Yarn.log-Aggregation-set yarn-site.xmlファイルでは、ログ集約を有効にします。ログ保持ポリシーの構成:yarn.log-aggregation.retain-secondsを設定して、172800秒(2日)などのログの保持時間を定義します。ログストレージパスを指定:Yarn.Nを介して

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centos Shutdownコマンドはシャットダウンし、構文はシャットダウン[オプション]時間[情報]です。オプションは次のとおりです。-hシステムをすぐに停止します。 -pシャットダウン後に電源をオフにします。 -r再起動; -t待機時間。時間は、即時(現在)、数分(分)、または特定の時間(HH:mm)として指定できます。追加の情報をシステムメッセージに表示できます。