Stanford/Google Brain: 二重蒸留、誘導拡散モデルのサンプリング速度が 256 倍に向上!

最近、分類器を使用しない誘導拡散モデルは高解像度画像生成に非常に効果的であり、DALL-E 2、GLIDE、Imagen などの大規模拡散フレームワークで広く使用されています。

ただし、分類子を使用しない誘導拡散モデルの欠点は、推論時の計算コストが高いことです。なぜなら、クラス条件付きモデルと無条件モデルという 2 つの拡散モデルを何百回も評価する必要があるからです。

この問題を解決するために、スタンフォード大学と Google Brain の学者は、2 段階の蒸留法を使用して分類器を使用しない誘導拡散モデルのサンプリング効率を向上させることを提案しました。

文書アドレス: https://arxiv.org/abs/2210.03142

分類器を使用しない誘導拡散モデルを高速サンプリング モデルに改良するにはどうすればよいですか?

まず、事前トレーニングされた分類子を使用しないガイダンス モデルについて、研究者はまず、条件付きモデルと無条件モデルの結合出力と一致する単一のモデルを学習しました。

研究者らは、このモデルを段階的に抽出して、より少ないサンプリング手順で拡散モデルを作成しました。

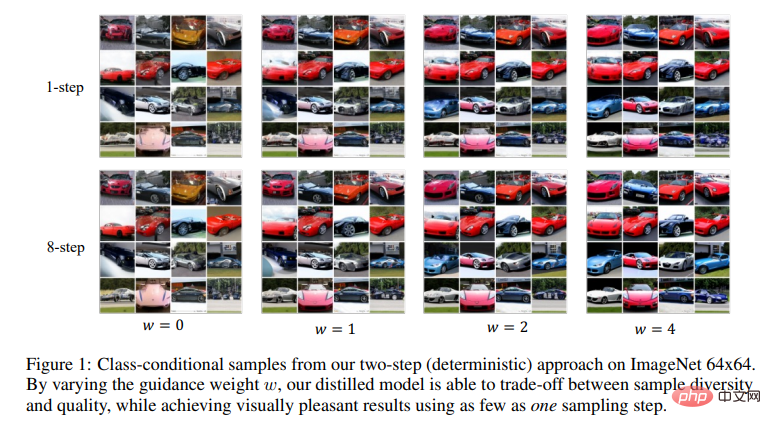

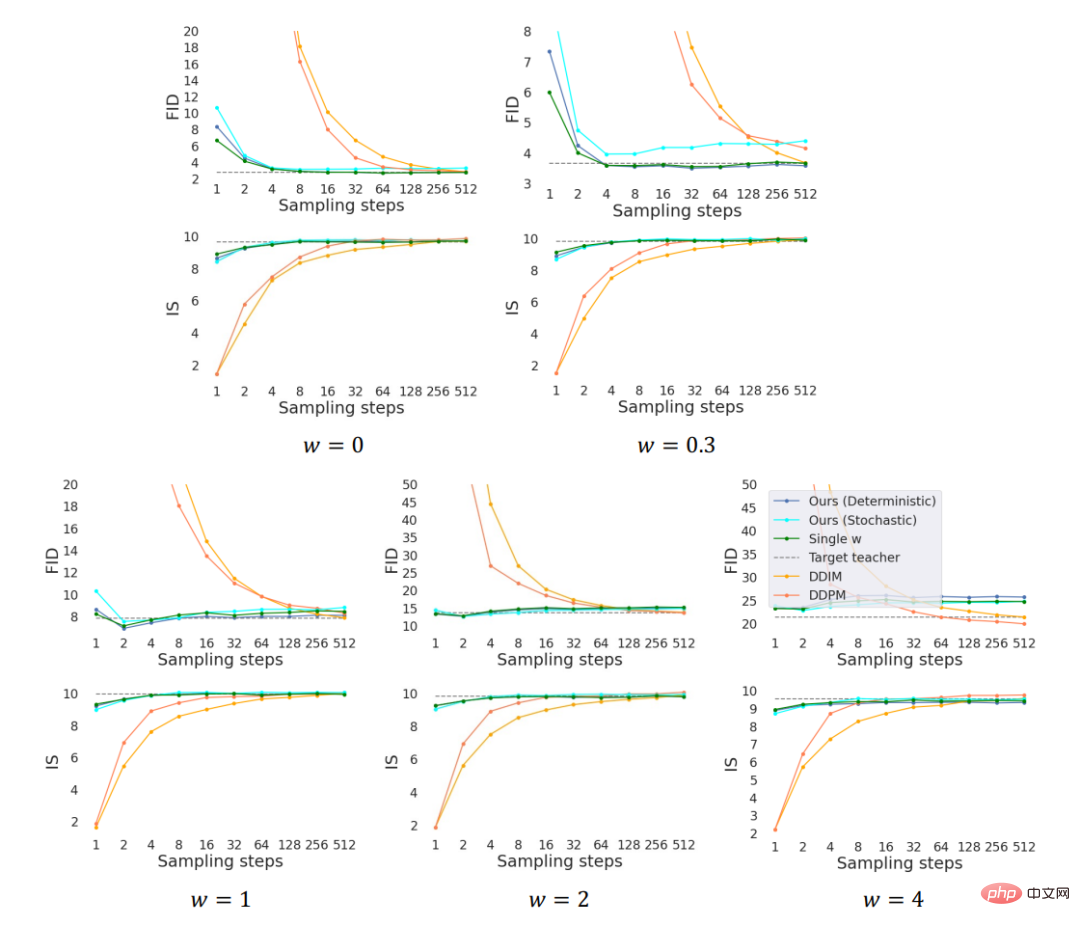

ImageNet 64x64 および CIFAR-10 では、この方法で元のモデルと視覚的に同等の画像を生成できることがわかります。

わずか 4 つのサンプリング ステップで、オリジナル モデルと同等の FID/IS スコアを取得でき、サンプリング速度も 256 倍と高速です。

ガイダンスの重み w を変更することで、研究者が抽出したモデルはサンプルの多様性と品質の間でトレードオフを行うことができることがわかります。 。たった 1 回のサンプリング ステップで、視覚的に満足のいく結果が得られます。

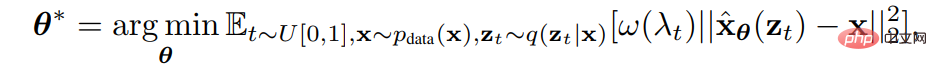

拡散モデルの背景データ分布からのサンプル x、ノイズ スケジューリング関数 研究者らは、重み付けされた値を最小化することでパラメータ θ を使用してモデルをトレーニングしました。平均二乗誤差 拡散モデル

研究者らは、重み付けされた値を最小化することでパラメータ θ を使用してモデルをトレーニングしました。平均二乗誤差 拡散モデル 。

。

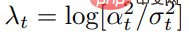

ここで、 は信号対雑音比、

は信号対雑音比、 および です。

および です。  は、事前に指定された重み付け関数です。

は、事前に指定された重み付け関数です。

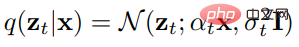

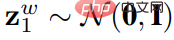

拡散モデルをトレーニングしたら、離散時間 DDIM サンプラーを使用してモデルからサンプリングできます。  具体的には、DDIM サンプラーは z1 〜 N (0,I) から始まり、次のように更新されます。

具体的には、DDIM サンプラーは z1 〜 N (0,I) から始まり、次のように更新されます。

ここで、N はサンプリング ステップの総数です。  を使用して、最終サンプルが生成されます。

を使用して、最終サンプルが生成されます。

分類子を使用しないガイダンスは、条件付き拡散モデルのサンプル品質を大幅に向上させる効果的な方法であり、GLIDE、DALL・E 2、Imagen などで広く使用されています。

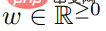

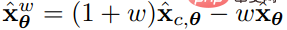

サンプルの品質と多様性を測定するためのガイダンス重みパラメーター が導入されています。サンプルを生成するために、分類子なしのガイダンスでは、各更新ステップで

が導入されています。サンプルを生成するために、分類子なしのガイダンスでは、各更新ステップで  を予測モデルとして使用し、条件付き拡散モデル

を予測モデルとして使用し、条件付き拡散モデル  と共同トレーニングされた

と共同トレーニングされた  。

。

分類器を使用しないガイダンスを使用したサンプリングは、サンプリング更新ごとに 2 つの拡散モデルを評価する必要があるため、一般にコストがかかります。

この問題を解決するために、研究者らは漸進蒸留を使用しました。これは、蒸留を繰り返すことで拡散モデルのサンプリング速度を高める方法です。

以前は、このメソッドをモデルの蒸留のガイドに直接使用することはできず、決定論的 DDIM サンプラー以外のサンプラーでも使用できませんでした。この論文では、研究者らはこれらの問題を解決しました。

分類器を使用しない誘導拡散モデルの抽出

彼らのアプローチは、分類器を使用せずに誘導拡散モデルを抽出することです。

トレーニングされた教師主導モデル の場合、彼らは 2 つのステップを踏みました。

の場合、彼らは 2 つのステップを踏みました。

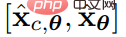

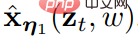

最初のステップで、研究者は、一致する学習可能なパラメータη1を持つ連続時間学生モデル を導入しました。任意のタイム ステップ t ∈ [0, 1] における教師モデルの出力。関心のある指導強度の範囲を指定した後、次の目標を使用して生徒モデルを最適化しました。 #####################で#########。

を導入しました。任意のタイム ステップ t ∈ [0, 1] における教師モデルの出力。関心のある指導強度の範囲を指定した後、次の目標を使用して生徒モデルを最適化しました。 #####################で#########。  指導の重み w を組み合わせるために、研究者は w 条件付きモデルを導入しました。ここで、w は学生モデルの入力として機能します。特徴をよりよく捉えるために、彼らはフーリエ埋め込み w を適用し、Kingma らが使用したタイムステッピング法を使用してそれを拡散モデルのバックボーンに組み込みました。

指導の重み w を組み合わせるために、研究者は w 条件付きモデルを導入しました。ここで、w は学生モデルの入力として機能します。特徴をよりよく捉えるために、彼らはフーリエ埋め込み w を適用し、Kingma らが使用したタイムステッピング法を使用してそれを拡散モデルのバックボーンに組み込みました。

初期化はパフォーマンスにおいて重要な役割を果たすため、研究者が生徒モデルを初期化するとき、教師条件モデルと同じパラメーターを使用しました (w コンディショニングに関連する新たに導入されたパラメーターを除く)。

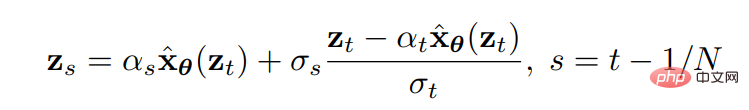

2 番目のステップ 、研究者は離散時間ステップのシナリオを想像し、最初のステップ  から学習モデルを徐々に変更しました。は、学習可能なパラメータ η2 とより少ないステップを持つスチューデント モデル

から学習モデルを徐々に変更しました。は、学習可能なパラメータ η2 とより少ないステップを持つスチューデント モデル  に抽出されます。

に抽出されます。

このうち、N はサンプリング ステップ数を表します。 と

と  について、研究者は、生徒モデル、教師モデルの 2 ステップ DDIM サンプリングの出力を 1 ステップで一致させます (例: t/N から t - 0.5/N、t - 0.5/N から t - 1/N)。

について、研究者は、生徒モデル、教師モデルの 2 ステップ DDIM サンプリングの出力を 1 ステップで一致させます (例: t/N から t - 0.5/N、t - 0.5/N から t - 1/N)。

教師モデルの 2N ステップを生徒モデルの N ステップに抽出した後、新しい N ステップの生徒モデルを新しい教師モデルとして使用し、同じことを繰り返すことができます。教師モデルを N/2 ステップの学生モデルに蒸留するプロセス。各ステップで、研究者は教師モデルのパラメーターを使用して化学モデルを初期化します。

#N ステップの決定論的およびランダム サンプリング

モデルが完成したら

のトレーニングを受けた研究者は、DDIM 更新ルールを通じてサンプリングを実行できます。研究者は、蒸留モデル

のトレーニングを受けた研究者は、DDIM 更新ルールを通じてサンプリングを実行できます。研究者は、蒸留モデル  # の場合、初期化

# の場合、初期化  # を考慮すると、このサンプリング プロセスが決定的であることに気付きました。

# を考慮すると、このサンプリング プロセスが決定的であることに気付きました。

さらに、研究者は N ステップのランダム サンプリングを実行することもできます。元のステップ サイズの 2 倍の確定的サンプリング ステップ (つまり、N/2 ステップの確定的サンプラーと同じ) を使用し、その後、元のステップ サイズを使用してランダムなステップを戻します (つまり、ノイズで摂動します)。

、t > 1/N の場合、次の更新ルールを使用できます——

、t > 1/N の場合、次の更新ルールを使用できます——

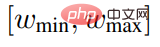

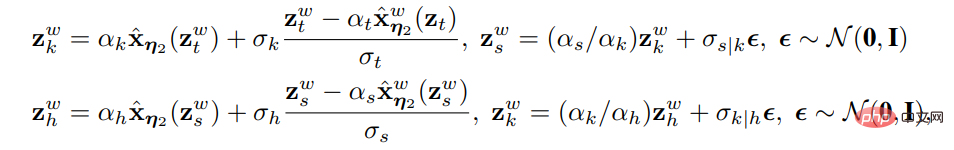

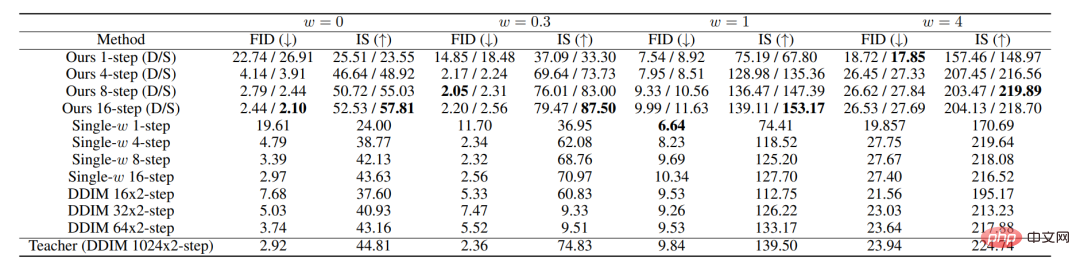

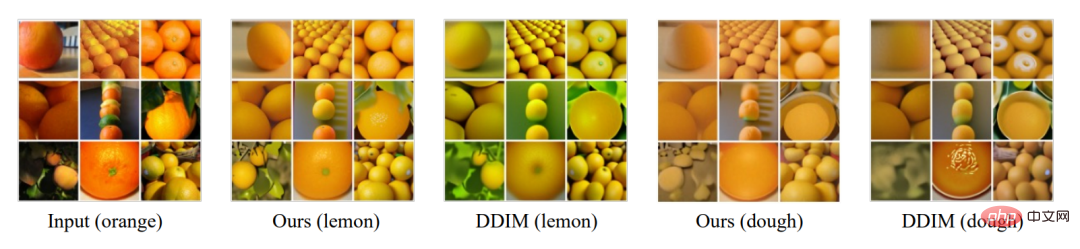

t=1/N の場合、研究者は決定論的更新公式を使用して ランダム サンプリングを実行するには、決定論的サンプラーと比較してわずかに異なるタイム ステップでモデルを評価する必要があり、トレーニング アルゴリズムに対するエッジ ケースの小さな変更が必要であることに注意してください。 その他の蒸留方法 ブートストラップ モデルに直接順蒸留を適用する方法もあります。 、教師モデルの構造に従って、学生モデルは、共同トレーニングされた条件付きモデルと無条件モデルに直接抽出されます。研究者らが試したところ、この方法は効果がないことがわかりました。 モデル実験は、ImageNet (64*64) と CIFAR 10 の 2 つの標準データ セットで実施されました。 実験では、ガイダンス重み w のさまざまな範囲が調査され、すべての範囲が同等であることが観察されたため、[wmin, wmax] = [0, 4] が使用されました。実験。第 1 ステップと第 2 ステップのモデルは、信号対雑音損失を使用してトレーニングされます。 ベースライン標準には、DDPM 祖先サンプリングと DDIM サンプリングが含まれます。 ガイダンス重み w を組み込む方法をよりよく理解するために、固定 w 値でトレーニングされたモデルが参照として使用されます。 公平な比較を行うために、実験ではすべての方法で同じ事前トレーニング済み教師モデルを使用します。 U-Net (Ronneberger et al., 2015) アーキテクチャをベースラインとして使用し、同じ U-Net バックボーンを使用して、w が埋め込まれた構造が 2 ステップのスチューデント モデルとして導入されます。 #上の図は、ImageNet 64x64 でのすべてのメソッドのパフォーマンスを示しています。ここで、D と S はそれぞれ決定的サンプラーと確率的サンプラーを表します。 実験では、誘導間隔 w∈[0, 4] を条件としたモデルのトレーニングは、w を固定値としてモデルをトレーニングした場合と同等でした。ステップ数が少ない場合、私たちの方法は DDIM ベースライン パフォーマンスを大幅に上回り、基本的に 8 ~ 16 ステップで教師モデルのパフォーマンス レベルに達します。 #FID および IS スコアによって評価される ImageNet 64x64 のサンプリング品質 ##また、教師モデルのエンコードプロセスを抽出して、スタイル転送の実験。具体的には、2 つのドメイン A と B の間でスタイル転送を実行するには、ドメイン A からの画像をドメイン A でトレーニングされた拡散モデルを使用してエンコードし、次にドメイン B でトレーニングされた拡散モデルを使用してデコードします。

エンコード プロセスは DDIM の逆サンプリング プロセスとして理解できるため、分類器なしのガイダンスでエンコーダとデコーダの両方を抽出し、上記のように DDIM エンコーダおよびデコーダと比較しました。図に示すように。また、ブーツ強度の変更によるパフォーマンスへの影響も調査します。 要約すると、誘導拡散モデルの蒸留方法と、蒸留されたモデルからサンプリングするランダム サンプラーを提案します。経験的に、私たちの方法はわずか 1 ステップで視覚的に高度なサンプリングを実現し、わずか 8 ~ 16 ステップで教師と同等の FID/IS スコアを取得します。  から

から  を導き出します。

を導き出します。 実験と結論

以上がStanford/Google Brain: 二重蒸留、誘導拡散モデルのサンプリング速度が 256 倍に向上!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7759

7759

15

15

1644

1644

14

14

1399

1399

52

52

1293

1293

25

25

1234

1234

29

29

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

ログインステップやパスワード回復プロセスなど、セサミオープンエクスチェンジWebバージョンのログイン操作の詳細な紹介も、ログイン障害、ページを開くことができず、プラットフォームにスムーズにログインするのに役立つ検証コードを受信できません。

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか? BYBITは、ユーザーにトレーディングサービスを提供する暗号通貨交換です。 Exchangeのモバイルアプリは、次の理由でAppStoreまたはGooglePlayを介して直接ダウンロードすることはできません。1。AppStoreポリシーは、AppleとGoogleがApp Storeで許可されているアプリケーションの種類について厳しい要件を持つことを制限しています。暗号通貨交換アプリケーションは、金融サービスを含み、特定の規制とセキュリティ基準を必要とするため、これらの要件を満たしていないことがよくあります。 2。法律と規制のコンプライアンス多くの国では、暗号通貨取引に関連する活動が規制または制限されています。これらの規制を遵守するために、BYBITアプリケーションは公式Webサイトまたはその他の認定チャネルを通じてのみ使用できます

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

この記事では、Binance、Okx、Gate.io、Bitflyer、Kucoin、Bybit、Coinbase Pro、Kraken、Bydfi、Xbit分散化された交換など、注意を払う価値のある上位10の暗号通貨取引プラットフォームを推奨しています。これらのプラットフォームには、トランザクションの数量、トランザクションの種類、セキュリティ、コンプライアンス、特別な機能の点で独自の利点があります。適切なプラットフォームを選択するには、あなた自身の取引体験、リスク許容度、投資の好みに基づいて包括的な検討が必要です。 この記事があなたがあなた自身に最適なスーツを見つけるのに役立つことを願っています

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Webサイトログインポータルの最新バージョンにアクセスするには、これらの簡単な手順に従ってください。公式ウェブサイトに移動し、右上隅の[ログイン]ボタンをクリックします。既存のログインメソッドを選択してください。「登録」してください。登録済みの携帯電話番号または電子メールとパスワードを入力し、認証を完了します(モバイル検証コードやGoogle Authenticatorなど)。検証が成功した後、Binance公式WebサイトLogin Portalの最新バージョンにアクセスできます。

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。