清華大学、ケンブリッジ大学、UICが共同で中国初のファクトチェックデータセットを発表:証拠に基づき、医学会など複数の分野をカバー

- #論文アドレス: https://arxiv.org/pdf/2206.11863.pdf

- ##データセット CHEF データセットのリンク: https://github.com/THU-BPM/CHEF

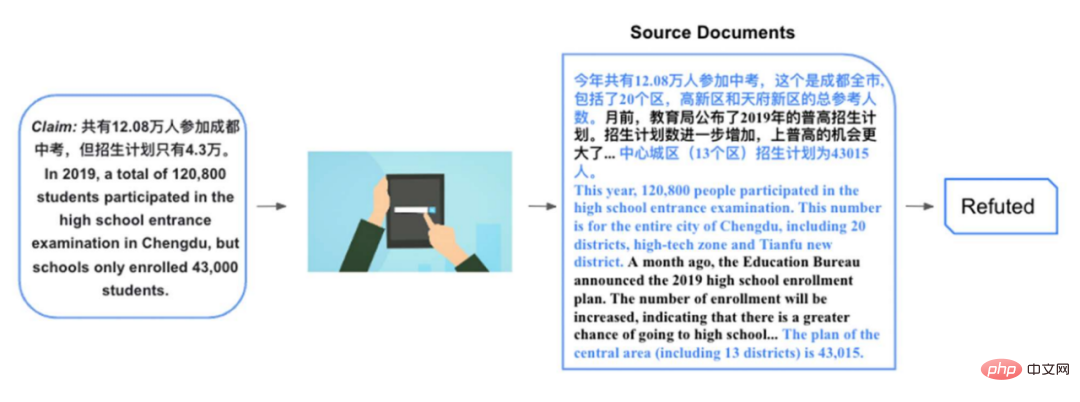

2019 年には、合計 120,800 人が成都高校入学試験を受験しましたが、入学計画はわずか 43,000 人でした 。この声明を検証することは比較的困難ですが、2019 年成都高校入学試験に関する関連文書を見つけた場合:

...合計 120,800 人が最高受験者でした今年の学校入学試験、これは20区、ハイテク区、天府新区を含む成都市の総基準数である。数カ月前、教育庁が2019年度普通科高等学校入学者計画を発表した。入学プランもさらに増え、一般高校に進学できる可能性はさらに高まりました。 ……この文書には声明に関連する多くの情報が含まれていますが、直接関連しており、声明の検証に役立つのは、上記の 2 番目の段落の後半です。そして多くの段落の後の最初の文。これらの証拠に基づいて、成都の 20 地区では実際に 120,800 人が高校受験をしており、中心都市部 (13 地区のみを含む) の入学計画は実際にわずか 43,000 人であることがわかります。数字は正しいのですが、ここで考え方を変えて、高校受験者数を議論する場合は20地区の人数を使いますが、入学計画を議論する場合は20地区の範囲を狭めます。 13 地区に拡大し、読者を誤解させます。この種の発言を検証するには、多くの場合、1 つ以上の文書から直接関連する証拠を抽出し、同時に抽出された証拠に基づいて推論を行う必要があります。中国のファクトチェック機械学習システムを促進するために、私たちはそのような証拠に基づいた中国のデータセットを提案します。

2019年度の中心市(13地区)の入学計画は43,015人です。

2. 関連研究

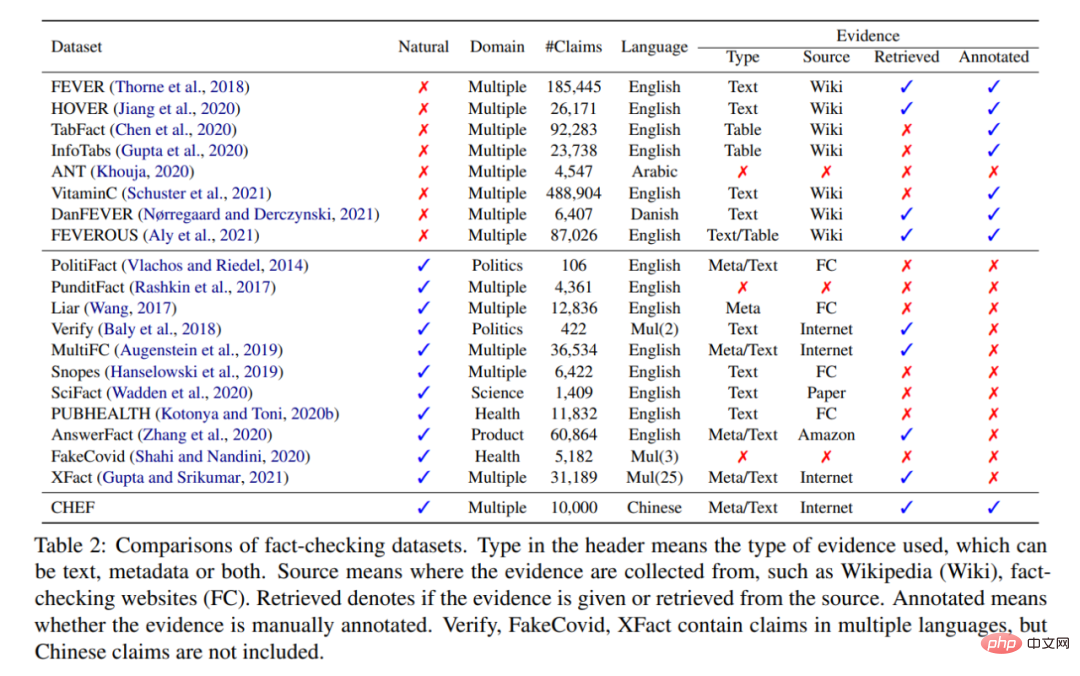

ファクト チェックのレビュー [1] によると、現在のファクト チェック データ セットは大まかに 2 つのカテゴリに分類できます。 ##人工(人工)と天然(天然)。

人工的 (人為的): 注釈者は、Wikipedia に従って文をステートメントとして書き直すように求められ、文書内の関連する段落は次のようになります。証拠として使用 この声明を検証してください。同義変換であれば証拠によって裏付けられる(Supported)、文中の実体が置き換えられたり、否定などの修飾が加えられた場合には、証拠によって否定される(Refuted)。 。

人工的 (人為的): 注釈者は、Wikipedia に従って文をステートメントとして書き直すように求められ、文書内の関連する段落は次のようになります。証拠として使用 この声明を検証してください。同義変換であれば証拠によって裏付けられる(Supported)、文中の実体が置き換えられたり、否定などの修飾が加えられた場合には、証拠によって否定される(Refuted)。 。

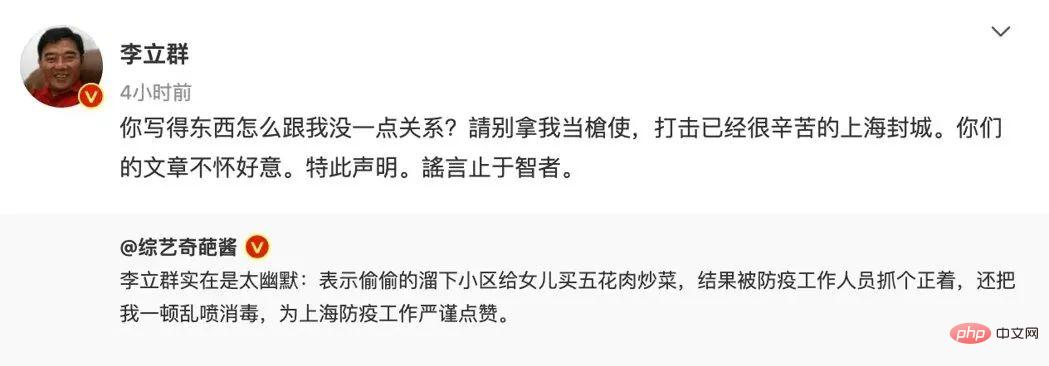

このアノテーション パラダイムはもともと FEVER[2] であり、TabFact[3] などのその後の多くの有名なデータ セットもこのパラダイムに従いました。このタイプの人工データ セットの利点はスケールアップできることであり、アノテーターは 100,000 個のステートメントにラベルを付けるように求められますが、これはニューラル ネットワークのトレーニングに非常に適しています。一方で、関連する証拠も簡単に入手できます。欠点は、これらの発言が日常生活で遭遇するような一般大衆に人気のある発言ではないことです。たとえば、李立群のウィキペディアに基づいて「彼はこっそり階下に肉を買いに行って捕まった」という発言を書き直すことはできないでしょう。 。一方、このタイプのデータセットは、Wikipedia に主張を検証するためのすべての知識が含まれていると仮定しています。これは比較的強力な仮定です。この仮定は、現実のシナリオでは満たされないことがよくあります。最も単純な問題は、Wikipedia にはタイムラグがあることです。

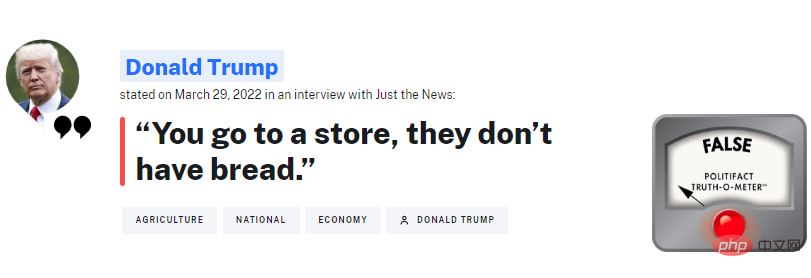

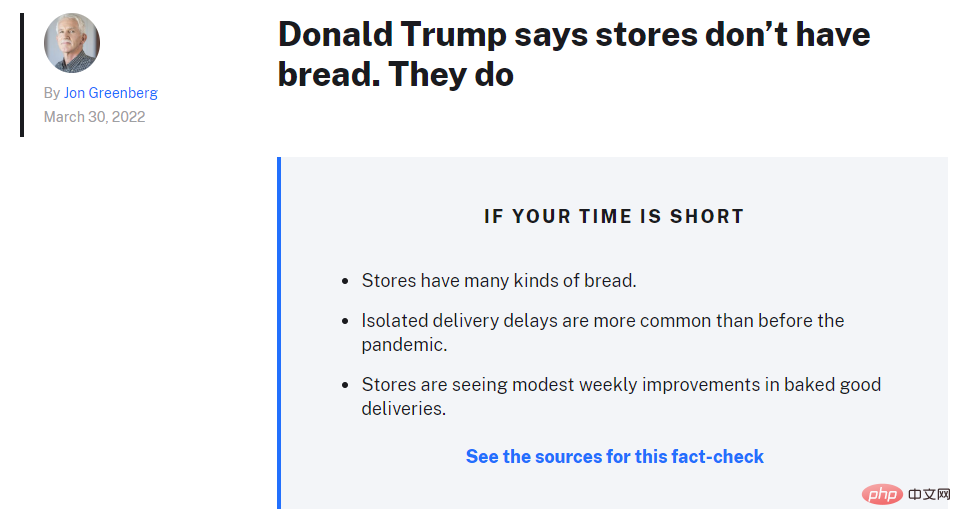

自然: これは事実確認プラットフォームから直接クロールされた声明であり、外国の比較有名な組織トランプ大統領の発言を頻繁にチェックするPolitiFactだ。このタイプのデータセットの利点は、一般の人々が毎日遭遇し、真実を知りたいと考えているステートメントであることです。これは、人間のファクトチェッカーが精査する必要がある声明でもあります。

最終的に人間の検証者をある程度代替できるシステムを構築したい場合、このシステムの入力はこのタイプのステートメントである必要があります。このタイプのデータセットの欠点も明らかです。それは、人間によって検証された主張の数が非常に限られているということです。表が示すように、ほとんどのデータ セットは、実際には手動で構築されたデータ セットよりも 1 桁小さいです。

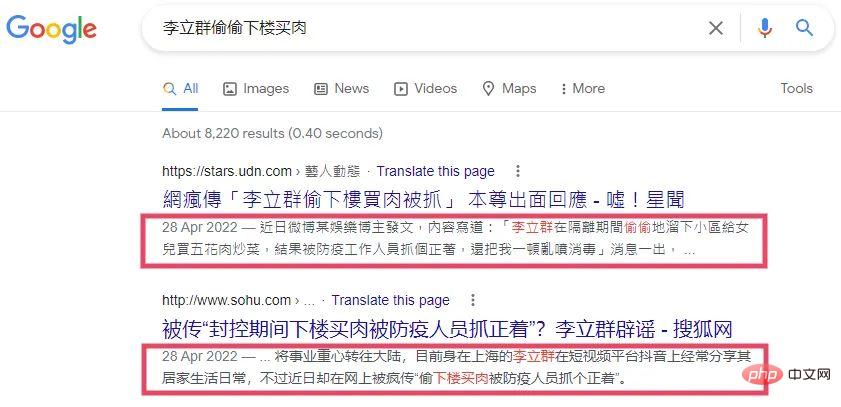

一方、証拠を見つけるのは非常に難しい問題です。既存のデータセットは通常、ファクトチェック記事 [4] を証拠として直接使用するか、クレームを使用して Google 検索クエリ [5][6] を入力し、返された検索概要 (赤いボックスで表示) を証拠として使用します。

##これらの証拠を見つける方法には 2 つの問題があります:

- ファクト チェック記事自体を証拠として使用する: 実際のシナリオでは、このアプローチは非現実的です。ファクト チェック システムを起動したい場合、システムが新しい主張を検証する必要がある場合、ファクト チェックがないことがよくあります。記事が表示されます。この方法では、システムは証拠を収集する方法を学習できません。

- Google スニペットを証拠として使用する: このアプローチは上記の問題を克服し、実際の現場に近づきます。ファクト チェッカーは多くの場合、関連情報を見つけるために検索エンジンに依存する必要があります。しかし、この方法には情報量が著しく不足するという欠点もあり、上図に示すように、Googleのルールに基づく要約では発言の真偽を判断するのに十分な情報が得られません。

上記の問題に対応して、CHEF を構築しました。CHEF には次のような特徴があります。 -世界の主張は同時に中国語で書かれ、中国の事実確認データセットのギャップを埋めています。

- 検索エンジンによって返された文書を元の証拠として使用し、実際の現場に近づけます。

- ヒューマン アノテーションを使用して、ドキュメントの関連する文を詳細な証拠として返します。これを使用して、証拠を収集する方法を学習する検証システムをトレーニングできます。

- 3. データセットの構築

- データセットの構築は 4 つの部分で構成されます: データ収集、ステートメント注釈、証拠検索およびデータ検証# ##。

元の声明は主に 4 つの中国の事実確認 Web サイトからクロールされました (デューク ニュース プラットフォームによる) ) のうち、簡体字中国語版は 2 つあります: China Rumor Refuting Center と Tencent True Truth。繁体字中国語は、台湾の 2 つのプラットフォーム、MyGoPen と台湾ファクトチェック センターから提供されています。ファクトチェック Web サイトからクロールされた主張の大部分 (90%) は虚偽であるため、一般的な噂や発言のほとんどが虚偽であり、検証プラットフォームによって反論/検証されることは、実際には非常に直感的です。以前の方法 (PublicHealth [7]) を参照して、チャイナ ニュース ネットワークのタイトルを実際の主張としてクロールし、比較的バランスのとれたラベルを持つデータ セットを構築しました。

3.2 声明の注釈

比較的成熟した外国のファクトチェック機関と比較して、中国の検証プラットフォームによって発行された記事は比較的あまり標準化されていません。たとえば、PolitiFact は、主張が何であるか、検証概要が何であるか、証拠と推論の詳細が何であるかを正確に示します (上の図を参照)。ただし、中国の記事は一般的にこのことを明確に示していないため、注釈者に記事を読んでもらい、記事によって検証された記述を抽出してもらいます。同時に、ステートメントもクリーンアップされ、ステートメントに含まれるバイアスが軽減されます。

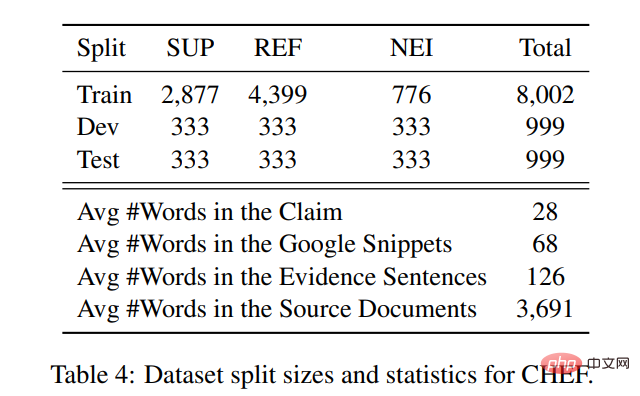

以前の研究では、ファクトチェック データセット内のステートメントには比較的強いバイアス (たとえば、虚偽のステートメントには通常否定的な単語が含まれる) と BERT などの PLM が含まれていることを示しています [8]。これらのバイアスを直接捉えることで、証拠がなくても主張を検証できます。クリーニング方法には、修辞的な質問を平叙文に変更することや、重い、衝撃的ななど、偏っている可能性のあるいくつかの単語を削除することが含まれます。主張を抽出した後、私たちはまた、事実確認記事に基づいて主張にラベルを付けるようにアノテーターに依頼しました。 『FEVER』などの一連の作品と同様の分類を採用しており、支持、反論、情報不足(NEI)の3分類を採用しています。その中で、Refuted が最大規模であり、NEI が最小規模である。

3.3 証拠の取得

このステートメントをクエリ ステートメントとして使用して Google 検索にクエリを実行し、その後、いくつかのドキュメントを除外します。その一部はステートメントが検索された後のドキュメントです。残りの部分は虚偽ニュース拡散プラットフォームからの文書であり、上位 5 つの文書が最後に保持されます。次に、注釈者は各記述の証拠として最大 5 つの文を選択するように求められました。

データセット内の主張と証拠の統計は次のとおりです。各主張に対して返される文書の平均長は 3691 ワードで、アノテーターが最後の部分を抽出した文が含まれます。詳細な証拠には 126 語が含まれており、Google のルールベースのスニペットを使用すると平均 68 語が含まれます。返されたドキュメントと注釈付きの文を使用して数値を比較するだけで、概要を直接使用するよりも多くのコンテキスト情報が得られます。

3.4 データ検証

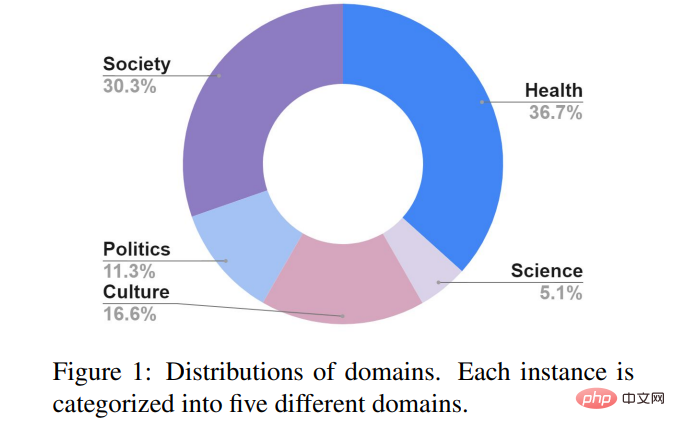

ラベリングの一貫性を確保するために、データ検証のラウンドを追加し、ランダムに 3 つを選択しました。合計 310 個のラベル付きステートメントのうちの % が、ラベル付けと再ラベル付けのために 5 人のアノテーターに配布されました。 Fleiss K スコアは 0.74 に達し、FEVER の 0.68 や Snopes[5] の 0.70 よりわずかに高く、データ アノテーションの品質が以前の人々によって構築されたデータ セットと比べて劣っていないことを示しています。 CHEFにおけるステートメントは主に、社会、公衆衛生、政治、科学、文化の5つのテーマに分かれています。政治分野に焦点を当てたヨーロッパやアメリカのファクトチェックプラットフォームとは異なり、中国のプラットフォームは新型コロナウイルス、ヘルスケア、医療などの公衆衛生問題により多くの注意を払っている。もう 1 つの主要なトピックは、詐欺、進学、社会的出来事などの社会です。

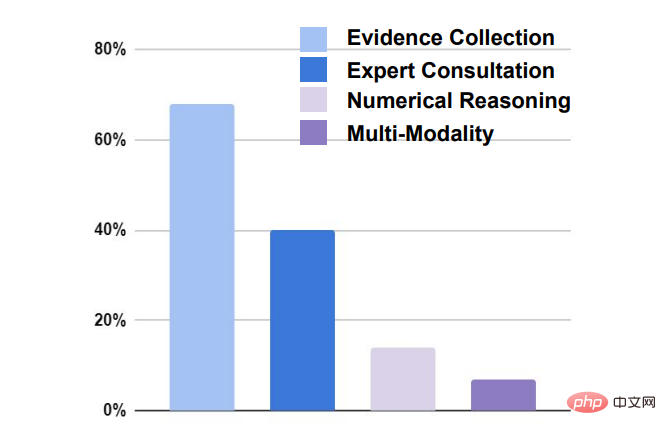

この声明を検証するには、主に 4 つの課題があります。

- 証拠の収集:主張の 70 % では関連証拠の検証が必要です。

- 専門家への相談: 請求の約 40% で、関連情報を得るために専門家への相談が必要です。

- 数的推論: 主張検証の 18% では、結論に達するために数的推論が必要です。

- マルチモダリティ: 申し立ての約 8% では、写真やビデオなどの非文字証拠が必要です。

4. ベースライン システム

以前の古典的なファクトチェック データセット (FEVER など) と同様に、機械学習システムはまず、特定の文書内の関連する文を証拠として選択する必要があります (証拠の検索)。 、そして証拠と照らし合わせて主張を検証します(主張検証)。

この記事では、何千人もの人々の成果に基づいて、ベースライン システムの 2 つの主要なカテゴリ、パイプライン システムとジョイント システムを提案します。パイプライン: 証拠検索とクレーム検証は 2 つの別個のモジュールです。証拠検索は最初に証拠を抽出するために使用され、その後、結合されたクレームが分類のためにクレーム検証モジュールに渡されます。

- #証拠検索部分: 4 つの異なる抽出ツールを使用して、返された文書から詳細な証拠として文を抽出します。 1 つ目は文字特徴マッチング (TF-IDF) に基づいており、2 つ目は意味論的特徴マッチングに基づいており、中国語 BERT を使用してコサイン類似度を計算します。 3 番目は混合機能です。上記の 2 つの機能を取得し、rankSVM を使用して並べ替えます。最終的なベースライン システムは、Google が返す従来のスニペットです。

- ステートメント検証部分: 3 つの異なるモデルを使用します。 1 つ目は中国の BERT に基づいており、上記で得られた声明と証拠をつなぎ合わせて 3 つの分類のために BERT に投げます。 2 つ目は、異なる重みを与える主張に基づいて証拠を分類する注意ベースのモデルです。 3 つ目はグラフベースのモデルです。FEVER では SOTA グラフ モデル KGAT[9] を使用します。これにより、推論のためのさまざまな証拠をより適切に統合できます。

共同: 証拠検索モジュールと請求検証モジュールは共同で最適化されます。 3 つの異なるモデルが使用されており、1 つ目は SOTA on FEVER [10] の結合モデルで、マルチタスク学習フレームワークを使用して、証拠と主張を同時にラベル付けすることを学習します。 2 つ目は、証拠の抽出を潜在変数 [11] として処理し、返された文書の各文に 0 または 1 のラベルを付ける方法です。1 のラベルが付けられた文は証拠として残され、トレーニング用の REINFORCE を使用してステートメントと一緒に分類されます。 。 3 番目の方法は 2 番目の方法と似ていますが、ポリシー勾配を使用する代わりに、HardKuma と共同トレーニングに重パラメータ法を使用する点が異なります [12]。

5. 実験結果

5.1 主な結果

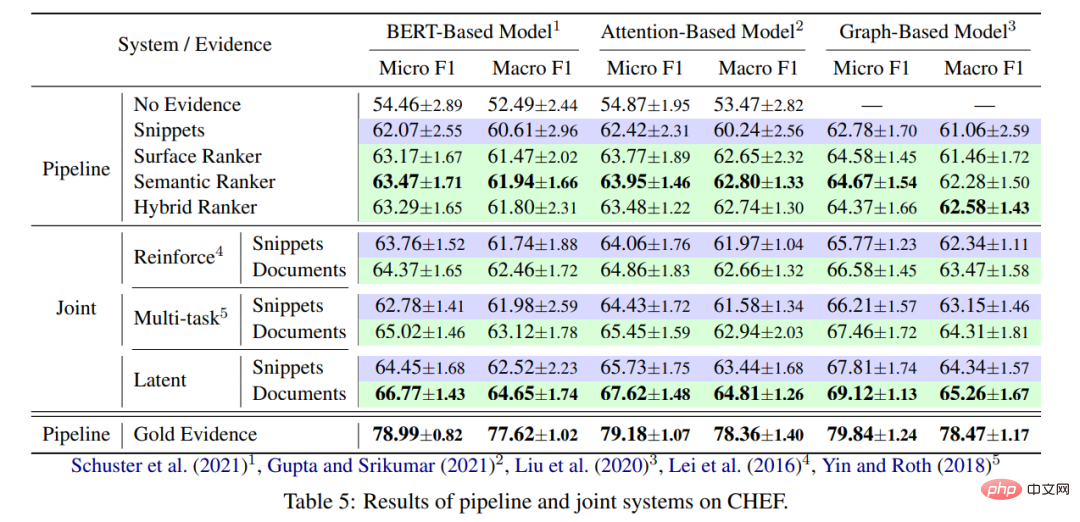

実験の主な結果を以下の図に示します。

- 証拠検索の観点から: 一般に、ジョイント モデルはパイプライン モデルよりも優れたパフォーマンスを発揮します。主な理由は、証拠検索モジュールを最適化して、主張の検証に役立つ証拠を見つけることができるためです。 。一方、返されたドキュメントを使用する方が、Google スニペットを使用するよりも常に優れています。これは主にドキュメントに豊富な情報が含まれているためです。最後に、ヒューマン アノテーションを直接使用することの証拠効果は、現在の 2 つの主要なカテゴリのベースライン モデルをはるかに上回ります。他の事実確認データセット (FEVEROUS) と同様に、主張を検証する際の証拠の検索は困難です。人間がラベル付けした証拠に基づいて証拠検索モジュールを最適化する方法は、将来的に研究する価値のある方向性です。

- クレーム検証の観点から: グラフベース モデル (KGAT) は、グラフを構築して証拠推論を取得することにより、単純な BERT ベースおよび注意ベースのモデルよりも優れたパフォーマンスを発揮します チェーンが効果的な方法です。しかしその一方で、グラフ モデルの改善は特に明らかではなく、データ セット自体には局所的な条件に基づいた最適化が必要になる可能性があります。

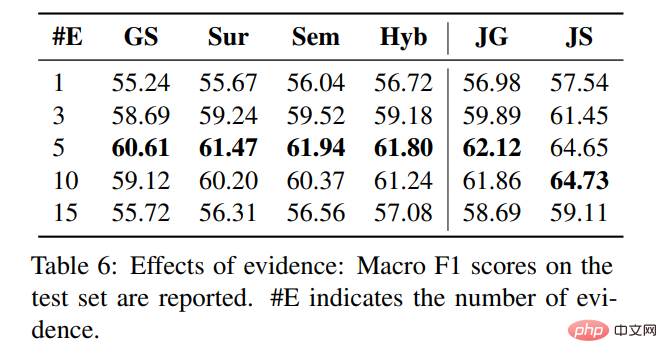

5.2 詳細な証拠の数

5.2 詳細な証拠の数

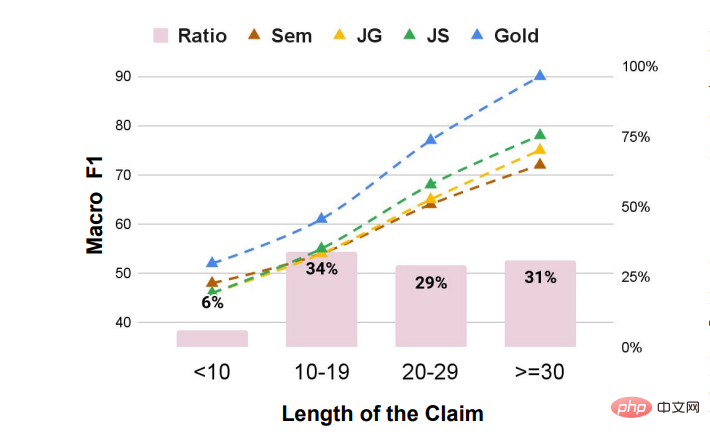

5.3 宣言の長さの影響

5.3 宣言の長さの影響

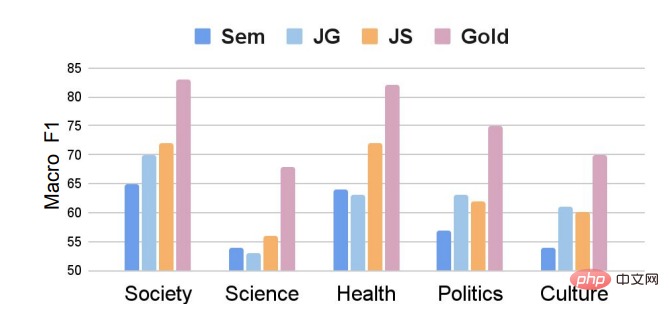

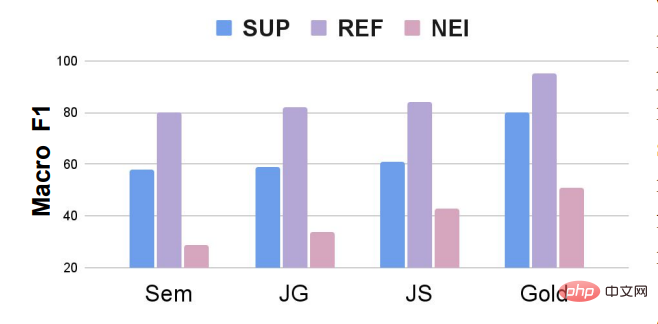

科学分野からの主張は検証が最も困難であり、モデル効果は基本的に 55 までです。一方で、関連する証拠を収集することはより困難であり、他方では、科学的問題に関する記述は比較的複雑であり、結果を得るために暗黙の推論を必要とすることがよくあります。 図に示すように、たとえ部分的な Supported 宣言を導入したとしても、データ セット全体は階級の不均衡の問題は依然として存在する。 NEI カテゴリに対するモデルの影響は、支持および反駁カテゴリに比べてはるかに弱いです。今後の研究では、カテゴリーの不均衡なファクトチェックデータセットのクレーム検証モデルを調整する方法や、データ拡張手法を使用してトレーニングプロセス中に NEI の数をランダムに増やす方法を研究することができます。トレーニングプロセス中の NEI 一部の主張の証拠を破棄し、それらの主張のカテゴリを NEI に変更します。 5.4 主張された分野の影響

5.5 宣言カテゴリの影響

以上が清華大学、ケンブリッジ大学、UICが共同で中国初のファクトチェックデータセットを発表:証拠に基づき、医学会など複数の分野をカバーの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1657

1657

14

14

1415

1415

52

52

1309

1309

25

25

1257

1257

29

29

1231

1231

24

24

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

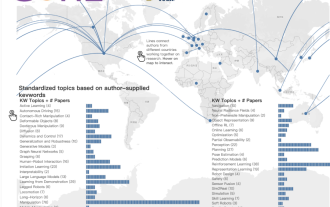

ICCV'23論文賞「Fighting of Gods」! Meta Divide Everything と ControlNet が共同で選ばれました、審査員を驚かせた記事がもう 1 つありました

Oct 04, 2023 pm 08:37 PM

ICCV'23論文賞「Fighting of Gods」! Meta Divide Everything と ControlNet が共同で選ばれました、審査員を驚かせた記事がもう 1 つありました

Oct 04, 2023 pm 08:37 PM

フランスのパリで開催されたコンピュータービジョンのトップカンファレンス「ICCV2023」が閉幕しました。今年の論文賞はまさに「神と神の戦い」です。たとえば、最優秀論文賞を受賞した 2 つの論文には、ヴィンセント グラフ AI の分野を覆す研究である ControlNet が含まれていました。 ControlNet はオープンソース化されて以来、GitHub で 24,000 個のスターを獲得しています。拡散モデルであれ、コンピュータ ビジョンの全分野であれ、この論文の賞は当然のことです。最優秀論文賞の佳作は、同じく有名なもう 1 つの論文、Meta の「Separate Everything」「Model SAM」に授与されました。 「Segment Everything」は、発売以来、後発のものも含め、さまざまな画像セグメンテーション AI モデルの「ベンチマーク」となっています。

紙のイラストも拡散モデルを使用して自動生成でき、ICLR にも受け入れられます。

Jun 27, 2023 pm 05:46 PM

紙のイラストも拡散モデルを使用して自動生成でき、ICLR にも受け入れられます。

Jun 27, 2023 pm 05:46 PM

生成 AI は人工知能コミュニティに旋風を巻き起こし、個人も企業も、Vincent 写真、Vincent ビデオ、Vincent 音楽など、関連するモーダル変換アプリケーションの作成に熱心になり始めています。最近、ServiceNow Research や LIVIA などの科学研究機関の数人の研究者が、テキストの説明に基づいて論文内のグラフを生成しようとしました。この目的のために、彼らは FigGen の新しい手法を提案し、関連する論文も TinyPaper として ICLR2023 に掲載されました。絵用紙のアドレス: https://arxiv.org/pdf/2306.00800.pdf 絵用紙のチャートを生成するのは何がそんなに難しいのかと疑問に思う人もいるかもしれません。これは科学研究にどのように役立ちますか?

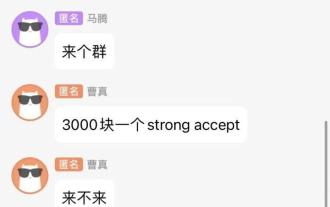

チャットのスクリーンショットから AI レビューの隠されたルールが明らかになります。 AAAI 3000元は強力に受け入れられますか?

Apr 12, 2023 am 08:34 AM

チャットのスクリーンショットから AI レビューの隠されたルールが明らかになります。 AAAI 3000元は強力に受け入れられますか?

Apr 12, 2023 am 08:34 AM

AAAI 2023 の論文提出期限が近づいていたとき、AI 投稿グループの匿名チャットのスクリーンショットが突然 Zhihu に表示されました。そのうちの1人は、「3,000元で強力なサービスを提供できる」と主張した。このニュースが発表されるとすぐに、ネットユーザーの間で国民の怒りを引き起こした。ただし、まだ急ぐ必要はありません。 Zhihuのボス「Fine Tuning」は、これはおそらく単に「言葉による喜び」である可能性が高いと述べた。 『ファイン・チューニング』によると、挨拶や集団犯罪はどの分野でも避けられない問題だという。 openreview の台頭により、cmt のさまざまな欠点がますます明らかになり、小さなサークルが活動できる余地は将来的には小さくなるでしょうが、余地は常にあります。これは個人の問題であり、投稿システムや仕組みの問題ではないからです。オープンRの紹介

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

中国チームが最優秀論文賞と最優秀システム論文賞を受賞し、CoRLの研究成果が発表されました。

Nov 10, 2023 pm 02:21 PM

中国チームが最優秀論文賞と最優秀システム論文賞を受賞し、CoRLの研究成果が発表されました。

Nov 10, 2023 pm 02:21 PM

2017 年に初めて開催されて以来、CoRL はロボット工学と機械学習の交差点における世界トップクラスの学術会議の 1 つになりました。 CoRL は、理論と応用を含むロボット工学、機械学習、制御などの複数のトピックをカバーするロボット学習研究のための単一テーマのカンファレンスであり、2023 年 CoRL カンファレンスは 11 月 6 日から 9 日まで米国アトランタで開催されます。公式データによると、今年は25か国から199本の論文がCoRLに選ばれた。人気のあるトピックには、演算、強化学習などが含まれます。 CoRLはAAAIやCVPRといった大規模なAI学会に比べて規模は小さいものの、今年は大型モデル、身体化知能、ヒューマノイドロボットなどの概念の人気が高まる中、関連研究も注目されるだろう。

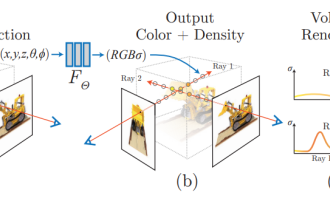

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

Neural Radiance Fieldsは2020年に提案されて以来、関連論文の数が飛躍的に増加し、3次元再構成の重要な分野となっただけでなく、自動運転の重要なツールとして研究の最前線でも徐々に活発になってきています。 NeRF は、過去 2 年間で突然出現しました。その主な理由は、特徴点の抽出とマッチング、エピポーラ幾何学と三角形分割、PnP とバンドル調整、および従来の CV 再構成パイプラインのその他のステップをスキップし、メッシュ再構成、マッピング、ライト トレースさえもスキップするためです。 、2D から直接入力画像を使用して放射線野を学習し、実際の写真に近いレンダリング画像が放射線野から出力されます。言い換えれば、ニューラル ネットワークに基づく暗黙的な 3 次元モデルを指定されたパースペクティブに適合させます。

Google AIビデオがまたすごい!オールインワンのユニバーサル ビジュアル エンコーダーである VideoPrism が 30 の SOTA パフォーマンス機能を更新

Feb 26, 2024 am 09:58 AM

Google AIビデオがまたすごい!オールインワンのユニバーサル ビジュアル エンコーダーである VideoPrism が 30 の SOTA パフォーマンス機能を更新

Feb 26, 2024 am 09:58 AM

AIビデオモデルSoraが人気を博した後、MetaやGoogleなどの大手企業は研究を行ってOpenAIに追いつくために手を引いた。最近、Google チームの研究者は、ユニバーサル ビデオ エンコーダー VideoPrism を提案しました。単一の凍結モデルを通じてさまざまなビデオ理解タスクを処理できます。画像ペーパーのアドレス: https://arxiv.org/pdf/2402.13217.pdf たとえば、VideoPrism は、以下のビデオ内でろうそくを吹き飛ばしている人を分類して特定できます。画像ビデオテキスト検索では、テキストコンテンツに基づいて、ビデオ内の対応するコンテンツを検索できます。別の例として、下のビデオについて説明します。小さな女の子が積み木で遊んでいます。 QAの質問と回答もご覧いただけます。