Wayformer: 動き予測のためのシンプルで効果的なアテンション ネットワーク

2022 年 7 月にアップロードされた arXiv 論文「Wayformer: Motion Forecasting via Simple & Efficient Attendant Networks」は、Google Waymo の著作物です。

複雑な運転シナリオではさまざまな形式の静的入力と動的入力が混在するため、自動運転の動作予測は困難なタスクです。道路の形状、車線の接続性、時間とともに変化する信号機の状態、およびエージェントとその相互作用の動的なセットに関する履歴情報を効率的なエンコーディングに表現および融合する最善の方法は、未解決の問題です。この多様な入力特徴のセットをモデル化するには、モダリティ固有のモジュールの異なるセットを使用して同様に複雑なシステムを設計するためのアプローチが多数あります。その結果、厳密な方法での拡張、拡張、または品質と効率のトレードオフが困難なシステムが生まれます。

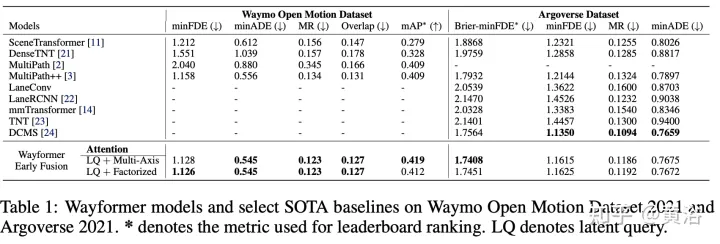

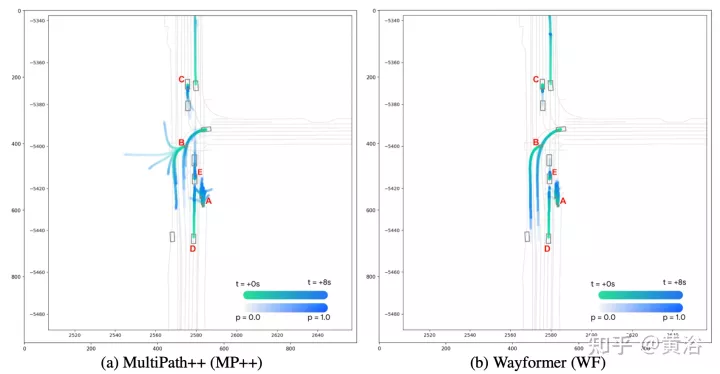

この記事の Wayformer は、シンプルで同様の注意ベースの動き予測アーキテクチャのシリーズです。 Wayformer は、アテンションベースのシーン エンコーダーとデコーダーで構成されるコンパクトなモデル記述を提供します。シーンエンコーダでは、入力モードの融合前、融合後、および階層融合の選択が検討されます。融合タイプごとに、分解の注意または潜在的なクエリの注意を通じて、効率と品質をトレードオフする戦略を検討します。融合前の構造はシンプルでモードに依存しないだけでなく、Waymo Open Movement Dataset (WOMD) と Argoverse リーダーボードの両方で最先端の結果を達成します。

運転シナリオは、道路情報、信号機の状態、エージェントの履歴、インタラクションなどのマルチモーダル データで構成されます。モダリティについては、Context という 4 番目の次元があり、モデル化された各エージェントの「コンテキスト上の目標のセット」(つまり、他の道路利用者の表現) を表します。

インテリジェンス履歴現在の状態だけでなく過去の一連のインテリジェンス状態が含まれています。各タイム ステップについて、x、y、速度、加速度、境界ボックスなどのエージェントの状態を定義する特徴と、コンテキストの次元を考慮します。

インタラクション テンソル は、エージェント間の関係を表します。モデル化されたエージェントごとに、モデル化されたエージェントの周囲にある固定数の最近傍コンテキストが考慮されます。これらのコンテキスト エージェントは、モデル化されたエージェントの動作に影響を与えるエージェントを表します。

道路マップエージェントの周囲の道路の特徴が含まれます。道路地図セグメントは、端点によって指定され、道路の形状を近似するタイプ情報で注釈が付けられたセグメントの集合であるポリラインとして表されます。モデリング エージェントに最も近いロード マップ セグメントを使用します。道路フィーチャには時間ディメンションがなく、時間ディメンション 1 を追加できることに注意してください。

各エージェントの 信号機情報には、エージェントに最も近い信号機の状態が含まれます。各交通信号ポイントには、信号の位置と信頼レベルを説明する特徴があります。

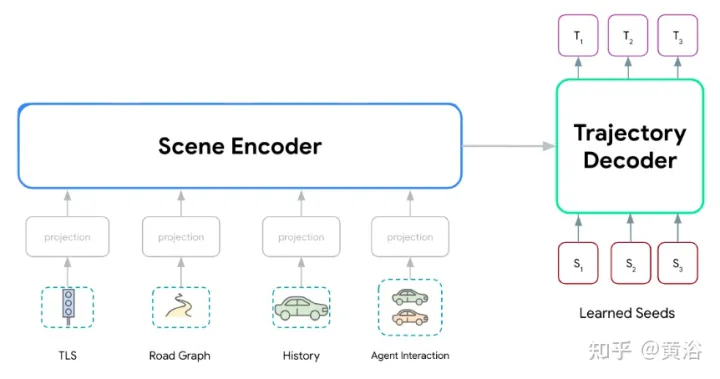

Wayformer モデル シリーズは、シーン エンコーダーとデコーダーの 2 つの主要コンポーネントで構成されています。シーン エンコーダは主に 1 つ以上のアテンション エンコーダで構成され、運転シーンを要約するために使用されます。デコーダは 1 つ以上の標準トランスフォーマ クロスアテンション モジュールであり、学習された初期クエリを入力し、シーン エンコーディング クロスアテンションを使用して軌道を生成します。

図に示すように、Wayformer モデルはマルチモーダル入力を処理してシーン エンコーディングを生成します。このシーン エンコーディングはデコーダーのコンテキストとして使用され、出力空間でマルチモーダルをカバーする k 個の可能な軌道を生成します。

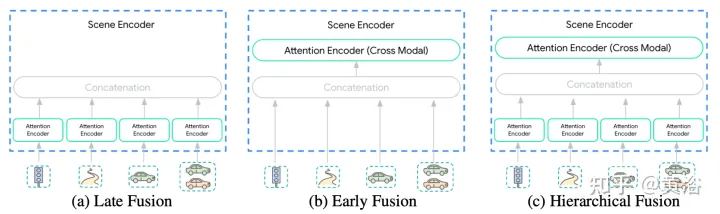

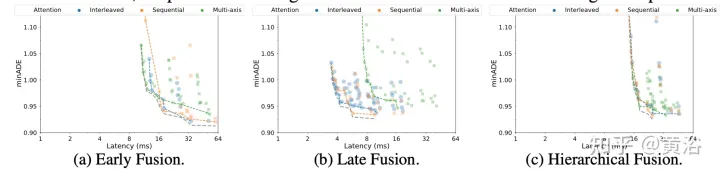

#シーン エンコーダへの入力は多様であるため、この統合は簡単な作業ではありません。モダリティは、同じ抽象化レベルまたはスケール ({ピクセル vs ターゲット オブジェクト}) で表現できない場合があります。したがって、一部のモダリティは他のモダリティよりも多くの計算を必要とする場合があります。モード間の計算による分解はアプリケーションに依存するため、エンジニアにとって非常に重要です。このプロセスを簡素化するために、ここでは、図に示すように、{post、pre、hierarchical} という 3 つの融合レベルが提案されています。

#Post-fusion はモーションです。予測 各モダリティが独自の専用エンコーダーを持つモデルへの最も一般的なアプローチ。これらのエンコーダーの幅を等しく設定すると、出力に余分な投影レイヤーが導入されるのを回避できます。さらに、すべてのエンコーダで同じ深さを共有することにより、探索スペースが管理可能なサイズに縮小されます。情報は、軌跡デコーダのクロスアテンション層のモダリティを越えて転送されることのみが許可されます。

プレフュージョンセルフアテンション エンコーダを各モダリティ専用にする代わりに、モダリティ固有のパラメータを投影層に減らします。図のシーン エンコーダは、単一のセルフ アテンション エンコーダ (「クロスモーダル エンコーダ」) で構成されており、ネットワークは誘導バイアスを最小限に抑えながら、モダリティ全体で重要性を割り当てる際に最大限の柔軟性を得ることができます。

階層的融合 最初の 2 つの極端な点の間の妥協点として、ボリュームはモダリティ固有のセルフ アテンション エンコーダとクロスモーダル エンコーダの間で階層的な方法で分解されます。ポストフュージョンで行われるように、幅と深さはアテンションエンコーダーとクロスモーダルエンコーダーで共有されます。これにより、シーン エンコーダの深さがモダリティ固有のエンコーダとクロスモーダル エンコーダに効果的に分割されます。

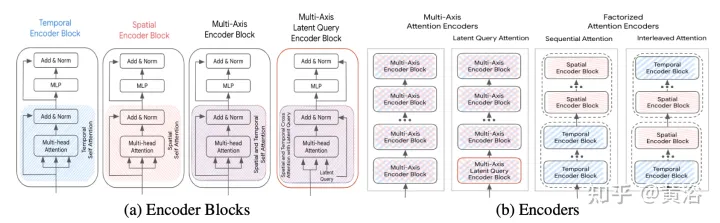

Transformer ネットワークは、次の 2 つの要因により、大規模な多次元シーケンスにはうまく拡張できません:

- (a) 自己注意は入力シーケンスの長さに対して 2 次です。 。

- (b) 位置フィードフォワード ネットワークは高価なサブネットワークです。

加速方法については以下で説明します (S は空間次元、T は時間領域次元です)。そのフレームワークは図に示すとおりです。

多軸アテンション:

多軸アテンション:

因数分解された注意:

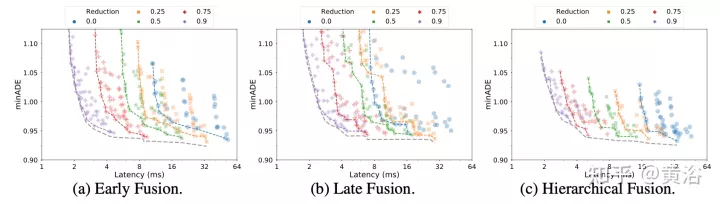

自己注意の計算複雑さは、入力シーケンスの長さの 2 乗です。多次元シーケンスでは、次元が追加されるたびに入力のサイズが乗算係数で増加するため、このことはさらに顕著になります。たとえば、一部の入力モダリティには時間と空間の次元があるため、計算コストは O(Sm2×T2) になります。この状況を軽減するには、注意を 2 つの次元に沿って分解することを検討してください。この方法は、入力シーケンスの多次元構造を利用し、各次元にセルフ アテンションを個別に適用することで、セルフ アテンション サブネットワークのコストを O(S2×T2) から O(S2) O(T2) に削減します。分解された注意は、多軸の注意と比較して計算量を削減できる可能性がありますが、自己注意を各次元の次数に適用すると複雑さが生じます。以下に 2 つの分解されたアテンション パラダイムを比較します。

シーケンシャル アテンション (シーケンシャル アテンション)- : N 層エンコーダは N/2 時間エンコーダ ブロックで構成され、もう 1 つの N/2 エンコーダ ブロックで構成されます。空間エンコーダブロックの。

- インターリーブされた注意 : N 層エンコーダーは、N/2 回交互する時間エンコーダー ブロックと空間エンコーダー ブロックで構成されます。

- 潜在クエリの注意

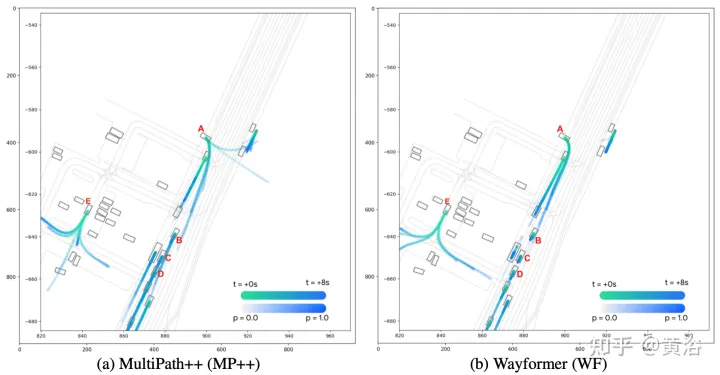

Wayformer 予測子は、エージェントがたどる可能性のある軌道を表すガウス混合を出力します。予測を生成するには、Transformer デコーダが使用されます。Transformer デコーダは、k 個の学習済み初期クエリ (Si) のセットを入力し、エンコーダのシーン エンベディングとのクロスアテンションを実行して、ガウス混合の各コンポーネントのエンベディングを生成します。

混合物に特定の成分が埋め込まれているとすると、線形射影層はその成分の非正準対数尤度を生成し、混合物全体の尤度を推定します。軌道を生成するには、別の線形レイヤー投影が使用され、各タイム ステップでの予測ガウスの平均および対数標準偏差に対応する 4 つの時系列が出力されます。 トレーニング中に、損失はそれぞれの分類損失と回帰損失に分解されます。 k 個の予測ガウスを仮定すると、真の軌跡の対数確率を最大化するように混合尤度がトレーニングされます。 予測器が複数のモードのガウス分布の混合を出力する場合、推論を行うのは難しく、ベンチマーク測定により考慮される軌道の数が制限されることがよくあります。したがって、評価プロセス中に軌跡の集約が適用され、元の出力混合の多様性を維持しながら、考慮されるモードの数が減ります。 実験結果は次のとおりです。分解メモ

潜在クエリ

以上がWayformer: 動き予測のためのシンプルで効果的なアテンション ネットワークの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7488

7488

15

15

1377

1377

52

52

77

77

11

11

19

19

40

40

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。