大規模な AI モデルの追求に資金を投じる大企業についてのファンと考え

この記事は Lei Feng.com から転載されたものです。転載する必要がある場合は、Lei Feng.com の公式 Web サイトにアクセスして許可を申請してください。

皆さんは、扇風機と石鹸の空箱の話を聞いたことがありますか?

有名な国際的急成長消費財メーカーがかつて石鹸の包装生産ラインを導入したとの噂ですが、この生産ラインには包装工程に欠陥があることが判明しました。石鹸、つまり、積み込まれていない箱がよくありました。顧客に空箱を販売することはできなかったので、オートメーション分野の博士研究員を雇って、石鹸の空箱を分別する計画を立てました。

博士研究員はすぐに十数人からなる技術チームを招集し、機械、オートメーション、マイクロエレクトロニクス、X線検出などの技術を総合的に活用し、90万ドルを投じて最終的に開発に成功しました。解決策としては、生産ラインの両側に 2 つの統合検出器を設置し、空の石鹸箱が通過するのを検知すると、ロボットが駆動して空の石鹸箱を押しのけます。

これは、実際の産業問題を解決するテクノロジーの実装における重要なブレークスルーであると言えます。

偶然にも、同じ時期に、中国南部の郷鎮企業も同じ生産ラインを購入しました。この問題を発見した上司は非常に怒り、従業員を工場に呼び、「この問題を解決する方法を考えてきてください。」と言いました。プレッシャーの下で、従業員はすぐに賢い計画を思いつきました。 190元。強力な扇風機を買って石鹸包装の生産ラインの横に置いたところ、生産ラインが回転した瞬間に風が強くなり、石鹸の空箱が現れるとすぐに吹き飛ばされました。

#ある小規模労働者は、その賢明な創造力でこの問題を迅速に解決し、業界で頻繁に取り上げられる#大きな目標、つまりコストの削減と効率の向上を達成しました。

業界における技術革新とインテリジェンスの意味は、この 2 つのスローガンにほかなりません。1 つはコストの節約であり、もう 1 つは効率の向上です。しかし、近年のAIの発展においては、学術でも産業界でも、大企業でも中小企業でも、資本の法則に違反するかのような「奇妙な」現象が起きています。民間企業か、国の資金による研究か。どの研究機関も大規模なモデルを「改良」するために多額の資金を費やしている。

サークル内の 2 つの声につながります:

1 つの声は、大規模なモデルがさまざまなタスクのベンチマークで強力なパフォーマンスを示していると述べました。将来の人工知能の発展の方向性は、性能と可能性でなければなりません。現時点での投資は、将来の時代の大きなチャンスを逃さないように準備することであり、トレーニングに数百万(またはそれ以上)を投資する価値があります。言い換えれば、大型モデルの優位性をつかむことが主な矛盾であり、高コストの投資が副次的な矛盾である。

AI テクノロジー実装の実際のプロセスにおいて、現在の大規模モデルの包括的な宣伝は、小規模モデルやその他の AI の方向性の研究リソースを奪うだけでなく、投資コストは高く、実際の産業問題を解決する際の費用対効果は低く、デジタル変革の文脈においてより多くの中小企業に利益をもたらすことはできません。

言い換えれば、「経済的な可用性」と「能力が強いかどうか」が、現実的な問題を解決するための AI アルゴリズムの 2 つの主要な焦点を構成します。今日、業界は、将来、AI があらゆる階層に力を与える「力」になるというコンセンサスに達しました。では、AIの大規模実装という観点から見ると、大型モデルと小型モデルではどちらが優れているのでしょうか?業界は本当にそれについて考えたのだろうか?

1 「ビッグ」モデルの登場近年、国内外の大手テクノロジー企業がAIの研究開発能力をアピールする声の中に、常に高周波のものです。語彙は「ビッグモデル」と表示されます。

この競争は外国のテクノロジー大手から始まります。 2018 年に Google は大規模な事前トレーニング済み言語モデル BERT を発表しました。大規模モデルの幕を開けた後、OpenAI は 2019 年と 2020 年に GPT-2 と GPT-3 を発表しました。2021 年には Google も後れを取ることなく、前者のスイッチトランス...

いわゆるモデルサイズ、主な測定指標はモデルパラメータのサイズです。モデルの「大きさ」とは、膨大な数のパラメーターを指します。

たとえば、BERT のパラメータ数は 2018 年に初めて 3 億個に達し、トップレベルの機械読解テスト SQuAD1.1 の 2 つの指標で人間を上回りました。 GLUE ベンチマークを 80.4% (絶対改善 7.6%) に押し上げ、MultiNLI 精度が 86.7% (絶対改善 5.6%) に達するなど、11 の異なる NLP テストで SOTA パフォーマンスを達成し、パラメーターの増加の影響を実証AI アルゴリズムのサイズ パフォーマンス向上の力。

OpenAIは、パラメータ量が15億個に達するGPT-2を次々とリリースし、GPT-3のパラメータ量は初めて1,000億個を超え、1,750億個に達しました。 Googleが2021年1月にリリースしたSwitch Transformerは、パラメータボリュームが1兆6000億で、初めて数兆に達した。

この厳しい状況に直面して、国内の大手メーカーや政府出資の研究機関さえも遅れをとることなく、大規模な精製モデルの成果を次々と発表しています。2021 年 4 月、アリババ DAMO アカデミーは中国語版をリリースしました。 270億パラメータの事前トレーニング済み言語モデル「PLUG」、4月にファーウェイと彭城研究所が2000億パラメータの「Pangu α」を共同リリース、6月に北京知源人工知能研究所が1兆7500億パラメータの「Enlightenment 2.0」をリリース; 9月、Baiduは100億のパラメータを備えた中国語と英語のバイリンガルモデルPLATO-Xをリリースした。

昨年10月までに、Alibaba Damo Academyはパラメータ数が10兆に達し、現在中国最大のAIモデルである「M6-10T」をリリースしました。アリババには及ばないものの、百度もモデルのパラメータ数の追求では大きく遅れをとっておらず、彭城研究所と共同で「百度文心」をリリースし、そのパラメータ数はPLATOの10倍である2600億に達した。 -バツ。

さらに、テンセントは大型モデル「Pai Daxing」を開発したとも述べていますが、パラメータの大きさは不明です。国内の大型モデル研究開発の主力企業には、一般的に注目を集めている大手AI研究開発企業に加えて、コンピューティングパワープロバイダーのInspur社も含まれており、昨年10月にパラメータ数が2000万人に達する大型モデル「Source 1.0」をリリースした。 2457億。総じて、2021年は中国の「大型モデル元年」と言えるだろう。

今年も大型モデルが引き続き人気です。当初、大規模なモデルは計算言語の分野に集中していましたが、現在では徐々にビジョン、意思決定に拡張され、その応用はタンパク質予測、航空宇宙などの主要な科学問題までカバーしています。Google、Meta、Baidu他の大手企業も同様の結果をもたらしています。一時期、パラメータが 1 億未満の AI モデルには音声がありませんでした。

パフォーマンスの超越であれ、タスクの拡張であれ、AI 大型モデルが本来の可能性を実証し、学術界と産業界に無限の想像力をもたらしたことは疑いの余地がありません。

研究実験により、データとパラメーターの量を増やすと、問題を解決する際のモデルの精度が効果的に向上することが示されました。 Googleが2021年にリリースした視覚伝達モデルBig Transferを例に挙げると、1,000カテゴリの128万枚の画像と18,291カテゴリの3億枚の画像の2つのデータセットをトレーニングに使用し、モデルの精度を77%から79%。

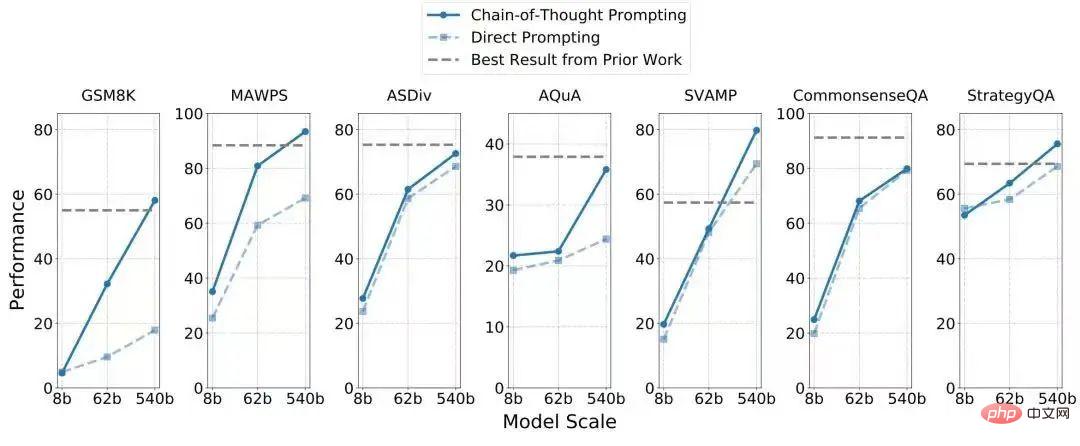

Google が今年発表した 5,400 億パラメータの一方向言語モデル PaLM を例に挙げると、これは Google が今年発表した新世代 AI フレームワークである Pathways に基づいています。 GPT-3のファインチューニングにより1,750億個のパラメータを追加し、推論能力が大幅に向上し、7つの算術問題・常識推論データセットにおいて、4つが現行のSOTAを上回り(下表参照)、唯一の8 つのサンプル (つまり、収集されたデータ) が使用されました。

視覚は知覚、言語は知性ですが、この 2 つは「因果推論」の克服において目覚ましい進歩を遂げたことはなく、因果推論この能力AIシステムの進化にとって非常に重要です。これは次のように理解できます。1 1=2 に基づいて 100 100=200 を導き出す子供の単純な能力は、機械システムには非常に複雑です。システムには因果推論の想像力が欠けているからです。機械が合理的な推論能力や想像力すら持たないとしたら、SF映画に出てくるような超知能ロボットの開発からは程遠いでしょう。大規模モデルの出現により、汎用人工知能 (AGI) の実現が可能になります。

したがって、大企業が大規模なモデルを推進するとき、多くの場合、それが複数のタスクを同時に解決し、複数のタスクで SOTA (現在の最高レベル) に到達できることを強調することがわかります。タスクのベンチマーク。例えば、Googleが今年発表した5,400億パラメータの言語モデルPaLMは、絵文字表現を通じてジョークを解釈したり映画を推測したりすることができ、Zhiyuanが発表した「Enlightenment 2.0」は、チェス、書道、絵画に堪能な仮想学生Hua Zhibingを育成できる。 。

つまり、大型モデルには多くの場合、多用途でさまざまな帽子をかぶることができるという 1 つの特徴があります。これは、複雑なシナリオの課題を解決するために重要です。

「小さなモデルにはパラメータの数が少なく、単一のタスクに限定されています。一方、大きなモデルの(利点は)人間が遊び方を学ぶときに学ぶ知識のようなものです」卓球。バドミントンには補助効果があります。大きなモデルのタスク間には一般化があります。新しいタスクに直面するとき、小さなモデルには数千または数万のトレーニング データが必要になる可能性がありますが、大きなモデルには 1 つのトレーニング データしか必要ありません。西湖大学の深層学習研究室長、Lan Zhenzhong 氏は Leifeng.com-AI Technology Review にこう説明しました。

対話システムの研究を例に挙げてみましょう。対話システムは主に 2 つのカテゴリに分類され、1 つはユーザーがタスクを割り当て、AI システムがそれを自動的に実行する (航空券の迅速な予約や映画のチケットの購入など) タスクベースの対話、もう 1 つはオープン型の対話です。映画「Her」(Her) などの対話は、あらゆるトピックについて人間とコミュニケーションを図ることができ、ユーザーに感情移入さえできる架空のロボットです。このうち後者の能力レベルは明らかに高く、研究開発もより困難である。前途には霧が多く、どのような課題に直面するかわかりません。現時点では、大型モデル自体が豊富な「能力パッケージ」と新しいタスクにおける並外れたパフォーマンスを備えており、その戦闘効率は明らかに優れています。小型モデルよりも優れています。

Lan Zhenzhong 氏は、現在、学界や産業界の AI 研究者が大規模モデルの多くの特性を完全には把握していないと指摘しました。例えば、前世代の GPT-3 から今世代の Instruct GPT に比べて、質的に飛躍していることがわかりますし、これも大規模なモデルですが、コマンドを受け付けたときの Instruct GPT の効果がはるかに優れています。これは、大規模なモデルを研究する場合にのみ体験できます。

パラメータの数が増えると、AI モデルのパフォーマンスはどうなるでしょうか? これは徹底的な調査が必要な科学的問題です。したがって、大規模モデルの研究に投資を続ける必要があります。

2 理想は遠くても、現実はすぐ近くです。

人間が進歩したいなら、誰もいないところへあえて行く人が必ずいるはずですは。

しかし、現実の世界では、星や海という理想を誰もが手に入れることができるわけではありません。直面している問題を迅速、簡単、費用対効果の高い方法で解決したいと願う人が増えています。問題は。最終的に、AI アルゴリズムを実装するには、技術の研究開発の投入と生産の比率を考慮する必要があります。この時点で、大型モデルの欠点が明らかになり始めます。

#無視できない残酷な事実は、大規模なモデルの計算が遅く、トレーニング コストが非常に高いということです。

一般的に、モデルのパラメーターの数が増えると、マシンの実行が遅くなり、計算コストが高くなります。外国メディアの開示によると、OpenAIは1750億個のパラメータを含むGPT-3のトレーニングに500万米ドル(約3500万人民元)近くを費やした。 Google は、5,400 億のパラメーターを含む PaLM をトレーニングする際に 6,144 個の TPU を使用しましたが、熱心なネットユーザーの統計によると、一般の人が PaLM をトレーニングするのにかかる費用は 900 万ドルから 1,700 万ドルの間です。これは単なる計算能力のコストです。

国内の大手メーカーは、大規模モデルのトレーニングにかかる経済的コストを明らかにしていませんが、既存の世界的に共有されているコンピューティング手法とリソースに基づくと、コンピューティング支出はそれほど大きな差はないはずです。 GPT-3 と PaLM はどちらも数千億ドルにすぎませんが、パラメータが数兆を超える大規模モデルのコストは驚異的なものに違いありません。大手メーカーが研究開発に十分に寛大であれば、大型モデルへの投資コストが「障害」になることはないが、資本がAIに対して慎重になっている現在、一部の新興企業や政府出資の研究機関は依然として賭けを続けている。大きなモデルに重点を置いているため、少し魔法のように思えます。

大規模モデルのコンピューティング能力に対する高い要件により、企業間の技術力の競争は金銭の競争に変わりました。長期的には、アルゴリズムが高消費商品になると、最先端の AI は少数の人しか利用できない運命にあり、その結果、包囲と囲い込みの独占状況が生じます。つまり、汎用人工知能がいつか登場したとしても、すべてのユーザーに恩恵をもたらすわけではないということです。

同時に、この路線では、中小企業のイノベーション力が圧迫されることになります。大規模なモデルを構築するには、中小企業は大手メーカーと協力して巨人の肩に乗らなければなりません(ただし、これはすべての小規模工場ができることではありません)、または多額の投資をして財務を準備する必要があります(ただし、資本の面では、寒い冬にはこれは現実的ではありません)。

#入力を計算した後、出力を計算します。残念ながら、現在大型モデルを改良している企業は、大型モデルがどれだけの経済的利益を生み出しているかを明らかにしていません。しかし、こうした大規模なモデルが問題解決のために次々と実装され始めていることは公開情報からも知られており、例えば、Alibaba Damo Academy が兆パラメータモデル M6 をリリースした後、その画像生成機能はすでに支援できると述べています。 M6 のコピーライティング生成能力を借りて作成されたコピーライティングは、モバイル タオバオ、アリペイ、アリババ シャオミでも使用されています。探索の初期段階にある大規模モデルの場合、短期的な収益を重視するのは厳しすぎます。しかし、私たちはまだ次の質問に答えなければなりません:

それがビジネス界であれ学術界であれ、大規模なモデルに賭けるとき、それは将来支配的になる可能性のある技術的な方向性を見逃さないためなのか、それともそれがあらゆる問題をよりよく解決できるからなのか既知の問題はありますか? 前者は学術的な探求の色彩が強いですが、後者は問題解決に AI テクノロジーを適用する業界の先駆者にとっての本当の関心事です。 この大規模モデルは、Google の BERT リリースによって開始されましたが、これは混沌としたオープンマインドなアイデアでした。BERT 実験以前、Google Brain の技術チーム は既知の現実の問題を中心に開発されていませんでした。モデル 、当時最大のパラメーター数 (3 億) を備えたこの AI モデルが結果に大幅な改善をもたらすとは予想していませんでした。同様に、OpenAI が Google を真似て GPT-2 と GPT-3 を開発したとき、特定のタスクはありませんでしたが、開発が成功した後、全員が GPT-3 でのタスクの効果をテストしたところ、すべての指標が改善されたことがわかりました。 . ただただ驚きました。現在の GPT-3 はプラットフォームのようなもので、何千ものユーザーによって使用されています。 しかし、時間が経つにつれて、大規模モデルの開発は、特定の実際的な問題を解決するという本来の目的に必然的に回帰します。たとえば、今年 Meta によってリリースされた大規模タンパク質予測モデル ESMFold 、Baidu はすぐに 以前にリリースされた大型航空宇宙モデル。 GPT-3 のような初期の大規模モデルが、パラメータ数の増加がアルゴリズムのパフォーマンスに与える影響を調査することを主な目的としており、純粋に「未知のものを導く未知のもの」であったとすれば、現在の大規模モデルは、スケール モデルの研究は、現実の問題を解決し、起業家的価値を生み出すという、より複雑で明確な目標を反映し始めています。 現時点では、大規模モデル開発の指針は研究者の意志からユーザーのニーズに変わります。一部の非常に小さな要件 (ナンバー プレート認識など) では、大きなモデルでも問題を解決できますが、高価なトレーニング コストのため、「大ハンマーで豚を殺す」ようなもので、必ずしもパフォーマンスが優れているとは限りません。 。つまり、数千万のコストをかけて数点の精度向上を得ると、価格性能比は非常に低くなってしまいます。 業界関係者は Leifeng.com-AI Technology Review に対し、ほとんどの場合、感情分析やニュース概要など、既知の実際的な問題を解決するためのテクノロジーを研究していると語った。 、実際に研究するための特別な小さなタスクを設計することができ、結果として得られる「小さなモデル」の効果は、GPT-3 などの大きなモデルの効果よりも簡単に優れています。一部の特定のタスクであっても、大規模なモデルは「使用できません」。 したがって、AI の開発を推進する過程では、大きなモデルと小さなモデルの組み合わせが避けられません。大型モデルの研究開発の敷居は非常に高いため、目に見える将来的には、経済的に入手可能で正確な攻撃が可能な小型モデルがAIの大規模実装という重要なタスクを担う主力となるでしょう。 大規模モデルを研究している一部の科学者でさえ、大規模モデルは同時に多くのタスクを実行できるが、「一般的な人工知能について話すときは、情報を得るにはまだ時期尚早です。」大規模モデルは最終目標を達成するための重要な方法かもしれませんが、理想はまだ遠く、AI はまず現状を満足させる必要があります。 実際、AI モデルがますます大規模化する現象に対応して、学界や産業界の一部の研究者は実装上の利点と欠点に気づき、積極的に対策を開発しています。 テクノロジーが人々に社会の変化についてどのような啓蒙をもたらしたかについて話したい場合、必ず言及される重要なことの 1 つは、「敷居をいかに下げるか」です。 (技術的にもコスト的にも)技術製品の価値を高めるには、より多くの人がこのテクノロジーの恩恵を享受できるようにすることによってのみ、その影響力を拡大することができます。 大規模なモデルに切り替える場合、核となる矛盾は、トレーニング速度を向上させる方法、トレーニング コストを削減する方法、または新しいアーキテクチャを提案する方法です。コンピューティング リソースの使用だけを見てみると、大規模モデルのジレンマは実際のところ目立ったものではありません。今年 6 月末にオープン エンジニアリング アライアンス MLCommons によって発表された MLPerf ベンチマークの最新のトレーニング結果によると、今年の機械学習システムのトレーニング速度は昨年のほぼ 2 倍であり、ムーアの法則 (18 年ごとに 2 倍) を超えています。 -24か月)。 実際、さまざまなサーバーの更新と反復、およびクラウド コンピューティングなどの新しい手法の出現により、コンピューティングは加速し、エネルギー消費は削減されています。たとえば、GPT-3 はわずか 2 年前に発売されましたが、開発した OPT モデルに基づくメタの計算は、2020 年の 1/7 に削減されました。さらに、最近の記事では、2018 年にはトレーニングに数千の GPU が必要だった大規模モデル BERT が、現在では 1 枚のカードで 24 時間でトレーニングできるようになり、通常の実験室で簡単にトレーニングできるようになったことが示されました。 コンピューティング能力を取得するボトルネックはもはや存在しません。唯一の障害は取得コストです。 近年、一部の研究者は、コンピューティング能力のみに依存することに加えて、大規模モデルの特性のみに基づいて、大規模モデルの「経済的な可用性」を実現する別の方法を見つけたいと考えています。モデルとアルゴリズム自体。 アプローチの 1 つは、データ中心の「次元削減」です。 最近、DeepMind は研究 (「コンピューティングに最適な大規模言語モデルのトレーニング」) を研究し、同じ計算量で、モデルのトレーニング データが数ではなく大きくなるということを発見しました。モデルのパラメータを拡大します。モデルを単に拡大するよりも拡大すると、より良い結果が得られます。 この DeepMind の調査では、データを最大限に活用した 700 億のパラメーター モデルである Chinchilla が、一連の下流タスクの評価において 1,750 億のパラメーター GPT-3 と 2,800 を上回りました。数十億のパラメータを使用します。 Lan Zhenzhong 氏は、チンチラが勝てた理由を、トレーニング中にデータを拡張して 2 倍にし、その後 1 回だけ計算したためであると説明しました。 もう 1 つの方法は、アルゴリズムとアーキテクチャの革新に頼って、大規模なモデルを「軽量化」することです。 Microsoft Research Asia の元副社長であり、現在は Lanzhou Technology の創設者である Zhou Ming は、このトラックのファンです。 起業家としての周明さんのアイデアは、お金を節約するという非常に「義務」です。同氏は、多くの大企業が現在、大規模モデルを追求していると指摘し、まず第一に、彼らは先を争っていること、第二に、自社のコンピューティング能力、特にクラウドサービスの能力を表現したいと考えていることを指摘した。誕生したばかりの小さな会社である蘭州科技は、AI を使用して価値を生み出すという夢を持っていますが、強力なクラウド機能を備えておらず、燃やすのに十分な資金もありません。そこで、Zhou Ming 氏は当初、モデル アーキテクチャを調整する方法を考えていました。知識を抽出し、大型モデルを顧客が使用できる「軽量モデル」に変換します。 同社が昨年7月に発売した軽量モデル「Mencius」は、このアイデアの実現可能性を証明した。 「孟子」のパラメータは 10 億個しかありませんが、中国語理解評価リスト CLUE でのパフォーマンスは、BERTSG や Pangu などのパラメータレベルが数百億、さらには数千億の大型モデルを上回っています(下表)。同じアーキテクチャ下では、モデルのパラメータ数が多いほどパフォーマンスが向上するというのがこの分野のコンセンサスですが、「孟子」の創意工夫はアーキテクチャの革新にあります。 学界では、つい最近、カリフォルニア大学バークレー校のマー・イー教授、沈祥陽、曹英が共同で研究を発表しました( 「知性の出現のための倹約と自己一貫性の原則について」) は、大規模モデルがますます大きくなっている技術的理由を理論的に分析しています。つまり、ディープ ニューラル ネットワークは本質的に「開ループ」システムです。分類に使用される識別モデルとサンプリングまたは再生に使用される生成モデルのトレーニングはほとんどの場合分離されているため、パラメーターのトレーニングが非効率になり、モデルのパフォーマンスを向上させる唯一の方法はヒープ パラメーターとヒープに依存することになります。コンピューティング能力。 この目的のために、彼らが提案した「改革」方法はより徹底的であり、識別モデルと生成モデルを組み合わせて完全な「圧縮された」閉ループシステムを形成するというものです。そのため、AI モデルは独立して学習でき、より効率的かつ安定し、新しい環境で発生する可能性のある新しい問題に直面した場合に、より強い適応性と応答性を備えます。言い換えれば、AI分野の研究者がこのルートに沿ってモデルを開発できれば、モデルのパラメータの大きさは大幅に減少し、「小さくて美しい」という道に戻り、大きなモデルの「未知のことを解決する」能力が回復するでしょう。問題」も達成できます。 経済的な可用性の実現という点では、AutoML または AutoAI を使用してモデル トレーニングの難しさを解決し、AI アルゴリズムの研究の敷居を下げ、アルゴリズム エンジニアが作業できるようにすることを支持する声さえあります。 AI 以外の専門家も、自分のニーズに応じて単一機能のモデルを柔軟に作成し、無数の小さなモデルを形成することができ、単一の火花が大草原の火災を引き起こす可能性があります。 この声は「需要」の観点からのものであり、密室に反対します。 たとえば、識別、検出、位置特定には視覚的なアルゴリズムが使用されますが、その中でも煙と花火の識別要件は異なるため、それらを可能にするプラットフォームまたはツールを提供します。煙認識と花火認識のそれぞれのビジュアルアルゴリズムをより高精度かつ迅速に生成でき、シナリオ間の「普遍性」や「一般化」を追求する必要がありません。このとき、ピアノ、チェス、書道、絵画のすべてに習熟した大きなモデルを、それぞれピアノ、チェス、書道、絵画に習熟した無数の小さなモデルに分割することで、問題を解決することもできます。 と書いて、空の石鹸皿を扇風機で吹き飛ばした話に戻ります。 AI テクノロジーを使用して現実世界の問題を解決する場合、大きなモデルと小さなモデルはポスドクの自動化ソリューションと小さな作業員の扇風機のようなものです。小さな問題を解決する場合、前者は冗長で面倒に見えますが、扇風機ほど速くはありませんが、ポスドクとそのチームが提供する価値を否定する人はほとんどいないし、ましてやポスドクを「排除」する人もいないでしょう。それどころか、技術研究開発の合理性を強調する理由は何百も挙げることができます。 しかし多くの場合、技術研究者は問題解決において小規模労働者の知恵を無視することが多く、テクノロジーの利点に限定されるのではなく、実際の問題から出発します。この観点から、大型モデルの研究には最先端をリードするという本質的な価値がありますが、コスト削減と効率向上という「経済的に使用できる」という目標も考慮する必要があります。 研究自体の話に戻ると、Lan Zhenzhong 氏は、大規模モデルに関する多くの結果があるにもかかわらず、オープンソースが非常に少なく、一般の研究者がアクセスできるのが限られており、これは非常に残念であると述べました。 大規模モデルはオープンソースではないため、一般のユーザーは需要の観点から大規模モデルの実用性を評価できません。実際、私たちは以前にいくつかのオープンソースの大規模モデルで実験を行ったところ、社会倫理と感情を理解する際の大規模言語モデルのパフォーマンスが非常に不安定であることがわかりました。 一般に公開されていないため、大手メーカーによる自社の大型モデルの導入も学術的な指標にとどまり、シュレーディンガーと同様のジレンマが生じます。内容から真偽を判断する方法はなく、一言で言えば、すべての最終決定権は彼らにあります。最後に、大規模な AI モデルがより多くの人々に実際に利益をもたらすことを願っています。

3 AI モデルはますます大きくなる必要がありますか?

4 最後に

以上が大規模な AI モデルの追求に資金を投じる大企業についてのファンと考えの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1423

1423

52

52

1317

1317

25

25

1268

1268

29

29

1243

1243

24

24

CでDMA操作を理解する方法は?

Apr 28, 2025 pm 10:09 PM

CでDMA操作を理解する方法は?

Apr 28, 2025 pm 10:09 PM

CのDMAとは、直接メモリアクセステクノロジーであるDirectMemoryAccessを指し、ハードウェアデバイスがCPU介入なしでメモリに直接データを送信できるようにします。 1)DMA操作は、ハードウェアデバイスとドライバーに大きく依存しており、実装方法はシステムごとに異なります。 2)メモリへの直接アクセスは、セキュリティリスクをもたらす可能性があり、コードの正確性とセキュリティを確保する必要があります。 3)DMAはパフォーマンスを改善できますが、不適切な使用はシステムのパフォーマンスの低下につながる可能性があります。実践と学習を通じて、DMAを使用するスキルを習得し、高速データ送信やリアルタイム信号処理などのシナリオでその効果を最大化できます。

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用すると、時間と時間の間隔をより正確に制御できます。このライブラリの魅力を探りましょう。 CのChronoライブラリは、時間と時間の間隔に対処するための最新の方法を提供する標準ライブラリの一部です。 Time.HとCtimeに苦しんでいるプログラマーにとって、Chronoは間違いなく恩恵です。コードの読みやすさと保守性を向上させるだけでなく、より高い精度と柔軟性も提供します。基本から始めましょう。 Chronoライブラリには、主に次の重要なコンポーネントが含まれています。STD:: Chrono :: System_Clock:現在の時間を取得するために使用されるシステムクロックを表します。 STD :: Chron

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

交換に組み込まれた量子化ツールには、1。Binance:Binance先物の定量的モジュール、低い取り扱い手数料を提供し、AIアシストトランザクションをサポートします。 2。OKX(OUYI):マルチアカウント管理とインテリジェントな注文ルーティングをサポートし、制度レベルのリスク制御を提供します。独立した定量的戦略プラットフォームには、3。3Commas:ドラッグアンドドロップ戦略ジェネレーター、マルチプラットフォームヘッジアービトラージに適しています。 4。Quadency:カスタマイズされたリスクしきい値をサポートするプロフェッショナルレベルのアルゴリズム戦略ライブラリ。 5。Pionex:組み込み16のプリセット戦略、低い取引手数料。垂直ドメインツールには、6。cryptohopper:クラウドベースの定量的プラットフォーム、150の技術指標をサポートします。 7。BITSGAP:

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでのハイDPIディスプレイの取り扱いは、次の手順で達成できます。1)DPIを理解してスケーリングし、オペレーティングシステムAPIを使用してDPI情報を取得し、グラフィックスの出力を調整します。 2)クロスプラットフォームの互換性を処理し、SDLやQTなどのクロスプラットフォームグラフィックライブラリを使用します。 3)パフォーマンスの最適化を実行し、キャッシュ、ハードウェアアクセラレーション、および詳細レベルの動的調整によりパフォーマンスを改善します。 4)ぼやけたテキストやインターフェイス要素などの一般的な問題を解決し、DPIスケーリングを正しく適用することで解決します。

Cのリアルタイムオペレーティングシステムプログラミングとは何ですか?

Apr 28, 2025 pm 10:15 PM

Cのリアルタイムオペレーティングシステムプログラミングとは何ですか?

Apr 28, 2025 pm 10:15 PM

Cは、リアルタイムオペレーティングシステム(RTOS)プログラミングでうまく機能し、効率的な実行効率と正確な時間管理を提供します。 1)Cハードウェアリソースの直接的な動作と効率的なメモリ管理を通じて、RTOのニーズを満たします。 2)オブジェクト指向の機能を使用して、Cは柔軟なタスクスケジューリングシステムを設計できます。 3)Cは効率的な割り込み処理をサポートしますが、リアルタイムを確保するには、動的メモリの割り当てと例外処理を避ける必要があります。 4)テンプレートプログラミングとインライン関数は、パフォーマンスの最適化に役立ちます。 5)実際のアプリケーションでは、Cを使用して効率的なロギングシステムを実装できます。

Cで文字列ストリームを使用する方法は?

Apr 28, 2025 pm 09:12 PM

Cで文字列ストリームを使用する方法は?

Apr 28, 2025 pm 09:12 PM

Cで文字列ストリームを使用するための主な手順と予防策は次のとおりです。1。出力文字列ストリームを作成し、整数を文字列に変換するなどのデータを変換します。 2。ベクトルを文字列に変換するなど、複雑なデータ構造のシリアル化に適用します。 3.パフォーマンスの問題に注意を払い、大量のデータを処理するときに文字列ストリームを頻繁に使用することを避けます。 std :: stringの追加方法を使用することを検討できます。 4.メモリ管理に注意を払い、ストリングストリームオブジェクトの頻繁な作成と破壊を避けます。 std :: stringstreamを再利用または使用できます。

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスの測定は、標準ライブラリのタイミングツール、パフォーマンス分析ツール、およびカスタムタイマーを使用できます。 1.ライブラリを使用して、実行時間を測定します。 2。パフォーマンス分析にはGPROFを使用します。手順には、コンピレーション中に-pgオプションを追加し、プログラムを実行してGmon.outファイルを生成し、パフォーマンスレポートの生成が含まれます。 3. ValgrindのCallGrindモジュールを使用して、より詳細な分析を実行します。手順には、プログラムを実行してCallGrind.outファイルを生成し、Kcachegrindを使用して結果を表示することが含まれます。 4.カスタムタイマーは、特定のコードセグメントの実行時間を柔軟に測定できます。これらの方法は、スレッドのパフォーマンスを完全に理解し、コードを最適化するのに役立ちます。

MySQLにデータを挿入する効率的な方法

Apr 29, 2025 pm 04:18 PM

MySQLにデータを挿入する効率的な方法

Apr 29, 2025 pm 04:18 PM

MySQLでデータを挿入するための効率的な方法には、次のものが含まれます。1。insertInto ...値構文、2。LoadDatainFileコマンドの使用、3。トランザクション処理の使用、4。バッチサイズの調整、5。Insurtignoreまたは挿入の使用...