メタ研究者がロボットの視覚操作を可能にする人工視覚野を作成

Meta Corporation の AI 研究部門の研究者は最近、ロボットの適応スキル調整と視覚野の複製における重要な進歩を発表する発表を行いました。これらの進歩により、現実世界からデータを取得することなく、AIを搭載したロボットが視覚を通じて現実世界で動作できるようになったという。

これは、人間の介入なしで動作し、現実世界と対話できる汎用の「身体型 AI」ロボットの作成における大きな進歩であると彼らは主張しています。研究者らはまた、世界中の何千人もの研究参加者の日常活動を記録するEgo4Dデータセットで訓練された「VC-1」と呼ばれる人工視覚野を作成したとも述べた。

研究者らが以前に公開したブログ投稿で説明したように、視覚野は生物が視覚を動きに変換できるようにする脳の領域です。したがって、人工視覚野を持つことは、目の前のシーンに基づいてタスクを実行する必要があるロボットにとって重要な要件です。

「VC-1」の人工視覚野は、さまざまな環境でさまざまな感覚運動タスクを適切に実行する必要があるため、研究参加者が含まれる Ego4D データセットは特に重要な役割を果たします。ユーザーはウェアラブルを使用します。カメラを使用して、料理、掃除、運動、工作などの日常の活動を何千時間ものビデオで記録します。

研究者らは次のように述べています:「生物には普遍的な視覚野があり、それが私たちが探している具現化エージェントです。したがって、私たちはEgo4Dを中核として、複数のタスクでうまく機能するデータセットの作成に着手しました」 「Ego4D は料理、園芸、工芸などの日常的な活動に主に焦点を当てているため、家やアパートを探索する自己中心的なビデオのデータセットも採用しました。」

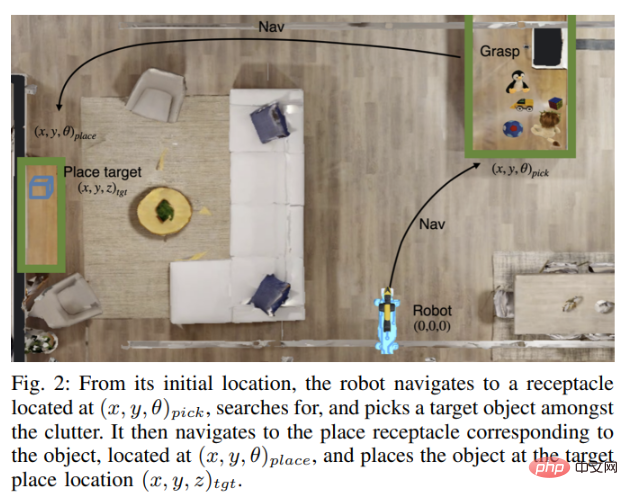

ただし、視覚野は「具体的な AI」の一要素にすぎず、ロボットが現実世界で完全に自律的に動作するには、現実世界の物体を操作できなければなりません。ロボットは、物体をナビゲートし、見つけて運び、別の場所に移動し、正しく配置するために視覚を必要とします。これらすべての動作は、見聞きしたことに基づいて自律的に実行されます。

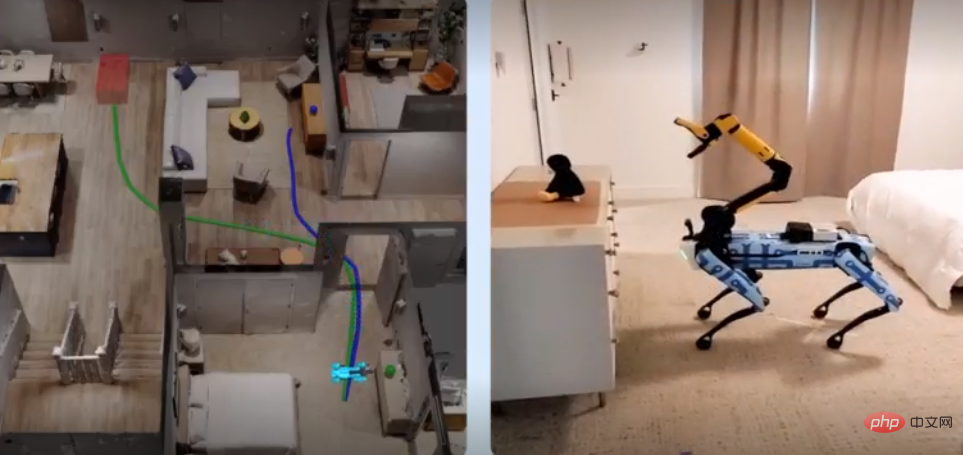

この問題を解決するために、Meta の AI 専門家はジョージア工科大学の研究者と協力して、ロボットがトレーニングをシミュレートし、これらのスキルを現実世界に再現するために使用するアダプティブ スキル コーディネーション (ASC) と呼ばれる新しいテクノロジーを開発しました。ロボット。

Meta は、Boston Dynamics とも協力して、ASC テクノロジーの有効性を実証しました。両社は、ASC テクノロジーとボストン ダイナミクスの Spot ロボットを組み合わせて、同社のロボットに強力なセンシング、ナビゲーション、および操作機能を提供しましたが、それには人間の大幅な介入も必要でした。たとえば、オブジェクトを選択するには、誰かがロボットのタブレットに表示されているオブジェクトをクリックする必要があります。

研究者らは記事の中で次のように書いています:「私たちの目標は、Boston Dynamics API を介してオンボードセンシングとモーターコマンドから世界を認識できる AI モデルを構築することです。」

スポットロボットテストはこの実験は、HM3D および 1,000 軒を超える住宅の屋内 3D スキャン データを含む ReplicaCAD データセットで構築されたシミュレーション環境である Habitat シミュレーターを使用して実施されました。その後、Spot ロボットは、これまで見たことのない家の周りを移動し、物体を運び、適切な場所に配置するように訓練されました。訓練されたスポット ロボットによって得られた知識と情報は、現実世界で動作するスポット ロボットに複製され、家のレイアウトに関する知識に基づいて同じタスクを自動的に実行します。

私たちは、家具完備の 185 平方メートルのアパートと 65 平方メートルの大学の研究室という 2 つの非常に異なる現実世界の環境を使用しました。 「さまざまなアイテムの再配置が必要でした。全体として、ASC テクノロジーを搭載した Spot ロボットは、ほぼ完璧に動作し、60 回のテスト中 59 回成功し、ハードウェアの不安定性、ピッキングの失敗、移動を克服しました。障害物や経路の遮断などの敵対的な干渉も克服しました。」とメタ研究者は述べています。 VC-1 モデルのソース コードも公開し、モデル サイズのスケーリング方法を別の論文で共有したこと、データ セット サイズなどの詳細についても説明しました。それまでの間、チームの次の焦点は、VC-1 と ASC を統合して、より人間に近い表現型 AI システムを作成することです。

以上がメタ研究者がロボットの視覚操作を可能にする人工視覚野を作成の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7451

7451

15

15

1374

1374

52

52

77

77

11

11

14

14

9

9

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

概要:Vue.js文字列配列をオブジェクト配列に変換するための次の方法があります。基本方法:定期的なフォーマットデータに合わせてマップ関数を使用します。高度なゲームプレイ:正規表現を使用すると、複雑な形式を処理できますが、慎重に記述して考慮する必要があります。パフォーマンスの最適化:大量のデータを考慮すると、非同期操作または効率的なデータ処理ライブラリを使用できます。ベストプラクティス:コードスタイルをクリアし、意味のある変数名とコメントを使用して、コードを簡潔に保ちます。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。