清華大学の Ou Zhijian 教授への独占インタビュー。ChatGPT のオーラと今後の課題について詳しく分析しています。

2022 年 11 月末に ChatGPT が開始されると、世界中の注目を集め、その人気は今も根強く残っています。検索エンジンの代替、特異点、変曲点、いくつかの職業が失業危機に直面し、人類は究極の課題に直面しています...このようなホットなトピックに直面して、この記事は私たちの理解を共有し、議論と修正を歓迎します。

一般的に、ChatGPT は技術的に大きな進歩を遂げており、 欠点 があるにもかかわらず、AGI (汎用人工知能、汎用人工知能、汎用人工知能) に向かって進んでいます。人工知能) にはまだ多くの 課題 がたくさんあります!

##図 1: https://openai.com/blog/chatgpt/ Web ページのスクリーンショット

##図 1: https://openai.com/blog/chatgpt/ Web ページのスクリーンショット

まずは、チャットボットにも関係するAI研究におけるEliza Effect

(エリザ効果)についてご紹介します。イライザ効果とは、人々が機械の結果を過剰に解釈し、本来持っていなかった意味を読み取ってしまうということです。人間には、特に人間が新しい現象を十分に理解していない場合に、自然現象が人間の行動に似ていると無意識のうちに信じてしまう心理的傾向があり、これを心理学では人間の擬人化(擬人化)と呼びます。例えば、昔の人々は、雷は空に住む雷神によって引き起こされ、雷神が怒ると雷が鳴ると信じられていました。

「Eliza」という名前は、1966 年に MIT のコンピューター科学者ジョセフ ワイゼンバウムによって開発されたチャット ロボットに由来しています。チャットボット Eliza は心理カウンセラーとして設計されました。賢い Eliza プロジェクトは予想外の成功を収めました。その効果は当時のユーザーに衝撃を与え、センセーションを巻き起こしました。しかし、実際には単純なルール文法に基づいた巧妙なアプリケーションにすぎませんでした。

ChatGPT の原理をある程度理解していれば、ChatGPT を理解する際に Eliza 効果を減らすことができるはずです。正しい判断があってこそ、私たちは健康で広範囲に及ぶことができます。この目的を達成するために、私たちは厳密であるよう努め、読者がさらに理解できるよう参考資料を提供します。以下は 3 つのパートに分かれています:

ChatGPT の進歩

- ChatGPT の欠点

- AGI への挑戦

個人ホームページ: http://oa.ee.tsinghua.edu .cn /ouzhijian

著者: Ou Zhijian、清華大学電子工学部准教授兼博士指導教員。 IEEE Audio Speech Language Journal (TASLP) の副編集長、Computer Speech & Language の編集委員、IEEE Speech Language Technical Committee (SLTC) のメンバー、IEEE Speech Technology (SLT) 2021 Conference の議長、China Computer の著名会員を歴任。連盟(CCF)および言論・公聴会の特別委員会委員等彼はこれまでに 100 本近くの論文を発表し、3 つの州賞および大臣賞を受賞し、国内外の優れた論文賞を数多く受賞しています。ランダムフィールド言語モデル、離散潜在変数モデルの学習アルゴリズム、エンドツーエンド対話モデルとそれらの半教師あり学習に関する基礎的な独自研究を実施しました。

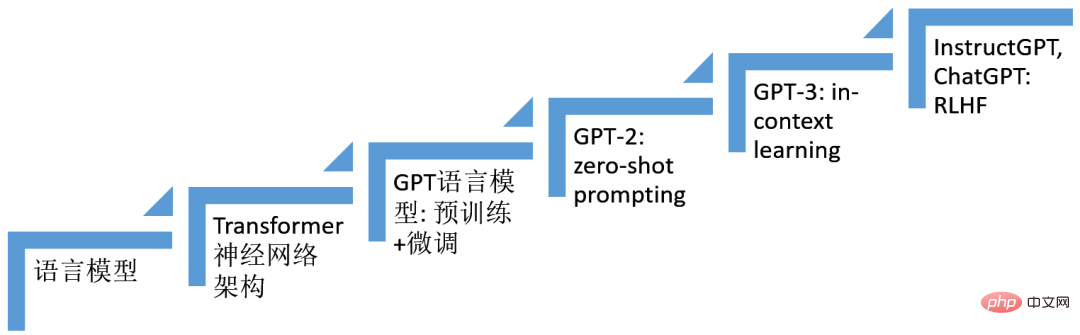

01 ChatGPT の進歩ChatGPT の進歩は、長年にわたって人工知能研究、特に深層学習技術の巨人の肩の上に立っています。多層ニューラルネットワーク技術の使用。 ChatGPTのシステム構築において重要な役割を果たすいくつかの技術を以下の図に示すように整理しました。

これらのテクノロジー (6 つのステップ) を組み合わせた結果、ChatGPT が誕生しました。ChatGPT のモデル スケルトンは、Transformer ニューラル ネットワーク アーキテクチャに基づく自己回帰言語モデル (

言語モデル) です。ファインチューニングに基づく技術 (finetuning)、Prompt (プロンプト) に基づく技術、状況学習 (インコンテキスト学習)、人間のフィードバックからの強化学習( RLHF) テクノロジーは徐々に発展し、最終的に ChatGPT の誕生につながりました。

図 2: ChatGPT の進捗状況

1. 言語モデル (LM、言語モデル)

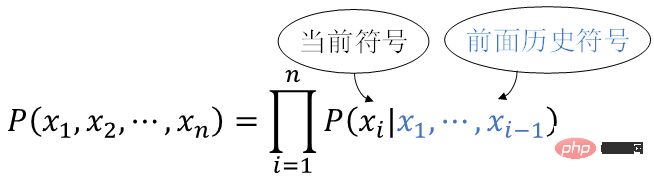

言語モデルは人間の自然言語の確率モデルです。人間の自然言語は文であり、文は自然言語記号のシーケンスです #xx1,x2,…,xn, subject確率分布への変換

確率論の乗算公式を使用すると、

を得ることができます。

を得ることができます。

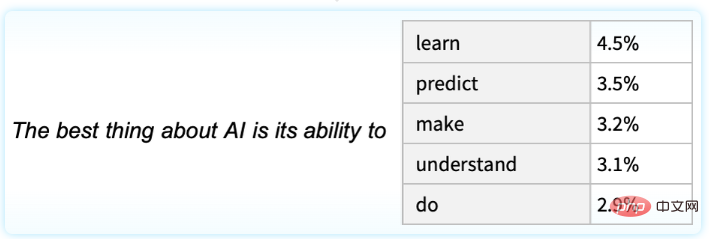

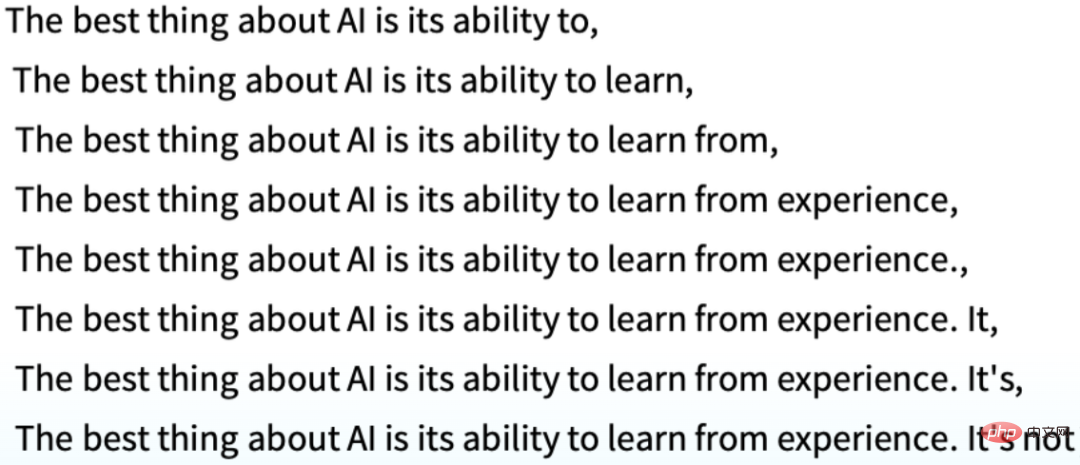

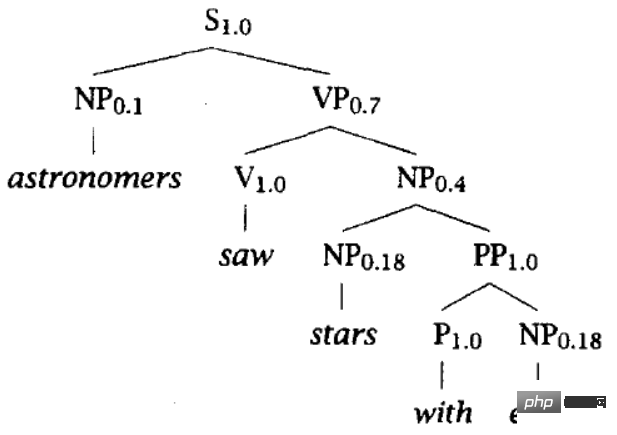

これを左から右に並べます、各位置には以前の 歴史的シンボルが使用されますx1,x2,…,x i-1 (つまり上記)、現在のシンボルが出現する (条件付き) 確率を計算します P(xi | x1,… ,x i-1) のモデルは 自己回帰言語モデル と呼ばれ、非常に自然であり、上記の条件を考慮して現在のシンボルを生成するために使用できます。たとえば、下の図は、上記のテキスト「AI の最も優れている点は、 を実行できることです」というテキストを考慮した次のシンボルの出現確率を示しています。

# #キー言語モデルの問題は、条件付き分布を表すためにどのような種類の関数ファミリーを構築するかです。

# #キー言語モデルの問題は、条件付き分布を表すためにどのような種類の関数ファミリーを構築するかです。

i | x1,…,xi-1 )、ビッグデータからモデルパラメータを効果的に学習できます。 ChatGPT に基づく技術の進歩は、ニューラル ネットワークを使用して P(xi | x1,…,xi-1) を表現することです。 。

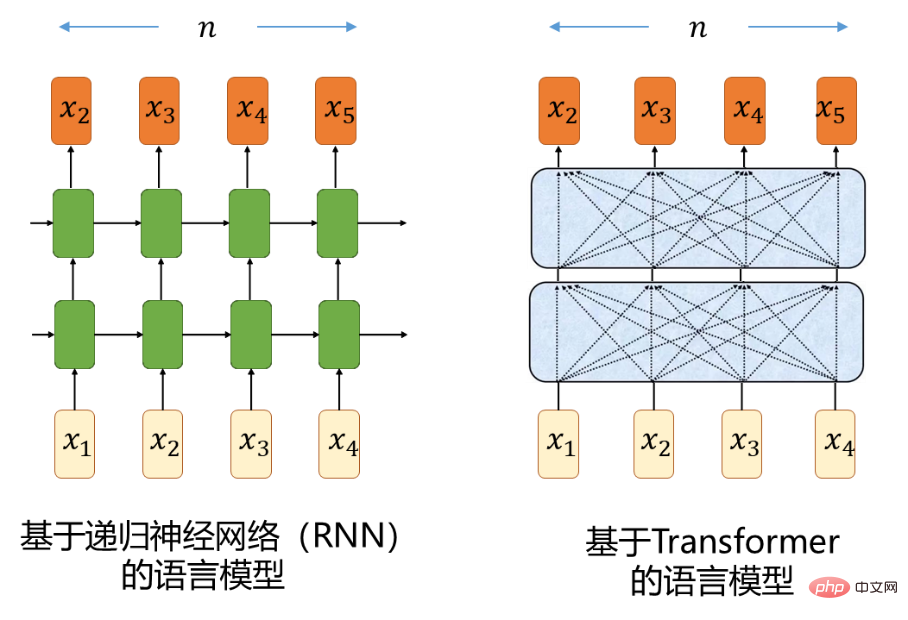

2. Transformer ニューラル ネットワーク アーキテクチャシーケンス条件付き分布の場合

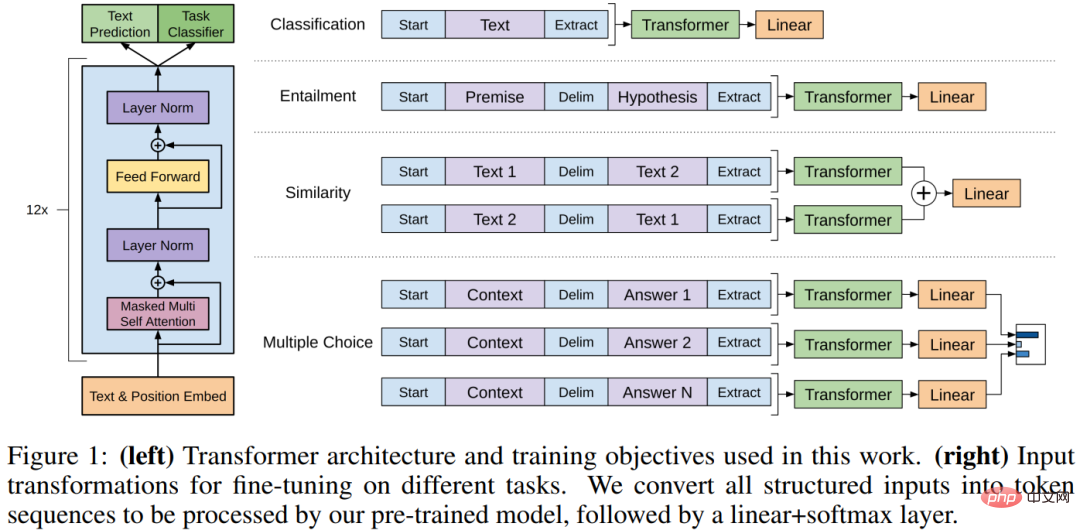

P (xi | ) モデリング。通常のリカレント ニューラル ネットワーク (RNN) を使用したシーケンス モデルは、学習中に爆発および消滅する勾配効果 [1] に遭遇するため、長い時間がかかります。期間記憶ネットワーク (長期短期記憶、LSTM) [2] を使用してシーケンス モデリングを実行します。 LSTM はゲート機構を導入することにより、勾配爆発と消滅の欠陥をある程度緩和します。 2017 年に開発された Transformer ニューラル ネットワーク アーキテクチャ [3] は、再帰計算を完全に放棄し、フィードフォワード ニューラル ネットワーク (FFNN) を使用して、セルフ アテンション メカニズムを利用してシーケンス構築を実行します。勾配爆発と消滅の欠陥。 シーケンス モデリングにおける RNN に対する Transformer の利点を直感的に理解してみましょう。シーケンス内の n 離れた 2 つの位置を考慮します。前方および後方計算における 2 つの位置間の信号と、ニューラル ネットワーク内を移動する経路長が、ニューラル ネットワークに影響を与える要素です。長距離の依存関係を学習する能力における重要な要素、RNN は O(n)、Transformer は O(1)

です。このセクションを理解していない読者は、次の内容を読むことに影響を与えることなく、このセクションをスキップできます:-)図 3

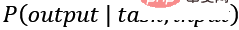

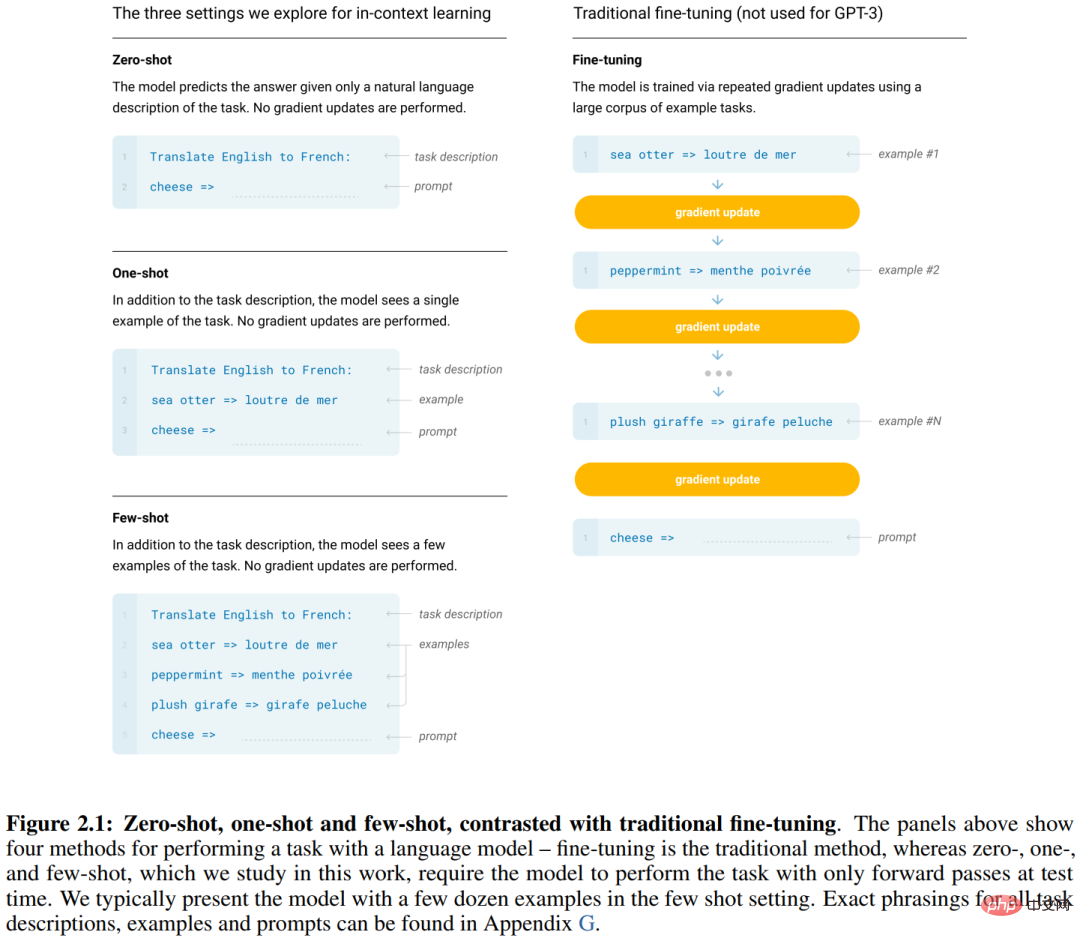

自然言語理解には、質問応答、意味的類似性評価、テキスト含意関係判断、文書分類、機械翻訳、読解、要約など、幅広いさまざまなタスクが含まれます。まず、大量の (ラベルのない) テキストで大規模な Transformer-LM (スケルトンと呼ばれることが多い) をトレーニングし、次にさまざまな問題に直面したときに下流タスクのそれぞれの注釈データを使用してこの大規模な Transformer ネットワークを微調整できることがわかりました。下流タスク。 は、大幅なパフォーマンス向上を実現しました。これは、いわゆる pre-training Fine-tuning 技術 (事前トレーニング微調整) です。代表的な技術には、GPT [4] や BERT [5] などがあります。 2018年から2019年に開発されました。 GPT は Transformer に基づく自己回帰言語モデルであり、BERT は Transformer に基づくマスク言語モデル (MLM) です。 GPT の原文に記載されているように、「私たちの研究は、自然言語の半教師あり学習のカテゴリーに広く分類されます。」 この教師なし事前トレーニングは、教師ありの細かい学習と組み合わされています。チューニングは半教師あり学習の一種であり、その本質は教師あり学習と教師なし学習を協調的に実行することです。 4. GPT-2 とゼロサンプル プロンプト テクノロジー 事前トレーニング微調整テクノロジーの枠組みの下で、それぞれの下流のタスクでは、多くのラベル付きデータを収集してラベル付けし、それぞれのタスクに関する「狭い専門家」を取得するために微調整する必要があります。それぞれの狭いモデルを個別に構築して保存する必要があり、時間がかかります。手間がかかり、リソースを消費します。 「私たちは、多くのタスクを実行できるより一般的なシステムに移行し、最終的にはそれぞれのトレーニング データセットを手動で作成してラベルを付ける必要がなくなります。>> 機械に自然言語の実行を学習させます。タスク (Q&A など) を理解するには、本質は条件付き分布を推定することです

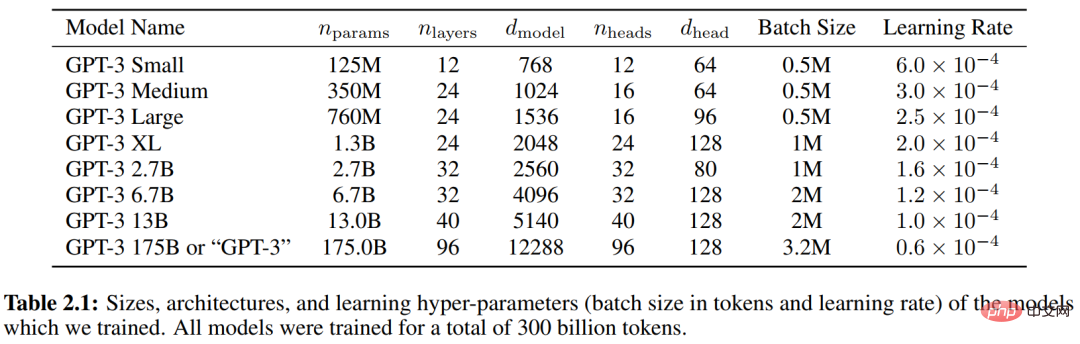

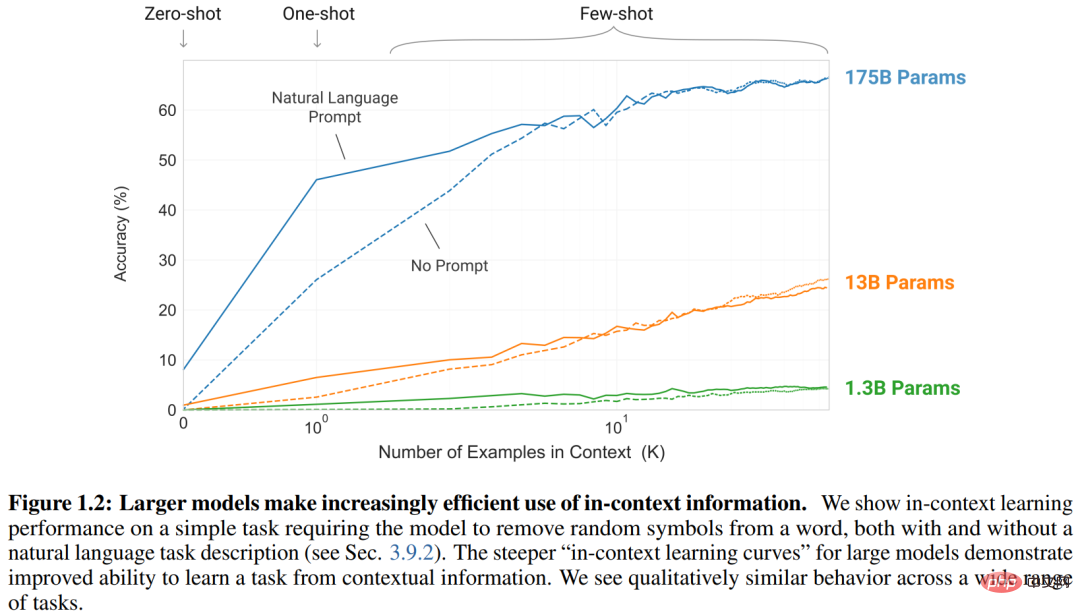

一般的なシステムはさまざまなタスクを実行できるため、そのモデリングは次のとおりです。さらにタスク

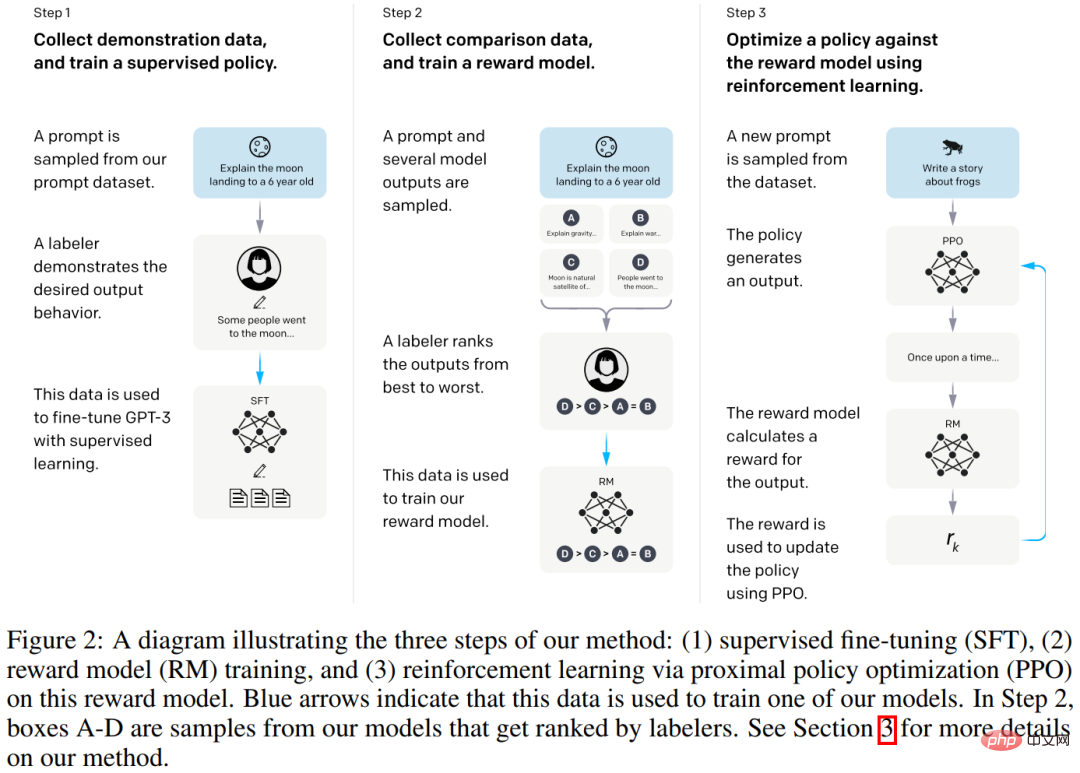

GPT-2に代表される革新的なアプローチは、##です。 # タスク、入力、出力 P(出力 | タスク, 入力) は言語モデル ## に要約されます。 #——上記の場合、次のシンボルが再帰的に生成されます。さまざまなタスクのトレーニング データは、 などのシンボル シーケンスの形式に均一に編成されます。例: ##(質問に答える、文書、質問、回答) このうち、タスク プロンプトと呼ばれることが多いです。プロンプトにはさまざまな方法があり、関連する研究も数多くありますが、この記事では紹介しません。 GPT-2 の前にも同様のアイデアに関する研究がありました。GPT-2 はスケール (トレーニング セットやモデルのサイズに関係なく) を新たなレベルに引き上げました 大規模なデータ セット WebText (40 GB) を使用して、最大パラメータ サイズ 1.5B の Transformer-LM がトレーニングされ、パラメータやモデル アーキテクチャを変更することなく、ゼロサンプル条件下で複数のタスクで優れたパフォーマンスを実証しました。パラメータまたは変更アーキテクチャ)。 GPT-2 のアプローチはマルチタスク学習とメタ学習を完全に体現しており、GPT-2 の優れたパフォーマンスの直感的な説明として使用できることは指摘する価値があります。 (GPT-2 原文 [6]「言語モデルは教師なしマルチタスク学習者である」より。GPT-2 は一連のトレーニングを行いました) Transformers -LM、パラメーター サイズはそれぞれ 117M、345M、762M、および 1542M です。上の図は、モデル パラメーターのスケールが増加するにつれて、各タスクのパフォーマンスが向上し続けていることを示しています。) 5. GPT-3 とコンテキスト内学習 2020 年の GPT-3 の取り組み[7]は、ビジョンと技術的なルートを継続します。 GPT-2 の、各タスクにおけるタスク固有のアノテーションと微調整の欠点を克服することを期待しており (タスク固有のデータセットとタスク固有の微調整が依然として必要です)、次のような普遍的なシステムを構築することを望んでいます。記事は、研究の動機の 1 つは、次のことに注意することであると明確に指摘しています: 「人間は、ほとんどの言語タスクを学習するために大規模な教師付きデータセットを必要としません。自然言語(例: 『この文が何か幸せなことを説明しているのか、それとも何か悲しいことを説明しているのか教えてください』)、またはせいぜい少数のデモンストレーション(例: 『ここに人々が勇敢に行動している例が 2 つあります。勇気の 3 番目の例を挙げてください』)が含まれることがよくあります。 「人間が少なくとも妥当な程度の能力で新しいタスクを実行できるようにするのに十分です。」 つまり、タスクの説明 (指示) とデモンストレーション サンプル (デモンストレーション) があれば、 )、マシンは人間と同じようにさまざまなタスクを実行できる必要があります。 GPT-3 は再び新しいレベルにスケールアップしました . トレーニング セットのサイズは、テキスト (クリーニング前) 45 TB と (クリーニング後) 570 GB です。 Transformer-LM のスケールは GPT-2 と比較して 10 倍増加し、175B に達しました (以下の表 2.1 を参照)。 GPT-2 の記事では主にゼロショットのプロンプト状況に関する実験が行われ、一方 GPT-3 では、総称してコンテキスト学習 (状況学習) と呼ばれる、ゼロショット、シングルショット、および少数ショットの状況に関する実験が行われました。デモンストレーション サンプル (デモンストレーション) は 0、1、またはそれ以上の値を指定できますが、それらはすべてタスクの説明 (タスクの説明) を持ちます。図 2.1 の図を参照してください。図 1.2 からわかるように、デモンストレーション サンプルの数が増加するにつれて、さまざまなサイズのモデルのパフォーマンスが向上します。 (上記はすべてオリジナルの GPT からのものです) -3 テキスト [7]「言語モデルは少数のショットで学習できる」) #6. InstructGPT、ChatGPT、および RLHF テクノロジー #自然言語理解のための大規模言語モデル (LLM) の現在の実践は、上記の P(output | task,input) に基づいています。 #、次のシンボルを再帰的に生成します。 InstructGPT 研究の出発点の 1 つは、人間とコンピューターの対話において、言語モデルを増やしても本質的に言語モデルがより良くなるわけではなく、ユーザーの意図に従いやすくなるということを考慮することです。大規模な言語モデルは、事実の捏造、偏った有害なテキストの生成、単にユーザーにとって役に立たないなど、満足できない動作を示す可能性もあります。 これは、最近の大規模 LM の多くで使用されている 言語モデリングの目標 は、インターネットから Web ページ上の次のシンボルを予測することであり、「有益かつ安全に従う」こととは異なるためです。ユーザー」「指示」の目標。したがって、言語モデリングの目標は 不整合 であると言えます。これらの予期しない動作を回避することは、何百ものアプリケーションで言語モデルを展開して使用する場合に特に重要です。 2022 年 3 月、InstructGPT の研究 [8] は、人間のフィードバックに基づいて微調整することで、言語モデルをさまざまなタスクに対するユーザーの意図に合わせて調整する方法を実証し、その結果得られるモデルは InstructGPT と呼ばれます。具体的には、以下の図 2 に示すように、InstructGPT 構築プロセスは 3 つのステップで構成されます。 を使用して、 GPT-3 (サイズ 175B) を微調整し、教師ありポリシー (教師ありポリシー) を取得するためのトレーニングを行います。 報酬モデル) をトレーニングします。 人間のフィードバックからの強化学習 (人間のフィードバックからの強化学習) と呼ばれる報酬モデルの戦略を最適化します。 、RLHF)。具体的には、PPOと呼ばれる戦略最適化手法が用いられる[9]。

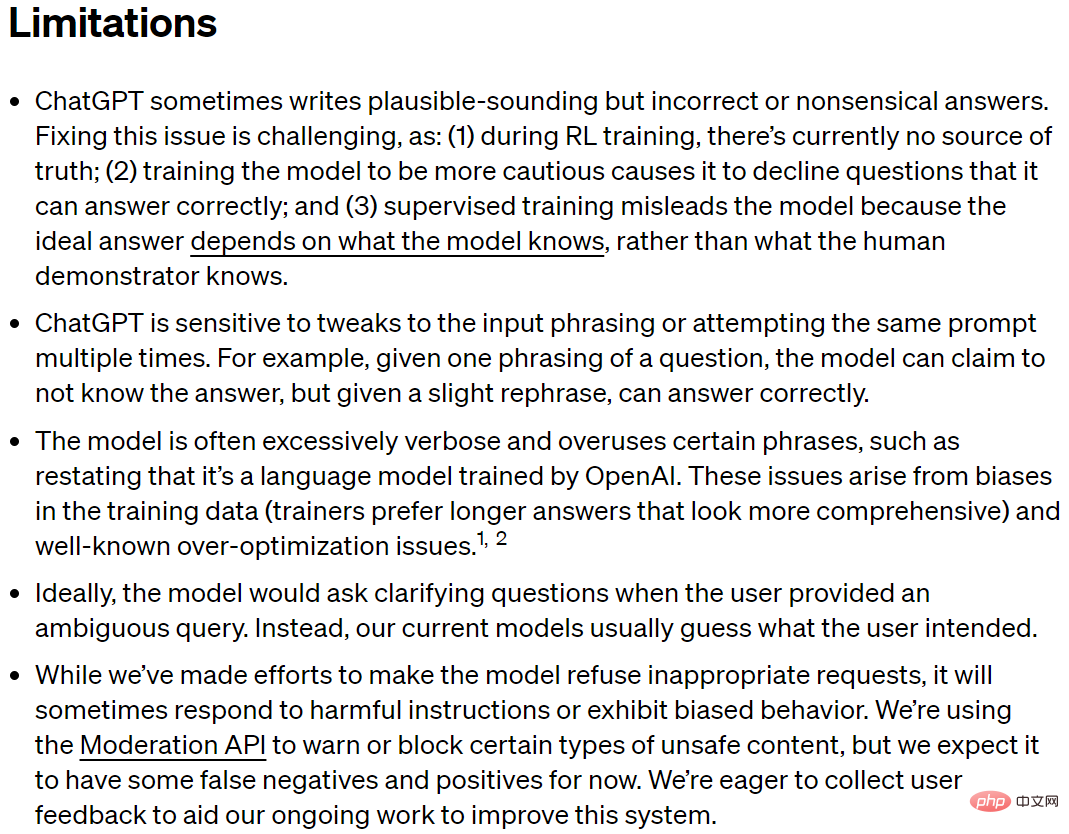

2022 年 11 月に、OpenAI は ChatGPT モデル [10] をリリースしました。これは基本的に InstructGPT モデルの後継です。同じ 3 ステップのトレーニング方法を使用しますが、モデルのトレーニングのためにより大規模なデータを収集します。 . そしてシステム構築。 要約: 言語モデルの研究、Transformer ニューラル ネットワーク アーキテクチャ、GPT 言語モデルと事前トレーニング微調整、GPT-2 とゼロショット プロンプトから) , GPT-3 とインコンテキスト学習は、InstructGPT、ChatGPT、および RLHF テクノロジに発展しました。振り返ってみると、これは比較的明確な技術的パスであるように見えますが、実際には、他のタイプの言語モデル (エネルギーベースの言語モデルなど) 11])、他の種類のニューラル ネットワーク アーキテクチャ(状態空間モデル [12] など)、他の種類の事前トレーニング方法(潜在変数モデル [13] に基づくものなど)、他の強化学習方法(潜在変数モデル [13] に基づくものなど)ユーザーシミュレーション [14]) など常に発展しており、新たな手法の研究は止まることなく、様々な手法が互いに刺激し合い、促進し合いながら、一般的な人工知能へとつながる激流を形成し、果てしなく突き進んでいます。 ChatGPT の 6 つの部分を通して非常に重要なポイントは、一般に暴力の美学として知られる スケール効果 です。ルートが基本的に正しい場合、スケールを増やすことはパフォーマンスを向上させる良い方法です。 量的な変化は質的な変化をもたらしますが、ルートに不備がある場合、量的な変化が質的な変化につながらない可能性があります。 ChatGPT の欠点について話しましょう。 02 ChatGPT の欠点 を説明するセクションを記事内に残す必要があります。逆に、欠点について話すことを避けることは厳格ではなく、テクノロジーの包括的な理解に役立たないため、一般の人々を誤解させ、イライザ効果を助長し、さらには誤った判断を下す可能性があります。 実際、ChatGPT [10] の原文は、その欠点について比較的包括的に述べています。

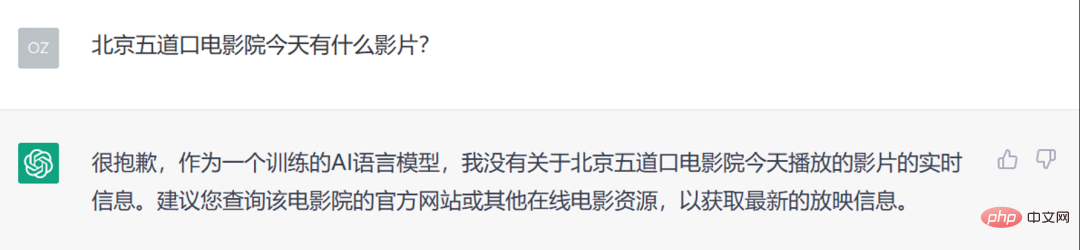

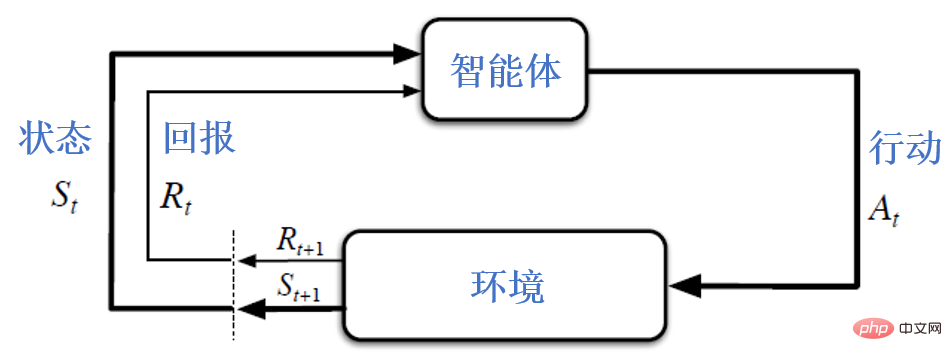

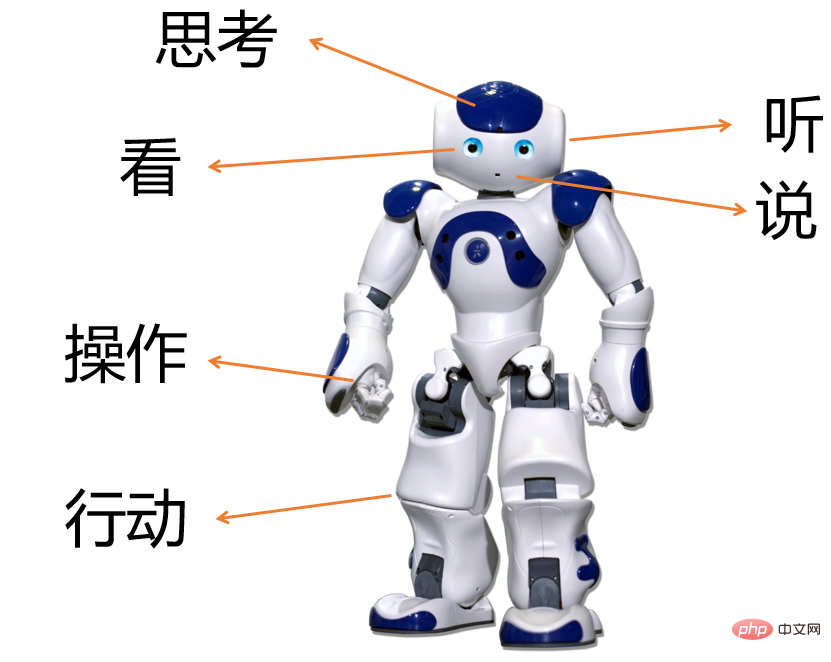

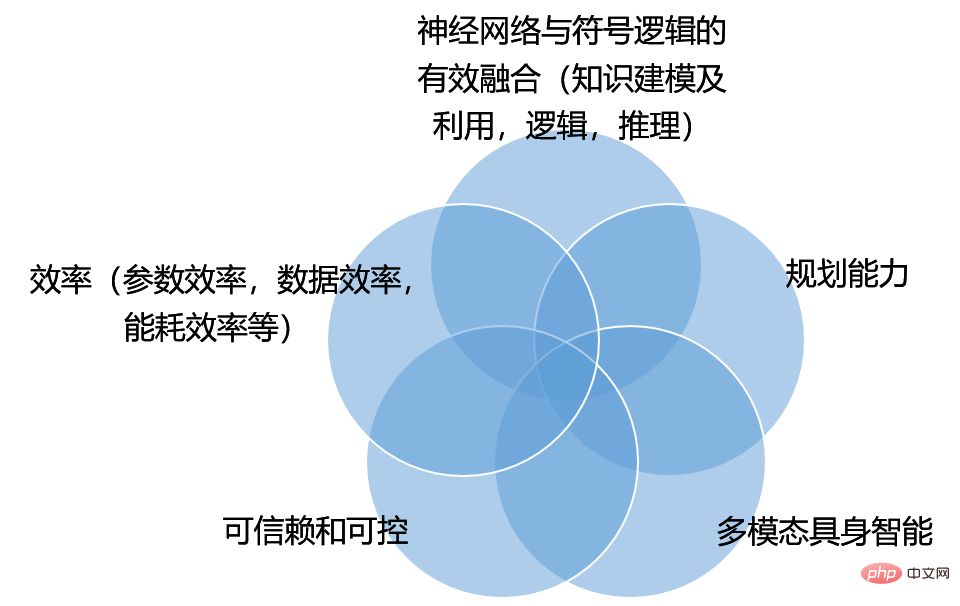

読者は上記を英語で直接読むことができ、以下に中国語で簡単な説明を読むことができます。読者は次の例でそれを理解することができます。 ChatGPT の欠点についてのさらなる分析については、次の章で AGI (汎用人工知能) が直面する課題を検討するときに説明します。 L1. ChatGPT は、合理的であるように見えても、不正確またはばかげた回答を書くことがあります。 L2. ChatGPT は、入力文言の調整や、同じプロンプト に対する複数の試行の影響を受けます。 L3. ChatGPT 世代の は、OpenAI でトレーニングされた言語モデルであることを繰り返すなど、冗長すぎることが多く、特定のフレーズ を多用します。 L4. 理想的には、ユーザーがあいまいなクエリを提供したとき、モデルは 明確な質問をする必要があります。その代わりに、現在のモデルはユーザーの意図を推測することがよくあります。 L5. ChatGPT は、モデルが不適切なリクエストを拒否できるように懸命に取り組んできましたが、それでも時々 有害な指示に応答したり、偏った動作を示したりする可能性があります。 03 AGI への課題 AGI を議論する場合、自然言語処理のみに焦点を当てるという制限から抜け出し、より広い視点から人工知能の研究と技術を検討する必要があります。人工知能に関する古典的な研究 [15] を参照すると、人工知能とはインテリジェント エージェントの研究と設計を指します。インテリジェント エージェント 周囲の環境を観察できるデバイス#を指します。 ## と makeaction 成功の可能性を最大化するには、より学術的に言えば、次の図に示すように、期待される効用 (utility) を最大化するか、期待されるリターン (return) を最大化します。注意深い読者は、次の図が強化学習のフレームワーク図としてもよく使用されることに気づくでしょう。実際、[15] にも同様の記述があります。「強化学習は AI のすべてを包含すると考えられるかもしれない」(強化学習は人工知能のすべてを包含すると考えられるかもしれません)。これらの概念を念頭に置いて、ChatGPT の欠点を理解しましょう。 1. ChatGPT はランダムにでっち上げ (間違った情報を真剣に提供) するため、知識のモデリングと利用に明らかな欠陥があります。 #これは基本的に、前に紹介した L1 に対応しており、前の例から明らかです。私たちが 知識 と呼ぶものには、常識的な知識、専門的な知識、リアルタイムの情報が含まれます。たとえば、常識的な観点から見ると、ChatGPT は当初、牛が哺乳類であり、卵を産むことができないことを認識していないことを示しました。リアルタイム情報から判断すると、ChatGPT は本質的に Transformer アーキテクチャに基づく大規模な自己回帰言語モデルであり、学習した知識はトレーニング データに限定されており、その期限は 2021 年です。読者は自分で ChatGPT を使用してみて、この点での欠点を発見できます。 上記の欠点は、より深いレベルで、人工知能の歴史における長年の 接続主義 (接続主義) と 象徴主義## を反映しています。 #(象徴主義) に関する 2 つの学派間の論争。 ##図 7 知識を信じています。 はニューラル ネットワークの重みに埋め込まれており、ニューラル ネットワークをトレーニングして重みを調整することで知識を学習できます。象徴主義は、知識が、リレーショナル データベース、ナレッジ グラフ、数理物理学やその他の専門知識、数理論理学などの記号システムによって組織されることを主張します。 。データと知識は両輪であり、長年にわたって多くの研究が行われてきましたが、一般に、効果的な統合方法を見つけるには依然として継続的な努力が必要です。 これは基本的に上記の L4 に対応します。L4 は、ChatGPT が説明の質問をしないことを指摘しているだけです。しかし、L4 よりもさらに深刻な欠点があり、ChatGPT の構築プロセスから、予測のために条件付き分布 をモデル化するだけで、計画は行いません。 図 6 に示すフレームワークでは、非常に重要な概念が計画であり、計画の目的は P(output | input) を最大化する大規模な言語モデルとは大きく異なります。 InstructGPT は、システムがユーザーの意図に従うべきであると考えており、RLHF (人間のフィードバックからの強化学習) テクノロジーを使用して、システムが人間の質問に対して aligned を出力できるようにします。これにより、GPT-3 の教師あり学習の必要性が部分的に軽減されます。無計画に作業を行った結果、位置ずれの問題が発生しました。 ChatGPT が AGI につながるためには、計画機能をさらに改善して期待される有用性を最大化することが大きな課題となります。 それでは、人間とコンピューターの対話システムの有用性は何でしょうか?この点に関して、InstructGPT の論文 [8] では、役立つ、正直、無害という 3 つの側面からこれについて議論しています。 「私たちは、言語モデルが役立つものであること(ユーザーがタスクを解決するのに役立つものであること)、誠実であること(情報を改ざんしたり、ユーザーを誤解させたりするものであってはなりません)、そして無害であること(人々や環境に物理的、心理的、社会的危害を与えてはなりません)を望んでいます。 ) )」ただし、RLHF テクノロジーにとどまらず、具体的な実装手段をさらに検討する必要があります。 3. ChatGPT の動作は制御できません。 #これは基本的に上記の L2、L3、L5 に対応します。システム出力は入力に敏感であり (L2)、冗長すぎたり、特定のフレーズを使いすぎたりする場合は制御する方法がありません (L3)、有害な指示に応答したり、偏った動作を示したりする場合は制御する方法がありません (L5) )。これらの欠点は ChatGPT に現れるだけでなく、現在の深層学習テクノロジーで構築されたコンピューター ビジョン、音声認識、その他のインテリジェント システムにも同様の制御不能な問題があります。 人間にはソクラテスの知恵、つまり「あなたは自分が知らないことを知っている」という知恵があります。これはまさに現在のディープ ニューラル ネットワーク システムに欠けているものです。間違っている。今日のニューラル ネットワーク システムのほとんどは自信過剰で人間にエラーを報告しませんが、依然として間違いを犯した場合のパフォーマンスが驚くほど高く、信頼して制御することが困難になっています。 信頼性と制御性は、AGI にとって大きな課題となります。 4. ChatGPT の効率が不十分です。 ChatGPT ステートメントの欠点として、この点は真剣に考慮されていませんでした。 効率には、パラメータ効率、データ効率、エネルギー消費効率などが含まれます。 ChatGPT は、非常に大規模なデータを使用し、非常に大規模なモデルをトレーニングし、その規模を継続的に拡大することにより、優れたパフォーマンスを達成しました。しかし、同じスケール (同じ数のモデル パラメーター、同じ量または同じデータ ラベリングのコスト、同じコンピューティング能力、同じエネルギー消費) では、ChatGPT は最も先進的なテクノロジーを表しているのでしょうか?答えは多くの場合「ノー」です。たとえば、最近の研究では、13B パラメーターを備えた LLaMA モデルが複数のベンチマーク テストで 175B GPT-3 モデルよりも優れたパフォーマンスを示したことが報告されています [19]。そのため、13B LLaMA モデルはパラメーター効率が優れています。私たち自身の最近の研究でも、適切に設計された知識検索対話モデルは 100M しか使用せず、そのパフォーマンスは 1B の大規模モデルのパフォーマンスを大幅に上回っていることも示しています。 エネルギー消費効率はわかりやすいので、データ効率を見てみましょう。現在のインテリジェント システムの構築は、多数の手動アノテーションに依存する教師あり学習パラダイムから抜け出せていないため、データ効率が低くなります。自己回帰に基づく大規模な言語モデルに基づいて、まず大量のテキスト (注釈なし) でトレーニングし、次に微調整またはプロンプト技術を使用することで、データ効率が低いという欠点を部分的に軽減できることがわかりました。現在の深層学習テクノロジーの機能を利用していますが、依然としてタスク関連の注釈データが必要です。モデルが大きくなるほど、ラベル付けの要件も大きくなります。 ラベル付きデータとラベルなしデータをさらに効率的に活用する方法は、データ効率を達成するための課題です。 5. マルチモーダルな身体化インテリジェンスは、AGI を探求する上で重要な部分です。 #ChatGPT はテキストの入力と出力に限定されており、多くの間違いを犯していることも、セマンティクス、知識、因果推論が深刻に欠如していることを示しています。単語の意味は、現実世界の基礎ではなく、統計的な共起にあるようです。したがって、将来の言語モデルがますます大きくなったとしても、いくつかの基本的な物理的常識では依然としてパフォーマンスが不十分です。 知能は言語能力をはるかに超えています。生物学的知能の基本要素は、動物が動物と感覚運動相互作用を行う能力にあります。世界#[20]。将来のインテリジェントマシンは必ずしも人間の形をしているとは限りませんが、聞く、話す、読む、書く、考える、物体を操作する、行動するなどの身体を介したマシンと環境との間のマルチモーダルな相互作用は、人間の人間の姿を大きく促進するでしょう。また、機械知能が単一のテキスト形式の限界を超え、人間をより良く支援するのにも役立ちます。 要約: 言語学の観点から見ると、言語知識には、単語の構造と特徴 (形態論と語彙)、単語がどのようにフレーズを形成するかが含まれます。および文 - 構文、形態素の意味、単語、フレーズ、文および談話 - 意味論 [21]。 ChatGPT は、非常に大規模なモデルを通じてかなりの言語知識 (特に意味レベル以下の知識) を学習し、一定の言語理解能力を備え、流暢な文章を生成できますが、明らかな欠点もあります。 これらの欠点に対応して、図 8 に示すように、ChatGPT と汎用人工知能 (AGI) への移行が将来直面するいくつかの課題を整理しました。いくつかの重要な研究内容を指摘しました。各分野の研究領域が孤立しているのではなく、相互に交差していることは注目に値します。例えば、信頼性や制御性の研究では、システムの出力が社会規範に適合することが望まれるため、システム計画の出力が社会規範に適合するように、この社会規範をシステムの有用性にどのように反映させるかが課題となる。したがって、システムの制御性に関する研究とシステム計画能力の向上に関する研究には重複部分があります。別の例として、体系的な計画と意思決定において知識を統合するにはどうすればよいでしょうか? 図 8: AGI に対する課題 ChatGPT は人工知能研究における重要なイベントであり、その進歩、欠点、AGI に向けた今後の課題を厳密に理解することが非常に重要です。私たちは、真実を追求し、実用的であり、常に革新することで、人工知能の開発を新たな高みに促進できると信じています。議論や修正を歓迎します。ありがとうございます!

タスク

タスク はすべて自然言語の記号シーケンスとして表現されます。

はすべて自然言語の記号シーケンスとして表現されます。  (フランス語、英語テキスト、フランス語テキストに翻訳)

(フランス語、英語テキスト、フランス語テキストに翻訳)

近年、人工知能 (ICML、ACL など) 分野のトップカンファレンスの非常に良い習慣は、投稿用アイテム 必要に応じて、作品の

制限事項  ChatGPT の欠点 (ChatGPT の原文 [10] からのスクリーンショット)

ChatGPT の欠点 (ChatGPT の原文 [10] からのスクリーンショット)

ChatGPT [10] の原文に記載されている欠点を踏まえて、

ChatGPT の欠点を次の 5 点に要約します。これら 5 つのポイントは、基本的に汎用人工知能 (AGI) に向けて ChatGPT が将来直面する課題を表しており、AGI に向けて早急に解決する必要がある重要な科学的課題およびキーテクノロジーです。この記事の視点は、タスクの観点から欠点や課題を分析するのではなく、さまざまなタスクに共通する問題の観点から分析することであることは指摘しておく価値があります。タスクが行、問題が列である場合、私たちの視点は列で分析することです。行ごとに非常に優れた分析と判断を行うこともできます。

ニューラル ネットワークに基づく生成対話システムは、知識ベースからの検索によって強化される [17];

ニューラル ネットワークの組み合わせです。およびシンボリック ロジックの効果的な統合

04 結論

以上が清華大学の Ou Zhijian 教授への独占インタビュー。ChatGPT のオーラと今後の課題について詳しく分析しています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7469

7469

15

15

1376

1376

52

52

77

77

11

11

19

19

28

28

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス