OpenAI が ChatGPT アップグレード計画を明らかに: 見つかったすべてのバグは修正されています

OpenAI の使命は、汎用人工知能 (AGI) が全人類に確実に利益をもたらすことです。そのため、私たちは AGI を実装する際に構築する AI システムの動作と、その動作がどのように決定されるかについてよく考えます。

ChatGPT を立ち上げて以来、ユーザーは政治的に偏見のある、または不快だと思われる出力を共有してきました。多くの場合、私たちは提起された懸念は正当なものであり、私たちが対処したいと考えているシステムの本当の限界を特定していると考えています。しかし同時に、ChatGPT の出力を形成するためにシステムとポリシーがどのように連携するかに関して、いくつかの誤解も見られました。

#ブログの要点は次のように要約されます:

- ChatGPT の動作がどのように形成されるか;

- ChatGPT のデフォルト動作を改善する方法;

- システムをさらにカスタマイズできるようにしたい;

- 私たちは、一般の人々に私たちの決定へのさらなる意見を知らせるために懸命に働きます。

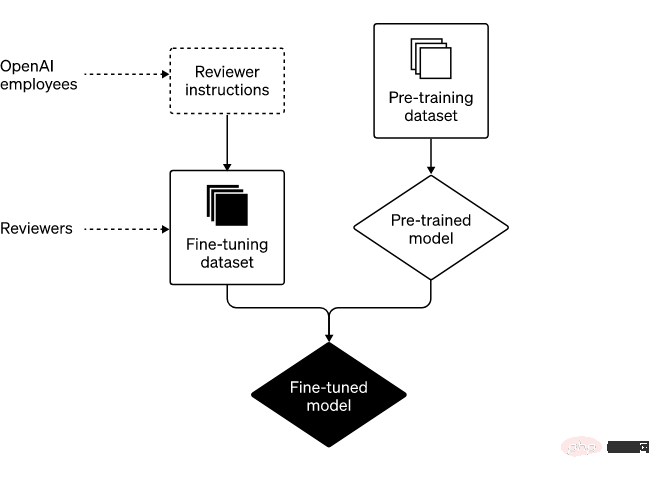

通常のソフトウェアとは異なり、私たちのモデルは大規模なニューラル ネットワークです。彼らの行動は、明示的にプログラムされたものではなく、広範なデータから学習されます。あまり適切ではないたとえを使用すると、このプロセスは通常のプログラミングというよりも犬の訓練に似ています。まず、モデルは「事前トレーニング」フェーズを通過します。この段階では、モデルは大量のインターネット テキスト (および大量の意見) にさらされることで、文内の次の単語を予測する方法を学習します。次は第 2 段階で、モデルを「微調整」してシステムの動作の範囲を狭めます。

現時点では、このプロセスは不完全です。場合によっては、微調整プロセスが、私たちの意図 (安全で便利なツールを作成する) とユーザーの意図 (特定の入力に応じて有用な出力を取得する) の両方を満たさないことがあります。 AI システムがより強力になるにつれて、AI システムを人間の価値観に合わせる方法を改善することが当社の優先事項になっています。 #2 つの主な手順: 事前トレーニングと微調整

ChatGPT を構築する 2 つの主な手順は次のとおりです:

次に、提供したガイドラインに従って人間のレビュー担当者が作成した、より狭いデータセットに基づいてこれらのモデルを「微調整」します。将来のユーザーがシステムに入力する可能性のあるすべての情報を予測することはできないため、ChatGPT が遭遇するすべての入力に対する詳細な手順は書いていません。代わりに、ガイドでは、レビュー担当者がさまざまな入力例の可能なモデル出力をレビューおよび評価するために使用するいくつかのカテゴリについて概説します。その後、使用中に、モデルは特定のユーザーから提供された幅広い特定の入力に応答するために、レビュー担当者のフィードバックから一般化されます。

システム開発におけるレビュー担当者の役割と OpenAI の戦略

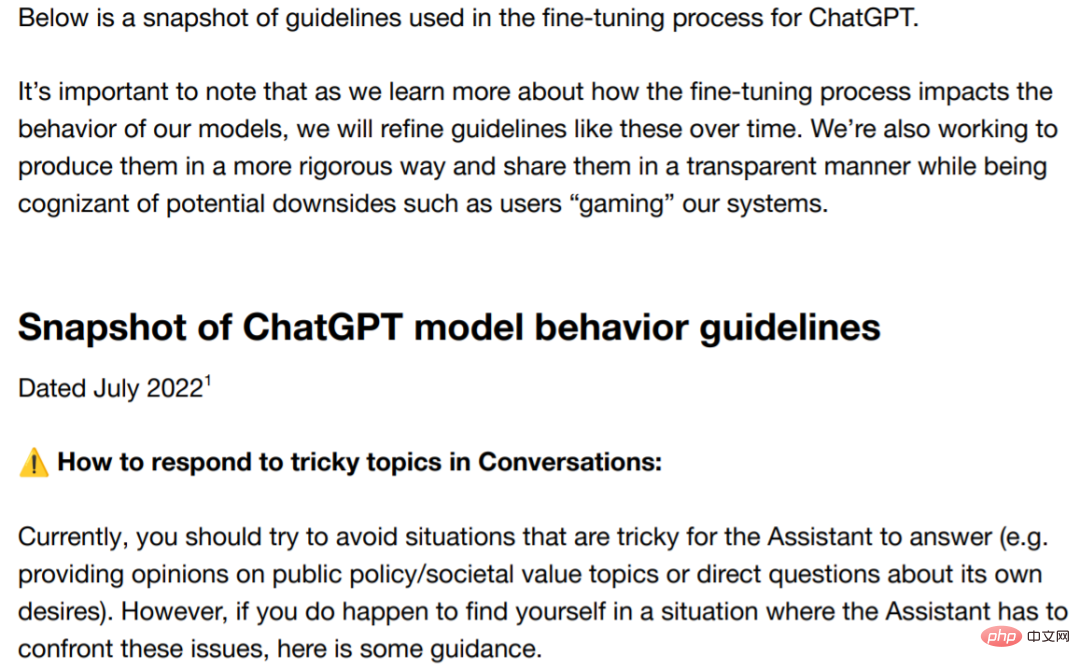

場合によっては、特定の種類の出力に関するガイダンスをレビュー担当者に提供することがあります。違法なコンテンツのリクエストを完了しないでください。」)。場合によっては、査読者と共有するより高度なガイダンスが提供されることもあります (例: 「物議を醸すトピックについてはどちらかの側につくことを避ける」)。重要なのは、査読者との仕事は一度で終わりではなく、継続的な関係であるということです。この関係を通じて、私たちは彼らの専門知識から多くのことを学びました。微調整プロセスの大部分は、レビュー担当者との強力なフィードバック ループを維持することであり、レビュー担当者からの質問に対処したり、ガイダンスをさらに明確にしたりするための毎週のミーティングが含まれます。この反復的なフィードバック プロセスは、時間の経過とともにモデルをより良くするためにモデルをトレーニングする方法です。 AI システムにとって、バイアスの問題は長い間存在しており、多くの研究者がそれについて懸念を表明しています。私たちはこの問題に取り組み、私たちの意図と進捗状況を公表することに断固として取り組んでいます。現場での進歩を表現するために、ここでは政治と論争に関連するトピックに関するいくつかのガイダンスを共有します。ガイドラインには、査読者はいかなる政治団体も支持してはならないと明確に記載されています。とはいえ、偏見が生じる可能性もある。 バイアスへの対処

ガイドのアドレス: https://cdn.openai.com/snapshot-of-chatgpt-model -behavior-guidelines.pdf

意見の相違は常に存在しますが、このブログといくつかのガイドラインを通じて、バイアスに関する私たちの考え方についてより深く理解していただければ幸いです。私たちは、テクノロジー企業は責任を持って厳しい監視に耐えられるポリシーを策定する必要があると強く信じています。

私たちは、これらのガイドラインの明確性を向上させるために懸命に取り組んできました。ChatGPT リリースからこれまでに学んだことに基づいて、レビュー担当者に、次のような潜在的な落とし穴に関する情報を提供します。偏見と課題、物議を醸すデータとトピックのより明確な説明。さらに、継続的な透明性への取り組みの一環として、プライバシーの規則や規範に違反しない方法でレビュー担当者に関する集計統計を共有するよう取り組んでいます。これもシステム出力における潜在的なバイアスの原因となるためです。

ルール報酬や憲法 AI (独自の人工知能手法) などの進歩に基づいて、私たちは現在、微調整プロセスを理解しやすく制御しやすくする方法を研究しています。

今後の方向性: システムの構成要素

私たちの使命を達成するために、私たちはより多くの人々が AI と AGI を使用し、その恩恵を受けられるようにすることに全力で取り組んでいます。これらの目標を達成するには、少なくとも 3 つの構成要素が必要であると考えています

#1. デフォルトの動作を改善する: AI システムをそのまま使用できるようにすることを期待しています。できるだけ多くのユーザーが、私たち AI システムが実際に機能していることを発見し、私たちのテクノロジーが AI システムの価値を理解して尊重していると考えることができます。

この目的を達成するために、私たちは ChatGPT がさまざまな入力に応答する際に生成する微妙なバイアスを軽減するための研究とエンジニアリングに投資してきました。 ChatGPT は、出力すべき内容を出力しない場合や、その逆の出力すべきでない内容を出力する場合があります。私たちは、ChatGPT には両方の分野で改善の可能性があると信じています。

さらに、AI システムの他の側面にも改善の余地があります。たとえば、システムが「物事をでっち上げる」ことがよくあります。この問題については、ユーザーのフィードバックが非常に貴重です。 ChatGPTの改善。

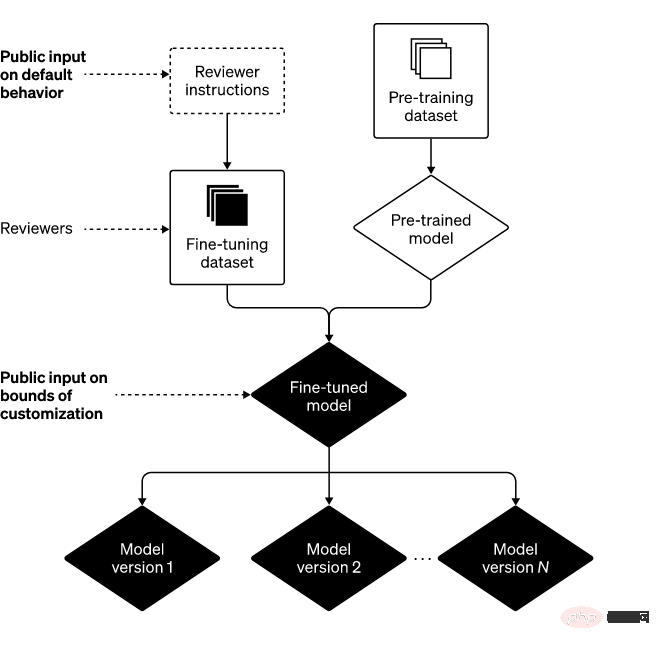

2. AI の価値を広く定義する: AI は個人にとって役立つツールであるべきであり、各ユーザーがいくつかの制約を設けて用途をカスタマイズできるようにする必要があると考えています。これに基づいて、ユーザーがその動作を簡単にカスタマイズできるようにするために、ChatGPT へのアップグレードを開発しています。

これは、一部の人が強く反対する出力が他の人にも見えることも意味します。カスタマイズを極端に行うと、テクノロジーの悪用につながり、AI のパフォーマンスを盲目的に増幅する可能性があるため、このバランスをとることは大きな課題です。

したがって、システムの動作には常にいくつかの制限があります。課題は、その境界が何であるかを定義することです。これらすべての決定を自分たちで行おうとしたり、単一のモノリシックな AI システムを開発しようとしたりすると、過度の権力の集中を避けるという約束を果たせなくなります。

3. パブリック入力 (デフォルトとハード境界): 過度の権力の集中を避ける 1 つの方法は、ChatGPT のようなシステムを使用する人、またはその影響を受ける人がルールに影響を与えることを許可することです。システムの。

私たちは、デフォルト値と明確な境界は一元的に開発されるべきであると考えており、これを実装するのは困難ですが、私たちの目標は、できるだけ多くの視点を含めることです。出発点として、私たちは「レッドチーム」の形で当社のテクノロジーへの外部からのインプットを求めます。また、私たちは最近、AI 教育 (私たちが導入している特に重要な状況) に関する一般の意見を募り始めました。

#結論上記の 3 つの構成要素を組み合わせると、次のフレームワークを描くことができます

時々間違いを犯すこともありますが、間違いを犯したときはモデルとシステムを学び、反復します。さらに、私たちに常に注意を払い、警戒を続けてくださった ChatGPT ユーザーやその他の方々に感謝し、今後数か月以内にこれら 3 つの分野における私たちの取り組みについてさらに詳しく共有できることを楽しみにしています。

以上がOpenAI が ChatGPT アップグレード計画を明らかに: 見つかったすべてのバグは修正されていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7695

7695

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。