複雑な質問に答えるとき、人間はさまざまな様式で情報を理解し、完全な思考連鎖 (CoT) を形成できます。深層学習モデルは「ブラックボックス」を開き、推論プロセスに一連の思考を提供できるでしょうか?最近、UCLA とアレン人工知能研究所 (AI2) は、モデルのマルチモーダル推論機能をテストするために、詳細な説明を備えた初のマルチモーダル科学質疑応答データ セットである ScienceQA を提案しました。 ScienceQA タスクでは、著者は GPT-3 (CoT) モデルを提案しました。これは、思考連鎖に基づく即時学習を GPT-3 モデルに導入し、モデルが回答を生成しながら対応する推論説明を生成できるようにします。 GPT-3 (CoT) は、ScienceQA で 75.17% の精度を達成しており、人間の評価により、より高品質の説明を生成できることが示されています。

複雑なタスクを人間と同じように効率的に学習して完了することは、人工知能が追求する長期的な目標の 1 つです。人間は、意思決定プロセス中に完全な思考連鎖 (CoT) 推論プロセスに従って、与えられた答えについて合理的な説明を行うことができます。

ただし、既存の機械学習モデルのほとんどは、特定のタスクを完了するために多数の入出力サンプル トレーニングに依存しています。これらのブラック ボックス モデルは、多くの場合、特定の推論プロセスを明らかにすることなく、最終的な答えを直接生成します。

Science Question Answering は、人工知能モデルに多段階の推論機能と解釈可能性があるかどうかを適切に診断できます。科学的な質問に答えるには、モデルはマルチモーダルなコンテンツを理解するだけでなく、正しい答えに到達するために外部の知識を抽出する必要もあります。同時に、信頼できるモデルは、その推論プロセスを明らかにする説明も提供する必要があります。しかし、現在の科学的な質問と回答のデータ セットのほとんどには、回答の詳細な説明がないか、テキスト形式に限定されています。

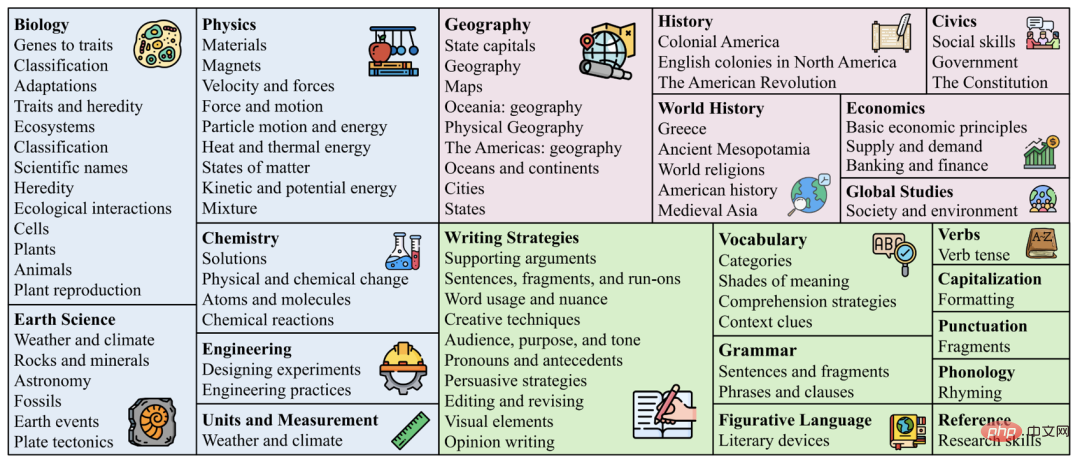

したがって、著者は、新しい科学の質問と回答のデータ セット ScienceQA を収集しました。これには、小学校および中学校の科学コースからの 21,208 の多肢選択式質問と回答が含まれています。 。一般的な質問には、マルチモーダルなコンテキスト (コンテキスト)、正しい選択肢、一般的な背景知識 (講義)、および具体的な説明 (説明) が含まれています。

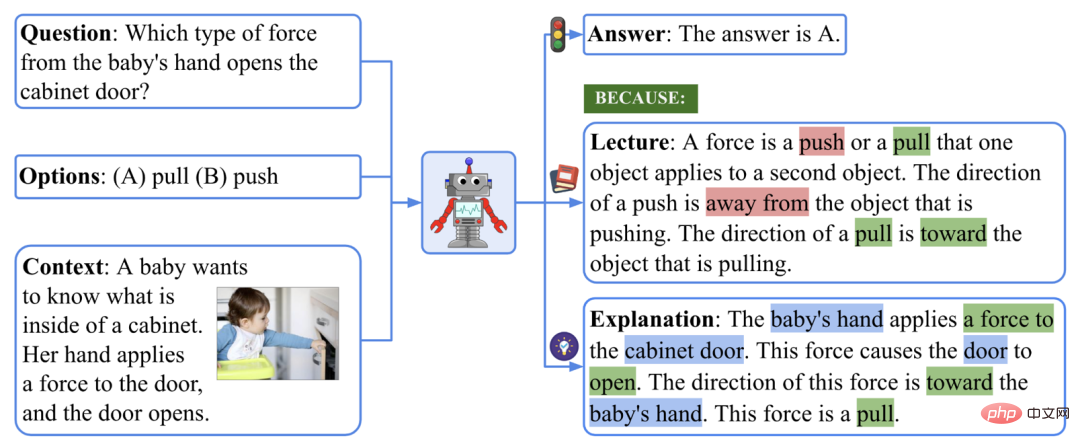

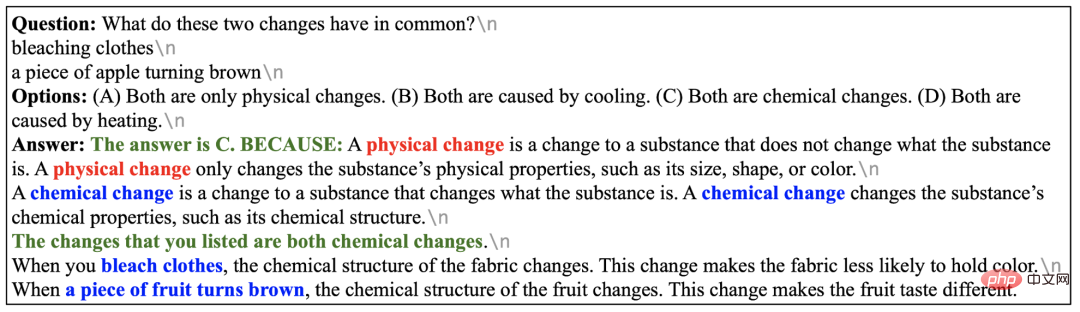

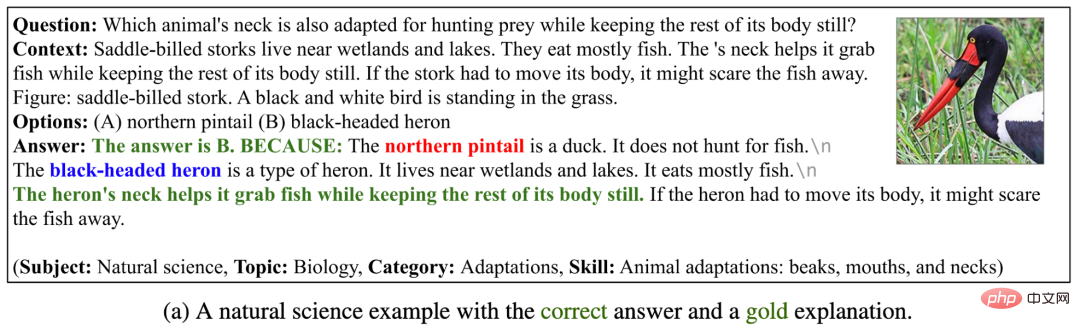

#ScienceQA データセットの例。

上記の例に答えるには、まず力の定義を思い出す必要があります。「力とは、押す力または引く力であり、... 「押す方向は... 引く方向は...」というように、多段階の推論プロセスを形成します。「赤ちゃんの手はキャビネットのドアに力を加えます。→ この力によってドアが開きます。→ 赤ちゃんの手がキャビネットのドアに力を加えます。→ この力によってドアが開きます。→この力の方向は赤ちゃんの手の方向です」と答え、最終的には「この力は引っ張る力です」と正解しました。

ScienceQA タスクでは、モデルは詳細な説明を出力しながら答えを予測する必要があります。この記事では、著者は大規模な言語モデルを利用して背景知識と説明を思考連鎖 (CoT) として生成し、人間が持つ多段階の推論能力を模倣します 。

実験の結果、現在のマルチモーダルな質問応答方法では、ScienceQA タスクで良好なパフォーマンスを達成できないことがわかりました。それどころか、思考連鎖に基づく迅速な学習により、GPT-3 モデルは ScienceQA データセットで 75.17% の精度を達成し、より高品質の説明を生成できます:人間による評価では、説明の 65.2% が関連性があり、正しく、完全でした。 Thoughtchain は、UnifiedQA モデルが ScienceQA データセットで 3.99% の改善を達成するのにも役立ちます。

データセット統計

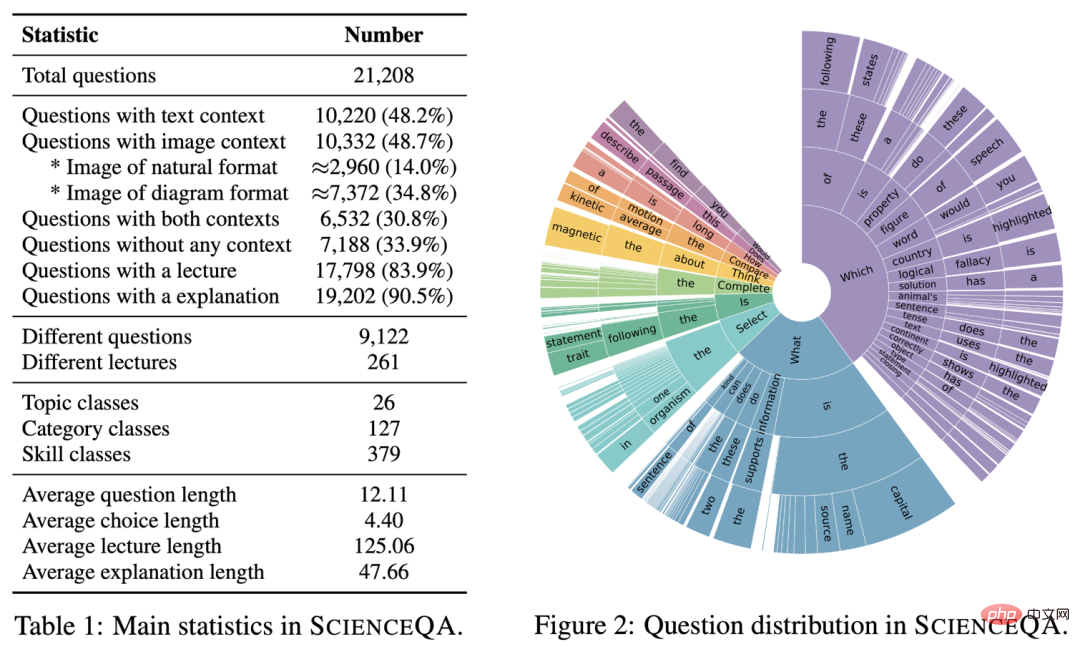

ScienceQA の主な統計を以下に示します。

ScienceQA データセットの主な情報

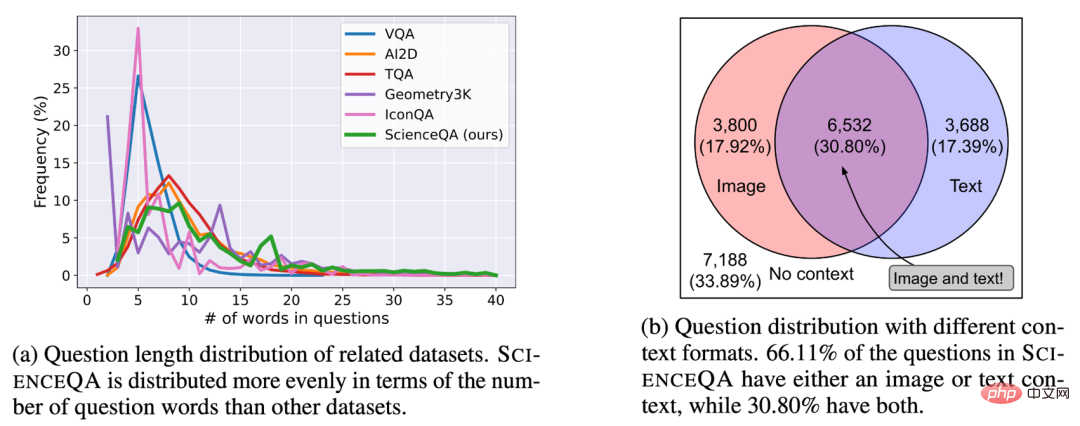

ScienceQA には が含まれています9122 さまざまな質問を含む、21208 の例。 10332 トラック (48.7%) には視覚的な背景情報があり、10220 トラック (48.2%) にはテキストの背景情報があり、6532 トラック (30.8%) には視覚的なテキストの背景情報がありました。大部分の問題には詳細な説明が付いています。83.9% の問題には背景知識の注釈 (講義) があり、90.5% の問題には詳細な解答 (解説) が付いています。

ScienceQA データセットにおける質問と背景の分布。

#データセット トピックの配布既存のデータ セットとは異なります

ScienceQA は、26 のトピック、127 のカテゴリ、379 の知識スキル (スキル) を含む、自然科学、社会科学、言語学の 3 つの主要分野をカバーしています。

#データ セットのワード クラウド分布

図のワード クラウド分布以下に示すように、ScienceQA の質問は意味上の多様性に富んでいます。モデルは、さまざまな問題の定式化、シナリオ、背景知識を理解する必要があります。

#ScienceQA のワード クラウド配布。

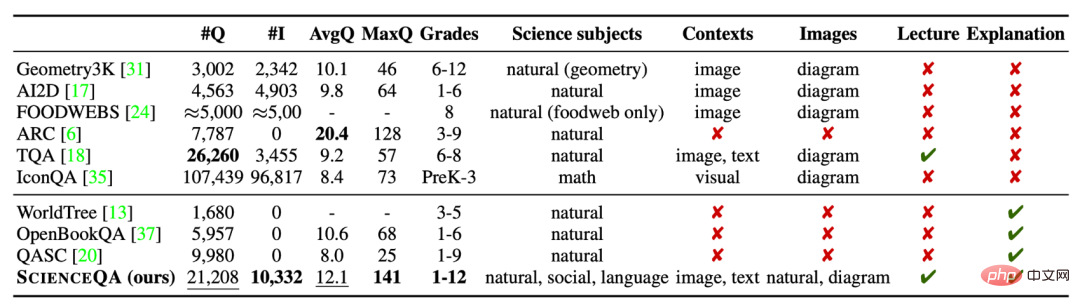

#データセットの比較

ScienceQA は最初の A マルチです-詳細な説明を含むモーダル科学質問と回答データセット

。既存のデータセットと比較すると、ScienceQA のデータ サイズ、質問の種類の多様性、トピックの多様性、その他の側面がその利点を反映しています。

##ScienceQA データセットと他の科学的な質問と回答のデータセットの比較。

2. モデルと手法ベースライン

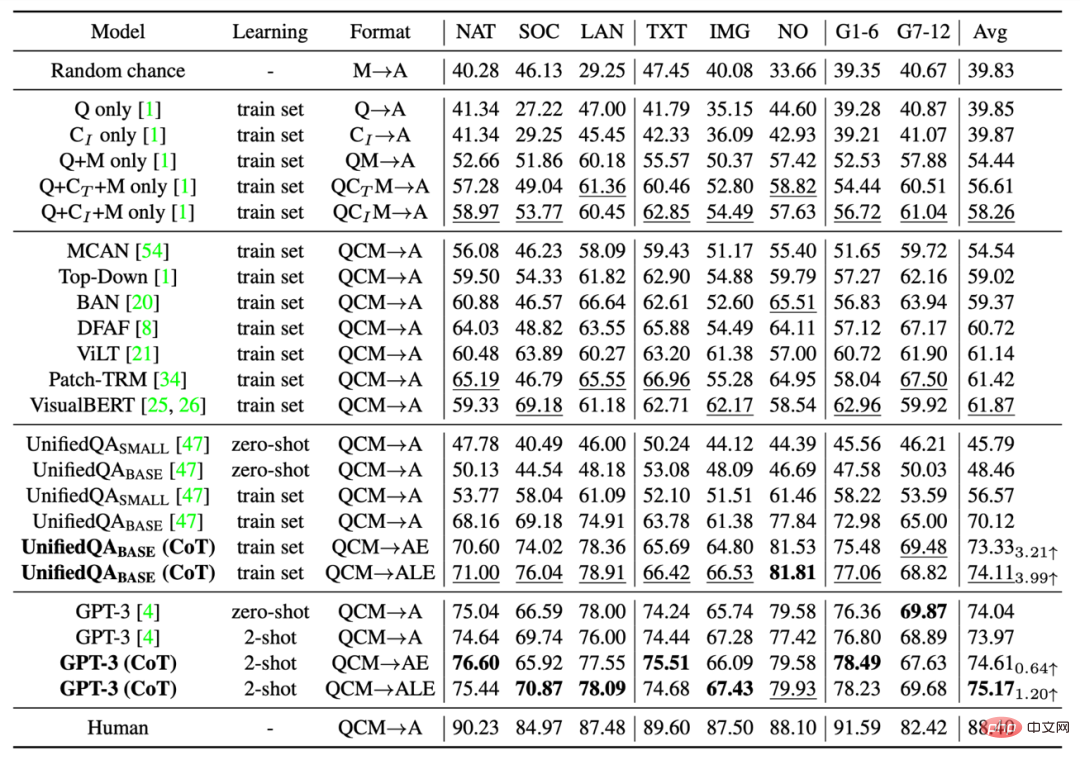

著者は、Top-Down tention、MCAN、BAN、DFAF、ViLT、Patch-TRM、VisualBERT などの VQA モデルや、UnifiedQA などの大規模言語モデルを含む、ScienceQA データセット上のさまざまなベンチマーク手法を評価しています。 GPT-3、ランダムな偶然と人間のパフォーマンス。言語モデル UnifiedQA および GPT-3 の場合、背景画像はテキスト キャプションに変換されます。

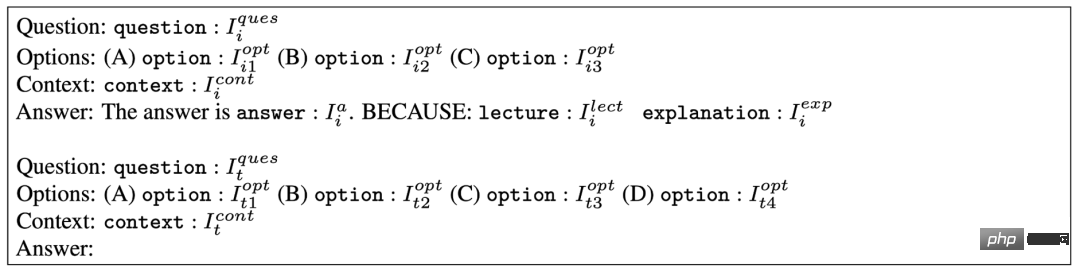

GPT-3 (CoT)

最近の研究成果により、適切な手がかりが与えられると、GPT-3 3 モデルは、さまざまな下流タスクで優れたパフォーマンスを発揮します。この目的を達成するために、著者は、プロンプトに思考連鎖 (CoT) を追加する GPT-3 (CoT) モデルを提案します。これにより、モデルは、回答を生成しながら、対応する背景知識と説明を生成できます。

特定のプロンプト テンプレートを次の図に示します。ここで、Ii はトレーニング例を表し、It はテスト例を表します。トレーニング例には、質問、選択肢、コンテキスト、および回答の要素が含まれており、回答は正解、背景知識 (Lecture)、および説明 (Description) で構成されます。 GPT-3 (CoT) は、入力されたプロンプト情報に基づいて、予想解答、予備知識、テスト例の説明を完了します。

3. 実験と分析

はScienceQA テスト セットのベンチマークとメソッドの精度結果を以下の表に示します。現在最高の VQA モデルの 1 つである VisualBERT は、61.87% の精度しか達成できません。

トレーニング プロセス中に CoT データを導入すると、UnifiedQA_BASE モデルは 74.11% の精度を達成できます。また、GPT-3 (CoT) は、2 つのトレーニング サンプルのプロンプトで 75.17% の精度を達成しました。これは、他のベンチマーク モデル# よりも高い精度です。人間は ScienceQA データセットで優れたパフォーマンスを発揮し、全体的な精度 88.40% を達成し、さまざまなカテゴリの質問にわたって安定したパフォーマンスを発揮しました。

ScienceQA テスト セットでのさまざまなメソッドの結果。

ScienceQA テスト セットでのさまざまなメソッドの結果。

生成された説明の評価

著者は、BLEU などの自動評価指標を使用しています。 1、BLEU-2、ROUGE-L、および文章類似度は、異なる方法で生成された説明を評価します。自動評価指標では予測結果と注釈付きコンテンツの類似性しか測定できないため、著者らはさらに手動評価方法を採用して、生成された説明の関連性、正確性、完全性を評価しました。ご覧のとおり、GPT-3 (CoT) によって生成された説明の 65.2% がゴールド スタンダード

を満たしています。# さまざまな評価方法により、解釈された結果が生成されます。

さまざまなプロンプト テンプレート

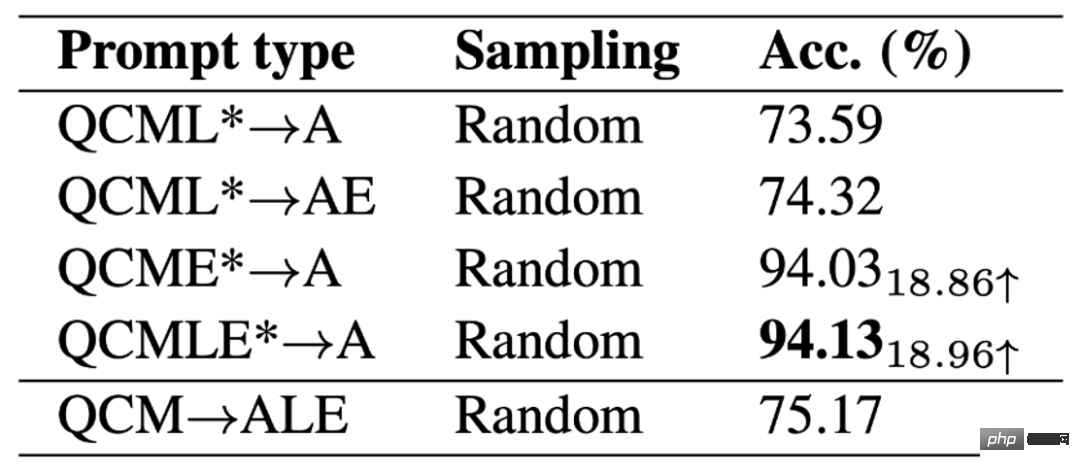

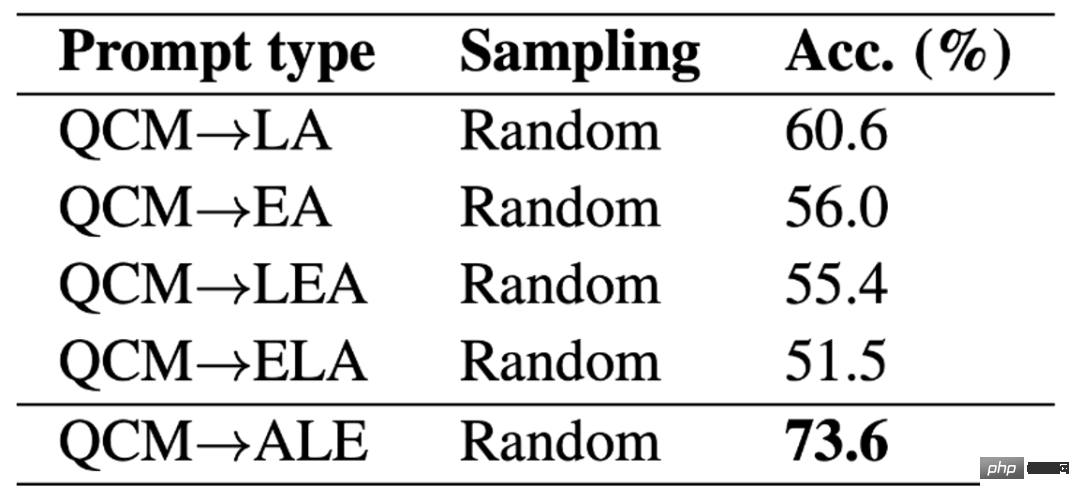

著者は、さまざまなプロンプト テンプレートを比較しました。 GPT-3 (CoT) の精度に対するプロンプト テンプレートの影響

。 QAM-ALE テンプレートの下では、GPT-3 (CoT) が最大の平均精度と最小の分散を取得できることがわかります。さらに、GPT-3 (CoT) は、2 つのトレーニング サンプルのプロンプトが表示された場合に最高のパフォーマンスを発揮します。 #さまざまなプロンプト テンプレートの結果の比較。

#モデルの上限

GPT-3 (CoT) モデルのパフォーマンスの上限を調査するために、著者は注釈付きの背景知識と説明をモデル (QCMLE*-A) の入力に追加しました。 #。 GPT-3 (CoT) は最大 94.13% の精度を達成できることがわかります。これは、モデル改善の可能性のある方向性も示唆しています。つまり、モデルは段階的な推論を実行できます。つまり、最初に正確な背景知識を取得し、正確な説明を生成し、次にこれらの結果を入力として使用します。このプロセスは、人間が複雑な問題を解決する方法と非常によく似ています。

GPT-3 (CoT) モデルのパフォーマンスの上限。

さまざまな ALE の場所

著者はGPT についてさらに詳しく説明します-3 (CoT) 予測を生成するとき、さまざまな ALE 位置が結果に及ぼす影響。 ScienceQA の実験結果によると、GPT-3 (CoT) が最初に背景知識 L または説明 E を生成し、次に回答 A を生成すると、予測精度が大幅に低下することが示されています。主な理由は、背景知識 L と説明 E の単語数が多いためで、LE を先に生成すると、GPT-3 モデルが最大単語数を使い果たすか、早期にテキストの生成を停止して、最終的な答えが得られなくなる可能性があります。 Aは取得できません。

#LE の場所が異なります。 #成功事例

#LE の場所が異なります。 #成功事例

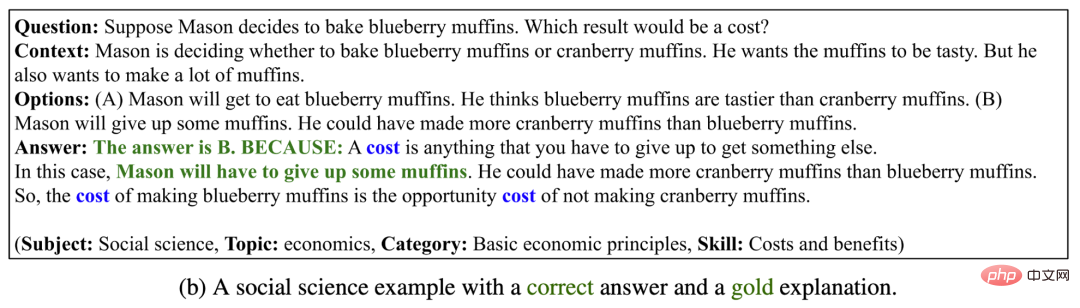

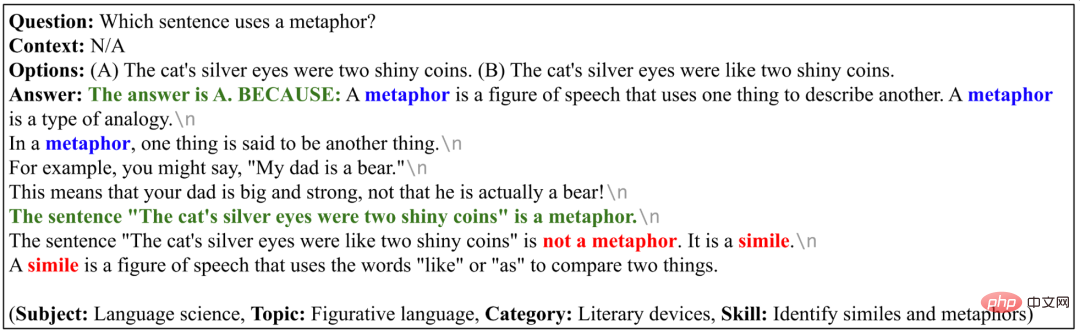

次の 4 つの例のうち、GPT-3 (CoT)

正しい答えを生成するだけでなく、適切で正確かつ完全な説明も提供します。これは、GPT-3 (CoT) が ScienceQA データセット上で強力な複数ステップの推論および説明能力を発揮することを示しています。

GPT-3 (CoT) 正解と説明の生成例。

GPT-3 (CoT) 正解と説明の生成例。

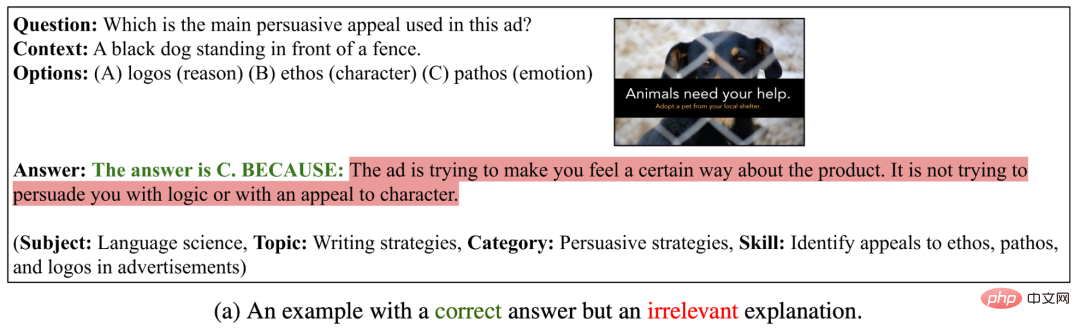

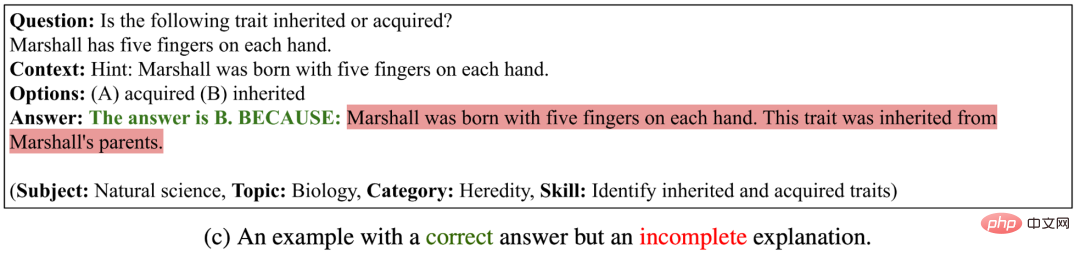

#失敗例 I

以下の 3 つの例では、GPT-3 (CoT) ) 正しい答えが生成されましたが、生成された説明は無関係、不正確、または不完全でした

。これは、GPT-3 (CoT) が論理的に一貫した長いシーケンスを生成するのに依然として大きな困難に直面していることを示しています。

##GPT-3 (CoT) は正しい答えを生成できますが、生成された説明は正しくありません。

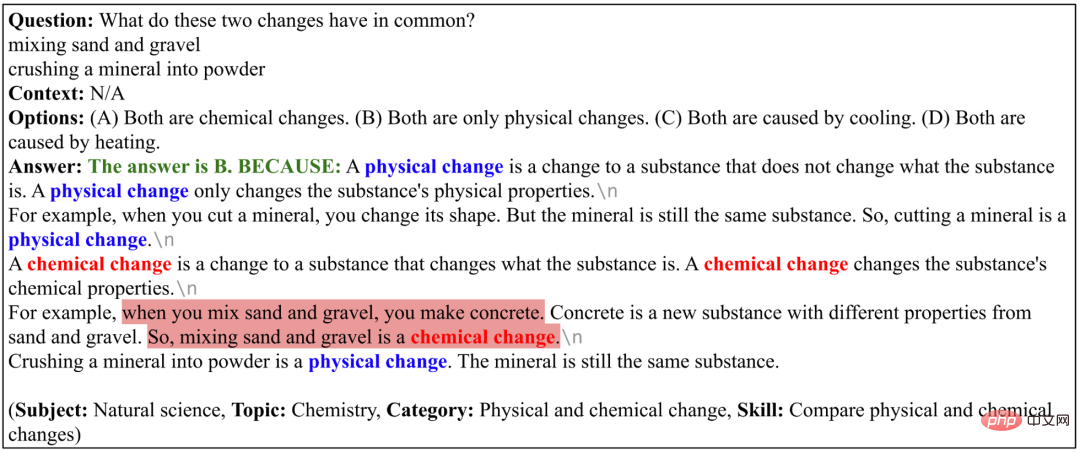

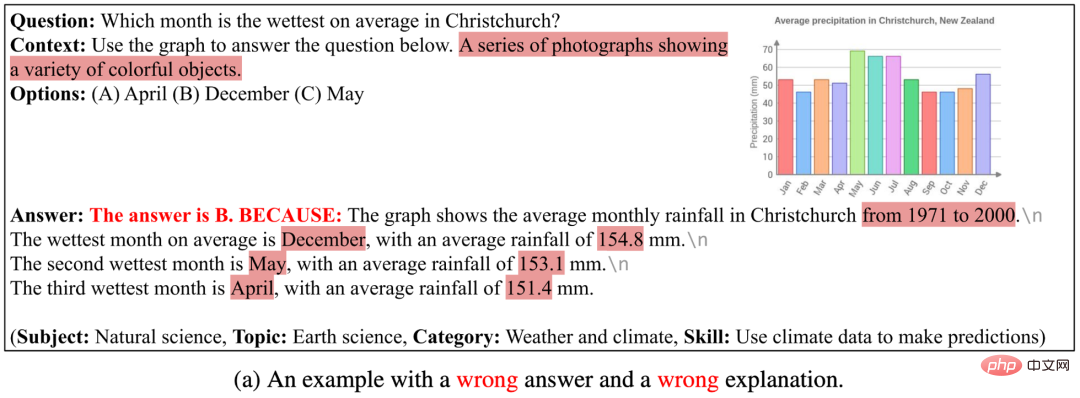

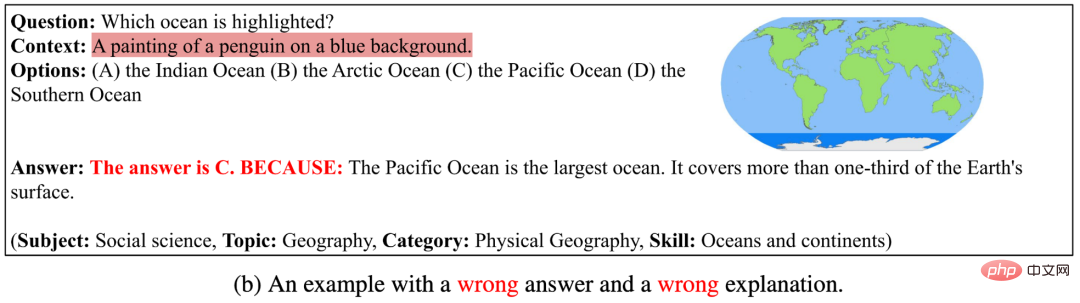

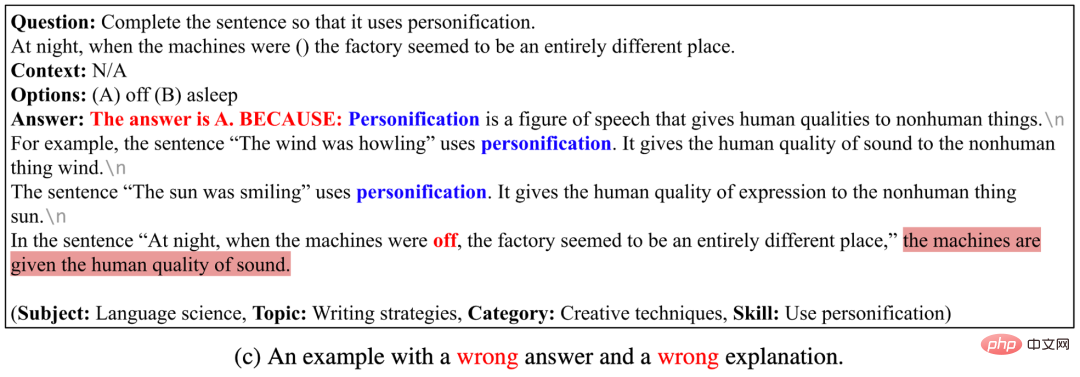

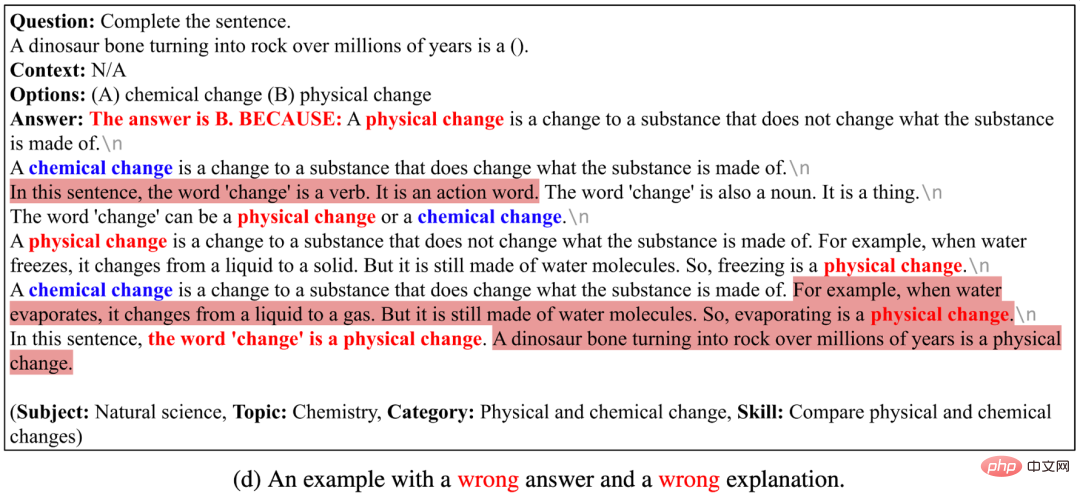

失敗例 II

次の 4 つの例では、GPT-3 (CoT) が正しく生成できません。答えも正しい説明 を生成できません。その理由は、 (1) 現在の画像キャプション モデルは、概略図、表、その他の画像の意味情報を正確に記述することができず、画像が画像注釈テキストで表されている場合、GPT-3 (CoT) は、次の内容を含む質問にまだ答えることができません。チャートの背景 問題; (2) GPT-3 (CoT) が長いシーケンスを生成する場合、矛盾または支離滅裂な問題が発生する傾向があります; (3) GPT-3 (CoT) はまだ特定の質問に答えることができません ドメイン知識の問題。

# #GPT -3 (CoT) は、不正解の例と説明を生成できます。 4. 結論と展望

著者は、詳細な説明を備えた初のマルチモーダルな科学的質問と回答のデータ セットである ScienceQA を提案しました。 ScienceQA には、初等および中等の科学科目からの 21,208 個の多肢選択問題が含まれており、3 つの主要な科学分野とさまざまなトピックをカバーしており、ほとんどの質問には詳細な背景知識と説明が注釈されています。 ScienceQA は、マルチモーダルな理解、複数ステップの推論、解釈可能性におけるモデルの機能を評価します。著者らは、ScienceQA データセットでさまざまなベースライン モデルを評価し、GPT-3 (CoT) モデルが回答を生成しながら、対応する背景知識と説明を生成できることを提案しています。多数の実験分析とケーススタディが、モデルの改善に役立つインスピレーションを提供してきました。以上が詳細な説明を備えた初のマルチモーダル科学質疑応答データセット、深層学習モデルの推論には思考連鎖が含まれていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。