AI の創造物は素晴らしいですが、まだ多くの課題を克服する必要があります

2022年8月、デジタル絵画「スペースオペラ」が優勝し大物議を醸した AIGC(AI生成コンテンツ)は蚊帳の外 世間では事件が多発目。同年11月30日にOpenAIがリリースしたチャットロボットモデルChatGPTは無料で公開されており、AIGCへの幅広い関心を呼び起こし、コードの変更、知識についての会話、人生についての質問など、さまざまな派手な質問を行う。 . ChatGPTの「機知」と「博学さ」「感動的で爽快です。

ChatGPT が広く注目を集めている理由は、OpenAI が 3 世代の GPT モデルをリリースしているためであり、各世代のモデルパラメータは前世代と比較して 10 倍、さらには 100 倍も増加しています。 RLHF (人間のフィードバックからの強化学習) メソッドを使用すると、人間の言語の意味をよりよく理解できるようになります。つまり、チャット、記事の執筆、問い合わせへの回答、コードのチェックなどで人間と対話するとき、私たちは人間の言語に似ています。 「真剣に考えた」上で、じっくり考えた人 答えは「人」です。

サークル内のこのようなホットな話題に直面して、Huoshan 音声および音声合成アルゴリズムの研究者である Stephen 氏は次のように述べています。「最近 AIGC が非常に人気になっている理由は、段階的な改善と切り離せないものです。制作ツールとしての AI は、より高い効率を達成するために、AIGC にはテキスト生成、オーディオ生成、画像生成、ビデオ生成などの多くの方向性が含まれており、これにより、コンテンツの急速な開発が促進されます。人工知能技術がその背後にあり、徐々に大きな商業的価値を反映しています。」

感情的であり、話したり行動したりできることが AI 音声の主な困難になっています

私たちは、AI ペイントによってあなたができることをよく嘆いています。 AIの「想像力」に感謝 ChatGPTに代表されるAIの質問と回答その博学さと回答の「読みやすさ」に衝撃を受ける一方、AIの音声はその人が本物のように内容を正しく理解できるかどうかをテストしますキャラクターの声色と状況に合った口調を合わせて表現するというもので、これはHuoshan Voice(ByteDance AI Labのインテリジェント音声およびオーディオチーム)とTomato Novelの協力でよく見られるAIによって生成された音声です。アルゴリズムを使用すると、小説のテキスト バージョンを直接聞くことができ、より「スマート」に聞こえます。 「: 差別化された音色と適切なトーンで、あなたは「ドラマの女王」になり、「感情、怒り、悲しみ、喜び」を演じることができます。大きな声で読むこと。

AIが表現力豊かで話したり行動したりするためには、まず出力内容を誤って読み取らないようにする必要があり、そのためにはテキスト解析モデルが必要であることがわかっています。 「トマトノベルズでは、テキスト解析フロントエンドにNLP分野で広く使われているTransformerアーキテクチャモデルBERTを使用しています。主に正則化モデル(TN)とニューラルネットワークのマルチタスクフロントエンドモデルをプラスしています。ルールの混合と長期的な手動ルール修正を組み合わせることで、フロントエンドの文レベルの精度が継続的に向上し、蒸留、定量化、その他のテクノロジを通じて必要な計算能力が削減されます。"

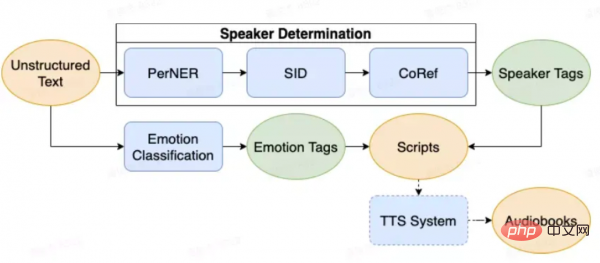

さらに、音声をより良く聞こえるようにするために、チームは、役割の所有権と感情の制御を実現するために、通常の TTS プロセスに基づいて機能モジュールも追加しました。たとえば、BERT 構造は、対話の決定と参照の曖昧さの解消という 2 つのタスクをモデル化する役割帰属にも使用され、また、同様の構造は感情予測にも使用されます。 「通常、小説では複数人での会話が行われ、それぞれの話者がさまざまな感情を持っています。音色と感情を切り離すことができれば、合成音声の表現力をより適切に制御でき、さまざまな音色や感情を表現できるようになります」さまざまな感情を柔軟に組み合わせることが非常に重要です。」

重要なのは、AI がさまざまなタイプの小説のテキストを理解できるようにするために、Huoshan Voice は「AI テキスト理解」モデルの提案でも率先して取り組んだことです。タスク用の長文理解AIシステムを複数個セットにしたものです。小説のテキストから会話の登場人物を自動的に区別し、会話で表現したい感情を特定し、文間の適切な休止を予測することができるため、高品質の AI オーディオブックの制作効率が大幅に向上し、手動の注釈を効果的に突破できます。 。

「アルテキスト理解」モデル

さらに、Huoshan Voice チームは、明瞭な発音、一貫したリズム、イントネーションの起伏に基づいて、音声を Plutchik の音声に従うようにする半教師あり学習のエンドツーエンド スタイルの制御音響モデルを独自開発しました。 Wheel. of Emotions)は、感情移入の手法を用いて、本来感情のない発音に多感情の合成効果を与え、幸福、悲しみ、驚き、恐怖などのさまざまな感情の色を表現します。 「音による感情の表現」をより適切に表現し、人間の言語で頻繁に発生する「パラランゲージ」現象を細心の注意を払ってモデル化および復元し、一般的なアクセントの休止、疑問の質問、笑いと泣き、およびオーディオブックでのさまざまな一般的な音を実現します。叫び声など、テキストの内容を見事に解釈しています。

「実際の人々の音声に近い効果をもたらし、最終的な AI の音声がさまざまな状況におけるさまざまなキャラクターの効果を反映できるようにすることが、私たちが追求してきた目標です。将来的には、これを達成したいと考えています」テキストを介したそれ - 大規模な音声共同トレーニング モデルは、さまざまなコンテキストのテキストから表現を抽出し、文字識別の成功率を向上させます。大規模な複数話者の音声合成モデルでは、感情、スタイル、音色、アクセントなどの属性が分離され、自由に転送できると同時に、テキストの説明に基づいて一致する背景サウンドを生成し、オーディオブックを聴くときの没入感を高めます。」

コンテンツの品質と制作効率の向上は、AIGC の核となる価値です

さらに実践してみると、人々はテキストや画像に加えて、より幅広い用途で音声インタラクションを使用していることがわかりました。たとえば、自宅では音声インタラクションを通じてさまざまな電化製品を制御する指示を出すことがよくありますが、旅行中は音声インタラクションを使用します。ナビゲーションやレストランの予約などを行う車内の音声アシスタント、オフィスシーンで中高周波で使用される会議アシスタントは、コンテンツの品質と制作効率を向上させるインテリジェントな音声ソリューションと切り離すことができません。

これに関して、Huoshan Voice チームは、関連する革新的な試みも行っています。たとえば、ショートビデオが国民的ファッションになっている今日、UGC グループビデオ作成のランダムな録画と制御不能な問題に直面して、 Huoshan Voice Intelligent Subtitles ソリューションは、実用的な要素により、ビデオ作品に自動的に字幕を追加し、中国語、英語、広東語などの一般的に使用される言語や方言の認識と互換性があるだけでなく、曲を認識できる。

これに関して、Huoshan の音声およびオーディオ理解部門のプロダクト マネージャーである W 氏は次のように付け加えました。「ビデオ コンテンツの制作において、字幕を追加する従来の方法では、クリエイターがビデオを口述し、校正する必要があります。また、開始時間に合わせてフレームごとに調整する必要があります。調整には、多くの場合、10 分のビデオを完了するまでに数時間のポストプロダクション時間が必要です。また、字幕チームは複数の言語に堪能で、精通していなければなりません"

創作の敷居を下げ、すべてのクリエイターが高品質のビデオコンテンツを簡単に制作し、美しい生活を記録できるようにするために、Huoshan Voice は自社開発されたインテリジェント字幕ソリューションを発売しました。方言や歌を効率的に認識できるだけでなく、言語が混在したり、話したり歌ったりするシーンでも良好な認識効果を発揮することができ、また、ユーザー作成コンテンツの音声特性やドメイン解析を通じて、アルゴリズムの最適化により、音声認識が大幅に向上し、騒音シーンや複数人での会話などの複雑なシーンでのパフォーマンスが向上します。特にモバイル ユーザーは、機能の応答時間に対する要求が高く、字幕が速くて正確であることを望んでいます。この目的のために、Huoshan Voice はエンジニアリングの最適化と戦略を数多く行ってきました。1 分間のビデオは 1 分間で完成します。ほんの2~3秒です。

ご存知のとおり、同じ内容を前にした場合、人間が音声情報を取得する効率は文字情報に比べて非常に低く、音声をテキストに変換して記録し利用する鍵は音声認識にあります。 Volcano Voice の発売など、「千の単語をテキストにすると、一単語は千の単語に相当する」というリアルタイム字幕ソリューションは、「音声認識と音声翻訳」の AI リンクを使用して、国境を越えた音声翻訳を実現します。言語を超えたコミュニケーションをよりスムーズに、会議記録や議事録を自動生成することで、参加者の作業効率を大幅に向上させ、会議後の整理や会議途中の録音の負担を大幅に軽減します。テクノロジーの急速な発展に伴い、AI 音声により人間とコンピューターの対話のための情報出力チャネルが増加し、情報取得の効率が向上することが予測されます。

AIGC がもたらす品質と効率の向上という問題と同様に、Huoshan Voice 音声インタラクションのプロダクト マネージャーである Y 氏の見解では、AIGC はインテリジェントな音声インタラクションの補助シナリオに実装されることが実際に期待されています。 、会話の要約、音声対話などを実現できます。技術的な推奨、感情的な慰め、作業指示の要約などの顧客サービス機能は、生産効率を向上させるための補助ソリューションを提供します。たとえば、ヒューマン マシンの会話がヒューマン マシンの会話をトリガーすると、マン マシンの会話の概要が自動的に生成され、マン マシンがユーザーの要求をより早く理解し、チャット履歴を確認するための突然の中断を避けることができます。 ; 相手との会話中に、ユーザーの音声を理解することにより、AIGC 機能を使用して顧客サービス参照用の回答が生成され、顧客サービス対話の効率が向上します。

「さらに、異常事態に対処する役割も果たせます。たとえば、ユーザーがイライラしたり、怒ったりしたときに、AICG は顧客サービスの参照用になだめる言葉を自動的に生成し、サービスの満足度を向上させる可能性があります。将来的には、テクノロジーと AIGC テクノロジーが成熟し続けるにつれて、おそらく仮想デジタル ヒューマンが労働力の一部を置き換え、人間と機械の共生の中で顧客に直接サービスを提供し、人件費を大幅に削減し、サービス効率を向上させることができるでしょう。」今日の AIGC はまだ、本当に独立してコンテンツを制作することができず、まだ人間がコンテンツ制作の効率を向上させるのを支援する段階にあることは明らかです。

コスト、著作権、実用性が依然として AIGC 開発のボトルネックです

ChatGPT によって与えられた驚くべき答えであれ、トマトの小説で AI によって演奏された感動的な声であれ、マスクでさえも驚いた : 私たちは危険なほど強力な人工知能からそう遠くはありません。これはAIGCの時代が到来していることを示しているようだ。

しかし、Huoshan 音声および音声合成アルゴリズムの研究者であり、長年 AI アルゴリズムの最前線で働いてきたスティーブン氏は、より冷静な判断を下し、次のように指摘しました。将来的には、シングルモーダルな生成タスクだけでなく、マルチモーダルな融合を実行するように、人間がコンテンツを作成するときと同じように、単一形式の知識に基づいて新しいコンテンツを思いつくだけではありません。顔、表情、姿勢、動作を個別に予測するものですが、将来的には、生成モデルを使用してこれらの特徴を予測し、特徴間の相乗効果を高め、個別の記録による作業負荷を軽減する可能性があります。 、また、マルチモーダルに基づいています。タスクを理解することによって得られる表現は、話しているユーザーの表情、口調、体の動きに基づいており、対応するフィードバックが生成された画像と音声に与えられます。」

技術開発の予測に加えて、無視できない点の 1 つは、AIGC が現在もコスト、著作権、実用性の面で依然として大きな課題に直面しているということです。同氏は、AIGC の現在のコストは依然として高いと考えており、その最も明白な兆候は、高品質のテキスト、画像、ビデオ生成テクノロジなどはすべて、トレーニングと推論の段階で大量のハードウェア リソースを消費することに相当するということです。そのため、大学や研究機関の参加が難しくなり、産業の発展につながりません。 「また、著作権保護の観点から、現在生成されているコンテンツの一部は違法行為に使用される可能性があるため、画像や音声の透かしなどの著作権保護を追加することがますます重要になっています。をコンテンツに追加しますが、プロセス中に、カットや混合などの後処理方法によってウォーターマークの失敗が発生しないようにすることも考慮する必要があります。」 過去 2022 年では、技術適用の影響はありましたが、画像とビデオの生成の方向性は大幅に改善されましたが、コンテンツを実際に実装できるのは、大量の手作業によるスクリーニングを経てからです。また、テキストの長い章に基づいて状況に応じた漫画やビデオを生成することは、シーンの連続性だけでなく、キャラクターの変化も反映しています 手作業を避けるために解決する必要がある技術的問題はまだたくさんあります 知能を「人工知能」に変えるのは課題であり、改善の余地はまだあります実用性。 AIGC が新たなコンテンツ制作手法として注目を集めている理由は、コンテンツ、特にインターネット プラットフォームに対する各界の、いかに効率的に理解し、作成し、実際、コンテンツの対話と配信は、今日の AI テクノロジーに機会と課題をもたらしています。以上がAI の創造物は素晴らしいですが、まだ多くの課題を克服する必要がありますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7549

7549

15

15

1382

1382

52

52

83

83

11

11

22

22

90

90

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

2023年、AI技術が注目を集め、プログラミング分野を中心にさまざまな業界に大きな影響を与えています。 AI テクノロジーの重要性に対する人々の認識はますます高まっており、Spring コミュニティも例外ではありません。 GenAI (汎用人工知能) テクノロジーの継続的な進歩に伴い、AI 機能を備えたアプリケーションの作成を簡素化することが重要かつ緊急になっています。このような背景から、AI 機能アプリケーションの開発プロセスを簡素化し、シンプルかつ直観的にし、不必要な複雑さを回避することを目的とした「SpringAI」が登場しました。 「SpringAI」により、開発者はAI機能を搭載したアプリケーションをより簡単に構築でき、使いやすく、操作しやすくなります。

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

OpenAI は最近、最新世代の埋め込みモデル embeddingv3 のリリースを発表しました。これは、より高い多言語パフォーマンスを備えた最もパフォーマンスの高い埋め込みモデルであると主張しています。このモデルのバッチは、小さい text-embeddings-3-small と、より強力で大きい text-embeddings-3-large の 2 つのタイプに分類されます。これらのモデルがどのように設計され、トレーニングされるかについてはほとんど情報が開示されておらず、モデルには有料 API を介してのみアクセスできます。オープンソースの組み込みモデルは数多くありますが、これらのオープンソース モデルは OpenAI のクローズド ソース モデルとどう違うのでしょうか?この記事では、これらの新しいモデルのパフォーマンスをオープンソース モデルと実証的に比較します。データを作成する予定です

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

AIモデルによって与えられた答えがまったく理解できない場合、あなたはそれをあえて使用しますか?機械学習システムがより重要な分野で使用されるにつれて、なぜその出力を信頼できるのか、またどのような場合に信頼してはいけないのかを実証することがますます重要になっています。複雑なシステムの出力に対する信頼を得る方法の 1 つは、人間または他の信頼できるシステムが読み取れる、つまり、考えられるエラーが発生する可能性がある点まで完全に理解できる、その出力の解釈を生成することをシステムに要求することです。見つかった。たとえば、司法制度に対する信頼を築くために、裁判所に対し、決定を説明し裏付ける明確で読みやすい書面による意見を提供することを求めています。大規模な言語モデルの場合も、同様のアプローチを採用できます。ただし、このアプローチを採用する場合は、言語モデルが

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

著者丨コンパイル: TimAnderson丨プロデュース: Noah|51CTO Technology Stack (WeChat ID: blog51cto) Zed エディター プロジェクトはまだプレリリース段階にあり、AGPL、GPL、および Apache ライセンスの下でオープンソース化されています。このエディターは高性能と複数の AI 支援オプションを備えていますが、現在は Mac プラットフォームでのみ利用可能です。 Nathan Sobo 氏は投稿の中で、GitHub 上の Zed プロジェクトのコード ベースでは、エディター部分は GPL に基づいてライセンスされ、サーバー側コンポーネントは AGPL に基づいてライセンスされ、GPUI (GPU Accelerated User) インターフェイス部分はApache2.0ライセンス。 GPUI は Zed チームによって開発された製品です

OpenAI を待つのではなく、Open-Sora が完全にオープンソースになるのを待ちましょう

Mar 18, 2024 pm 08:40 PM

OpenAI を待つのではなく、Open-Sora が完全にオープンソースになるのを待ちましょう

Mar 18, 2024 pm 08:40 PM

少し前まで、OpenAISora はその驚くべきビデオ生成効果で急速に人気を博し、数ある文学ビデオ モデルの中でも際立って世界的な注目を集めるようになりました。 2 週間前にコストを 46% 削減した Sora トレーニング推論再現プロセスの開始に続き、Colossal-AI チームは世界初の Sora のようなアーキテクチャのビデオ生成モデル「Open-Sora1.0」を完全にオープンソース化し、全体をカバーしました。データ処理、すべてのトレーニングの詳細、モデルの重みを含むトレーニング プロセスを管理し、世界中の AI 愛好家と協力してビデオ作成の新時代を推進します。ちょっと覗いてみましょう。Colossal-AI チームがリリースした「Open-Sora1.0」モデルによって生成された賑やかな街のビデオを見てみましょう。オープンソラ1.0

マイクロソフトとOpenAIは人型ロボットに1億ドル投資する計画!ネチズンはマスク氏に電話をかけている

Feb 01, 2024 am 11:18 AM

マイクロソフトとOpenAIは人型ロボットに1億ドル投資する計画!ネチズンはマスク氏に電話をかけている

Feb 01, 2024 am 11:18 AM

MicrosoftとOpenAIが人型ロボットのスタートアップに巨額の資金を投資していることが年初に明らかになった。このうちマイクロソフトは9500万ドル、OpenAIは500万ドルを投資する予定だ。ブルームバーグによると、同社は今回のラウンドで総額5億米ドルを調達する予定で、資金調達前の評価額は19億米ドルに達する可能性がある。何が彼らを惹きつけるのでしょうか?まずはこの会社のロボット分野の実績を見てみましょう。このロボットはすべて銀と黒で、その外観はハリウッドの SF 大作映画に登場するロボットのイメージに似ています。今、彼はコーヒー カプセルをコーヒー マシンに入れています。正しく置かれていない場合でも、何もせずに自動的に調整されます。人間リモコン: ただし、しばらくすると、コーヒーを持ち帰って楽しむことができます: 家族にそれを認識した人はいますか? はい、このロボットは少し前に作成されました。