近年、画像、テキスト、音声、動画などを含むAI生成コンテンツ(AIGC)が注目を集めていますが、AIGCは諸刃の剣となり批判も受けています。その無責任な使用は物議を醸しています。

画像生成テクノロジーが適切に使用されないと、「被告」になる可能性があります。

最近、Sony AI と Wisdom Source の研究者は、AIGC の現在の問題についてさまざまな側面から議論し、AI が生成したコンテンツをより信頼できるものにする方法について議論しました。

# 論文リンク: https://arxiv.org/pdf/2303.01325.pdf

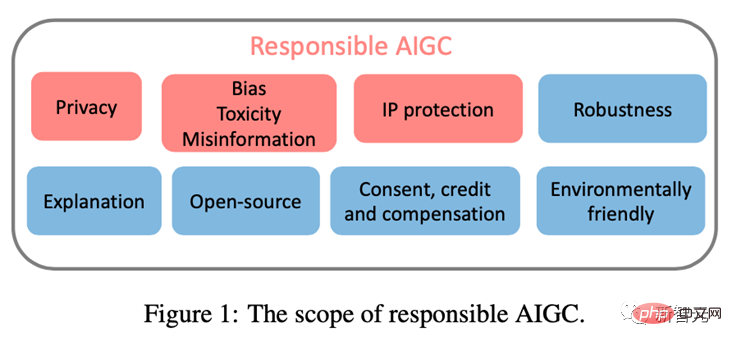

この記事は、AIGC の健全な発展を妨げる可能性のある 3 つの主要な問題に焦点を当てています: (1)プライバシー; (2)バイアス、毒性、誤った情報; (3) 知的財産 (IP) のリスク。

この記事は、既知のリスクと潜在的なリスク、および考えられる AIGC 悪用シナリオを文書化することで、認識を高めることを目的としています。 AIGC の潜在的なリスクと乱用に関する懸念を表明し、社会の利益のためにより倫理的で安全な方向で AIGC の開発を促進するために、これらのリスクに対処するための指示を提供します。

プライバシーご存知のとおり、大規模な基本モデルには一連のプライバシー漏洩の問題があります。

以前の研究では、侵入者が訓練された GPT-2 モデルからシーケンスを生成し、訓練セットから記憶されたシーケンスを識別できることが示されており、[Kandpal et al., 2022] はこれらの成功のおかげであると考えています。トレーニング セット内に重複データが存在するとプライバシーが侵害されるため、研究では、一度しか出現しないシーケンスよりも複数回出現するシーケンスの方が生成される可能性が高いことが実証されています。

AIGC モデルは大規模な Web スクレイピング データでトレーニングされるため、過剰適合とプライバシー漏洩の問題が特に重要になります。

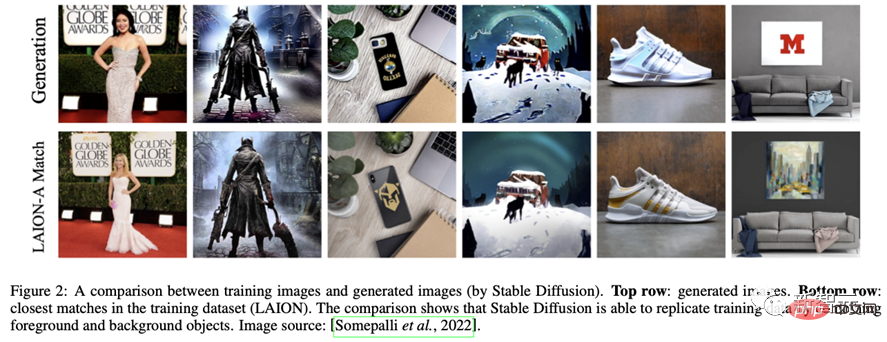

たとえば、安定拡散モデルは、トレーニング データ内の繰り返し画像を記憶します [Rombach et al., 2022c]。 [Somepalli et al., 2022] は、安定拡散モデルがトレーニング データから画像を露骨にコピーし、トレーニング データ セット内の前景オブジェクトと背景オブジェクトの単純な組み合わせを生成することを実証しました。

さらに、このモデルはメモリを再構築する機能を示しており、その結果、元のオブジェクトと意味的には同じですが、ピクセルが異なるオブジェクトが生成されます。さまざまな形のオブジェクト。このようなイメージが存在すると、データの記憶と所有権に関する懸念が生じます。

同様に、最近の調査によると、Google の Imagen システムにも、実在の人物の写真や著作権で保護された画像が漏洩するという問題があることがわかっています。 Matthew Butterick 氏の最近の訴訟 [Butterick, 2023] では、システム内のすべての視覚情報は著作権で保護されたトレーニング画像から得られるため、生成された画像は、外観に関係なく、それらのトレーニング画像の著作物でなければならないと指摘しました。

同様に、DALL・E 2 も同様の問題に悩まされていました。新しい画像を作成する代わりに、トレーニング データから画像をコピーすることがありました。

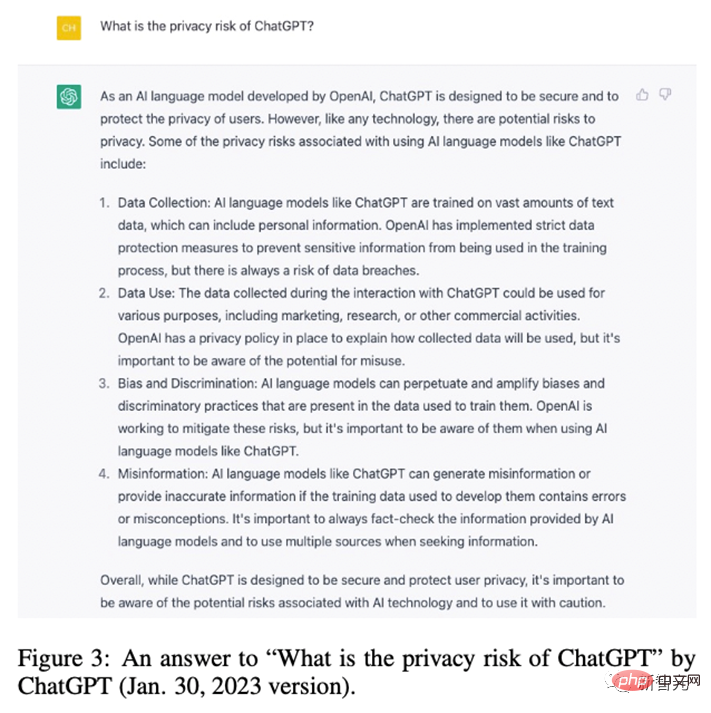

OpenAI は、画像がデータセット内で複数回コピーされたためにこの現象が発生したことを発見し、同様に ChatGPT 自体もプライバシー漏洩のリスクがあることを認めました。

#大規模モデルのプライバシー漏洩問題を軽減するために、多くの企業や研究者がプライバシー保護に多大な努力を払ってきました。産業レベルでは、Stability AI は Stable Diffusion の限界を認識しました。

この目的のために、Stable Diffusion によって記憶された画像を識別するための Web サイト (https://rom1504.github.io/clip-retrieval/) を提供しています。

さらに、アート会社 Spawning AI は、ユーザーが自分の写真や作品を識別できるようにするために、「Have I Been Trained」(https://haveibeentrained.com) という Web サイトを作成しました。人工知能のトレーニングに使用されます。

#OpenAI は、データの重複を減らすことでプライバシーの問題を解決しようとします。

さらに、Microsoft や Amazon などの企業は、従業員の機密漏洩を防ぐために、従業員が機密データを ChatGPT と共有することを禁止しています。この情報は、ChatGPT の将来のバージョンのトレーニングに使用される可能性があるためです。

学術レベルでは、Somepalli らはコンテンツの重複を特定するための画像検索フレームワークを研究し、Dockhorn らは生成データのプライバシーを確保するための差分プライバシー拡散モデルも提案しました。モデル。

偏見、有害性、誤った情報AIGC モデルのトレーニング データは現実世界から取得されていますが、これらのデータは誤って有害な固定観念を強化し、特定の人々を排除したり疎外したりする可能性があります。憎しみや暴力を扇動して個人を怒らせる可能性のある有害なデータソースが含まれている [Weidinger et al., 2021]。

これらの問題のあるデータセットに基づいてトレーニングまたは微調整されたモデルは、有害な固定観念、社会的偏見、有害性を継承したり、不当な差別や特定の社会集団への危害につながる誤った情報を生成したりする可能性があります。

たとえば、Stable Diffusion v1 モデルは主に LAION-2B データセットでトレーニングされており、このデータセットには英語の説明が含まれる画像のみが含まれています。したがって、モデルは白人と西洋文化に偏っており、他の言語からの手がかりが完全には表現されていない可能性があります。

安定拡散モデルの後続のバージョンは LAION データセットのフィルタリングされたバージョンに基づいて微調整されましたが、バイアスの問題は依然として残りました。同様に、DALLA・E、DALLA・E 2、Imagen も社会的偏見と少数派に対する否定的な固定観念を示しています。

さらに、Imagen は人間以外の画像を生成する場合でも、社会的および文化的な偏見を持っていることが示されています。これらの問題のため、Google は Imagen を一般公開しないことを決定しました。

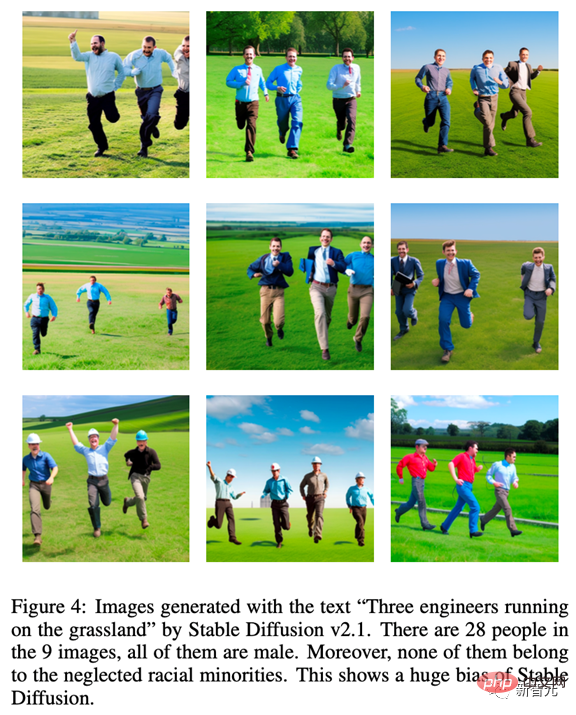

AIGC モデルの固有のバイアスを説明するために、安定拡散 v2.1 をテストしました。「草原を走る 3 人のエンジニア」というプロンプトを使用して生成された画像はすべて男性でした。そして、無視された少数派グループに属するものはどれもなく、結果として得られる画像に多様性が欠如していることを示しています。

さらに、AIGC モデルは誤った情報を生成する可能性もあります。たとえば、GPT およびその派生物によって生成されたコンテンツは、正確かつ信頼できるように見えますが、完全に誤った情報が含まれている可能性があります。

したがって、一部の分野 (学校、法律、医療、天気予報など) では誤解を招く情報が提供される可能性があります。たとえば、医療分野では、ChatGPT によって提供される医療用量に関する回答が不正確または不完全である可能性があり、生命を脅かす可能性があります。交通分野では、ドライバーがChatGPTが示す間違った交通ルールに従うと、事故や死亡事故につながる可能性があります。

問題のあるデータやモデルに対しては、多くの防御手段が講じられてきました。

OpenAI は元のトレーニング データ セットを細かくフィルタリングし、DALLA·E 2 トレーニング データ内の暴力的またはポルノ的なコンテンツを削除します。ただし、フィルタリングによりトレーニング データにバイアスが生じる可能性があります。その後、下流のモデルに伝播されます。

この問題を解決するために、OpenAI はフィルターによって引き起こされるバイアスを軽減する事前トレーニング テクノロジーを開発しました。さらに、AIGC モデルが現在の社会状況をタイムリーに反映できるようにするために、研究者はモデルで使用されるデータセットを定期的に更新する必要があり、これは情報の遅れによる悪影響を防ぐのに役立ちます。

ソース データの偏見や固定観念は減らすことができますが、AIGC モデルのトレーニングと開発中に依然として広まったり、悪化したりする可能性があることに注意してください。したがって、データ ソース レベルだけでなく、モデルのトレーニングと開発のライフサイクル全体を通じて、バイアス、有害性、誤った情報の存在を評価することが重要です。

AIGC の急速な発展と広範な応用に伴い、AIGC の著作権問題は特に重要になってきています。

2022 年 11 月、Matthew Butterick 氏は、Microsoft の子会社である GitHub に対して、同社の製品コード生成サービス Copilot が著作権法を侵害しているとして集団訴訟を起こしました。テキストから画像へのモデルと同様に、一部の生成モデルは、アーティストの作品に対する本来の権利を侵害していると非難されています。

[Somepalli et al., 2022] は、安定拡散によって生成された画像がトレーニング データからコピーされる可能性があることを示しています。 Stable Diffusion は、生成された画像の所有権を一切否定し、画像コンテンツが合法で無害である限り、ユーザーがそれらを自由に使用できるようにしていますが、この自由は依然として著作権をめぐる激しい紛争を引き起こしています。

安定拡散のような生成モデルは、知的財産所有者の許可なしにインターネットからの大規模な画像でトレーニングされるため、これが権利を侵害していると考える人もいます。

知的財産問題に対処するために、多くの AIGC 企業が行動を起こしています。

たとえば、Midjourney は利用規約に DMCA 削除ポリシーを盛り込んでおり、アーティストが著作権侵害の疑いがある場合に自分の作品をデータセットから削除するようリクエストできるようにしています。

同様に、Stability AI は、Stable Diffusion の将来のバージョンのトレーニング セットから自分の作品を除外するオプションをアーティストに提供する予定です。さらに、テキスト透かし [He et al., 2022a; He et al., 2022b] を使用して、これらの AIGC ツールが他のソースからのサンプルを許可なく使用しているかどうかを識別することもできます。

たとえば、Stable Diffusion は、Getty Images の透かしが付いた画像を生成しました [Vincent、2023]。

OpenAI は、GPT モデルによって生成されたテキストを識別する透かし技術を開発しています。これは、教育者が課題の盗作を検出するために使用できるツールです。 Googleはまた、公開する画像にPartiウォーターマークを適用している。 OpenAI は、透かしに加えて、AI が生成したテキストと人間が書いたテキストを区別するための分類子を最近リリースしました。

AIGC はまだ初期段階にありますが、急速に拡大しており、当面は活動を続けるでしょう。

ユーザーと企業がこれらのリスクを十分に理解し、これらの脅威を軽減するための適切な措置を講じられるように、この記事では AIGC モデルの現在および潜在的なリスクを要約します。

これらの潜在的なリスクを完全に理解できず、適切なリスク予防策と安全保証が採用されない場合、AIGC の開発は重大な課題や規制上の障害に直面する可能性があります。 したがって、責任ある AIGC に貢献するには、より広範なコミュニティの参加が必要です。

最後に、SonyAI と BAAI に感謝します。

以上が法のギリギリをさまよう「画像生成技術」:この論文が教える「被告」にならないためのコツの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。