警告! ChatGPT の爆発によって引き起こされたエネルギー消費危機は、データセンター運営者に大きな課題をもたらしています

最近、アメリカの OpenAI 社が所有するインテリジェントなチャット ツールである ChatGPT がソーシャル メディアを席巻し、100 億ドルを超える投資を集め、資本市場における人工知能アプリケーションの大ブームを引き起こしています。一時的に脚光を浴びる。

Microsoft が OpenAI への 100 億ドルの投資を最初に発表し、その後 Amazon と米国版「Today's Headlines」BuzzFeed が発表しました。日常業務で ChatGPT が可能になるとのこと。Baidu も 3 月に ChatGPT チャットボットの「中国語版」のリリースを発表しました。多くのテクノロジー企業が火に油を注いだ後、ChatGPT は即座に世界的な注目を集めました。

データによると、Amazon が導入するロボットの数は急速に増加しており、1 日あたりの増加数は約 1,000 に達しています。さらに、Facebookの親会社Metaも2023年にデータセンターに40億~50億ドルを追加投資する予定で、その全額が人工知能に使用されると予想されている。 IBMのクリシュナCEOは、人工知能は2030年までに世界経済に16兆ドルの貢献をすると予想されていると述べた。

ChatGPT の人気により、2023 年には大手企業が人工知能の分野で新たな熾烈な戦いを開始する可能性があります。

ただし、ChatGPT-3 は次の単語を予測するときに複数の推論計算を実行する必要があるため、多くのリソースと電力を消費します。クラウド コンピューティング、ビデオ ストリーミング、5G ネットワークの爆発的な成長をサポートするためにデータ センター インフラストラクチャが拡大するにつれ、その GPU および CPU アーキテクチャは差し迫ったコンピューティング ニーズを満たすために効率的に動作できなくなり、ハイパースケール データセンター オペレーターにとって大きな課題となっています。

GPT3.5 トレーニングでは、Microsoft が特別に構築した AI コンピューティング システム、10,000 個の V100 GPU で構成される高性能ネットワーク クラスターを使用し、総コンピューティング電力消費量は約 3640 PF 日です。 (つまり、1 秒あたり 1 京回計算される場合、計算には 3640 日かかります)。このような大規模かつ長期にわたる GPU クラスターのトレーニング タスクでは、ネットワーク相互接続ベースのパフォーマンス、信頼性、コスト、その他の側面に極端な要件が課されます。

たとえば、Meta は、世界中のデータセンターの拡張を一時停止し、人工知能のデータ処理ニーズを満たすためにこれらのサーバー ファームを再構成すると発表しました。

人工知能プラットフォームにおけるデータ処理の需要は非常に大きいです。ChatGPT の OpenAI 作成者は、昨年 11 月にこのプラットフォームを立ち上げました。Microsoft が今後予定している Azure クラウド プラットフォームのアップグレードに乗らなければ、継続することはできません。 。 走る。

このデジタル変革をサポートするデータセンター インフラストラクチャは、人間の脳のように 2 つの半球、つまり葉に組織され、一方の葉は他方の葉よりもはるかに強力である必要があります。 1 つの半球は、「トレーニング」と呼ばれるものを提供します。これは、ChatGPT が生成する単語サラダを作成するために最大 300B のデータ ポイントを処理するのに必要な計算能力です。

トレーニング フラップには強力なコンピューティング能力と最先端の GPU 半導体が必要ですが、現在はクラウド コンピューティング サービスと 5G ネットワークをサポートするデータセンター クラスターで必要とされています。接続性はほとんどありません。

同時に、各 AI プラットフォームの「トレーニング」に重点を置いたインフラストラクチャにより、膨大な電力需要が発生し、ギガワットの再生可能エネルギーの近くにデータ センターを設置する必要があります。液体冷却システム、再設計されたバックアップ電源および発電機システムなどの新しい設計機能が搭載されています。

人工知能プラットフォーム 脳のもう一方の半球では、「推論」モードとして知られる高機能デジタル インフラストラクチャが、入力された質問に応答する、または入力された質問の数秒以内に応答する対話型の「生成」プラットフォームをサポートしています。命令に従うと、クエリが処理され、モデル化されたデータベースに入力され、説得力のある人間の構文で応答されます。

北米最大のデータセンタークラスターなど、今日のデータセンターネットワークはハイパーコネクトされていますが、北バージニアの「データセンター」には、人工知能の下流域に対応できる最も広範な光ファイバーネットワークもあります。脳の「推論」ローブ レベル 1 の接続が必要ですが、これらの施設も、必要な膨大な処理能力を満たすためにアップグレードする必要があり、変電所に近づける必要があります。

さらに、研究機関のデータによると、データセンターは世界最大のエネルギー消費者となっており、総電力消費量に占めるデータセンターの割合は2017年の3%から2025年には4.5%に増加すると予想されています。中国を例に挙げると、全国で稼働するデータセンターの電力消費量は2030年に4,000億kWhを超えると予想されており、同国の総電力消費量の4%を占める。

したがって、デジタル製品であっても開発と消費にはエネルギーが必要であり、ChatGPTも例外ではなく、機械学習作業における推論処理が計算電力消費量の80~90%を占めると推定されています。 ChatGPT 2022 年 11 月 30 日にオンラインになって以来、二酸化炭素排出量は 814.61 トンを超えました。

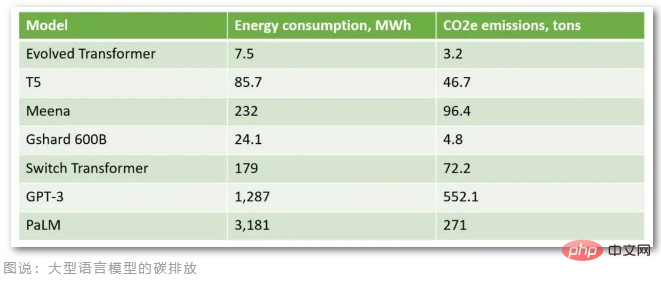

専門組織の計算によると、Microsoft の Azure クラウドでホストされている ChatGPT に 1 日あたり 100 万件のユーザー問い合わせがあると仮定して (特定の応答時間と語彙の下で 1 日あたり約 29,167 時間)、 A100 GPU の最大電力 407W (ワット) に基づくと、1 日あたりの二酸化炭素排出量は 3.82 トンに達し、月間二酸化炭素排出量は 100 トンを超えます。現在、ChatGPT には毎日 1,000 万人を超えるユーザーがおり、実際の二酸化炭素排出量は 1 か月あたり 100 トンをはるかに超えています。さらに、1,750億個のパラメーターを含むこのような大規模な言語モデルをトレーニングするには、数万のCPU/GPUが24時間データを入力する必要があり、約1,287MWhの電力を消費し、552トン以上の二酸化炭素を排出します。

これらの大規模言語モデルの二酸化炭素排出量から判断すると、ChatGPT の前身である GPT-3 が最も二酸化炭素排出量が大きくなります。アメリカ人は毎年平均16.4トンの二酸化炭素を排出し、デンマーク人は毎年平均11トンの二酸化炭素を排出していると報告されています。その結果、ChatGPT のモデルは、デンマーク人 50 人が年間排出する炭素排出量よりも多くの炭素排出量を排出するようにトレーニングされています。

クラウド コンピューティング プロバイダーも、データ センターが大量の電力を使用することを認識しており、再生可能エネルギーと自然冷却条件を利用するために北極にデータ センターを構築および運営するなど、効率を向上させるための措置を講じています。しかし、これでは AI アプリケーションの爆発的な成長に対応するには十分ではありません。

米国のローレンス バークレー国立研究所は、過去 20 年間、データセンターの効率向上によりエネルギー消費量の増加が抑制されてきたことを研究で発見しましたが、現在のエネルギー効率対策ではエネルギー消費量の増加を抑制するのに十分ではない可能性があることを研究で示しています。将来のデータセンターのニーズに応えます。

人工知能業界は現在、重要な転換点にあります。生成 AI、画像認識、データ分析における技術の進歩により、機械学習の独自の接続と用途が明らかになりつつありますが、このニーズを満たすことができるテクノロジー ソリューションをまず構築する必要があります。なぜなら、ガートナーによると、より持続可能な選択がなければ、そうでなければ 2025 年までに, AIは人間の活動よりも多くのエネルギーを消費します。

以上が警告! ChatGPT の爆発によって引き起こされたエネルギー消費危機は、データセンター運営者に大きな課題をもたらしていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7700

7700

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1230

1230

29

29

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Samsung、BM1743 データセンターグレード SSD を発表: v7 QLC V-NAND を搭載し、PCIe 5.0 をサポート

Jun 18, 2024 pm 04:15 PM

Samsung、BM1743 データセンターグレード SSD を発表: v7 QLC V-NAND を搭載し、PCIe 5.0 をサポート

Jun 18, 2024 pm 04:15 PM

6 月 18 日のこのサイトのニュースによると、サムスン セミコンダクターは最近、最新の QLC フラッシュ メモリ (v7) を搭載した次世代データセンター グレードのソリッド ステート ドライブ BM1743 をテクノロジー ブログで紹介しました。 ▲Samsung QLCデータセンターグレードのソリッドステートドライブBM1743 4月のTrendForceによると、QLCデータセンターグレードのソリッドステートドライブの分野で、SamsungとSK Hynixの子会社であるSolidigmだけが企業向け顧客検証に合格したという。その時。前世代の v5QLCV-NAND (このサイトの注: Samsung v6V-NAND には QLC 製品がありません) と比較して、Samsung v7QLCV-NAND フラッシュ メモリは積層数がほぼ 2 倍になり、記憶密度も大幅に向上しました。同時に、v7QLCV-NAND の滑らかさ

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

オープン AI がついに検索に進出します。サンフランシスコの同社は最近、検索機能を備えた新しい AI ツールを発表した。今年 2 月に The Information によって初めて報告されたこの新しいツールは、まさに SearchGPT と呼ばれ、次のような機能を備えています。