ヒントンの最新研究: ニューラル ネットワークの未来はフォワードフォワード アルゴリズムです

過去 10 年間、深層学習は驚くべき成功を収め、多数のパラメーターとデータを使用した確率的勾配降下法が効果的であることが証明されました。勾配降下法では通常、バックプロパゲーション アルゴリズムが使用されるため、脳がバックプロパゲーションに従うかどうか、接続の重みを調整するために必要な勾配を取得する他の方法があるかどうかなどの疑問が常に大きな注目を集めてきました。

チューリング賞受賞者でディープラーニングのパイオニアであるジェフリー・ヒントンは、バックプロパゲーションの提案者の一人として、バックプロパゲーションでは脳の働きを説明できないと近年繰り返し提案してきました。代わりに、彼は新しいニューラル ネットワーク学習方法である前方前方アルゴリズム (FF) を提案しています。

最近の NeurIPS 2022 カンファレンスで、ヒントン氏は「ディープ ニューラル ネットワークをトレーニングするためのフォワード-フォワード アルゴリズム」と題した特別講演を行い、フォワード アルゴリズムについて説明しました。逆アルゴリズム。論文「The Forward-Forward Algorithm: Some Preliminary Investigations」の初稿はトロント大学のホームページに掲載されています:

##paper アドレス: https://www.cs.toronto.edu/~hinton/FFA13.pdf

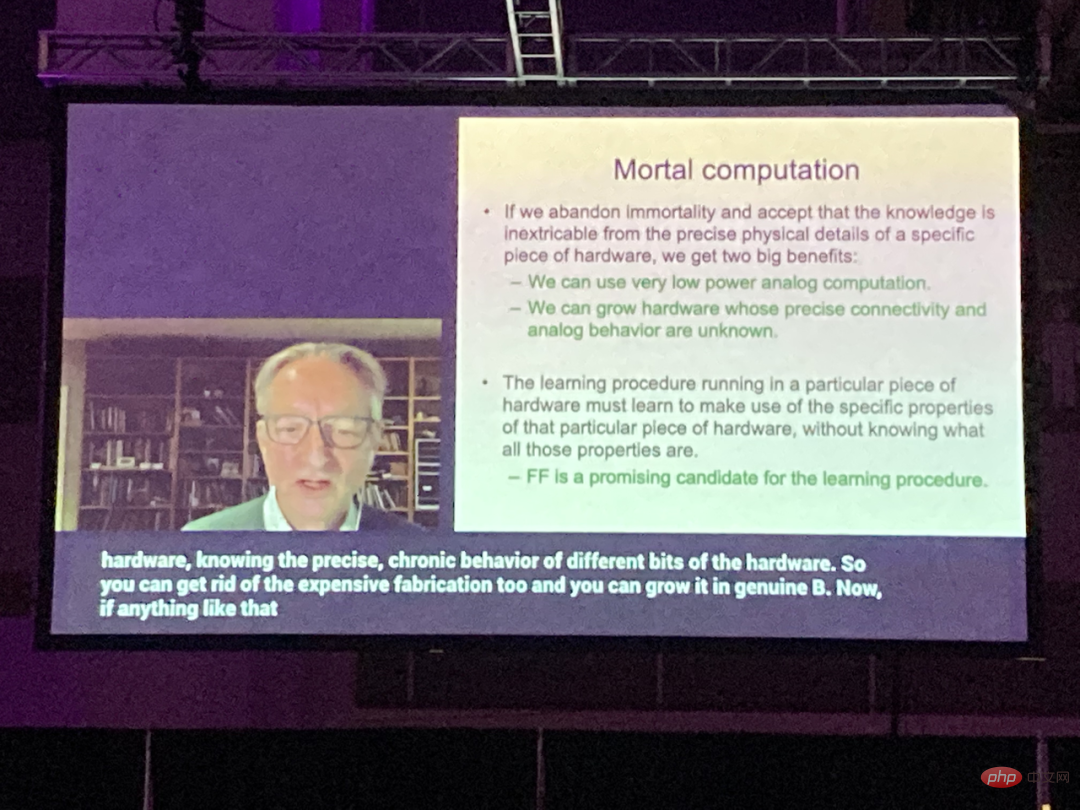

は、1 つの順方向パスを使用するバックプロパゲーション アルゴリズムとは異なります。 FF アルゴリズムは 2 つの順方向パスで構成され、1 つは正 (つまり実数) データを使用し、もう 1 つはネットワーク自体によって生成された負のデータを使用します。ヒントンは、FF アルゴリズムの利点は、脳の皮質学習をより適切に説明でき、極めて低い消費電力でハードウェアをシミュレートできることであると考えています。

ヒントンは、ソフトウェアとハードウェアを分離するコンピュータの形式を放棄すべきであると主張しています。将来のコンピュータは「死なない」ように設計され、それによってコンピューティング リソースを大幅に節約する必要があります。

FF アルゴリズムは、この種のハードウェアで効率的に実行するためのまさに最適な学習方法です。#これは、将来、数兆のパラメータを持つ大規模モデルの計算能力の制約を解決する理想的な方法となる可能性があります。

#1

FF アルゴリズムは、逆アルゴリズムよりも脳の説明に優れており、よりエネルギーを節約できます

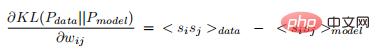

## FF アルゴリズムでは、各層に独自の目的関数があり、正のデータの場合は良好度が高く、負のデータの場合は良好度が低くなります。レイヤー内のアクティビティの平方和は、良さの尺度として使用できます。また、アクティビティの平方和を減算するなど、他にも多くの可能性があります。

ポジティブ パスとネガティブ パスを時間内に分離できれば、ネガティブ パスをオフラインで完了でき、ポジティブ パスの学習がより簡単になり、アクティビティを保存せずにネットワーク経由でビデオを送信できるようになります。または終端伝播導関数。

ヒントンは、FF アルゴリズムが 2 つの点でバックプロパゲーションよりも優れていると考えています。

まず、FF は大脳皮質の学習について説明します。より良いモデル;

第 2 に、FF はエネルギー効率が高く、 強化学習に頼らずに非常に低電力のシミュレーション ハードウェアを使用します。

皮質が誤差導関数を伝播したり、後続の逆伝播のために神経活動を保存したりするという具体的な証拠はありません。ある皮質領域から視覚経路の以前の領域へのトップダウン接続は、視覚系でバックプロパゲーションが使用される場合に期待されるボトムアップ接続を反映しません。代わりに、神経活動が 2 つの領域 (約 6 つの皮質) を通過して、開始された場所に戻るループを形成します。

数列を学習する方法の 1 つとして、時間によるバックプロパゲーションの信頼性は高くありません。頻繁に中断することなく一連の感覚入力を処理するには、脳は感覚処理のさまざまな段階を通じてデータを送信する必要があり、また、その場で学習できるプロセスも必要とします。パイプラインの後の表現は、パイプラインの初期段階の表現に影響を与えるトップダウンの情報を後から提供する可能性がありますが、知覚システムは停止してバックプロパゲーションを行うのではなく、リアルタイムで推論して学習する必要があります。

バックプロパゲーションのもう 1 つの重大な制限は、正しい導関数を導出するために順伝播によって実行される計算を完全に理解する必要があることです。順伝播にブラックボックスを挿入した場合、ブラックボックスの微分可能モデルを学習しない限り逆伝播は実行できません。

ブラック ボックスは、バックプロパゲーションを実行する必要がないため、FF アルゴリズムの学習プロセスには影響しません。

完璧な順伝播モデルがない場合は、さまざまな強化学習手法から始めることができます。 1 つのアイデアは、重みまたは神経活動に対してランダムな摂動を実行し、これらの摂動を結果として生じるペイオフ関数の変化と相関させることです。ただし、強化学習には分散が大きいという問題があるため、他の変数が同時に摂動されると、単一の変数の摂動の影響を確認することが困難になります。これを行うには、他のすべての摂動によって引き起こされるノイズを平均化するために、学習率が摂動される変数の数に反比例する必要があります。これは、強化学習が数百万または数十億のバックプロパゲーション競合パラメーターを含む大規模ネットワークにあまり適応できないことを意味します。そしてヒントンの主張は、未知の非線形性を含むニューラル ネットワークは強化学習に頼る必要がないということです。

FF アルゴリズムは、速度の点ではバックプロパゲーションに匹敵します。その利点は、順方向計算の正確な詳細が不明な場合に使用できることです。ニューラル ネットワークでは、学習は、ニューラル アクティビティを保存したり、伝播誤差導関数を終了したりする必要なく、シーケンシャル データのパイプライン処理中に行われます。

ただし、電力に制約のあるアプリケーションでは、FF アルゴリズムはまだバックプロパゲーションに取って代わられていません。たとえば、非常に大規模なデータセットでトレーニングされた非常に大規模なモデルの場合、まだ可能です。主にバックプロパゲーションです。前方アルゴリズム

前方アルゴリズムは、Glass Oltzmann マシンとノイズ対比推定からインスピレーションを得た貪欲な多層学習手順です。

バックプロパゲーションの前方パスと後方パスを、異なるデータと反対のターゲットに対して動作し、互いにまったく同じように動作する 2 つの前方パスに置き換えます。このうち、順方向チャネルは実際のデータを操作して重みを調整して各隠れ層の好感度を高め、逆方向チャネルは「負のデータ」の重みを調整して各隠れ層の好感度を下げます。

この記事では、神経活動の二乗和と負の活動の二乗和という 2 つの異なる指標について説明します。

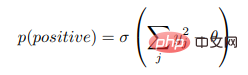

特定の層の良さ関数がその層内の整流された線形ニューロン活動の二乗和であり、学習の目的はその良さを既存の層の良さよりもはるかに高くすることであると仮定します。実データの特定のしきい値であり、負のデータのしきい値をはるかに下回っています。つまり、入力ベクトルが正または負のデータとして正しく分類された場合に正 (つまり、真) である確率は、ロジスティック関数 σ を善度からしきい値 θ を差し引いた値に適用することで決定できます。

##ここで、

は、層正規化前の隠れユニット j のアクティビティです。ネガティブ データは、ニューラル ネットワークのトップダウン接続によって予測することも、外部から提供することもできます。  レイヤーごとの最適化関数を使用した多層表現の学習

レイヤーごとの最適化関数を使用した多層表現の学習

次のようにして位置合わせを達成できることが簡単にわかります。単一の隠れ層を学習するための隠れユニットのアクティビティの二乗の合計。データの場合は高く、負のデータの場合は低くなります。ただし、最初の隠れ層アクティビティが 2 番目の隠れ層の入力として使用される場合、新しい特徴を学習することなく、最初の隠れ層のアクティビティ ベクトルの長さのみが正のデータと負のデータを区別するために適用されます。

この状況を防ぐために、FF は隠れベクトルの長さを次の層の入力として使用する前に正規化し、最初の隠れ層を決定するために使用された情報をすべて削除します。したがって、次の隠れ層は、層の正規化の影響を受けない、最初の隠れ層内のニューロンの相対活動情報を使用することになります。

つまり、最初の隠れ層のアクティビティ ベクトルには長さと方向があります。長さは層の良性を定義するために使用され、方向のみが次の隠れ層に渡されます。層。

#2

FF アルゴリズムの実験

バックプロパゲーション ベースライン

この記事の実験のほとんどでは、手書き数字の MNIST データセットを使用しました。トレーニングに 50,000、適切なハイパーパラメーターの検索時の検証に 10,000、テスト エラー率の計算に 10,000 です。いくつかの隠れ層を使用して設計された畳み込みニューラル ネットワークでは、約 0.6% のテスト誤差を達成できます。

タスクの「配置不変」バージョンでは、ニューラル ネットワークはピクセルの空間レイアウトに関する情報を取得しません。トレーニングの開始前に、すべてのトレーニング画像とテスト画像が同じピクセルのランダムな突然変異の影響を受ける場合、ニューラル ネットワークは同様に良好に機能します。

このタスクの「順列不変」バージョンの場合、完全に接続された複数の隠れ層を持つ修正線形単位 (ReLU) を備えたフィードフォワード ニューラル ネットワークのテスト誤差は約 1.4% です。ここで、トレーニングには約 20 エポックかかります。ドロップアウト (トレーニングを遅くする) やラベル スムージング (トレーニングを高速化する) などのさまざまな正則化機能を使用すると、テスト エラーを約 1.1% に減らすことができます。さらに、ラベルの教師あり学習と教師なし学習を組み合わせることで、テスト誤差をさらに減らすことができます。

複雑な正則化子を使用しない場合、タスクの「順列不変」バージョンでは 1.4% のテスト誤差が達成され、学習プロセスがバックプロパゲーションと同じくらい効果的であることが実証されました。

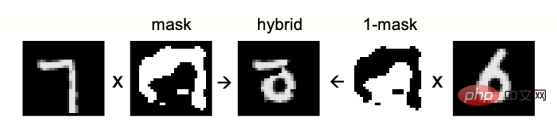

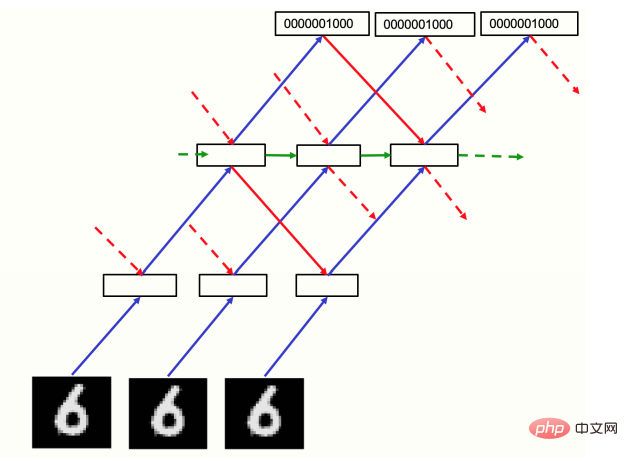

#図 1: ネガティブ データとして使用される混合画像

教師なしFF アルゴリズム

FF 答えるべき主な質問は 2 つあります。ネガティブ データの適切なソースが与えられた場合、データ構造をキャプチャするための効率的な多層表現を学習できるでしょうか。ネガティブなデータはどこから来るのでしょうか?

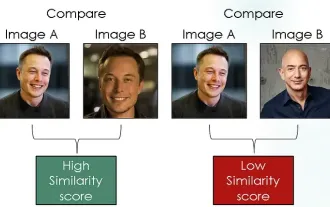

まず、手動のネガティブ データを使用して最初の質問に答えます。教師あり学習タスクで対照学習を使用する一般的な方法は、ラベルに関する情報をまったく使用せずに入力ベクトルを表現ベクトルに変換し、ソフトマックスで確率分布を決定することを使用してこれらの表現ベクトルをロジット ベクトルに単純に線形変換する方法を学習することです。ラベルの。明らかな非線形にもかかわらず、これは依然として線形分類器と呼ばれ、隠れ層の学習が含まれず、導関数の逆伝播が必要ないため、ロジット ベクトルの線形変換の学習が監視されます。 FF は、実際のデータ ベクトルを正の例として使用し、破損したデータ ベクトルを負の例として使用して、この表現学習を実行できます。

FF が形状画像の長期相関の特徴付けに重点を置くようにするには、長期相関は異なるものの、短期相関は非常に似ている負のデータを作成する必要があります。これは、1 と 0 の領域からなるかなり大きなマスクを持つ Complete を作成することで実行できます。次に、マスクにデジタル画像を追加し、マスクの反対側に別のデジタル画像を加算することで、ネガ データのハイブリッド画像が作成されます (図 1)。

ランダムなビットマップからマスクの作成を開始し、[1/4、1/2、1/4] 形式のフィルターを水平方向と垂直方向の両方に使用して繰り返し画像をぼかします。繰り返しぼやける画像の閾値は 0.5 に設定されました。 4 つの隠れ層 (各隠れ層には 2000 ReLU が含まれる) を使用して 100 エポックのトレーニングを行った後、最後の 3 つの隠れ層の正規化されたアクティビティ ベクトルがソフトマックス入力として使用される場合、テスト誤差は 1.37% になります。

さらに、完全に接続された層を使用するのではなく、ローカルの受容野を (重み共有なしで) 使用すると、パフォーマンスを向上させることができます。60 エポックのトレーニングのテスト誤差は 1.16% です。アーキテクチャは「」を使用しています。 「ピア正規化」により、隠れたユニットが過剰にアクティブになったり、永久にシャットダウンしたりするのを防ぎます。

教師あり学習 FF アルゴリズム

ラベル情報を使用せずに隠れた表現を学習し、最終的にはさまざまなタスクを実行できる可能性があります。モデル: 教師なし学習では、タスクごとに大規模な特徴セットが抽出されます。ただし、単一のタスクのみに興味があり、小規模なモデルを使用したい場合は、教師あり学習の方が適しています。

教師あり学習で FF を使用する 1 つの方法は、入力にラベルを含めることです。正のデータは正しいラベルを持つ画像で構成され、負のデータは誤ったラベルを持つ画像で構成されます。ラベルは 2 つの間の唯一のものです違いは、FF はラベルに関係のない画像内のすべての特徴を無視することです。

MNIST 画像には、畳み込みニューラル ネットワークの作業を容易にするために黒い境界線が含まれています。最初の隠れ層の学習コンテンツは、最初の 10 ピクセルをラベルの N 表現の 1 つで置き換えると簡単に明らかになります。 4 つの隠れ層を持つネットワークでは、各隠れ層には 2000 ReLU が含まれています。60 エポック後、層間の完全な接続のテスト エラーは MNIST によって 1.36% になります。このテスト パフォーマンスを達成するには逆伝播が必要です。約 20 エポックです。 FF 学習率を 2 倍にして 40 エポックのトレーニングを行うと、テスト誤差は 1.46% と若干悪化します。

FF でトレーニングした後、テスト数字と 10 個の 0.1 エントリで構成されるニュートラル ラベルを含む入力から開始するネットワークによる前方パスを作成することで、テスト数字が分類されます。 、最初の隠れ層を除くすべての隠れアクティビティは、トレーニング中に学習されたソフトマックス入力として使用されます。これは、画像分類の高速な次善の方法です。最良の方法は、入力の一部として特定のラベルを使用してネットワークを実行し、最初の隠れ層を除くすべての層のメリットを累積することです。これをラベルごとに個別に実行した後、累積メリットが最も高いラベルを選択します。トレーニング中に、ニュートラル ラベルからのフォワード パスを使用してハード ネガティブ ラベルが選択されるため、トレーニングにはエポックの約 1/3 が必要になります。

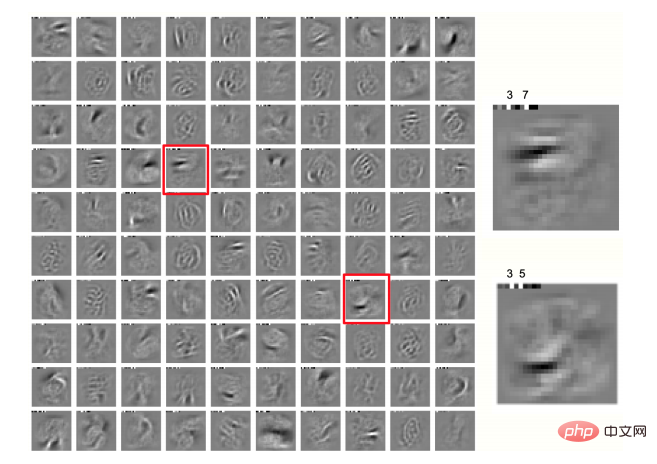

画像の各方向で最もディザリングされた 2 つのピクセルを使用してトレーニング データを増やし、ピクセル空間レイアウトの知識を使用して画像ごとに 25 の異なるオフセットを取得します。もはや不変の取り決めではありません。同じネットワークを 500 エポックの拡張データでトレーニングすると、テスト誤差は 0.64% に達する可能性があり、バックプロパゲーションでトレーニングされた畳み込みニューラル ネットワークと同様です。図 2 に示すように、最初の隠れ層でも興味深いローカル ドメインが得られます。

# 図 2: ジッターのある MNIST で学習されたネットワークの最初の隠れ層にある 100 個のニューロンのローカル ドメイン、クラス ラベル。各画像の最初の 10 ピクセル

FF を使用してトップダウンの知覚効果をシミュレートします

現在、すべての画像分類の例すべて一度に 1 つの層を学習するフィードフォワード ニューラル ネットワークを使用します。つまり、後の層で学習された内容は前の層の学習に影響を与えません。これはバックプロパゲーションに比べて大きな弱点であるように見えますが、この明らかな制限を克服する鍵は、静止画像を多層リカレント ニューラル ネットワークによって処理される退屈なビデオとして扱うことです。

FF 正のデータと負のデータは両方とも時間的に順方向に実行されますが、各層のアクティビティ ベクトルは、前の層と次の層の前の時間ステップによって正規化されます。が決定されます (図 3)。このアプローチが機能するかどうかの予備チェックとして、各時間フレームで単純に繰り返される静的な MNIST 画像で構成される「ビデオ」入力を使用できます。この画像は、一番下にピクセル イメージがあり、一番下に数値クラスの N 個の表現の 1 つが表示されます。上、2 つまたは 3 つの中間層があり、それぞれに 2000 個のニューロンがあります。

予備実験では、リカレント ネットワークは 10 タイム ステップで実行されました。各タイム ステップの偶数番号の層は、奇数番号の層の正規化アクティビティに従って更新されました。アクティビティの更新、その 交互更新は二相性発振を回避するように設計されていますが、現在は ではないようです: に基づくすべての隠れ層の同期以前のタイムステップで少し減衰のある正規化された状態 更新学習がわずかに向上し、不規則なアーキテクチャにとって有益です。したがって、この実験では同期更新が使用され、新しい正規化前の状態は、以前の正規化前の状態の 0.3 に、計算された新しい状態の 0.7 を加えた値に設定されました。

#図 3: ビデオを処理するリカレント ネットワーク

図 3 のようにネットワークは MNIST で 60 エポックにわたってトレーニングされ、各画像の隠れ層はボトムアップ パスで初期化されます。その後、ネットワークは、10 個のラベルごとに 8 回の反復を実行し、反復 3 ~ 5 で平均良好度が最も高いラベルを選択することにより、ダンピングを伴う 8 回の同期反復を実行します。ネットワークのテスト データのパフォーマンスを評価するには、 、テスト誤差は 1.31% です。ネガティブデータを一度ネットワークに通して全カテゴリの確率を取得し、確率に比例して誤ったカテゴリを選択・生成することで学習効率を向上させます。 リカレント ネットワークでは、目標は、ポジティブ データの上位層入力とデータ間の良好な関係を維持することです。下位層の入力の一貫性はあるが、負のデータの一貫性は良くありません。空間的にローカルな接続性を持つネットワークに望ましい特性: トップダウン入力は画像のより広い領域によって決定され、より多くの処理段階の結果が得られるため、画像のコンテキスト予測として見ることができます。これは、ローカル画像ドメインのボトムアップ入力に基づいて生成されるべき結果です。 入力が時間の経過とともに変化する場合、トップダウン入力は古い入力データに基づくことになるため、ボトムアップ入力を予測する表現を学習する必要があります。目的関数の符号を反転し、正のデータに対して低二乗アクティビティを実行すると、トップダウン入力は正のデータに対するボトムアップ入力を打ち消すことを学習するはずで、これは予測コーディングと非常に似ているように見えます。レイヤの正規化とは、たとえキャンセルがうまく機能したとしても、多くの情報が次のレイヤに送信され、すべての予測誤差が小さければ正規化によって情報が増幅されることを意味します。 コンテキスト予測を局所特徴として使用し、学習用の教師信号を抽出するというアイデアは長い間存在していましたが、問題は、次のようなニューラル ネットワークでどのように機能するかにあります。一方的な時間的文脈ではなく、空間的文脈。トップダウンとボトムアップの重みの教師信号としてトップダウンとボトムアップの入力からのコンセンサスを使用することは、他の画像からのコンテキスト予測を使用してネガティブ ペアを作成する問題と同様に、明らかに崩壊につながるアプローチです。解決しました。その中でも、負の内部表現ではなく負のデータを使用することが鍵のようです。 ヒントンは次に、CIFAR-10 データセットで FF アルゴリズムのパフォーマンスをテストし、FF が有効であることを証明しました。トレーニング 結果として得られるネットワークのパフォーマンスはバックプロパゲーションに匹敵します。 データセットには、ピクセルごとに 3 つのカラー チャネルを持つ 50,000 個の 32x32 トレーニング画像が含まれているため、各画像の次元は 3072 になります。これらの画像の背景は複雑で変動性が高く、非常に限られたトレーニング データでは適切にモデル化できないため、隠れ層が非常に小さい場合を除き、バックプロパゲーションを使用して 2 ~ 3 つの隠れ層を含む完全に接続されたネットワークを使用できます。したがって、現在のほとんどすべての研究結果は畳み込みネットワークに関するものです。 バックプロパゲーションと FF は両方とも、過学習を減らすために重み減衰を使用します。ヒントンは 2 つの方法で学習されたネットワークのパフォーマンスを比較しました。 FF トレーニング済みネットワークの場合、テスト方法は単一の順伝播を使用するか、ネットワークに画像と 10 個のラベルのそれぞれに対して 10 回の反復を実行させ、反復 4 ~ 6 でラベルのエネルギーを蓄積します (つまり、誤差の程度が最も低い時期に基づく場合)。 結果として、FF のテスト パフォーマンスはバックプロパゲーションよりも劣りますが、わずかに悪化するだけです。同時に、隠れ層が増えても 2 つの間のギャップは拡大しません。ただし、バックプロパゲーションを使用すると、トレーニング エラーをより早く減らすことができます。 さらに、ヒントンはシーケンス学習において、シーケンス内の次の文字を予測するタスクを通じて、FF でトレーニングされたネットワークがバックプロパゲーションよりも優れていることも証明しました。 FF でトレーニングされたネットワークは、独自のネガティブ データを生成でき、生物学的により一貫性があります。 ヒントンは FF アルゴリズムをさらに発展させました。他の既存の対照的な学習方法と比較されます。彼の結論は次のとおりです: FF はボルツマン マシンと単純なローカル善関数の組み合わせです; FF は必要ありません バックプロパゲーションは次のようになります。識別モデルと生成モデルを学習するため、これは GAN の特殊なケースです; 実際のニューラル ネットワークでは、SimCLR などの自己教師あり比較手法と比較して、FF はより適切に測定できます2 つの異なる表現間の一貫性。 1980 年代初頭、ディープ ニューラル ネットワークには 2 つの最も有望な学習方法がありました。1 つはバックプロパゲーションで、もう 1 つはバックプロパゲーションです。もう 1 つは教師なし比較学習を行うボルツマン マシンです。 ボルツマン マシンは、両方向に等しい重みを持つペアごとの接続を持つ確率的バイナリ ニューロンのネットワークです。外部入力なしで自由に実行できる場合、ボルツマン マシンは、他のアクティブなニューロンから受け取る合計入力に等しい確率で各バイナリ ニューロンをオン状態に設定することによって繰り返し更新します。この単純な更新プロセスは、最終的に平衡分布からサンプリングします。各グローバル構成 (すべてのニューロンにバイナリ状態を割り当てる) は、その負のエネルギーに比例する対数確率を持ちます。負のエネルギーは、その構成内のニューロンのすべてのペア間の重みの単純な合計です。 ボルツマン マシン内のニューロンのサブセットは「可視」であり、バイナリ データ ベクトルは、可視ニューロン上にクランプすることによってネットワークに提示され、繰り返し更新されます。ニューロンの状態。ボルツマン機械学習の目的は、ネットワークの実行時に、目に見えるニューロン上のバイナリ ベクトルの分布をデータ分布と自由に一致させることです。 最も驚くべきことは、自走ボルツマンマシンが熱平衡状態にあるとき、ニューロン上に表示されるデータ分布とモデル分布の間にカルバック・リーブラーの発散が見られることです。は非常に単純な導関数 (任意の重量について) を持ちます: ここで、山かっこは熱平衡時のランダムな変動の予想とそのデータを示します。前期。 この結果の興味深い点は、誤差導関数を明示的に伝播することなく、ネットワークの奥深くにある重みの導関数が得られることです。覚醒時と睡眠時の 2 つの異なる段階で神経活動を広げます。 ただし、学習ルールを数学的に最も単純なものにするコストは非常に高くなります。平衡分布を近似するには深いボルツマン マシンが必要ですが、これは機械学習技術としては非現実的であり、皮質学習モデルとしても信じがたいものになります: 大規模なネットワークには、知覚中に平衡分布を近似する時間がありません。さらに、皮質結合の詳細な対称性に関する証拠はなく、配列を学習する明白な方法もありません。さらに、重みの多くの正の更新の後に多くの負の更新が続き、負のフェーズがレム睡眠に対応する場合、ボルツマン機械学習手順は失敗します。 しかし、上記の欠点にもかかわらず、ボルツマン マシンは、同じように機能するものの、目に見えるニューロンの境界が異なる 2 つの動作原理を使用するため、依然として非常にスマートな学習方法です。条件 (つまり、データが制限されている場合と制限されていない場合) は、バックプロパゲーションの前方パスと後方パスを置き換えます。 ボルツマン マシンは、次の 2 つのアイデアを組み合わせたものと見ることができます。 #対照学習に関する最初のアイデアは、他の多くのエネルギー関数で使用できます。たとえば、フィードフォワード ニューラル ネットワークの出力を使用してエネルギーを定義し、ネットワークを通じてバックプロパゲーションを使用して、重みと可視状態に関するエネルギーの導関数を計算します。次に、可視状態に関するエネルギーの導関数を追跡することによって、負のデータが生成されます。さらに、エネルギー関数によって定義されるボルツマン分布からデータ ベクトルをサンプリングすることによって負のデータを生成する必要がなくなり、平衡分布からサンプリングすることなく、単一の隠れ層を備えたボルツマン マシンの学習効率も向上します。 ヒントンの見解では、式 2 の数学的単純さと、すべての可能な隠れた構成に対してベイズ積分を実行する確率的更新プロセスは非常にエレガントであるため、伝播するための 2 つの解というアイデアのみを使用します。バックプロパゲーションは依然としてマルコフ連鎖モンテカルロの複雑さと絡み合っているため、順方向バックプロパゲーションの代わりに神経活動が必要となります。 シンプルなローカル善関数は、バイナリ ランダム ニューロン ネットワークの自由エネルギーよりも扱いが簡単で、FF はボルツマン マシンの対照学習とこの関数を組み合わせています。 GAN (敵対的生成ネットワーク) は多層ニューラル ネットワークを使用してデータを生成します識別ネットワークは生成モデルをトレーニングして、生成モデルの出力に関して導関数を与え、その導関数が生成されたデータではなく実際のデータである確率 GAN は次のとおりです。判別モデルと生成モデルは互いに対立するため、トレーニングが困難です。 GAN は非常に美しい画像を生成できますが、モード崩壊の問題があります。つまり、サンプルを生成しない画像空間の大きな領域が存在する可能性があります。また、各ネットワークに適合させるためにバックプロパゲーションを使用するため、皮質でそれらを実装する方法を理解するのは困難です。 FF は、判別ネットワークの各隠れ層が正または負の入力に対して独自の貪欲な決定を行う GAN の特殊なケースとみなすことができます。バックプロパゲーションは必要ありません。判別モデルと生成モデルを学習するために、それ自体の隠れた表現を学習するのではなく、判別モデルによって学習された表現を再利用するためです。 生成モデルが学ぶ必要がある唯一のことは、これらの隠れた表現を生成されたデータに変換する方法です。線形変換を使用してソフトマックスの対数を計算する場合、逆伝播は必要ありません。 。両方のモデルに同じ非表示表現を使用する利点の 1 つは、一方のモデルが他方のモデルに比べて学習するのが早すぎる場合に発生する問題がなくなり、モードの崩壊も回避できることです。 SimCLR のような自己教師あり比較手法は、目的関数を最適化することで学習します。同じ画像の 2 つの異なる作物の表現間の一貫性、および 2 つの異なる画像からの作物の表現間の不一致をサポートします。 このタイプの方法では、通常、多くの層を使用してクリップされた表現を抽出し、目的関数の導関数を逆伝播することによってこれらの層をトレーニングします。 2 つのクリッピングが常にまったく同じ方法で重なっている場合、これらは機能しません。その場合、共有ピクセルの強度を報告するだけで完全な一貫性が得られるからです。 しかし、実際のニューラル ネットワークでは、2 つの異なる表現間の一貫性を測定するのは簡単ではなく、同じ重みを使用して 2 つのクリップされた表現を同時に抽出する方法はありません。 。 そして、FF は一貫性を測定するために別の方法を使用します。実際のニューラル ネットワークではこの方が簡単だと思われます。 #多くの異なる情報源が、同じニューロンのセットに入力を提供します。どのニューロンを活性化するかについてソースが一致している場合、正の干渉が発生し、高い二乗活動が発生します。一方、一致していない場合、二乗活動は低くなります。正の干渉を使用して一貫性を測定することは、入力を 2 つの別々のソースに任意に分割する必要がないため、2 つの異なる表現ベクトルを比較するよりもはるかに柔軟です。 SimCLR このタイプのアプローチの主な弱点は、2 つの画像クロップの表現を導き出すために大量の計算が使用されることですが、目的関数は表現に対して適度な制約しか提供しないことです。これにより、問題の領域が制限され、情報の速度が重みを加える可能性があります。クリップされた表現を代替物ではなく正しいペアに近づけるためには、必要な情報は 20 ビットだけです。 FF の問題は、正の例と負の例を区別するのに 1 ビットしか必要としないため、より深刻です。 この制約の貧困に対する解決策は、各層を多くの小さなブロックに分割し、各ブロックが事前に正規化されたアクティビティ ベクトルの長さを使用して正の例と負の例を決定することを強制することです。 。制約を満たすために必要な情報は、ブロック数に応じて線形にスケーリングされます。これは、SimCLR のような方法でより大きなコントラスト セットを使用して達成される対数スケーリングよりもはるかに優れています。 しかし、これには致命的な欠陥があります。ランダムな重み行列を通じていくつかのランダムなノイズ画像をマッピングするとします。結果として得られるアクティビティ ベクトルには、データとは独立して、重み行列によって作成された相関構造が含まれます。教師なし学習がこれらの活動ベクトルに適用されると、そのベクトル内に何らかの構造が発見されますが、これはシステムに外の世界について何も伝えません。 元のボルツマン機械学習アルゴリズムは、2 つの異なる外部境界条件によって引き起こされる統計を比較することで、この欠陥を回避するように設計されました。これにより、ネットワークの他の部分の結果である構造がすべて取り消されます。正のデータと負のデータを比較するときにルーティングを制約する必要はなく、ネットワーク不正行為を防ぐためにクリッピング間のランダムな空間関係も必要ありません。これにより、それぞれが肯定的なデータと否定的なデータを区別するという独自の目標を持った、相互接続された多数のニューロン グループを取得することが容易になります。 モータル計算はヒントンの最近の重要な見解の 1 つです (注: この用語には認められた中国語訳がなく、暫定的に「非不滅計算」と訳されています)。 # 彼は、現在の汎用デジタル コンピューターは命令に忠実に従うように設計されており、汎用コンピュータが特定のタスクを実行するには、何を行うかを非常に詳細に指定するプログラムを書く必要があります。 主流の考え方は、同じプログラムまたは同じ重みのセットをハードウェアの異なる物理コピーで実行できるように、ソフトウェアをハードウェアから分離する必要があると依然として主張しています。これにより、プログラムまたは重みに含まれる知識が「不滅」になります。ハードウェアが死んでも、知識も一緒に消えません。 しかし、これはもはや真実ではなく、研究コミュニティは、コンピューターの構築方法に対するディープラーニングの長期的な影響をまだ完全には理解していません。 ソフトウェアとハードウェアの分離はコンピュータ サイエンスの基礎の 1 つであり、電気的なことを気にせずにプログラムの特性を研究できるなど、多くの利点をもたらします。エンジニアリングであり、一度プログラムを作成すれば、それを何百万ものコンピュータにコピーできます。しかし、ヒントンは次のように指摘しています。計算を実行するためのハードウェア。 このように、同じタスクを実行する異なるハードウェア インスタンスでは、接続性と非線形性が大きく変化する可能性があり、学習プロセスのパラメータ値から効果的な利用方法を見つけることができます。ハードウェアの特定の各インスタンスの未知のプロパティ。これらのパラメーター値は特定のハードウェア インスタンスでのみ役立つため、実行される計算は不滅ではなく、ハードウェアとともに消滅します。 異なる動作をする別のハードウェアにパラメータ値をコピーすること自体はあまり意味がありませんが、より生物学的なアプローチを使用して、1 つのハードウェアが学習した内容を転送することができます。もう一つのハードウェア。画像内のオブジェクト分類のようなタスクの場合、私たちが本当に関心があるのは、特定のハードウェアでその関数を実装するパラメーター値ではなく、ピクセル強度をクラス ラベルに関連付ける関数です。 蒸留を使用すると、関数自体を別のハードウェアに転送できます。新しいハードウェアをトレーニングすると、古いハードウェアと同じ答えが得られるだけでなく、不正解の確率も同じになります。これらの確率は、どのラベルが最も可能性が高いと考えられたかということだけでなく、古いモデルがどのように一般化したかをより詳細に示します。したがって、間違った答えの確率に一致するように新しいモデルをトレーニングすることにより、古いモデルと同じ方法で一般化するようにモデルをトレーニングしていることになります。これは、このようなニューラル ネットワーク トレーニングが実際に一般化を最適化する珍しい例です。 数兆パラメータのニューラル ネットワークの消費電力をわずか数ワットに抑えたい場合、非永久コンピューティングが唯一の選択肢となる可能性があります。 その実現可能性は、正確な詳細が不明なハードウェアで効率的に実行できる学習プロセスを見つけられるかどうかにかかっています。ヒントン氏の見解では、 この論文の最後で、ヒントンは次の未解決の疑問を指摘しています。 空間コンテキストを使用した予測

CIFAR-10 データセット テスト

3

FF アルゴリズムとボルツマン マシン、GAN、SimCLR の関係

FF はボルツマン マシンの対照学習を吸収します

FF は GAN の特殊なケースです

FF は SimCLR よりも一貫性を測定するのが簡単です

多層表現を学習するための教師なしの方法は、最初に隠れ層を学習することです。これは A 層がキャプチャします。データに何らかの構造がある場合、その層のアクティビティ ベクトルがデータとして扱われ、同じ教師なし学習アルゴリズムが再度適用されます。これは、制限付きボルツマン マシン (RBM) またはスタック オートエンコーダーを使用して多層表現を学習する方法です。

4

将来の非不死コンピュータでは

FFが最良の学習アルゴリズムです

以上がヒントンの最新研究: ニューラル ネットワークの未来はフォワードフォワード アルゴリズムですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7672

7672

15

15

1393

1393

52

52

1206

1206

24

24

91

91

11

11

YOLOは不滅です! YOLOv9 がリリースされました: パフォーマンスとスピード SOTA~

Feb 26, 2024 am 11:31 AM

YOLOは不滅です! YOLOv9 がリリースされました: パフォーマンスとスピード SOTA~

Feb 26, 2024 am 11:31 AM

現在の深層学習手法は、モデルの予測結果が実際の状況に最も近くなるように、最適な目的関数を設計することに重点を置いています。同時に、予測に十分な情報を取得するには、適切なアーキテクチャを設計する必要があります。既存の方法は、入力データがレイヤーごとの特徴抽出と空間変換を受けると、大量の情報が失われるという事実を無視しています。この記事では、ディープネットワークを介してデータを送信する際の重要な問題、つまり情報のボトルネックと可逆機能について詳しく説明します。これに基づいて、深層ネットワークが複数の目的を達成するために必要なさまざまな変化に対処するために、プログラマブル勾配情報 (PGI) の概念が提案されています。 PGI は、目的関数を計算するためのターゲット タスクに完全な入力情報を提供することで、ネットワークの重みを更新するための信頼できる勾配情報を取得できます。さらに、新しい軽量ネットワーク フレームワークが設計されています。

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

上記および筆者の個人的な理解: 現在、自動運転システム全体において、認識モジュールが重要な役割を果たしている。道路を走行する自動運転車は、認識モジュールを通じてのみ正確な認識結果を得ることができる。下流の規制および制御モジュール自動運転システムでは、タイムリーかつ正確な判断と行動決定が行われます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。純粋な視覚に基づく BEV 認識アルゴリズムは、ハードウェア コストが低く導入が容易であるため、業界で好まれており、その出力結果はさまざまな下流タスクに簡単に適用できます。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の最下層はマージ ソートを使用し、その複雑さは O(nlogn) で、クイック ソート、ヒープ ソート、安定したソートなど、さまざまなソート アルゴリズムの選択肢を提供します。

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

論文のアドレス: https://arxiv.org/abs/2307.09283 コードのアドレス: https://github.com/THU-MIG/RepViTRepViT は、モバイル ViT アーキテクチャで優れたパフォーマンスを発揮し、大きな利点を示します。次に、この研究の貢献を検討します。記事では、主にモデルがグローバル表現を学習できるようにするマルチヘッド セルフ アテンション モジュール (MSHA) のおかげで、軽量 ViT は一般的に視覚タスクにおいて軽量 CNN よりも優れたパフォーマンスを発揮すると述べられています。ただし、軽量 ViT と軽量 CNN のアーキテクチャの違いは十分に研究されていません。この研究では、著者らは軽量の ViT を効果的なシステムに統合しました。

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能 (AI) と法執行機関の融合により、犯罪の予防と検出の新たな可能性が開かれます。人工知能の予測機能は、犯罪行為を予測するためにCrimeGPT (犯罪予測技術) などのシステムで広く使用されています。この記事では、犯罪予測における人工知能の可能性、その現在の応用、人工知能が直面する課題、およびこの技術の倫理的影響について考察します。人工知能と犯罪予測: 基本 CrimeGPT は、機械学習アルゴリズムを使用して大規模なデータセットを分析し、犯罪がいつどこで発生する可能性があるかを予測できるパターンを特定します。これらのデータセットには、過去の犯罪統計、人口統計情報、経済指標、気象パターンなどが含まれます。人間のアナリストが見逃す可能性のある傾向を特定することで、人工知能は法執行機関に力を与えることができます

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

01 今後の概要 現時点では、検出効率と検出結果の適切なバランスを実現することが困難です。我々は、光学リモートセンシング画像におけるターゲット検出ネットワークの効果を向上させるために、多層特徴ピラミッド、マルチ検出ヘッド戦略、およびハイブリッドアテンションモジュールを使用して、高解像度光学リモートセンシング画像におけるターゲット検出のための強化されたYOLOv5アルゴリズムを開発しました。 SIMD データセットによると、新しいアルゴリズムの mAP は YOLOv5 より 2.2%、YOLOX より 8.48% 優れており、検出結果と速度のバランスがより優れています。 02 背景と動機 リモート センシング技術の急速な発展に伴い、航空機、自動車、建物など、地表上の多くの物体を記述するために高解像度の光学式リモート センシング画像が使用されています。リモートセンシング画像の判読における物体検出

画像の類似性比較にコントラスト損失を使用してシャム ネットワークを探索する

Apr 02, 2024 am 11:37 AM

画像の類似性比較にコントラスト損失を使用してシャム ネットワークを探索する

Apr 02, 2024 am 11:37 AM

はじめに コンピュータ ビジョンの分野では、画像の類似性を正確に測定することは、幅広い実用化を伴う重要なタスクです。画像検索エンジンから顔認識システム、コンテンツベースの推奨システムに至るまで、類似した画像を効果的に比較して見つける機能が重要です。シャム ネットワークとコントラスト損失を組み合わせることで、データ駆動型の方法で画像の類似性を学習するための強力なフレームワークが提供されます。このブログ投稿では、シャム ネットワークの詳細を掘り下げ、コントラスト損失の概念を探り、これら 2 つのコンポーネントがどのように連携して効果的な画像類似性モデルを作成するかを探っていきます。まず、Siamese ネットワークは、同じ重みとパラメータを共有する 2 つの同一のサブネットワークで構成されています。各サブネットワークは入力画像を特徴ベクトルにエンコードします。