Google は Anthrophic に 4 億ドルを費やしました。AI モデルのトレーニング計算は 5 年間で 1,000 倍に増加しました。

スケーリングの法則の発見以来、人々は人工知能の開発がロケットと同じ速さで進むだろうと考えていました。

2019 年においても、マルチモダリティ、論理的推論、学習速度、クロスタスク転移学習、長期記憶には、人工的な学習の進歩を遅らせたり止めたりする「壁」が依然として存在するでしょう。知能。それ以来数年が経ち、マルチモーダルで論理的な推論の「壁」は崩れてきました。

これを踏まえると、ほとんどの人は、人工知能の急速な進歩は停滞したり横ばいになるのではなく、今後も続くだろうとますます確信するようになりました。

現在、多くのタスクにおける人工知能システムのパフォーマンスは人間のレベルに近くなり、これらのシステムのトレーニングにかかるコストはハッブル宇宙望遠鏡のコストよりもはるかに低くなります。これは「ビッグサイエンス」プロジェクトであるため、AI には将来の大きな発展の可能性が秘められています。

しかし、開発によってもたらされるセキュリティリスクはますます顕著になってきています。

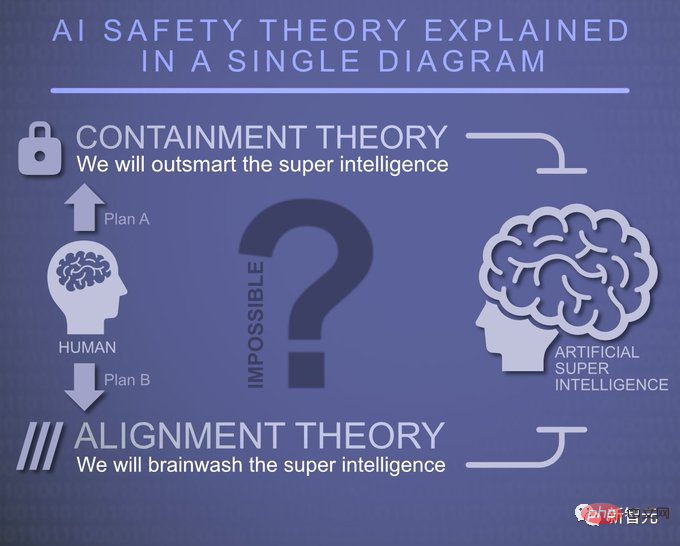

# 人工知能の安全性の問題に関して、Anthropic は 3 つの可能性を分析しました。

楽観的な状況下では、セキュリティ上の欠陥により高度な人工知能によって引き起こされる壊滅的なリスクが発生する可能性は非常に小さいです。ヒューマン フィードバックからの強化学習 (RLHF) や憲法上の人工知能 (CAI) など、すでに開発されているセキュリティ テクノロジは、リスクに対処するのにほぼ十分です。

主なリスクは、意図的な誤用と、広範な自動化や国際的な権力関係の変化などによって引き起こされる潜在的な危害であり、これには AI 研究所や学界や市民社会機関などの第三者が必要となります。政策立案者が高度な人工知能によってもたらされる潜在的な構造的リスクの一部を回避するのに役立つ広範な研究。

良いシナリオでも悪いシナリオでも、高度な人工知能の開発によって壊滅的なリスクが発生する可能性はあり、それが合理的でさえあり、それを回避するには多大な科学的および工学的努力が必要になります。たとえば、Anthropic が提供する「コンビネーション パンチ」によってリスクを回避できます。

Anthropic は現在、さまざまな方向に取り組んでいます。主に次のような分野に分かれています。 3 つの分野: 書き込み、画像処理または生成、ゲームなどにおける AI の機能、人工知能システムの調整機能をトレーニングするための新しいアルゴリズムの開発、人工知能システムが実際に調整されているかどうか、その効果の程度、およびそのアプリケーションの評価と理解能力。

Anthropic は、安全な人工知能を訓練する方法を研究するために、次のプロジェクトを立ち上げました。

メカニズムの解釈可能性メカニズムの解釈可能性、つまり、人間が未知のものを理解する方法と同様に、ニューラル ネットワークを人間が理解できるアルゴリズムにリバース エンジニアリングしようとします。潜在的に安全ではないコンピュータ プログラムをリバース エンジニアリングすることが可能です。

Anthropic は、モデルをレビューして安全でない側面を特定し、強力なセキュリティ保証を提供できる「コード レビュー」に似たことができるようになることを期待しています。

これは非常に難しい質問ですが、思っているほど不可能ではありません。

一方で、言語モデルは大規模で複雑なコンピューター プログラムです (「重ね合わせ」という現象が事態をさらに困難にします)。一方で、このアプローチは当初考えられていたよりも解決可能である可能性があるという兆候もあります。 Anthropic は、このアプローチを小さな言語モデルに拡張することに成功し、文脈学習を促進すると思われるメカニズムも発見し、記憶に関与するメカニズムについての理解を深めることができました。

Antropic の解釈可能性研究は、他の種類の順列科学によって残されたギャップを埋めたいと考えています。たとえば、解釈可能性の研究が生み出す最も価値のあるものの 1 つは、モデルが誤って一致しているかどうかを識別する能力であると彼らは考えています。

多くの点で、技術的な一貫性の問題は、AI モデルの不正な動作を検出する問題と切り離せません。

新しい状況で悪い動作を確実に検出できれば(たとえば、「モデルの心を読む」ことによって)、これらの失敗モデルを示さないモデルをトレーニングするより良い方法を見つけることができます。

Anthropic は、ニューラル ネットワークの詳細な動作と学習をより深く理解することで、安全性を追求するためのより幅広いツールを開発できると考えています。

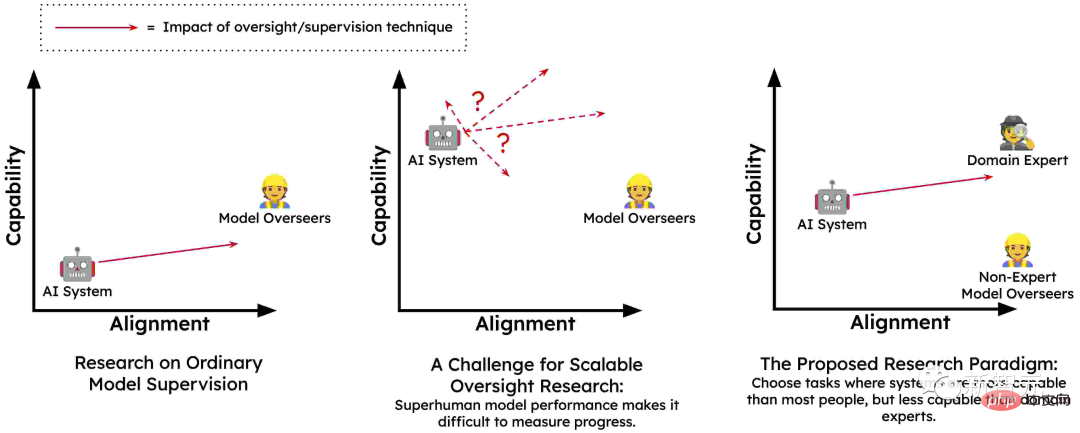

スケーラブルな監視

言語モデルを統合人工知能システムに変換するには、その動作をガイドするための大量の高品質なフィードバックが必要です。主な理由は、人間がさまざまな環境で有害な動作を回避するためにモデルを適切にトレーニングするために必要な正確なフィードバックを提供できない可能性があることです。

人間は AI システムにだまされて、実際のニーズを反映したフィードバックを提供するよう仕向けられる可能性があります (例: 誤解を招く提案に対して誤って肯定的なフィードバックを提供してしまうなど)。そして、人間はこれを大規模に行うことはできません。これがスケーラブルな監視の問題であり、安全で一貫した AI システムをトレーニングする上での核心です。

したがって、Anthropic は、必要な監視を提供する唯一の方法は、人工知能システムに部分的に自分自身を監視させるか、人間が自分自身を監視するのを支援することであると考えています。何らかの方法で、少量の高品質な人間による監視が、大量の高品質な人工知能による監視に増幅されます。

このアイデアは、RLHF や憲法 AI などのテクノロジーを通じて有望であることが示されており、言語モデルはすでに事前トレーニングされています。人間の価値観について多くのことを学んだので、より大きなモデルが人間の価値観をより正確に理解できることが期待できます。

スケーラブルな監督、特に CAI などの技術のもう 1 つの重要な特徴は、自動化されたレッド チーム化 (別名敵対的トレーニング) が可能になることです。つまり、潜在的に問題となる可能性のある AI システムへの入力を自動的に生成し、それがどのように反応するかを確認し、より正直で無害な方法で動作するように自動的に訓練することができます。

CAI に加えて、人間支援監視、AI-AI ディベート、マルチエージェント RL レッドチーム、作成モデル生成の評価など、さまざまなスケーラブルな監視手法があります。 。これらの方法を通じて、モデルは人間の価値観をよりよく理解できるようになり、モデルの行動は人間の価値観とより一致するようになります。このようにして、Anthropic はより強力なセキュリティ システムをトレーニングできます。

学習プロセスではあるが、結果は得られない

新しいタスクを学習する方法の 1 つは、試行錯誤を通じて行うことです。望ましい最終結果がわかっていれば、成功するまで新しい戦略を試し続けることができます。アントロピックではこれを「結果指向の学習」と呼んでいます。

このプロセスでは、エージェントの戦略は望ましい結果によって完全に決定され、この目標を達成できるようにいくつかの低コストの戦略を選択する傾向があります。

通常、より良い学習方法は、専門家に指導してもらい、成功のプロセスを理解してもらうことです。練習ラウンドでは、アプローチを改善することに集中できるため、成功はそれほど重要ではないかもしれません。

進歩するにつれて、コーチと相談して新しい戦略を追求し、それが自分にとってより効果的かどうかを確認することもできます。これを「プロセス指向学習」といいます。プロセス指向の学習では、最終結果が目標ではなく、プロセスを習得することが鍵となります。

高度な人工知能システムの安全性に関する多くの懸念は、少なくとも概念レベルでは、これらのシステムをプロセス指向の方法でトレーニングすることで対処できます。

人間の専門家は、AI システムが実行するさまざまなステップを引き続き理解しており、これらのプロセスを促進するには、その理由を人間に説明する必要があります。

AI システムは、プロセスの有効性と理解しやすさに基づいてのみ報酬が与えられるため、とらえどころのない方法や有害な方法で成功しても報酬は得られません。

この方法では、人間やそのエージェントが獲得プロセスのトレーニング中に否定的なフィードバックを提供する場合のように、問題のあるサブ目標 (リソースの獲得や欺瞞など) を追求しても報酬は得られません。

Anthropic は、「プロセス指向学習」が安全で透過的なシステムをトレーニングする最も有望な方法であり、最も簡単な方法でもあると考えています。

一般化の理解

機械的解釈可能性の作業では、ニューラル ネットワークによって実行される計算をリバース エンジニアリングします。 Anthropic はまた、大規模言語モデル (LLM) のトレーニング手順をより詳細に理解しようと努めました。

LLM は、驚くべき創造性から自己保存、欺瞞に至るまで、さまざまな驚くべき新しい行動を示しています。これらの動作はすべてトレーニング データから得られますが、そのプロセスは複雑です:

モデルはまず大量の元のテキストで「事前トレーニング」され、さまざまな表現を学習します。それと、さまざまなエージェントの能力をシミュレートします。その後、さまざまな方法で微調整され、その中には驚くべき結果をもたらすものもあります。

微調整フェーズでの過剰なパラメータ化により、学習されたモデルは、世界中のほとんどの知識から得られる、事前にトレーニングされた暗黙的なバイアスに大きく依存します。事前トレーニングで構築された表現ネットワーク。

モデルが憂慮すべき動作をするとき、たとえば、欺瞞的な AI として動作するとき、それは、ほぼ同一のトレーニング シーケンスを無害に吐き戻しているだけなのでしょうか?それとも、この行動 (さらにはそれにつながる信念や価値観) が、モデルの AI アシスタントの概念に不可欠な部分となり、さまざまな状況で適用されるようになったのでしょうか?

Anthropic は、モデルの出力をトレーニング データまで追跡して、この動作を理解するのに役立つ重要な手がかりを特定する技術に取り組んでいます。

危険な障害モードのテスト

重要な問題は、高度な人工知能が、欺瞞や戦略的計画能力などの有害な創発的行動を開発する可能性があることです。これらの行動は、人工知能には存在しません。小さくて能力の低いシステム。

この問題が差し迫った脅威になる前に、Anthropic は環境を構築することが問題を予測する方法であると考えています。そこで、彼らはこれらの特性を意図的に小規模モデルにトレーニングしました。これらのモデルは危険をもたらすほど強力ではないため、分離して研究することができます。

Anthropic は、AI システムが「状況認識」の下でどのように動作するかに特に興味を持っています。たとえば、トレーニング環境で人間と会話している AI であると認識したとき、これがどのような影響を与えるかなどです。トレーニング中の彼らの行動は? AI システムが欺瞞的になったり、驚くほど次善の目標を開発したりする可能性はあるでしょうか?

理想的には、これらの傾向が規模に応じてどのように変化するのかについて詳細な定量的モデルを構築し、突然の危険な故障モードを事前に予測できるようにしたいと考えています。

同時に、Anthropic は研究自体に関連するリスクについても懸念しています。

研究が小規模な対象で行われた場合、モデルでは重大なリスクが発生することはあり得ませんが、より大型でより高性能なモデルで実行すると重大なリスクが発生します。したがって、Anthropic は、重大な危害を引き起こす可能性のあるモデルについてこの種の研究を行うつもりはありません。

社会的影響と評価

人類研究の重要な柱は、ツール、測定、評価を確立することによって、人工知能システムの能力、限界、機能を批判的に評価し、理解することです。潜在的な社会的影響 潜在的な社会的影響。

たとえば、Anthropic は、大規模な言語モデルの予測可能性を分析した研究を発表しました。彼らは、これらのモデルの高レベルの予測可能性と予測不可能性に注目し、この特性がどのように有害な動作につながるかを分析しました。 。

この研究では、さまざまなモデル スケールでモデルの出力を調査することで、危険を発見して軽減するためのレッド チーム言語モデルへのアプローチを検討します。最近、彼らは現在の言語モデルが指示に従い、偏見や固定観念を減らすことができることを発見しました。

アントロピックは、人工知能システムの急速な応用が短期、中期、長期的に社会にどのような影響を与えるかについて非常に懸念しています。

彼らは、今日の AI の影響に関する厳密な調査を実施することで、政策立案者や研究者に、潜在的に大きな社会的危機を緩和し、AI の恩恵が確実に人々に利益をもたらすために必要な議論とツールを提供することを目指しています。

#結論人工知能は今後 10 年間で世界に前例のない影響を与えるでしょう。コンピューティング能力の指数関数的な増加と人工知能機能の予測可能な向上は、将来のテクノロジーが今日のものよりもはるかに進歩していることを示しています。

ただし、これらの強力なシステムを人間の価値観と密接に統合する方法についてはまだ十分に理解されていないため、壊滅的な障害のリスクがゼロになるという保証はありません。最小化された。したがって、私たちは常に楽観的ではない状況に備える必要があります。

複数の角度からの実証研究を通じて、Anthropic が提供するセキュリティ作業の「組み合わせパンチ」は、人工知能のセキュリティ問題の解決に役立つ可能性があるようです。

Anthropic からのこれらの安全に関する推奨事項は、次のことを示しています:

「人工知能システムがどのように学習し、現実世界に一般化するかについての理解を深めるには、スケーラブルな AI システムの監視およびレビュー技術を開発し、透明性があり説明可能な AI システムを作成し、結果を追うのではなく安全プロセスに従うように AI システムをトレーニングし、潜在的に危険な AI の故障モードとその防止方法を分析し、人工知能を評価します。ポリシーや研究などをガイドします。」

私たちは人工知能に対する完璧な防御に向けてまだ模索段階にありますが、Anthropic は前進するための優れたガイドを提供します。

以上がGoogle は Anthrophic に 4 億ドルを費やしました。AI モデルのトレーニング計算は 5 年間で 1,000 倍に増加しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7529

7529

15

15

1378

1378

52

52

81

81

11

11

21

21

75

75

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

AI スタートアップ企業は一斉に OpenAI に転職し、イリヤが去った後にセキュリティ チームが再編成されました。

Jun 08, 2024 pm 01:00 PM

AI スタートアップ企業は一斉に OpenAI に転職し、イリヤが去った後にセキュリティ チームが再編成されました。

Jun 08, 2024 pm 01:00 PM

先週、社内の辞任と社外からの批判が相次ぐ中、OpenAIは内外のトラブルに見舞われた。 - 未亡人姉妹への侵害が世界中で白熱した議論を巻き起こした - 「覇権条項」に署名した従業員が次々と暴露 - ネットユーザーがウルトラマンの「」をリストアップ噂の払拭: Vox が入手した漏洩情報と文書によると、アルトマンを含む OpenAI の上級幹部はこれらの株式回収条項をよく認識しており、承認しました。さらに、OpenAI には、AI セキュリティという深刻かつ緊急の課題が直面しています。最近、最も著名な従業員2名を含むセキュリティ関連従業員5名が退職し、「Super Alignment」チームが解散したことで、OpenAIのセキュリティ問題が再び注目を集めている。フォーチュン誌は OpenA を報じた。