ディープフェイクはかつてないほどリアルです! Nvidia の最新の「暗黙の歪み」はどの程度強いのでしょうか?

近年、コンピュータービジョン分野の世代技術はますます強力になり、それに対応する「偽造」技術もますます成熟していますディープフェイクの顔変更からアクションシミュレーションまで、本物と偽物を見分けるのは困難です。

最近、NVIDIA はさらに大きな動きを見せ、## を使用した新しい Implicit Warping (暗黙的ワーピング) フレームワーク を NeurIPS 2022 カンファレンスで公開しました。 #ソース画像 と のセットがビデオ の動きを駆動して、 ターゲット アニメーション を作成します。

論文リンク: https://arxiv.org/pdf/2210.01794.pdf #エフェクトの観点からは、生成された画像はよりリアルになり、ビデオ内でキャラクターが動いても、

背景は変化しません。 複数の入力ソース画像は通常、

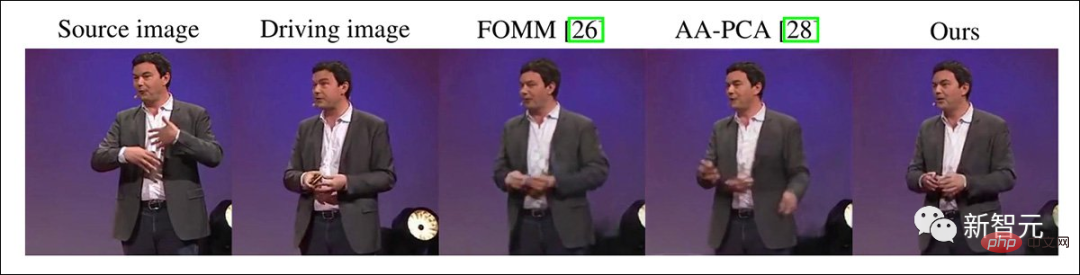

異なる外観情報を提供し、ジェネレーターの 「ファンタジー」スペース を削減します。次の 2 つはモデルの入力として使用されます。 他のモデルと比較すると、インプリシットディストーションではビューティーエフェクトのような「空間の歪み」が発生しないことがわかります。

文字のオクルージョンのため、複数のソース画像で

より完全な背景を提供することもできます。

下のビデオからわかるように、左側に写真が 1 枚しかない場合、

下のビデオからわかるように、左側に写真が 1 枚しかない場合、

他のモデルを比較する場合、ソース画像は 1 つだけの方が優れています。

魔法のような暗黙の歪み

すべての手法が画像の単一フレームからビデオを生成しようとしているわけではありません。ビデオの各フレームに対して複雑な計算を実行する研究もいくつかあります。これが実際にディープフェイクが行うことです。模倣ルートを選択してください。

ただし、DeepFake モデルは取得する情報が少ないため、ビデオ クリップごとにトレーニングする必要があり、DeepFaceLab や FaceSwap のオープンソース手法と比較してパフォーマンスが低下します。任意の数のビデオ クリップにアイデンティティを適用できます。

2019 年にリリースされた FOMM モデルでは、キャラクターがビデオに合わせて動くことができるため、ビデオの模倣タスクにさらなる威力を発揮します。

その後、他の研究者は、単一の顔画像または全身表現から複数のポーズや表情を導き出そうと試みましたが、このアプローチは通常、比較的無表情で動かない被写体に対してのみ機能しました。ネットワークが解釈しなければならない顔の表情やジェスチャーに「動作の突然の変化」がないため、比較的静止した「トーキングヘッド」となります。

これらの技術や手法の中には、ディープフェイクや潜在的な拡散画像合成手法が普及する前に注目を集めたものもありますが、適用範囲は限られています。汎用性が問われました。

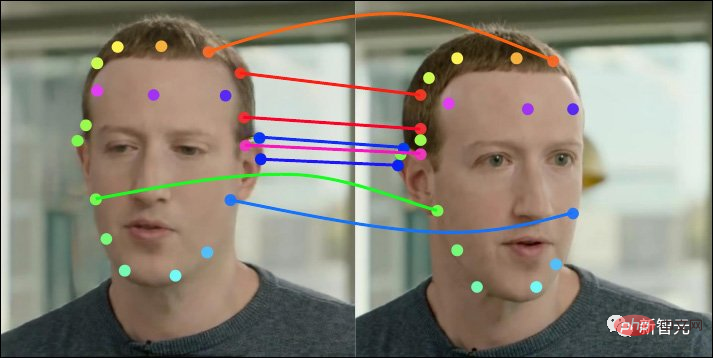

NVIDIA が今回焦点を当てている暗黙の歪みは、1 つのフレームから必要なすべてのポーズを取得するのではなく、複数のフレーム間、あるいは 2 つのフレーム間のみで情報を取得することです。他の競合モデルには存在しないか、扱いが非常に悪いです。

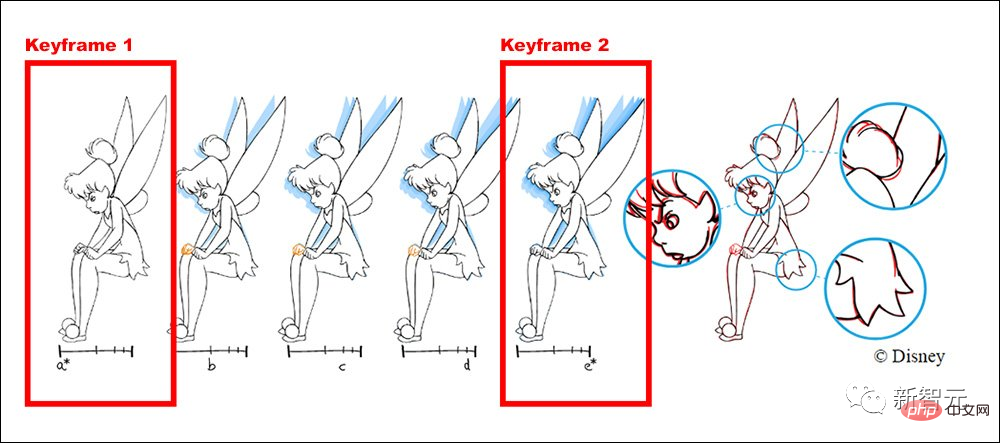

たとえば、ディズニーのワークフローでは、上級アニメーターがメイン フレームとキー フレームを描き、他の若手アニメーターが中間フレームの描画を担当します。

NVIDIA の研究者は、以前のバージョンでのテストを通じて、「キーフレーム」が追加されると以前の方法による結果の品質が低下し、新しい方法がアニメーション制作のロジックと矛盾していることを発見しました。一貫して、キーフレームの数が増加するにつれて、パフォーマンスは直線的に向上します。

開始フレームや終了フレームに表示されていないイベントや表現など、クリップの途中で突然の変化がある場合、ここで暗黙的な歪みを追加できます。 1 フレームごとに、追加情報がクリップ全体のアテンション メカニズムにフィードバックされます。

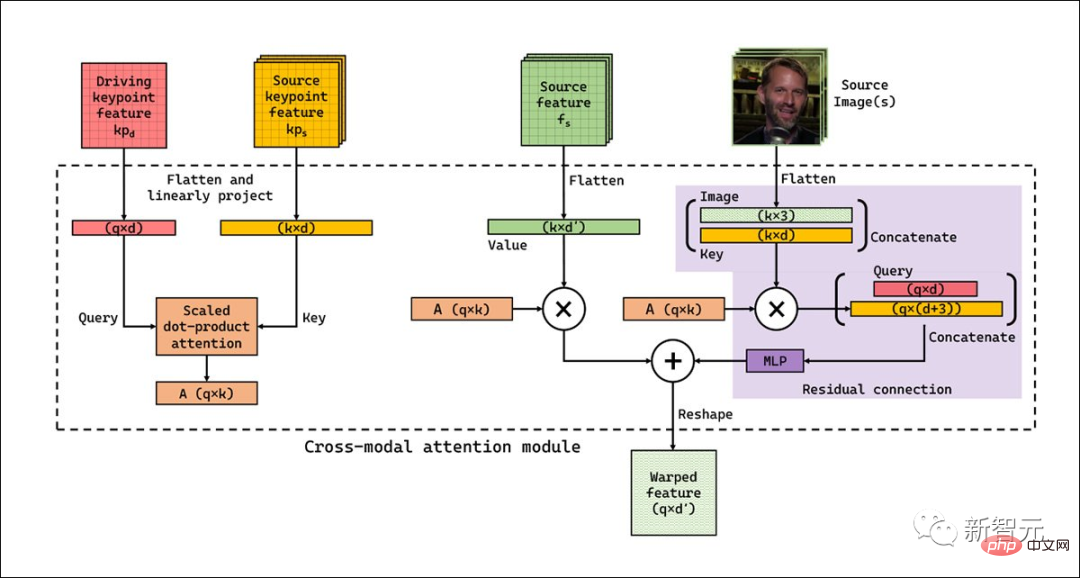

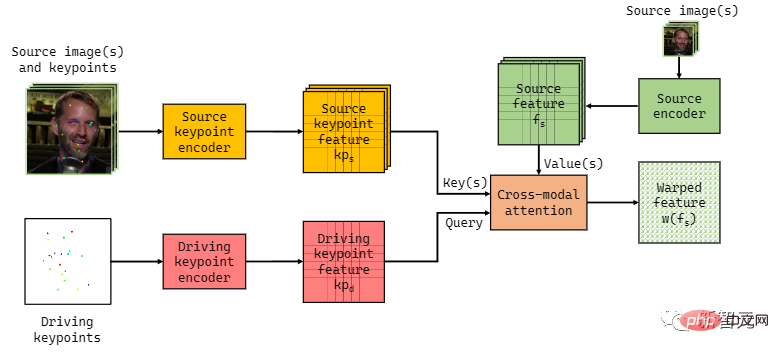

モデル構造

FOMM、Monkey-Net、face-vid2vid などの以前のメソッドは、時間を描画するために明示的な歪みを使用していました。シリーズ、ソースの顔とコントロール、動きから抽出された情報を適応させ、今回のシリーズと一致させる必要があります。

このモデル設計では、キーポイントの最終的なマッピングは非常に厳密になります。

対照的に、Implicit Warp は、ワークフロー内で事前定義されたブートストラップが少なく、クロスモーダル アテンション レイヤーを使用し、複数のフレームワークからの入力に適応できます。

ワークフローでは、キーごとの歪みも必要なく、システムは一連の画像から最も適切な特徴を選択できます。

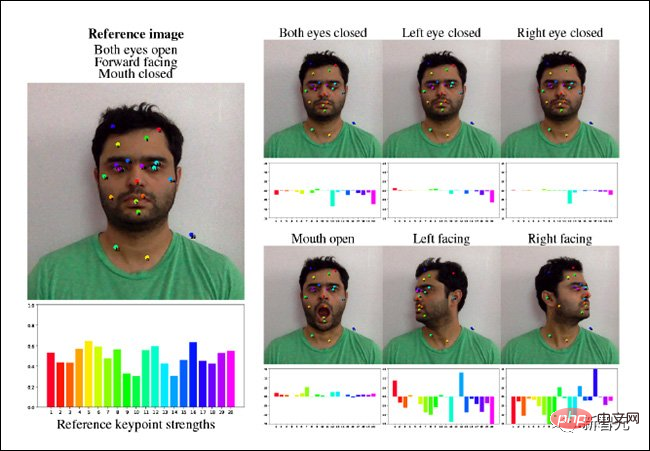

暗黙的ワーピングでは、FOMM フレームワークのいくつかのキー ポイント予測コンポーネントも再利用し、最後に単純な U-net を使用してスペース ドライブのキーポイント表現を導き出します。エンコード用。別の U-net を使用して、ソース画像と派生した空間表現をエンコードし、どちらのネットワークも 64 ピクセル (256 ピクセル平方出力) から 384x384 ピクセルの範囲の解像度で動作できます。

このメカニズムでは、特定のビデオ内のポーズや動きで起こり得るすべての変化を自動的に考慮することはできないため、追加のキーフレームが必要であり、一時的に追加することもできます。この介入機能がないと、ターゲット モーション ポイントに十分似ていないキーが自動的に更新され、出力品質が低下します。

これについて研究者らは、これは特定のキーフレーム セット内のクエリに最も類似したキーではあるが、良好な出力を生成するには十分ではない可能性があると説明しています。

たとえば、ソース画像には唇が閉じた顔があり、ドライバー画像には唇が開いて歯が露出した顔があるとします。この場合、ソース画像には、画像の口領域を駆動するための適切なキー (および値) がありません。

この方法は、ソース画像内の情報の欠如に対処できる、追加の画像に依存しないキーと値のペアを学習することでこの問題を解決します。

現在の実装は 512x512 ピクセルの画像で約 10 FPS と非常に高速ですが、研究者らは、将来のバージョンではパイプラインが因数分解された I-D アテンション レイヤーまたは空間削減を通過できると考えています。最適化するアテンション (SRA) レイヤー (例: Pyramid Vision Transformer)。

#暗黙的ワーピングでは、ローカル アテンションではなくグローバル アテンションを使用するため、以前のモデルでは予測できなかった要因を予測できます。

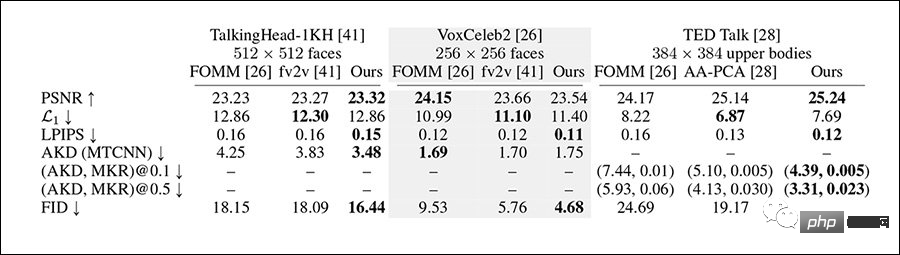

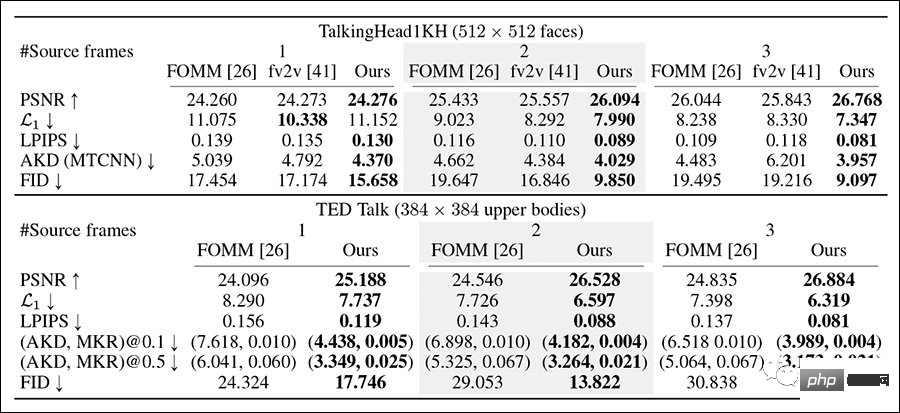

実験結果研究者らは、VoxCeleb2 データセット、より困難な TED Talk データセット、および TalkingHead-1KH データセットでシステムをテストし、256x256px 間のベースラインを比較しました。 FID、AlexNet ベースの LPIPS、ピーク信号対雑音比 (pSNR) などのメトリクスを使用した、フル 512x512 ピクセルの解像度。

テストに使用される対照的なフレームワークには、FOMM と face-vid2vid、および AA-PCA が含まれます。以前の方法には複数のキーフレームを使用する機能がほとんどまたはまったくないため、これは暗黙的歪みの主要な革新でもあります。スタッフは同様のテスト方法も設計しました。

暗黙的ワーピングは、ほとんどのメトリクスで最も対照的な方法よりも優れたパフォーマンスを発揮します。

研究者らが最大 180 フレームのシーケンスと選択されたギャップ フレームを使用したマルチキーフレーム再構成テストでは、今回は暗黙的ワーピングが全体的に勝利しました。

ソース画像の数が増えると、この方法ではより良い再構成結果が得られ、すべての指標のスコアが向上します。

そして、ソース画像の数が増えると、予想に反して、以前の作業の再構築効果は悪化します。

AMT スタッフを通じて定性調査を実施した結果、暗黙的変形の生成結果は他の方法よりも強力であると考えられています。

このフレームワークにアクセスすると、ユーザーはより一貫性のある長いビデオ シミュレーションや全身ディープフェイク ビデオを作成できるようになります。システムがテストされたどのフレームよりもはるかに広い可動範囲。

しかし、より現実的な画像合成の研究では、これらの技術は簡単に偽造に使用される可能性があり、論文には標準的な免責事項があるため、懸念も生じています。

当社の手法がディープフェイク製品の作成に使用された場合、悪影響を及ぼす可能性があります。悪意のある音声合成は、アイデンティティ間で偽の情報を転送および送信することにより、人々の誤ったイメージを作成し、個人情報の盗難や偽のニュースの拡散につながります。しかし、管理された環境では、同じテクノロジーをエンターテイメント目的にも使用できます。

この論文では、Google の Project Starline などのニューラル ビデオ再構築に対するこのシステムの可能性についても指摘しています。このフレームワークでは、再構築作業は主にクライアント側に焦点を当てており、クライアントからのまばらな入力を活用しています。スポーツ情報。

このソリューションは研究コミュニティからの関心をますます集めており、純粋なモーション データやまばらな間隔のキー フレームを送信することで低帯域幅の電話会議を実装しようとしている企業もあります。ターゲット クライアントに到達すると解釈され、フル HD ビデオに挿入されます。

以上がディープフェイクはかつてないほどリアルです! Nvidia の最新の「暗黙の歪み」はどの程度強いのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7469

7469

15

15

1376

1376

52

52

77

77

11

11

19

19

29

29

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

最初のパイロットおよび重要な記事では、主に自動運転技術で一般的に使用されるいくつかの座標系と、それらの間の相関と変換を完了し、最終的に統合環境モデルを構築する方法を紹介します。ここでの焦点は、車両からカメラの剛体への変換 (外部パラメータ)、カメラから画像への変換 (内部パラメータ)、および画像からピクセル単位への変換を理解することです。 3D から 2D への変換には、対応する歪み、変換などが発生します。要点:車両座標系とカメラ本体座標系を平面座標系とピクセル座標系に書き換える必要がある 難易度:画像の歪みを考慮する必要がある 歪み補正と歪み付加の両方を画面上で補正する2. はじめに ビジョンシステムには、ピクセル平面座標系 (u, v)、画像座標系 (x, y)、カメラ座標系 ()、世界座標系 () の合計 4 つの座標系があります。それぞれの座標系には関係性があり、

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

著者の個人的な考えの一部 自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発に伴い、高品質のマルチビュー トレーニング データとそれに対応するシミュレーション シーンの構築がますます重要になってきています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分離できます。 さまざまな次元のロングテール シナリオ: 障害物データ内の近距離車両、車両切断中の正確な進行角、車線などラインデータ 曲率の異なるカーブやランプ・合流・合流などの撮影が難しいシーン。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。 3D 真の値 - 一貫性の高い画像: 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。これが私を導いた

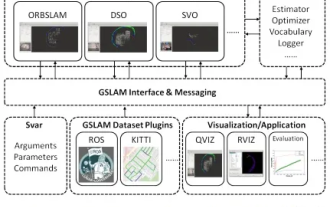

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

19 年前の論文を突然発見 GSLAM: A General SLAM Framework and Benchmark オープンソース コード: https://github.com/zdzhaoyong/GSLAM 全文に直接アクセスして、この作品の品質を感じてください ~ 1 抽象的な SLAM テクノロジー近年多くの成功を収め、多くのハイテク企業の注目を集めています。ただし、既存または新たなアルゴリズムへのインターフェイスを使用して、速度、堅牢性、移植性に関するベンチマークを効果的に実行する方法は依然として問題です。この論文では、GSLAM と呼ばれる新しい SLAM プラットフォームを提案します。これは、評価機能を提供するだけでなく、研究者が独自の SLAM システムを迅速に開発するための有用な方法を提供します。

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。