タスクの多様性を達成することは、基本的な深層学習モデルの研究における中心的な課題であり、最近の大規模モデルの方向性における主な焦点の 1 つでもあります。

ただし、時系列分野では、きめ細かいモデリングが必要な予測タスクや、高レベルの意味情報の抽出が必要な分類タスクなど、さまざまなタイプの分析タスクが大きく異なります。 さまざまなタイミング解析タスクを効率的に完了するための統合された深い基本モデルを構築する方法、これまで確立されたソリューションはありませんでした。

この目的を達成するために、清華大学ソフトウェア学部のチームは、タイミング変更モデリングの基本的な問題に関する研究を実施し、タスク汎用タイミング基本モデルである TimesNet を提案しました。 ICLR 2023に受理されました。

著者リスト: Wu Haixu*、Hu Tenge*、Liu Yong*、Zhou Hang、Wang Jianmin、 Long Mingsheng

リンク: https://openreview.net/pdf?id=ju_Uqw384Oq

コード: https://github.com/thuml/TimesNet

時系列アルゴリズム ライブラリ: https://github.com/thuml/Time -シリーズ-ライブラリ

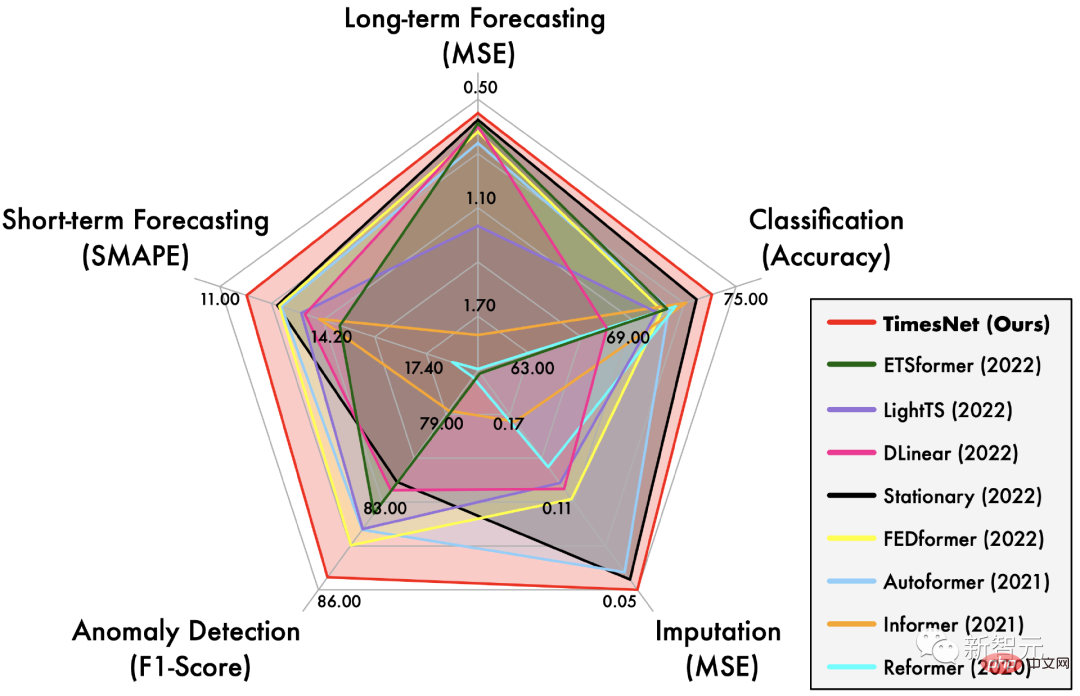

TimesNet は、長期および短期の予測、欠損値の補充、異常検出、分類の 5 つの主要なタスクにおいて包括的なリーダーシップを達成しました。

自然言語や動画などのシーケンスデータとは異なり、一度だけ一部のスカラーのみが保存され、その重要な情報は時間的変動 (Temporal 変動) に多く含まれます。

したがって、タイミング変更のモデリングは、あらゆる種類のタイミング解析タスクに共通する中心的な問題です。

近年、リカレント ニューラル ネットワーク (RNN)、時間畳み込みネットワーク (TCN)、トランス ネットワーク (変成器)。

ただし、最初の 2 種類のメソッドは主に、近い瞬間の間の変化をキャプチャすることに重点を置いており、長期的な依存関係におけるモデリング機能が不十分です。

Transformer には長期的な依存関係のモデル化において当然の利点がありますが、現実世界では非常に複雑なタイミング変化があるため、離散的な依存関係間の注意だけに頼って依存関係をマイニングするのは困難です。タイムポイント、信頼性の高いタイミング依存関係。

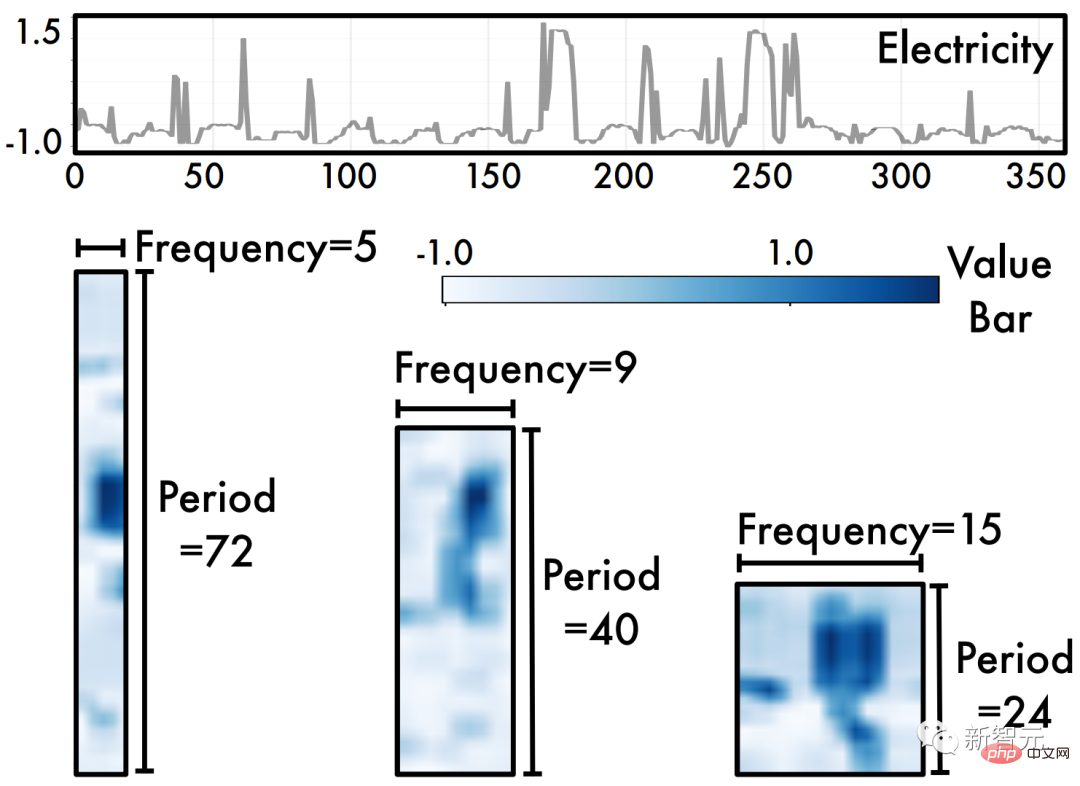

この目的を達成するために、この記事では、次の図に示すように、新しい複数周期の観点からタイミングの変化を分析します。

時系列は、

2 設計アイデア

上記の 2 つの観察に基づいて、TimesNet の構造を次のように設計しました。

したがって、時系列データを折りたたんだ後、高度な

Visual Backbone Networkを直接使用して、Swin Transformer などの時系列データの特徴抽出を実行できます。 ResNext、ConvNext など。 この設計により、タイミング解析タスクが急成長するコンピューター ビジョン分野から直接恩恵を受けることもできます。 3 TimesNet

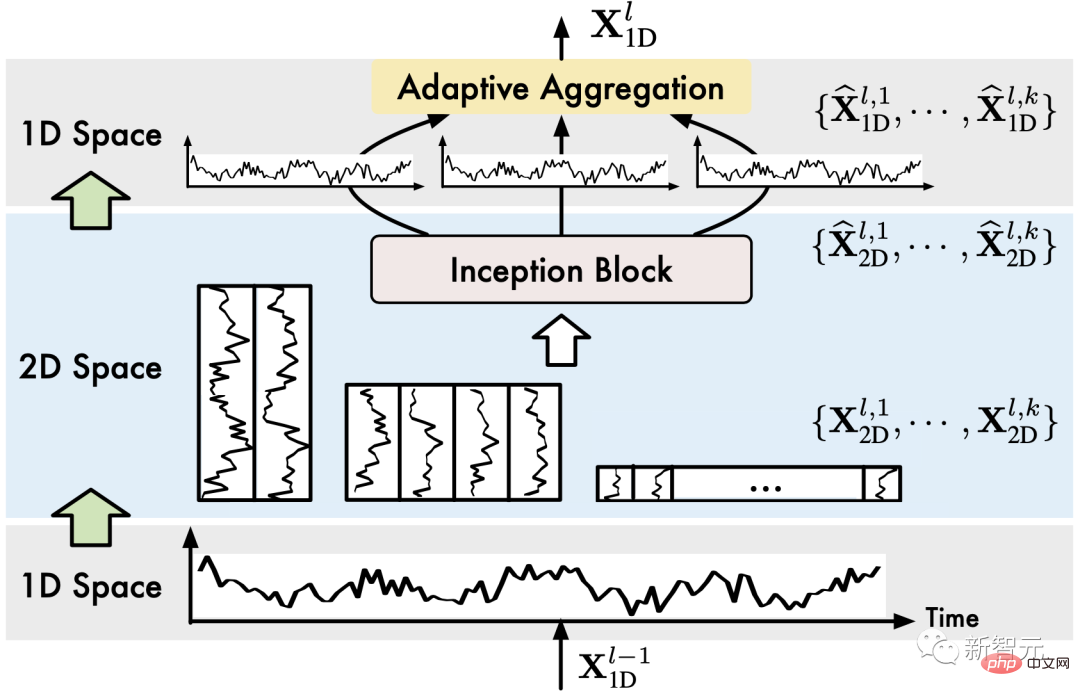

#このセクションでは、まず時系列データを 2 次元空間に拡張する方法を紹介し、次にモデルの全体的なアーキテクチャを紹介します。

3.1 タイミング変更: 1D->2D

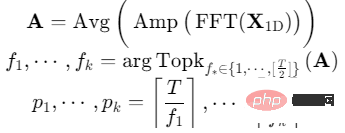

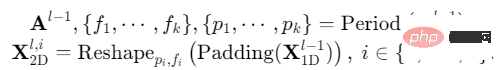

(1) 期間抽出

期間の長さの場合、次元時系列のチャネル次元、期間情報は時間次元の高速フーリエ変換 (FFT) によって直接抽出できます。つまり、

ここで、 はそれぞれの周波数成分の強度を表します。最大の強度を持つ周波数は、最も重要な周期長に対応します。

(2) シーケンスの折りたたみ 1D->2D

選択された個別の期間についてこのプロセスは次のように形式化できます:

ここで、シーケンスの最後に 0 が追加されます。シーケンスの長さを割り切れるようにします。

上記の操作を通じて、周期 の 2 次元時系列変化に対応する 2 次元テンソルのセットを取得します。

3.2 モデル設計

全体的に、TimesNet は積み重ねられた TimesBlock で構成されています。入力シーケンスは最初に埋め込み層を通過して、深い特徴を取得します。 3 番目のレイヤー TimesBlock の入力は次のとおりで、出力は次のとおりです。

# 具体的には、次の図に示すように、各 TimesBlock には次のサブプロセスが含まれています。

(1) 時系列の折りたたみ (1D->2D)

(1) 時系列の折りたたみ (1D->2D)

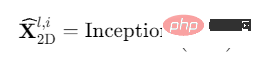

(2) 抽出2 次元時系列変化表現 (2D Representation)  : 前に分析したように、変換された 2 次元時系列変化は 2D 局所性を持っているため、2D 畳み込みを直接使用して特徴を抽出できます。ここでは、古典的なインセプション モデルを選択しました。

: 前に分析したように、変換された 2 次元時系列変化は 2D 局所性を持っているため、2D 畳み込みを直接使用して特徴を抽出できます。ここでは、古典的なインセプション モデルを選択しました。

1D タイミング機能を 2D 空間に変換したため、注目に値します。そのため、ResNeXt、ConvNeXt、Attention-based Swin Transformer など、コンピューター ビジョンの分野における多くの最先端のモデルを利用することもできます。これにより、時系列分析がビジュアル バックボーン ネットワークと連携して機能することが可能になります。

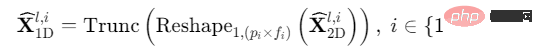

(3) 時系列の拡張 (2D->1D): 後続の複数期間の融合のために、2 次元の時系列変化表現を 1 つに拡張します。 -次元空間:

Trunc(⋅) は、手順 (1) の Padding(⋅) 操作によって追加された 0 を削除することを意味します。

(4) 適応融合 (1D 集約) : 複数期間の情報を融合するために、抽出された 2 次元時系列の加重加算を実行します。表現を選択し、「の合計の重みは、ステップ (1) で取得した対応する周波数強度です。」を選択します。 1D 時系列 TimesNet では、2D 空間の設計のために、「複数サイクルの 2 次元のタイミング変化を抽出し、適応融合する」というタイミング変化モデリング プロセスを実装しています。

4 実験

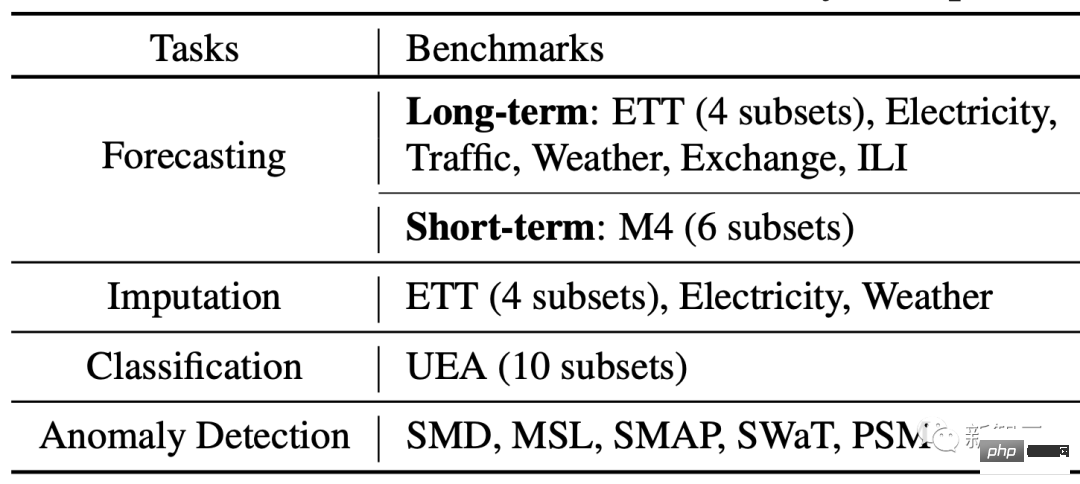

長期予測、短期予測、欠損値の埋め込み、異常検出、分類の 5 つの主要なタスクについて実験を行いました。 、36 のデータセット、81 の異なる実験設定をカバーしています。

同時に、RNN、CNN、MLP に基づく最新のものを含む、19 の異なる深度手法が比較されました。 、N-BEATS (2019)、Autoformer (2021)、LSSL (2022)、N-Hits (2022)、FEDformer (2022)、Dlinear (2023) などのトランスフォーマー モデル。

4.1 全体的な結果

冒頭のレーダー チャートに示されているように、TimesNet は 5 つのタスクすべてで SOTA を達成しました。

(1) 長期予測: この注目度の高いタスクにおいて、TimesNet は最先端の Transformer および MLP ベースのモデルを上回っています。

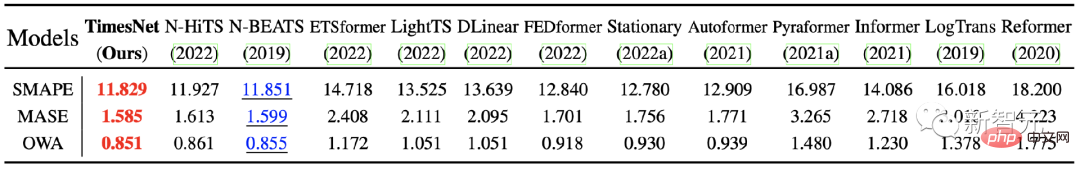

(2) 短期予測

: この実験で使用された M4 データセットには次のものが含まれます。サンプリング周波数が異なる 6 つのサブデータセット、合計 100,000 個を超えるデータ。 TimesNet は、この複雑なデータ分散状況でも最適な結果を達成し、モデルの時間変化モデリング機能を検証しました。

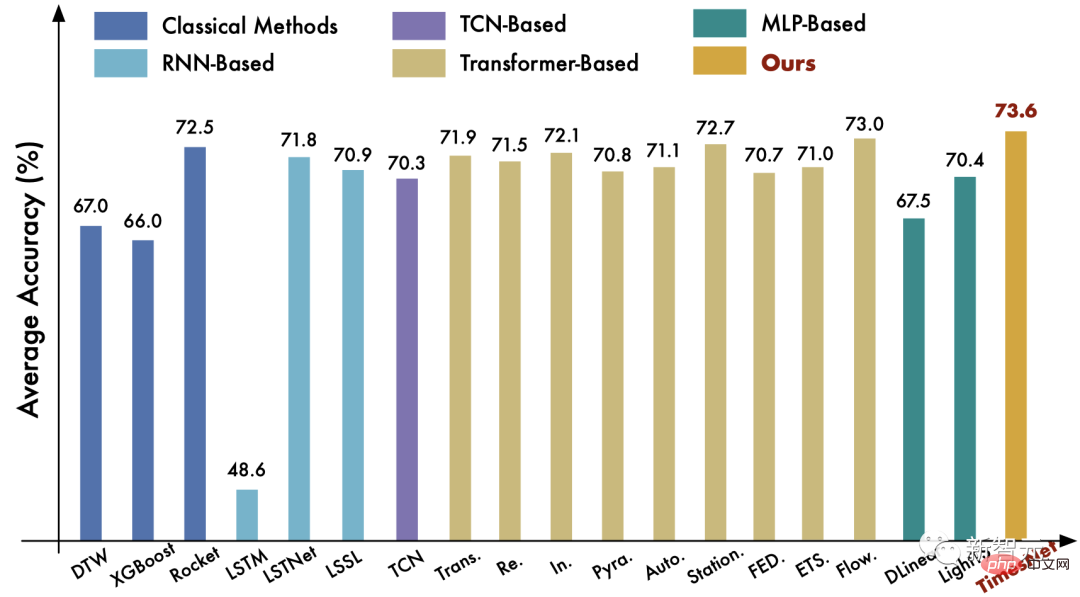

(3) 分類タスク : このタスクでは、TimesNet は古典的な Rocket アルゴリズムや最先端の深層学習モデルを上回っています。フローフォーマー。

#タスクの比較の詳細については、論文を参照してください。

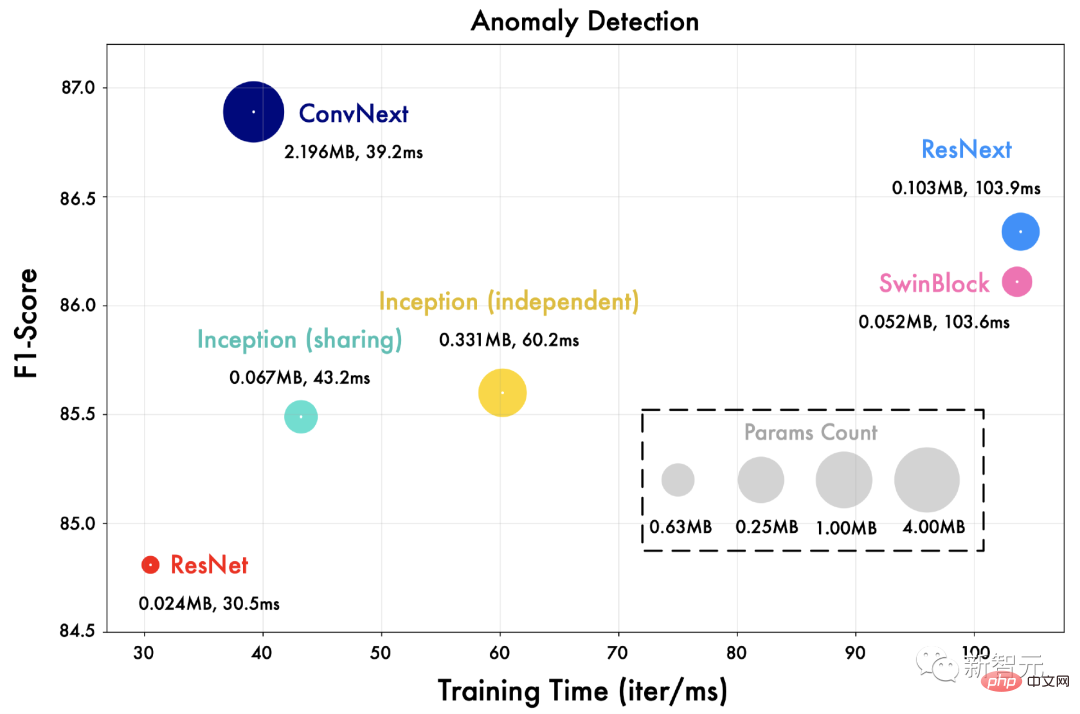

TimesNet のインセプション ネットワークを別のビジュアル バックボーン ネットワークに置き換えます。たとえば、 ResNet、ConvNext、Swin Transformer など

下の図に示すように、より高度なビジュアル バックボーン ネットワークにより、より良い結果が得られます。これは、TimesNet のフレームワークの下では、時系列分析がビジュアル バックボーン ネットワークの分野の進歩から直接恩恵を受けることができることも意味します。

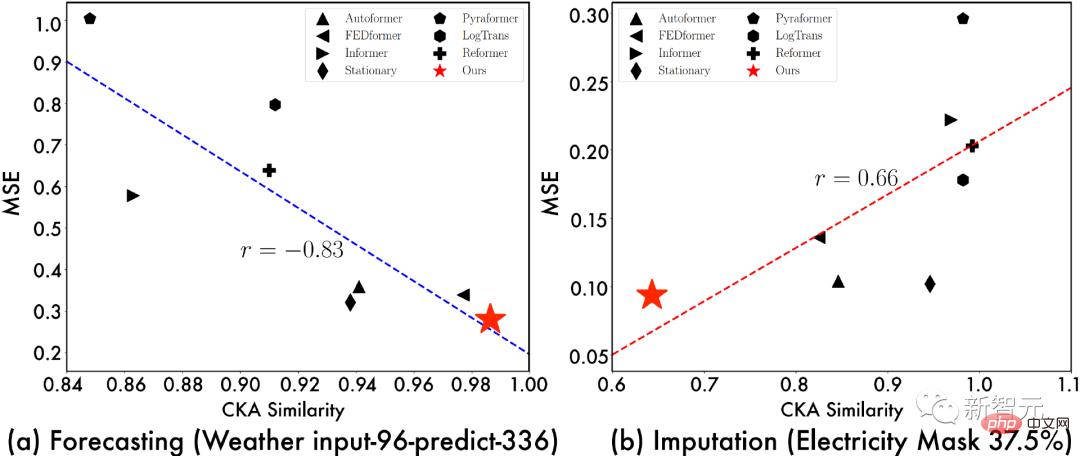

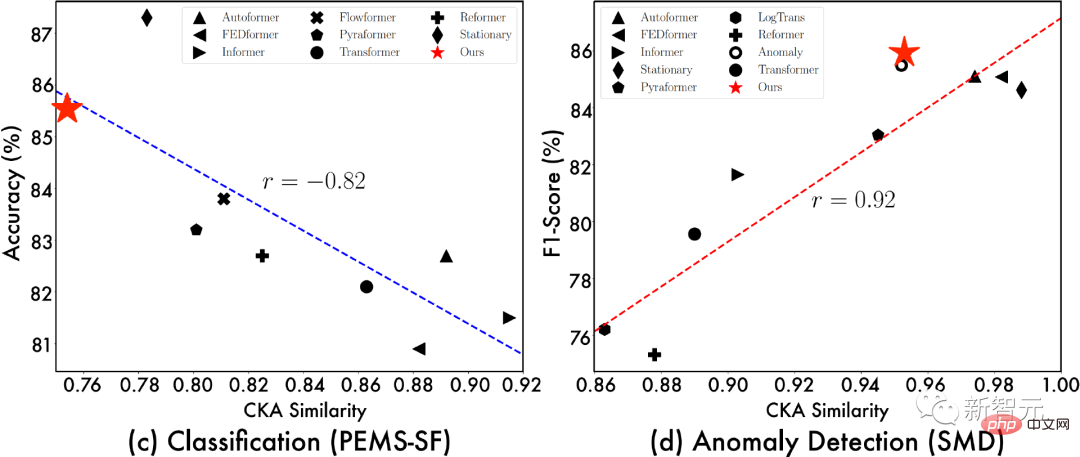

ソースをさらに調査するには、 TimesNet の効果として、「モデルの最下位レベル表現間の CKA 類似性」と「モデル効果」の関係を示します。このうち、CKA 類似度が低いほど、モデルの最下層と最上層の表現の差が大きくなり、より階層的な表現になります。

同時に、上記の表現分析は、特定のタスクのディープ モデルの設計アイデアも提供します。たとえば、予測タスクの場合は、基礎となる微細なモデルの抽出に焦点を当てる必要があります。粒状の特徴を理解し、タスクを埋めるために、グローバル表現を考慮した学習をさらに進める必要があります。

5 概要

同時に、TimesNet は、長期および短期の予測、欠損値の補完、異常検出、分類という 5 つの主流の時系列分析タスクにおいて包括的なリーダーシップを獲得しました。優れた応用価値を持っています。

以上がタイミング分析ペンタゴンウォリアー!清華大学が TimesNet を提案: 予測、充填、分類、検出をリードの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。