ChatGPT ボリューム モデルを実行するには、今後は GPU のみが必要になります。これを 100 倍高速化する方法を次に示します。

計算コストは、ChatGPT などの大規模なモデルを構築するときに人々が直面する大きな課題の 1 つです。

統計によると、GPT から GPT-3 への進化は、モデル サイズの成長プロセスでもあります。パラメーターの数は 1 億 1,700 万から 1,750 億に増加し、その量は増加しました。事前トレーニング データの量は 5 GB から 45 TB に増加し、1 回の GPT-3 トレーニングのコストは 460 万米ドルとなり、トレーニングの総コストは 1,200 万米ドルに達します。

トレーニングに加えて、推論にもコストがかかります。 ChatGPT を実行する OpenAI の計算能力コストは 1 日あたり 100,000 米ドルであると推定する人もいます。

大規模なモデルがより多くの機能を習得できるようにするテクノロジーを開発する一方で、AI に必要なコンピューティング リソースを削減しようとしている人もいます。最近、FlexGenという技術が「RTX 3090でChatGPTボリュームモデルを動作させる」ということで注目を集めています。

FlexGen によって高速化された大規模モデルは依然として非常に遅いように見えます (1,750 億パラメーターの言語モデルを実行すると 1 秒あたり 1 トークン)。しかし、印象的なのは、不可能が可能になったことです。

従来、大規模言語モデル (LLM) 推論には高い計算量とメモリ要件があるため、トレーニングに複数のハイエンド AI アクセラレータを使用する必要がありました。この研究では、LLM 推論の要件を消費者グレードの GPU まで削減し、実用的なパフォーマンスを達成する方法を検討します。

最近、スタンフォード大学、カリフォルニア大学バークレー校、チューリッヒ工科大学、ヤンデックス、モスクワ州立高等経済学校、メタ、カーネギーメロン大学およびその他の機関からの新しい研究により、FlexGen は高品質であると提案されました。限られた GPU メモリで LLM を実行するためのスループット生成エンジン。

GPU、CPU、ディスクからのメモリと計算を集約することで、FlexGen はさまざまなハードウェア リソースの制約の下で柔軟に構成できます。線形計画オプティマイザーを通じて、重み、アクティベーション、アテンション キー/値 (KV) キャッシュを含むテンソルの保存とアクセスのための最適なパターンを検索します。 FlexGen は、精度の損失を無視して、重みと KV キャッシュを 4 ビットにさらに圧縮します。最先端のオフロード システムと比較して、FlexGen は単一の 16 GB GPU 上で OPT-175B を 100 倍高速に実行し、1 トークン/秒の実際の生成スループットを初めて達成します。 FlexGen にはパイプライン化された並列ランタイムも付属しており、より多くの分散 GPU が利用可能な場合にデコードでの超線形スケーリングが可能になります。

現在、このテクノロジーはコードを公開し、数千のスターを獲得しています: https://www.php.cn /link/ee715daa76f1b51d80343f45547be570

はじめに

近年、大規模な言語モデルは、幅広いタスクで優れたパフォーマンスを示しています。 LLM は前例のない一般的なインテリジェンスを示しますが、構築時に人々を前例のない課題にさらすことにもなります。これらのモデルには数十億、さらには数兆のパラメーターが含まれる場合があり、その結果、モデルを実行するには非常に高い計算量とメモリ要件が必要になります。たとえば、GPT-175B (GPT-3) では、モデルの重みを保存するためだけに 325GB のメモリが必要です。このモデルが推論を実行するには、少なくとも 5 台の Nvidia A100 (80GB) と複雑な並列処理戦略が必要です。LLM 推論のリソース要件を削減する方法は、最近頻繁に議論されています。これらの取り組みは 3 つの方向に分かれています:

(1) 総メモリ使用量を削減するためのモデル圧縮;

(2) 協調推論、分散化によるコストの償却。

(3) CPU とディスク メモリを利用するためのオフロード。

これらの手法により、LLM を使用するための計算リソース要件が大幅に削減されます。ただし、モデルは GPU メモリに収まると想定されることが多く、既存のオフロード ベースのシステムでは、単一の GPU を使用して許容可能なスループットで 1,750 億個のパラメーター サイズのモデルを実行するのに依然として苦労しています。

新しい研究では、著者らは高スループットの生成推論のための効果的なオフロード戦略に焦点を当てています。 GPU メモリが十分でない場合は、それを二次ストレージにオフロードし、部分ロードを通じて部分的に計算を実行する必要があります。一般的なマシンでは、次の図に示すように、メモリ階層は 3 つのレベルに分割されます。高レベルのメモリは高速ですが不足しており、低レベルのメモリは低速ですが豊富です。

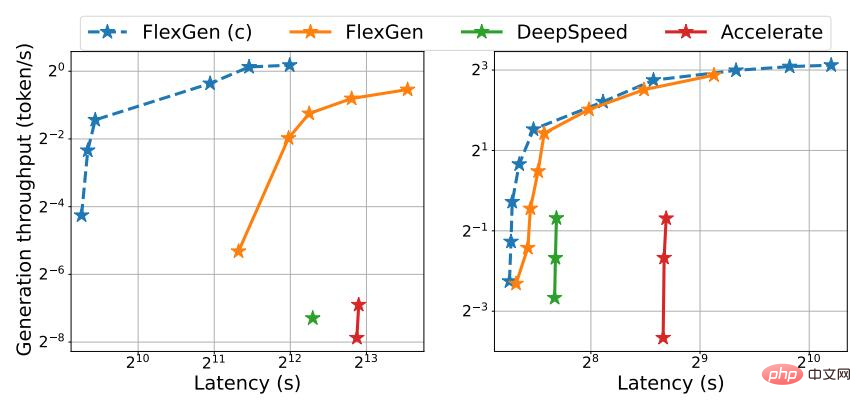

FlexGen では、作者は低遅延を追求するのではなく、ベンチマーク、情報抽出、データ並べ替えなどのアプリケーションで一般的なスループット指向のシナリオをターゲットにしています。オフロードでは低遅延の実現が本質的に課題ですが、スループット重視のシナリオではオフロードの効率を大幅に改善できます。図 1 は、オフロードを使用した 3 つの推論システムのレイテンシーとスループットのトレードオフを示しています。慎重にスケジュールを設定すると、I/O コストが大量の入力に分散され、計算と重複する可能性があります。この研究で著者らは、コンシューマ グレードの GPU スループットが最適化された 1 台の T4 GPU が、コンピューティング能力の単位あたりのコストの点で、クラウド上のレイテンシが最適化された 8 台の A100 GPU よりも 4 倍効率的であることを示しました。

図 1. OPT-175B (左) と OPT-30B (右) 上面3 つのオフロード ベースのシステムのレイテンシーとスループットのトレードオフ。 FlexGen は新しいパレート最適境界を達成し、OPT-175B の最大スループットを 100 倍に増加します。他のシステムでは、メモリ不足によりスループットをさらに向上させることができませんでした。

トレーニングのコンテキストにおけるオフロードのレイテンシとスループットのトレードオフについて議論する研究はありますが、LLM 推論の生成にそれを使用した人はまだいません。それは全く異なるプロセスです。 LLM の自己回帰的な性質により、生成推論には特有の課題が生じます。すべてのパラメータを保存することに加えて、順次デコードし、大規模なアテンション キー/値キャッシュ (KV キャッシュ) を維持する必要があります。既存のオフロード システムはこれらの課題に対処できないため、過剰な I/O を実行し、ハードウェアの能力を大幅に下回るスループットを達成します。

生成推論のための適切なオフロード戦略を設計することは困難です。まず、このプロセスには、重み、アクティベーション、KV キャッシュという 3 つのテンソルがあります。ポリシーでは、3 レベルの階層で、何を、どこで、いつアンインストールするかを指定する必要があります。 2 番目に、バッチごと、トークンごと、レイヤーごとの計算の構造により、さまざまな方法で計算できる複雑な依存関係グラフが形成されます。戦略では、実行時間を最小限に抑えるスケジュールを選択する必要があります。これらの選択により、複雑な設計空間が作成されます。

この目的を達成するために、新しいメソッド FlexGen 上で、LLM 推論のためのオフロード フレームワークが提案されています。 FlexGen は、GPU、CPU、ディスクからメモリを集約し、I/O 操作を効率的にスケジュールし、可能な圧縮方法と分散パイプライン並列処理についても説明します。

#この研究の主な貢献は次のとおりです:

#1. 著者は、可能なオフロード戦略と用途の検索空間を正式に定義しています。コスト モデルと線形計画ソルバーが最適な戦略を検索します。注目すべきことに、研究者らは、検索スペースが最適な計算順序の 2 倍以内の I/O 複雑さでほぼ I/O 最適な計算順序を捕捉していることを実証しました。検索アルゴリズムは、さまざまなハードウェア仕様やレイテンシー/スループットの制約に合わせて構成でき、トレードオフ領域をスムーズにナビゲートする方法を提供します。既存の戦略と比較して、FlexGen ソリューションは重み付け、アクティベーション、KV キャッシュの配置を統合し、より大きなバッチ サイズを可能にします。

2. 研究によると、OPT-175B などの LLM の重みと KV キャッシュは、再トレーニング/キャリブレーションなしで、精度の損失が無視できる程度で 4 ビットに圧縮できることがわかっています。これは、きめ細かいグループ化の量子化によって実現され、I/O コストを大幅に削減できます。

3. NVIDIA T4 GPU (16GB) で OPT-175B を実行して、FlexGen の効率を実証します。単一の GPU 上で、同じレイテンシー要件が与えられた場合、非圧縮 FlexGen は、DeepSpeed Zero-Inference (Aminabadi et al.、2022) および Hugging Face Accelerate (HuggingFace、2022) と比較して 65 倍高いスループットを達成できます。現在、後者が最も先進的です。業界におけるオフロードに基づく推論システム。より高いレイテンシと圧縮が許可される場合、FlexGen はスループットをさらに向上させ、100 倍の改善を達成できます。 FlexGen は、単一の T4 GPU を使用して OPT-175B で 1 トークン/秒の速度スループットを達成した最初のシステムです。パイプライン並列処理を備えた FlexGen は、複数の分散 GPU を使用したデコードにおいて超線形スケーリングを実現します。

研究では、著者らはオフロードおよび分散型セット推論手法の代表として FlexGen と Petals も比較しました。結果は、1 つの T4 GPU を備えた FlexGen が、スループットの点で 12 つの T4 GPU を備えた分散型 Petal クラスターよりも優れており、場合によってはより低いレイテンシを実現することさえ示しています。

動作メカニズム

GPU、CPU、ディスクからのメモリと計算を集約することで、FlexGen はさまざまなハードウェア リソースの制約の下で柔軟に構成できます。線形計画オプティマイザーを通じて、重み、アクティベーション、アテンション キー/値 (KV) キャッシュを含むテンソルの保存とアクセスのための最適なパターンを検索します。 FlexGen は、精度の損失を無視して、重みと KV キャッシュを 4 ビットにさらに圧縮します。

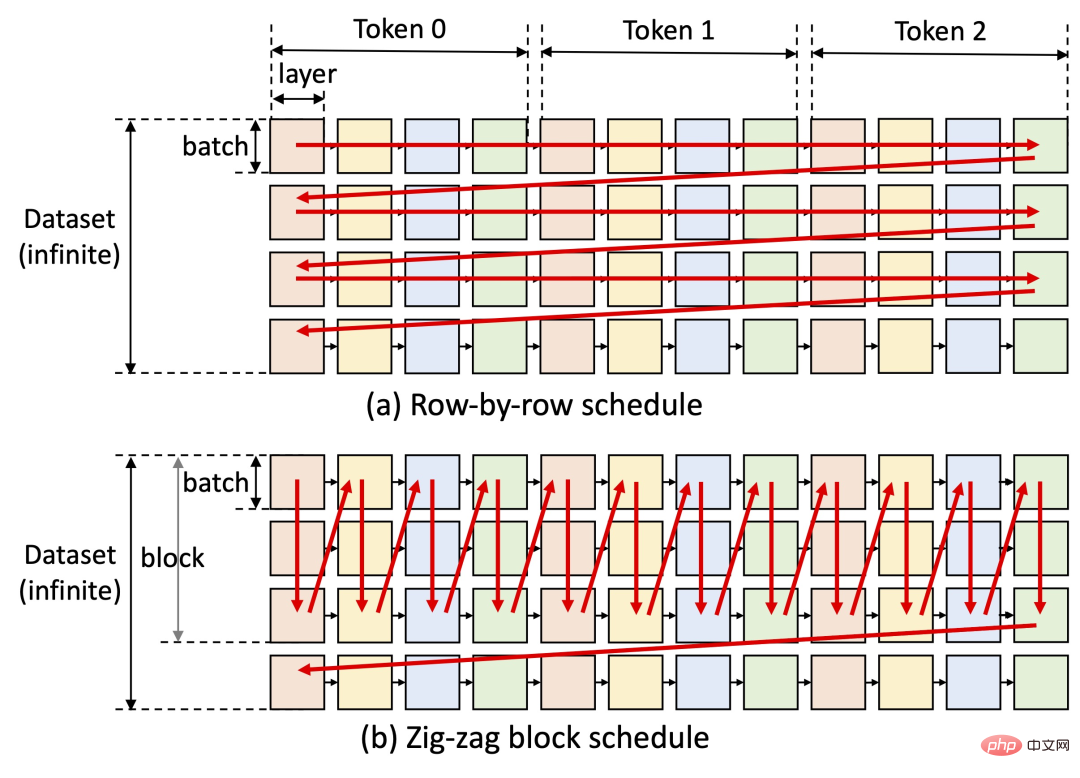

FlexGen の重要なアイデアの 1 つは、レイテンシとスループットのトレードオフです。オフロード手法では低レイテンシーの実現が本質的に困難ですが、スループット重視のシナリオではオフロード効率を大幅に改善できます (以下の図を参照)。 FlexGen は、下の図 (b) に示すように、ブロック スケジューリングを利用して重みを再利用し、I/O を計算とオーバーラップさせますが、他のベースライン システムは、下の図 (a) に示すように、非効率的な行ごとのスケジューリングを使用します。

現在、研究著者らの次のステップには、Apple の M1 および M2 チップのサポートと Colab 導入のサポートが含まれています。

FlexGen は、リリース以来すぐに GitHub で何千ものスターを獲得し、ソーシャル ネットワークでも非常に人気があります。このプロジェクトは非常に期待されており、高性能大規模言語モデルを実行する上での障壁は徐々に克服されつつあるようで、年内にはChatGPTを1台のマシンで扱えるようになることが期待されています。

誰かがこの方法を使用して言語モデルをトレーニングしたところ、結果は次のとおりです:

大量のデータが与えられておらず、AI は特定の知識を知りませんが、質問に答えるロジックは比較的明確なようです。もしかしたら、将来のゲームではそのような NPC が登場するかもしれません?

以上がChatGPT ボリューム モデルを実行するには、今後は GPU のみが必要になります。これを 100 倍高速化する方法を次に示します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7692

7692

15

15

1639

1639

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。