今後 10 年間で、AI 音声認識は次の 5 つの方向に発展します

著者|Migüel Jetté

コンパイラ|bluemin

編集者|Chen Caixian

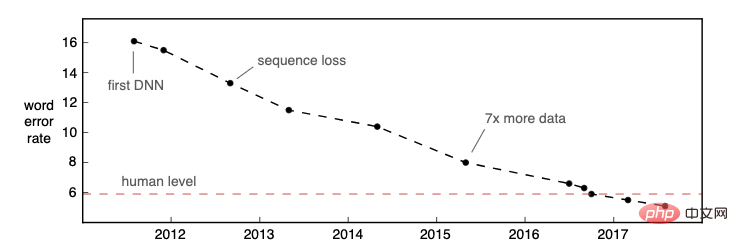

過去 2 年間、自動音声認識 (ASR) は、次の分野で広く使用されてきました。商用利用において重要な開発が達成されており、測定指標の 1 つは、Alexa、Rev、AssemblyAI、ASAPP など、完全にニューラル ネットワークに基づいた複数のエンタープライズ レベルの ASR モデルが正常に起動されたことです。 2016 年、Microsoft Research は、25 年前の「Switchboard」データ セットにおいて、そのモデルが人間レベルのパフォーマンス (単語誤り率で測定) に達したことを発表する記事を発表しました。 ASR の精度は向上し続けており、より多くのデータセットやユースケースで人間レベルのパフォーマンスに達しています。

画像出典: Awni Hannun のブログ投稿「音声認識は解決されていない」

ASR テクノロジの認識精度が大幅に向上したことで、アプリケーション シナリオは次のようになります。私たちは、ASR の商業利用はまだピークではないと考えており、この分野での研究や市場への応用はまだ模索されていません。 AI 音声関連の研究と商用システムは、今後 10 年間で次の 5 つの分野に焦点を当てると予測しています:

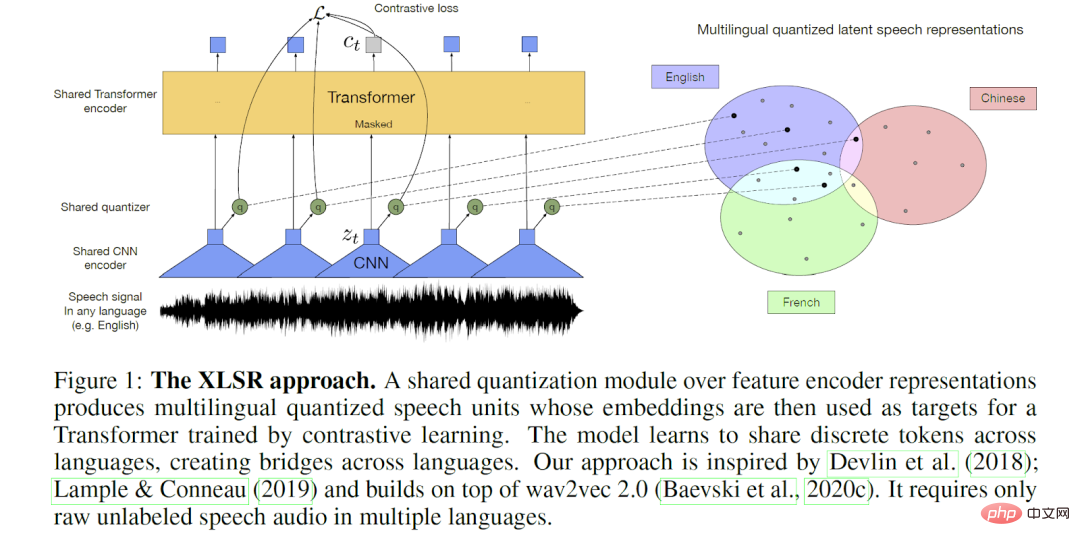

#1. 多言語 ASR モデル 「今後 10 年間で、私たちは真の多言語モデルを実稼働環境に展開し、開発者が誰もがどの言語でも理解できるアプリケーションを構築できるようにし、音声認識の力を真に世界に解き放ちます。」

従来の ASR システムは、話し言葉を認識するプロセスで複数の仮説のグリッドを生成することができ、これは人間による文字起こし、音声対話システム、および情報検索に大きな利点があることが証明されています。 n-best の情報を豊富な出力形式で含めることで、より多くのユーザーが ASR システムを使用するようになり、ユーザー エクスペリエンスが向上します。現在、音声デコード中に生成される、または生成される可能性のある追加情報を構造化または保存するための標準は存在しませんが、CallMiner の Open Speech Transcription Standard (OVTS) はこの方向への確かな一歩であり、企業が複数の ASR ベンダーを探索して選択することを容易にします。

将来的には、ASR システムは標準形式でより豊富な出力を生成し、より強力なダウンストリーム アプリケーションをサポートすると予測しています。たとえば、ASR システムは可能なメッシュの全範囲を出力し、アプリケーションはトランスクリプトの編集時にこの追加データを使用してインテリジェントな自動トランスクリプションを実行できます。同様に、検出された地域の方言、アクセント、周囲の騒音、雰囲気などの追加のメタデータを含む ASR 転写により、より強力な検索アプリケーションが可能になります。

3. すべての人のための大規模 ASR

「この 10 年間で、大規模な ASR (つまり、民営化、手頃な価格、信頼性の高い、これらのシステムは、ビデオを検索し、私たちが関与するすべてのメディア コンテンツにインデックスを付け、世界中の聴覚障害のある消費者がすべてのビデオにアクセスできるようにすることができます。ASR は次の課題への答えとなります。オーディオとビデオのすべてのキーは、アクセスして実行できるようにするためのものです。」

おそらく誰もがオーディオおよびビデオ ソフトウェアを頻繁に使用します。ポッドキャスト、ソーシャルメディアストリーム、オンラインビデオ、ライブグループチャット、Zoomミーティングなど。しかし、実際に転写される関連コンテンツはほとんどありません。現在、コンテンツの転写は ASR API の最大の市場の 1 つとなっており、特にその精度と手頃な価格を考慮すると、今後 10 年間で急激に成長すると予想されます。そうは言っても、ASR トランスクリプションは現在、特定のアプリケーション (ブロードキャスト ビデオ、特定の会議やポッドキャストなど) にのみ使用されています。その結果、多くの人がこのメディア コンテンツにアクセスできず、放送やイベント後に関連情報を見つけることが困難になっています。

将来的には、この状況は変わるでしょう。マット・トンプソン氏が 2010 年に予測したように、ある時点で ASR は安価になり、彼の言うところの「スピーチ可能性」を私たちが経験できるほど普及するでしょう。将来的には、ほぼすべてのオーディオおよびビデオ コンテンツが文字起こしされ、即座にアクセス可能、保存可能、および大規模な検索が可能になると予測しています。しかし、ASR の開発はここで終わるわけではなく、これらのコンテンツが実用的なものになることを期待しています。私たちは、消費または関与するそれぞれの音声やビデオが、ポッドキャストや会議から自動的に生成される洞察や、ビデオ内の重要な瞬間の自動要約など、追加のコンテキストを提供することを望んでいます。私たちは、NLP システムが上記の処理をルーチン化できることを望んでいます。

#4. 人間と機械のコラボレーション

「今世紀末までに、私たちは次のような進化する ASR システムを手に入れるでしょう。 「人間の助けや自己監視によって継続的に学習する生体。これらのシステムは現実世界のさまざまなソースから学習し、新しい単語や言語の変種を非同期ではなくリアルタイムで理解し、自己デバッグし、さまざまな使用法を自動的に監視します。」

ASR が主流になり、カバーするユースケースの数が増えるにつれ、人間とマシンのコラボレーションが重要な役割を果たすようになるでしょう。 ASR モデルのトレーニングはこれをよく反映しています。現在、オープンソース データセットと事前トレーニングされたモデルにより、ASR ベンダーの参入障壁が低くなりました。ただし、トレーニング プロセスは依然として非常に単純です。データの収集、データの注釈付け、モデルのトレーニング、結果の評価、モデルの改善です。しかし、これはプロセスに時間がかかり、多くの場合、調整の難しさやデータ不足によりエラーが発生しやすくなります。 Garnerin らは、メタデータの欠落とコーパス全体の表現の不一致により、ASR パフォーマンスの同等の精度を保証することが困難であることを観察しましたが、これは Reid と Walker がメタデータ標準の開発時に解決しようとした問題でもあります。

将来的には、人間はインテリジェントな手段を通じて ASR トレーニングを効率的に監督し、機械学習の加速においてますます重要な役割を果たすようになるでしょう。人間参加型アプローチでは、人間のレビュー担当者を機械学習/フィードバック ループに配置し、モデル結果の継続的なレビューと調整を可能にします。これにより、機械学習がより高速かつ効率的になり、より高品質な出力が得られます。今年の初めに、ASR の改善により、Rev の人間の文字起こし者 (「Revvers」と呼ばれます) が ASR ドラフトに対して後編集を実行して生産性を高める方法について議論しました。 Revver の転写は、改良された ASR モデルに直接入力でき、好循環を形成します。

人間の言語の専門家が引き続き ASR に不可欠な分野の 1 つは、逆テキスト正規化 (ITN) です。ITN では、認識された文字列 (「5 ドル」など) を、期待される書面形式 (「 $5」など) に変換します。 Pusateri らは「手作りの文法と統計モデル」を使用したハイブリッド アプローチを提案し、Zhang らはこれらの方針に沿って、手作りの FST で RNN を制約することで継続しました。

5. 責任ある ASR

「すべての AI システムと同様、将来の ASR システムは、より厳格な AI 倫理原則に準拠し、システムが「誰もが平等に、より高度な説明可能性を持ち、自らの決定に責任を持ち、ユーザーとそのデータのプライバシーを尊重します。」

将来の ASR システム AI の 4 つの原則公平性、説明可能性、プライバシーの尊重、説明責任などの倫理が遵守されます。

公平性: 公平な ASR システムは、話者の背景、社会経済的地位、その他の特性に関係なく音声を認識します。このようなシステムを構築するには、モデルとトレーニング データのバイアスを特定して軽減する必要があることに注意してください。幸いなことに、政府、NGO、企業はすでに偏見を特定し軽減するためのインフラストラクチャの構築に取り組んでいます。

解釈可能性: ASR システムはもはや「ブラック ボックス」ではなくなります。データの収集と分析、モデルのパフォーマンス、および出力プロセスを必要に応じて解釈します。この追加の透明性要件により、モデルのトレーニングとパフォーマンスを人間がより適切に監視できるようになります。 Gerlings らと同様に、私たちは解釈可能性をさまざまな利害関係者 (研究者、開発者、顧客、そして Rev の場合は転写担当者を含む) の観点から見ています。研究者は、問題を軽減するために誤ったテキストを出力する理由を知りたいと思うかもしれませんが、転写担当者は、特に ASR の方が人よりも効率的である可能性がある騒がしい状況では、ASR がその有効性を評価するのに役立つように、なぜ ASR がそのように考えるのかの証拠を必要としているかもしれません。」 「もっとよく聞いてください。」 Weitz らは、音声キーワード認識のコンテキストにおいて、エンドユーザーの解釈可能性に向けた重要な第一歩を踏み出しました。 Laguarta と Subirana は、アルツハイマー病検出のための音声バイオマーカー システムに臨床医主導の通訳を組み込みました。

プライバシーの尊重:「音声」はさまざまな米国法および国際法の下で「個人データ」とみなされ、したがって、音声録音の収集と処理は厳格な個人プライバシー保護の対象となります。 Rev では、データ セキュリティと制御機能をすでに提供しており、将来の ASR システムではユーザー データのプライバシーとモデルのプライバシーがさらに尊重されます。多くの場合、これには ASR モデルをエッジ (デバイスまたはブラウザー上) にプッシュすることが含まれる可能性が高くなります。音声プライバシーの課題により、この分野の研究が推進されており、欧州連合などの多くの管轄区域が立法化への取り組みを開始しています。プライバシーを保護する機械学習の分野では、テクノロジーのこの重要な側面に注目が集まり、社会に広く受け入れられ、信頼されるようになることが期待されています。

説明責任: ASR システムを監視して、最初の 3 つの原則が遵守されていることを確認します。そのためには、必要な監視システムを設計および開発し、調査結果に応じて行動を起こすためのリソースとインフラストラクチャへの投資が必要になります。 ASR システムを導入する企業は、テクノロジーの使用に責任を負い、ASR の倫理原則を遵守するために特別な努力を払うことになります。 ASR システムの設計者、保守者、および利用者としての人間は、これらの原則の実装と強制を担当することになることは言及する価値があります。これは、人間とマシンのコラボレーションのもう 1 つの例です。

参考リンク: https://thegradient.pub/the-future-of-speech-recognition/https://awni.github.io/speech-recognition/

以上が今後 10 年間で、AI 音声認識は次の 5 つの方向に発展しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7486

7486

15

15

1377

1377

52

52

77

77

11

11

19

19

38

38

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

最初のパイロットおよび重要な記事では、主に自動運転技術で一般的に使用されるいくつかの座標系と、それらの間の相関と変換を完了し、最終的に統合環境モデルを構築する方法を紹介します。ここでの焦点は、車両からカメラの剛体への変換 (外部パラメータ)、カメラから画像への変換 (内部パラメータ)、および画像からピクセル単位への変換を理解することです。 3D から 2D への変換には、対応する歪み、変換などが発生します。要点:車両座標系とカメラ本体座標系を平面座標系とピクセル座標系に書き換える必要がある 難易度:画像の歪みを考慮する必要がある 歪み補正と歪み付加の両方を画面上で補正する2. はじめに ビジョンシステムには、ピクセル平面座標系 (u, v)、画像座標系 (x, y)、カメラ座標系 ()、世界座標系 () の合計 4 つの座標系があります。それぞれの座標系には関係性があり、

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

セルフメディアで最も収益性の高い 5 つの分野は何ですか? 2024年のDouyinのサポートの方向性は何ですか?

Mar 22, 2024 am 10:11 AM

セルフメディアで最も収益性の高い 5 つの分野は何ですか? 2024年のDouyinのサポートの方向性は何ですか?

Mar 22, 2024 am 10:11 AM

インターネットの急速な発展に伴い、セルフメディア業界はますます多くの人々の注目を集めるようになりました。この業界では、幅広い市場の見通しと収益性により、多くの注目を集めている分野があります。この記事では、セルフメディアの最も収益性の高い 5 つの分野を明らかにするとともに、セルフメディアの発展の機会をよりよく把握できるよう、2024 年の Douyin のサポートの方向性について説明します。 1. セルフメディアで最も収益性の高い 5 つの分野は何ですか?オンライン教育の台頭により、教育とトレーニングの分野の人気が高まっています。人々は、学問的なコースだけでなく、スキルトレーニングや職場での昇進など、知識とスキルの習得に積極的に投資します。セルフメディアクリエイターは、学生が学習にお金を払うよう引き付ける高品質の教育コンテンツを作成することで、収益を得ることができます。この傾向は人々が生涯学習に関心を持っていることを示しています

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

著者の個人的な考えの一部 自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発に伴い、高品質のマルチビュー トレーニング データとそれに対応するシミュレーション シーンの構築がますます重要になってきています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分離できます。 さまざまな次元のロングテール シナリオ: 障害物データ内の近距離車両、車両切断中の正確な進行角、車線などラインデータ 曲率の異なるカーブやランプ・合流・合流などの撮影が難しいシーン。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。 3D 真の値 - 一貫性の高い画像: 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。これが私を導いた

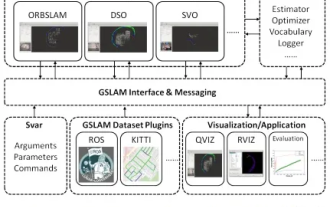

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

19 年前の論文を突然発見 GSLAM: A General SLAM Framework and Benchmark オープンソース コード: https://github.com/zdzhaoyong/GSLAM 全文に直接アクセスして、この作品の品質を感じてください ~ 1 抽象的な SLAM テクノロジー近年多くの成功を収め、多くのハイテク企業の注目を集めています。ただし、既存または新たなアルゴリズムへのインターフェイスを使用して、速度、堅牢性、移植性に関するベンチマークを効果的に実行する方法は依然として問題です。この論文では、GSLAM と呼ばれる新しい SLAM プラットフォームを提案します。これは、評価機能を提供するだけでなく、研究者が独自の SLAM システムを迅速に開発するための有用な方法を提供します。

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、