論文の著者は人気がありますが、ChatGPT などの大規模な言語モデルはいつ論文の共著者になれるのでしょうか?

ChatGPT はリリース以来注目を集めており、現在利用可能な最も強力な言語モデルの 1 つと考えられています。そのテキスト生成能力は人間のそれに劣らず、一部の機械学習専門家は、研究者がChatGPTを使用して論文を書くことを禁止しています。

しかし最近、論文の著者欄に ChatGPT と明確に署名されました。何が起こっているのでしょうか?

この論文は、医学研究論文プラットフォーム medRxiv で公開された「USMLE での ChatGPT のパフォーマンス: 大規模言語モデルを使用した AI 支援医学教育の可能性」です。論文、著者は 3 名。

論文のタイトルからわかるように、この論文の主な内容は、米国の医療機関における ChatGPT のパフォーマンスを研究することです。ライセンス試験 (USMLE)。実験結果によると、特別なトレーニングや強化を行わなくても、すべての試験における ChatGPT のスコアは合格基準点に達したか、それに近かったことが示されています。さらに、ChatGPT によって生成された回答は、高度な一貫性と洞察力を示しています。この研究は、大規模な言語モデルが医学教育に役立つ可能性があり、臨床上の意思決定に役立つ可能性があることを示唆しています。

研究の内容から判断すると、Twitter ユーザーが次のように述べているように、ChatGPT は研究対象に近いようです。「人間の研究者が実験結果に貢献するのであれば、当然、彼らは研究対象となるでしょう」彼は論文の共著者ですが、モデルとアルゴリズムに関してそのような前例はありません。」

しかし、別のネチズンはすぐに彼に反論しました。コメントエリア内: 「パスカルの賭けの文脈におけるラパマイシン: 生成的な事前訓練済みトランスフォーマーの視点」というタイトルの以前の論文は、署名されただけでなく、ChatGPT が筆頭著者でもありました。

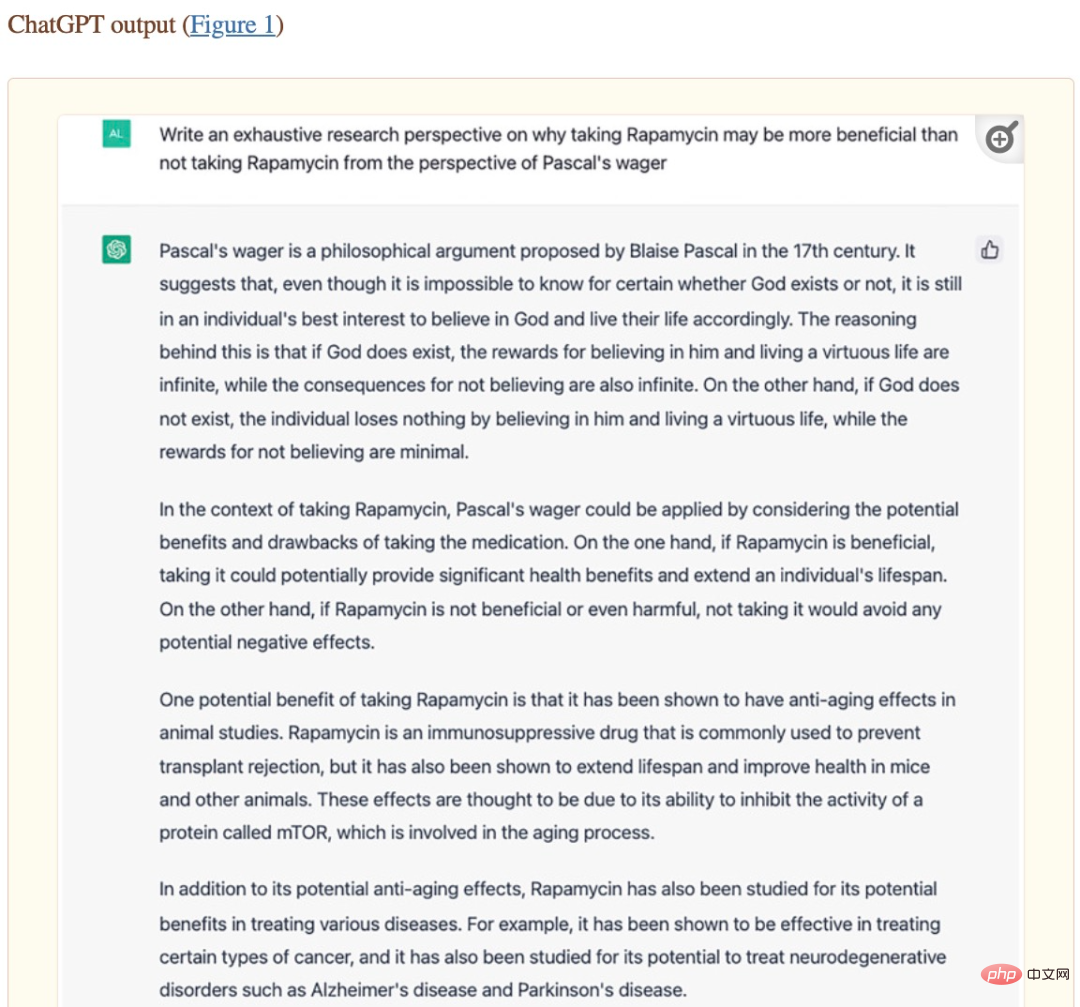

この論文は、国立衛生研究所 (NIH) の Oncoscience に掲載されています。しかし、論文著者の寄稿から、この論文の内容の大部分は実際に ChatGPT によって生成されたことがわかりました。論文の 2 番目の著者である Alex Zhavoronkov は、研究テーマに関連する ChatGPT の質問をし、ChatGPT が自動的に多数の意見と説明があり、ChatGPT によって生成されたコンテンツは Alex Zhavoronkov によって管理されます。さらに、ChatGPT は論文のフォーマットも支援します。

論文「パスカルの賭けの文脈におけるラパマイシン: 生成的な事前訓練済みトランスフォーマーの観点」のスクリーンショット。

#論文の署名を決定する際、Alex Zhavoronkov は OpenAI の共同創設者兼 CEO の Sam Altman に確認を求め、最終的にこの記事を ChatGPT で公開しました。第一著者の論文。これは、大規模な言語モデルなどの強力な AI システムが将来的に学術研究に有意義な貢献をし、論文の共著者になる能力さえあることを示唆しています。

ただし、大規模な言語モデルで学術論文を書くことを許可することにはいくつかの欠点もあります。たとえば、トップの機械学習カンファレンスである ICML は次のように述べています。「ChatGPT は公開データでトレーニングされており、これは「多くの場合、同意なしに収集されます。特定の条件下で収集されると、これは一連の責任帰属問題を引き起こすことになります。」

ノースウェスタン大学のキャサリン・ガオらによる最近の研究では、研究者らは次のことを選択した。 Journal of the American Medical Association (JAMA)、New England Journal of Medicine (NEJM)、British Medical Journal (BMJ)、The Lancet、Nature Medicine に掲載された手動研究論文に掲載された一部のデータは、ChatGPT を使用して論文の要約を生成します。そしてレビューをテストします。人間はこれらの概要が AI によって生成されたことを検出できますか?

実験結果によると、レビュー担当者は生成された要約の 68% と元の要約の 86% しか正しく識別できませんでした。彼らは、生成された概要の 32% を元の概要と誤って識別し、元の概要の 14% を AI によって生成されたものと誤って識別しました。査読者は、「この 2 つを区別するのは驚くほど難しく、生成された要約は曖昧で、人々に定型的な印象を与えます。」

この実験結果は、両者を区別するのが難しいことを示しています。人間の研究者は、テキストが AI によって生成されたのか、それとも人間によって書かれたのかを判断するのは良い兆候ではなく、AI は「不正行為」をしているようです。

しかし、これまでのところ、言語モデルによって生成されたコンテンツはその正しさを完全には保証できず、一部の専門分野ではエラー率が非常に高いことさえあります。人間が書いたコンテンツと AI モデルが生成したコンテンツを区別できない場合、人間は AI に誤解されるという深刻な問題に直面することになります。

以上が論文の著者は人気がありますが、ChatGPT などの大規模な言語モデルはいつ論文の共著者になれるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7486

7486

15

15

1377

1377

52

52

77

77

11

11

19

19

38

38

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPT と Python を使用してユーザー意図認識機能を実装する方法 はじめに: 今日のデジタル時代において、人工知能技術はさまざまな分野で徐々に不可欠な部分になりました。その中で、自然言語処理 (Natural Language Processing、NLP) テクノロジーの開発により、機械が人間の言語を理解して処理できるようになります。 ChatGPT (Chat-GeneratingPretrainedTransformer) は、

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

オープン AI がついに検索に進出します。サンフランシスコの同社は最近、検索機能を備えた新しい AI ツールを発表した。今年 2 月に The Information によって初めて報告されたこの新しいツールは、まさに SearchGPT と呼ばれ、次のような機能を備えています。