Google AIシンガーが登場! AudioLM は、数秒間聞くだけで音楽や歌を作曲できます。

画像生成モデルが登場!ビデオ生成モデルが満載!

次はオーディオ生成モデルです。

最近、Google 研究チームは音声生成用の AI モデル、AudioLM を発表しました。

わずか数秒の音声プロンプトで、高品質で一貫した音声を生成できるだけでなく、ピアノ音楽も生成できます。

論文アドレス: https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

AudioLM は、長期使用可能な高品質オーディオ生成フレームワークです。一貫性 、入力オーディオを離散トークンの文字列にマッピングし、オーディオ生成タスクを言語モデリング タスクに変換します。

既存のオーディオ タガーは、オーディオ生成の品質と安定した長期的な構造の間でトレードオフを行う必要があります。

この矛盾を解決するために、Google は「ハイブリッド トークン化」ソリューションを採用しています。これは、事前トレーニングされたマスク言語モデルの離散化アクティブ化を使用し、ニューラル オーディオ コーデックによって生成された離散コードを使用して高品質の合成を実現します。

AudioLM モデルは、録音や注釈を付けずに音声でトレーニングすると、短いプロンプトに基づいて自然で一貫した連続単語を生成することを学習でき、文法的にスムーズな連続音声を実現します。話者のアイデンティティとイントネーションを維持しながら、意味的に合理的です。

AudioLM は、音声に加えて、音楽記号のトレーニングを必要とせずに、一貫したピアノ音楽を生成することもできます。

テキストからピアノ音楽へ: 2 つの主要な問題

近年、膨大なテキスト コーパスでトレーニングされた言語モデルは、その優れた生成能力を示し、オープンな対話、機械翻訳、さらには常識さえも実現しています。推論では、自然画像などのテキスト以外の信号もモデル化できます。

AudioLM のアイデアは、言語モデリングにおけるこれらの進歩を活用して、注釈付きデータでトレーニングせずに音声を生成することです。

しかし、これには 2 つの問題に直面する必要があります。

まず、オーディオのデータ レートがはるかに高く、ユニット シーケンスが長くなります。たとえば、文には数十の文字表現が含まれていますが、音声波形に変換されると、通常は数十万の値が含まれます。

さらに、テキストと音声の間には 1 対多の関係があります。同じ文を、異なるスタイル、感情的な内容、コンテキストを持つ異なる話者が提示することができます。

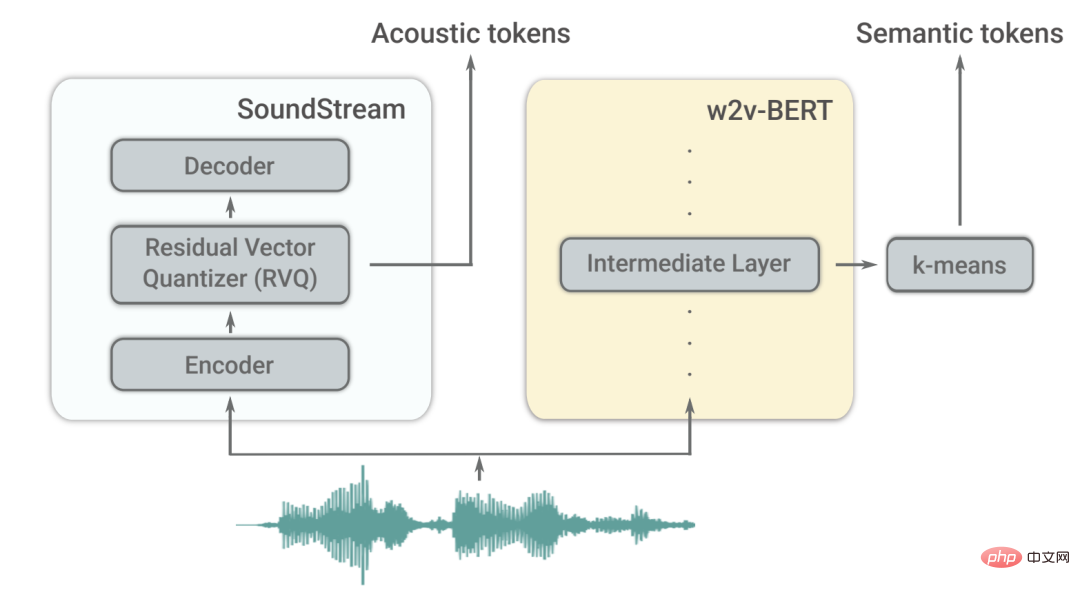

これら 2 つの課題を克服するために、AudioLM は 2 つのオーディオ タグを利用します。

まず、自己教師ありオーディオ モデルである w2v-BERT からセマンティック タグが抽出されます。

これらのタグは、ローカルな依存関係 (スピーチ内のスピーチ、ピアノ音楽のローカルメロディーなど) とグローバルな長期構造 (スピーチの言語構文と意味内容、ピアノ音楽のハーモニーとリズムなど) の両方をキャプチャします。長いシーケンスをモデル化するためにオーディオ信号を大幅にダウンサンプリングします。

ただし、これらのトークンから再構築されたオーディオの忠実度は高くありません。

音質を向上させるために、AudioLM はセマンティック タグ付けに加えて、SoundStream ニューラル コーデックによって生成された音響タグも利用して、オーディオ波形の詳細 (スピーカー特性や録音条件など) をキャプチャして高品質な合成を実現します。 。

トレーニング方法は?

AudioLM は、テキストや音楽の記号表現を一切使用せずにトレーニングされた音声のみのモデルです。

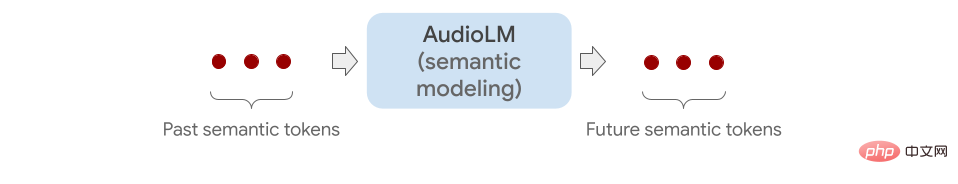

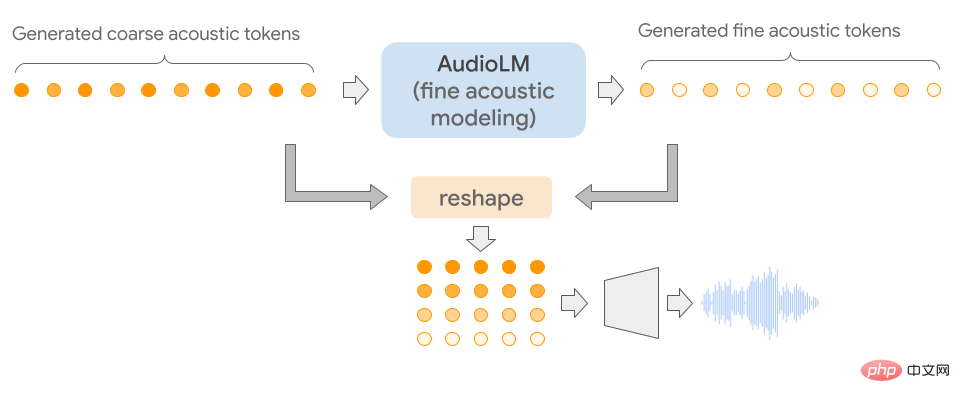

セマンティック タグ付けから細かい音響タグ付けまで、複数の Transformer モデル (ステージごとに 1 つ) をチェーンすることにより、オーディオ シーケンスを階層的にモデル化します。

各ステージは、言語モデルのトレーニングと同様に、最後のトークンに基づいて次のトークンを予測するようにトレーニングされます。

最初のステージでは、セマンティック タグに対してこのタスクを実行し、オーディオ シーケンスの高レベル構造をモデル化します。

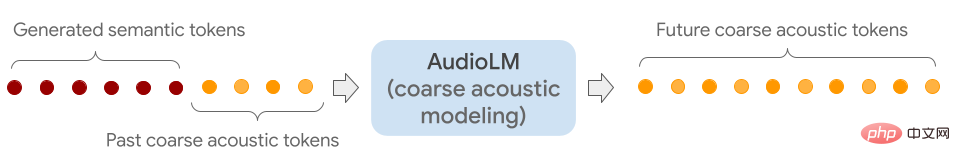

第二段階では、意味タグ列全体と過去のラフタグを結び付け、両者を条件としてラフモデルに入力し、将来のマークを予測します。 。

このステップでは、スピーカーの特性や音楽の音色などの音響特性をシミュレートします。

第 3 段階では、細かい音響モデルを使用して粗い音響信号を処理し、最終的なオーディオに詳細を追加します。

最後に、音響マーカーが SoundStream デコーダーに入力されて波形が再構築されます。

トレーニングが完了したら、AudioLM を数秒間の音声で調整して、連続音声を生成できるようになります。

AudioLM の一般的な適用性を実証するために、研究者は、異なるオーディオ分野で 2 つのタスクを通じてそれをテストしました。

1 つ目は音声継続です。このモデルは、プロンプトされた話者の特徴と韻律を保持しながら、文法的に正しく、意味的に一貫した新しいコンテンツを出力します。

2 つ目はピアノ継続で、メロディー、ハーモニー、リズムの点でキューと一致したピアノ音楽を生成します。

以下に示すように、灰色の縦線の後に聞こえるサウンドはすべて AudioLM によって生成されます。

研究者らは、有効性を検証するために、人間の評価者に短い音声クリップを聞いて、それが人間の音声のオリジナルの録音なのか、AudioLM によって生成された録音なのかを判断するよう依頼しました。

収集された評価によると、AudioLM の成功率は 51.2% であることがわかります。これは、この AI モデルによって生成された音声が通常のリスナーにとって実際の音声と区別するのが難しいことを意味します。

ノースイースタン大学で情報科学と言語科学を研究しているルパル・パテル氏は、人工知能を使用して音声を生成するこれまでの研究では、トレーニング データに明示的に注釈が付けられている場合にのみ、これらのニュアンスを捉えることができたと述べました。

対照的に、AudioLM は入力データからこれらの機能を自動的に学習し、忠実度の高い結果も実現します。

GPT3 や Bloom (テキスト生成)、DALLE や Stable Diffusion (画像生成)、RunwayML や Make-A-Video (ビデオ生成) などのマルチモーダル ML モデルの出現により、コンテンツの作成と創造性仕事は変化しています。

未来の世界は、人工知能によって生成された世界です。

参考資料:

https://www.php.cn/link/c11cb55c3d8dcc03a7ab7ab722703e0a

https ://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

https://www.php.cn/link/c5f7756d9f92a8954884ec415f79d120

https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9

以上がGoogle AIシンガーが登場! AudioLM は、数秒間聞くだけで音楽や歌を作曲できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7465

7465

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

MySQLデータベースパフォーマンス最適化ガイドリソース集約型アプリケーションでは、MySQLデータベースが重要な役割を果たし、大規模なトランザクションの管理を担当しています。ただし、アプリケーションのスケールが拡大すると、データベースパフォーマンスのボトルネックが制約になることがよくあります。この記事では、一連の効果的なMySQLパフォーマンス最適化戦略を検討して、アプリケーションが高負荷の下で効率的で応答性の高いままであることを保証します。実際のケースを組み合わせて、インデックス作成、クエリ最適化、データベース設計、キャッシュなどの詳細な主要なテクノロジーを説明します。 1.データベースアーキテクチャの設計と最適化されたデータベースアーキテクチャは、MySQLパフォーマンスの最適化の基礎です。いくつかのコア原則は次のとおりです。適切なデータ型を選択し、ニーズを満たす最小のデータ型を選択すると、ストレージスペースを節約するだけでなく、データ処理速度を向上させることもできます。