ChatGPT が突然非常に強力になったのはなぜですか?中国人医師による 10,000 ワードの長い記事が GPT-3.5 機能の起源を深く解剖

OpenAI が最近リリースした ChatGPT は、人工知能の分野に大きな衝撃を与えました。その強力な機能は、言語処理研究者の期待をはるかに超えています。

ChatGPT を経験したユーザーは当然次のような質問をします: 元の GPT 3 はどのようにして ChatGPT に進化したのですか? GPT 3.5 の驚くべき言語機能はどこから来るのでしょうか?

最近、アレン人工知能研究所の研究者は、ChatGPT の緊急能力を分析し、これらの能力の起源を追跡しようとする記事を書きました。 GPT-3.5 モデル シリーズと関連する大規模言語モデルがどのように段階的に進化して現在の強力な形式になったかを示す、包括的な技術ロードマップが示されています。

元のリンク: https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756

著者Fu Yaoは、2020年に入学したエディンバラ大学の博士課程の学生です。コロンビア大学で修士号を取得し、北京大学で学士号を取得しました。彼は現在、研究インターンとしてアレン人工知能研究所に勤務しています。彼の主な研究方向は、人間の言語の大規模な確率的生成モデルです。

著者 Peng Hao は北京大学を卒業し、学士号を取得し、ワシントン大学で博士号を取得し、現在は研究機関の若手研究者です。アレン人工知能研究所に在籍し、2023 年に卒業予定 8 月に、イリノイ大学アーバナ シャンペーン校のコンピュータ サイエンス学部に助教授として着任しました。彼の主な研究対象は、言語 AI をより効率的かつ理解しやすくすること、および大規模な言語モデルを構築することです。

著者Tushar Khotはウィスコンシン大学マディソン校を博士号を取得して卒業し、現在はアレン人工知能研究所の研究員です。彼の主な研究方向は構造化機械推論です。

1. 2020 バージョンの第一世代 GPT-3 と大規模な事前トレーニング

第一世代 GPT-3 は 3 つの重要な機能を実証しました:

- 言語生成: プロンプト単語 (プロンプト) に従って、プロンプト単語を完成させる文を生成します。これは、今日人間が言語モデルと対話する最も一般的な方法でもあります。

- コンテキスト内学習: 特定のタスクのいくつかの例に従い、新しいテスト ケースのソリューションを生成します。非常に重要な点は、GPT-3 は言語モデルであるにもかかわらず、その論文では「言語モデリング」についてほとんど言及されていないということです - 著者は執筆エネルギーのすべてを文脈学習のビジョンに費やしており、これが GPT-3 の本当の焦点です。

- 世界の知識: 事実の知識 (事実の知識) と常識 (常識) が含まれます。

では、これらの能力はどこから来たのでしょうか?

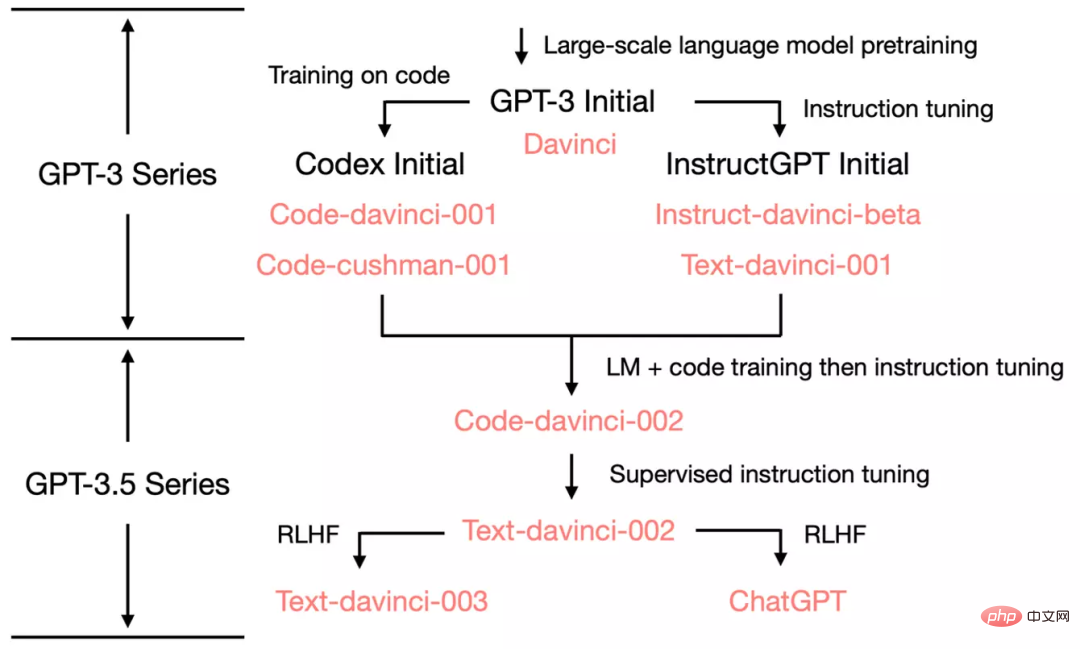

基本的に、上記の 3 つの機能は大規模な事前トレーニングから得られます。つまり、3,000 億語のコーパス (トレーニング コーパスの 60%) 上で 1,750 億個のパラメータを持つモデルを事前トレーニングします。 2016 年から 2019 年にかけて、C4 の 22% は WebText2 から来ており、16% は Books から来ており、3% は Wikipedia から来ています)。で:###### 気になるのは初代GPT-3の強さです。 実際には、オリジナルの GPT-3 (OpenAI API では davinci と呼ばれます) が「強い」のか「弱い」のかを判断するのは困難です。 一方で、特定のクエリに合理的に応答し、多くのデータセットで適切なパフォーマンスを達成します; 一方では、多くのタスクでは、T5 のような小型モデルよりもパフォーマンスが悪くなります (元の論文を参照)。 今日 (2022 年 12 月) の ChatGPT 標準では、第 1 世代の GPT-3 が「インテリジェント」であると言うのは困難です。 Meta のオープンソース OPT モデルは、オリジナルの GPT-3 を複製しようとしていますが、その機能は今日の標準とは著しく対照的です。 OPT をテストした多くの人も、現在の text-davinci-002 と比較すると、このモデルは確かに「それほど良くない」と考えています。 それにもかかわらず、OPT は、オリジナルの GPT-3 を近似したオープンソースとして十分に優れたものである可能性があります (OPT の論文とスタンフォード大学の HELM 評価によると)。 第一世代 GPT-3 は一見弱いように見えますが、その後の実験により、第一世代 GPT-3 には非常に強力な可能性があることが証明されました。これらの可能性は、後にコード トレーニング、命令チューニング、ヒューマン フィードバックによる強化学習 (RLHF) によって解き放たれ、最終的な本体は非常に強力な創発機能を実証しました。 OpenAI がどのように発展したかを示すために、オリジナルの GPT-3 から始めます。 ChatGPT を見てみましょう GPT-3.5 の進化ツリーを見てみましょう: 2020 年 7 月に、OpenAI は davinci の第一世代 GPT をリリースしました。 -3紙のモデルインデックスを搭載して以来、進化を続けています。 2021 年 7 月に、Codex 論文がリリースされました。この論文では、初期の Codex が (おそらく内部の) 120 億パラメータの GPT-3 バリアントに基づいて微調整されました。この 120 億パラメータ モデルは、後に OpenAI API の code-cushman-001 に進化しました。 2022 年 3 月に、OpenAI は命令チューニングに関する論文をリリースしました。その教師あり命令チューニング部分は、davinci-instruct-beta および text-davinci-001 に対応します。 2022 年 4 月から 7 月にかけて、OpenAI は Code-davinci-002 モデル (Codex とも呼ばれる) のベータ テストを開始しました。次に、code-davinci-002、text-davinci-003、および ChatGPT はすべて、code-davinci-002 からの命令を微調整することによって取得されます。詳細については、OpenAI のモデル インデックスのドキュメントを参照してください。 Codex はコードのみのモデルのように聞こえますが、code-davinci-002 はおそらく自然言語にとって最も強力な GPT-3.5 バリアントです (text-davinci-002 および -003 よりも優れています)。 )。 code-davinci-002 はテキストとコードの両方でトレーニングされ、指示 (以下で説明) に基づいて適応された可能性があります。 次に、2022 年 5 月から 6 月にリリースされた text-davinci-002 は、code-davinci-002 に基づいた教師あり命令調整モデルです。 text-davinci-002 の命令を微調整すると、モデルのコンテキスト学習能力は低下する可能性がありますが、モデルのゼロショット能力は強化されます (後述)。 次に、2022 年 11 月にリリースされた text-davinci-003 と ChatGPT があり、これらはヒューマン フィードバックに基づく強化学習 (ヒューマン フィードバックからの強化学習による命令チューニング) モデルのバージョンです。2 つの異なるバリエーションです。 text-davinci-003 は、text-davinci-002 で失われた部分的なコンテキスト学習機能の一部を復元します (ただし、それでも code-davinci-002 より劣ります)。 (微調整中に言語モデリングが混合されました)、ゼロサンプル機能がさらに改善されました (RLHF のおかげで)。一方、ChatGPT は、会話履歴をモデル化する機能のために、ほぼすべてのコンテキスト学習機能を犠牲にしているようです。 全体として、code-davinci-002 より前の 2020 年から 2021 年にかけて、OpenAI はコード トレーニングと命令の微調整を通じて GPT-3 を強化することに多大な労力を投資してきました。 code-davinci-002 が完成するまでに、すべての機能がすでに備わっていました。その後の命令の微調整では、教師ありバージョンまたは強化学習バージョンのどちらを使用しても、次のことが行われる可能性があります (これについては後で詳しく説明します): code-davinci- 002 text-davinci-002 より前には、davinci-instruct-beta と text-davinci-001 という 2 つの中間モデルがありました。どちらも上記の 2-002 モデルよりも多くの点で劣っています (たとえば、text-davinci-001 の連鎖思考推論能力は強力ではありません)。 そこで、このセクションでは -002 モデルに焦点を当てます。 code-davinci-002 と text-davinci-002、この 2 つに焦点を当てます。兄弟は GPT3.5 モデルの最初のバージョンで、1 つはコード用、もう 1 つはテキスト用です。これらは、元の GPT-3 とは異なる 3 つの重要な機能を備えています: これらの能力はどこから来たのでしょうか? 以前のモデルと比較した場合、主な違いは命令の微調整とコード トレーニングの 2 つです。具体的には: ###### 細部の違いにも注意してください: 具体的には: 上記の 3 つの能力はオリジナルの GPT-3 にすでに存在しており、指示とコード トレーニングを通じてのみトリガー/ロック解除されますか?それとも、これらの機能はオリジナルの GPT-3 には存在せず、命令とコードのトレーニングによって導入されたのでしょうか? ただし、code-davinci-002 はオリジナルの GPT-3 davinci に基づいておらず、オリジナルの GPT-3 よりも大きなモデルに基づいている可能性があります。この場合、OPT を調整しても再現できない可能性があります。 研究コミュニティは、OpenAI が code-davinci-002 のベース モデルとしてどのような種類のモデルをトレーニングしたのかをさらに明確にする必要があります。 次の仮説と証拠があります: は現在段階中 (2022 年 12 月)、 text-davinci-002、text-davinci-003、ChatGPT の間には厳密な統計的比較はほとんどありません。主な理由は次のとおりです。 最初に、text-davinci-002、text-davinci-003、ChatGPT 間の次の比較に注目します。

それでは、RLHF トリガーの機能を見てみましょう: 注目に値する 2 つの点があります: 舞台裏で何が起こっているのか: これまでのところ、私たちは GPT-3.5 で登場したすべての機能を注意深く検討してきました。次の表は、進化の経路をまとめたものです: 結論は次のとおりです: このブログ投稿では、GPT-3.5 シリーズのさまざまな機能を注意深く調査し、そのすべての新機能の起源を追跡しました。能力のソース。 元の GPT-3 モデルは、事前トレーニングを通じて生成機能、世界の知識、コンテキスト内学習を獲得しました。その後、命令チューニングのモデル ブランチを通じて、命令に従い、目に見えないタスクに一般化する能力を獲得しました。コードによってトレーニングされたブランチ モデルはコードを理解する能力を獲得し、コード トレーニングの副産物として、モデルは潜在的に複雑な推論を実行する能力も獲得します。 これら 2 つのブランチを組み合わせると、code-davinci-002 は、すべての優れた機能を備えた最強の GPT-3.5 モデルのように見えます。次に、教師あり命令チューニングと RLHF を通じて、人間による調整、つまり調整税と引き換えにモデルの機能が犠牲になります。 RLHF を使用すると、モデルは知識範囲外の質問を拒否しながら、より有益で偏りのない回答を生成できます。 この記事が GPT 評価の明確な全体像を提供し、言語モデル、命令チューニング、コード チューニングに関する議論のきっかけになれば幸いです。最も重要なことは、この記事がオープンソース コミュニティ内で GPT-3.5 を再現するためのロードマップとして機能することを願っています。

2. GPT-3 の 2020 バージョンから ChatGPT の 2022 バージョンへ

多くの論文では、code-davinci-002 がベンチマークで最高のパフォーマンスを達成すると報告しています (ただし、モデルは必ずしも人間の期待と一致するとは限りません)。 code-davinci-002 の命令を微調整した後、モデルは、次のような、人間の期待により沿った (またはモデルが人間と一致した) フィードバックを生成できます。 ゼロサンプルの質問と回答、安全で公平なメッセージの生成対話応答、およびモデルの知識の範囲を超えた拒否が問題です。

3. Code-Davinci-002 と Text-Davinci-002、コードをトレーニングし、命令を微調整します

3.1 複雑な推論能力と新しいタスクに一般化する能力の源

##Code-davinci- 002 基本モデル text-davinci-002 は、命令微調整 code-davinci-002 の成果です (OpenAI ドキュメントを参照)。これは、次のデータに基づいて微調整されます: (1) 人間が注釈を付けた指示と期待される出力、(2) 人間のアノテーターが選択したモデル出力。

001 モデルは主に純粋なコード/純粋なテキスト タスク用です。002 モデルは、コード トレーニングと命令の微調整、コードと任意の機能を深く統合します。テキストで十分です。

この段階で、命令の微調整とコード トレーニングの重要な役割を特定しました。重要な問題は、コードのトレーニングと命令の微調整の影響をさらに分析する方法です。

4. text-davinci-003 と ChatGPT、ヒューマン フィードバックからの強化学習 (RLHF) の力

#text-davinci-003 と ChatGPT が以下より小さい執筆時点で生後1か月。

したがって、これらのモデル間の比較は、研究コミュニティの集合的な経験に基づいています (統計的にはそれほど厳密ではありません)。しかし、私たちは、予備的な記述的比較によってモデルのメカニズムを解明できると信じています。 3 つすべてモデルはコマンドに応じて微調整されています。

これは、ほとんどの新しいモデルの動作が RLHF の影響によるものであることを意味します。

5. 現段階での GPT-3.5 の進化プロセスの概要

# モデルの会話履歴。

GPT-3.5 は自然言語処理研究における重要なステップですが、すべてが完全に含まれているわけではありません。多くの研究者 (AI2 を含む) によって想定されている望ましい特性。 GPT-3.5 にはない重要なプロパティをいくつか以下に示します:

7. 結論

FAQ

以上がChatGPT が突然非常に強力になったのはなぜですか?中国人医師による 10,000 ワードの長い記事が GPT-3.5 機能の起源を深く解剖の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7554

7554

15

15

1382

1382

52

52

83

83

11

11

24

24

96

96

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPT と Python を使用してユーザー意図認識機能を実装する方法 はじめに: 今日のデジタル時代において、人工知能技術はさまざまな分野で徐々に不可欠な部分になりました。その中で、自然言語処理 (Natural Language Processing、NLP) テクノロジーの開発により、機械が人間の言語を理解して処理できるようになります。 ChatGPT (Chat-GeneratingPretrainedTransformer) は、

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

ChatGPT と Java を使用して AI ベースの音声アシスタントを開発する方法

Oct 27, 2023 pm 06:09 PM

ChatGPT と Java を使用して AI ベースの音声アシスタントを開発する方法

Oct 27, 2023 pm 06:09 PM

ChatGPT と Java を使用して人工知能ベースの音声アシスタントを開発する方法 人工知能 (Artificial Intelligence、略して AI) の急速な発展により、さまざまな分野が参入しており、その中でも音声アシスタントは人気のあるアプリケーションの 1 つです。この記事では、ChatGPT と Java を使用して人工知能ベースの音声アシスタントを開発する方法を紹介します。 ChatGPT は、AI 研究機関である OpenAI によって開発された、自然言語による対話のためのオープンソース プロジェクトです。