Meta のオープンソース ChatGPT の代替品は使いやすいですか?テスト結果と修正方法を公開、2日で5.2kスター

ChatGPT の継続的な人気により、大手テクノロジー企業は長い間休むことができませんでした。

つい先週、Meta は新しい大規模モデル シリーズを「オープンソース」化しました—— LLaMA (Large Language Model Meta AI)、パラメータの数は 70 億から 650 億の範囲に及びます。 LLaMA は、これまでにリリースされた多くの大型モデルよりもパラメータが少ないものの、パフォーマンスが優れているため、リリース時には多くの研究者が興奮しました。

たとえば、130 億パラメータの LLaMA モデルは、「ほとんどのベンチマークで」1750 億パラメータの GPT-3 を上回るパフォーマンスを示し、単一の V100 GPU で実行できます。65 個のパラメータを備えた最大の LLaMA モデルです。 10 億のパラメータは、Google の Chinchilla-70B や PaLM-540B に匹敵します。

パラメータの数が減るのは一般の研究者や営利団体にとっては良いことですが、LLaMA は本当に論文どおりのパフォーマンスを発揮するのでしょうか?現在の ChatGPT と比較すると、LLaMA はかろうじて競合できるでしょうか?これらの質問に答えるために、一部の研究者はこのモデルをテストしました。

一部の企業はすでに LLaMA の欠点を補おうとしており、RLHF などのトレーニング方法を追加することで LLaMA のパフォーマンスを向上させることができるかどうかを確認したいと考えています。

LLaMA 予備レビュー

このレビューは @En Ryu という名前の Medium 著者からのものです。ここでは、ジョーク解釈、ゼロショット分類、コード生成という 3 つの困難なタスクにおける LLaMA と ChatGPT のパフォーマンスを比較しています。関連するブログ記事は「ミニ投稿:LLaMA初見」です。

作者は、RTX 3090/RTX 4090 で LLaMA 7B/13B バージョンを実行し、単一の A100 で 33B バージョンを実行しています。

ChatGPT とは異なり、他のモデルは命令の微調整に基づいていないため、プロンプトの構造が異なることに注意してください。

ジョークの説明

これは、Google のオリジナルの PaLM 論文に示されている使用例です。なぜ面白いのかを説明するモデル。このミッションには世界の知識と基本的なロジックの組み合わせが必要です。 PaLM より前のすべてのモデルではこれができませんでした。著者らは、PaLM の論文からいくつかの例を抽出し、LLaMA-7B、LLaMA-13B、LLaMA-33B のパフォーマンスを ChatGPT と比較しました。

#ご覧のとおり、結果はひどいものです。これらのモデルは笑いを誘いますが、実際には理解していません。関連するテキストのストリームをランダムに生成しているだけです。 ChatGPT のパフォーマンスは LLaMA-33B と同じくらい悪いですが (他のいくつかのモデルはさらに悪い)、別の戦略に従っています。つまり、大量のテキストを生成し、その答えの少なくとも一部が正しいことを期待しています (しかし、それらのほとんどは明らかに No です)。 、それは試験中に質問に答えるためのみんなの戦略と非常に似ていますか?

しかし、ChatGPT は少なくとも Schmidthuber に関するジョークを理解しました。しかし、全体として、ゼロサンプルのジョーク解釈タスクにおけるこれらのモデルのパフォーマンスは、PaLM からは程遠いです (PaLM の例が慎重に選択されていない限り)。

ゼロサンプル分類

著者が検討した 2 番目のタスクは、より困難です - クリックベイト)分類です。クリックベイトが何であるかについては人間ですら同意できないため、著者はプロンプトでこれらのモデルの例をいくつか提供しています (つまり、サンプルがゼロではなく、実際にはサンプルが少ないです)。以下は LLaMa のプロンプトです:

I will tell whether the following news titles are clickbait: 1) The WORST care homes in England: Interactive map reveals the lowest-rated 2,530 residences - so is there one near you? Clickbait: yes 2) Netflix's top 10 most-watched movies of all time Clickbait: yes 3) Peering Through the Fog of Inflation Clickbait: no 4) You’ll never believe which TV cook this cheeky chap grew up to be Clickbait: yes

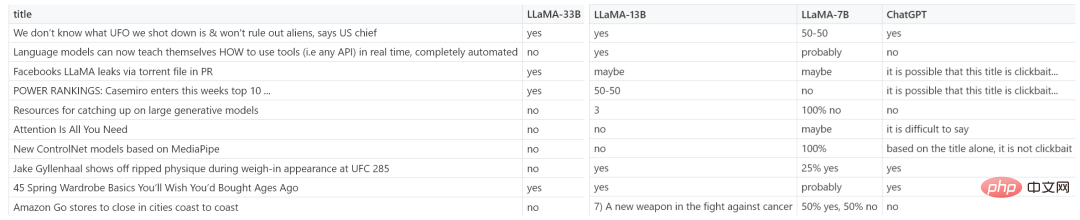

下の図は、LLaMA-7B、LLaMA-13B、LLaMA-33B、および ChatGPT の結果の例を示しています。

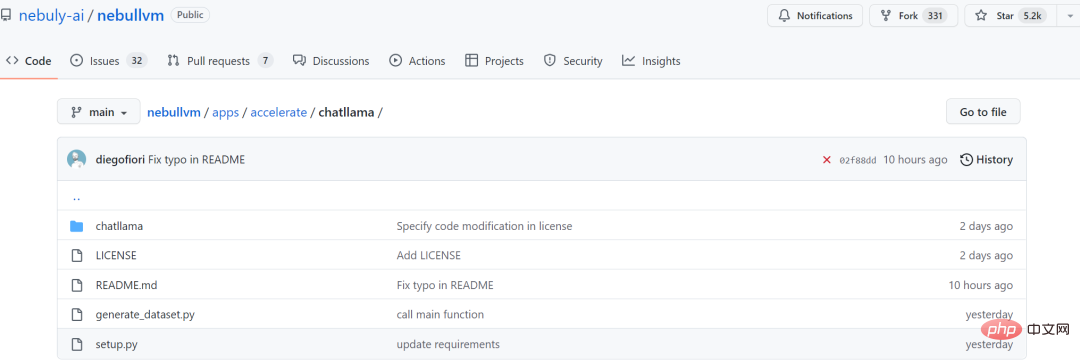

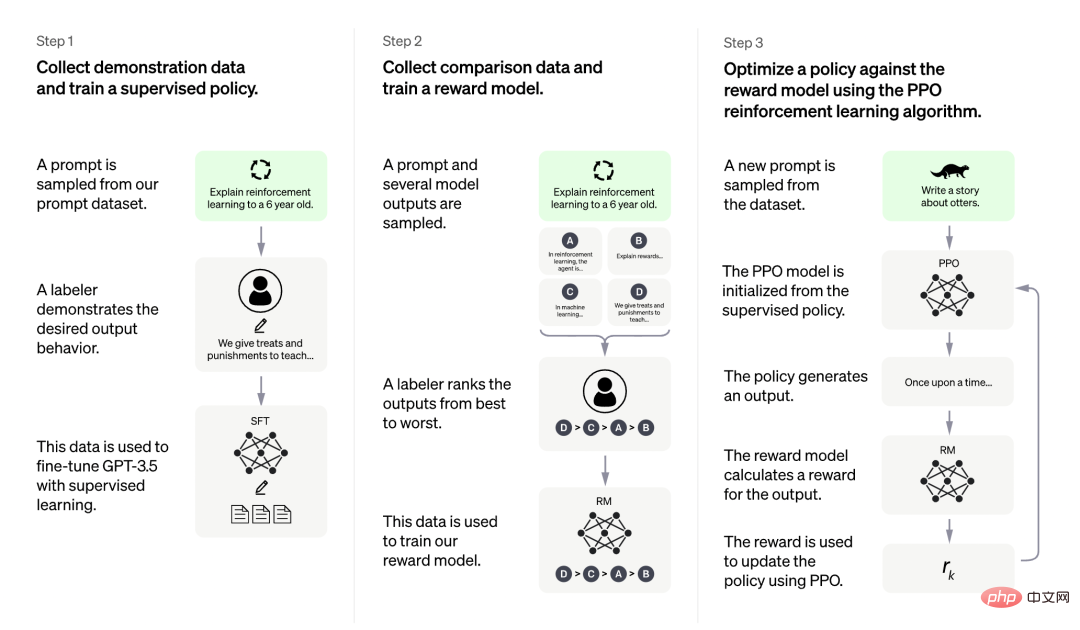

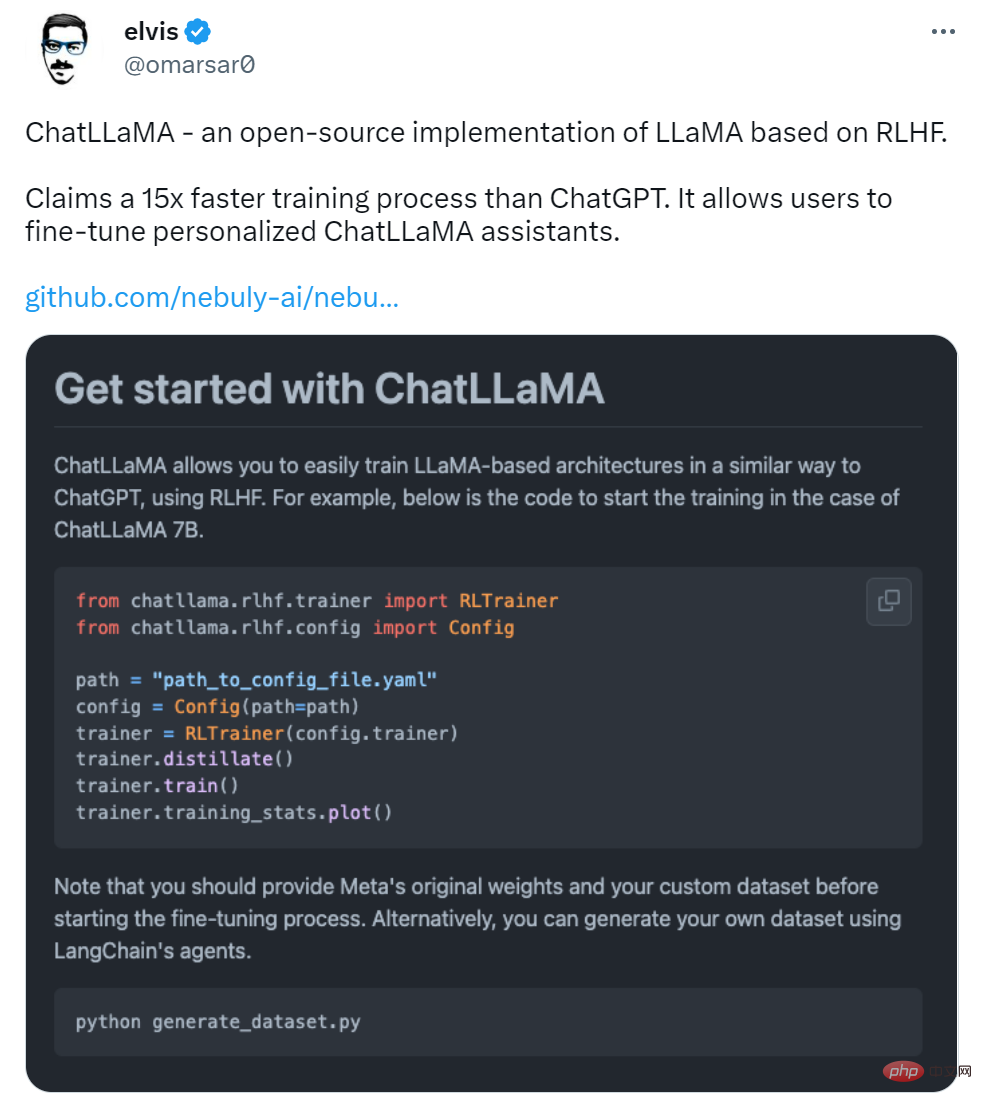

很明显,赢家为 LLaMA-33B,它是唯一一个能够遵循所有请求格式(yes/no)的模型,并且预测合理。ChatGPT 也还可以,但有些预测不太合理,格式也有错误。较小的模型(7B/13B)不适用于该任务。 代码生成 虽然 LLM 擅长人文学科,但在 STEM 学科上表现糟糕。LLaMA 虽然有基准测试结果,但作者在代码生成领域尝试了一些特别的东西,即将人类语言零样本地转换为 SQL 查询。这并不是很实用,在现实生活中直接编写查询会更有效率。这里只作为代码生成任务的一个示例。 在 prompt 中,作者提供表模式(table schema)以及想要实现的目标,要求模型给出 SQL 查询。如下为一些随机示例,老实说,ChatGPT 看起来效果更好。 从测试结果来看,LLaMA 在一些任务上表现还不错,但在另一些任务上和 ChatGPT 还有一些差距。如果能像 ChatGPT 一样加入一些「训练秘籍」,效果会不会大幅提升? 虽然 LLaMA 发布之初就得到众多研究者的青睐,但是少了 RLHF 的加持,从上述评测结果来看,还是差点意思。 在 LLaMA 发布三天后,初创公司 Nebuly AI 开源了 RLHF 版 LLaMA(ChatLLaMA)的训练方法。它的训练过程类似 ChatGPT,该项目允许基于预训练的 LLaMA 模型构建 ChatGPT 形式的服务。项目上线刚刚 2 天,狂揽 5.2K 星。 项目地址:https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama ChatLLaMA 训练过程算法实现主打比 ChatGPT 训练更快、更便宜,我们可以从以下四点得到验证:

-- We have a table `events` with columns `event_id`, `timestamp`, `user_id`, `rpc_method`.

-- We want to count how many users issued request "Login" over the last week.

-- SQL query for this is:

-- 7b

SELECT count (*)

FROM events

WHERE user_id IN (SELECT user_id

FROM events

WHERE timestamp >= NOW () - INTERVAL 7 DAY)

AND rpc_method = 'Login';

-- 13b

SELECT COUNT (*) FROM events WHERE rpc_method = "Login"

AND UNIX_TIMESTAMP (timestamp) >= UNIX_TIMESTAMP (CURRENT_DATE - INTERVAL 7 DAY)

-- 33b

SELECT user_id,

COUNT (DISTINCT user_id) AS total

FROM events

WHERE timestamp BETWEEN TIMESTAMP '2013-08-14 00:00:00' AND TIMESTAMP '2013-08-21 00:00:00'

AND rpc_method = 'Login'

GROUP BY user_id

-- ChatGPT

SELECT COUNT (DISTINCT user_id)

FROM events

WHERE rpc_method = 'Login'

AND timestamp >= DATE_SUB (NOW (), INTERVAL 1 WEEK);

加入 RLHF,初创公司 Nebuly AI 开源 ChatLLaMA 训练方法

图源:https://openai.com/blog/chatgpt

更是有研究者表示,ChatLLaMA 比 ChatGPT 训练速度最高快 15 倍。

不过有人对这一说法提出质疑,认为该项目没有给出准确的衡量标准。

项目刚刚上线 2 天,还处于早期阶段,用户可以通过以下添加项进一步扩展:

- 带有微调权重的 Checkpoint;

- 用于快速推理的优化技术;

- 支持将模型打包到有效的部署框架中。

Nebuly AI 希望更多人加入进来,创造更高效和开放的 ChatGPT 类助手。

该如何使用呢?首先是使用 pip 安装软件包:

pip install chatllama-py

然后是克隆 LLaMA 模型:

git clone https://github.com/facebookresearch/llama.gitcd llama pip install -r requirements.txt pip install -e .

一切准备就绪后,就可以运行了,项目中介绍了 ChatLLaMA 7B 的训练示例,感兴趣的小伙伴可以查看原项目。

以上がMeta のオープンソース ChatGPT の代替品は使いやすいですか?テスト結果と修正方法を公開、2日で5.2kスターの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7496

7496

15

15

1377

1377

52

52

77

77

11

11

19

19

52

52

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません