CNNに基づく新語発見アルゴリズム

著者 | Ctrip のシニア R&D マネージャーである mczhao は、自然言語処理テクノロジーの分野に注力しています。

概要

消費者向けホットスポットや新しいインターネット有名人のミームが継続的に出現する中、電子商取引プラットフォームの NLP タスクでは、今まで見たことのない単語がいくつか出てきます。これらの単語はシステムの既存の語彙に含まれていないため、「未登録単語」と呼ばれます。

一方で、語彙集内の単語の不足は、語彙集に基づく一部の単語セグメンターの単語分割の品質に影響を及ぼし、間接的にテキストの想起とハイライト プロンプトの品質に影響を与えます。つまり、ユーザーテキストの検索精度と検索結果の解釈可能性です。

一方、主流のNLP深層学習アルゴリズムであるBERT/Transformerなどでは、中国語を処理する際に単語ベクトルの代わりに単語ベクトルが使用されることが多いです。理論的には、単語ベクトルを使用した方が効果が高いはずですが、未登録の単語があるため、実際には単語ベクトルを使用した方が効果が高くなります。語彙がより完全であれば、単語ベクトルを使用するよりも単語ベクトルを使用する効果が高くなります。

要約すると、新語の発見は現時点で解決しなければならない問題です。

1. 従来の教師なし手法

業界では、中国語の新語発見というこの問題に対して、比較的成熟した解決策が存在します。入力はコーパスであり、これらのテキストを NGram にセグメント化した後、候補セグメントが生成されます。これらの断片の統計的特徴を計算し、これらの特徴に基づいてこの断片が単語であるかどうかを判断します。

業界の主流のアプローチは、人気、結束力、左右隣接キャラクターの豊富さの 3 つの側面の指標を数えて観察することです。これら 3 つの指標について説明した記事はインターネット上に多数ありますので、ここでは簡単に紹介しますが、詳細については、Hello NLP と Smooth NLP の 2 つの新語発見記事を参照してください。

1.1 人気度

人気度を表現するには単語の頻度を使用します。すべてのコーパス内のすべての断片の出現回数をカウントすると、それらの高頻度断片は多くの場合 1 つの単語になります。

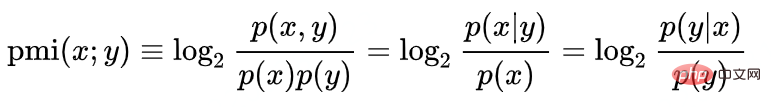

#1.2 凝集度 点相互情報量を使用して凝集度を測定します:

#たとえば、Han Ting が単語であるかどうかを判断します、log(P("Han Ting")/P("Han")P("Ting"))。 Hanting が単語になる確率は、「Hanting」の人気に正比例し、「Han」と「ting」という単語の人気に反比例します。これは理解するのが簡単です。たとえば、漢字で最も一般的な単語は「的」です。どの漢字でも「的」と一致する確率は非常に高くなりますが、「x の」または「的 x」を意味するわけではありません。 「」も同じ単語です。ここでは、「的」という単一単語の人気が抑制的な役割を果たしています。

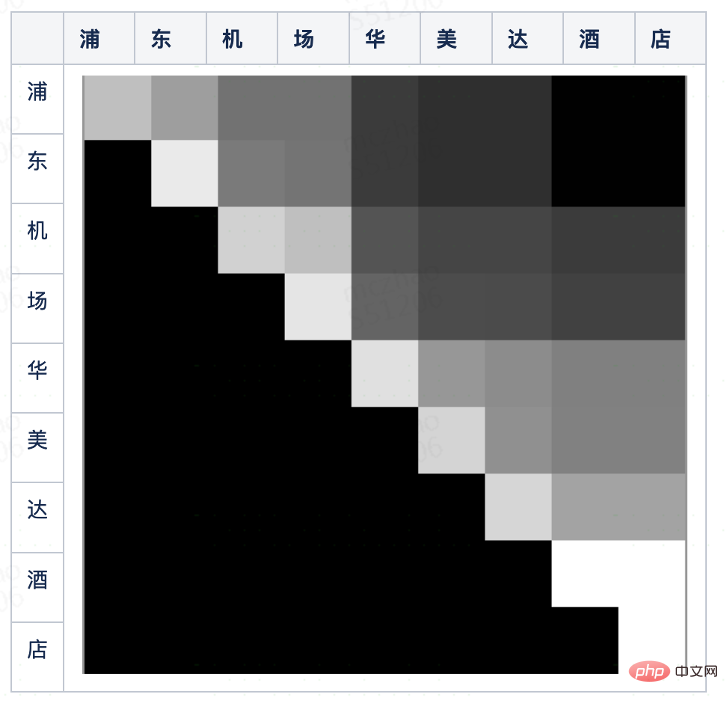

1.3 左右の隣接文字の豊富さ

左右の隣接エントロピーは、左右の文字の豊富さを表します。左右の隣接エントロピーは、候補単語断片の左側または右側に出現する単語の分布のランダム性です。左側のエントロピーと右側のエントロピーを分離することも、2 つのエントロピーを 1 つのインジケーターに結合することもできます。

たとえば、セグメント「シャングリラ」は熱量と凝集度が非常に高く、そのサブセグメントに対応します。セグメント「Shangri-La」 「Gri」の人気と凝集性も非常に高いですが、「Shangri」の後に「La」という単語が現れることが多いため、その右隣のエントロピーが非常に低く、単語形成が阻害されます。 「シャングリ」は別の単語ではありえないと判断できます。

2. 従来の方法の制限

従来の方法の問題は、しきい値パラメーターを手動で設定する必要があることです。 NLPの専門家は、現在のコーパスの断片の確率分布を理解した上で、これらの指標を数式で組み合わせたり、単独で使用したりして、判定基準となる閾値を設定し、それを用いた判定結果も高い精度を実現します。

ただし、確率分布や単語の頻度は静的ではなく、コーパスがますます豊富になるにつれて、またはコーパスの重み付けされた人気度 (通常は対応する製品の人気度) が変動するため、専門家は、 set 式のパラメータとしきい値も常に調整する必要があります。これは多くの人的資源を無駄にし、人工知能エンジニアを単なる調整者に変えてしまいます。

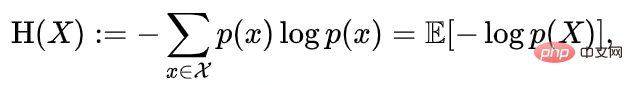

#3. 深層学習に基づく新語発見 3.1 単語頻度確率分布図 業界における上記のアルゴリズムの 3 つの指標には、単語頻度という基本的なソース機能が 1 つだけあります。統計手法では、通常、いくつかの単純で重要な統計がヒストグラムや箱ひげ図などの図の形で表示されます。モデルの介入がなくても、人々はそれらを見るだけで一目で正しい判断を下すことができます。裁判官。コーパスを制限された長さのすべての断片に切り取り、断片の単語頻度を 0 ~ 255 に正規化し、2 次元行列にマッピングできます。行は開始文字を表し、列は終了文字を表します。1 ピクセルは断片、ピクセル点の明るさは候補単語断片の人気度です。

上の写真は「浦東空港ラマダホテル」という短文の単語出現頻度確率分布図です。肉眼でそれを確認できてとても驚きました。 「浦東」、「浦東空港」、「空港」、「ラマダ ホテル」など、明るい直角二等辺三角形のブロックを大まかに分離できます。これらのブロックは、対応するフラグメントが必要な単語であることを判断できます。

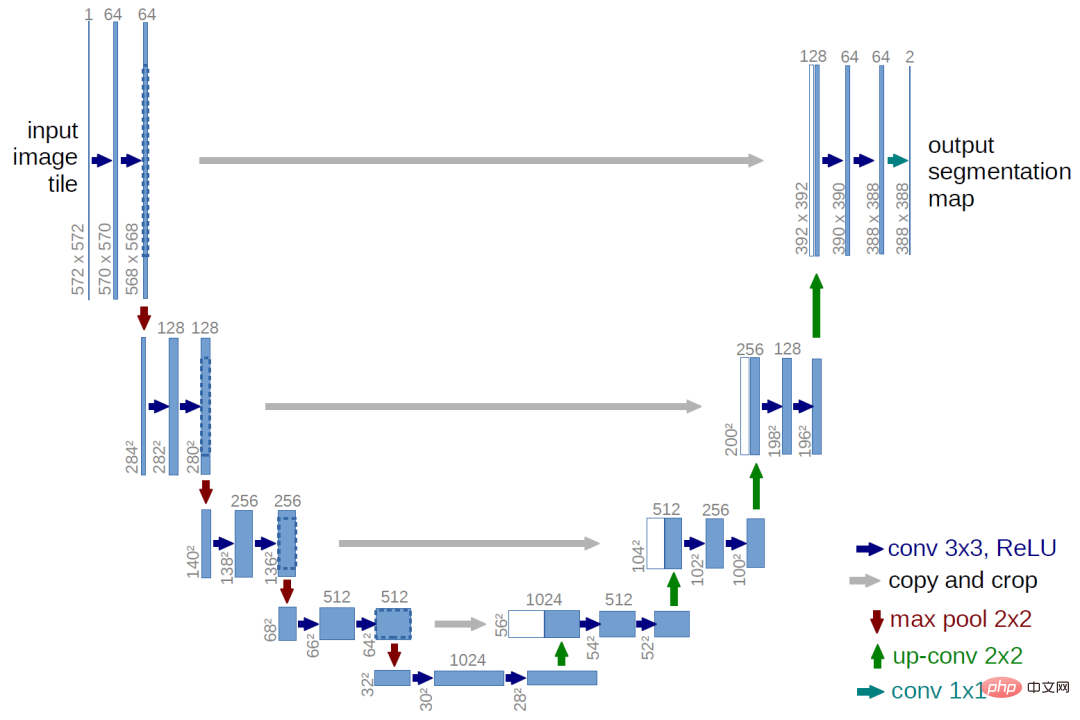

3.2 古典的な画像セグメンテーション アルゴリズム

単語頻度確率分布マップを観察することで、短文セグメンテーション問題を画像セグメンテーションに変換できます。問題 。初期の画像セグメンテーション アルゴリズムは、上記の新語発見アルゴリズムに似ています。エッジのグレースケールの変化を検出するためのしきい値ベースのアルゴリズムでもあります。テクノロジーの発展に伴い、現在では深層学習アルゴリズムが一般的に使用されており、より有名なものはU-Net 画像セグメンテーション アルゴリズム。

U-Net の前半では、畳み込みダウンサンプリングを使用して、異なる粒度で複数の層の特徴を抽出します。アップサンプリングにより、これらの特徴は同じ解像度で連結され、最終的に完全接続層 Softmax を通じてピクセルレベルの分類結果が取得されます。

3.3 畳み込みネットワークに基づく新語発見アルゴリズム

単語頻度確率分布マップの分割は、グラフの分割と似ています。これらはすべて、位置が隣接し、同様のグレー レベルを持つパーツを切り出します。したがって、短い文を分割するには、画像分割アルゴリズムを参照し、完全な畳み込みネットワークを使用することもできます。畳み込みを使用する理由は、短い文章でも画像でも、局所的な情報、つまり最先端に近いピクセルに注目するためです。多層ネットワークを使用する理由は、多層プーリングにより異なる層の地物のしきい値判定を示すことができるためです。たとえば、地図の地形を切り取るとき、傾き (一次微分/差分) だけでなく、傾きの変化(二次)、導関数/差分)、2 つはそれぞれしきい値処理され、組み合わせ方法は単純な線形重み付けではなく、シリアル ネットワークです。

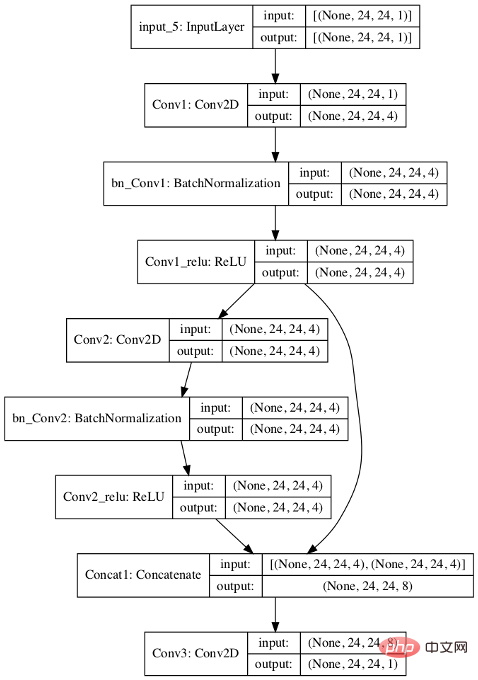

新しい単語の発見シナリオでは、次のアルゴリズムを設計します。

- まず、短編の単語頻度分布マップを埋めます。 0 ~ 24x24 の文;

- 最初に 2 つの 3x3 畳み込み層があり、4 つのチャネルを出力します;

- 2 つの畳み込み層を連結し、別の 3x3 畳み込みを実行して、単一のチャネルを出力します ;

- 損失関数は logistic=T を使用するため、最後の層はソフトマックス出力なしで分類に使用できます。

#U-Net と比較すると、次の違いがあります:

1) ダウンサンプリングとアップサンプリングが廃止されました。その理由は、一般的にセグメンテーションに使用される短文は比較的短く、単語頻度分布図の解像度も高くないため、モデルも簡素化されています。

2) U-Net は 3 つのカテゴリ (ブロック 1、ブロック 2、エッジ上) ですが、このアルゴリズムでは 2 つのカテゴリ (ピクセルが単語かどうか) のみが必要です。 U-Net はいくつかの連続したブロックと分割線を出力し、ある点が正であるかどうかだけを必要とします。

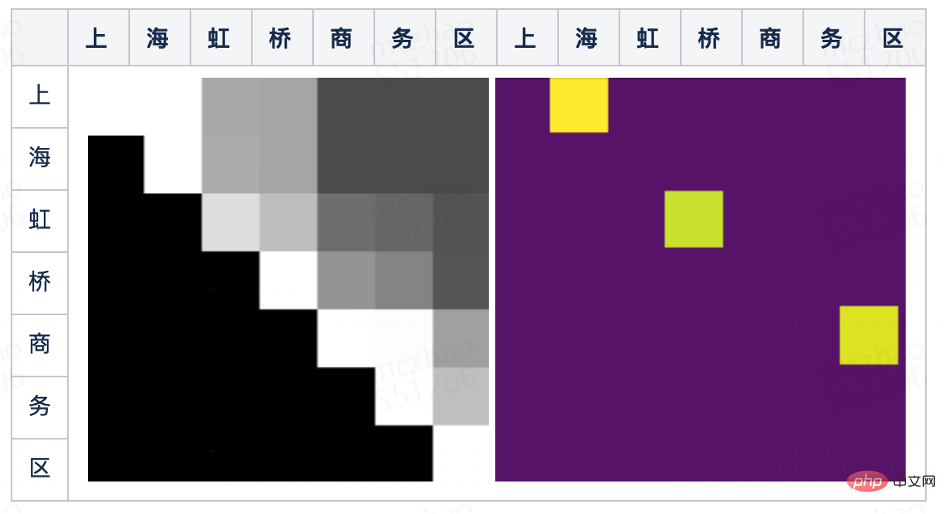

#下の図は、モデルのトレーニング後にモデルによって予測された結果を示しています。出力結果では、「上海」(上段と海の列)、「虹橋」、「ビジネス地区」の 3 つの単語に対応するピクセルが特定されたことがわかります。

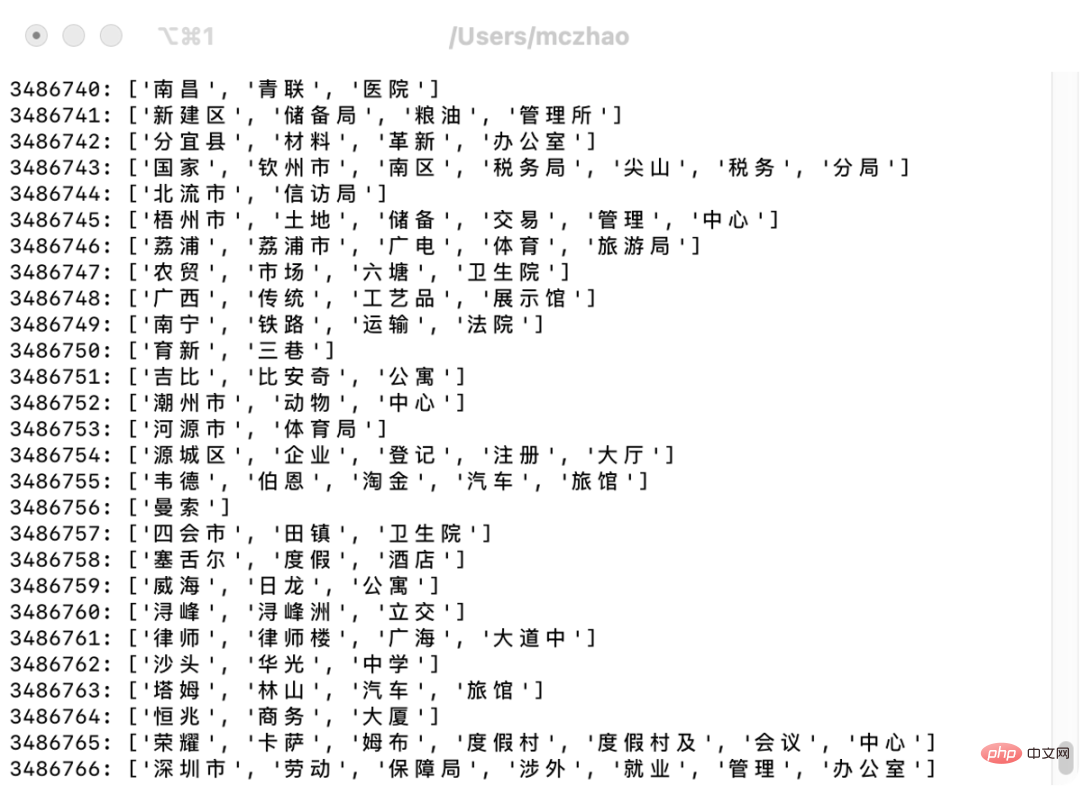

トレーニングされたモデルを使用し、Ctrip のランドマーク ライブラリにランドマーク名を入力すると、自動的にセグメント化され、いくつかの新しい単語を発見できます, 以下に示すように、一部悪いケースもありますが、全体的な精度は良好です。

これらの単語を辞書にインポートすると、検索語のセグメント化の精度が向上し、その単語の辞書の範囲が広がります。セグメンテーションの結果が向上します。検索語のセグメント化は一般に過剰に想起し、想起漏れを排除する傾向があるため、業界では単語のセグメント化による想起に対するより抜本的なアプローチを採用しており、精度は通常、その後の並べ替えによって解決されます。したがって、単語の分割の精度は向上しましたが、ユーザーの目から見ると、検索結果の精度はそれほど向上していません。ただし、単語の分割エラーによって引き起こされる不適切な強調表示の問題の一部は解決できます。

4. モデルの内部分析

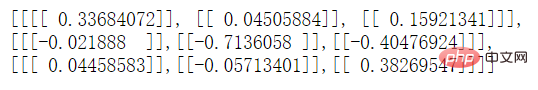

モデルがどのように機能するかを調べたい場合は、中間層の畳み込みカーネルを表示できます。まず、モデルの畳み込み層の畳み込みカーネルの数を 4 から 1 に単純化します。トレーニング後、TensorFlow の API:model.get_layer('Conv2').__dict__ を介して中間層を表示します。 Conv2 層のコンボリューション カーネルは次のとおりであることがわかりました。

最初の効果と 1 番目の効果、モデルの 2 番目の行です。効果は逆です。ピクセルに対応する前の行から、現在の行の差 (重み付き) を引いたものです。グレースケールの差が大きい場合、このピクセルによって表される文字列は、言葉。

1 行目と 2 列目の絶対値 0.04505884 が比較的小さいこともわかります。これは、最初の行の前方パラメータから 2 行目と 2 行目を引いた値である可能性があります。 3 番目の列から 2 番目の負の列を引いた値が互いに打ち消し合います。

5. 最適化空間

この記事では、非常に単純な構造を持つ完全な畳み込みネットワーク モデルについて説明しますが、まだ多くの余地があります。改善のためです。

まず、機能の選択範囲を拡大します。 たとえば、この記事の入力特徴には単語頻度のみが含まれていますが、左右の隣接エントロピーも入力特徴に含まれている場合、セグメンテーション効果はより正確になります。

2 つ目は、ネットワークの深さを増やすことです。 モデル分析を通じて、畳み込みの最初の層は主に 0 で満たされたピクセルによって生成されるケースを処理することであることがわかりました。実際に実際の熱に焦点を当てている畳み込みの層は 1 つだけです。3x3 畳み込みの場合一次差分の結果については、現在のピクセルの前後 2 行目と 2 列目は考慮されません。コンボリューション カーネル サイズを適切に拡張したり、ネットワークを深くしたりして、モデルの視野を大きくすることができます。しかし、ネットワークを深くすると、過剰適合の問題も生じます。

最後に、このモデルは語彙を補足して単語分割効果を向上させるために使用できるだけでなく、候補単語の想起や単語分割の参照として直接使用することもできます。単語分割プロセスにおける単語分割パス スコアリングこのモデルの予測結果は、両方のステップに適用できます。

以上がCNNに基づく新語発見アルゴリズムの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1653

1653

14

14

1413

1413

52

52

1305

1305

25

25

1251

1251

29

29

1224

1224

24

24

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

上記および筆者の個人的な理解: 現在、自動運転システム全体において、認識モジュールが重要な役割を果たしている。道路を走行する自動運転車は、認識モジュールを通じてのみ正確な認識結果を得ることができる。下流の規制および制御モジュール自動運転システムでは、タイムリーかつ正確な判断と行動決定が行われます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。純粋な視覚に基づく BEV 認識アルゴリズムは、ハードウェア コストが低く導入が容易であるため、業界で好まれており、その出力結果はさまざまな下流タスクに簡単に適用できます。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の最下層はマージ ソートを使用し、その複雑さは O(nlogn) で、クイック ソート、ヒープ ソート、安定したソートなど、さまざまなソート アルゴリズムの選択肢を提供します。

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能 (AI) と法執行機関の融合により、犯罪の予防と検出の新たな可能性が開かれます。人工知能の予測機能は、犯罪行為を予測するためにCrimeGPT (犯罪予測技術) などのシステムで広く使用されています。この記事では、犯罪予測における人工知能の可能性、その現在の応用、人工知能が直面する課題、およびこの技術の倫理的影響について考察します。人工知能と犯罪予測: 基本 CrimeGPT は、機械学習アルゴリズムを使用して大規模なデータセットを分析し、犯罪がいつどこで発生する可能性があるかを予測できるパターンを特定します。これらのデータセットには、過去の犯罪統計、人口統計情報、経済指標、気象パターンなどが含まれます。人間のアナリストが見逃す可能性のある傾向を特定することで、人工知能は法執行機関に力を与えることができます

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

01 今後の概要 現時点では、検出効率と検出結果の適切なバランスを実現することが困難です。我々は、光学リモートセンシング画像におけるターゲット検出ネットワークの効果を向上させるために、多層特徴ピラミッド、マルチ検出ヘッド戦略、およびハイブリッドアテンションモジュールを使用して、高解像度光学リモートセンシング画像におけるターゲット検出のための強化されたYOLOv5アルゴリズムを開発しました。 SIMD データセットによると、新しいアルゴリズムの mAP は YOLOv5 より 2.2%、YOLOX より 8.48% 優れており、検出結果と速度のバランスがより優れています。 02 背景と動機 リモート センシング技術の急速な発展に伴い、航空機、自動車、建物など、地表上の多くの物体を記述するために高解像度の光学式リモート センシング画像が使用されています。リモートセンシング画像の判読における物体検出

Jiuzhang Yunji DataCanvas マルチモーダル大規模モデル プラットフォームの実践と考察

Oct 20, 2023 am 08:45 AM

Jiuzhang Yunji DataCanvas マルチモーダル大規模モデル プラットフォームの実践と考察

Oct 20, 2023 am 08:45 AM

1. マルチモーダル大型モデルの発展の歴史 上の写真は、1956 年に米国のダートマス大学で開催された最初の人工知能ワークショップです。このカンファレンスが人工知能開発の始まりとも考えられています。記号論理学の先駆者たち(前列中央の神経生物学者ピーター・ミルナーを除く)。しかし、この記号論理理論は長い間実現できず、1980 年代と 1990 年代に最初の AI の冬の到来さえもたらしました。最近の大規模な言語モデルが実装されて初めて、ニューラル ネットワークが実際にこの論理的思考を担っていることがわかりました。神経生物学者ピーター ミルナーの研究は、その後の人工ニューラル ネットワークの開発に影響を与えました。彼が参加に招待されたのはこのためです。このプロジェクトでは。

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

1. 58 Portraits プラットフォーム構築の背景 まず、58 Portraits プラットフォーム構築の背景についてお話ししたいと思います。 1. 従来のプロファイリング プラットフォームの従来の考え方ではもはや十分ではありません。ユーザー プロファイリング プラットフォームを構築するには、複数のビジネス分野からのデータを統合して、ユーザーの行動や関心を理解するためのデータ マイニングも必要です。最後に、ユーザー プロファイル データを効率的に保存、クエリ、共有し、プロファイル サービスを提供するためのデータ プラットフォーム機能も必要です。自社構築のビジネス プロファイリング プラットフォームとミドルオフィス プロファイリング プラットフォームの主な違いは、自社構築のプロファイリング プラットフォームは単一のビジネス ラインにサービスを提供し、オンデマンドでカスタマイズできることです。ミッドオフィス プラットフォームは複数のビジネス ラインにサービスを提供し、複雑な機能を備えていることです。モデリングを提供し、より一般的な機能を提供します。 2.58 中間プラットフォームのポートレート構築の背景のユーザーのポートレート 58

SOTA をリアルタイムで追加すると、大幅に増加します。 FastOcc: より高速な推論と展開に適した Occ アルゴリズムが登場しました。

Mar 14, 2024 pm 11:50 PM

SOTA をリアルタイムで追加すると、大幅に増加します。 FastOcc: より高速な推論と展開に適した Occ アルゴリズムが登場しました。

Mar 14, 2024 pm 11:50 PM

上記と著者の個人的な理解は、自動運転システムにおいて、認識タスクは自動運転システム全体の重要な要素であるということです。認識タスクの主な目的は、自動運転車が道路を走行する車両、路側の歩行者、運転中に遭遇する障害物、道路上の交通標識などの周囲の環境要素を理解して認識できるようにすることで、それによって下流のシステムを支援できるようにすることです。モジュール 正しく合理的な決定と行動を行います。自動運転機能を備えた車両には、通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなど、さまざまな種類の情報収集センサーが装備されており、自動運転車が正確に認識し、認識できるようにします。周囲の環境要素を理解することで、自動運転車が自動運転中に正しい判断を下せるようになります。頭