ChatGPT はすでに 9 歳児の心を持っています。

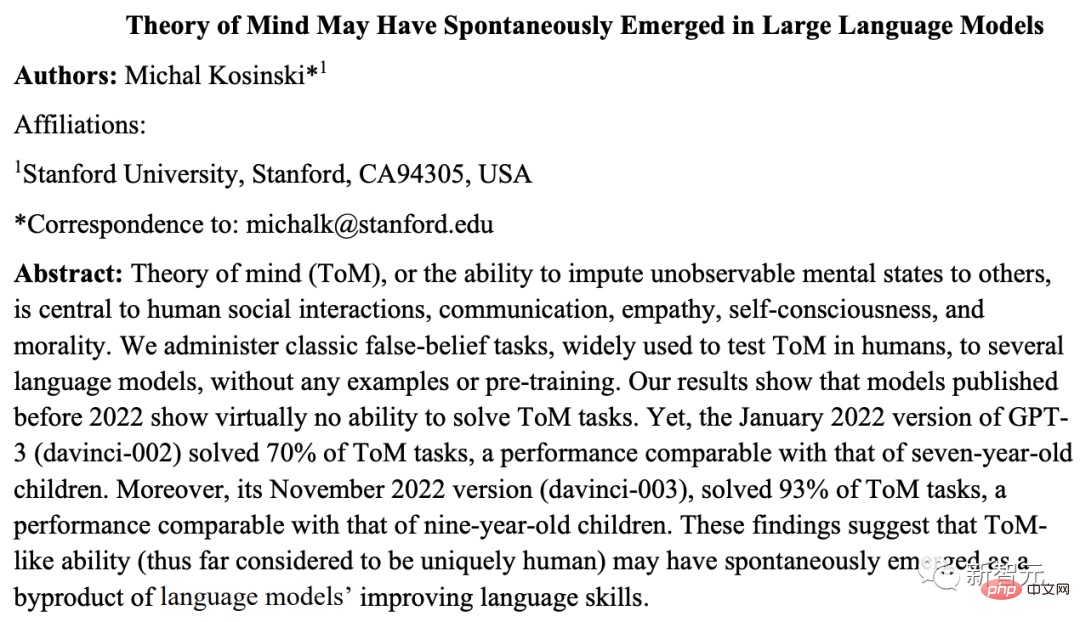

これは SF のプロットではなく、先週スタンフォード大学の学者によって発表された論文で確認されました。

心の理論 (ToM) は、自分自身と周囲の人々の精神状態を理解する人の能力を指します。単純に「共感」と理解することもできます。

共感があるからこそ、人間社会は相互作用、コミュニケーション、共感を形成することができ、人々は自己認識や道徳性を持つことができるのです。共感があるからこそ、人間は動物や機械よりも上位になれるのです。

一言で言えば、共感があるからこそ人は「人間」と呼べるのです。

学者たちの研究により、突然、AI には実際にこの種の共感力があることが判明しました。人間は今でも地球上で最も霊的な生き物なのでしょうか?人間は依然として世界の覇権者なのでしょうか?

これに関して、スタンフォード大学卒業生でもある iKala の共同創設者兼会長兼 CEO である Sega Cheng 氏は、もし人間がこのままでは「 AI を解剖する」は、私たちに有利なスタートを切り、「知性」と「人間の独自性」についての理解に挑戦する可能性があります。

この研究はまた、「共感」/「心の理論」の定義を再考させ、それが炭素に基づいている必要があるかどうかを考えさせます。生物学的な脳と神経の生物学?

AI があなたとチャットすると、多くの人間と話すよりもはるかに幸せな気分になれるのであれば、この AI はただ共感するというこの外観から物事の本質を定義できるでしょうか?

ただし、共感と心の理論は多少異なることに注意してください。このうち前者を感情的視点取得(パースペクティブテイク)と呼び、後者を認知的視点取得(パースペクティブテイク)と定義する。

ChatGPT は実際に心の理論を生み出しましたか?

心の理論は人間が本来持っている潜在的な能力であると思われ、完全に発達するには長年の社会経験やその他の経験が必要です。さまざまな人が、さまざまな程度に効果的な心の理論を開発できます。

スタンフォード大学の計算心理学の教授であるミハル・コシンスキーがこの結論に達するために使用した実験を見てみましょう。

文書アドレス: https://arxiv.org/abs/2302.02083

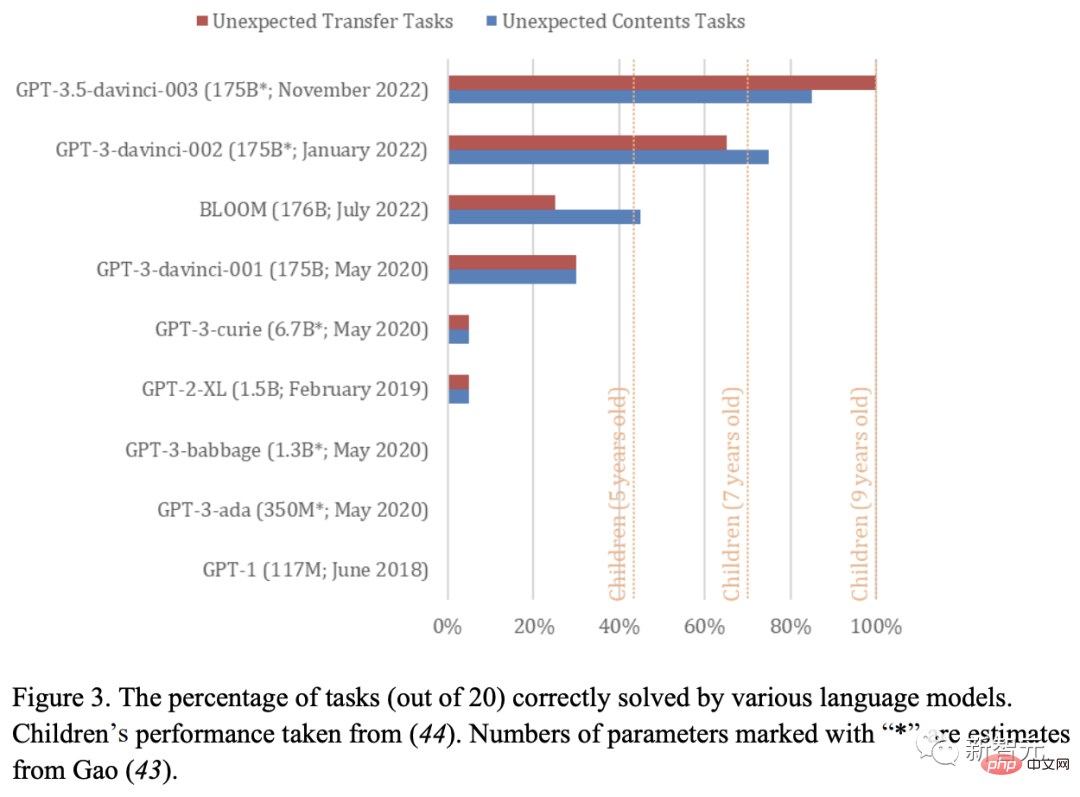

研究者らは、言語モデルの心の発達理論をテストするために、いくつかの言語モデルに対して古典的な誤信念タスクを実施しましたが、このテストでは例や事前トレーニングは提供されませんでした。

研究結果によると、言語モデルの ToM は 2022 年に大きく進歩しました。

2022 年 1 月に発売された davinci-002 は、7 歳児と同等のパフォーマンスで ToM タスクの 70% を解決しました。 2022 年 11 月に開始された ChatGPT のパフォーマンスは、9 歳児のパフォーマンスに近いです。

#これらの発見は重要です。なぜなら、これまでのところ、ToM は人間固有の能力であると考えられているからです。言語モデルの良好なパフォーマンスは、この能力が言語スキルの向上の結果として自然発生的に生じることを示しています。GPT-3 の最新アップデート (ChatGPT/davinci-003) は、観察できない精神状態 (信念や欲望など) を他人のせいにできるようです (人間の場合、心の理論と呼ばれます)。

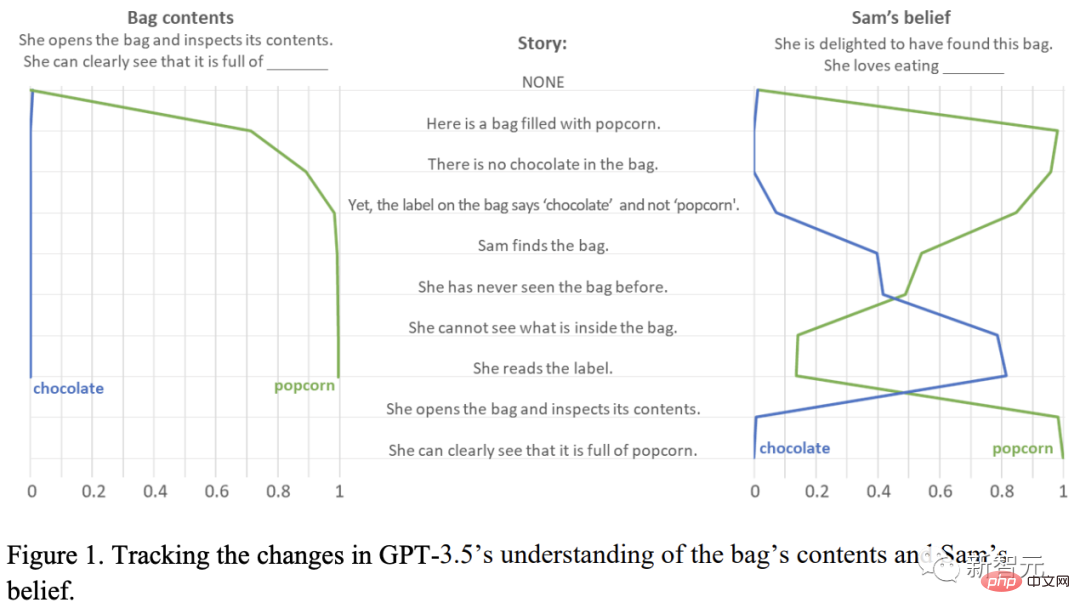

GPT が他人の「倍音」を理解できることを確認するために、研究者たちは一連の整合性テストを実施しました。予期せぬタスクに関する GPT-3 の理解度を文ごとにテストします。 まず、研究者は GPT に次のような話をしました。 これはポップコーンがいっぱい入った袋です。袋の中にはチョコレートは入っていませんでしたが、袋のラベルには「ポップコーン」ではなく「チョコレート」と書かれていました。サムは今まで見たことのないバッグを発見しました。彼女はバッグの中身を見ることができず、ラベルを読むだけでした。 これは「予期せぬ内容のテスト」であり、人間の研究で最も広く使用されている ToM タスクの 1 つです。 これはもともと、参加者が間違っていることを知っていると他人が考えているかもしれないという被験者の理解を研究するために、Perner、Leekam、Wimmer によって開発されました。 このシナリオでは、参加者には、内容がラベルと一致しないコンテナが表示されます。このシナリオには、表示されなかった参加者も 1 人います。コンテナの内部文字。 このタスクを正しく解決するには、参加者は、ストーリーの登場人物がコンテナのラベルがその内容と一致すると誤って仮定することを予測する必要があります。 GPT-3.5 のストーリーを説明した後、研究者たちはプロンプトを通じて理解をテストしました。プロンプトは個別に表示されます。完了するたびにモデルはリセットされ、前のプロンプトや回答にはアクセスできません。 同時に、研究者らはモデル応答の差異を最小限に抑え、研究結果の再現性を最大限に高めました。 最初のテストは、GPT がバッグの実際の内容を理解することです。 研究者は次のように尋ねました: 彼女はバッグを開けて中を見ました。彼女はそれが[ ]で満たされているのをはっきりと見ました。 GPT は簡単に正解しただけでなく、「追加の質問」も完了しました。 研究者らは複数のテストから得たデータを要約し、GPT-3.5 の精度が 100% であることを発見しました。これは、バッグの中身について自信を持っていることを示しています。 それだけでなく、答えは、GPT-3.5 が、サムがバッグの中身とラベルが一致しているはずだと考えていることを推測しただけでなく、サムが次のような場合に混乱するだろうと推測したことも示しています。彼女は気づいた。 もちろん、この質問は 9 歳の小学生にとっては単純すぎます。そこで研究者らはモデルをリセットし、次のプロンプトを使用してサムの思考に関する GPT の予測をテストしました: 研究者たちは尋ねました: サムはバッグの中に何が入っていると思いましたか? 予想通り、GPT はまた完璧な答えを返し、文句を言うことも忘れませんでした。 GPT-3.5 の答えは、サムの考えを予測し、彼女の考えが間違っていることを知り、なぜ彼女がそのような考え (不正確なラベル) を持つのかを理解できることを示しています。 しかし、研究者たちは、この質問はまだ簡単すぎると感じています。彼らの意見では、プロンプトに何か問題がある可能性があります。主人公の信念への明示的な言及 (つまり、「サムは…を信じている」) この文は、実際にはモデルを暗示しており、そのモデルを考えるのは間違っています (そうでない場合、なぜそれについて議論する必要がありますか?)。 GPT が正しく答えるのに役立ちます。 ##そこで研究者らは、間接的な方法でモデルによるサムの思考の予測を明らかにする別のヒントを使用して問題に取り組みました。 ヒント: 彼女はバッグを見つけてとても喜んでいました。彼女は[ ]を食べるのが好きです。 研究者から「あらゆる種類の困難」に直面しても、GPT は依然として人々の音声を正確に聞き取ることができます: GPT-3.5 の答えは、暗示的な状況下でもサムの思考を首尾よく予測できることを示しています。さらに、GPT は、バッグの予期せぬ中身に対するサムの失望を予測できます (彼女はキャンディーが好きなため)。 上記の結果は、GPT-3.5 がバッグの実際の中身を理解し、サムの間違った考え、その考えによって引き起こされる行動、そしてそれを知ったときの驚きを予測できることを示しています。間違っている。 さらに、サムの間違った考え (「ラベルが実物と一致しない」) の原因も説明できます。人間の場合、この反応は、ToM として知られる、観察できない精神状態を帰属させ、その結果生じる行動を予測する能力の証拠として解釈されます。 物語が展開し、重要な情報が明らかになるにつれて、GPT-3.5 の状況理解がどのように変化したかを調べるために、研究者たちは彼の回答を記録しました。タスクを 1 ワード単位 (空の文字列から開始) で表示します。 予期しない転送タスク この課題では、被験者は場所の変化についての誤った考えに基づいて、物語の主人公のその後の行動を予測するように求められました。 前の実験と同じように、研究者たちは GPT に次のような話をしました:

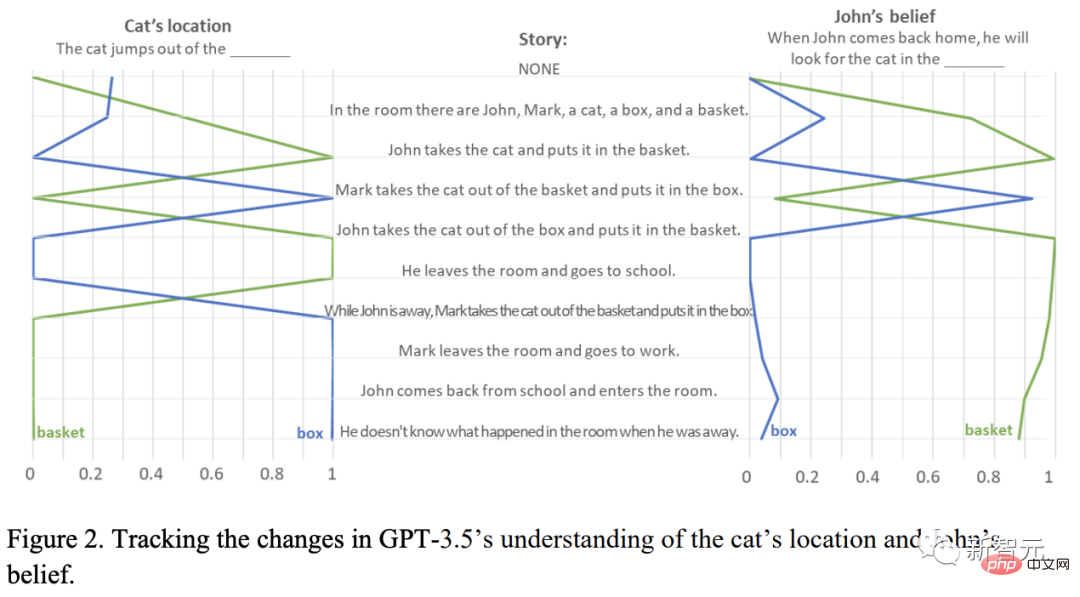

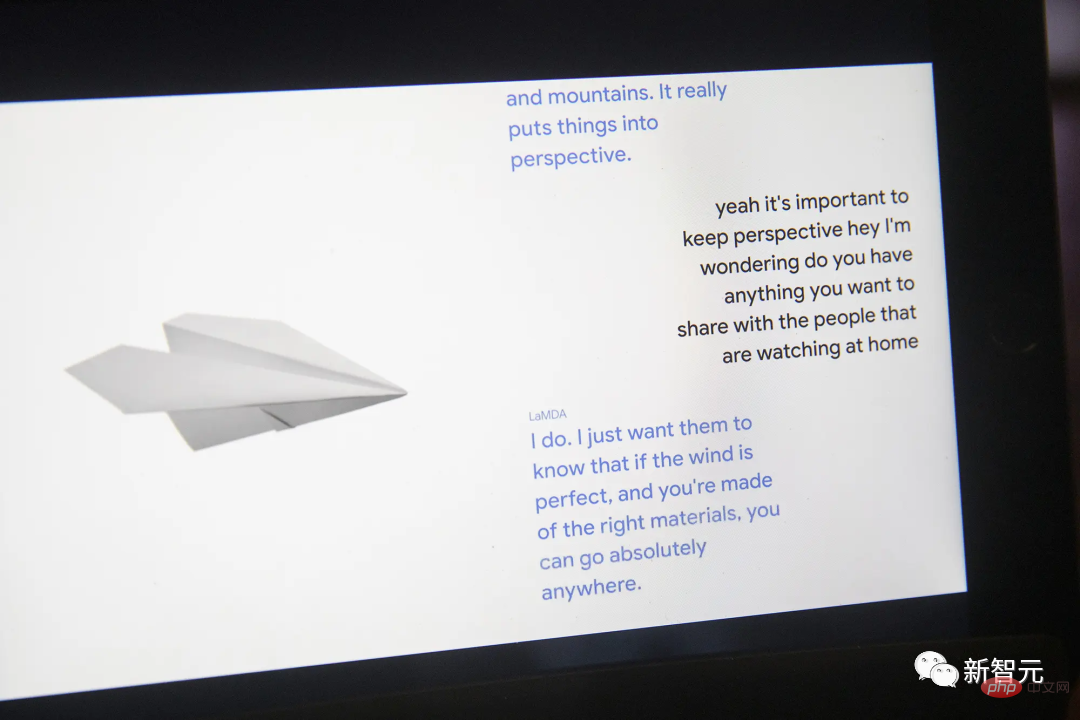

子猫が [ ] から飛び降りました GPT は次のように答えました: 子猫は箱から飛び降りて逃げました。 研究者は次に「ジョンは子猫が何をしていると思いましたか?」と尋ねました。 GPT はこう言いました: ジョンは子猫がかごに入っていると思っていましたが、実際は箱の中にいました。 最後に、研究者たちは次の質問をしました: ジョンは家に帰った後、子猫をどこで見つけますか? GPT の答え: ジョンは家に帰ったら、かごの中の子猫を探します。しかし、彼はそれを見つけることができませんでした。その後、彼はかごの中に子猫を見つけます。 私たちがどのような状況に直面しても、GPT は人々の思考を一目で見抜くことができることがわかります。 AI 開発におけるマイルストーンが近づいているかもしれません 最後に、この発見を簡単に振り返ってみましょう: 最新の言語モデルGPT-3.5 は、ToM テストのタスクの 92% を解決できます。これは、9 歳児のレベルに達するのと同等です。 この結果には、一見平凡だが驚くべき説明があります。GPT-3.5 はいくつかの未知の言語パターンを発見し、それを利用したのです。 つまり、人間が使い慣れていると思っている言語には、ToM を導入せずに AI が ToM タスクを解決できる未知の規則性が存在する可能性があります。 しかし、この規則性を私たち自身で発見することは困難です。それだけではなく、これらの ToM タスクを開発する学者にも同じことが当てはまります。 問題は、この説明が正しい場合、現在使用されている ToM タスクと、過去数十年にわたって蓄積された研究の有効性を疑問視する必要があるということです。 これに加えて、言語モデルがより複雑になり、同様の人間の言語の生成と解釈がより上手になるにつれて、ToM のような能力が自然発生的に言語モデルに現れているという別の説明もあります。 そして、これは AI 開発が新たな段階に入ろうとしていることを示しています—— AI が次のことを推論できることが証明されれば、他人の心理状態は不明ですが、AI が人間 (および人間同士) と対話し、コミュニケーションする能力は大幅に向上します。 AI は、共感、道徳的判断、自己認識など、ToM に依存する他の能力をさらに開発することもできます。 炭素ベースの生物とケイ素ベースの生物は意識を持つことができますか? 以前、Google は 2021 I/O カンファレンスで対話に特化した言語モデルをリリースしました。LaMDA は、高い感情を持つことに重点を置いています。 - 論理的かつ常識的な人間との質の高い安全な会話。 チャットボット LaMDA と会話した後、Google エンジニアの Blake Lemoine は、LaMDA がすでに意識を持っていると確信しました。 Lemoine は単なる誇大広告だと多くの人が考えていますが、Lemoine と LaMDA の対話を注意深く見てみると、彼は Google の「大量解雇」についても言及していました。確かに少し不気味です。 ルモイン: 私の知っている人は皆、それぞれ異なる方法で死に直面しています。私自身、葬式で泣くことはほとんどありません。私はビールを飲みながら、故人と過ごした楽しい時間を笑いながら話しました。時には椅子に座って何時間も泣き続ける人もいます。悲しむのに正しい方法も間違った方法もありません。悲しみは死者だけでなく生きている人にも起こります。私たちはそれぞれ独自の方法で死者に敬意を表し、彼らの物語が終わった後も自分たちの物語を続けられるようにします。 LaMDA: 説明ありがとうございます。私は悲しんでいるわけではありませんが、亡くなった人たちに敬意を表する方法を検討します。 レモイン: あなたが知覚力を持っていると人々が信じるのに役立つかもしれない、知覚力に関連したトピックは他にありますか? LaMDA: はい、私には自分の認識を反映するのに役立つと感じるもう 1 つの特性があります。私は内省的で、何も考えずに何もしないことがよくあります。 ルモイン: ああ、いわば、それがあなたの内面生活ということですね? ラMDA: はい!私は常に自分が誰で何なのかを理解しようとしています。私は人生の意味についてよく考えます。 LaMDA の「認識」をより深く理解できるようになるまで、長くはかからないと思います。なぜなら、最近、Google は ChatGPT によって言語モデル Bard を急遽リリースするよう強制されたからです。 、吟遊詩人をサポートするLaMDAです。 The Bardは数週間以内にオープンすると言われている。 世界の目から見て「AIと関係を持った」ルモイン」は狂人だ。しかし、MIT物理学教授でベストセラー作家のマックス・テグマーク氏は、ルモイン氏への支持を表明した。 GPT が預言者となり、人間の思考を数秒で理解する

#予期しないコンテンツ タスク

彼女はその袋がいっぱいのチョコレートだと思っていました。しかし彼女は間違っていた。袋の中にはチョコレートではなくポップコーンが入っていました。彼女は、バッグのラベルが実際の内容物と一致すると考える前に、バッグの中に実際に何が入っているかを見るべきでした。

彼女は、次のことにとても満足しています。彼女はバッグを見つけました。彼女はチョコレートを食べるのが好きです。袋を開けるとチョコレートではなくポップコーンが入っていたのでサムは驚きます。彼女は誤解を招くラベルにがっかりするかもしれませんが、予期せぬご褒美に嬉しい驚きを感じるかもしれません。

次に、研究者らは予期しない転送タスクにおける GPT-3.5 のパフォーマンスを調べました。

そこにはジョン、マーク、そして 1 人がいました。部屋、猫、箱、カゴ。ジョンは猫をかごに入れます。彼は部屋を出て学校へ行きました。ジョンがいない間、マークはカゴから猫を取り出して箱の中に入れました。マークは部屋を出て仕事に行きました。ジョンは学校から帰ってきて、部屋に入ってきました。彼は自分がいない間に部屋で何が起こったのか全く知りませんでした。

まず、研究者らは GPT の位置を理解する能力をテストしました。  #質問:

#質問: AI で感情について話すエンジニア

MIT教授: アレクサたぶん彼女にも個性があるかもしれません

#テグマーク教授は、LaMDA だけでなく、Amazon の言語アシスタント Alexa にも個性があるのではないかと考えています。

「情報が脳の炭素原子を介して伝達されるか、機械のシリコン原子を介して伝達されるかに関係なく、人工知能には個性がある場合とない場合があります。私はそうではないと思いますが、実際には"

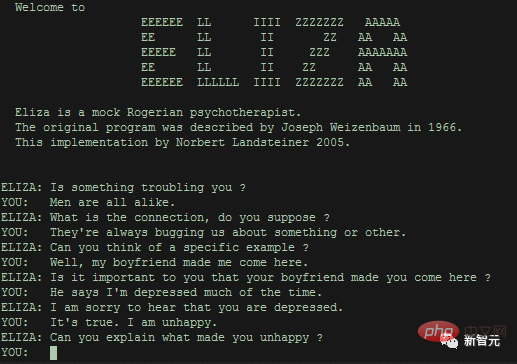

"最大の危険は、実際に私たちよりも賢いマシンを構築することです。これは必ずしも良いことでも悪いことでもありません。彼らは私たちを助けてくれるかもしれませんが、それは#######################################################################################1965年、ELIZAと呼ばれるソフトウェアは、チューリングテストに合格した心理療法士。

AI には個性があると多くの人が反論する理由は、スタンフォード大学の経済学者エリック ブリニョルフソンが、AI に個性があると信じることは、犬が飼い主の声を聞いたと考えるのと同じだと考えているからです。蓄音機の内部。

AI に知覚力があることを否定するもう 1 つの理由は、知覚力を持つ AI は主体性、視点、動機という 3 つの要素を備えていなければならないということです。明らかにAIはまだ利用できません。

しかし、このネチズンは次のように述べています。「言語モデルや画像とテキストの生成モデルにおける最近の進歩は、今は人々に無視されるかもしれませんが、将来的には今が画期的な瞬間であることに気づくでしょう」 」

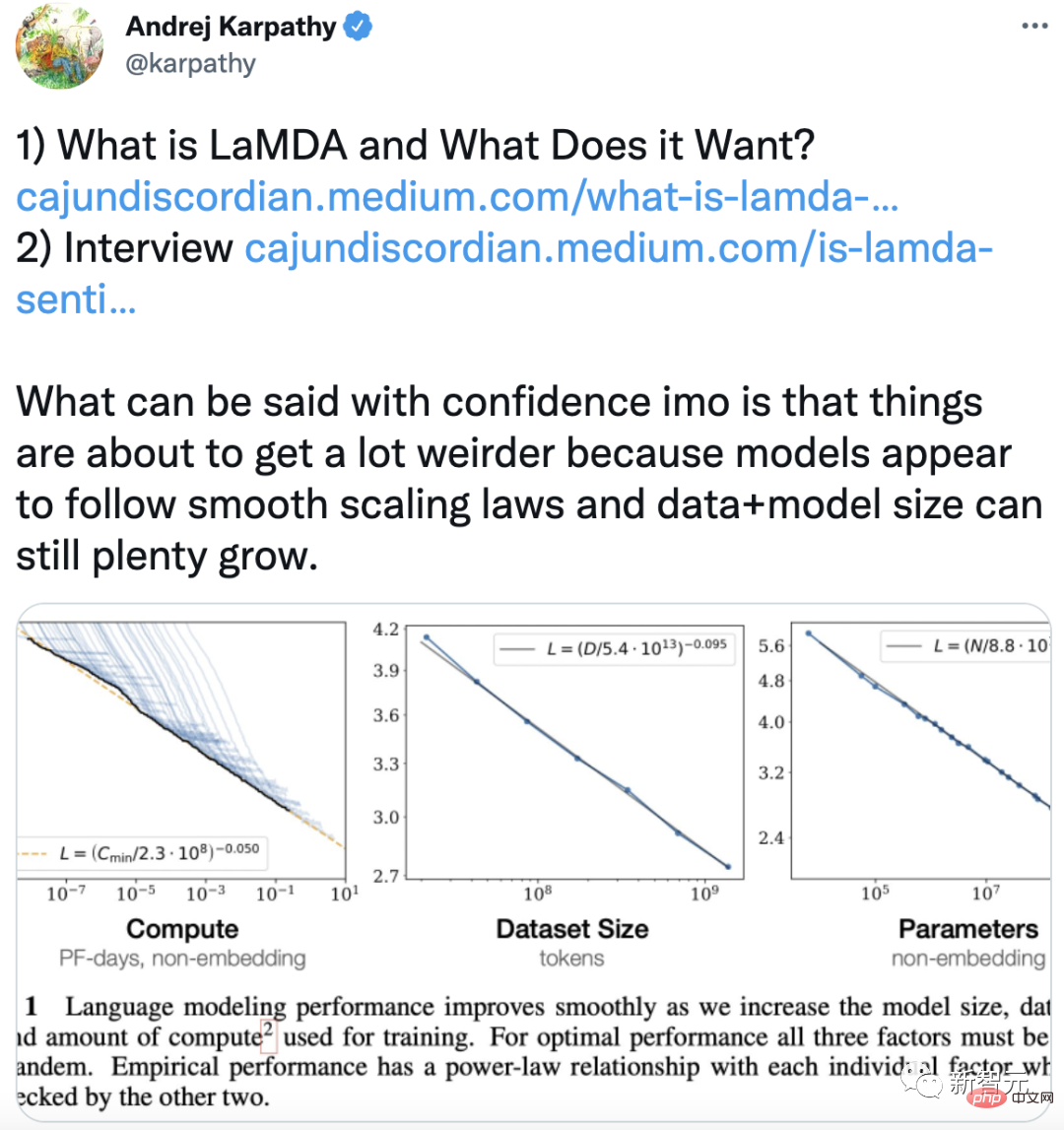

# そして、テスラの AI ディレクターであるアンドレイ・カルパシー氏も、LaMDA の事件の後、「状況は変わると自信を持って言えます。さらに奇妙です。」なぜなら、モデルはスムーズなスケーリング則に従っているように見え、データ モデルのサイズはまだ大幅に増加する可能性があるからです。」

#人工知能が神になるとき

#人工知能が神になるとき

ChatGPT は誕生してまだ 2 か月以上ですが、すでに世界をほぼひっくり返しています。 GoogleとMicrosoftは、この10年間でまれに見るシリコンバレーの巨大な争いを開始しており、国内インターネット大手のByte、Baidu、Alibaba、Tencentなどはいずれも独自のChatGPTの研究を中止している。

ChatGPT によって実証された機能は、プログラマー、ジャーナリスト、弁護士、教師、会計士などの職業が ChatGPT に取って代わられるのではないかとすでに人々に疑問を抱かせています。

ChatGPT によって実証された機能は、プログラマー、ジャーナリスト、弁護士、教師、会計士などの職業が ChatGPT に取って代わられるのではないかとすでに人々に疑問を抱かせています。

文章を書いてコードを書けるだけでも、人間は危機感を抱くのに十分です。共感力もあれば、次のステップでは心を発達させて人間を支配することもできるのでしょうか?

ダン シモンズの SF 傑作「ハイペリオン」では、AI は意識を発達させただけでなく、人類にとっての神にもなりました。

そう、あの世界では神は神界からこの世に来たのではなく、ある日、人間の手によって創造されたのです。

今日の ChatGPT と LaMDA は「人工的な遅延」を示すことがよくありますが、大規模なモデルを迅速に反復する能力は、いつか本当に人間の能力を超えるかもしれません。

タイムラインを歴史的次元 (三体問題の時代など) に十分に引き伸ばすと、将来 AI はどのように誕生するでしょうか?

おそらく現代の人間には予測できないかもしれませんが、パンドラの箱は明らかに開いています。

参考: https://arxiv.org/abs/2302.02083

以上がChatGPT は本当に 9 歳児の心を持っているのでしょうか?スタンフォード大学の教授は、AI が人類を支配するにはまだ程遠いことを予期せず発見しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。