CNN を基本モデルとして使用する、変形可能な畳み込み InternImage は、検出とセグメンテーションの新記録を達成しました。

近年の大規模ビジュアルトランスフォーマーの開発のブームにより、コンピュータビジョンの分野におけるパフォーマンスの限界が押し上げられています。 Vision Transformer モデルは、モデル パラメーターとトレーニング データの数を拡張することで、畳み込みニューラル ネットワークを打ち負かします。上海人工知能研究所、清華大学、Nanda、SenseTime、Hong Kong Chinese の研究者らは、畳み込みニューラル ネットワークとビジュアル トランスフォーマーの間のギャップを要約しました。演算子レベルで見ると、従来の CNN 演算子には長距離依存性と適応空間集約機能が欠けており、構造レベルで見ると、従来の CNN 構造には高度なコンポーネントが欠けています。

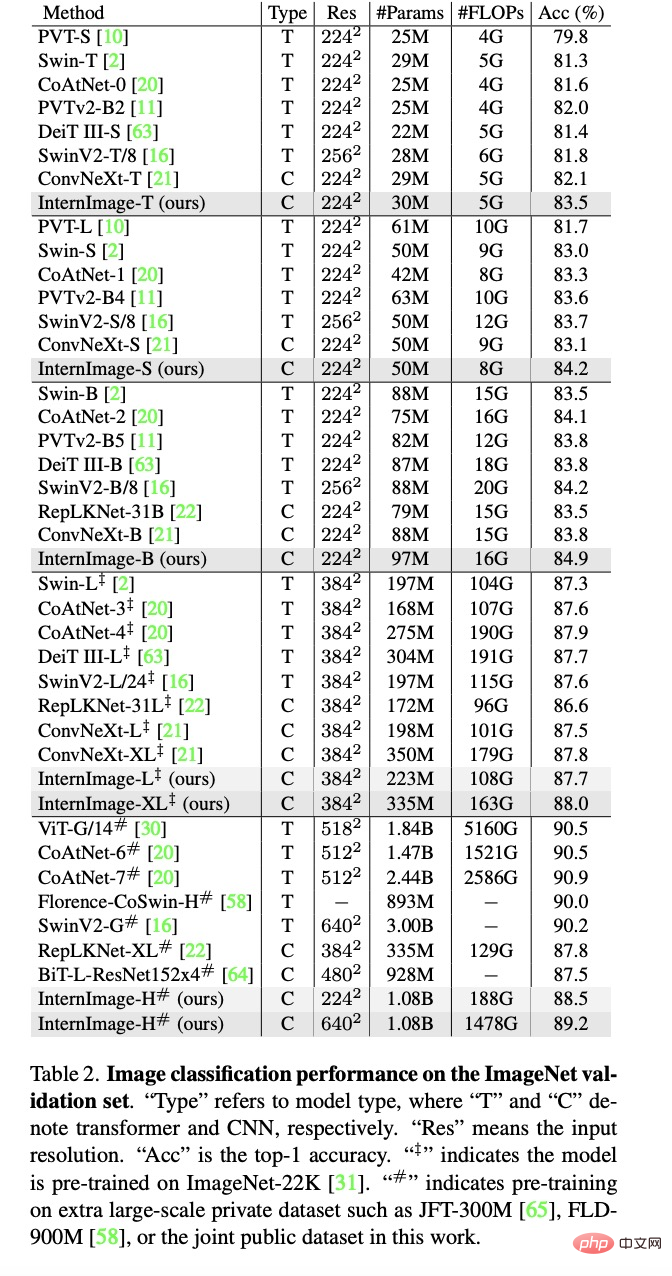

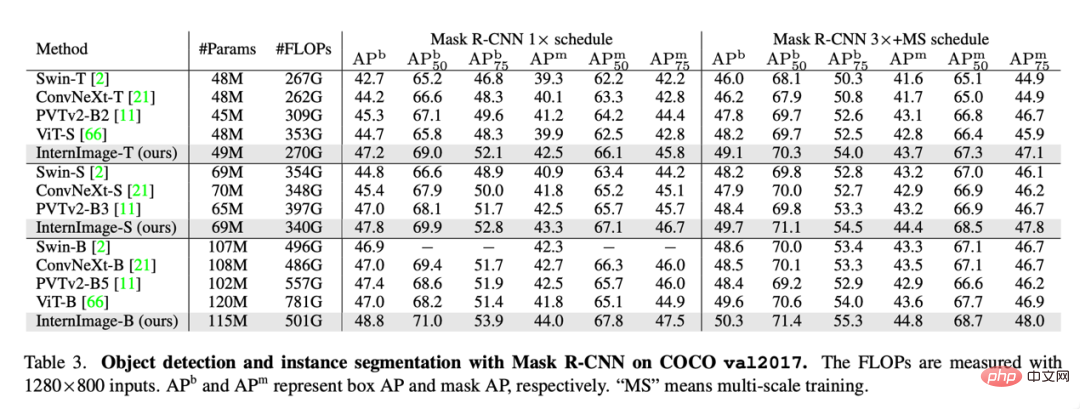

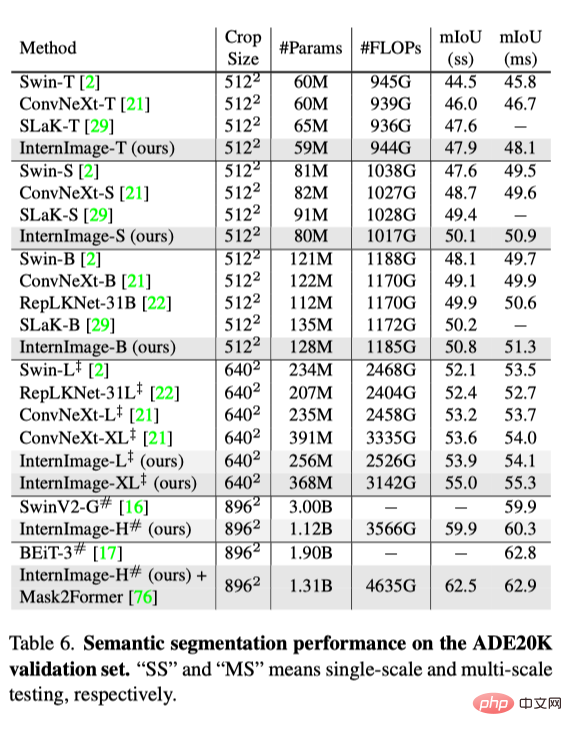

上記の技術的問題に対応して、浦江研究所、清華大学、その他の機関の研究者らは、畳み込みニューラル ネットワークに基づく大規模モデルと呼ばれる革新的なモデルを提案しました。 InternImage の場合、スパース動的畳み込みをコア オペレーターとして使用し、関連情報を条件として入力することで適応的な空間集約を実現します。 InternImage は、従来の CNN の厳密な帰納的バイアスを軽減することにより、大量のデータからより強力で堅牢な大規模パラメータ パターンを学習できるようにします。その有効性は、画像分類、オブジェクト検出、セマンティック セグメンテーションなどの視覚タスクで検証されています。 ImageNet、COCO、ADE20K などの難しいベンチマーク データ セットで競争力のある結果を達成し、同じパラメータ レベルでビジュアル Transformer 構造を超え、大規模な画像モデルに新しい方向性を提供しました。

- 論文リンク: https://arxiv.org/abs/2211.05778

- オープンソース コード: https://github.com/OpenGVLab/InternImage

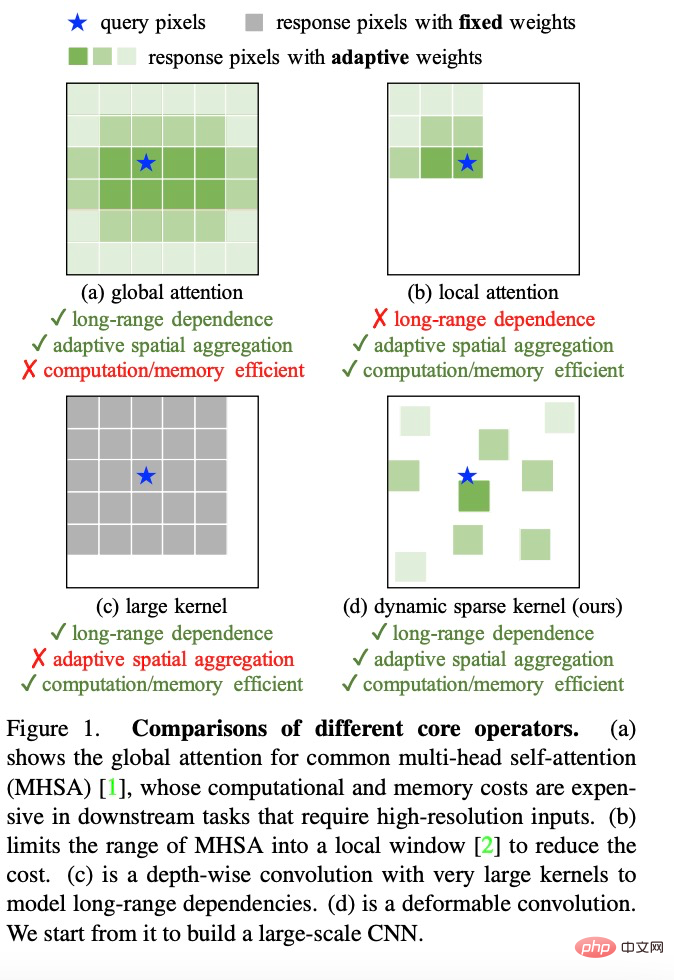

(1) オペレータ レベルから見ると、ビジュアル Transformer のマルチヘッド アテンション メカニズムには長距離依存性と適応性があります。空間集約機能の恩恵を受けて、ビジュアル Transformer は、CNN ネットワークよりも強力で堅牢な表現を大量のデータから学習できます。

(2) モデル アーキテクチャの観点から見ると、ビジュアル Transformer には、マルチヘッド アテンション メカニズムに加えて、CNN ネットワークにはない、Layer などのより高度なモジュールがあります。正規化(LN)、フィードフォワードニューラルネットワークFFN、GELUなど

最近の研究の中には、大規模なカーネル畳み込みを使用して長距離の依存関係を取得しようとしているものもありますが、モデルのスケールと点で最先端のビジュアル トランスフォーマーにはまだ程遠いです。正確さ。

変形可能な畳み込みネットワークのさらなる拡張

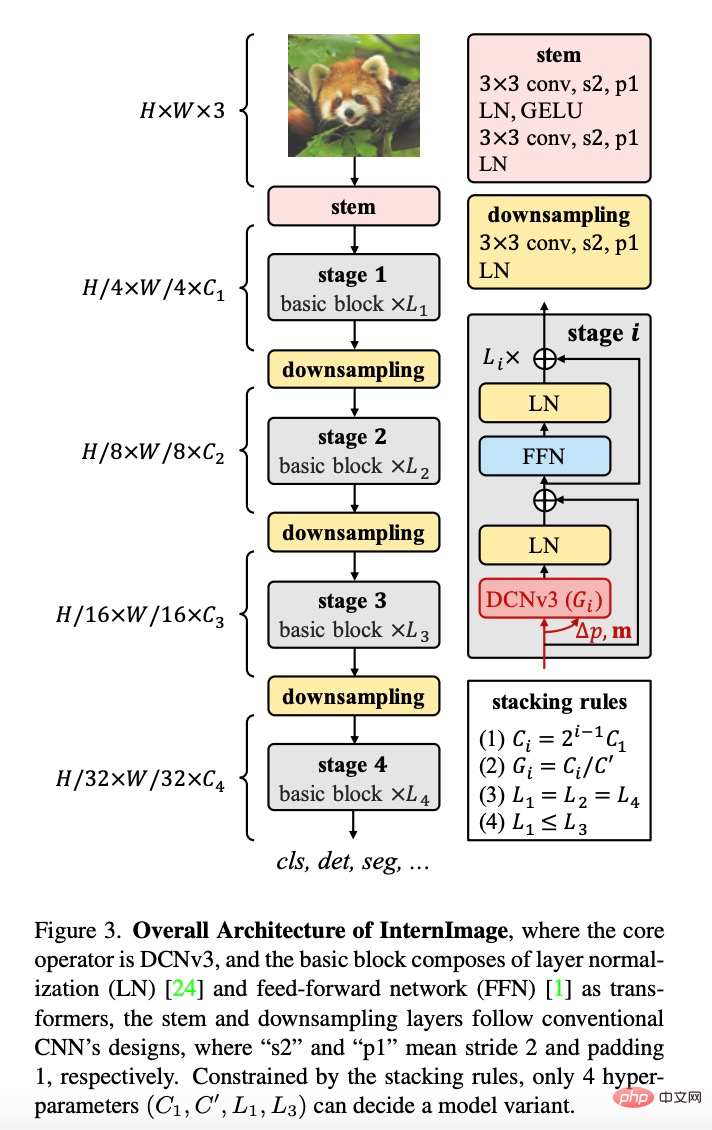

InternImage は、(1) DCNv3 演算子を含む演算子とモデル構造を再設計することにより、畳み込みモデルのスケーラビリティを向上させ、帰納的バイアスを軽減します。共有投影重み、マルチグループ メカニズム、および DCNv2 オペレーターに基づくサンプリング ポイント変調を導入します。 (2) 基本モジュール。モデル構築の基本モジュール単位として高度なモジュールを統合します。 (3) モジュールのスタックルール。モデルを拡張する際のモデルの幅、深さ、グループ数、その他のハイパーパラメータを標準化します。この作業は、大規模なパラメーターに効果的に拡張できる CNN モデルの構築に特化しています。まず、変形可能な畳み込み演算子 DCNv2 が、長距離の依存関係に適応し、誘導バイアスを弱めるように再設計され、次に、調整された畳み込み演算子が高度なコンポーネントと結合されて、基本ユニット モジュールが確立され、最後に、モジュールのスタッキングとスケーリングのルールを調査して実装します。大規模なパラメータを備えたベース モデルを構築し、大量のデータから強力な表現を学習できます。

この調査では、演算子レベルで、まず、畳み込み演算子と他の主流の演算子の主な違いを要約します。現在主流の Transformer シリーズ モデルは、大規模なモデル構築を実現するために主にマルチヘッド セルフ アテンション メカニズムに依存しています。その演算子には、長距離フィーチャ間の接続関係を構築するのに十分な長距離依存関係があり、空間適応集約も備わっています。ピクセルレベルの構築を実現する機能。ただし、このグローバル アテンション メカニズムには膨大なコンピューティングとストレージの要件があり、効率的なトレーニングと迅速なコンバージェンスの実現が困難になります。同様に、ローカル アテンション メカニズムには長距離の特徴依存性がありません。大コアの高密度畳み込みには空間集約機能がないため、畳み込みの自然な誘導バイアスを克服するのは難しく、モデルの拡張には役立ちません。したがって、InterImage は、コンピューティング リソースやストレージ リソースをあまり浪費することなく、グローバル アテンション効果を達成し、効率的なトレーニングを実現する動的なスパース畳み込み演算子を設計します。

DCNv2 オペレーターをベースに、研究者らは DCNv3 オペレーターを再設計、調整、提案し、具体的な改善点としては以下の部分が挙げられます。

(1) 共有投影の重み。従来の畳み込みと同様に、DCNv2 のさまざまなサンプリング ポイントには独立した投影重みがあるため、パラメータ サイズはサンプリング ポイントの総数と線形に関係します。パラメータとメモリの複雑さを軽減するために、分離可能な畳み込みのアイデアを利用し、位置に依存しない重みを使用してグループ化重みを置き換えます。射影重みは異なるサンプリング ポイント間で共有され、すべてのサンプリング位置の依存関係は保持されます。

(2) マルチグループ機構を導入します。マルチグループ設計は、グループ化畳み込みで最初に導入され、Transformer のマルチヘッド セルフ アテンションで広く使用されており、適応空間集約と組み合わせることで、機能の多様性を効果的に向上させることができます。これに触発されて、研究者は空間集計プロセスをいくつかのグループに分割し、各グループは独立したサンプリング オフセットを持ちます。それ以来、単一の DCNv3 レイヤーの異なるグループが異なる空間集約パターンを持ち、その結果、機能の多様性が豊富になりました。

(3) サンプリングポイント変調のスカラー正規化。モデル容量が拡張されたときの不安定性の問題を軽減するために、研究者らは正規化モードをサンプルごとにソフトマックス正規化に設定し、これにより大規模モデルのトレーニングプロセスがより安定するだけでなく、すべてのサンプリング ポイントのモデル、接続関係。

DCNv3 オペレーターを構築した後、まず基本モジュールとモデルの他のレイヤーの全体的な詳細を標準化してから、 InterImage を構築するためのスタッキング戦略。最後に、提案されたモデルの展開規則に従って、異なるパラメータ量を持つモデルが構築されます。

基本モジュール。従来の CNN で広く使用されているボトルネック構造とは異なり、この研究では、GELU、レイヤー正規化 (LN)、フィードフォワード ネットワーク (FFN) などのより高度なコンポーネントを備えた、ViT に近い基本モジュールを採用しています。さまざまな視覚タスクをより効率的に実行できます。基本モジュールの詳細は上の図に示されており、コア オペレーターは DCNv3 です。DCNv3 は、軽量の分離可能な畳み込みを介して入力特徴を渡すことにより、サンプリング バイアスと変調スケールを予測します。その他のコンポーネントについては、通常のトランスと同じ設計に従います。

オーバーレイ ルール。ブロックスタッキングプロセスを明確にするために、この研究では 2 つのモジュールスタッキングルールを提案します. 最初のルールは、最後の 3 つのステージのチャネル数です。最初のステージ  意思決定、つまり

意思決定、つまり  ; 2 番目のルールは、各モジュールのグループ番号が各ステージのチャネル数に対応することです。

; 2 番目のルールは、各モジュールのグループ番号が各ステージのチャネル数に対応することです。  ; 3 番目のスタッキング モードは「AABA」に固定されます。つまり、ステージ 1、2、および 4 のモジュール スタックの数は同じです。 、ステージ 3 の値を超えない

; 3 番目のスタッキング モードは「AABA」に固定されます。つまり、ステージ 1、2、および 4 のモジュール スタックの数は同じです。 、ステージ 3 の値を超えない  。したがって、パラメータボリューム 30M のモデルをベースとして選択し、具体的なパラメータは、Steam 出力チャンネル数

。したがって、パラメータボリューム 30M のモデルをベースとして選択し、具体的なパラメータは、Steam 出力チャンネル数  # が 64、グループ数がその 1/16 です。各ステージの入力チャンネル数 ステージ 1、2、4 のモジュール スタック

# が 64、グループ数がその 1/16 です。各ステージの入力チャンネル数 ステージ 1、2、4 のモジュール スタック  の数は 4、ステージ 3 のモジュール スタックの数

の数は 4、ステージ 3 のモジュール スタックの数  18、モデルパラメータは30Mです。

18、モデルパラメータは30Mです。

モデルのスケーリング ルール

モデルのスケーリング ルール

。上記の制約の下での最適なモデルに基づいて、この調査では、ネットワーク モデルの 2 つのスケーリング次元、深さ D (モジュール スタックの数) と幅 C (チャネルの数) を、制限係数 # を使用して正規化しました。 # および は、複合係数  に沿って深さと幅をスケールします。つまり、

に沿って深さと幅をスケールします。つまり、 、

、 、実験によれば、最適な設定は

、実験によれば、最適な設定は  です。

です。  このルールに従って、この研究では、InternImage-T、S、B、L、XL というさまざまなスケールのモデルを構築しました。特定のパラメータは次のとおりです:

このルールに従って、この研究では、InternImage-T、S、B、L、XL というさまざまなスケールのモデルを構築しました。特定のパラメータは次のとおりです:

実験結果

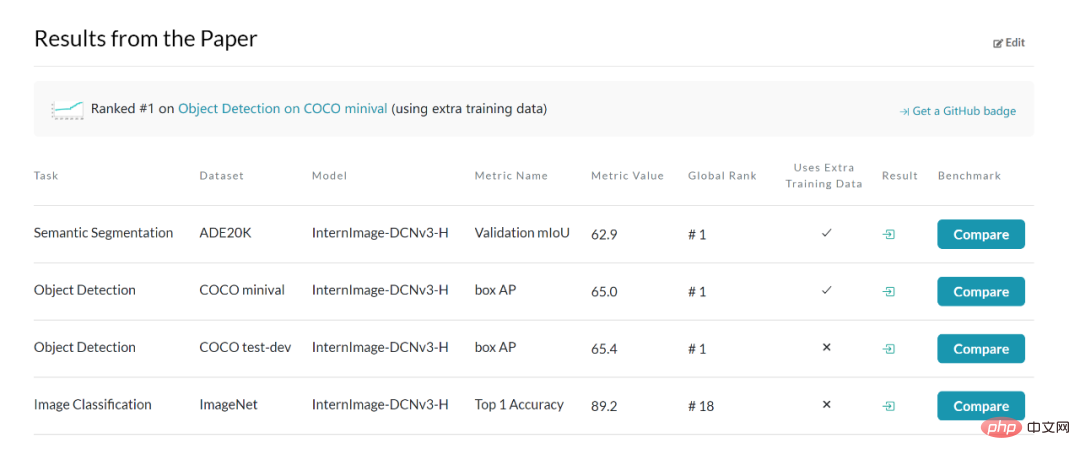

画像分類実験: 4億2700万の公開データセットを使用: Laion-400M、YFCC15M、CC12M , InternImage-H は、ImageNet-1K 上で 89.2% の精度を実現します。

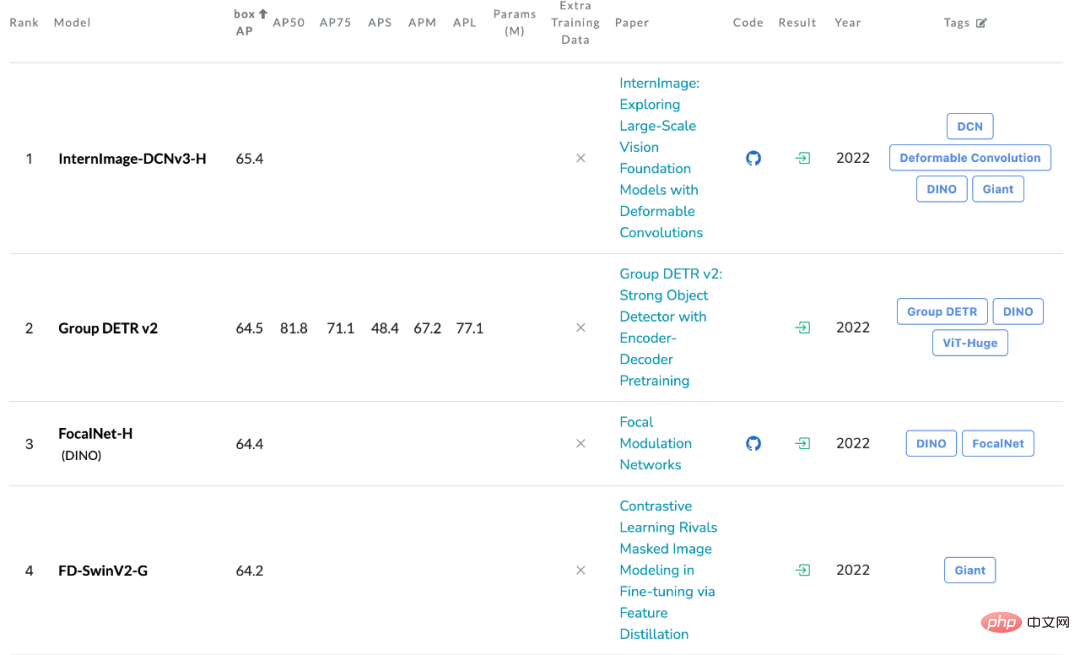

#オブジェクト検出: 最大の InternImage-H をバックボーンとして取得ネットワークを構築し、基本的な検出フレームワークとして DINO を使用して、Objects365 データセットで DINO 検出器を事前トレーニングし、COCO で微調整しました。このモデルは、ターゲット検出タスクで 65.4% という最適な結果を達成し、COCO ターゲット検出のパフォーマンス境界を突破しました。

セマンティック セグメンテーション: セマンティック セグメンテーションについては、InterImage-H Itも非常に優れたパフォーマンスを達成し、Mask2Former と組み合わせると、ADE20K で現在の最高の 62.9% を達成しました。

本研究は、強力な表現を提供できる新しい CNN ベースの大規模基本モデルである InternImage を提案します。画像分類、オブジェクト検出、セマンティック セグメンテーションなどの多用途の視覚タスク。研究者らは、基本モデルのニーズを満たすように柔軟な DCNv2 オペレーターを調整し、コア オペレーターに基づいて一連のブロッキング、スタッキング、スケーリング ルールを開発しました。オブジェクト検出とセマンティック セグメンテーションのベンチマークに関する広範な実験により、InterImage が大量のデータでトレーニングされた適切に設計された大規模ビジュアル Transformer と同等以上のパフォーマンスを達成できることが検証されており、CNN も大規模ビジュアル基本モデルにおいて重要なステップであることが示されています。研究して選んでください。それでも、大規模な CNN はまだ開発の初期段階にあり、研究者らは InterImage が良い出発点として機能することを期待しています。

以上がCNN を基本モデルとして使用する、変形可能な畳み込み InternImage は、検出とセグメンテーションの新記録を達成しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7455

7455

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。