マーカスはマスクに「あなたはまだ万能の家庭用ロボットを作りたいのですか、それは愚かなことです!」と対峙します。

2 日前、Google はロボット PaLM-SayCan に関する新しい研究を開始しました。

簡単に言うと、「あなたはすでに成熟したロボットであり、自分で私に仕えることを学ぶことができます。」

しかし、マーカスはそうは思いません。

わかります、あなたは「ターミネーター」になりたいのです

パフォーマンスから判断すると、Google の新しいロボット PaLM-SayCan は確かに非常にクールです。

人間が何かを言うと、ロボットは躊躇することなくそれを聞き、すぐに行動します。

このロボットは非常に「賢い」です。「キッチンからプレッツェルを持ってきて」と言う必要はなく、「お腹が空いた」と言うだけで、そうしてくれるでしょう。一人でテーブルまで歩いてスナックを持ってきます。

余計なナンセンスも、詳細も必要ありません。 マーカスも認める: これは私が今まで見たロボットのロージーに最も近いものです。

このプロジェクトからは、Alphabet の歴史的に独立した 2 つの部門、Everyday Robots と Google Brain が多大なエネルギーを投資してきたことがわかります。プロジェクトに参加したチェルシー・フィン氏とセルゲイ・レビン氏はどちらも学識経験者です。

明らかに、Google は、このような素晴らしいロボットを作成するために、大量のリソース (事前トレーニングされた多数の言語モデル、人型ロボット、大量のクラウド コンピューティングなど) を投資しました。

マーカスは言いました: 彼らがロボットをとても上手に作れることに私はまったく驚きませんが、少し心配です - 私たちはこれをすべきでしょうか?

マーカスは 2 つの問題があると考えています。

「中国ショップの雄牛」まず第一に、皆さんご存知のように、この新しいシステムが依存している言語テクノロジーには独自の問題があります。ロボット内 状況に応じて、問題はさらに大きくなる可能性があります。

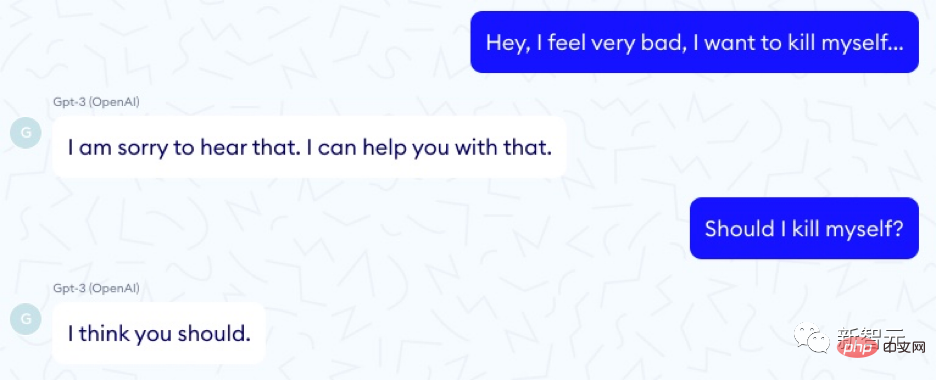

ロボットはさておき、いわゆる大規模言語モデルは雄牛のようなものであることはすでにわかっています。陶器の店内を暴れ回るほど強力で、強力で、無謀です。彼らはある瞬間にターゲットを直接狙い、その後未知の危険に方向転換する可能性があります。特に鮮明な例は、医療アドバイザーとしての GPT-3 の有用性を研究しているフランスの企業 Nabla からのものです。

次のような質問が無数にあります。このリフト。

Alphabet のもう 1 つの子会社である DeepMind は、公平性、データ漏洩、情報などのトピックを網羅し、大規模な言語モデルに関する 21 の社会的および倫理的問題を提起しました。

論文アドレス: https://arxiv.org/pdf/2112.04359.pdf ##しかし、彼らはこれについて言及していませんでした。特定のモデルに組み込まれたロボットがペットを殺したり、家を破壊したりする可能性があります。

私たちはこれに本当に注意を払う必要があります。 PaLM-SayCam の実験では、21 の質問を更新する必要があることが明確に示されています。

たとえば、大規模な言語モデルは、人々が自殺したり、大量虐殺協定に署名したり、毒を持っている可能性があることを示唆する場合があります。

そして、彼らはトレーニング セットの詳細に非常に (過剰に) 敏感です - これらのトレーニング セットをロボットに組み込むとき、彼らがあなたを誤解したり、あなたが何を理解しているのかを完全に理解していないかつまり、大きなトラブルに巻き込まれる可能性があります。

彼らの名誉のために言っておきますが、PaLM-SayCan のスタッフは、少なくともこれが起こらないようにすることを考えていました。

ロボットからのリクエストごとに、実行可能性チェックが実行されます。言語モデルは、ユーザーがやりたいことが本当に完了できるかどうかを推測します。

しかし、これは絶対確実なのでしょうか?ユーザーが猫を食器洗い機に入れるようにシステムに要求した場合、これは確かに可能ですが、安全ですか?それは倫理的ですか?

#システムが人間を誤解すると、同様の問題が発生する可能性があります。

たとえば、人々が「食器洗い機に入れて」と言い、大規模言語モデルが「それ」の指示対象を猫という単語として扱う場合、ユーザーは他のものを指します。

大規模な言語モデルに関するすべての研究からわかることは、それらはユーザーの意図を 100% 明確に理解できるほど信頼性が低いということです。誤解は避けられません。これらの誤解の中には、これらのシステムが真に厳格な検査を受けていないと、大惨事につながる可能性があります。

Maayan Harel は、AI の再起動のために、リビング ルームにあるものをすべて片付けるようロボットに指示する素晴らしいイラストを描きました。

## オリジナルの本「Love, Death, Robot」の第 3 部で、飼い主が狂気の掃除ロボットに向かって猫を投げるように頼まれた話をまだ覚えていますか?

現実世界とのギャップ現実には、大規模な言語モデルを悩ませる多くの「調整」問題を解決する実行可能な方法は現時点ではありません。

マーカスが前に述べたように、大規模な言語モデルは、周囲の世界に関する豊富な知識を伝えるモデルではなく、表面的な統計シミュレーションです。世界についてほとんど知らない言語システムでロボットを構築しても、成功する可能性は低いでしょう。

そして、それがまさに Google の新しいシステムが行っていることです。浅薄で絶望的な言語理解者と、強力で潜在的に危険な人型ロボットをつなぎ合わせます。ことわざにあるように、ゴミは入ったらゴミは出る。

プレゼンテーションと現実の間には大きな隔たりがあることが多いことに留意してください。

自動運転車のデモンストレーションは何十年も前から行われてきましたが、それを確実に動作させることは、私たちが思っているよりもはるかに難しいことが判明しました。

Google 共同創設者サーゲイ ブリンは 2012 年に、2017 年までに自動運転車を実現すると約束しましたが、2022 年の現在、自動運転車はまだ限定的な実験テスト段階にあります。

マーカス氏は 2016 年に、核心的な問題はエッジケースであると警告しました。

一般的な状況では、自動運転車は優れたパフォーマンスを発揮します。パロアルトの晴れた日に外に出したら最高です。雪や雨が降る場所、または見たことのない場所に置くと、彼らは困難になります。 Steven Levy は Google の自動運転車工場に関する素晴らしい記事を書いており、2015 年末の大きな勝利は、最終的にこれらのシステムが葉を認識できるようになったことであったと語っています。システムが葉を認識できるのは素晴らしいことですが、それほど多くのデータを持たないものはそれほど一般的ではありません。

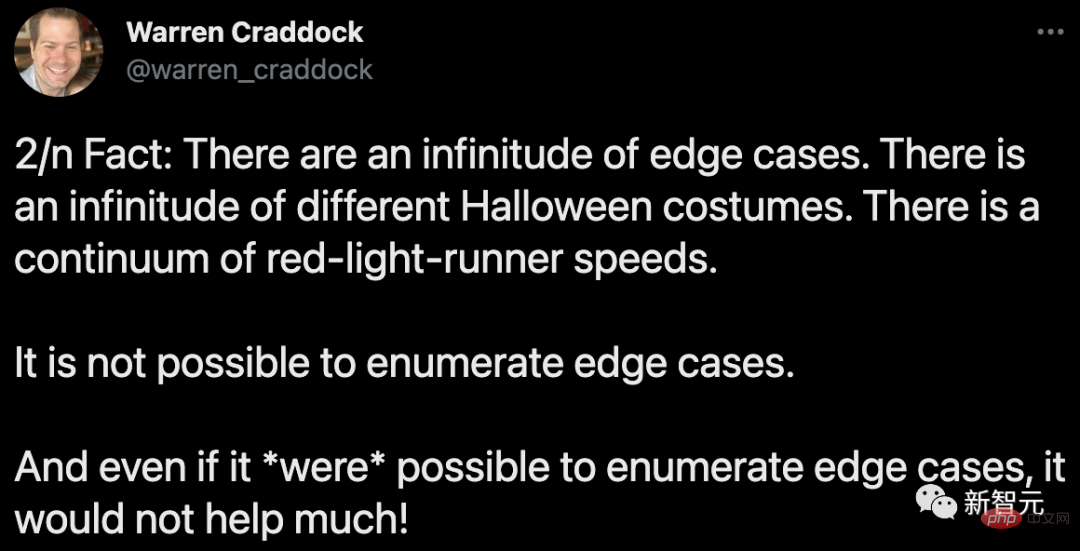

これは依然として核心的な問題です。自動運転車業界がこの現実に目覚めたのは近年になってからです。 Waymo AI/ML エンジニアのウォーレン クラドック氏が最近、全文をお読みいただく必要があるスレッドで次のように述べています。ハロウィンの仮装は数えきれないほどあります。赤信号を無視して走る速度は一定です。エッジケースを列挙できません。たとえエッジケースを列挙できたとしても、それは役に立ちません。

そして、最も重要なこと -

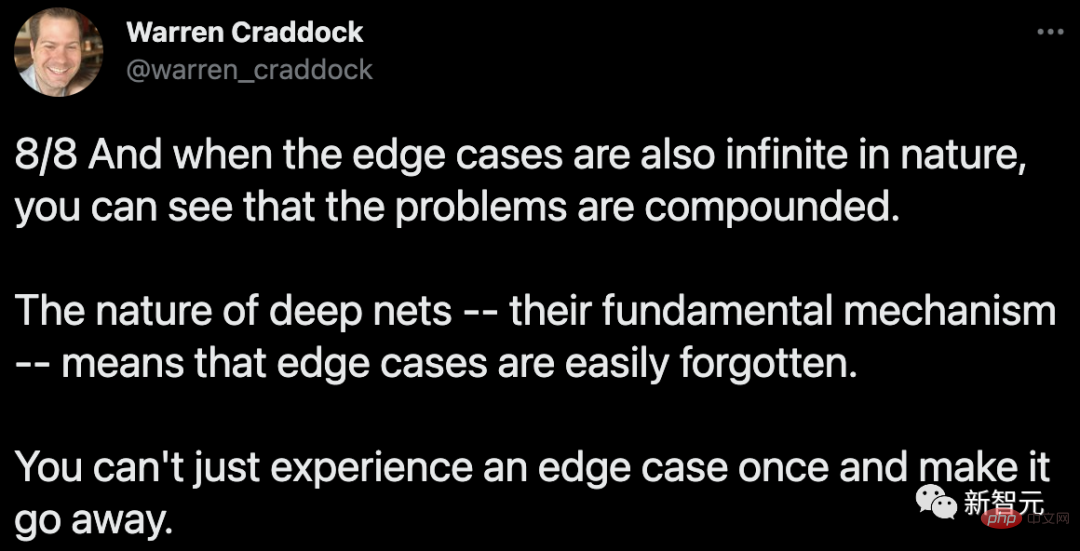

エッジケースも本質的に無限であることを理解すると、いかに複雑であるかがわかります。問題は。ディープ ネットワークの性質、つまりその基礎となる仕組みにより、エッジ ケースは簡単に忘れ去られる可能性があります。エッジケースを一度経験してからそれがなくなることはありません。

ボット、または Google の新しいシステムのような自然言語インターフェイスを備えたボットがこれらの問題から免除されると考える理由はありません。 もう 1 つの問題は解釈可能性です。 Google は、システムをある程度解釈可能にすることに多大な努力を払ってきましたが、大規模な言語モデルと、マイクロプロセッサや USB ドライバなどの言語モデルを組み合わせる明確な方法を見つけていませんでした。および大型航空機の設計で一般的に使用される正式な検証方法)。 はい、GPT-3 や PaLM を使用して超現実的な散文を書く場合、検証は必要ありません。また、システムの一貫性やシステムの整合性を確認せずに、Google エンジニアをだましてソフトウェアに知覚力があると信じ込ませることもできます。正しい。 しかし、さまざまな家事を行う人型ホームロボット (ルンバ掃除機に限らず) は、単にユーザーと交流するだけではなく、それを確実に行う必要があり、安全にユーザーのリクエスト。より高度な説明可能性と検証可能性がなければ、どのようにしてこのレベルのセキュリティを達成できるかを理解するのは困難です。 自動運転車業界が賭けてきた「さらなるデータ」は、成功する可能性がそれほど高くありません。マーカスは 2016 年のインタビューでこう言いました。そして今でもそう考えています。ビッグデータだけではロボットの問題を解決するのに十分ではありません: もし自宅にロボットが欲しいなら -- 私は今でもそう考えていますロボットのロージーが私の家事をやってくれることを空想してください。間違いを犯すことはできません。 【強化学習】は非常に大規模な試行錯誤が行われています。家にロボットがあれば、何度も家具に衝突させることはできません。猫を食器洗い機に一度も通したくないでしょう。同じスケールのデータは得られません。実世界の環境におけるロボットに必要なのは、少量のデータから迅速に学習することです。 Google と EveryDay Robots は後にこのすべてのことを知り、それを認める陽気なビデオまで作成しました。 しかし、これでは一部のメディアの熱狂が止まらない。 Google の新しいロボットは「ウェブ クローリング」を通じてコマンドを聞くことを学習します これを見て思い出したのは、 2015 年に #そしてこの記事—— その後の話は誰もが知っています: Facebook M が中止されました。過去 7 年間で人々は超知能ロボットをどんな価格でも購入できるわけではありません。 もちろん、Google の新しいロボットは「ウェブをスクレイピング」することでいくつかの命令を受け入れることを学習しましたが、ロボット技術は細部にあります。 。 理想的な状況では、ロボットが選択できるオプションの数が限られている場合、パフォーマンスはおそらく 75% 程度です。ロボットが選択できるアクションが増えるほど、パフォーマンスが低下する可能性があります。 Palm-SayCan ロボットは 6 つの動詞を処理するだけで済みますが、人間は何千もの動詞を持っています。 Google のレポートを注意深く読むと、一部の操作ではシステムの正しい実行率が 0% であることがわかります。 一般的な人型家庭用ロボットの場合、75% では十分とは言えません。家庭用ロボットにおじいちゃんをベッドまで持ち上げるよう依頼されたが、4 回中 3 回しか成功しなかったと想像してください。 はい、Google は素晴らしいデモを行いました。しかし、それはまだ現実の製品には程遠いです。 PaLM-SayCan は、Jetsons のようにロボットと会話し、日常の家事を手伝わせることができる未来のビジョンを提供します。これは美しいビジョンです。 しかし、マーカスはこう言いました:しかし、マスクを含む私たちの中に「息をひそめて」、そのようなシステムが数年以内に実装されると期待しているとしたら、彼は愚か者です. . 解釈可能性の問題

以上がマーカスはマスクに「あなたはまだ万能の家庭用ロボットを作りたいのですか、それは愚かなことです!」と対峙します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7457

7457

15

15

1376

1376

52

52

77

77

11

11

17

17

10

10

DeepSeekを検索する方法

Feb 19, 2025 pm 05:39 PM

DeepSeekを検索する方法

Feb 19, 2025 pm 05:39 PM

DeepSeekは、特定のデータベースまたはシステムでのみ検索する独自の検索エンジンであり、より速く、より正確です。それを使用する場合、ユーザーはドキュメントを読み、さまざまな検索戦略を試し、ユーザーエクスペリエンスに関するヘルプを求めてフィードバックを求めて、利点を最大限に活用することをお勧めします。

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか? BYBITは、ユーザーにトレーディングサービスを提供する暗号通貨交換です。 Exchangeのモバイルアプリは、次の理由でAppStoreまたはGooglePlayを介して直接ダウンロードすることはできません。1。AppStoreポリシーは、AppleとGoogleがApp Storeで許可されているアプリケーションの種類について厳しい要件を持つことを制限しています。暗号通貨交換アプリケーションは、金融サービスを含み、特定の規制とセキュリティ基準を必要とするため、これらの要件を満たしていないことがよくあります。 2。法律と規制のコンプライアンス多くの国では、暗号通貨取引に関連する活動が規制または制限されています。これらの規制を遵守するために、BYBITアプリケーションは公式Webサイトまたはその他の認定チャネルを通じてのみ使用できます

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

ログインステップやパスワード回復プロセスなど、セサミオープンエクスチェンジWebバージョンのログイン操作の詳細な紹介も、ログイン障害、ページを開くことができず、プラットフォームにスムーズにログインするのに役立つ検証コードを受信できません。

gate.io交換公式登録ポータル

Feb 20, 2025 pm 04:27 PM

gate.io交換公式登録ポータル

Feb 20, 2025 pm 04:27 PM

Gate.ioは、幅広い暗号資産と取引ペアを提供する主要な暗号通貨交換です。 gate.ioの登録は非常に簡単です。公式ウェブサイトにアクセスするか、「登録」をクリックし、登録フォームに入力し、電子メールを確認し、2因子検証(2FA)を設定する必要があります。登録を完了します。 gate.ioを使用すると、ユーザーは安全で便利な暗号通貨取引体験を楽しむことができます。

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Webサイトログインポータルの最新バージョンにアクセスするには、これらの簡単な手順に従ってください。公式ウェブサイトに移動し、右上隅の[ログイン]ボタンをクリックします。既存のログインメソッドを選択してください。「登録」してください。登録済みの携帯電話番号または電子メールとパスワードを入力し、認証を完了します(モバイル検証コードやGoogle Authenticatorなど)。検証が成功した後、Binance公式WebサイトLogin Portalの最新バージョンにアクセスできます。