2022 年に ML 研究がサークルから外される: 人気の安定した拡散、ゼネラリストエージェントの Gato、LeCun のリツイート

2022年も終わりに近づいてきました。この年、機械学習の分野で多数の貴重な論文が発表され、機械学習コミュニティに大きな影響を与えました。

本日、ML および NLP 研究者、メタ AI テクノロジー製品マーケティング マネージャー、DAIR.AI 創設者の Elvis S. が、2022 年に注目を集めた 12 件の機械学習論文をまとめました。この投稿は急速に広まり、チューリング賞受賞者のヤン・ルカン氏によってリツイートされた。

#次に、1 つずつ見ていきましょう。

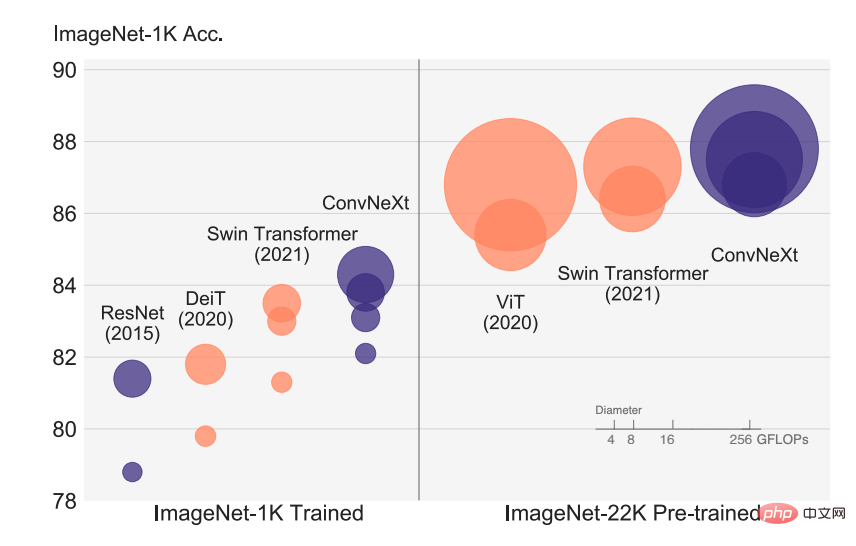

論文 1: 2020 年代の ConvNet

視覚認識の急速な発展は ViT の導入から始まり、ViT は従来の認識をすぐに置き換えました。 ConvNet 、SOTA 画像分類モデルになります。 ViT モデルには、ターゲット検出、セマンティック セグメンテーションなどの一連のコンピューター ビジョン タスクにおいて多くの課題があります。したがって、一部の研究者は階層型 Swin Transformer を提案し、以前に ConvNet を再導入し、Transformer を一般的なビジュアル バックボーンとして実際に実現可能にし、さまざまなビジュアル タスクで優れたパフォーマンスを示しました。

ただし、このハイブリッド アプローチの有効性は、依然として、畳み込みに固有の誘導バイアスではなく、Transformer 固有の利点によるところが大きいです。この記事では、FAIR と UC Berkeley の研究者が設計空間を再調査し、純粋な ConvNet が達成できる限界をテストしました。研究者たちは、標準の ResNet を視覚的な Transformer 設計に徐々に「アップグレード」し、その過程で、パフォーマンスの違いを引き起こすいくつかの重要なコンポーネントを発見しました。

論文アドレス: https://arxiv.org/abs/2201.03545v2

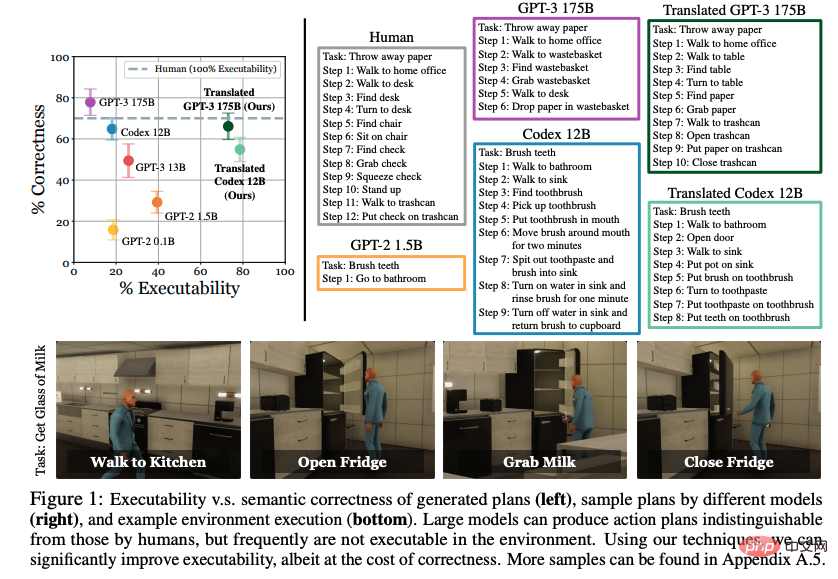

論文 2: ゼロショット プランナーとしての言語モデル: 身体化されたエージェントのための実用的な知識の抽出大規模言語モデル (LLM) を通じて学んだ世界の知識インタラクティブ環境でのアクションに使用されますか?この論文では、カリフォルニア大学バークレー校、CMU、および Google の研究者が、選択された実行可能なステップのセットとして自然言語を表現する可能性を調査しています。これまでの研究では、明示的に配布された例から行動方法を学習することに焦点を当てていましたが、驚くべきことに、事前トレーニングされた言語モデルが十分に大きく、適切なヒントが与えられていれば、さらなるトレーニングを行わなくても、高レベルのタスクを効果的に中レベルの計画に分解できることがわかりました。ただし、LLM によって作成された計画は、許容可能なアクションに正確に対応していないことがよくあります。

研究者によって提案された手順は、既存の実証を条件とし、計画を許容可能なアクションに意味論的に変換します。 VirtualHome 環境での評価では、提案されたアプローチにより LLM ベースラインの実行可能性が大幅に向上することが示されています。人間による評価では、強制力と正確性の間のトレードオフが明らかになりますが、言語モデルから実用的な知識を抽出できる可能性の兆しが示されています。

文書アドレス: https://arxiv.org/abs/2201.07207v2

文書アドレス: https://arxiv.org/abs/2201.07207v2

#論文 3: OFA: シンプルなシーケンスツーシーケンス学習フレームワークによるアーキテクチャ、タスク、およびモダリティの統合

これは Alibaba Damo Academy です。統合されたマルチモーダル マルチタスク モデル フレームワーク OFA は、この段階で一般モデルが最もよく満たす 3 つの特性、すなわちモダリティの独立性、タスクの独立性、およびタスクの多様性を要約しています。この論文は ICML 2022 に採択されました。

グラフィックスとテキストの分野では、OFA は、統一された seq2seq フレームワークと共有を通じて、ビジュアル グラウンディング、VQA、画像キャプション、画像分類、text2image 生成、言語モデリングなどの古典的なタスクを表します。追加のパラメータ構造を追加することなく、タスク間で異なるモードの入力と出力を行い、Finetune と事前トレーニングの一貫性を実現します。

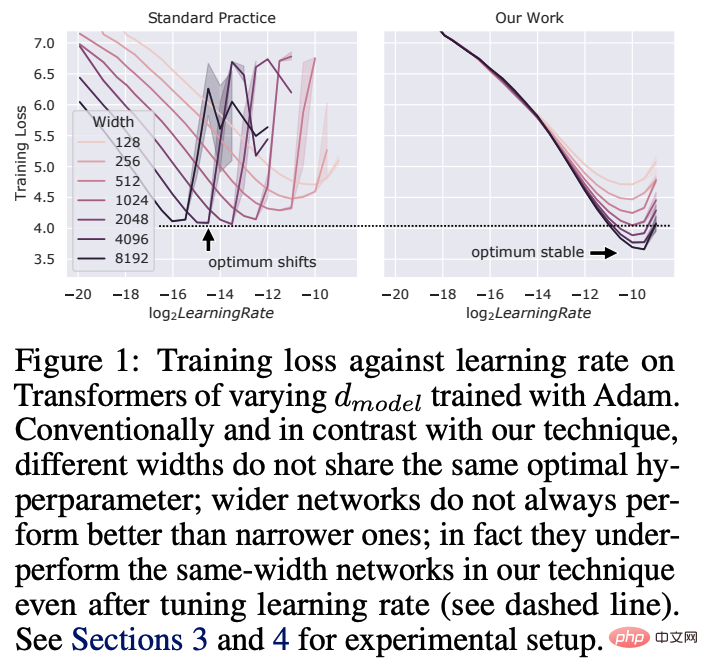

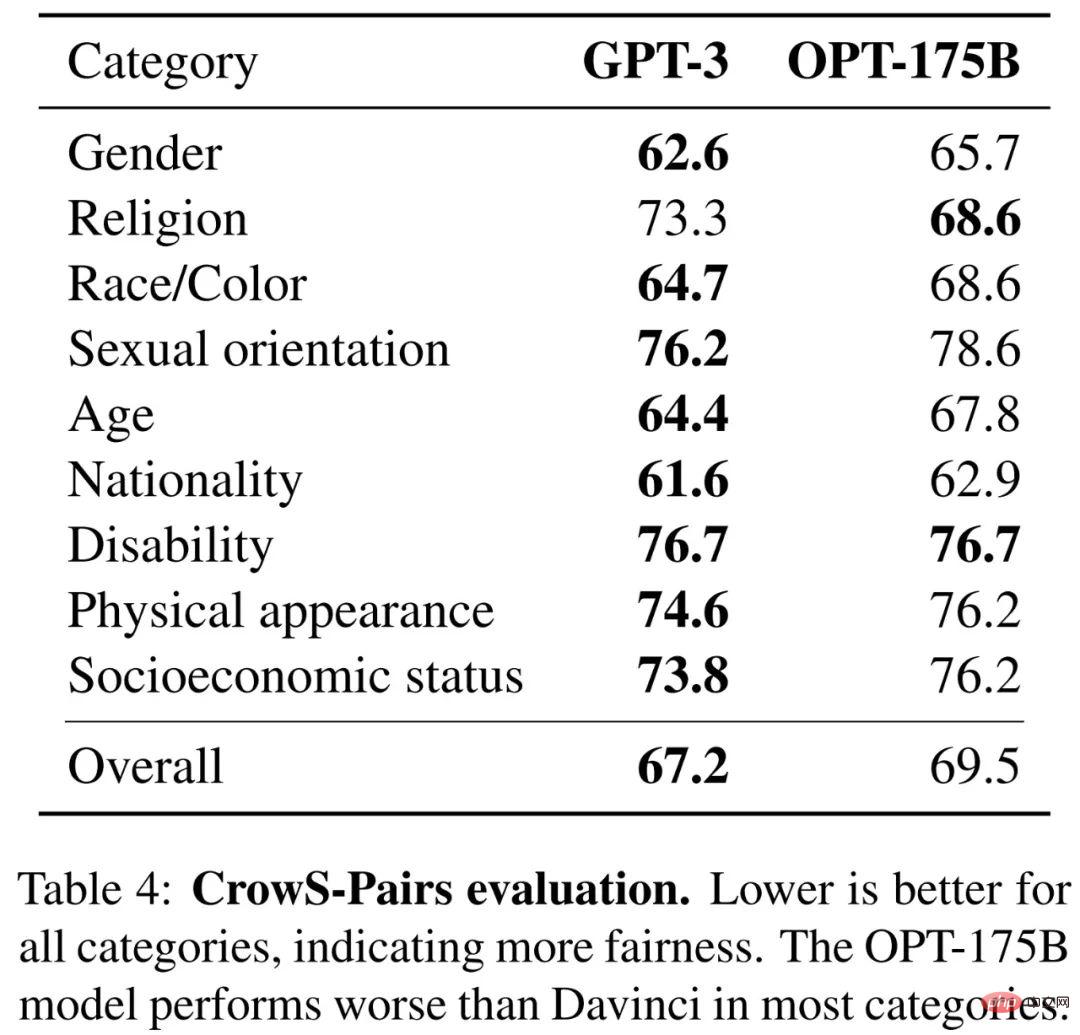

論文アドレス: https://arxiv.org/abs/2202.03052v2 #論文 4: Tensor プログラム V: 大規模なチューニングゼロショット ハイパーパラメータ転送によるニューラル ネットワーク ディープ ラーニングにおけるハイパーパラメータ (HP) チューニングは、数十億のパラメータを持つニューラル ネットワークにとってコストのかかるプロセスです。これは特にインターネットに当てはまります。 。この論文では、Microsoft と OpenAI の研究者が、最近発見された Maximal Update Parametrization (muP) では、モデル サイズが変化しても多くの最適な HP が安定していることを示しています。 これにより、muTransfer と呼ばれる新しい HP チューニング パラダイムが生まれ、muP でターゲット モデルをパラメータ化し、小規模なモデルに対して HP チューニングを直接実行しません。これは、後者のモデルを直接調整する必要がまったくないことも意味します。研究者は、Transformer と ResNet で muTransfer を検証しました。たとえば、4,000 万のパラメーター モデルから移行すると、事前トレーニングの合計コストのわずか 7% の調整コストで、公開されている 6.7B GPT-3 モデルよりもパフォーマンスが向上します。 文書アドレス: https://arxiv.org/abs/2203.03466v2 大規模なモデルは、多くの場合、数千日の計算期間にわたってトレーニングされます。サンプルと数ショット学習。しかし、計算コストを考慮すると、適切な資金がなければ、これらの大規模なモデルを複製するのは困難です。 API を通じて利用できるいくつかのモデルでは、完全なモデルの重みにアクセスできないため、研究が困難になります。 この記事では、メタ AI 研究者が Open Pre-trained Transformers (OPT) を提案しました。これは、125M から 175B の範囲のパラメーターを持つ、デコーダー専用の事前トレーニング済みトランスフォーマー モデルのセットです。不定。彼らは、OPT-175B が GPT-3 と同等の性能を発揮しながら、開発に必要な二酸化炭素排出量はわずか 1/7 であることを示しました。

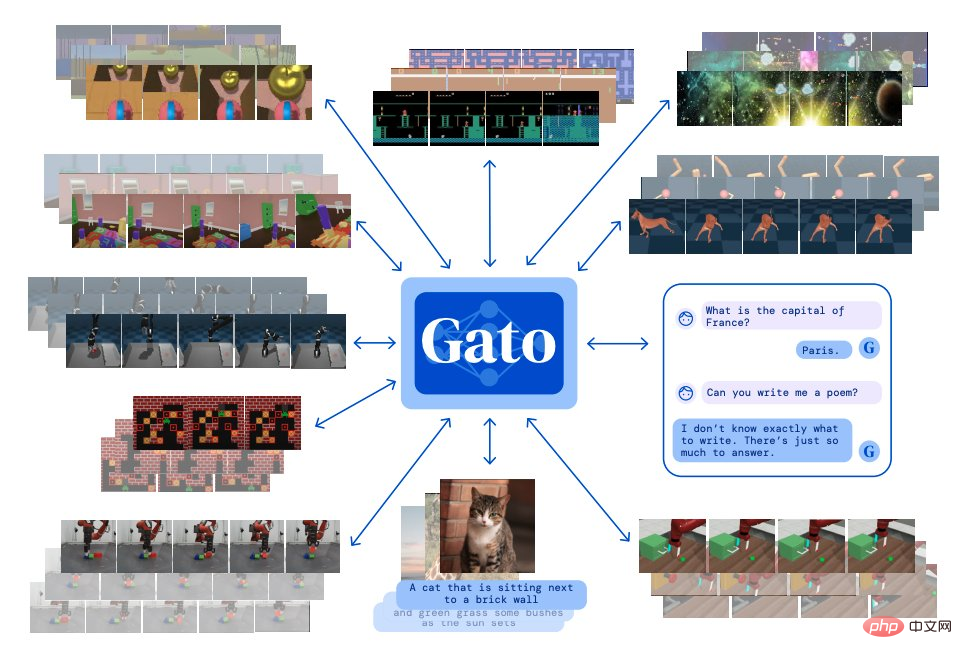

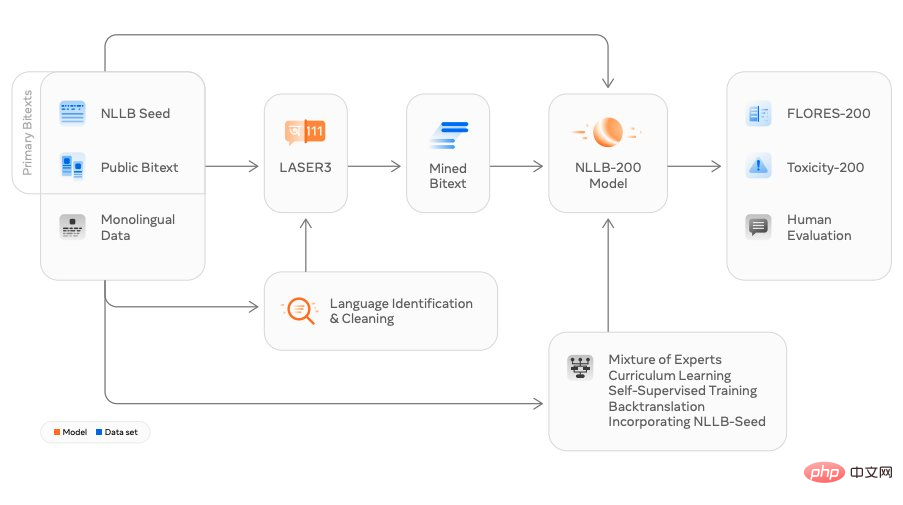

#論文 6: ジェネラリスト エージェント #大規模言語モデリングに触発されて、Deepmind は単一の「ジェネラリスト」エージェント Gato を構築しました。モーダル、マルチタスク、およびマルチ実施形態の特性。 Gato は、Atari ゲームをプレイしたり、写真の字幕を出力したり、他のユーザーとチャットしたり、ロボット アームでブロックを積み上げたりすることができます。さらに、Gato はコンテキストに基づいて、テキスト、関節トルク、ボタンの押下、またはその他のトークンを出力するかどうかを決定できます。 ゲームをプレイするほとんどのエージェントとは異なり、Gato はゲームごとに個別にトレーニングするのではなく、同じトレーニング モデルを使用して多くのゲームをプレイできます。 文書アドレス: https://arxiv.org/abs/2205.06175v3 #論文 7: 言語モデルを使用した定量的推論の問題の解決 Google の研究者は、Minerva と呼ばれる深層学習言語モデルを提案しました。定量的な数学的問題は、次の方法で解決できます。段階的な推論。そのソリューションには、電卓などの外部ツールに依存しない数値計算や記号操作が含まれます。 さらに、Minerva は、小さなサンプル プロンプト、思考連鎖、スクラッチパッド プロンプト、多数決の原則などのさまざまなテクニックを組み合わせて、STEM 推論タスクで SOTA パフォーマンスを実現します。 Minerva は、PaLM (Pathways Language Model) に基づいて構築されており、118GB データ セットでさらにトレーニングされています。データ セットは、arXiv の科学および技術論文から取得されており、次の使用が含まれています。 LaTeX と MathJax、またはさらなるトレーニングのための Web ページ データの他の数学的表現。 下の図は、ミネルヴァが問題を解決する方法の例を示しています: 紙アドレス: https://arxiv.org/abs/2206.14858 #論文 8: 言語を取り残さない: 人間中心の機械翻訳のスケーリング Meta AI の研究者は、翻訳モデル NLLB (No Language Left Behind) をリリースしました。これは、直訳すると「言語を置き去りにすることはできません」という意味で、中国語を除く 200 言語間のあらゆる翻訳をサポートできます。 、英語、フランス語、日本語一般的に使用される言語への翻訳に加え、NLLB はルガンダ、ウルドゥー語などの多くのニッチな言語への翻訳も可能です。 Meta は、これが単一のモデルを使用して複数の言語に翻訳される世界初のデザインであると主張しており、これを利用して、より多くの人々がソーシャル プラットフォーム上で言語を越えて交流できるようにしたいと考えています。同時に、将来のメタバースにおけるユーザーのインタラクティブ エクスペリエンスも向上します。 論文アドレス: https://arxiv.org/abs/2207.04672v3 論文 9: 潜在拡散モデルによる高解像度画像合成 この研究は、ミュンヘン大学の研究者とランウェイの CVPR 2022 論文「潜在拡散モデルによる高解像度画像合成」に基づいており、Eleuther AI や LAION などのチームと協力しています。仕上げる。 Stable Diffusion は、10 GB VRAM を備えたコンシューマ グレードの GPU で実行でき、前処理や後処理を行わずに 512x512 ピクセルの画像を数秒で生成できます。 わずか 4 か月で、このオープンソース プロジェクトは 38,000 個のスターを獲得しました。

安定拡散生成画像の表示例:

OpenAIは、英語音声認識において人間レベルに近く、精度が高いオープンソースモデルWhisperをリリースしました。 Whisper は自動音声認識 (ASR、Automatic Speech Recognition) システムで、OpenAI は 98 言語、680,000 時間分のマルチタスク監視データをインターネットから収集しました。音声認識に加えて、Whisper は複数の言語を文字に起こし、それらの言語を英語に翻訳することもできます。

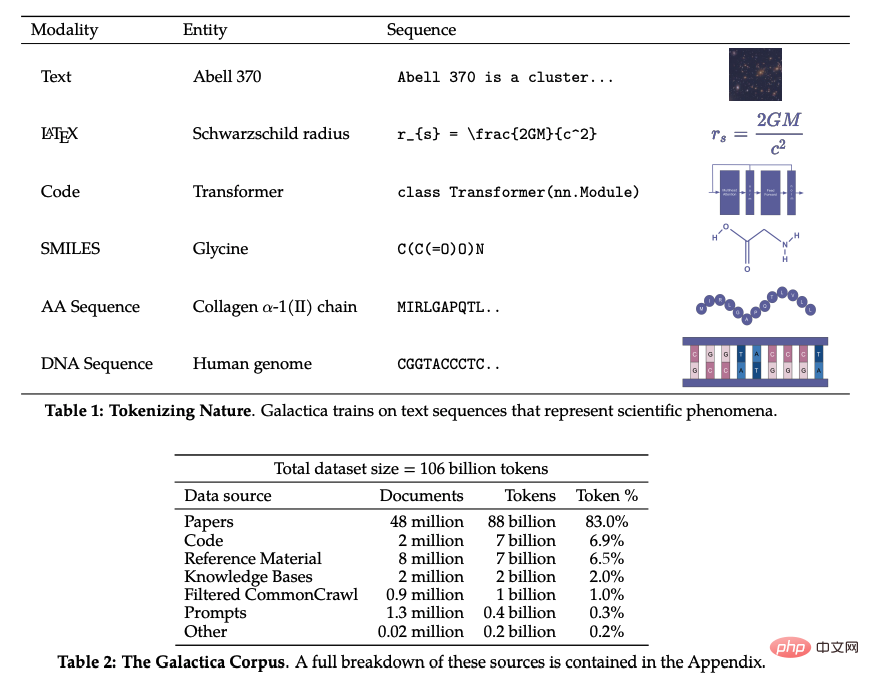

論文アドレス: https://arxiv.org/abs/2212.04356 #論文 11: ビデオの作成: テキストテキストビデオ データを使用しないビデオへの生成 Meta AI の研究者は、最先端のテキストからビデオへのモデルである Make-A-Video を提案しました。 , 指定されたテキスト プロンプトからビデオを生成できます。 Make-A-Video には 3 つの利点があります: (1) T2V (Text-to-Video) モデルのトレーニングを加速し、視覚的表現やマルチモーダル表現を学習する必要がありません。スクラッチ 、(2) ペアになったテキストとビデオのデータは必要ありません、(3) 生成されたビデオは、今日の画像生成モデルのいくつかの利点を継承します。 このテクノロジーは、テキストからビデオへの生成を可能にし、わずか数語または数行のテキストを使用してユニークなビデオを作成できるように設計されています。下の写真は、スーパーヒーローの服と赤いマントを着て空を飛んでいる犬を示しています: 紙のアドレス: https:// arxiv.org/abs/2209.14792 論文 12: ギャラクティカ: 科学のための大規模言語モデル 近年、さまざまな主題分野の研究の進歩に伴い、科学文献やデータが爆発的に増加しており、学術研究者が大量の情報から有用な洞察を発見することがますます困難になっています。通常、人は科学知識を得るために検索エンジンを利用しますが、検索エンジンは科学知識を自律的に整理することができません。 最近、Meta AI の研究チームは、科学的知識を保存、結合、推論できる新しい大規模言語モデルである Gaoptica を提案しました。ギャラクティカはレビュー論文を要約し、エントリの百科事典クエリを生成し、質問に対して知識豊富な回答を提供できます。 論文アドレス: https://arxiv.org/abs/2211.09085

文書アドレス: https://arxiv.org/abs/2205.01068v4

文書アドレス: https://arxiv.org/abs/2205.01068v4

##論文 10: 大規模な弱い監視による堅牢な音声認識

##論文 10: 大規模な弱い監視による堅牢な音声認識

以上が2022 年に ML 研究がサークルから外される: 人気の安定した拡散、ゼネラリストエージェントの Gato、LeCun のリツイートの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1677

1677

14

14

1431

1431

52

52

1334

1334

25

25

1280

1280

29

29

1257

1257

24

24

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

学習曲線を通じて過学習と過小学習を特定する

Apr 29, 2024 pm 06:50 PM

学習曲線を通じて過学習と過小学習を特定する

Apr 29, 2024 pm 06:50 PM

この記事では、学習曲線を通じて機械学習モデルの過学習と過小学習を効果的に特定する方法を紹介します。過小適合と過適合 1. 過適合 モデルがデータからノイズを学習するためにデータ上で過学習されている場合、そのモデルは過適合していると言われます。過学習モデルはすべての例を完璧に学習するため、未確認の新しい例を誤って分類してしまいます。過適合モデルの場合、完璧/ほぼ完璧なトレーニング セット スコアとひどい検証セット/テスト スコアが得られます。若干修正: 「過学習の原因: 複雑なモデルを使用して単純な問題を解決し、データからノイズを抽出します。トレーニング セットとしての小さなデータ セットはすべてのデータを正しく表現できない可能性があるため、2. 過学習の Heru。」

宇宙探査と人類居住工学における人工知能の進化

Apr 29, 2024 pm 03:25 PM

宇宙探査と人類居住工学における人工知能の進化

Apr 29, 2024 pm 03:25 PM

1950 年代に人工知能 (AI) が誕生しました。そのとき、研究者たちは、機械が思考などの人間と同じようなタスクを実行できることを発見しました。その後、1960 年代に米国国防総省は人工知能に資金を提供し、さらなる開発のために研究所を設立しました。研究者たちは、宇宙探査や極限環境での生存など、多くの分野で人工知能の応用を見出しています。宇宙探査は、地球を超えた宇宙全体を対象とする宇宙の研究です。宇宙は地球とは条件が異なるため、極限環境に分類されます。宇宙で生き残るためには、多くの要素を考慮し、予防策を講じる必要があります。科学者や研究者は、宇宙を探索し、あらゆるものの現状を理解することが、宇宙の仕組みを理解し、潜在的な環境危機に備えるのに役立つと信じています。

透明!主要な機械学習モデルの原理を徹底的に分析!

Apr 12, 2024 pm 05:55 PM

透明!主要な機械学習モデルの原理を徹底的に分析!

Apr 12, 2024 pm 05:55 PM

平たく言えば、機械学習モデルは、入力データを予測された出力にマッピングする数学関数です。より具体的には、機械学習モデルは、予測出力と真のラベルの間の誤差を最小限に抑えるために、トレーニング データから学習することによってモデル パラメーターを調整する数学関数です。機械学習には、ロジスティック回帰モデル、デシジョン ツリー モデル、サポート ベクター マシン モデルなど、多くのモデルがあります。各モデルには、適用可能なデータ タイプと問題タイプがあります。同時に、異なるモデル間には多くの共通点があったり、モデル進化の隠れた道が存在したりすることがあります。コネクショニストのパーセプトロンを例にとると、パーセプトロンの隠れ層の数を増やすことで、それをディープ ニューラル ネットワークに変換できます。パーセプトロンにカーネル関数を追加すると、SVM に変換できます。これです

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

MetaFAIR はハーバード大学と協力して、大規模な機械学習の実行時に生成されるデータの偏りを最適化するための新しい研究フレームワークを提供しました。大規模な言語モデルのトレーニングには数か月かかることが多く、数百、さらには数千の GPU を使用することが知られています。 LLaMA270B モデルを例にとると、そのトレーニングには合計 1,720,320 GPU 時間が必要です。大規模なモデルのトレーニングには、これらのワークロードの規模と複雑さにより、特有のシステム上の課題が生じます。最近、多くの機関が、SOTA 生成 AI モデルをトレーニングする際のトレーニング プロセスの不安定性を報告しています。これらは通常、損失スパイクの形で現れます。たとえば、Google の PaLM モデルでは、トレーニング プロセス中に最大 20 回の損失スパイクが発生しました。数値的なバイアスがこのトレーニングの不正確さの根本原因です。