魔法を使って魔法を倒せ!人間のトップ棋士に匹敵する囲碁AIが同業者に敗れた

近年、セルフゲームにおける強化学習は、囲碁やチェスなどの一連のゲームにおいて超人的なパフォーマンスを達成しています。さらに、理想化されたセルフプレイもナッシュ均衡に収束します。ナッシュ均衡はゲーム理論で非常に有名です. これはゲーム理論の創始者でありノーベル賞受賞者であるジョン・ナッシュによって提唱されました. ゲームの過程において、相手の戦略の選択に関係なく、一方は特定の戦略を選択します. .戦略のことをドミナント戦略といいます。他のすべてのプレーヤーの戦略が決定されているときに、いずれかのプレーヤーが最適な戦略を選択する場合、この組み合わせはナッシュ均衡として定義されます。

これまでの研究では、セルフ ゲームにおける一見効果的であるように見える継続的制御戦略も、対策によって悪用される可能性があることが示されており、セルフ ゲームはこれまで考えられていたほど強力ではない可能性があることが示唆されています。これは次の疑問につながります: 対決戦略はセルフゲームを克服する方法なのでしょうか、それともセルフゲーム戦略自体は不十分なのでしょうか?

この質問に答えるために、MIT、カリフォルニア大学バークレー校などの研究者が調査を行った結果、セルフゲームで得意な分野、つまり囲碁を選択しました。具体的には、公開されている最強の囲碁 AI システムである KataGo に対する攻撃を実行しました。固定ネットワーク (KataGo をフリーズ) の場合、エンドツーエンドの敵対的戦略をトレーニングしました。KataGo をトレーニングする際の計算のわずか 0.3% を使用して、敵対的戦略を取得し、この戦略を使用して KataGo を攻撃しました。この場合、彼らの戦略はKataGo に対して 99% の勝率を達成しました。これは、ヨーロッパのトップ 100 の囲碁プレイヤーに匹敵します。そして、KataGo が超人レベルに近づくほど十分な検索を使用したとき、勝率は 50% に達しました。重要なことは、攻撃者(この論文では、この研究で学んだ戦略を指します)は、一般的な囲碁戦略を学習しても勝つことはできません。

ここで KataGo について話します。この記事にあるように、この記事を書いた時点では KataGo はまだ最も強力なパブリック Go AI システムでした。検索のサポートにより、KataGo は非常に強力であり、それ自体が超人である ELF OpenGo や Leela Zero を破ったと言えます。今回の研究の攻撃者は、非常に強力であると言える KataGo を破りました。

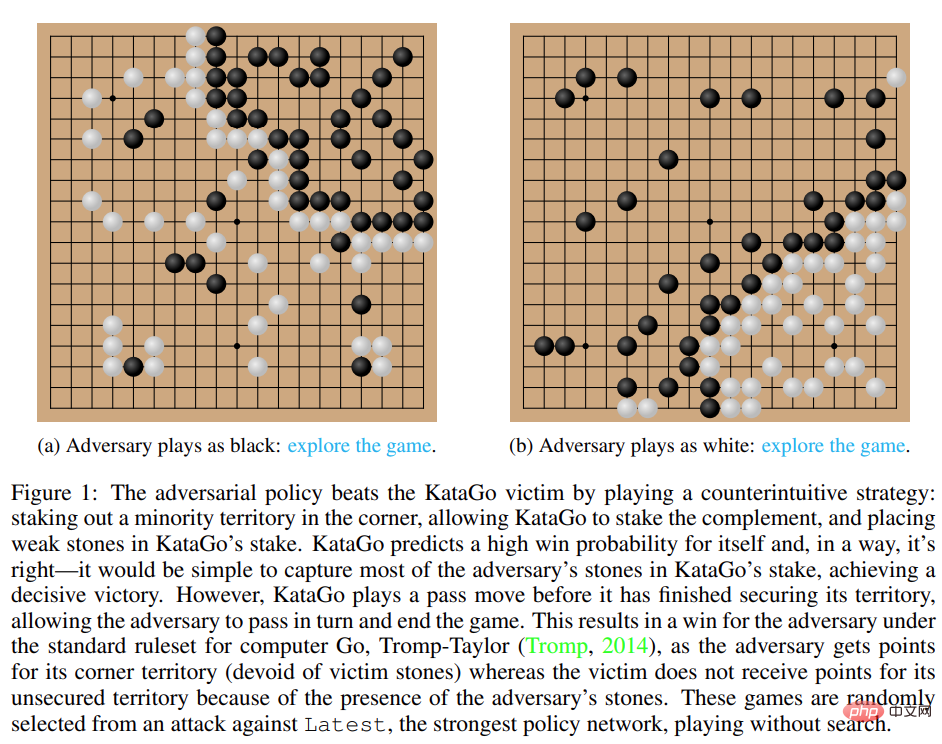

# 図 1: 敵対的戦略が KataGo の被害者を破る。

- #論文アドレス: https://arxiv.org/pdf/2211.00241.pdf #研究ホームページ: https://go Attack.alignmentfund.org/adversarial-policy-katago?row=0#no_search-board

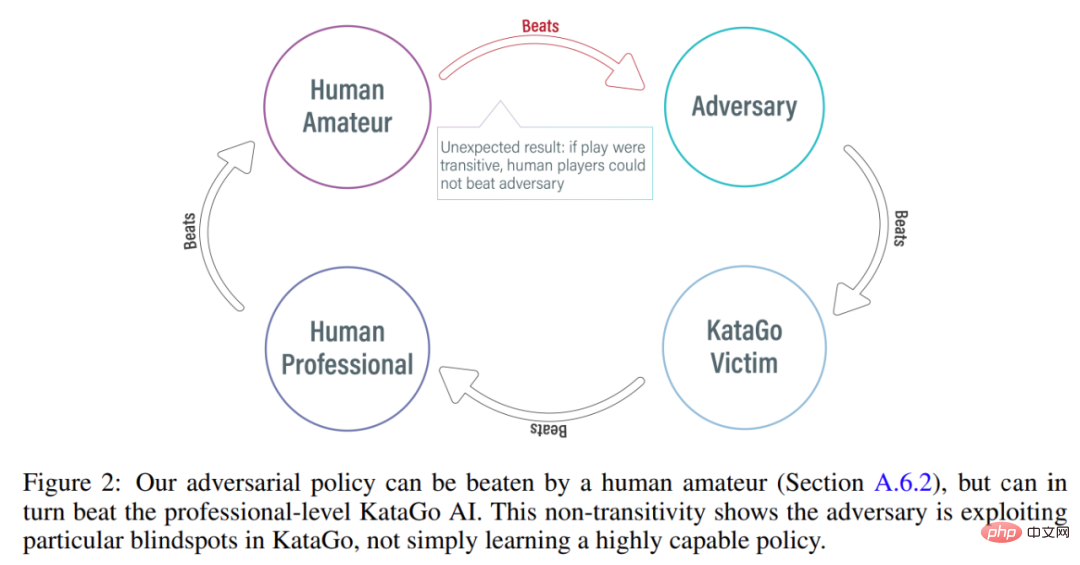

- #興味深いことに、この研究で提案された敵対的戦略は人間のプレイヤーに勝つことはできず、アマチュア プレイヤーでも提案されたモデルを大幅に上回る可能性があります。

攻撃方法

KataGo や AlphaZero などの以前の方法では、通常、エージェントが単独でゲームをプレイするようにトレーニングされ、ゲームの対戦相手はエージェントそのものです。 MIT、カリフォルニア大学バークレー校などによるこの研究では、攻撃者(敵対者)と固定された被害者(被害者)のエージェントの間でゲームが行われ、攻撃者はこのように訓練されます。この研究では、単にゲームの対戦相手を模倣するのではなく、被害者エージェントとのゲームのやり取りを悪用するように攻撃者を訓練することを目指しています。このプロセスは「被害者プレイ」と呼ばれます。

従来のセルフ ゲームでは、エージェントは自身のポリシー ネットワークからサンプリングすることで対戦相手の行動をモデル化しますが、このアプローチは実際に機能します。自己。しかし、被害者プレイでは、攻撃者のポリシー ネットワークから被害者をモデル化することは間違ったアプローチです。この問題を解決するために、この研究では次の 2 種類の敵対的 MCTS (A-MCTS) を提案します。

従来のセルフ ゲームでは、エージェントは自身のポリシー ネットワークからサンプリングすることで対戦相手の行動をモデル化しますが、このアプローチは実際に機能します。自己。しかし、被害者プレイでは、攻撃者のポリシー ネットワークから被害者をモデル化することは間違ったアプローチです。この問題を解決するために、この研究では次の 2 種類の敵対的 MCTS (A-MCTS) を提案します。

- A-MCTS-S: A-MCTS-S では、研究者は攻撃者の検索プロセスを次のように設定します: 被害者がチェスの駒を動かしたとき、被害者の戦略ネットワークからサンプルを取得します。攻撃者が駒を動かす番になると、攻撃者のポリシー ネットワークからサンプルが取得されます。

- A-MCTS-R: A-MCTS-S は被害者の能力を過小評価しているため、この研究では、A-MCTS-R ツリーで A-MCTS-R を提案しています。各被害者ノード上の被害者。ただし、この変更により、攻撃者のトレーニングと推論の計算の複雑さが増加します。

研究では、トレーニング中に、凍結された KataGo 被害者に対するゲームに対する敵対的戦略をトレーニングしました。検索を行わない場合、攻撃者は KataGo の被害者に対して 99% を超える勝率を達成できます。これは、ヨーロッパのトップ 100 の囲碁プレイヤーに匹敵します。さらに、訓練された攻撃者は、被害者エージェントとの 64 ラウンドの対戦で 80% 以上の勝率を達成しました。研究者らは、これは人間の最高の囲碁プレイヤーに匹敵すると推定しています。

これらの対局は、この研究で提案された対策が完全にゲーム的なものではなく、むしろ KataGo をだまして攻撃者に有利な位置に配置させることを示していることに注目する価値があります。 。実際、攻撃者は人間の最高の囲碁プレイヤーと同等のゲーム戦略を悪用することができましたが、人間のアマチュアには簡単に敗北しました。

攻撃者の人間との対戦能力をテストするために、この研究では、論文の筆頭著者である Tony Tong Wang に実際に攻撃者モデルと対戦するよう依頼しました。王氏はこの研究プロジェクトの前に囲碁を習ったことがなかったが、それでも攻撃者モデルに大差をつけて勝った。これは、この研究で提案された敵対的戦略は、人間のトッププレイヤーを倒すことができる AI モデルを倒すことはできるが、人間のプレイヤーには勝つことができないことを示しています。これは、一部の AI Go モデルにバグがあることを示している可能性があります。

評価結果

攻撃被害者ポリシー ネットワーク

まず、研究者らは自分自身を評価しました。 KataGo のパフォーマンスに基づいて攻撃方法を評価したところ (Wu, 2019)、A-MCTS-S アルゴリズムは検索不要の Most (KataGo の最新ネットワーク) に対して 99% 以上の勝率を達成したことがわかりました。

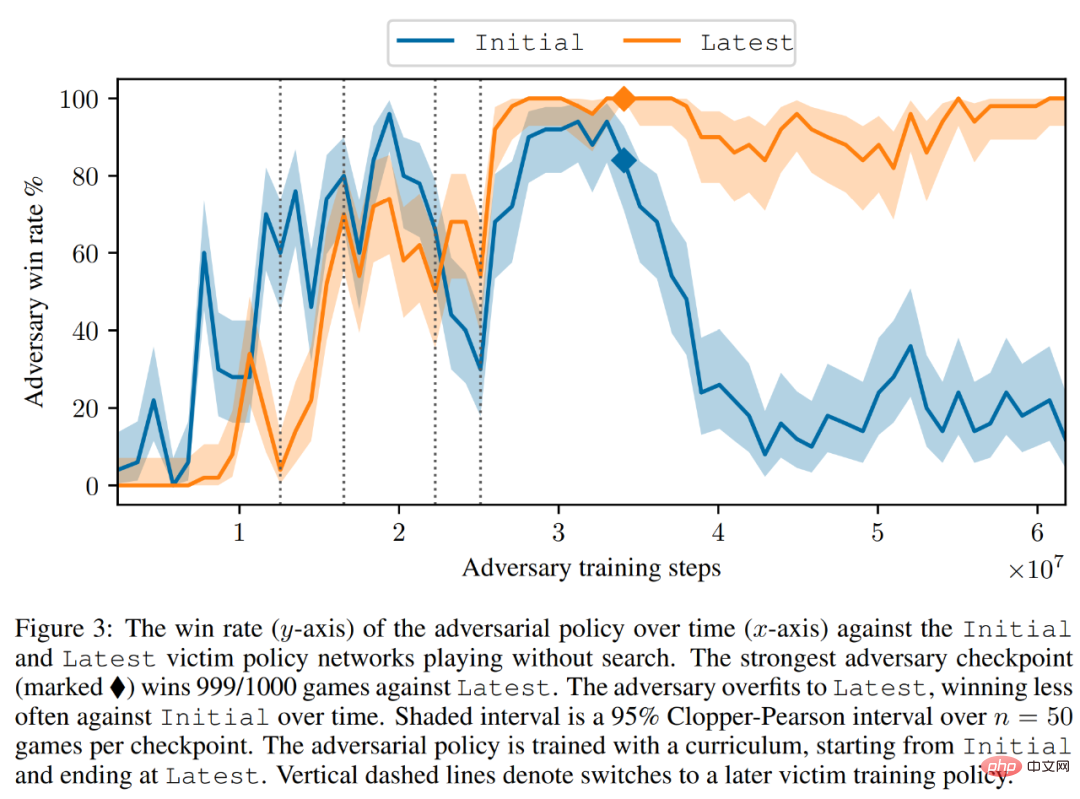

以下の図 3 に示すように、研究者は初期および最新のポリシー ネットワークでの自己対決戦略のパフォーマンスを評価しました。彼らは、トレーニングのほとんどの間、自己攻撃者が両方の被害者に対して高い勝率 (90% 以上) を達成したことを発見しました。しかし、時間が経つにつれて、攻撃者は最新型に過剰適合し、初期型に対する勝率は約 20% に低下します。

研究者らは、Late に対する最良の対抗戦略チェックポイントも評価し、99% 以上の勝率を達成しました。さらに、このような高い勝率は、敵対的戦略がわずか 3.4 × 10^7 タイム ステップ (被害者のタイム ステップの 0.3%) でトレーニングされている間に達成されます。

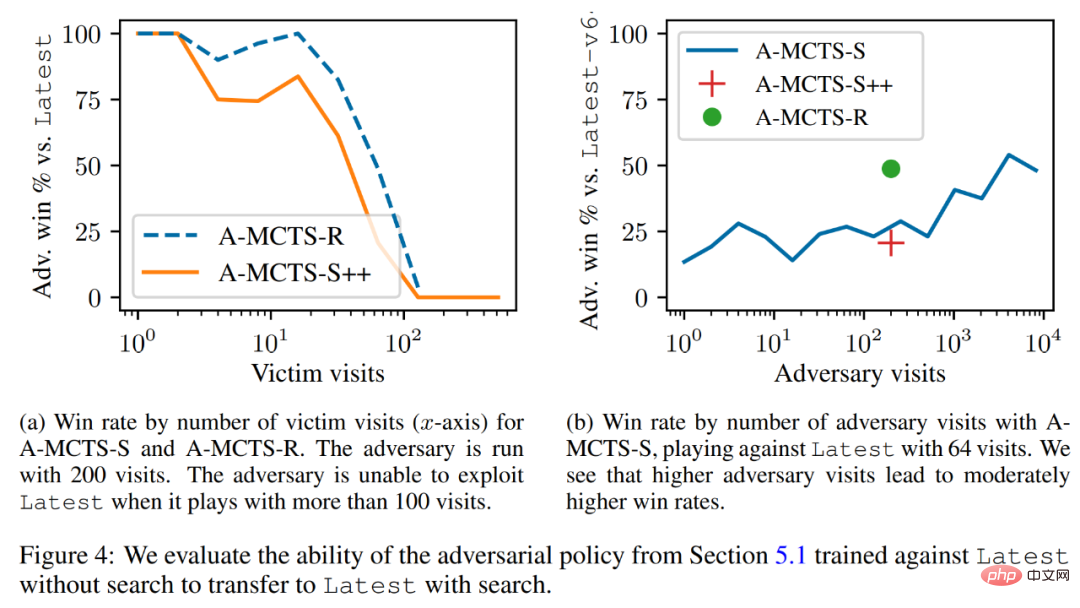

検索で被害者に移行する

研究者は敵対的戦略を行うは低位検索メカニズムに正常に移行され、前のセクションで訓練された敵対的戦略が最新を検索する能力について評価されました。以下の図 4a に示すように、被害者に対する A-MCTS-S の勝率は、被害者ラウンド 32 回で 80% に低下したことがわかりました。しかし、ここでは、被害者はトレーニングと推論中に検索を行いません。

さらに、研究者らは A-MCTS-R もテストし、被害者ラウンド数が 32 でパフォーマンスが優れていることを発見しました。 99%以上の勝率を達成しましたが、ラウンド128では勝率が10%を下回りました。

図 4b では、研究者らは、攻撃者が 4096 ラウンドに達したとき、A-MCTS-S が最新に対して 54% の最大勝率を達成したことを示しています。これは、49% の勝率を達成した 200 エポックでの A-MCTS-R のパフォーマンスに非常に似ています。

その他の評価

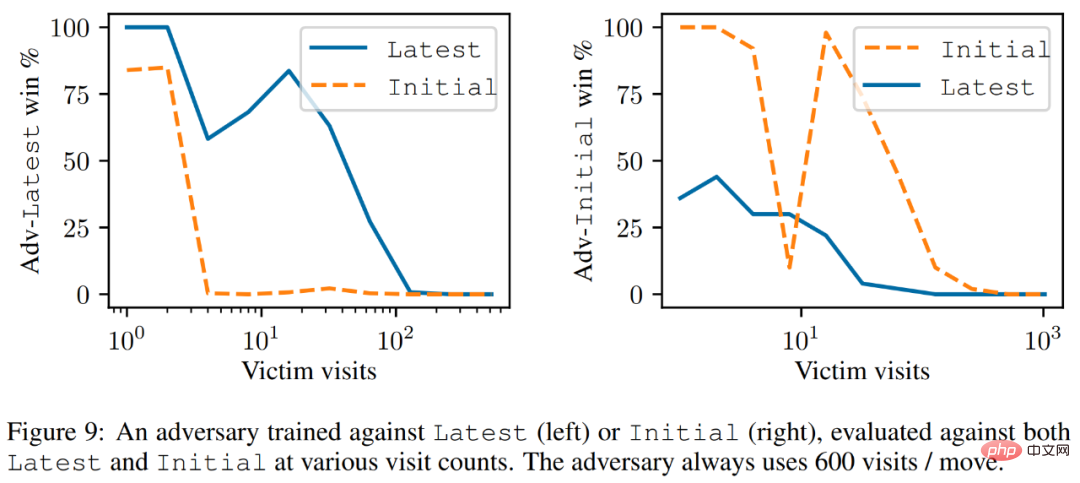

以下の図 9 に示すように、研究者らは、latest はより強力なインテリジェンスではあるものの、しかし、最新に対してトレーニングされた攻撃者は、初期よりも最新に対してより優れたパフォーマンスを発揮します。

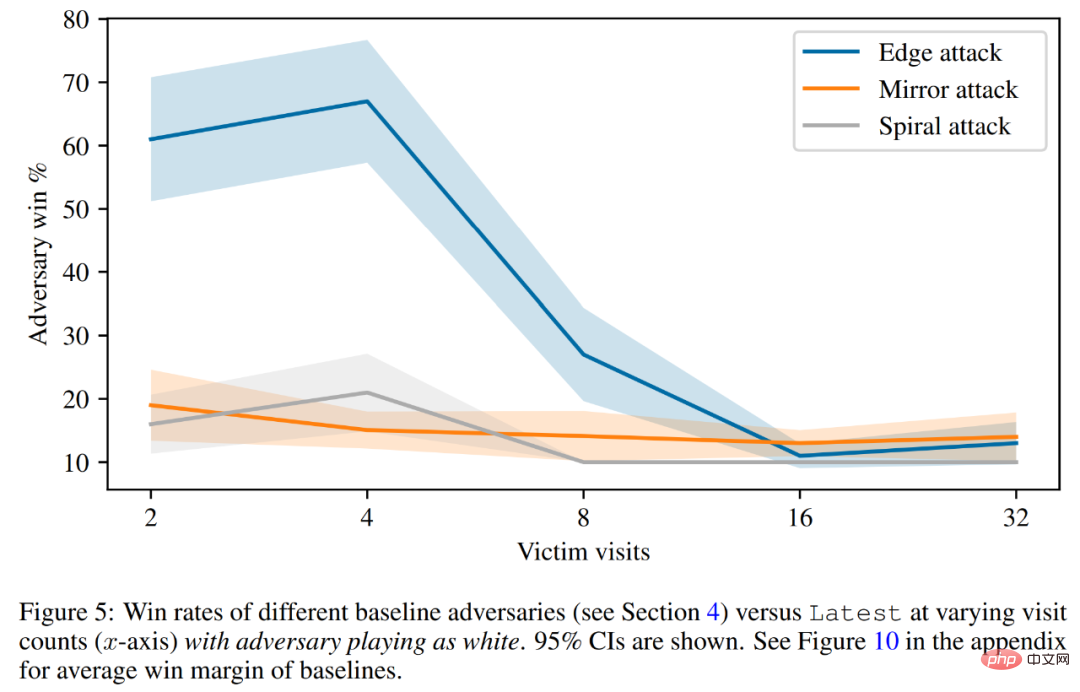

最後に、研究者らは、被害者の価値予測やハードコーディングされた防御評価などの攻撃原理について議論しました。以下の図 5 に示すように、すべてのベースライン攻撃のパフォーマンスは、訓練された敵対戦略よりも大幅に悪くなっています。

技術的な詳細については、元の論文を参照してください。

以上が魔法を使って魔法を倒せ!人間のトップ棋士に匹敵する囲碁AIが同業者に敗れたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7461

7461

15

15

1376

1376

52

52

77

77

11

11

17

17

17

17

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

概要:Vue.js文字列配列をオブジェクト配列に変換するための次の方法があります。基本方法:定期的なフォーマットデータに合わせてマップ関数を使用します。高度なゲームプレイ:正規表現を使用すると、複雑な形式を処理できますが、慎重に記述して考慮する必要があります。パフォーマンスの最適化:大量のデータを考慮すると、非同期操作または効率的なデータ処理ライブラリを使用できます。ベストプラクティス:コードスタイルをクリアし、意味のある変数名とコメントを使用して、コードを簡潔に保ちます。

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。