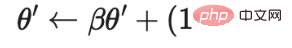

θ の移動平均を表します。

の移動平均を表します。

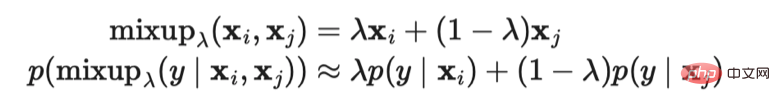

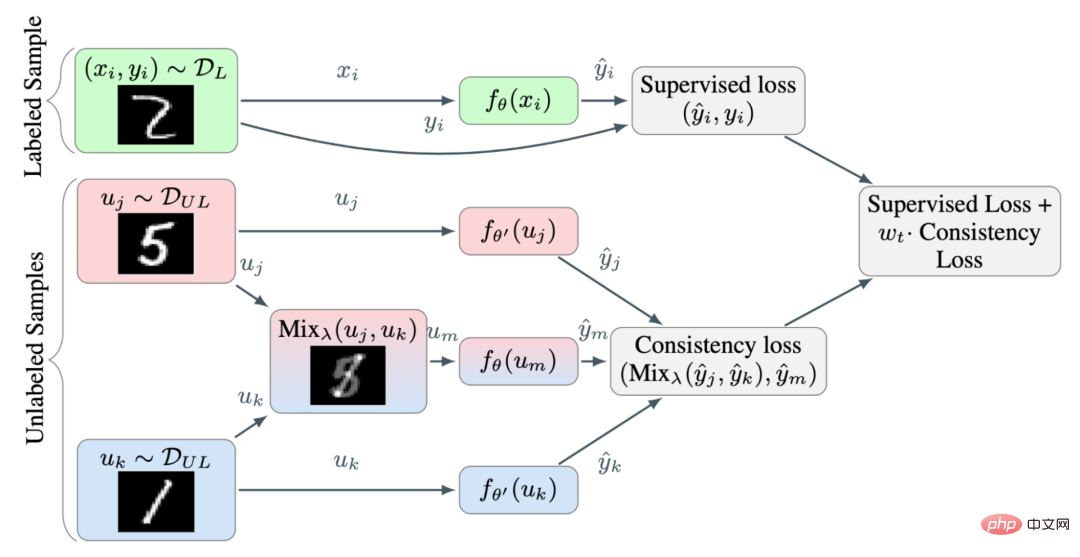

# 図 6: 補間一貫性トレーニングの概要。 MixUp メソッドを使用して、内挿ラベルを学習ターゲットとしてさらに内挿サンプルを生成します。 (画像出典: Verma et al. の 2019 年の論文「半教師あり学習のための補間一貫性トレーニング」)

ランダムに選択された 2 つのラベルなしサンプルは異なるカテゴリに属するため、確率はは非常に高いため (たとえば、ImageNet には 1000 のターゲット カテゴリがあります)、2 つのランダムなラベルなしサンプル間に Mixup メソッドを適用すると、決定境界付近で補間が生成される可能性があります。低密度分離仮説によれば、決定境界は低密度領域に位置することがよくあります。

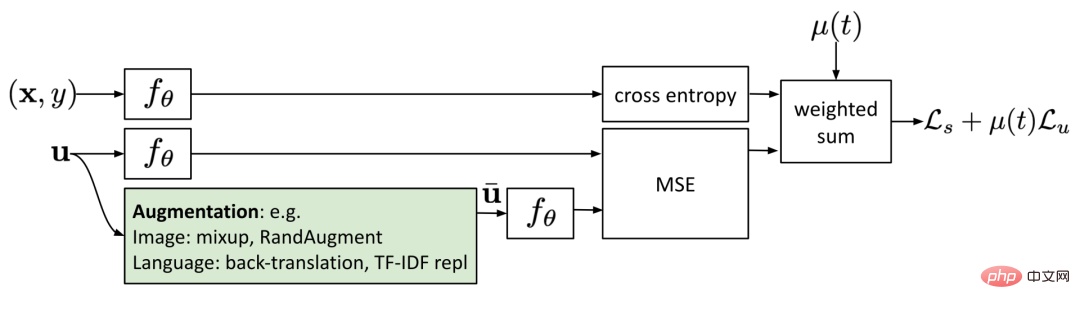

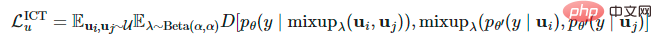

は、 θ の移動平均を表します。 VAT と同様に、2020 年の論文「一貫性トレーニングのための教師なしデータ拡張」で Xie らによって提案された教師なしデータ拡張 (UDA) は、ラベルのないサンプルに拡張サンプルによって予測されたものと同じ出力を与えることを学習します。 UDA は、一貫したトレーニングを通じてノイズの「品質」が半教師あり学習のパフォーマンスにどのような影響を与えるかを研究することに特に焦点を当てています。意味のある効率的なノイズ サンプルを生成するには、高度なデータ拡張手法を使用することが重要です。優れたデータ拡張手法は、ターゲットを絞った誘導バイアスを使用して効率的 (つまり、ラベルを変更しない) で多様なノイズを生成できる必要があります。

θ の移動平均を表します。 VAT と同様に、2020 年の論文「一貫性トレーニングのための教師なしデータ拡張」で Xie らによって提案された教師なしデータ拡張 (UDA) は、ラベルのないサンプルに拡張サンプルによって予測されたものと同じ出力を与えることを学習します。 UDA は、一貫したトレーニングを通じてノイズの「品質」が半教師あり学習のパフォーマンスにどのような影響を与えるかを研究することに特に焦点を当てています。意味のある効率的なノイズ サンプルを生成するには、高度なデータ拡張手法を使用することが重要です。優れたデータ拡張手法は、ターゲットを絞った誘導バイアスを使用して効率的 (つまり、ラベルを変更しない) で多様なノイズを生成できる必要があります。

画像フィールドの場合、UDA は、Cubuk らによって 2019 年の論文「RandAugment: A 実用的な自動データ強化手法により、検索スペース " (RandAugment: 検索スペースを削減した実用的な自動データ拡張)。これは、学習や最適化を必要とせずに、Python 画像処理ライブラリ PIL で利用可能な拡張操作を均一にサンプリングするため、AutoAugment メソッドを使用するよりもはるかに安価です。

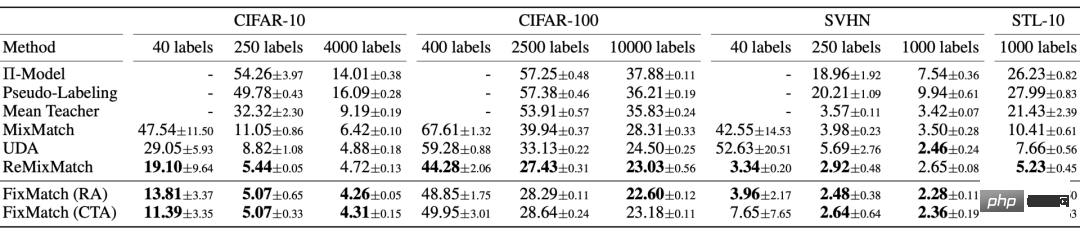

図 7: CIFAR-10 分類におけるさまざまな半教師あり学習手法の比較。 RandAugment 処理を行わずに 50,000 サンプルでトレーニングした場合、完全な監視下での Wide-ResNet-28-2 と PyramidNet ShakeDrop のエラー率はそれぞれ **5.4** と **2.7** です。

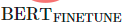

言語フィールドの場合、UDA は TF-IDF に基づく逆翻訳と単語置換の組み合わせを使用します。逆翻訳では高レベルの意味は保持されますが、特定の単語自体は保持されません。一方、TF-IDF ベースの単語置換では、TF-IDF スコアの低い有益でない単語が削除されます。言語タスクに関する実験で、研究者らは、UDA が転移学習と表現学習を補完するものであることを発見しました。たとえば、ドメイン内のラベルなしデータ (図 8 の ) で BERT モデルを微調整すると、パフォーマンスがさらに向上します。

図 8: さまざまなテキスト分類タスクでさまざまな初期化設定を使用した教師なしデータ拡張手法の比較。 (画像出典: Xie et al. の 2020 年の論文「Unsupervised Data Augmentation for Consistency Training」)

を計算する場合、以下を使用して UDA を使用できます。結果を最適化するための 3 つのトレーニング手法:

を計算する場合、以下を使用して UDA を使用できます。結果を最適化するための 3 つのトレーニング手法:

- 低信頼度マスキング: サンプルの予測信頼度がしきい値

より低い場合は、マスク処理を実行します。

より低い場合は、マスク処理を実行します。

- 予測分布の鮮明化: Softmax で低温

を使用して、予測確率分布を鮮明にします。

を使用して、予測確率分布を鮮明にします。

- ドメイン内データのフィルタリング: 大規模なドメイン外データセットからより多くのドメイン内データを抽出するために、研究者は分類器をトレーニングしてドメイン内ラベルを予測し、保持します。予測の信頼度が高いサンプルは、ドメイン内候補サンプルとして使用されます。

このうち、 は##と同じモデル重みの固定値です。 # は VAT にあるため、勾配の更新はありません。

は##と同じモデル重みの固定値です。 # は VAT にあるため、勾配の更新はありません。 は拡張データ ポイント、

は拡張データ ポイント、 は予測信頼度のしきい値、

は予測信頼度のしきい値、 は分布鮮明化温度です。

は分布鮮明化温度です。

5 擬似ラベリング

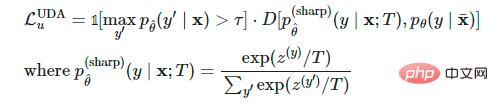

Lee らの 2013 年の論文「擬似ラベリング: ディープ ニューラル ネットワークのためのシンプルで効率的な半教師あり学習方法」擬似ラベル: ディープ ニューラル ネットワークのシンプルで効率的な半教師あり学習法は (擬似ラベル: ディープ ニューラル ネットワークのためのシンプルで効率的な半教師あり学習法) で提案されており、最大ソフトマックスに基づいてラベルのないサンプルに擬似ラベルを割り当てます。現在のモデルによって予測された確率を計算し、完全に監視された設定の下でラベルのないサンプルに擬似ラベルを割り当てます。ラベル付きサンプルとラベルなしサンプルでモデルを同時にトレーニングします。

なぜ疑似タグが機能するのでしょうか?擬似ラベル付けは、実際にはエントロピー正則化と同等であり、ラベルなしデータのクラス確率の条件付きエントロピーを最小限に抑え、それによってクラス間の低密度分離を実現します。言い換えれば、予測されたクラス確率は実際にクラスの重複を計算し、エントロピーを最小化することはクラスの重複、したがって密度分離を削減することと同等です。

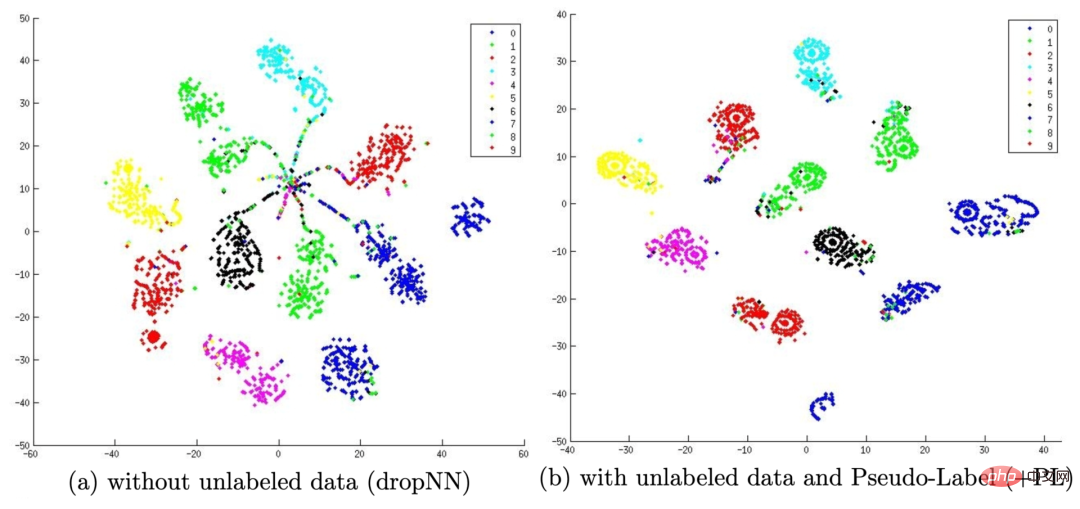

#図 9: (a) は、600 個のラベル付きデータのみを使用してモデルをトレーニングした後、MINIST でテスト出力が実行されることを示しています。テスト セット t-SNE 視覚化結果 (b) は、600 個のラベル付きデータと 60,000 個のラベルなしデータの疑似ラベルを使用してモデルをトレーニングした後の、MINIST テスト セットでのテスト出力の t-SNE 視覚化結果を表します。擬似ラベルにより、学習された埋め込み空間がより適切に分離できるようになります。 (画像出典: Lee et al. の 2013 年の論文「Pseudo Labels: A Simple and Efficient Semi-supervised Learning Method for Deep Neural Networks」)

疑似ラベルを次の目的で使用します。トレーニング 自然は反復的なプロセスです。ここで、擬似ラベルを生成するモデルをTeacherモデル、擬似ラベルを用いて学習するモデルをStudentモデルと呼びます。

(1) ラベル伝播

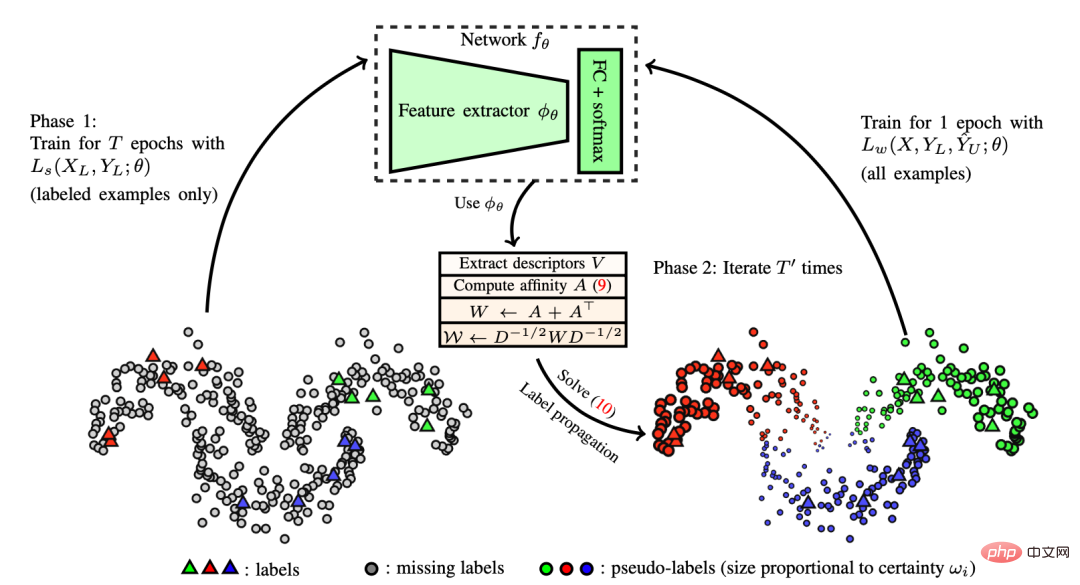

Iscenらが2019年に発表した論文「Label Propagation for Deep Semi-supervised Learning」においてラベル伝播の概念が提案されました半教師あり学習では、特徴の埋め込みに基づいてサンプル間の類似性グラフを構築するというアイデアです。次に、グラフ内のペアごとの類似性スコアに比例した伝播重みを使用して、擬似ラベルが既知のサンプルからラベルのないサンプルに「拡散」されます。概念的には、これは k-NN 分類器に似ていますが、どちらも大規模なデータセットにうまく対応できないという問題があります。

# 図 10: タグの伝播がどのように機能するかを示す概略図。 (画像出典:2019年Iscenら発行「Label Propagation of Deep Semi-supervised Learning」) (2)セルフトレーニング

自己トレーニングは新しい概念ではありません。Scudder らは 1965 年に「一部の適応パターン認識マシンのエラーの確率」という論文を発表し、Nigram & Ghani らは CIKM で論文「Co-training の有効性と適用性の分析」を発表しました。 2000年に出版されたtrainin』にはすべてこのコンセプトが含まれています。これは、ラベルのない各サンプルがラベルと一致するまで、次の 2 つのステップを順番に実行する反復アルゴリズムです。

まず、ラベル付きデータ デバイス上で分類を構築します。

Xie et al. が 2020 ImageNet 分類で発表した論文「騒々しい学生によるセルフ トレーニングにより ImageNet 分類が向上する」では、セルフ トレーニングがディープ ラーニングに適用され、大きな成果を上げた。 ImageNet 分類タスクでは、研究者らはまず EfficientNet モデルを教師モデルとしてトレーニングして 3 億枚のラベルなし画像の疑似ラベルを生成し、次により大きな EfficientNet モデルを学生モデルとしてトレーニングして、実際のラベル付き画像と疑似ラベルを学習しました。彼らの実験設定では、重要な要素は Student モデルのトレーニング中にノイズを追加することですが、Teacher モデルは擬似ラベル生成プロセス中にノイズを追加しません。したがって、彼らの方法は「Noisy Student」と呼ばれ、ランダムな深さ、ドロップアウト、および RandAugment メソッドを使用して Student モデルにノイズを追加します。 Student モデルは Teacher モデルよりも優れたパフォーマンスを示しますが、これは主にノイズを追加する利点によるものです。追加されたノイズは、ラベル付きデータとラベルなしデータの両方でモデルによって生成された決定境界を平滑化するという複合効果をもたらします。 Student モデルのセルフトレーニングには、他にも次のような重要な技術設定がいくつかあります。

- Student モデルに加えて、より多くのデータを適合させるのに十分な大きさ (つまり Teacher モデルよりも大きい) にする必要があります。

- ノイズを追加するスチューデント モデルは、データ バランシング手法と組み合わせる必要があります。これは、クラスの重みごとに疑似ラベル付けされた画像の数のバランスを取るために特に重要です。

- ソフト疑似タグはハードタグよりもうまく機能します。

Student モデルにノイズを追加すると、FGSM (入力データの損失勾配を使用し、入力データを調整して最大化する高速勾配符号攻撃) に対する防御力も向上します。モデルが敵対的な堅牢性のために最適化されていない場合でも、堅牢性。

Du らは、2020 年の論文「自己トレーニングにより自然言語理解のための事前トレーニングが改善される」で SentAugment メソッドを提案しました。言語分野の自己訓練を行う際のドメイン。文ベクトルに依存して大規模なコーパスからラベルのないドメイン内サンプルを検索し、取得した文を自己トレーニングに使用します。

(3) 確証バイアスの軽減(Confification Bias)

確証バイアスとは、教師モデルが成熟していないために誤った疑似ラベルが与えられてしまう問題のことです。十分。間違ったラベルに過剰適合すると、より良い Student モデルが得られない可能性があります。

確証バイアスを軽減するために、Eric Arazoらの論文「深層半教師あり学習における擬似ラベリングと確証バイアス」(教師あり学習では2つの新しい手法が提案されています) 。

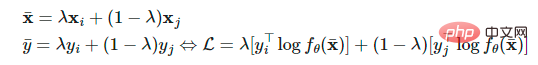

1 つはソフト ラベルを使用したミックスアップ法です。 2 つのサンプルと対応する真のラベルと擬似ラベル

2 つのサンプルと対応する真のラベルと擬似ラベル  が与えられると、内挿ラベル方程式はソフトマックス出力クロスに変換できます。 -エントロピー損失:

が与えられると、内挿ラベル方程式はソフトマックス出力クロスに変換できます。 -エントロピー損失:

ラベル付きサンプルが少なすぎる場合は、Mixup メソッドを使用するだけでは十分ではありません。したがって、論文の著者はラベル サンプルをオーバーサンプリングして、各ミニバッチ内のラベル サンプルの最小数を設定しました。これは、ラベル付きサンプルの 重み補正 よりも効果的です。これは、頻度が低くて大規模な更新ではなく、より頻繁に更新されるためです (実際にはより不安定です)。

一貫性の正則化と同様に、データ拡張およびドロップアウト手法も擬似ラベルの役割を果たすために重要です。

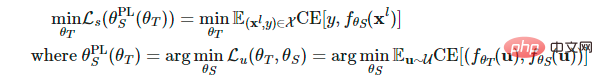

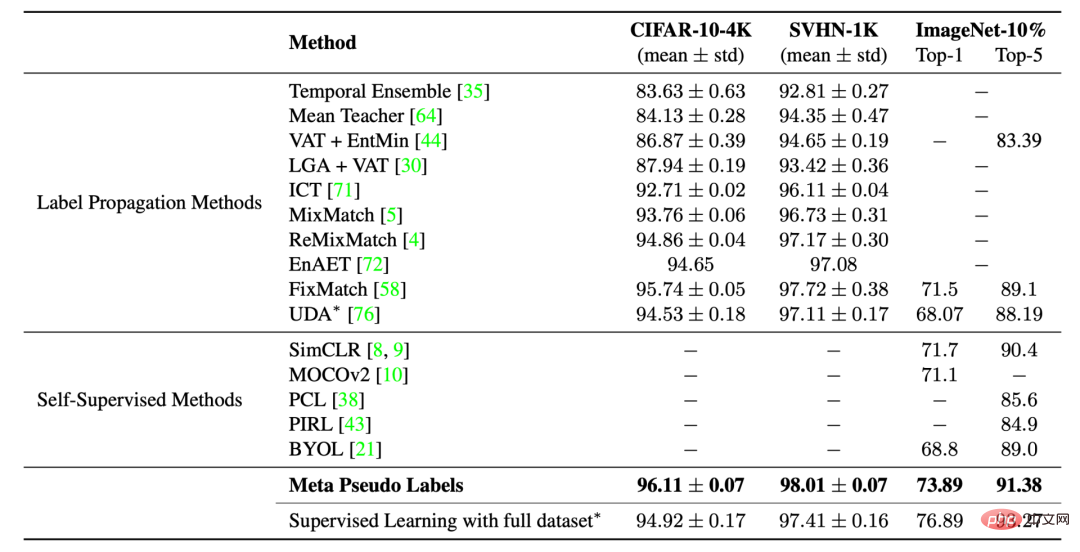

Hieu Pham らは、2021 年の論文「Meta Pseudo Labels」でメタ擬似ラベルを提案しました。ラベル データセットのパフォーマンスに関するスチューデント モデルのフィードバックに基づいて、継続的な調整が行われます。教師モデル。 Teacher モデルと Student モデルは同時にトレーニングされ、Teacher モデルはより適切な擬似ラベルを生成することを学習し、Student モデルは擬似ラベルから学習します。

教師モデルと学生モデルの重みをそれぞれ  と

と  に設定します。ラベル付きサンプルの学生モデルの損失は

に設定します。ラベル付きサンプルの学生モデルの損失は

の関数として定義され、それに応じてこの損失を最小限に抑えるために教師モデルを最適化する傾向があります。

の関数として定義され、それに応じてこの損失を最小限に抑えるために教師モデルを最適化する傾向があります。

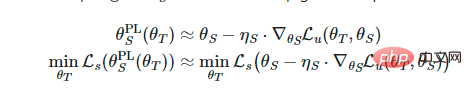

ただし、上記の方程式を最適化するのは簡単な作業ではありません。 MAML (Model-Agnostic Meta-Learnin) のアイデアを借用すると、マルチステップ

計算を実行しながら

計算を実行しながら  で 1 ステップの勾配更新を実行することに似ています。

で 1 ステップの勾配更新を実行することに似ています。

#ソフト疑似ラベルが使用されているため、上記の目的関数は微分可能な関数です。ただし、ハード擬似ラベルを使用した場合、微分不可能な関数となるため、REINFORCE などの強化学習手法が必要になります。

最適化プロセスは、2 つのモデル間で交互に実行されます:

- スチューデント モデルの更新: ラベルのないサンプルのバッチ

が与えられた場合、関数

が与えられた場合、関数  を通じて疑似ラベルを生成し、ワンステップの確率的勾配降下法を使用して

を通じて疑似ラベルを生成し、ワンステップの確率的勾配降下法を使用して  を最適化できます: ## #。

を最適化できます: ## #。

- 教師モデルの更新: ラベル付きサンプルのバッチ が与えられた場合、学生モデルの更新を繰り返し使用して

:

:  を最適化します。さらに、一貫した正則化を組み込むために、UDA オブジェクトが Teacher モデルに適用されます。

を最適化します。さらに、一貫した正則化を組み込むために、UDA オブジェクトが Teacher モデルに適用されます。

図 11: メタ擬似ラベリングと他の半教師あり学習または自己教師あり学習の比較画像に対するメソッドの分類タスクにおけるパフォーマンスの比較。 (画像ソース: Hieu Pham et al. の 2021 年の論文「Meta Pseudo Labels」)

6 一貫性正則化擬似ラベル

一貫性と正則化を組み合わせることができます。擬似ラベリング手法を組み合わせて半教師あり学習に適用します。

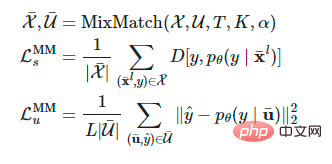

(1) MixMatch

Berthelot らの 2019 年の論文「MixMatch: A Holistic Approach to Semi-supervised Learning」 「To Semi」で提案された MixMatch 手法-教師あり学習」は、半教師あり学習に適用される全体的な手法です。次の手法を統合することで、ラベルのないデータを使用します:

- 一貫性の正則化: モデルが摂動されたラベルのないサンプルに対して同じ予測を出力できるようにします。

- エントロピー最小化 (エントロピー最小化): ラベルのないデータに対する信頼性の高い予測をモデルに出力させます。

- MixUp の機能強化: モデルがサンプル間で線形に動作するようにします。

ラベル付きデータ  とラベルなしデータ

とラベルなしデータ  のバッチが与えられた場合、拡張バージョンは

のバッチが与えられた場合、拡張バージョンは  操作

操作  および

および  を通じて取得されます。それぞれ、強化されたサンプルとラベルされていないサンプルの予測されたラベルを表します。

を通じて取得されます。それぞれ、強化されたサンプルとラベルされていないサンプルの予測されたラベルを表します。

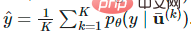

は、推測されるラベルの重複を減らすために使用されるシャープニング温度です。K はそれぞれの強化されたラベルの数です。ラベル サンプルによって生成されたバージョン。

は、推測されるラベルの重複を減らすために使用されるシャープニング温度です。K はそれぞれの強化されたラベルの数です。ラベル サンプルによって生成されたバージョン。 は MixMatch 関数のパラメーターです。各

は MixMatch 関数のパラメーターです。各  に対して、MixMatch は K 個の拡張バージョン (

に対して、MixMatch は K 個の拡張バージョン ( は k から 1 に等しい) を生成し、....、

は k から 1 に等しい) を生成し、....、 の K 個の拡張バージョンを生成し、モデルは平均

の K 個の拡張バージョンを生成し、モデルは平均  に基づいて擬似ラベルを推測します。

に基づいて擬似ラベルを推測します。

図 12: MixMatch の「ラベル推測」プロセス: K 個の強化されたラベルなしサンプルの平均により、予測された周辺分布が修正され、最終的に分布が鮮明になります。 (画像出典: Berthelot et al. の 2019 年の論文「MixMatch: A Holistic Method for Semi-supervised Learning」)

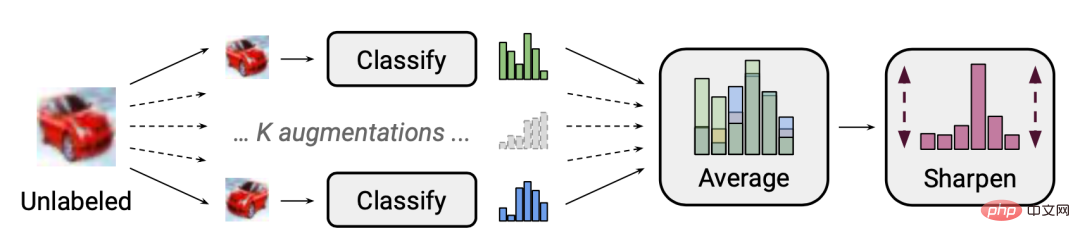

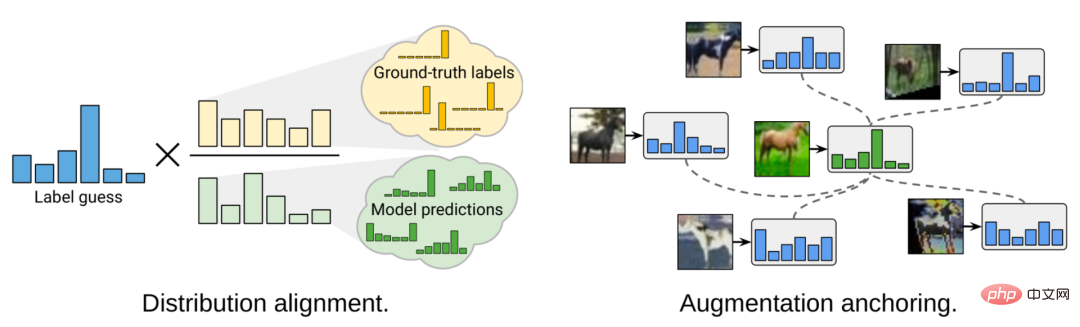

この論文のアブレーション研究によると、ラベルなしデータの MixUp 拡張は特に重要です。擬似ラベル分布の温度シャープニングを削除すると、パフォーマンスに重大な影響を与える可能性があります。ラベルを推測するには、ラベルのないデータの複数の拡張バージョンの平均を計算することも重要です。 2020 年の論文「ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring」(ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring) では、Berthelot らは、次の 2 つの新しいメカニズムを導入することにより、ReMixMatch メソッドをさらに提案しました。

## 図 13: ReMixMatch メソッドによる MixMatch メソッドの 2 つの改善の図見せる。 (画像出典: Berthelot et al. の 2020 年の論文「ReMixMatch: 分布アライメントと強化されたアンカリングを使用した半教師あり学習」)

1. 分布アライメント (分布アライメント ) 。この方法により、周辺分布  が真値ラベルの周辺分布に近くなります。

が真値ラベルの周辺分布に近くなります。  をグラウンド トゥルース ラベルのクラス分布、

をグラウンド トゥルース ラベルのクラス分布、 をラベルなしデータの予測クラス分布の移動平均とします。ラベルのないサンプル

をラベルなしデータの予測クラス分布の移動平均とします。ラベルのないサンプル  に対するモデルの予測は、真の周辺分布と一致するように

に対するモデルの予測は、真の周辺分布と一致するように  に正規化されます。

に正規化されます。

周辺分布に一貫性がない場合、エントロピーの最小化は有用な目標ではないことに注意してください。さらに、ラベル付きデータとラベルなしデータのクラス分布が互いに一致するという仮定は実際には絶対的すぎるため、現実の設定では必ずしも正しいとは限りません。

2. 拡張アンカリング。ラベルのないサンプルを指定すると、最初に弱く強化された「アンカー」バージョンが生成され、次に CTAugment (Control Theory Augment) メソッドを使用して、K 個の強く強化されたバージョンの平均が計算されます。 CTAugment は、予測がネットワークの許容範囲内に留まるトークバック モデルの拡張バージョンのみをサンプリングします。

ReMixMatch 損失は次の項目で構成されます:

- データ拡張とミックスアップ手法を適用する教師あり損失

- データ拡張とミックスアップ手法を適用するが、ターゲットとして疑似ラベルを使用する教師なし損失

- Mixup 法を使用しない、強力に強化された単一のラベルなし画像のクロス エントロピー損失

- 自己教師あり学習における回転損失 (回転損失)。

(2) DivideMix

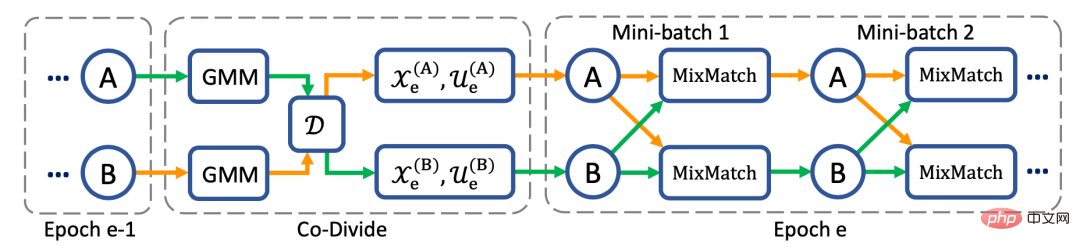

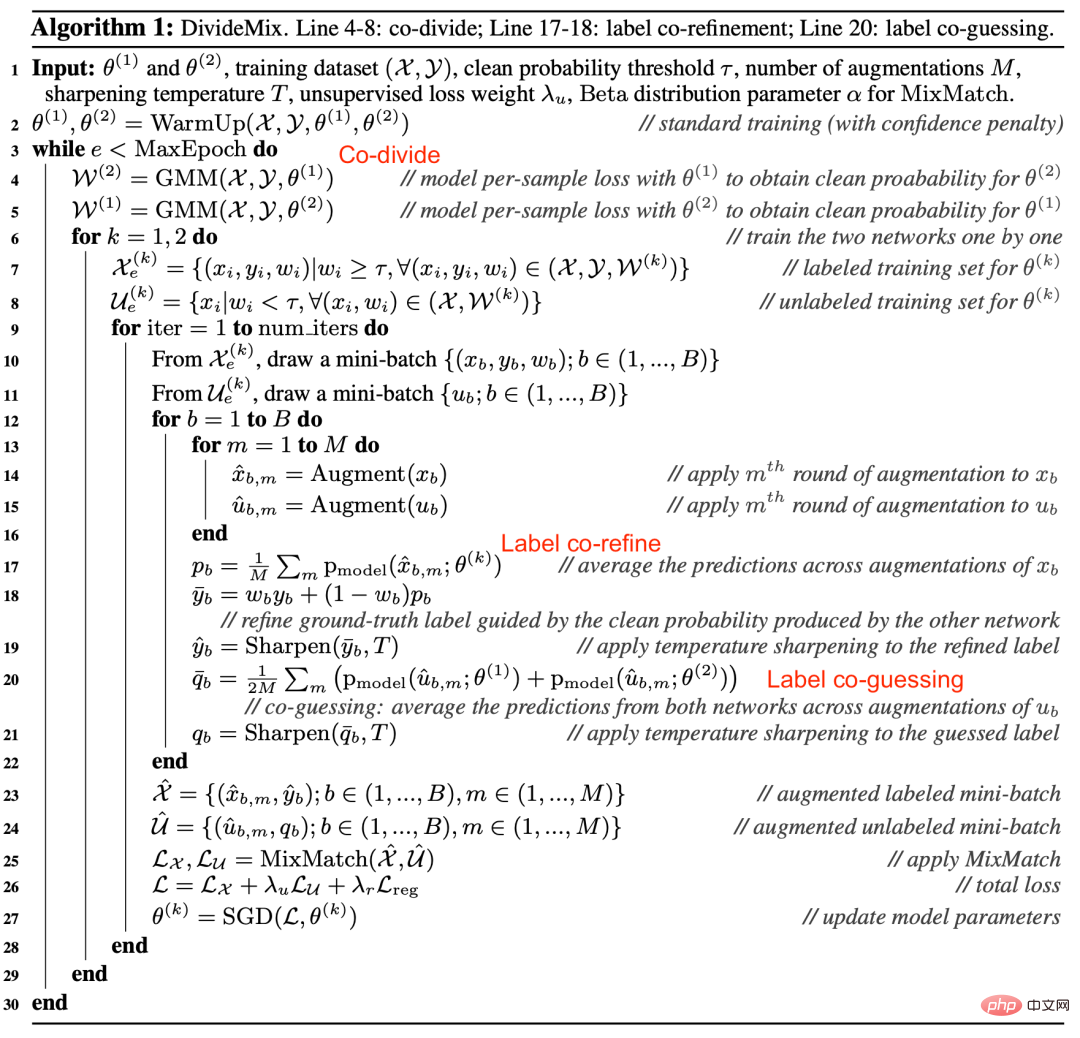

Junnan Li らの 2020 年の論文「DivideMix: ノイズ ラベル学習を使用した半教師あり学習の実装」(DivideMix) : 学習 DivideMix 手法は、半教師あり学習とノイズのあるラベルを使用した学習を組み合わせた (半教師あり学習としてノイズのあるラベルを使用) で提案されています (ノイズのあるラベルを使用した学習、LNL)。混合ガウス モデル (GMM) を通じて各サンプルの損失分布をモデル化します。GMM は、トレーニング データを、クリーンなサンプルを含むラベル付きデータセットとノイズのあるサンプルを含むラベルなしデータセットに動的に分割します。

Arazo らが 2019 年の論文「教師なしラベル ノイズ モデリングと損失補正」(教師なしラベル ノイズ モデリングと損失補正) で提案したアイデアによると、バイナリ ガウス混合モデルはクロスエントロピー損失に適合します。クリーンなサンプルは、ノイズの多いサンプルよりも早く損失が少なくなることが期待されます。平均値が小さいガウス混合モデルは、きれいなラベルの クラスタリングに対応し、ここでは c として示されます。混合ガウス モデル  の事後確率 (つまり、サンプルがクリーンなサンプル セットに属する確率) がしきい値より大きい場合、サンプルはクリーンなサンプルとみなされ、それ以外の場合はノイズとみなされます。サンプル。

の事後確率 (つまり、サンプルがクリーンなサンプル セットに属する確率) がしきい値より大きい場合、サンプルはクリーンなサンプルとみなされ、それ以外の場合はノイズとみなされます。サンプル。

データ クラスタリングのプロセスは共分割と呼ばれます。確証バイアスを回避するために、DividImax メソッドは、Double Q-Learning の仕組みと同様に、各ネットワークが他のネットワークからのデータセットの別々の部分を使用する 2 つの交差ネットワークを同時にトレーニングします。

##図 14: DivideMix は 2 つのネットワークを個別にトレーニングして、確証バイアスを減らす。 2 つのネットワークは、協調的な分割、協調的なリファインメント、および協調的な推測を同時に実行します。 (画像出典: Junnan Li et al. の 2020 年の論文「DivideMix: using Noisy Label Learning to Implement Semi-supervised Learning」)

MixMatch と比較すると、DivideMix にはノイズの多いサンプルを処理するための共分割ステップが追加され、トレーニング中に次の改善が行われました。 ラベルの共洗練: グラウンド トゥルース ラベル をネットワーク予測 の組み合わせで線形化します。ここで、 は平均です。別のネットワークがクリーンなデータ セットを生成する可能性

は平均です。別のネットワークがクリーンなデータ セットを生成する可能性  のもとで、

のもとで、 の複数の拡張バージョンが生成されます。

の複数の拡張バージョンが生成されます。

ラベル共推測: ラベルのないデータ サンプルに対する 2 つのモデルの予測を平均します。

# 図 15: DivideMix アルゴリズム。 (画像出典: Junnan Li et al. の 2020 年の論文「DivideMix: using Noisy Label Learning to Implement Semi-supervised Learning」)

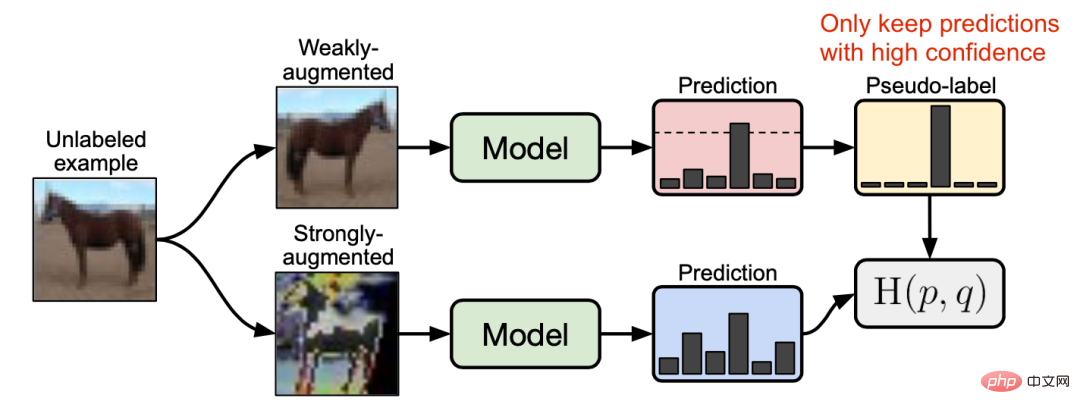

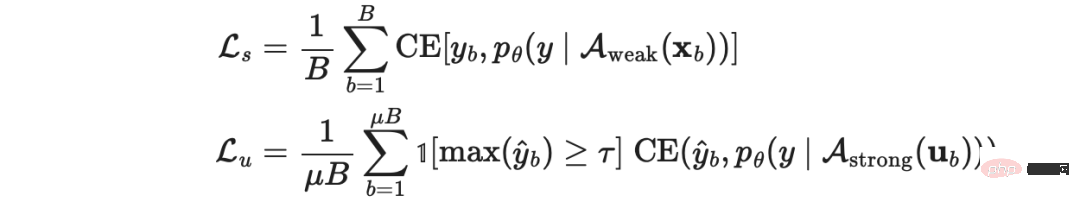

(3) FixMatch Sohn et al. が 2020 年の論文「FixMatch: Simplifying Semi-Supervised Learning with Consistency and Confidence」で提案した FixMatch 手法では、弱い強化手法を使用してラベルのないサンプルを検出し、擬似ラベルを生成し、信頼性の高い予測のみを保持します。ここでは、弱い強調と信頼性の高いフィルタリングの両方が、高品質で信頼できる疑似ラベル ターゲットの生成に役立ちます。次に、FixMatch は、大幅に強化されたサンプルを指定して、これらの疑似ラベルを予測します。

# 図 16: FixMatch メソッドの動作の図。 (画像出典: Sohn et al. の 2020 年の論文「FixMatch: Simplifying semi-supervised learning using一貫性と信頼性」)

##ここで、

##ここで、

はラベルのないサンプルの擬似ラベルであり、 は と  の相対的なサイズを決定するハイパーパラメーターです。弱い強化

の相対的なサイズを決定するハイパーパラメーターです。弱い強化 : 標準の翻訳と変換の強化。強力な強化

: 標準の翻訳と変換の強化。強力な強化 : AutoAugment、Cutout、RandAugment、CTAugment などのデータ強化方法。

: AutoAugment、Cutout、RandAugment、CTAugment などのデータ強化方法。

# 図 17: 画像分類タスクにおける FixMatch および他のいくつかの半教師あり学習手法のパフォーマンス。 (画像出典: Sohn et al. の 2020 年の論文「FixMatch: Simplifying semi-supervised learning using一貫性と信頼性」)

# 図 17: 画像分類タスクにおける FixMatch および他のいくつかの半教師あり学習手法のパフォーマンス。 (画像出典: Sohn et al. の 2020 年の論文「FixMatch: Simplifying semi-supervised learning using一貫性と信頼性」)

FixMatch のアブレーション研究によると、

- しきい値 τ を使用する場合、温度パラメーター T を使用しても、予測分布の鮮明化に大きな影響はありません。

- Cutout と CTAugment は、モデルの良好なパフォーマンスを達成する上で重要な役割を果たす強力な拡張手法です。

- ラベル推測で弱いブースティングではなく強いブースティングが使用されると、モデルはトレーニングの初期段階で発散します。弱い補強が破棄されると、モデルは推測されたラベルを過剰適合します。

- 疑似ラベル予測に強い強化ではなく弱い強化を使用すると、モデルのパフォーマンスが不安定になります。モデルのパフォーマンスを安定させるには、強力なデータ拡張が不可欠です。

7 強力な事前トレーニングとの組み合わせ

この方法では、自己教師あり学習を通じて、大規模な教師なしデータ コーパス上でタスクに依存しないモデルを事前トレーニングします。次に、モデルは、小さなラベル付きデータセットを使用して下流タスクで微調整されます。これは、特に言語タスクでは一般的なパラダイムです。研究によると、モデルが半教師あり学習と事前トレーニングを組み合わせた場合、追加のゲインが得られることがわかっています。

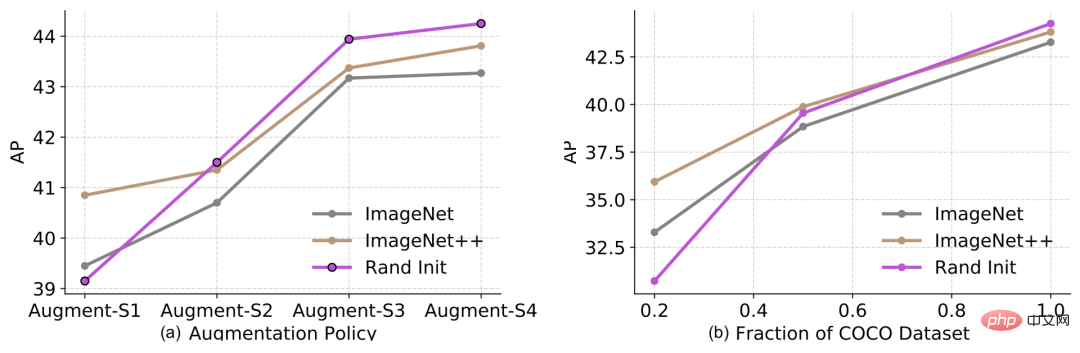

Zophらの2020年の論文「事前トレーニングとセルフトレーニングの再考」では、セルフトレーニングが事前トレーニングよりもどれほど効果的であるかを研究しました。彼らの実験設定は、COCO の結果を改善するための事前トレーニングまたは自己トレーニングに ImageNet を使用することです。 ImageNet を自己トレーニングに使用する場合、ラベルは破棄され、ImageNet サンプルのみがラベルのないデータ ポイントとして使用されることに注意することが重要です。 He Kaiming らは、2018 年の論文「Re Thinking ImageNet Pre-training」で、下流のタスク (ターゲット検出など) が大きく異なる場合、ImageNet 分類の事前トレーニングの効果はあまり良くないことを証明しました。

図 18: (a) データ拡張の結果 (弱いものから強いものへ) と (b)ラベル データセットのサイズがオブジェクト検出パフォーマンスに与える影響。凡例: 「Rand Init」は、ランダムな重みで初期化されたモデルを表します。「ImageNet」は、ImageNet データセット上で 84.5% の Top-1 精度を持つ事前トレーニング済みモデルを使用して初期化されます。「ImageNet」は、Top-1 を使用して初期化されます。 ImageNet データセットの 1 の精度 -1 は、精度 86.9% の事前トレーニング済みモデルで初期化されます。 (画像出典: Zoph et al. の 2020 年の論文「Re Thinking Pre-training and Self-Training」)

この実験では、一連の興味深い発見が得られました:

- 下流タスクで使用できるラベル付きサンプルが増えるほど、事前トレーニングの効果は低くなります。事前トレーニングは低データ モード (20%) では役立ちますが、高データの状況では中立または逆効果になります。

- 高データ/強力ブースト モードでは、事前トレーニングが逆効果であっても、セルフ トレーニングは役に立ちます。

- 同じデータ ソースを使用する場合でも、セルフ トレーニングは事前トレーニングよりもさらなる改善をもたらす可能性があります。

- 自己教師あり事前トレーニング (SimCLR による事前トレーニングなど) は、教師あり事前トレーニングと同様に、高データ モードでのモデルのパフォーマンスに悪影響を及ぼします。

- 教師あり学習目標と自己教師あり学習目標を共同トレーニングすることは、トレーニング前タスクと下流タスクの間の不一致を解決するのに役立ちます。事前トレーニング、共同トレーニング、および自己トレーニングはすべて加算的です。

- ノイズ ラベルまたは非ターゲット ラベル (つまり、事前トレーニングされたラベルが下流のタスク ラベルと一致していない) は、ターゲットの疑似ラベルよりも劣ります。

- セルフトレーニングは、事前トレーニングされたモデルを微調整するよりも計算コストが高くなります。

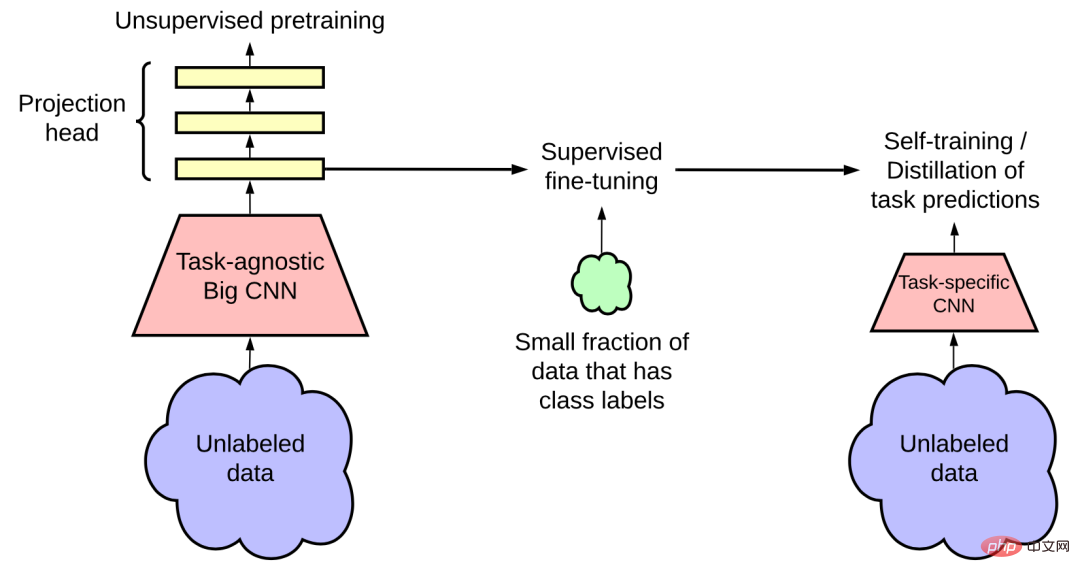

Ting Chen et al. の 2020 年の論文「大きな自己教師ありモデルは強力な半教師あり学習者」では、3 段階の手順手法が提案されています。自己教師あり事前トレーニング、教師あり微調整、自己トレーニングの利点:

1. 教師なしまたは部分教師ありのメソッドを使用して、大規模なモデルをトレーニングします。

##2. いくつかのラベル付きサンプルでのモデルの微調整を監視する (大規模 (深くて広い) ニューラルの場合) モデルが大きくなるほど、少ないラベル付きサンプルでもパフォーマンスが向上するため、ネットワークが重要です。

3. 自己トレーニングで擬似ラベルを使用して、ラベルのないサンプルを抽出します。

a. このタスク固有の使用法では学習された表現の追加容量が必要ないため、大規模なモデルの知識を小規模なモデルに抽出できます。

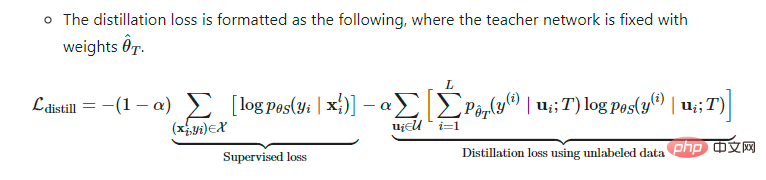

b. 教師ネットワークを固定し、重みを  としたときの蒸留損失の式は次のとおりです。

としたときの蒸留損失の式は次のとおりです。

図 19: 半教師あり学習フレームワークは、タスクに依存しない教師なし事前トレーニング (左) とタスク固有の自己トレーニングと抽出 (右) を通じて、ラベルなしのデータ コーパスを使用します。 (画像出典: Ting Chen et al. の 2020 年の論文「大規模自己教師ありモデルは強力な半教師あり学習者」)

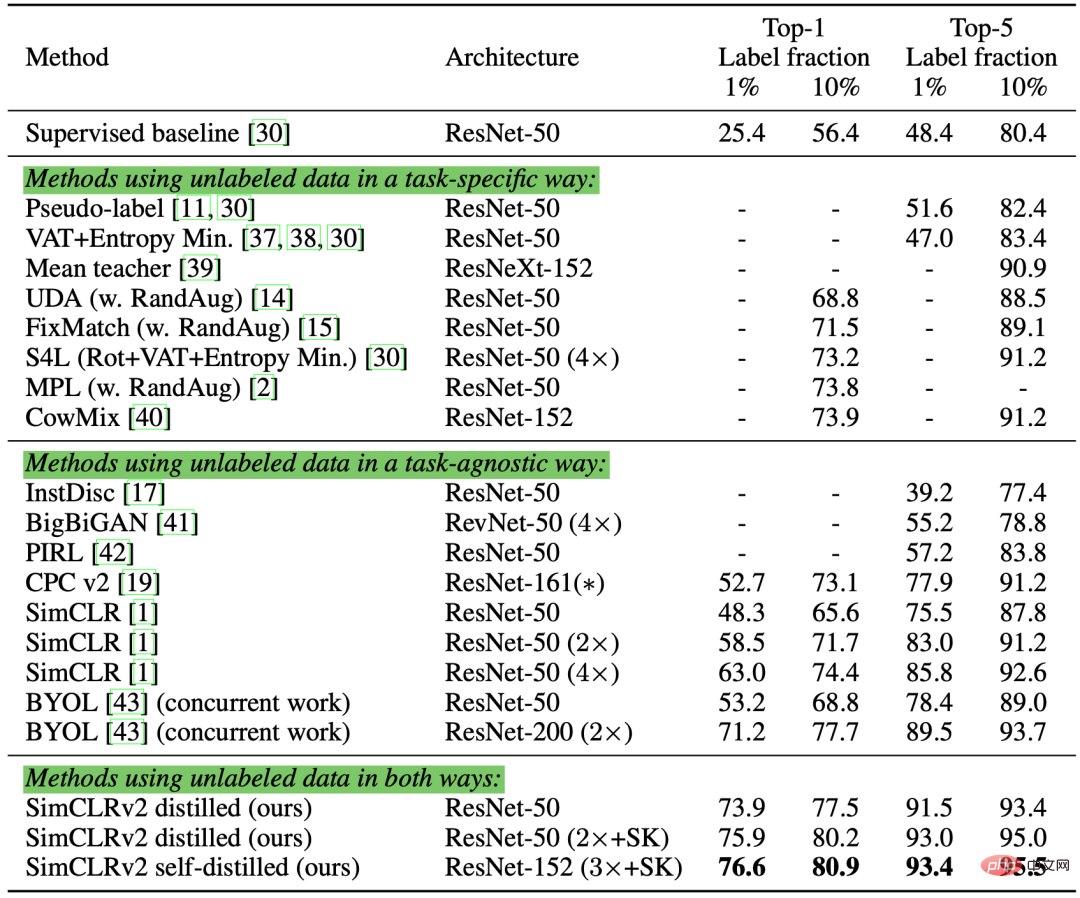

この論文の著者は、 ImageNet 分類タスクで実験しました。自己教師あり事前トレーニングでは、SimCLR を直接改良した SimCLRv2 を使用します。実証研究における彼らの観察は、2020 年に Zoph らによって提案された結果の一部を裏付けました:

- #大規模なモデルのラベル学習はより効率的です;

- #SimCLR のプロジェクト ヘッドをより大きく、より深くすると、表現学習を改善できます。

- ラベルなしデータを蒸留に使用すると、半教師あり学習を最適化できます。

# 図 20: ImageNet 分類における SimCLRv2 半教師あり蒸留のパフォーマンスの比較。 (画像出典:Ting Chen et al.の2020年の論文「大規模な自己教師ありモデルは強力な半教師あり学習者」)

最近の半教師あり学習者の分析を通じて-教師あり学習方法 要約すると、多くの方法は確証バイアスを減らすことを目的としていることがわかります。

高度なデータ拡張方法を通じて、効果的で多様なノイズをサンプルに適用します。 -

##クラスの重複を減らすために疑似ラベルの分布を明確にします。

-

# 引用が必要な場合は、次のように明記してください:

<span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">@</span><span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">article</span>{<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">weng2021semi</span>,<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">title</span> <span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">=</span> <span style="color: rgb(102, 153, 0); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">"Learning with not Enough Data Part 1: Semi-Supervised Learning"</span>,<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">author</span><span style="color: rgb(215, 58, 73); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">=</span> <span style="color: rgb(102, 153, 0); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">"Weng, Lilian"</span>,ログイン後にコピー

は通常、勾配関数の使用を選択します (t はトレーニング ステップ数です)。トレーニング回数が増加するにつれて、

は通常、勾配関数の使用を選択します (t はトレーニング ステップ数です)。トレーニング回数が増加するにつれて、 の割合が増加します。免責事項: この記事では、半教師ありメソッドをすべてカバーしているわけではなく、モデル アーキテクチャのチューニングのみに焦点を当てています。半教師あり学習で生成モデルとグラフベースの手法を使用する方法については、論文「深層半教師あり学習の概要」を参照してください。

の割合が増加します。免責事項: この記事では、半教師ありメソッドをすべてカバーしているわけではなく、モデル アーキテクチャのチューニングのみに焦点を当てています。半教師あり学習で生成モデルとグラフベースの手法を使用する方法については、論文「深層半教師あり学習の概要」を参照してください。

2

2

7547

7547

15

15

1382

1382

52

52

83

83

11

11

22

22

90

90

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

与えられた入力、条件付き確率データセットのラベル付け。

与えられた入力、条件付き確率データセットのラベル付け。

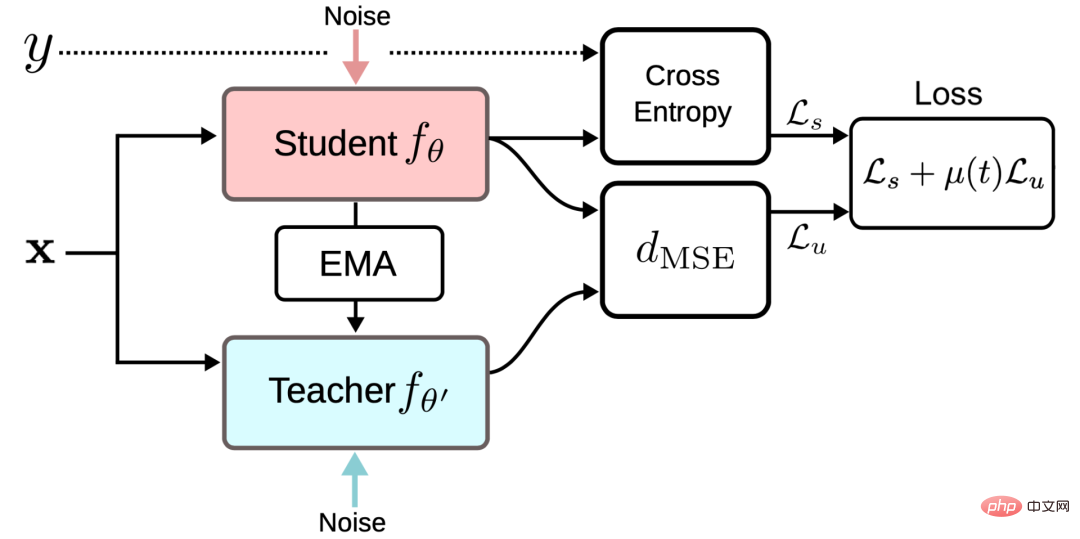

。 SimCLR、BYOL、SimCSE などのいくつかの自己教師あり学習手法では、この考え方が採用されています。同じサンプルの異なる拡張バージョンは、同じ表現を生成します。言語モデリングにおけるクロスビュー トレーニングと自己教師あり学習におけるマルチビュー学習の研究動機は同じです。

。 SimCLR、BYOL、SimCSE などのいくつかの自己教師あり学習手法では、この考え方が採用されています。同じサンプルの異なる拡張バージョンは、同じ表現を生成します。言語モデリングにおけるクロスビュー トレーニングと自己教師あり学習におけるマルチビュー学習の研究動機は同じです。

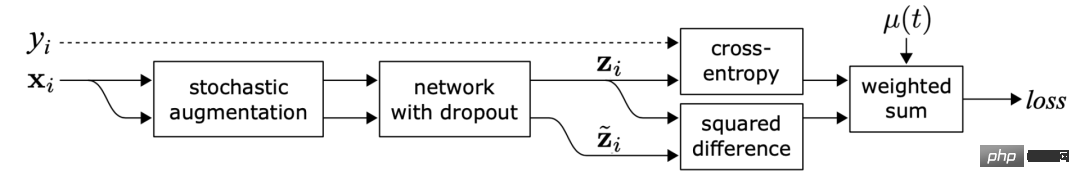

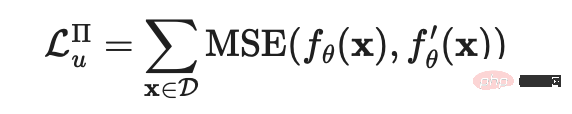

このうち、

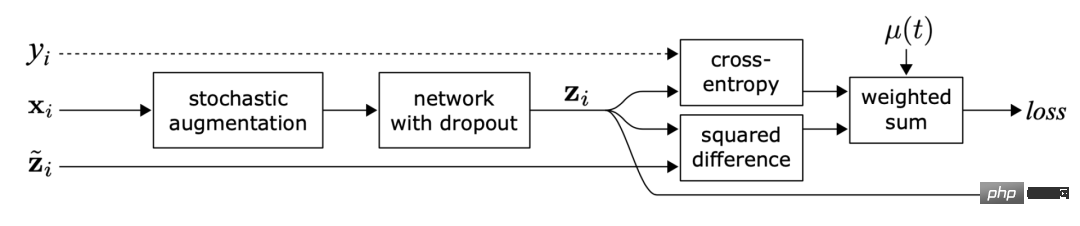

このうち、 は、同じニューラル ネットワークに適用される異なるランダム エンハンスメントまたはドロップアウト マスクの値を指します。この損失ではデータセット全体が使用されます。

は、同じニューラル ネットワークに適用される異なるランダム エンハンスメントまたはドロップアウト マスクの値を指します。この損失ではデータセット全体が使用されます。

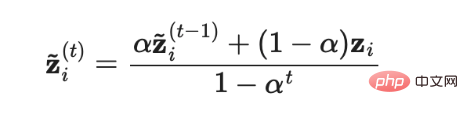

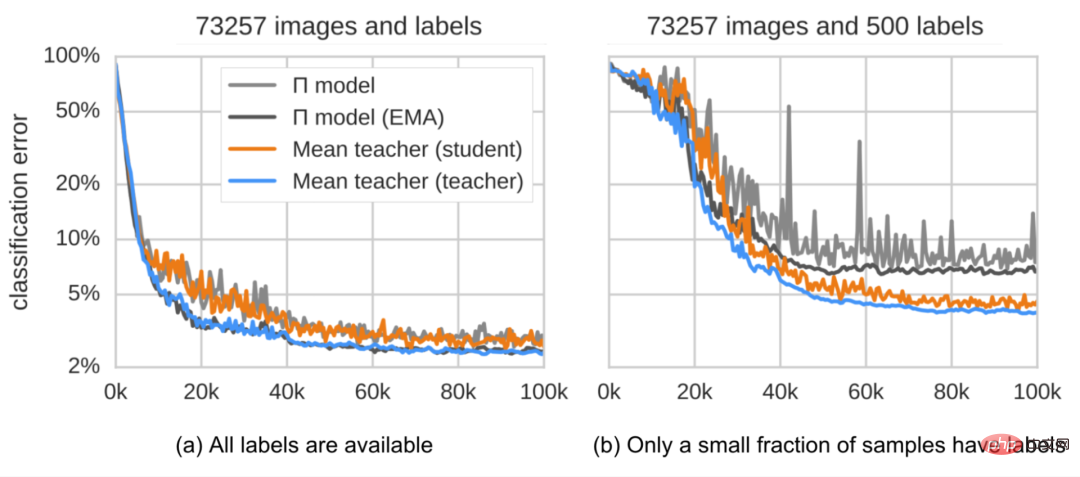

のリアルタイム モデル予測の指数移動平均 (EMA) を引き続き使用し、EMA の計算と更新は 1 回だけで済みます。各反復で。逐次積分モデルの出力

のリアルタイム モデル予測の指数移動平均 (EMA) を引き続き使用し、EMA の計算と更新は 1 回だけで済みます。各反復で。逐次積分モデルの出力  は 0 に初期化されているため、この起動バイアスを補正するために正規化のために

は 0 に初期化されているため、この起動バイアスを補正するために正規化のために  で除算します。 Adam オプティマイザーにも同じ理由でこのようなバイアス補正項があります。

で除算します。 Adam オプティマイザーにも同じ理由でこのようなバイアス補正項があります。  ここで、

ここで、 は t 回目の反復におけるアンサンブル予測、

は t 回目の反復におけるアンサンブル予測、 は現在のラウンドにおけるモデル予測です。

は現在のラウンドにおけるモデル予測です。  =0 であるため、バイアス補正後、

=0 であるため、バイアス補正後、 は最初の反復におけるモデル予測値

は最初の反復におけるモデル予測値  と完全に等しいことに注意してください。

と完全に等しいことに注意してください。

は真の値ラベルのワンホット エンコーディングを近似する真の分布、

は真の値ラベルのワンホット エンコーディングを近似する真の分布、 はモデル予測、

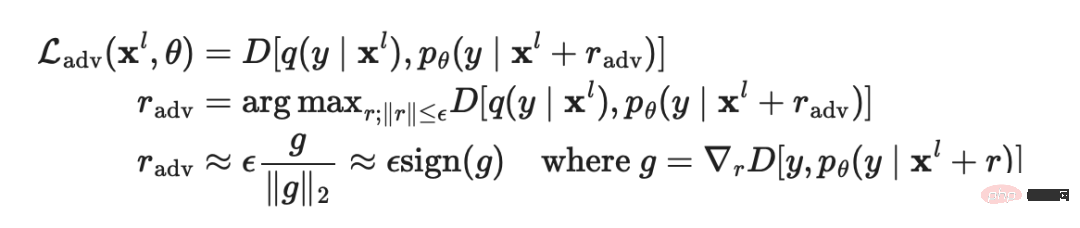

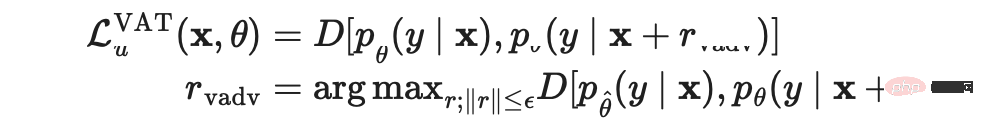

はモデル予測、 は値間の差を計算する距離関数です。 2つの配布。宮戸らは、2018 年に発表された論文「Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning」(Virtual Adversarial Training、VAT) で仮想敵対トレーニングを提案しましたが、この手法は、半教師あり学習の分野。

は値間の差を計算する距離関数です。 2つの配布。宮戸らは、2018 年に発表された論文「Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning」(Virtual Adversarial Training、VAT) で仮想敵対トレーニングを提案しましたが、この手法は、半教師あり学習の分野。  は未知であるため、現在の重みが

は未知であるため、現在の重みが  に設定されている場合、VAT は未知の項を元の入力の現在のモデルの予測に置き換えます。

に設定されている場合、VAT は未知の項を元の入力の現在のモデルの予測に置き換えます。  はモデルの重みの固定値であるため、

はモデルの重みの固定値であるため、 に対して勾配の更新は実行されないことに注意してください。

に対して勾配の更新は実行されないことに注意してください。

の移動平均を表します。

の移動平均を表します。

θ

θ

を計算する場合、以下を使用して UDA を使用できます。結果を最適化するための 3 つのトレーニング手法:

を計算する場合、以下を使用して UDA を使用できます。結果を最適化するための 3 つのトレーニング手法:  より低い場合は、マスク処理を実行します。

より低い場合は、マスク処理を実行します。  を使用して、予測確率分布を鮮明にします。

を使用して、予測確率分布を鮮明にします。

は##と同じモデル重みの固定値です。 # は VAT にあるため、勾配の更新はありません。

は##と同じモデル重みの固定値です。 # は VAT にあるため、勾配の更新はありません。 は拡張データ ポイント、

は拡張データ ポイント、 は予測信頼度のしきい値、

は予測信頼度のしきい値、 は分布鮮明化温度です。

は分布鮮明化温度です。

2 つのサンプルと対応する真のラベルと擬似ラベル

2 つのサンプルと対応する真のラベルと擬似ラベル  が与えられると、内挿ラベル方程式はソフトマックス出力クロスに変換できます。 -エントロピー損失:

が与えられると、内挿ラベル方程式はソフトマックス出力クロスに変換できます。 -エントロピー損失:

と

と  に設定します。ラベル付きサンプルの学生モデルの損失は

に設定します。ラベル付きサンプルの学生モデルの損失は

の関数として定義され、それに応じてこの損失を最小限に抑えるために教師モデルを最適化する傾向があります。

の関数として定義され、それに応じてこの損失を最小限に抑えるために教師モデルを最適化する傾向があります。

計算を実行しながら

計算を実行しながら  で 1 ステップの勾配更新を実行することに似ています。

で 1 ステップの勾配更新を実行することに似ています。

が与えられた場合、関数

が与えられた場合、関数  を通じて疑似ラベルを生成し、ワンステップの確率的勾配降下法を使用して

を通じて疑似ラベルを生成し、ワンステップの確率的勾配降下法を使用して  を最適化できます: ## #。

を最適化できます: ## #。

:

:  を最適化します。さらに、一貫した正則化を組み込むために、UDA オブジェクトが Teacher モデルに適用されます。

を最適化します。さらに、一貫した正則化を組み込むために、UDA オブジェクトが Teacher モデルに適用されます。

とラベルなしデータ

とラベルなしデータ  のバッチが与えられた場合、拡張バージョンは

のバッチが与えられた場合、拡張バージョンは  操作

操作  および

および  を通じて取得されます。それぞれ、強化されたサンプルとラベルされていないサンプルの予測されたラベルを表します。

を通じて取得されます。それぞれ、強化されたサンプルとラベルされていないサンプルの予測されたラベルを表します。

は、推測されるラベルの重複を減らすために使用されるシャープニング温度です。K はそれぞれの強化されたラベルの数です。ラベル サンプルによって生成されたバージョン。

は、推測されるラベルの重複を減らすために使用されるシャープニング温度です。K はそれぞれの強化されたラベルの数です。ラベル サンプルによって生成されたバージョン。 は MixMatch 関数のパラメーターです。各

は MixMatch 関数のパラメーターです。各  に対して、MixMatch は K 個の拡張バージョン (

に対して、MixMatch は K 個の拡張バージョン ( は k から 1 に等しい) を生成し、....、

は k から 1 に等しい) を生成し、....、 の K 個の拡張バージョンを生成し、モデルは平均

の K 個の拡張バージョンを生成し、モデルは平均  に基づいて擬似ラベルを推測します。

に基づいて擬似ラベルを推測します。

が真値ラベルの周辺分布に近くなります。

が真値ラベルの周辺分布に近くなります。  をグラウンド トゥルース ラベルのクラス分布、

をグラウンド トゥルース ラベルのクラス分布、 をラベルなしデータの予測クラス分布の移動平均とします。ラベルのないサンプル

をラベルなしデータの予測クラス分布の移動平均とします。ラベルのないサンプル  に対するモデルの予測は、真の周辺分布と一致するように

に対するモデルの予測は、真の周辺分布と一致するように  に正規化されます。

に正規化されます。  の事後確率 (つまり、サンプルがクリーンなサンプル セットに属する確率) がしきい値より大きい場合、サンプルはクリーンなサンプルとみなされ、それ以外の場合はノイズとみなされます。サンプル。

の事後確率 (つまり、サンプルがクリーンなサンプル セットに属する確率) がしきい値より大きい場合、サンプルはクリーンなサンプルとみなされ、それ以外の場合はノイズとみなされます。サンプル。

は平均です。別のネットワークがクリーンなデータ セットを生成する可能性

は平均です。別のネットワークがクリーンなデータ セットを生成する可能性  のもとで、

のもとで、 の複数の拡張バージョンが生成されます。

の複数の拡張バージョンが生成されます。

の相対的なサイズを決定するハイパーパラメーターです。弱い強化

の相対的なサイズを決定するハイパーパラメーターです。弱い強化 : 標準の翻訳と変換の強化。強力な強化

: 標準の翻訳と変換の強化。強力な強化 : AutoAugment、Cutout、RandAugment、CTAugment などのデータ強化方法。

: AutoAugment、Cutout、RandAugment、CTAugment などのデータ強化方法。

としたときの蒸留損失の式は次のとおりです。

としたときの蒸留損失の式は次のとおりです。