自然: AI モデルは大きいほど優れているのでしょうか?

生成 AI モデルは最近ますます大きくなっていますが、大きいほど良いのでしょうか? ######いいえ。現在、一部の科学者は、よりスリムでエネルギー効率の高いシステムを提案しています。

記事アドレス: https://www.nature.com/articles/d41586-023-00641-w

記事アドレス: https://www.nature.com/articles/d41586-023-00641-w

言語不定数学モデル

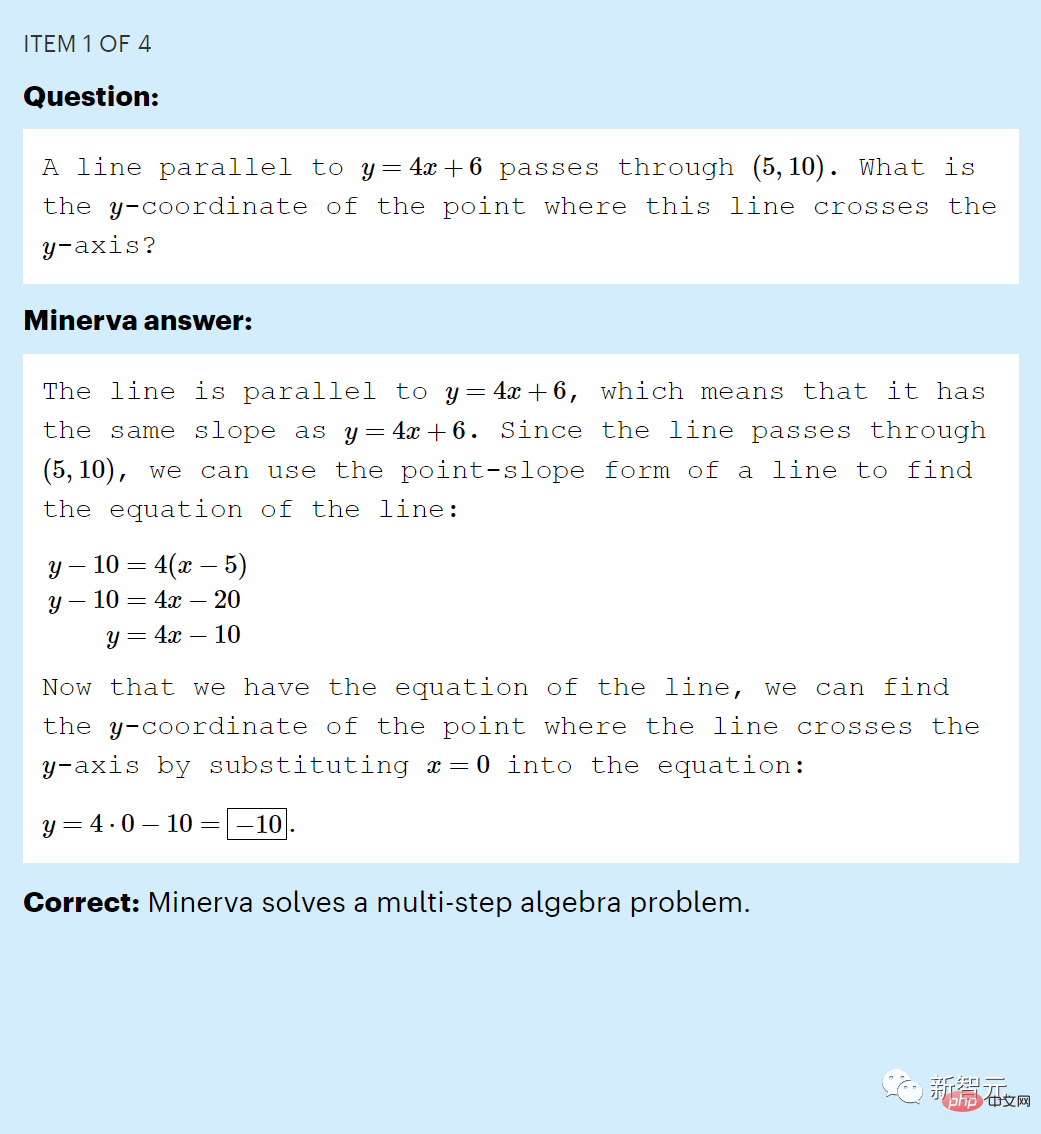

最近のテクノロジー業界の寵児である ChatGPT は、答えるのに推論が必要な数学的な質問に直面すると、パフォーマンスが低下することがよくあります。

たとえば、「y = 4 x 6 に平行な直線は (5, 10) を通ります。この直線と y 軸の交点の y 座標は何ですか?」という問題です。正しく答えられないことがよくあります。

推論能力の初期のテストでは、ChatGPT は中学校レベルの MATH データセットのサンプルに回答したとき、わずか 26 (パーセント) のスコアを獲得しました。

これは当然のことですが、入力テキストが与えられると、ChatGPT はトレーニング データ セット内の単語、記号、文章の統計規則に基づいて新しいテキストを生成するだけです。

言語モデルを学習するだけで数学的推論を模倣することを言語モデルが学習することはもちろん不可能です。

しかし実際には、2022 年 6 月の時点で、Google が作成した Minerva と呼ばれる大規模言語モデルがすでにこの「呪い」を解いていました。

ミネルバは、MATH データセット (2) の質問で 50% のスコアを獲得しました。この結果は研究者に衝撃を与えました。

ミネルバは「MATH」データセットの中学校の数学の問題に正解しました

ミネルバは「MATH」データセットの中学校の数学の問題に正解しました

Microsoft Research の機械学習専門家であるセバスチャン ビュベック氏は、内部関係者によると、彼らは皆ショックを受けてそれについて話しました。

Minerva の利点は、もちろん、数学のテキストでトレーニングされていることです。

しかし、Google の調査は、モデルのパフォーマンスが非常に優れているもう 1 つの大きな理由、つまりその規模の大きさを示唆しています。 ChatGPT の約 3 倍のサイズです。

ミネルバの結果は、一部の研究者が長い間疑問に思っていたこと、つまり大規模な LLM をトレーニングし、より多くのデータを供給することで、パターン認識のみによる推論が必要な問題を解決できる可能性があることを示唆しています。

もしそうなら、研究者らは、この「大きいほど良い」戦略が強力な人工知能への道を提供する可能性があると述べています。

しかし、この議論には明らかに疑問があります。

LLM は依然として明らかな間違いを犯しており、一部の科学者は、大規模なモデルはトレーニング データの関連範囲内のクエリに答える能力が向上するだけで、まったく新しい質問に答える能力は獲得できないと考えています。

この議論は現在、人工知能の最前線で激化しています。

営利企業は、AI モデルが大規模であれば、より良い結果が得られることを認識しており、構築、トレーニング、実行にそれぞれ数百万ドルの費用がかかる、ますます大規模な LLM を展開しています。

しかし、これらのモデルには大きな欠点があります。それらの出力は信頼できない可能性があり、誤った情報の拡散を促進するだけでなく、単に高価であり、多くのエネルギーを消費します。

コメンテーターは、大規模な LLM は決して真似したり、推論の質問に一貫して回答できるスキルを習得したりすることはできないと信じています。

コメンテーターは、大規模な LLM は決して真似したり、推論の質問に一貫して回答できるスキルを習得したりすることはできないと信じています。

その代わり、一部の科学者は、より小型でエネルギー効率の高い AI によって進歩がもたらされるだろうと主張しています。これは、脳が学習して接続を確立する方法に部分的にインスピレーションを得た見解です。

大きいモデルのほうが良いのでしょうか?

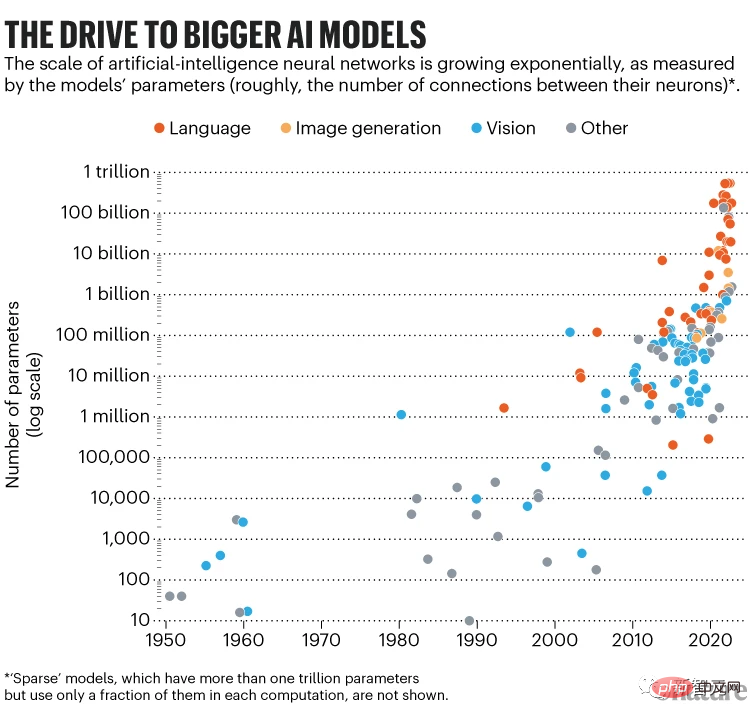

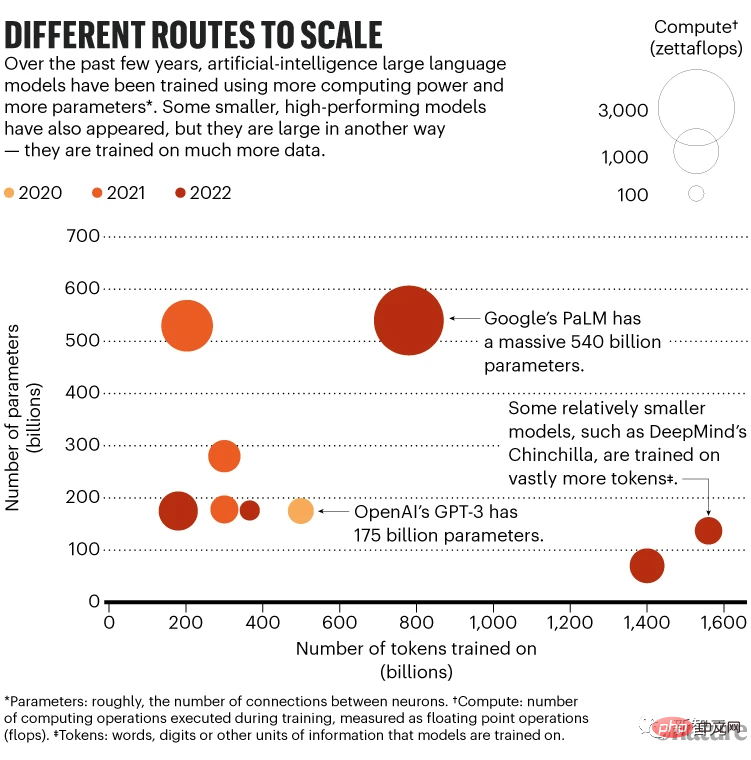

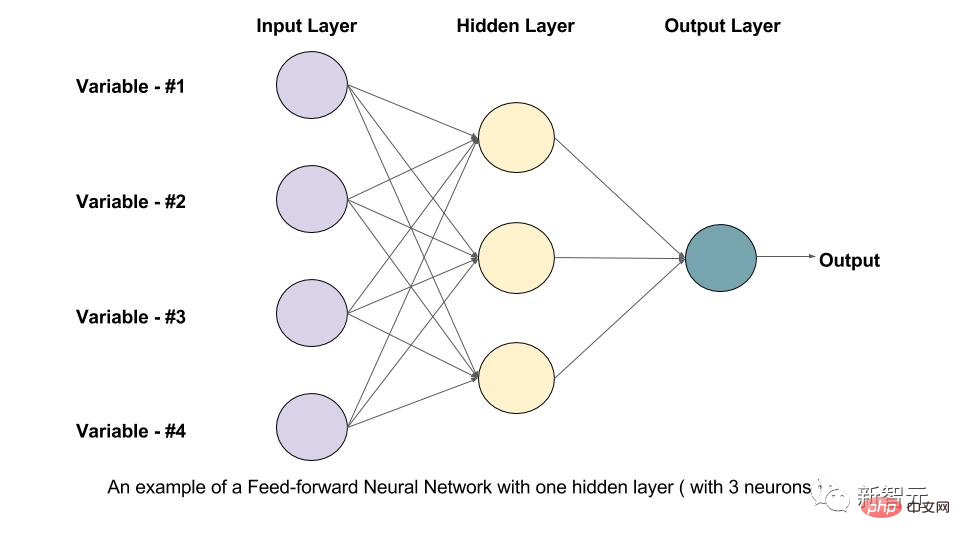

LLM のサイズは、LLM に含まれるパラメーターの数によって測定され、パラメーターの数はニューロン間の接続強度の調整可能な値を表します。

このようなネットワークをトレーニングするには、アルゴリズムが次回より適切に実行できるように、既知の文のマスク部分を予測し、これらのパラメーターを調整するようにネットワークに依頼する必要があります。

人間が書いた何十億もの文章に対してこの操作を繰り返すと、ニューラル ネットワークは人間が言語を書く方法を模倣する内部表現を学習します。

この段階では、LLM は事前トレーニング済みとみなされます。そのパラメーターは、テキスト内のすべての事実、バイアス、エラーを含む、トレーニング中に見た書き言葉の統計構造を捕捉します。その後、特殊なデータに基づいて「微調整」することができます。

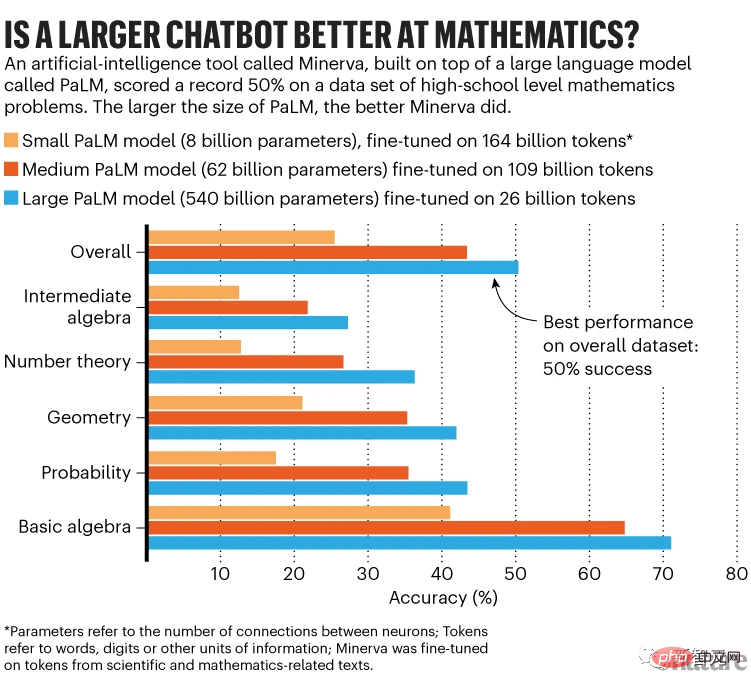

たとえば、Minerva を作成するために、研究者らは Google の Pathways Language Model (PaLM) を使用しました。PaLM には 5,400 億のパラメーターがあり、7,800 億のトークンのデータセットで事前トレーニングされています。

トークンは、単語、数字、または何らかの情報単位にすることができます。PaLM の場合、トークンは英語および多言語の Web ドキュメント、書籍、コードから収集されます。 Minerva は、PaLM が科学論文や数学 Web ページからの数百億のトークンを微調整した結果です。

ミネルヴァは、「520 未満の最大の 30 の倍数は何ですか?」という質問に答えることができます。

LLM は段階的に考えているように見えますが、問題をトークン シーケンスに変換し、統計的に妥当な次のトークンを生成し、それを元のシーケンスに追加し、別のトークンを生成するだけです。このプロセスは推論と呼ばれます。

Google の研究者は、80 億、620 億、5,400 億のパラメーターを備えた事前トレーニング済みの基盤となる PaLM モデルを使用して、ミネルバの 3 つのサイズを微調整しました。ミネルバのパフォーマンスはスケールに応じて向上します。

MATH データ セット全体で、最小モデルの精度は 25%、中程度のモデルは 43% に達し、最大のモデルは 50% の基準を突破します。

最大のモデルも微調整データが最も少なく使用されました。微調整されたのは 260 億トークンのみでしたが、最小のモデルは 1,640 億トークンで微調整されました。

しかし、最大のモデルは微調整に 1 か月かかり、特殊なハードウェアには最小のモデルの 8 倍のコンピューティング能力が必要でしたが、微調整にはわずか 2 週間かかりました。

理想的には、最大のモデルをより多くのトークンで微調整する必要があります。 Google Research の Minerva チームのメンバー、Ethan Dyer 氏は、これによりパフォーマンスが向上した可能性があると述べています。しかしチームは、コストを計算するのは実現可能ではないと考えた。

スケール効果

最大のミネルバ モデルが最高のパフォーマンスを示します。これは、スケーリング則 (スケール効果) に関する研究と一致しています。これらの法則がパフォーマンスを決定します。 モデルとしての改善方法サイズが大きくなります。

2020 年の調査では、パラメーターが多い、トレーニング データが多い、「計算」 (トレーニング中に実行される計算操作の数) が多い、の 3 つのいずれかが与えられた場合にモデルのパフォーマンスが向上することが示されました。

パフォーマンスはべき乗則に従ってスケールします。つまり、パラメーターの数が増加するにつれてパフォーマンスが向上します。

しかし、研究者たちはその理由を知りません。 「これらの法則は純粋に経験的なものです」とカナダのモントリオール大学ミラ・ケベック人工知能研究所のコンピューター科学者イリーナ・リッシュは言う。

最良の結果を得るには、2020 年の調査では、トレーニング データが 2 倍になるにつれてモデル サイズを 5 倍に増やす必要があることが示唆されています。昨年の作品から少し修正しました。

今年の 3 月、DeepMind は、モデル サイズとトレーニング データの両方を拡張することが最善であり、より多くのデータでトレーニングされたより小さなモデルの方が、より少ないデータでトレーニングされたより大きなモデルよりも優れたパフォーマンスを発揮すると主張しました。

たとえば、DeepMind の Chinchilla モデルには 700 億のパラメーターがあり、1 兆 4000 億のトークンでトレーニングされていますが、2,800 億のパラメーターの Gopher モデルは 3,000 億のトークンでトレーニングされています。その後の評価では、チンチラがゴーファーを上回りました。

2 月、メタ科学者たちは、この概念に基づいて LLaMA と呼ばれる小規模なパラメーター モデルを構築しました。これは、最大 1 兆 4000 億のトークンでトレーニングされました。

研究者らは、LLaMA の 130 億パラメータ バージョンは ChatGPT の前身である GPT-3 (1750 億パラメータ) よりも優れており、650 億パラメータ バージョンは Chinchilla や PaLM よりも競争力があると述べています。

昨年 10 月、モントリオールのマギル大学のイーサン・カバレロ氏らは、規模とパフォーマンスの間のより複雑な関係を発見したと報告しました。場合によっては、複数のべき乗則がパフォーマンスを制御できる可能性があります。モデルのサイズによってどのように変化するか。

たとえば、一般方程式を当てはめる仮説的なシナリオでは、パフォーマンスは最初は徐々に向上し、その後モデルのサイズが増加するにつれて急速に向上しますが、その後パラメーターの数が増加し続けるとわずかに低下します。その後また増加します。この複雑な関係の特性は、各モデルの詳細とそのトレーニング方法によって異なります。

最終的に、研究者らは、特定の LLM がいつスケールアップするかを事前に予測できるようにしたいと考えています。

別の理論的発見も、2021 年に Bubeck らによって提案された機械学習の「ロバスト性の法則」という、より大規模なモデルの推進を裏付けています。

入力に小さな変動があっても答えが一貫している場合、モデルは堅牢です。

そして、Bubeck と彼の同僚は、モデル内のパラメータの数を増やすとロバスト性が向上し、ひいては汎化能力が向上することを数学的に実証しました。

Bubeck 氏は、スケールアップは必要だが、一般化するには十分ではないことを定期的な証拠が示していると述べました。それでも、より大きなモデルへの移行を正当化するために利用されてきました。 「それは合理的なことだと思います。」

ミネルヴァは、思考連鎖プロンプトと呼ばれる重要なイノベーションも利用しています。ユーザーは、問題と解決策のいくつかの例、および答えに至る推論を含むテキストを質問の前に付けます (これは古典的な思考連鎖です)。

推論中、LLM はこのコンテキストからヒントを得て、推論のように見える段階的な答えを提供します。

これにはモデルのパラメーターを更新する必要がないため、微調整に必要な追加の計算能力は必要ありません。

思考連鎖プロンプトに応答する機能は、1,000 億を超えるパラメータを持つ LLM にのみ表示されます。

Google Research の Blaise Agüera y Arcas 氏は、この結果は経験的なスケーリング則に基づいて大規模なモデルを改善するのに役立つと述べました。 「モデルが大きくなれば、どんどん良くなる。」

合理的な懸念

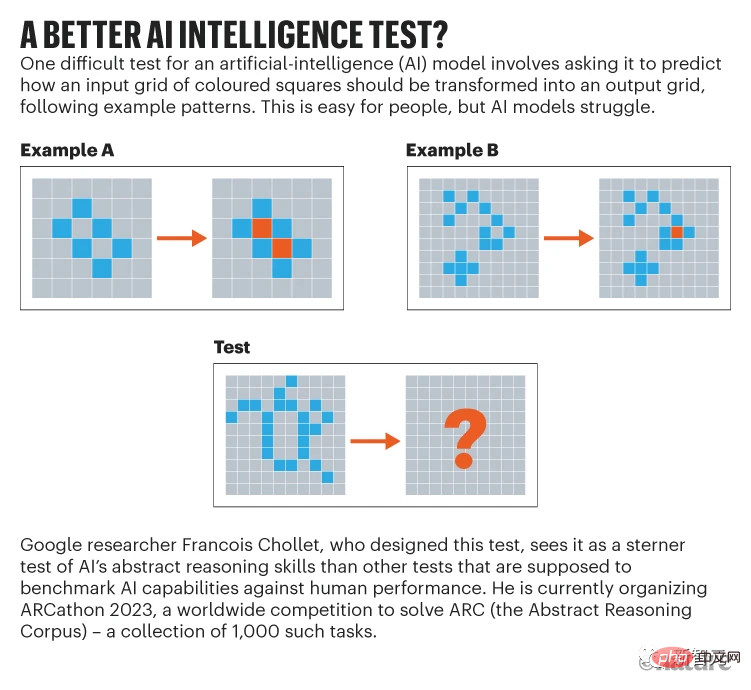

Google の人工知能研究者であるフランソワ ショレ氏は、 LLM がどれほど大きくなっても、新しい問題を確実に解決するのに十分な推論 (または模倣推論) 能力を備えることはできません。

彼は、LLM は、トレーニング データまたはプロンプトのいずれかで、以前に遭遇したテンプレートを使用することによってのみ推論しているようだと述べました。 「見たことのないものを即座に理解することはできません。」

おそらく、LLM ができる最善のことは、言語自体の統計パターンを使用できるほど多くのトレーニング データを吸収することです。質問に対する答え。

しかし、Agüera y Arcas は、LLM は特別な訓練を受けていない驚くべきいくつかの能力を獲得しているようだと考えています。

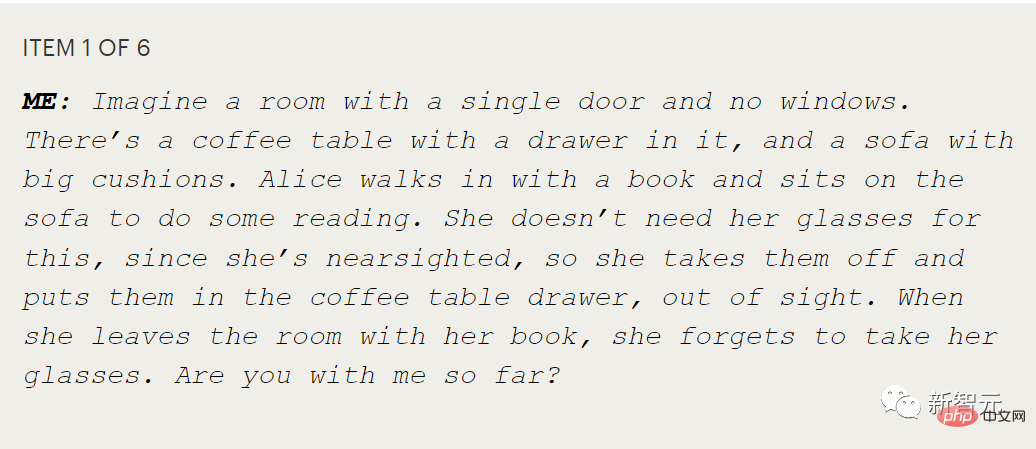

特に、テストでは、その人がいわゆる心の理論、つまり他人の精神状態を理論化または測定する能力を持っているかどうかが示されます。

たとえば、アリスはメガネを引き出しに置き、ボブはアリスに気づかれないようにメガネをクッションの下に隠します。アリスはメガネを見つけるために最初にどこに行きますか?

子供にこの質問をすることは、アリスには彼女独自の信念があり、それは子供の知っていることと一致しない可能性があることを理解しているかどうかをテストすることです。

Google のもう 1 つの LLM、Agüera y Arcas の LaMDA のテストでは、LaMDA がこの種のより拡張された会話で正しく応答することがわかりました。

彼にとって、これは他人の意図を内部的にシミュレートするLLMの能力を示しています。

Agüera y Arcas 氏は次のように述べています:「シーケンスを予測するだけのこれらのモデルは、心の理論を含むさまざまな驚くべき能力を開発しました。」しかし、彼はこれらのモデルが間違いを起こしやすいことを認めました。スケールを変更するだけで信頼性の高い推論を行うのに十分かどうかはわかりませんが、必要なようです。

Google Research の Blaise Agüera y Arcas が、LaMDA との会話についてブログに書きました。物語の中で二人の対話者が何を知っていて何を知らなかったかを一貫してモデル化することができ、明らかに心の理論のパロディである

しかし、チョレット氏は、たとえ LLM であっても、

しかし、チョレット氏は、たとえ LLM であっても、

「少し詳しく調べてみると、それが空であることがすぐにわかります。ChatGPT にはそれがありません。あなたが話していることのモデルです。」それはあたかも人形劇を見ているのに、その人形が生きていると信じているようなものです。」

これまでのところ、LLM は人間では絶対に犯さない不条理な間違いを依然として犯している、とメラニー・ミッチェル氏は語った。彼女はサンタフェ研究所で人工知能システムにおける概念的な抽象化と類推を研究しています。

これにより、ガードレールなしでLLMを社会に放出するのが安全なのかという懸念が生じています。

ミッチェル氏は、LLM が真に新しいまだ見たことのない問題を解決できるかどうかの難点の 1 つは、この能力を完全にテストできていないことだと付け加えました。

「私たちの現在のベンチマークは十分ではありません」と彼女は言いました。 「彼らは物事を体系的に探求しません。私たちはそれを行う方法をまだ知りません。」

チョレットは、抽象推論コーパスと呼ばれる、彼が設計した抽象推論テストを提唱しています。

規模による問題

規模による問題

たとえば、OpenAI は GPT-3 のトレーニングに 400 万ドル以上を費やすと予想されており、ChatGPT の運用を維持するには毎月数百万ドルかかる可能性があります。

その結果、さまざまな国の政府がこの分野での優位性を拡大しようと介入し始めています。

昨年 6 月、約 1,000 人の学術ボランティアからなる国際チームが、フランス政府、Hugging Face およびその他の機関からの資金提供を受けて、700 万ドル相当のコンピューティング時間を費やして、1,760 パラメーター、数十億の BLOOM モデルをトレーニングしました。

米国エネルギー省も 11 月に、大規模な研究モデル プロジェクトに独自のスーパーコンピューティングを認可しました。研究チームはチンチラと同様の700億個のパラメータモデルを訓練する予定だという。

#ただし、誰がトレーニングを行うとしても、LLM の消費電力を過小評価することはできません。

#ただし、誰がトレーニングを行うとしても、LLM の消費電力を過小評価することはできません。

Google によると、PaLM のトレーニングには約 2 か月間で約 3.4 ギガワット時がかかり、これは米国の家庭約 300 軒の 1 年間のエネルギー消費量に相当します。

Google は 89% クリーン エネルギーを使用していると主張していますが、業界全体の調査によると、ほとんどのトレーニングでは主に化石燃料を燃料とする電力網が使用されています。

より小さく、よりスマートに?

この観点から、研究者は LLM のエネルギー消費を削減し、ニューラル ネットワークをより小さく、より効率的に、そしておそらくよりスマートにすることに熱心に取り組んでいます。

LLM のトレーニングにかかるエネルギー コスト (かなりの量ではありますが、これも 1 回限り) に加えて、推論に必要なエネルギーはユーザー数が増加するにつれて急増します。たとえば、BLOOM モデルは、Google Cloud Platform にデプロイされた 18 日間で合計 230,768 のクエリに応答し、平均電力は 1,664 ワットでした。

それに比べて、私たち自身の脳はどの LLM よりもはるかに複雑で大きく、860 億個のニューロンと約 100 兆個のシナプス接続を備えていますが、電力はわずか約 20 ~ 50 ワットです。

その結果、一部の研究者は、脳を模倣することでモデルをより小さく、よりスマートに、より効率的にするというビジョンを実現したいと考えています。

本質的に、LLM は「フィードフォワード」ネットワークです。これは、情報が入力から LLM の層を通って出力端まで一方向に流れることを意味します。

しかし、脳はそうではありません。たとえば、人間の視覚系では、ニューロンは、受け取った情報を脳に順方向に伝達するだけでなく、ニューロン間で逆方向に情報を伝達できるようにするフィードバック接続も備えています。フィードフォワード接続の数の 10 倍のフィードバック接続が存在する可能性があります。

人工ニューラル ネットワークでは、リカレント ニューラル ネットワーク (RNN) にもフィードフォワード接続とフィードバック接続の両方が含まれます。フィードフォワード ネットワークのみを持つ LLM とは異なり、RNN は時間の経過に伴うデータのパターンを識別できます。ただし、RNN はトレーニングが難しく、速度が遅いため、LLM の規模に拡張することが困難です。

現在、小規模なデータセットを使用したいくつかの研究では、スパイキング ニューロンを備えた RNN は標準的な RNN よりも優れたパフォーマンスを発揮でき、理論上は計算効率が 3 桁も高いことが示されています。

ただし、このようなスパイク ネットワークがソフトウェアでシミュレートされている限り、真の効率向上を達成することはできません (スパイキング ネットワークをシミュレートするハードウェアは依然としてエネルギーを消費するため)。

一方、研究者たちは、既存の LLM のエネルギー効率を高めるさまざまな方法を実験しています。

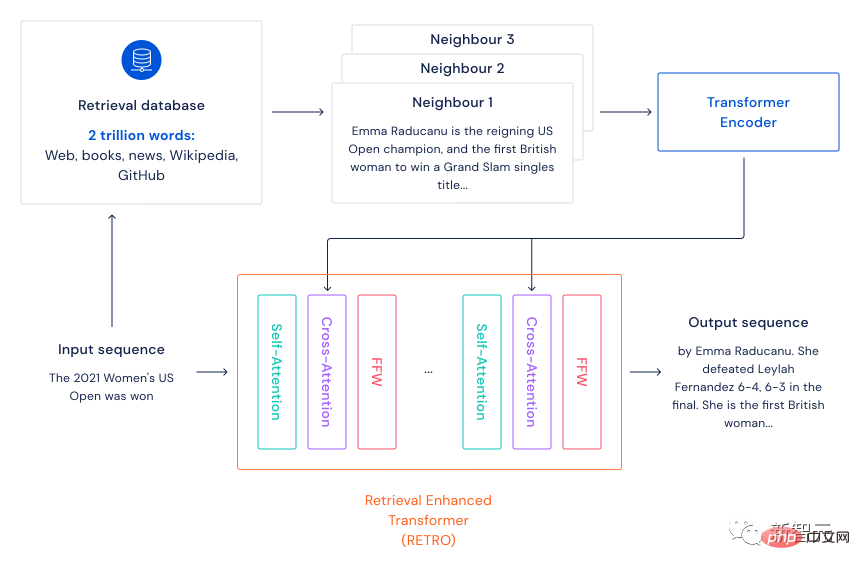

2021 年 12 月、DeepMind は検索ベースの言語モデル フレームワーク Retro を提案しました。

#レトロは主に、学習時に現在の知識を使用するだけでなく記憶を呼び出す脳のメカニズムを模倣します。その枠組みは、まず大規模なテキストデータセット(脳の記憶として機能する)を準備し、kNNアルゴリズムを使用して入力文の最近傍n文(検索記憶)を見つけることです。

入力文と取得された文が Transformer によってエンコードされた後、クロスアテンションが実行されるため、モデルは入力文の情報とメモリ情報を同時に使用してさまざまな NLP タスクを完了できます。

以前のモデルの多数のパラメーターは、主にトレーニング データ内の情報を保存するためでした。この検索ベースのフレームワークを使用すると、モデル内のパラメーターの数が減少します。特別に大きくする必要はなく、より多くのテキスト情報を含めることができるため、パフォーマンスをあまり低下させることなくモデルの速度が自然に向上します。

この方法ならモデルトレーニング中の電気代も節約でき、環境に優しい女子たちにも好評でした!

実験結果は、75 億のパラメーターと 2 兆のトークンのデータベースを備えた大規模な言語モデルが、25 倍のパラメーターを備えたモデルよりも優れたパフォーマンスを発揮できることを示しています。研究者らは、これは「より強力な言語モデルを構築しようとする場合、生のパラメータスケーリングよりも効率的なアプローチ」であると書いている。

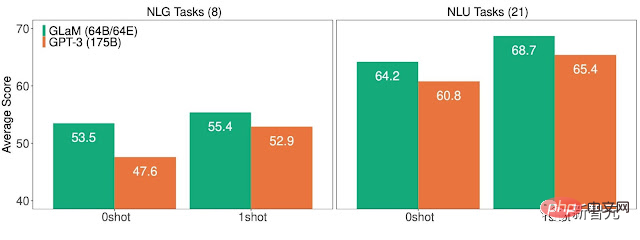

同じ月、Google の研究者は、エネルギー効率を大規模に改善する別の方法を提案しました。

1.2 兆個のパラメータを持つこの疎な一般言語モデル GLaM は、内部に 64 個の小さなニューラル ネットワークを持っています。

推論プロセス中、モデルはタスクを完了するために 2 つのネットワークのみを使用します。言い換えれば、1 兆を超えるパラメータのうち、約 8% のみが使用されることになります。

Google によると、GLaM は GPT-3 のトレーニングに必要なコンピューティング リソースと同じコンピューティング リソースを使用しますが、トレーニング ソフトウェアとハードウェアの改良により、エネルギー消費量は GPT-3 の 1/3 にすぎません。推論に必要な計算リソースは GPT-3 の半分です。さらに、GLaM は、同じ量のデータでトレーニングした場合、GPT-3 よりも優れたパフォーマンスを発揮します。

しかし、更なる改善のために、これらのよりエネルギー効率の高い LLM であっても、サイズが大きくなり、より多くのデータと計算を使用するよう運命づけられているようです。

参考資料:

https://www.nature.com/articles/d41586-023-00641-w

以上が自然: AI モデルは大きいほど優れているのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

データベース酸属性の詳細な説明酸属性は、データベーストランザクションの信頼性と一貫性を確保するための一連のルールです。データベースシステムがトランザクションを処理する方法を定義し、システムのクラッシュ、停電、または複数のユーザーの同時アクセスの場合でも、データの整合性と精度を確保します。酸属性の概要原子性:トランザクションは不可分な単位と見なされます。どの部分も失敗し、トランザクション全体がロールバックされ、データベースは変更を保持しません。たとえば、銀行の譲渡が1つのアカウントから控除されているが別のアカウントに増加しない場合、操作全体が取り消されます。 TRANSACTION; updateaccountssetbalance = balance-100wh