近年、質問応答技術やマルチモーダル理解技術の活発な発展により、視覚的な質問応答タスク(Visual Question Answering)がますます普及しています。 VQA、CLEVER、Visual-7Wなどの大規模なビジュアル質問応答データセットが次々にリリースされ、ビジュアル質問応答タスクの反復開発が大きく促進されました。しかし、現在の視覚的質問回答データのほとんどは、「彼女の目は何色ですか?」など、写真を見たアノテーターが架空にデザインした人工的に合成された質問です。手動で生成されたデータは比較的単純で、品質が低く、さらに偏っています。したがって、この研究では、QQ ブラウザーでのユーザーからの実際の質問に基づいた、大規模な中国語ベースの画像質問と回答のデータセット、ChiQA を提案します。

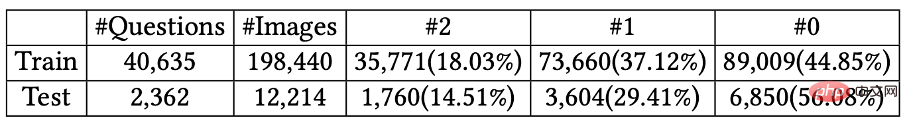

ChiQA には、40,000 を超える実際のユーザー クエリと 200,000 を超える質問と画像のペアが含まれています。データといくつかのベースライン モデルは GitHub で公開されています。関連する研究が CIKM2022 の長い論文に採択されました。

文書アドレス: https://arxiv.org/abs/2208.03030

Github アドレス: https://github.com/benywon/ChiQA

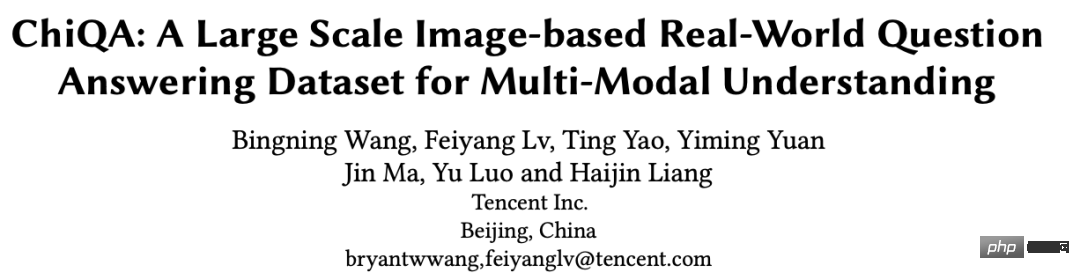

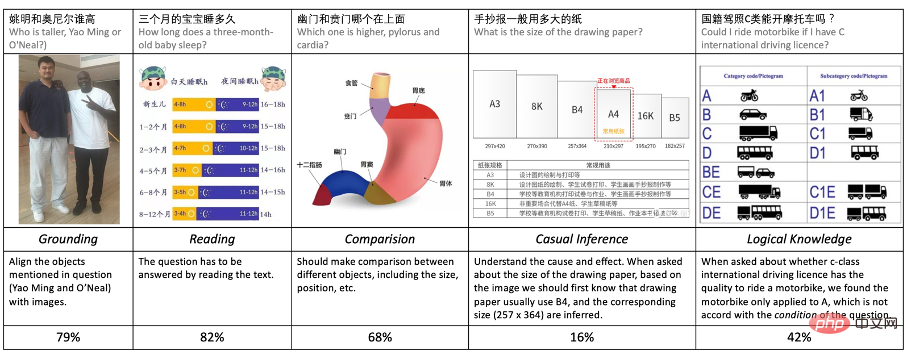

シングルモーダル質問応答タスクの比較ChiQA の 3 つの顕著な機能質問応答は、人工知能およびインテリジェント言語処理において非常に重要なタスクの 1 つです。近年、大規模なデータセット (SQuAD、NaturalQuestions など) のリリースと大規模な事前トレーニング済み言語モデル (BERT、GPT など) の導入により、質問と回答のタスクが急速に発展しました。ただし、現在のほとんどの質問応答タスクは単峰性です。つまり、質問、リソース、回答はすべてテキストベースです。ただし、認知知能と実際のアプリケーションの観点から見ると、画像などのマルチモーダル リソースの方がより豊富な情報と回答を提供できることがよくあります。たとえば、「iPhone13 の寸法はどれくらいですか?」という質問の場合です。さまざまなiPhone13モデルのサイズ比較表は、より明確で直感的です。以下に示すような例もいくつかあります。

#図 1: 画像を使用してユーザーの質問に答えるのに適した例

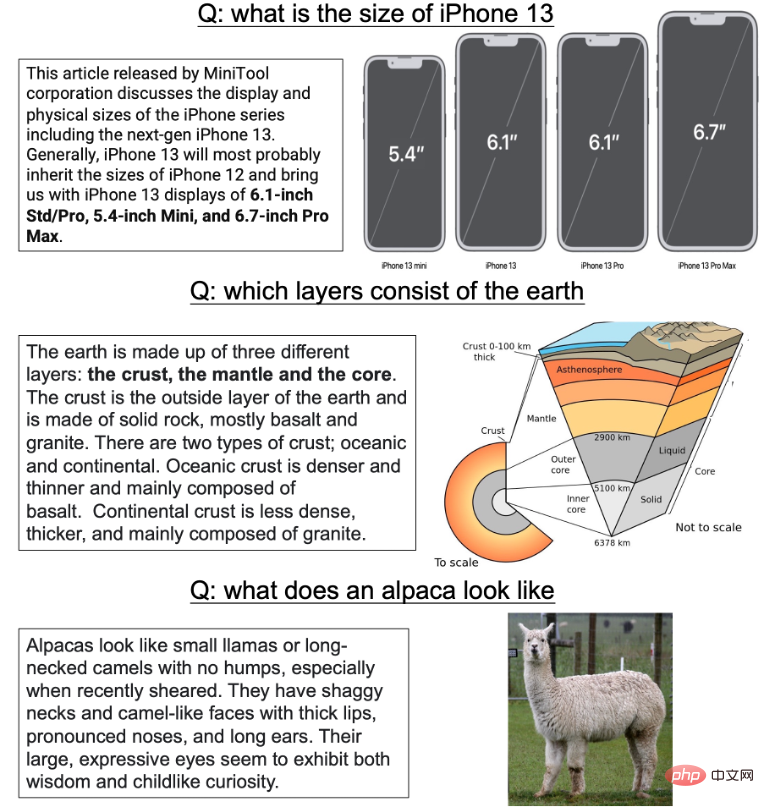

近年、マルチモーダルな理解を実現するための質問回答データやタスクが次々と提案されています。 VQA1.0および2.0、CLEVR、GQAなど。ほとんどの画像の質問と回答のデータ セットでは、システムは人工的に生成された画像または実際の画像をアノテーターに提供します。アノテーターは、特定の属性またはエンティティを対象としたいくつかの質問を手動で作成する必要があります。ただし、このデータ収集プロセスには必然的に多くの欠陥があります:1) すべての質問は画像に依存します。つまり、アノテーターは画像を見た後に質問します。大規模なデータ構築の過程において、人為的に生成された質問は多様性に欠け、アノテーターの主観的要因により偏っていることがよくあります。最初にリソースを調べてから質問するこの種のデータでトレーニングされたモデルは、多くの場合、背景のリソースを見ずに質問を調べることで、非常に良い結果を簡単に達成できます。

2)第 2 に、従来の VQA データでは、答えは単純なエンティティ、関係、または特定の領域の単純な説明であることがよくあります。しかし、実際の画像質疑応答タスクでは、テキストによる回答の多くは不要です。たとえば、「アルパカはどのように見えますか?」という質問に対して、アルパカの外観を説明する長い回答を提供することは非常に冗長です。第 2 に、この種の短いエンティティ記述では、アノテーターが局所的な関係のみに注意を払い、実際の全体構造に関する一部の情報にはほとんど注意を払わないことがよくあります。

3) 最後に、ほとんどの前へ リソースは英語に重点を置く傾向があり、中国語ドメインの画像に関する質問と回答のデータはほとんどありません。

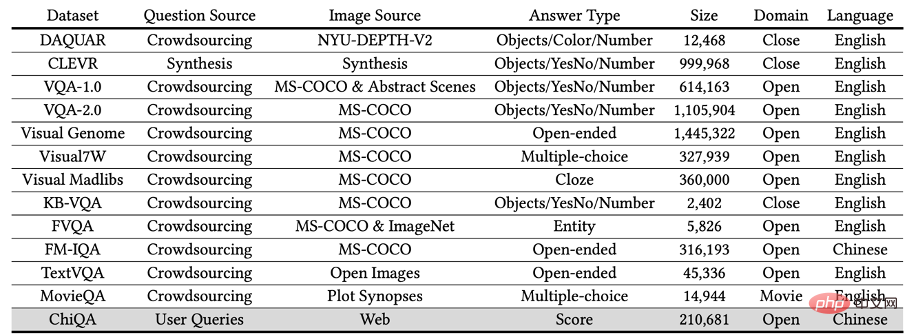

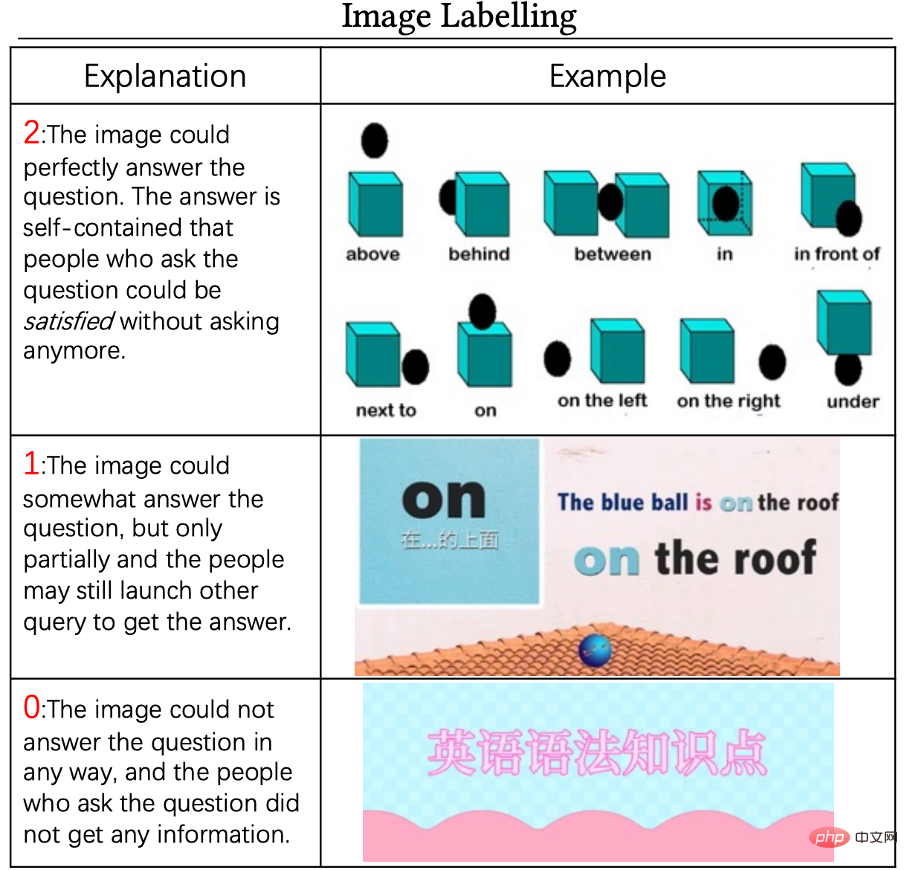

この研究では、上記の問題に応えて、大規模な中国語画像質問応答データセット - ChiQA (中国語画像質問応答) を提案します。私たちは、モバイル QQ ブラウザでユーザーの実際の検索語句から開始し、特定の API を通じていくつかの関連画像を取得しました。その後、画像が質問に完全に答えることができるかどうかを示すための 3 レベルの注釈を専門的に訓練されたアノテーターに画像を渡しました ( 2 ポイント)ユーザーの質問に対して、一部回答した(1 ポイント)、回答できなかった(0 ポイント)。 ChiQA には、次の 3 つの注目すべき機能があります。 最終的に、40,000 を超える質問を収集しました。各質問には約 5 つの関連する画像があり、合計 200,000 を超える質問と画像のペアが含まれています。各質問には複数の写真があり、各写真を 2-1-0 の 3 段階スケールで採点します。 ChiQA の例をいくつか以下に示します。

データ収集: すべての質問は実際のユーザーのクエリから得られます

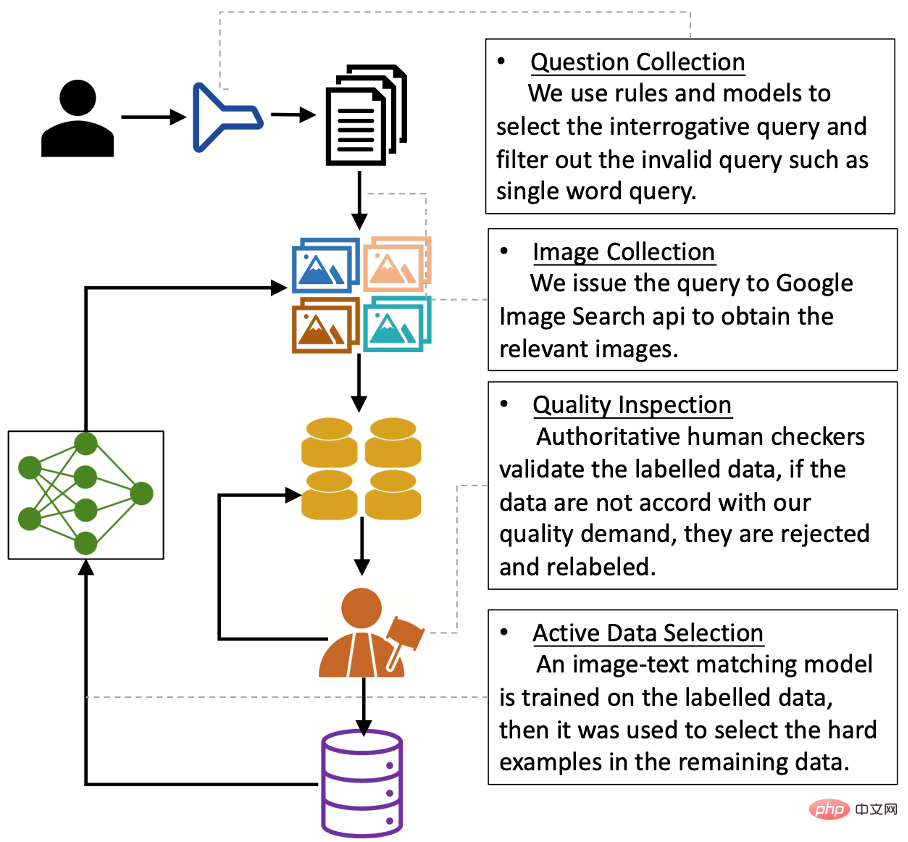

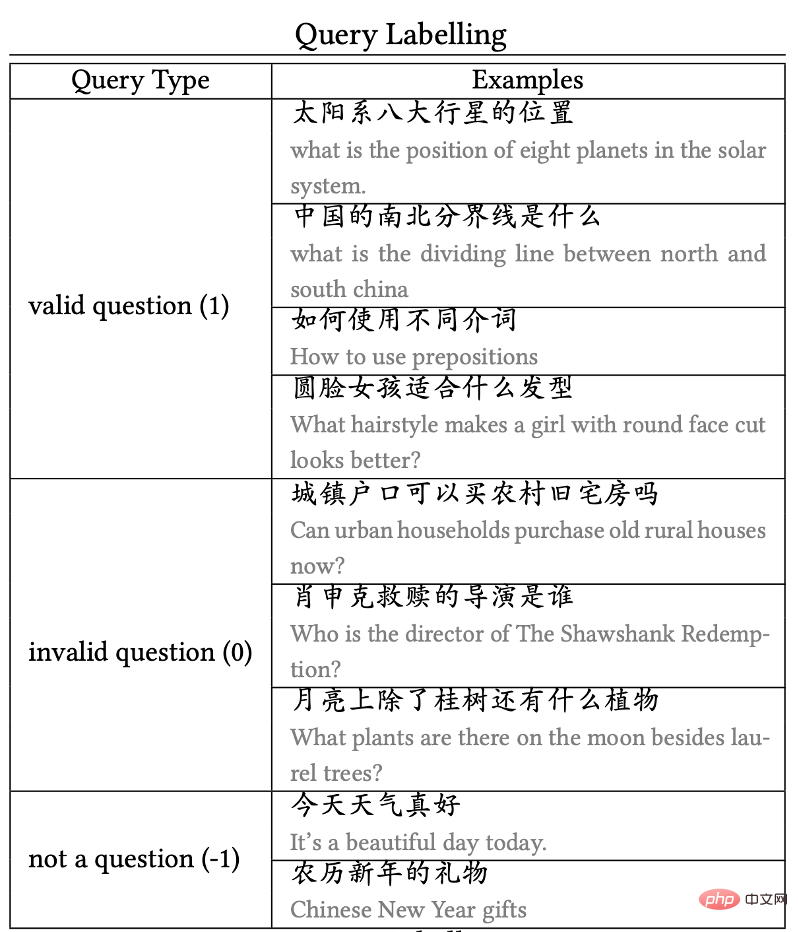

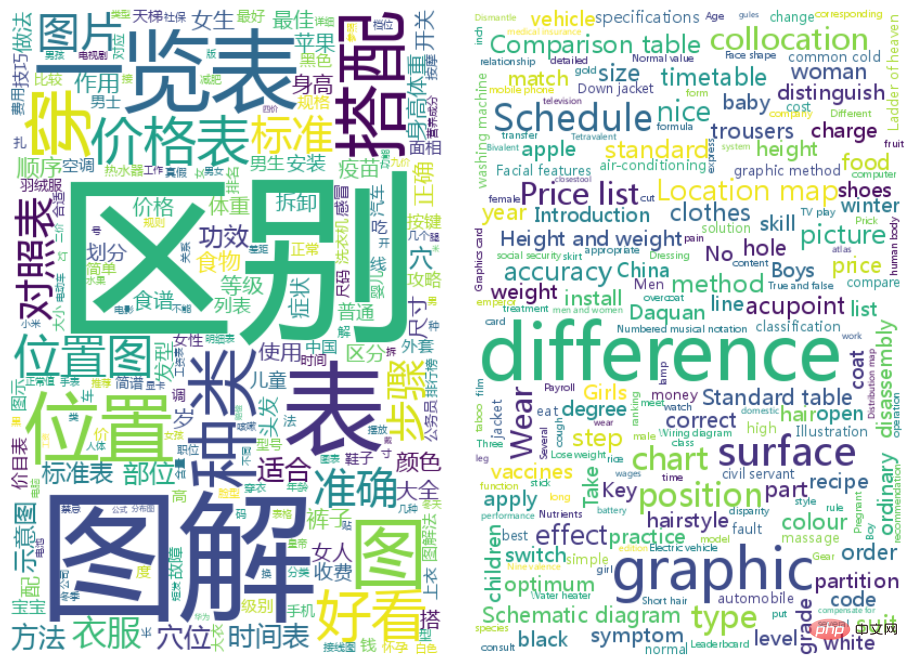

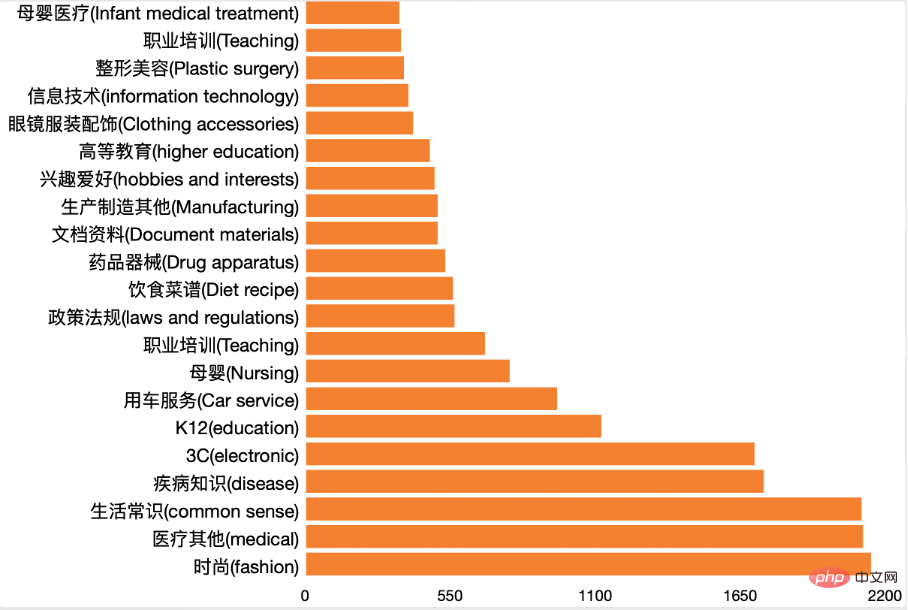

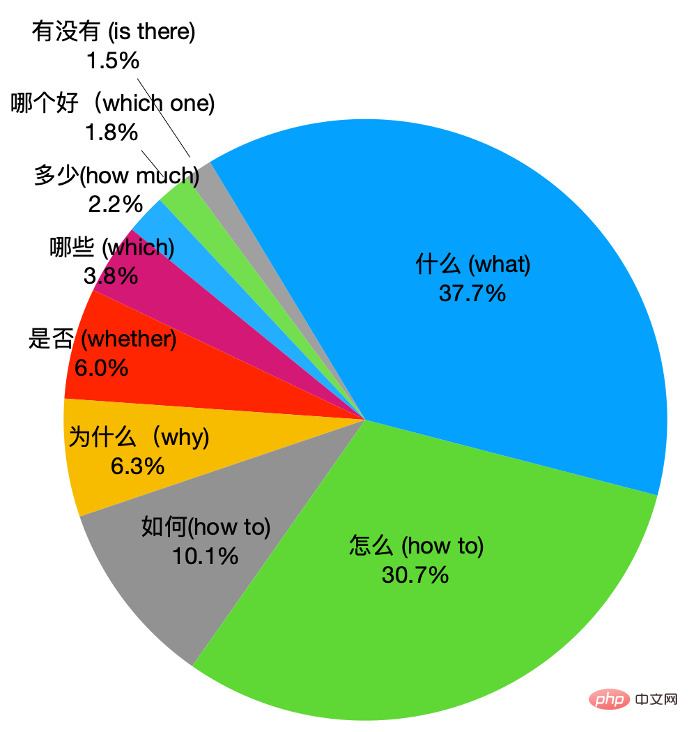

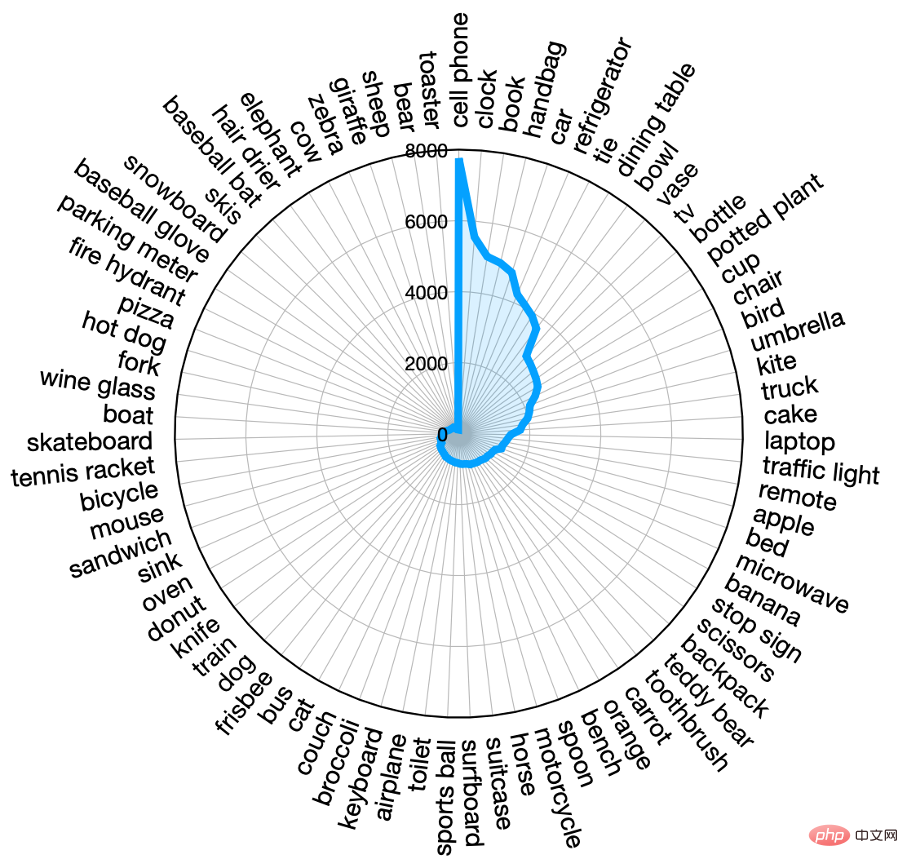

##図 4: データ収集プロセス ChiQA の主な特徴は、すべての質問が実際のユーザーのクエリから得られることです。しかし、検索エンジン ユーザーの検索ログからユーザーのクエリをランダムにサンプリングすると、ほとんどのクエリには質疑応答の意図はありません。 したがって、最初に質問と回答の意図を持つクエリを除外する必要があります。この研究では、内部で構築された弱い監視メソッドを使用してバイナリ分類器をトレーニングし、クエリに質問応答の意図があるかどうかを判断します。この意図モデルの人による評価では、90% の精度と 80% の再現率を達成することができました。このモデルを使用してユーザー クエリをサンプリングし、モデルによって Q&A の意図があると判断されて次のラウンドに移行した約 75,000 のユーザー クエリを取得しました。 質問を取得した後、関連する画像を取得するために、これらの質問を Google が提供するオープン API (Google Images API - SerpApi) に送信します。 Google API は、クエリごとに最も関連性の高い 100 個の画像を返します。最終データの品質を確保するために、長さまたは幅が 200 ピクセル未満のクエリと、長すぎるか幅が広すぎる画像を削除しました。 元の画像を取得した後、フィルタリングされた最初の 5 つの画像を取得し、アノテーターにクエリと対応する 5 つの画像に注釈を付けるように依頼します。以下の図に示すように、このタスク専用に注釈インターフェイスを設計しました。 図 5: ChiQA アノテーション インターフェイス アノテーション プロセス中に、私たちはアノテーターに次の 3 つの側面にマークを付けるよう依頼しました。 1) 問題の注釈 この作業は主に画像に焦点を当てているため、 Q&A、実際、ユーザーからの一般的な質問の多くは、画像 Q&A とは関係がありません (または、画像で答えるのが難しいものです)。そこで、まずこの質問がイメージ問答問題とみなせるかどうかを注釈者にマークしてもらいます。例: #質問が「xxx と xxx の違い」の場合、この質問はイメージ問答を目的とした質問とみなされます; 質問が漠然としていたり曖昧であったり、事実の推測に基づいていない意見が含まれている場合、その質問は画像 Q&A の意図がないと分類され、その後の画像注釈プロセスには参加しません。 いくつかのクエリ アノテーションの例を図 6 に示します。 図 6: 例クエリ注釈の 2) 画像注釈 前のステップの有効なクエリについては、 5 つの候補クエリにラベルを付けます。注釈標準は 3 レベルの 0-1-2 注釈です。 0 ポイントは、その画像を使用してこの質問にまったく答えることができないことを意味し、2 ポイントは、質問に答えることができないことを意味します。画質は許容範囲内であり、十分に使用できます。この質問に個別に回答してください。スコア 1 の画像は、その 2 つの中間にあります。これは、画像がクエリに関連していることを意味しますが、直接回答することはできません。最終的な回答を得るには、ユーザーがさらにクエリや推論を必要とする可能性があります。 0 ポイント、1 ポイント、および 2 ポイントの例を以下に示します。 ## 図 7: 「異なるポイントを使用する方法」という質問に対して前置詞 」、画像の注釈とスコアリングの例 3) 品質管理 私たちは、アノテーションの全プロセス 厳格な品質管理プログラムが採用されています。具体的には、まず 3 つの品質の高いチームを招待してトライアル アノテーションを実施し、最も優れたアノテーション品質を持つチームを選択して、残りのすべてのデータにアノテーションを付けます。第 2 に、アノテーション プロセス中に、アノテーション付きデータをバッチに分割します。データのバッチごとに、手動検証のためにデータの 5 分の 1 をサンプリングします。データの合格率が 90% 未満の場合、これはバッチ データは返され、データの精度が 90% に達するまで再ラベル付けされます。 データ収集作業の後、データがランダムにサンプリングされ、アノテーションが付けられた場合、多くの場合、いくつかの単純なパターンがあり、そのような単純なパターンがデータ内に多数存在すると、最終的なモデルに偏りが生じる可能性があります。したがって、アクティブラーニングアノテーションプロセスを設計します。具体的には、まずアノテーターにデータのバッチにアノテーションを付けるよう依頼し、データのバッチのアノテーションが完了した後、このデータのバッチを使用して膜貫通テキストと画像のマッチング モデルをトレーニングします。モデルがトレーニングされた後、このモデルを使用して新しいサンプルを「選択」し始めます。モデルがこの新しいサンプルの予測について非常に不確実な場合 (つまり、最終的な分類予測のエントロピーが特に大きい場合)、このサンプルはモデルにとって比較的難しいと考えられます。したがって、次のラウンドの途中まで保持される可能性が高くなります。そうでない場合は、モデルがデータに非常に自信を持っていることを意味するため、モデルはそれを保持します。次のラウンドまで確率が低くなります。 アクティブ ラーニング データ選択プロセスにより、実際にデータセットがより不偏になることがわかりました。最初の段階でラベル付けされたデータには、目に見えないバイアスが含まれていることがわかりました。たとえば、「ヒント」という単語を含む質問は有効な質問としてマークされますが、対応するほとんどすべての画像は回答不能 (つまり、0 ポイント) としてマークされます。したがって、モデルは、質問に含まれる質問に基づいて最終的な質問を直接予測する可能性があります。画像を見ずにクエリを実行すると、結果が表示されます。この能動学習プロセスにより、この信頼性が高く偏ったショートカットが次のラウンドで選択することが困難になる可能性が低減され、その結果、このモデルの影響が軽減されます。 アノテーション付きデータから 2,500 個のデータをランダムに除外し、異なるアノテーターに再アノテーションを付けるよう依頼しました。アノテーションの結果が前回の結果と同じであれば、データはテストセットとして保持され、異なる場合には、そのタスクをよく知る「専門家」に再度アノテーションを依頼し、最終的に2362テストを取得します。データと 40,000 を超えるトレーニング データ。トレーニング セットとテスト セットの統計情報を次の図に示します。 図 8: トレーニング セットの統計情報ChiQA のトレーニング セットとテスト セット データに注釈を付けた後、ChiQA でデータの統計と分析を実行します。 1) クエリの一般的な単語の分析: 吃音単語セグメンテーションを使用してクエリをセグメント化し、単語をクエリします。は頻度に応じて次のクラウド チャートに表示されます: #ChiQA で最も一般的なクエリであることがわかります。違いやイラスト、場所など。これは私たちの直観と一致します。なぜなら、これらの言葉は実際に写真が答えるのに非常に適した質問だからです。 2) ドメイン分析 内部ドメイン分類分類子を使用してすべてのクエリを実行します。分類、最終結果 データには多くのフィールドのデータが含まれており、フィールド内のデータは 1 つも含まれていないことがわかります。分野が絶対多数を占めます。これにより、データの分布が均一になります。次に、質問内の疑問詞もカウントします。結果は次の図に示されています。 ChiQA ではこのような質問が大半を占めており、その他の質問もかなりの割合を占めています。 #3) 画像分析 質問に加えて、ChiQA で画像の分析も実行しました。ほとんどの画像は言語に依存しないため、業界で優れたパフォーマンスを持つと認められているターゲット検出モデル DETR を使用して、画像内のエンティティをマイニングします。 DETR は、画像内のエンティティを、「人」や「犬」などの標準 MS-COCO で定義されたエンティティにマッピングできます。 ChiQA で各画像のエンティティをマイニングし、最も頻度の高いエンティティの分布を次の図に表示します。 ChiQA で確認できる内容は次のとおりです。には 30 個のエンティティが少なくとも 1000 回出現しており、ChiQA が非常に均等に分散され、ほとんどのフィールドをカバーする画像データであることがわかります。最も頻繁に出現するエンティティは「人物」、「携帯電話」、「車」などです。これは質問の配布と似ています。 4) 推論スキル データをより適切に分析するために、必要な ChiQA データも分析します。推論スキルが分析されました。推論を必要とする 5 つのスキルの分析に焦点を当てます:

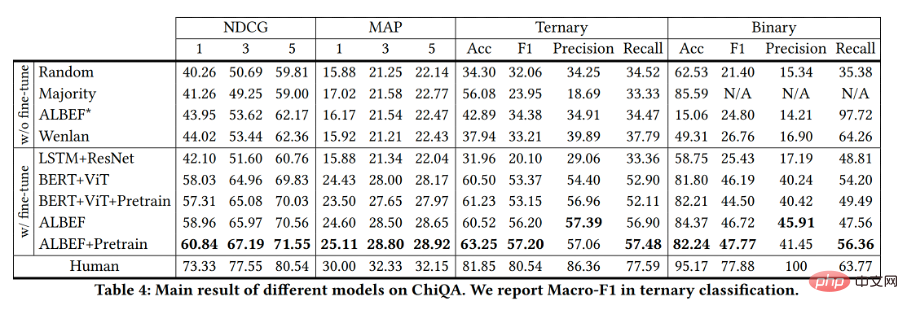

実験的評価指標 NDCG@N: 正規化された割引累積ゲイン ChiQA データセットで一般的に使用される複数のモデルを実験しました。前の画像とテキストのマッチング作業に従って、最初に画像とテキストをそれぞれエンコーダーでエンコードし、次にそれらの表現のクロスモーダル融合を実行し、最後に予測レイヤーを使用してマッチング スコアを取得します。以下にリストされているモデルで、♣ を追加することはモデルが事前トレーニングされていることを意味し、◆ を追加することは事前トレーニングされていないことを意味します。 #結果の表示は次のとおりです: 上記モデル テストセットの指標を図に示します。以前の最先端のクロスモーダル手法を直接適用すると、パフォーマンスが低く、メトリクスはランダム スコアリング モデルよりわずかに優れているだけであることがわかります。これは、ChiQA データが難しく、ALBEF* や Wenlan などの大規模な弱教師対比学習のみを使用するモデルでは、視覚的な質問応答に必要な詳細な情報を区別できない可能性があることを意味します。さらに、これらのモデルのパフォーマンスが低いことは、ChiQA データセットが以前の弱教師画像テキスト マッチング データとは異なることを示しています。これは、弱教師画像テキスト マッチングは相関に焦点を当てているのに対し、ChiQA データは画像の応答性も必要とするためです。 最後に、ChiQA で微調整されたモデルは、ベースラインを大きく上回る進歩を遂げましたが、人間のパフォーマンスにはまだ程遠いため、モデルは ChiQA データセットに対してまだ多くのことを行う必要があります。 。 改善の余地。 インターネットの発展に伴い、ユーザーの質問と回答に対する要求が高まっており、システムはより直観的で便利な回答を提供する必要があります。 。特に近年はマルチメディアコンテンツがますます豊富になり、写真や動画をベースにしたQ&Aコンテンツが多く公開されるようになりました。 QQ Browser Lab Lizhiチームは、今年4月に業界に先駆けて画像質疑応答プロジェクトを立ち上げ、例えばユーザーがキウイフルーツとキウイフルーツの違いを検索すると、その結果が直感的に前面に表示されるユーザーの様子を写真で表現します。以下の図に示すように: 現在、写真によって直接満たされるこの種の問題は、オンライン化されてから良い結果をもたらしています。ユーザーの行動(CTR、単語交換率など)が従来の結果と比較して大幅に改善されていることが観察されており、写真などをベースにした現在の「新しいQ&A」は、より良いサービスを提供できるプロダクトビジネスであることがわかります。ユーザーのニーズに応えます。 著者チームの紹介 QQ ブラウザ検索テクノロジー センター チームは、テンセント PCG 情報プラットフォームとサービス ラインの検索テクノロジーの研究開発を担当するチームであり、テンセントのコンテンツ エコロジーに基づいて、ユーザー調査を通じて製品の革新を推進し、ユーザーにグラフィックを提供します、情報、小説、長尺・短尺の動画、サービスなど多面的な情報ニーズに応えます。アルゴリズムに関しては、自然言語処理、深層学習、マルチモーダルの理解と生成、知識の計算と応用、その他のテクノロジーに基づいて、コンテンツの理解、相関付けと並べ替え、マルチモーダル検索、インテリジェントな質問と回答、マルチモーダルな検索を構築します。言語翻訳、検索推奨およびその他の技術的方向性、業界の高度なテクノロジーを探索および適用して、より良いユーザー検索エクスペリエンスを作成する;エンジニアリングの観点から、検索テクノロジーの中期工業化システムを構築し、高性能、高可用性を磨き上げる, Tencent に PCG を提供する低コストの数百億レベルの検索システムは、さまざまなコンテンツ ビジネスの検索シナリオ向けの基本的な検索エンジン サービスを提供し、現在 QQ Browser、Tencent Video、Tencent News、Tencent などの複数の PCG 製品ラインをサポートしています魏志。

画像収集と注釈のプロセスとエクスペリエンス

アクティブ ラーニング データのアノテーション

結果をより公平にする

テストセットのアノテーション

グルーディングに加えて、ChiQA データの 80% 以上では、画像内のテキストとコントラストの関係を深く理解する必要があることがわかります。 。これは、以前のほとんどの VQA データとは大きく異なります。次に、ロジックや比較を必要とする問題がかなり多く、ChiQA のデータが非常に難しいことがわかります。 ChiQA での推論スキルの分析は、このデータをより深く理解し、その後のモデル設計にアプリオリなガイダンスを提供できると信じています。

グルーディングに加えて、ChiQA データの 80% 以上では、画像内のテキストとコントラストの関係を深く理解する必要があることがわかります。 。これは、以前のほとんどの VQA データとは大きく異なります。次に、ロジックや比較を必要とする問題がかなり多く、ChiQA のデータが非常に難しいことがわかります。 ChiQA での推論スキルの分析は、このデータをより深く理解し、その後のモデル設計にアプリオリなガイダンスを提供できると信じています。 ChiQA データセットには、0、1、2 の 3 つのレベルの注釈スコアがあるため、実験ではモデルのランキングをテストします。の指標と通常の分類指標。 3 つのカテゴリに分類されます:

ベースライン モデル

以上がChiQA - 200,000 件の実際のユーザーの質問に基づいた画像の質問と回答のデータセットの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。