自動運転のためのマルチセンサーフュージョンを簡単に分析した記事

インテリジェント コネクテッド カーは自動運転とどのような関係があるのでしょうか?

自動運転の核心はクルマにあり、インテリジェントネットワーク接続システムとは何でしょうか?インテリジェント ネットワーク接続のキャリアは自動車でもありますが、中心となるのは接続する必要があるネットワークです。 1つは車内のセンサーや知能制御システムで構成されるネットワーク、もう1つはすべてのクルマが接続・共有するネットワークです。ネットワーク接続とは、自動車を大規模なネットワークに接続して、位置、ルート、速度などの重要な情報を交換することです。インテリジェントネットワークシステムの開発目標は、車載センサーや制御システムの設計最適化により車の安全性と快適性を向上させ、車をより人間らしくすることであり、最終的な目標はもちろん無人運転の実現である。

自動運転車の 3 つのコア補助システム: 環境認識システム、意思決定および計画システム、制御および実行システム。これらは、インテリジェント ネットワーク化車両が実現する 3 つの主要テクノロジーでもあります。それ自体で解決しなければならない質問です。

インテリジェントネットワーク接続システムにおいて、環境認識システムはどのような役割を果たしますか?

環境認識テクノロジーとは何ですか?主に何が含まれますか?

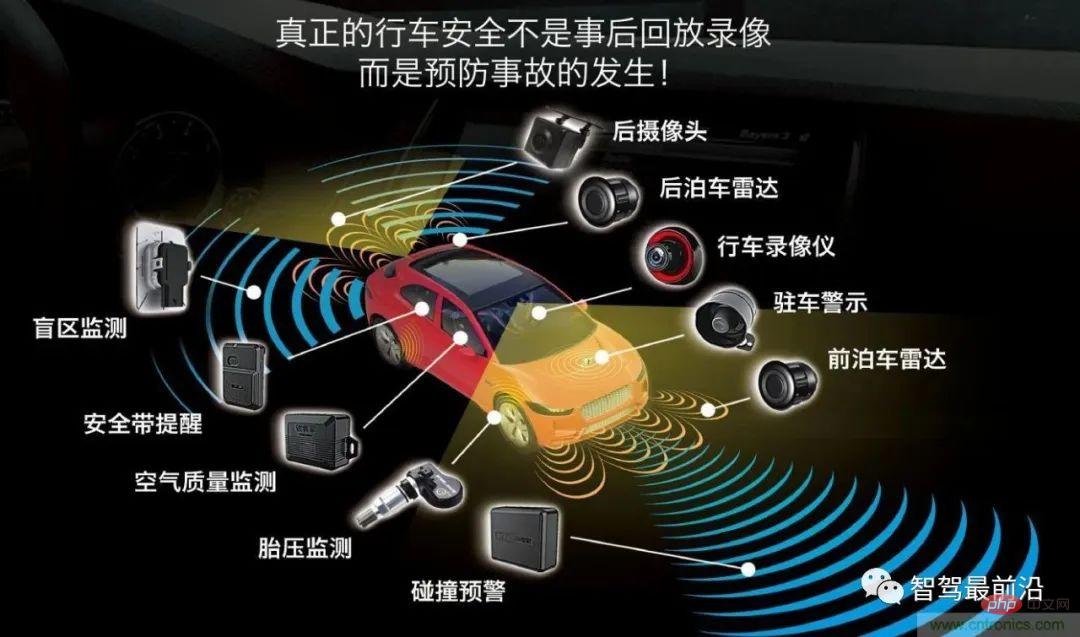

環境認識には、主にセンサー、認識、位置決めという 3 つの側面が含まれます。センサーには、カメラ、ミリ波レーダー、ライダー、超音波が含まれ、データの収集、色の識別、距離の測定を行うために、さまざまなセンサーが車両に設置されています。

# スマートカーがセンサーによって取得したデータを使用してインテリジェントな運転を実現したい場合、センサーによって取得したデータを処理する必要があります。 (知覚)アルゴリズムと計算されたデータ結果は、車両、道路、人などに関する情報の交換を実現するために生成され、車両が安全な運転か危険な運転かを自動的に分析し、車両が状況に応じてインテリジェントな運転を実現できます。人々の願いを実現し、最終的には人々に代わって意思決定や自動運転の目標を決定します。

次に、ここで重要な技術的問題が発生します。異なるセンサーは異なる役割を果たします。複数のセンサーによってスキャンされたデータはどのようにして完全な物体の画像データを形成するのでしょうか?

マルチセンサーフュージョン技術

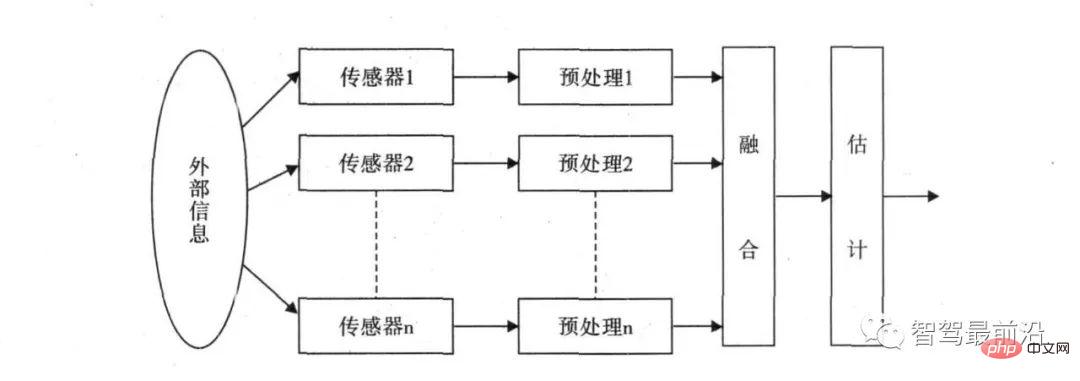

カメラの主な機能は物体の色を識別することですが、ミリ波レーダーは雨天の影響を受けるカメラの欠点を補うことができ、歩行者や通行止めなどの比較的遠方の障害物を識別できますが、障害物の具体的な形状を識別することはできません。ミリ波レーダーでは障害物を認識できないことをライダーが補うことができる 特殊な形状のデメリット; 超音波レーダーは主に車体上の近距離の障害物を認識し、駐車の際に主に使用されます。さまざまなセンサーから収集された外部データを融合してコントローラーが決定を下すための基礎を提供するには、マルチセンサー融合アルゴリズムを処理してパノラマ認識を形成する必要があります。

マルチセンサー フュージョン (フュージョン アルゴリズム処理) とは何ですか?また、主なフュージョン アルゴリズムは何ですか?

マルチセンサーフュージョンの基本原理は、人間の脳による総合的な情報処理のプロセスと同様であり、さまざまなセンサーを使用して、複数のレベルでの情報の組み合わせを補完し、最適化します。複数の空間でデータを収集し、最終的に 2 つの観測値を生成し、環境の一貫した解釈を行います。この過程では、複数のソースデータを最大限に活用して合理的に管理・利用する必要があり、情報融合の最終目標は、観測データによって得られた分離された観測情報をもとに、情報を多段階・多面的に組み合わせることにより、より有用な情報を導き出すことである。各センサー。これは、複数のセンサーの協調動作を活用するだけでなく、他の情報源からのデータを包括的に処理して、センサーシステム全体のインテリジェンスを向上させます。

マルチセンサーデータフュージョンの概念は軍事分野で最初に使用されましたが、近年では自動運転の開発に伴い、さまざまなレーダーが使用されています。車両をターゲットにするために使用されています。さまざまなセンサーにはデータの精度の問題があるため、最終的に融合されたデータをどのように決定するのでしょうか?たとえば、ライダーが前方車までの距離が 5m であると報告した場合、ミリ波レーダーは前方車までの車間距離が 5.5m であると報告し、カメラは前方車までの車間距離が 4m であると判断します。 、中央処理装置はどのように最終判断を下すべきでしょうか?この問題を解決するには、一連のマルチデータ融合アルゴリズムが必要です。

マルチセンサー フュージョンの一般的に使用される方法は、ランダムと人工知能の 2 つのカテゴリに分類されます。 AI カテゴリには主にファジー論理推論と人工ニューラル ネットワーク手法が含まれ、確率的手法には主にベイジアン フィルタリング、カルマン フィルタリングおよびその他のアルゴリズムが含まれます。現在、自動車のフュージョンセンシングは主にランダムフュージョンアルゴリズムを使用しています。

自動駕駛汽車融合感知演算法主要採用卡爾曼濾波演算法,利用線性系統狀態方程,透過系統輸入輸出觀測數據,對系統狀態進行最佳估計的演算法,它是目前解決絕大部分問題都是最優、效率最高的方法。

多重感測器需要進行融合演算法處理,企業對應就會需要融合感知類別的演算法工程師去解決多感測器融合的問題,融合感知類別的絕大多數的崗位要求都是需要能夠掌握多種感測器的工作原理及訊號的資料特徵,能夠掌握融合演算法進行軟體開發以及感測器標定演算法能力以及點雲資料處理、深度學習偵測演算法等等。

環境感知的的第三部分內容-定位(slam)

#Slam叫做同步定位和製圖,是假設場景是靜態情況下透過攝影機的運動來獲取影像序列並得到場景3-D結構的設計,這是電腦視覺的重要任務,攝影機所獲得的資料經過演算法處理也就是視覺slam。

環境感知定位法除了視覺slam,還有雷射雷達slam、GPS/IMU和高精地圖。這些感測器所獲得的數據都是需要經過演算法的處理才能形成數據結果為自動駕駛決策提供位置資訊依據。所以想要從事環境感知方向的工作,不僅可以選擇融合感知演算法崗位,還可以選擇slam方向。

以上が自動運転のためのマルチセンサーフュージョンを簡単に分析した記事の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7470

7470

15

15

1377

1377

52

52

77

77

11

11

19

19

29

29

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力