OpenAIが提案する新しいムーアの法則をどう理解するか?中国の隠れたコンピューティングパワー巨人が言いたいことがある

この記事はAI New Media Qubit(公開アカウントID:QbitAI)の許可を得て転載していますので、転載については出典元にご連絡ください。

ChatGPT は世界中で人気があり、それに関連するあらゆるものが最前線にあります。

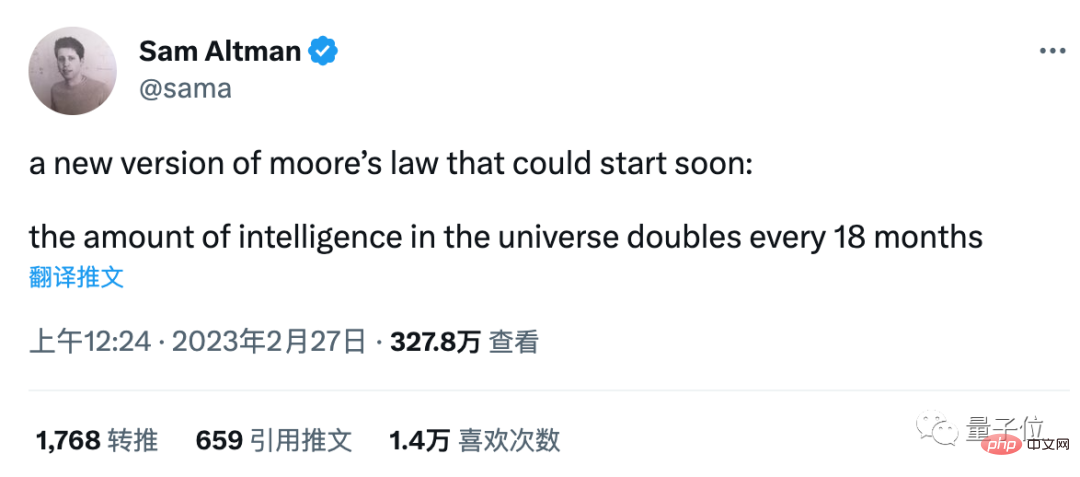

OpenAI CEO サム アルトマンの一見何気ない言葉が白熱した議論の焦点となっています:

ムーアの法則の新バージョンが間もなく登場します、中国の宇宙インテリジェンスは 18 年ごとに 2 倍になります月。

ニューラル ネットワークのパラメータを参照しているのではないかと推測する人もいますが、過去数年のデータとは一致しません。

人間やAIを含む知的エージェント全体の能力として理解している人もいますが、この指標をどう測るかが問題となっています。

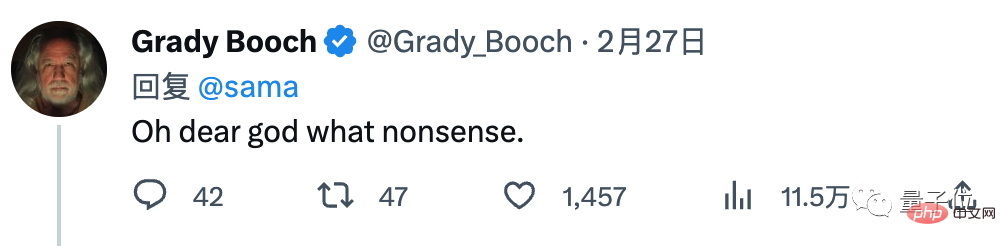

この判決に同意しない学者やネットユーザーも多く、IBMの科学者グレイディ・ブーチ氏は「これはナンセンスだ」と発言し、ホットコメントのトップとなった。

これらの議論に対して、アルトマンは「まだです」とだけ答えた。

#しかし、何はともあれ、AI の急速な発展の背後には、コンピューティング能力が明確で測定可能な指標であり、不可欠な条件です。

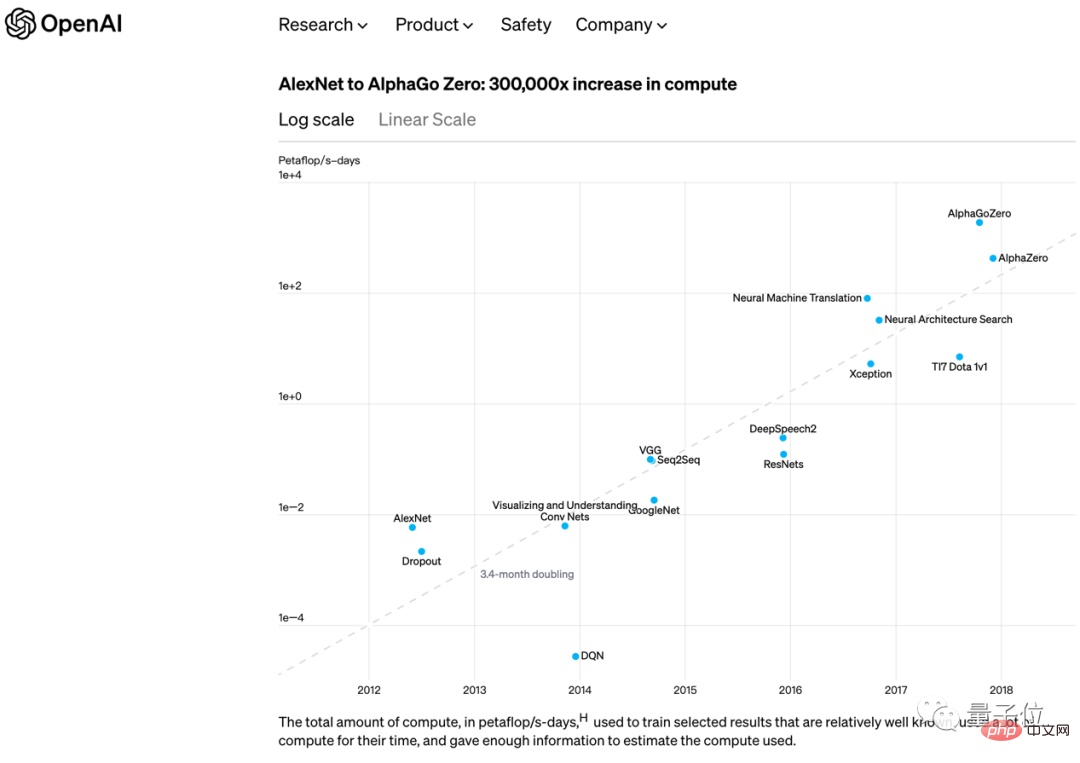

2018 年初頭に、OpenAI はムーアの法則に似た別の見解も発表しました。

2012 年の AlexNet から 2017 年末の AlphaGo Zero まで、最大の AI モデルをトレーニングするために必要なコンピューティング能力は、3.4 か月ごとに 2 倍になります。

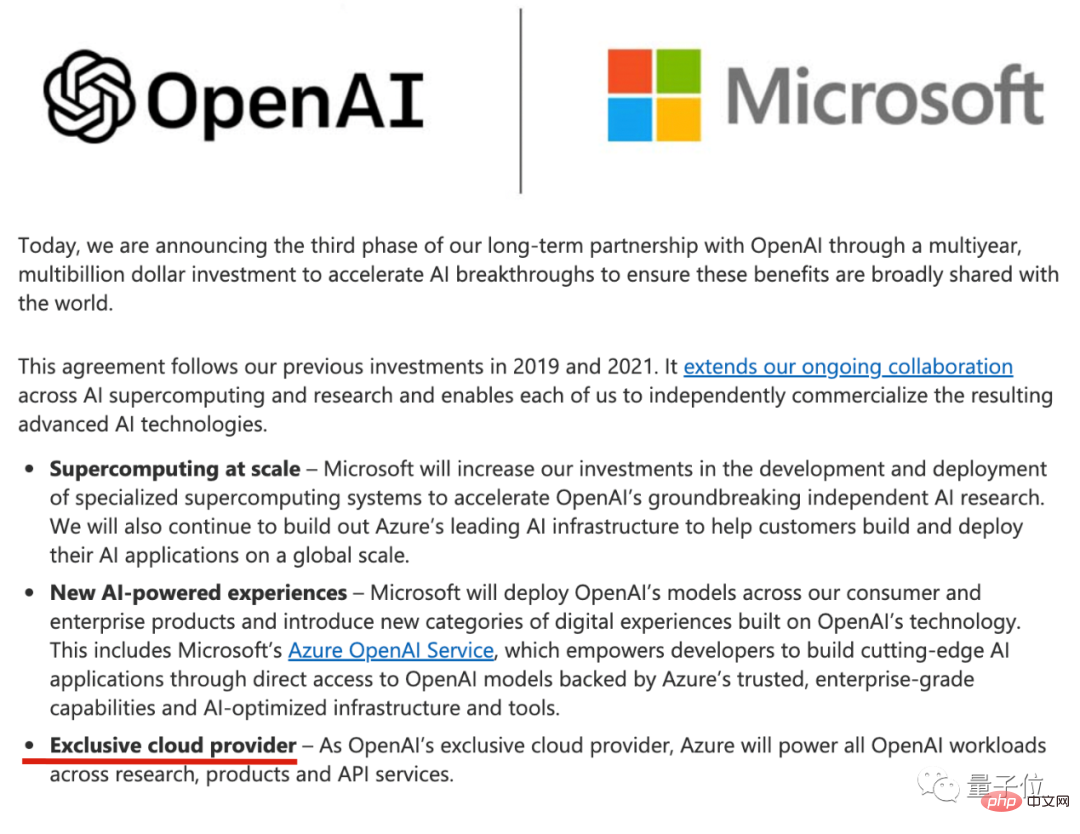

2 か月に短縮されました。 ####。 ChatGPT 時代では、考慮する必要があるのは AI トレーニングのコンピューティング能力だけではありません。世界中の月間アクティブ ユーザー数が 1 億人で、Microsoft Bing 検索やその他の製品にアクセスできるため、AI 推論のコンピューティング能力も重要です。サポート。 ChatGPT のコンピューティング能力を最も直接的に提供するプロバイダーは Microsoft Azure クラウドです。Microsoft Azure クラウドは、2019 年に OpenAI に初めて 10 億米ドルを投資して以来、OpenAI の独占的なクラウド プロバイダーです。

最新の100億米ドルの追加投資が行われた際、両当事者は声明の中でこの点を改めて強調した。

独占供給とは、Azure クラウドが提供するツール チェーンを使用して、OpenAI の開発インフラストラクチャがすべて Azure クラウド上に構築されていることを意味します。

これに対応して、Google AI は独自の Google Cloud によってサポートされており、クラウド コンピューティング業界のナンバーワンである Amazon も、オープンソースの大規模モデル Bloom の展開に協力するよう HuggingFace に緊急にアプローチしました。

……

クラウドコンピューティングは計算能力の源ではなく、ChatGPTが普及したのと同じように、計算能力の供給側でも優れたパフォーマンスを発揮する企業が数多く現れました。

すぐに思い浮かぶ選手もいるかもしれませんが、他の業界であまりにも有名すぎて意外な選手もいます。

その中には中国の選手もいます。

新しいムーアの法則はコンピューティング能力から切り離すことはできません

画像認識および推奨アルゴリズムに代表される AI アプリケーションの最後の波がデジタル経済の発展を促進するために実装されたとき、コンピューティング能力は専門用語から転じて経済用語となり、産業界や学術界で繰り返し強調されてきました。

この生成 AI の波が世界的な熱狂に火をつけたとき、コンピューティング パワーは再び一般の人々の仕事や生活に関連するものにアップグレードされ、一般の人々に認識されました。

ChatGPT の料金はいくらですか?

半導体業界の情報組織であるセミアナリシスは、次のように推定しました: GPU で測定すると、約 3,617 台の Nvidia HGX A100 サーバーが必要で、これは 28,936 台の A100 になります; 資金で測定すると、ユーザーの質問ごとにかかるコストは 0.36 セントです.

1 日の費用は 690,000 ドル

です。 導き出された結論は次のとおりです。ChatGPT が Google 検索のすべてのトラフィックを負担すると、合計 410 万の NVIDIA A100 GPU

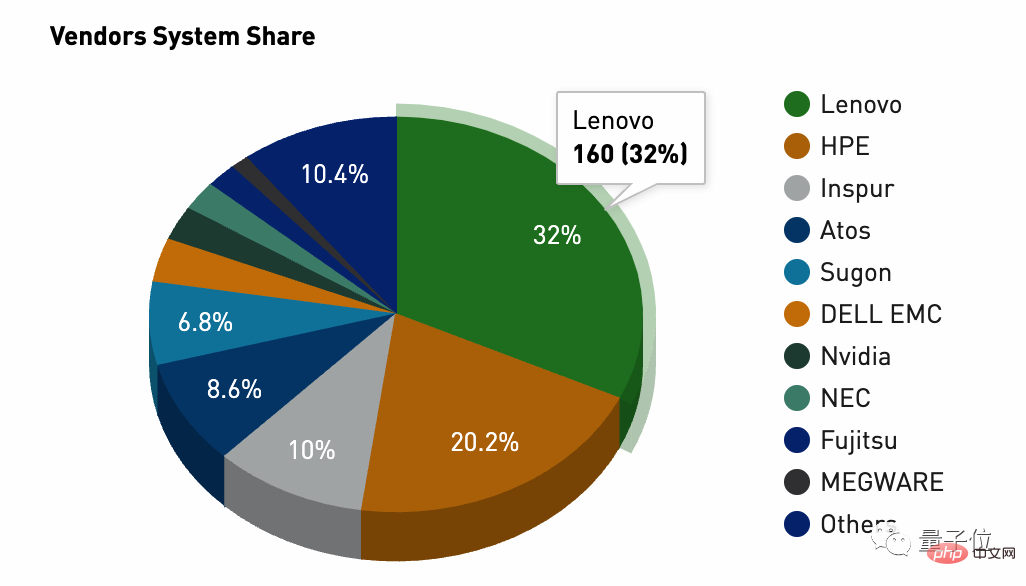

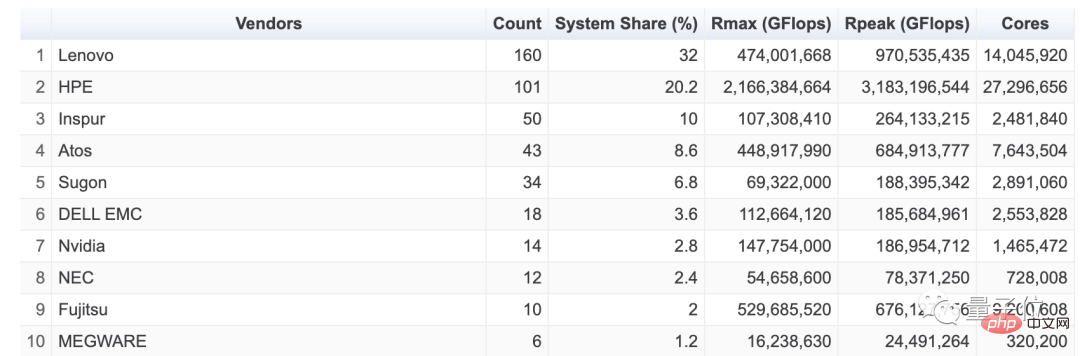

が必要になります。 したがって、当然のことながら、NVIDIA は ChatGPT の人気において最も有名な利益を得ている企業です。 NVIDIA は現在、AI チップ市場の約 75% ~ 80% を占めています。ChatGPT でのあらゆる熱い検索は、Lao Huang のアカウントに金貨が届く音です。この熱意の波に支えられて、リリース時点では、最新の財務報告書によると、NVIDIA の株価は 2023 年に 45% 上昇します。 CEO Huang Renxun も電話会議で最新の声明を発表しました: 「ジェネレーティブ AI は、グローバル企業に人工知能の開発と導入における戦略的緊急性の感覚を与えました。」 そしてこれはほんの始まりにすぎませんシティバンクによると、Nvidia の GPU の売上高は今後 12 か月で 30 億米ドルから 110 億米ドルに達するとのことです。 Nvidia に加えて、GPU アップストリームからの ChatGPT ボーナスの勝者は、チップ製造レベルにある TSMC です。 最近、NVIDIA、AMD、Apple が将来の生産能力を確保することを狙って、TSMC に緊急発注を行ったとの報道がありました。 これまでTSMCの収益の柱は長年にわたりスマートフォン事業であったが、2022年にはスマートフォン販売の低迷と人工知能の台頭という二重の影響を受け、ハイパフォーマンスコンピューティング事業がそれを追い越した。 3四半期連続の業績は、時代の転換点の前触れでもあるのかもしれない。 さらに重要なのは、TSMC がこの変更を実際に明らかにしたことです。最近の公式声明で、TSMCは来年に楽観的な期待を示しており、その表現も非常に興味深いものである。世界の半導体産業は不況に直面しているが、通年の業績は依然としてわずかに増加すると予想されている。 もちろん、もっと単純に大雑把に推論すれば、実際にNVIDIAが台頭したときにTSMCの業績は悪くないのですが、結局は産業チェーンの役割と需要と供給の関係がそこにあるのです。 。 では、この需要と供給に基づいて、ChatGPT によってもたらされるコンピューティング能力の配当は、クラウド コンピューティングやクラウド サービス メーカーにもたらされるのでしょうか? はい、完全にそうではありません。 ChatGPT の人気が高まる中、多くの分析がクラウド コンピューティングを指摘していましたが、一部のアナリストはすぐに中間リンク (GPU からクラウド コンピューティング サービスへの中間リンク) であるサーバーに注目しました。 チップがその役割を真に果たそうとする場合、サーバーをバイパスすることはできません。チップがどのように高速で相互接続されるか、キャビネット全体がエネルギー消費と熱放散をどのように制御するか、システム設計がさまざまな環境にどのように適応するかなどです。ワークロード、すべてが最終的なパフォーマンスと効率に影響します。 Gartner は、2025 年までに世界のサーバー市場は 1,350 億米ドルに達し、その中で AI サーバーと AI クラウド サービスが爆発的に増加すると予測しています。 記事の冒頭で述べた中国からのコンピューティングパワー参加者が隠れているのは、AI サーバーの方向にあるこのリンクです。 レノボ グループ、レノボ。 もしかしたら、以前は PC から Lenovo Group についてよく知っていたかもしれませんが、PC の本質は個人のコンピューティング能力でもあります。 Lenovo は、PC からハイパフォーマンス コンピューティング、そしてより広範なコンピューティング インフラストラクチャに至るまで、このような道を歩んできました。 これは、最も直感的な財務報告データによって証明されています。レノボ・グループが発表した第3四半期財務報告書(2022年10~12月)によると、ISG(インフラストラクチャー・ソリューション・グループ)インフラストラクチャー・ソリューション事業は売上高が48%増加し、営業利益が156%急増した。 これは、世界のサーバー出荷台数が前年比 7.1%、前月比 4.3% 減少した DigiTimes の統計とは対照的です。 Lenovo Group ISG は、コンピューティングパワーを核としたインフラストラクチャの成果とソリューションを提供しており、サーバーは最も重要なビジネスの 1 つです。 そして、それはより直接的にサーバー ビジネスに分類されます。この四半期の収益は前年比 35% 増加し、世界で 3 番目に大きなサーバー プロバイダーになりました。 GhatGPTは必須です。 しかし、ChatGPT の突然の人気は、実際には、コンピューティングパワーの勝者としての Lenovo Group の隠れた役割を前面に押し出しただけでした。 Lenovo Group の会長兼 CEO である Yang Yuanqing 氏は、ChatGPT の背後に必要なユニバーサル コンピューティング パワー インフラストラクチャが、長年にわたって導入されてきた Lenovo の強みであると述べました。 レノボはすでにコンピューティング機器の需要を予測し、「エンド-エッジ-クラウド-ネットワーク-インテリジェンス」という新しいITアーキテクチャを提案しています。 昨年、Lenovo はユニバーサル コンピューティング パワーをさらに提案しました。つまり、データの爆発的な増加に伴い、私たちはデジタル化とインテリジェンスの新時代に突入しました。コンピューティングの需要は急増しています。「個別戦闘用」の機器や地域に集中したデータセンターでは、コンピューティングのニーズを満たすには程遠いのです。需要に応じて、ユーザーにユビキタスなユニバーサル コンピューティング パワーを提供するには、「エンド-エッジ-クラウド-ネットワーク-インテリジェンス」という 新しい IT アーキテクチャが必要です。 1 つ目はサーバー製品のパフォーマンス、2 つ目は量のスケールです。 この分野では、世界のハイパフォーマンス コンピューティング リスト TOP500 がサーバーのコンピューティング能力を観察するための最良の参考資料です。世界のハイ パフォーマンス コンピューティング リスト TOP500 の最新号 (2022 年 11 月) を開くと、上記のことがわかります. レノボグループの強さを語る。 市場シェアは 32% を占め、160 ユニットの供給で世界第 1 位にランクされ、第 2 位のヒューレット・パッカード グループを 12 ポイント近くリードしています。 Lenovo はどのようにしてコンピューティング パワーの「見えない」チャンピオンになれるのでしょうか?

世界のトップ10のパブリック・クラウド・プロバイダーのうち8社がレノボですグループのお客様。

つまり、Lenovo サーバーは世界中の顧客に認められていますが、これは国内のサーバー メーカーにとっては容易ではありません。 これらの顧客の中には、クラウド分野で第 2 位の Microsoft Azure クラウド (ChatGPT の背後にある高速化エンジン) や「金融家の父」などの外部の憶測が含まれています。 Microsoft が OpenAI をサポートするために多額の投資を行ったとき、聡明な Microsoft CEO の Nadella 氏は、サポートにリアルマネーを投資するつもりはないとのコメントがありました。中核となるのは同等のクラウド サービスであり、彼は OpenAI の株式を取得していました。一流の AI 研究機関の戦略的レイアウトを採用し、自社の Azure クラウドに顧客と成長をもたらしたことはまさに一石二鳥であり、このビジネスを失うことはできません。 クレイジーな OpenAI が大型モデルで本当に有名になるとは予想していませんでした。ChatGPT の偶然の革新によって世界的なテクノロジー インターネットに本格的に火をつけ、すべてのプレイヤーを大型モデルの興奮に引き込みましたそして生成AI。 Microsoft は、この恩恵を率先して享受しただけでなく、古くからのライバルである Google を追い詰め、Google の検索のドル箱を揺るがしました。 Microsoft と緊密なパートナーシップを結び、2022 年に Microsoft Device Partner Award を受賞した Lenovo Group のメリットは、財務実績に直接反映されています。 さらに、マイクロソフト CEO のナデラ氏が 2021 年の Lenovo Group Innovation and Technology Conference に出席した理由もこの関係性から理解できますが、その年の発表はあまりにも「業界用語」であり、ニーズがあったと言えます。 ChatGPT ボーナスは今日になって初めて真に理解できるものであり、当時の発表では次のように書かれていました:将来的には、両社は PC、クラウド コンピューティング、エッジ コンピューティングの 3 つの分野でより緊密な協力を実行し、そしてサービス。 しかし、たとえ Lenovo Group が ChatGPT ブームのコンピューティングパワープロバイダーになったとしても、この見通しは持続可能であることを意味するのでしょうか?結局のところ、Microsoft と ChatGPT のケースには独自の特殊性があり、舞台裏で Lenovo グループがその甘さを味わうことができたのは幸運でした。 しかし、ChatGPTが確立した大型モデルの開発方向から判断すると、この傾向は今後も継続し、コンピューティング電源側も方向転換をしていくだろう。 多くのインフラストラクチャ専門家の意見に基づいて「ファイナンシャル イレブン」が出した最近の結論によると、AI のコンピューティング能力はクラウド コンピューティングの財務モデルに大きな影響を及ぼし、その背後にはムーアの法則のスタイルがあるとのことです。成長ロジック: まず、AI コンピューティングの消費電力と成長率は、一般的なコンピューティングの消費電力よりもはるかに大きくなります。情報通信技術アカデミーの 2022 年のデータによると、中国の一般的なコンピューティング能力は 2021 年に 95 EFlops に達し、成長率は 24%、シェアは 47% に達すると予想されています。インテリジェントなコンピューティング能力の規模は 104EFlops で、成長率は 85%、シェアは 50% 以上です。これは、インテリジェントなコンピューティング能力がクラウド コンピューティングの新たな成長ポイントになることを意味します。 第二に、インテリジェントなコンピューティング能力の価格は、一般的なコンピューティング能力の価格よりも高くなります。一般的なコンピューティング能力の価格は継続的に低下しており、AI コンピューティング能力は相対的に不足しているため、現在価格が上昇しています。理論上、大規模な演算を実現するAIの計算能力の粗利益率は、一般的な計算能力に比べて10%以上高い。 第三に、垂直産業における AI コンピューティング能力の大規模モデルの使用により、新しいアプリケーション モデルの出現が可能になります。たとえば、金融、自動運転、医療研究開発、スマート製造のシナリオでは、企業は通常、同社の AI 大型モデル オープンソース プラットフォームを購入し、自社のビジネスに適した小型モデルを調整する必要があります。この種の PaaS ベースの AI サービスは、粗利益の 60% 以上をもたらす可能性があります。これは現時点で、AI コンピューティング能力/AI モデルの利用をさらに進めるための最善の道です。 AI コンピューティング能力の方向性におけるこの種の変化は、中国市場により具体的な影響を与える可能性もあります: 中国のクラウド ベンダーの AI コンピューティング能力が大規模であることは否定できません。このモデルと Microsoft の間には大きな隔たりがあります。その理由は、計算能力の規模、データの規模、モデルの精度にギャップがあるためです。コンピューティング能力の規模を例に挙げると、ChatGPT をサポートするインテリジェント コンピューティング クラスターには、少なくとも数万枚の NVIDIA GPU A100 グラフィックス カードが必要です。完全なモデルのトレーニングには 1,200 万ドル以上の費用がかかります。ChatGPT の背後にあるインテリジェント コンピューティング クラスターには、GPU グラフィックス カードの購入だけで 10 億元以上の費用がかかります。現在、同様のインフラをサポートできる国内企業は 3 社しかありません。中国のクラウド ベンダーのデータ センターには、通常、数千枚の GPU グラフィックス カードしか搭載されていません。その理由は、Nvidiaの最上位GPUの購入コストが8万元もするためだ。通常、サーバーには 4 ~ 8 個の GPU が必要で、GPU サーバーのコストは通常 40 万元を超えます。国内サーバーの平均価格は4万~5万元。これは、GPU サーバーのコストが通常のサーバーの 10 倍以上であることを意味します。

したがって、この大規模なモデル主導の技術変化の波は、基本的に中国のコンピューティング電源供給企業にとっての課題と機会を推測することができます。

まず第一に、完全で成熟した安定したインテリジェント コンピューティング クラスター インフラストラクチャが必要です。

第二に、関連製品には総合的な性能に加えて、環境保護とコスト削減といったエネルギー効率の利点も必要です。

これら 2 つの結論を明確にすると、ChatGPT ボーナスの隠れた勝者として Lenovo Group が持続可能なコンピューティング能力の見通しを持ち続ける理由がおそらく理解できるでしょう。

コンピューティング能力が新たなムーアの法則をもたらしたとすれば、エネルギー消費の問題は無視できない、国家発展改革委員会のハイテク部門の主任担当者は2021年に、年間電力消費量は私の国のデータセンターは社会の電力消費量の約 2% を占めています。

もっと直感的に言えば、「年間電力消費量が三峡ダムの発電量を超える」ということですが、ムーアの法則は指数関数的増加であり、三峡ダムの発電量は指数関数的に増加することはありません。

Lenovo グループは、最先端の 「ポセイドン」温水冷却テクノロジー # を開発しました。これは、50°C の温水を使用して流れの循環によって熱を奪い、チラーと熱交換器が必要、 廃熱を建物の暖房に利用することもできる、 年間電気代が節約され、排出量が 42% 以上削減される

最新のグローバル HPC Green500 リストに掲載、Lenovo Group が提供する Henri システム 消費電力 1 ワットあたり 65 億 910 万回の浮動小数点演算の性能が認定されており、国内外の要件を満たしているだけでなく、世界で最もエネルギー効率の高い高性能コンピューティング システムとなっています。

実際、Lenovo は、もはやあなたの固定観念にあるコンピューターだけの会社ではありません。。全体として、コンピューティング インフラストラクチャ ビジネスが爆発的に成長している一方で、レノボ グループ全体としては徐々に変革が完了しており、総収益に占めるパーソナル コンピューター以外のビジネスの割合は 40% を超えています。

ChatGPT、大型モデル、さらには AI など、技術革新サイクルで最初に急増するコンピューティング能力の配当は、Lenovo グループをリフレッシュし、より正確にはコンピューティング能力の供給側を変えています。シーンが前面に出てきます。

以上がOpenAIが提案する新しいムーアの法則をどう理解するか?中国の隠れたコンピューティングパワー巨人が言いたいことがあるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1672

1672

14

14

1428

1428

52

52

1332

1332

25

25

1276

1276

29

29

1256

1256

24

24

トップ10のデジタル通貨取引プラットフォーム:トップ10の安全で信頼できるデジタル通貨交換

Apr 30, 2025 pm 04:30 PM

トップ10のデジタル通貨取引プラットフォーム:トップ10の安全で信頼できるデジタル通貨交換

Apr 30, 2025 pm 04:30 PM

上位10のデジタル仮想通貨取引プラットフォームは次のとおりです。1。Binance、2。Okx、3。Coinbase、4。Kraken、5。HuobiGlobal、6。Bitfinex、7。Kucoin、8。Gemini、9。Bitstamp、10。Bittrex。これらのプラットフォームはすべて、さまざまなユーザーニーズに適した高度なセキュリティとさまざまな取引オプションを提供します。

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

交換に組み込まれた量子化ツールには、1。Binance:Binance先物の定量的モジュール、低い取り扱い手数料を提供し、AIアシストトランザクションをサポートします。 2。OKX(OUYI):マルチアカウント管理とインテリジェントな注文ルーティングをサポートし、制度レベルのリスク制御を提供します。独立した定量的戦略プラットフォームには、3。3Commas:ドラッグアンドドロップ戦略ジェネレーター、マルチプラットフォームヘッジアービトラージに適しています。 4。Quadency:カスタマイズされたリスクしきい値をサポートするプロフェッショナルレベルのアルゴリズム戦略ライブラリ。 5。Pionex:組み込み16のプリセット戦略、低い取引手数料。垂直ドメインツールには、6。cryptohopper:クラウドベースの定量的プラットフォーム、150の技術指標をサポートします。 7。BITSGAP:

EaseProtocol.comは、ISO 20022メッセージ標準をブロックチェーンスマートコントラクトとして直接実装しています

Apr 30, 2025 pm 05:06 PM

EaseProtocol.comは、ISO 20022メッセージ標準をブロックチェーンスマートコントラクトとして直接実装しています

Apr 30, 2025 pm 05:06 PM

この画期的な開発により、金融機関は、グローバルに認識されているISO20022標準を活用して、さまざまなブロックチェーンエコシステム全体の銀行プロセスを自動化できます。簡単なプロトコルは、使いやすい方法を通じて広範な採用を促進するように設計されたエンタープライズレベルのブロックチェーンプラットフォームです。本日、ISO20022メッセージング標準を正常に統合し、ブロックチェーンスマートコントラクトに直接組み込んだことを発表しました。この開発により、金融機関は、Swiftメッセージングシステムを置き換えているグローバルに認識されているISO20022標準を使用して、さまざまなブロックチェーンエコシステムの銀行プロセスを簡単に自動化できます。これらの機能は、「easetestnet」でまもなく試されます。 easeprotocolarchitectdou

デジタル通貨アプリの将来はありますか? Apple Mobile Digital Currency Trading PlatformアプリダウンロードTop10

Apr 30, 2025 pm 07:00 PM

デジタル通貨アプリの将来はありますか? Apple Mobile Digital Currency Trading PlatformアプリダウンロードTop10

Apr 30, 2025 pm 07:00 PM

デジタル通貨アプリの見通しは幅広く、次のことに特に反映されています。1。テクノロジーイノベーション駆動型機能のアップグレード、DefiおよびNFTおよびAIおよびビッグデータアプリケーションの統合によるユーザーエクスペリエンスの改善。 2。AMLおよびKYCの規制コンプライアンスの傾向、グローバルフレームワークの改善、より厳しい要件。 3。機能の多様化とサービスの拡大、貸付、財務管理、その他のサービスの統合、ユーザーエクスペリエンスの最適化。 4。ユーザーベースとグローバル拡張、および2025年にはユーザースケールが10億を超えると予想されます。

通貨サークルの3人の巨人は何ですか?トップ10推奨される仮想通貨メイン交換アプリ

Apr 30, 2025 pm 06:27 PM

通貨サークルの3人の巨人は何ですか?トップ10推奨される仮想通貨メイン交換アプリ

Apr 30, 2025 pm 06:27 PM

通貨サークルでは、いわゆるビッグ3は通常、最も影響力があり広く使用されている3つの暗号通貨を指します。これらの暗号通貨は、市場で重要な役割を果たしており、取引量と時価総額の点でうまく機能しています。同時に、主流の仮想通貨交換アプリは、投資家やトレーダーが暗号通貨取引を実施するための重要なツールでもあります。この記事では、通貨サークルの3人の巨人と、推奨されるトップ10の主流の仮想通貨アプリを詳細に紹介します。

失敗した暗号交換FTXは、最新の試みで特定の発行者に対して法的措置を講じる

Apr 30, 2025 pm 05:24 PM

失敗した暗号交換FTXは、最新の試みで特定の発行者に対して法的措置を講じる

Apr 30, 2025 pm 05:24 PM

最新の試みで、解決されたCrypto Exchange FTXは、債務を回収し、顧客を返済するために法的措置を講じました。債務を回収し、クライアントを返済するための最新の取り組みで、解決された暗号交換FTXは、特定の発行者に対して法的措置を提起しました。 FTX取引およびFTX Recovery Trustは、合意されたコインを交換に送金するという合意を果たさなかった特定のトークン発行者に対して訴訟を起こしました。具体的には、リストラチームは月曜日にコンプライアンスの問題について、NFTStars LimitedとOrosemi Inc.を訴えました。 FTXは、期限切れのコインを回収するためにトークン発行者を訴えています。 FTXは、かつて米国で最も優れた暗号通貨取引プラットフォームの1つでした。銀行は2022年11月に、その創設者SAMが

信頼できる交換プラットフォームは何ですか?トップ10のデジタル通貨交換

Apr 30, 2025 pm 04:15 PM

信頼できる交換プラットフォームは何ですか?トップ10のデジタル通貨交換

Apr 30, 2025 pm 04:15 PM

上位10のデジタル通貨交換は次のとおりです。1。Binance、2。Okx、3。Coinbase、4。Kraken、5。HuobiGlobal、6。Bitfinex、7。Kucoin、8。Gemini、9。Bitstamp、10。Bittrex。これらのプラットフォームはすべて、さまざまなユーザーニーズに適した高度なセキュリティとさまざまな取引オプションを提供します。

AIおよび作曲家:コードの品質と開発の強化

May 09, 2025 am 12:20 AM

AIおよび作曲家:コードの品質と開発の強化

May 09, 2025 am 12:20 AM

作曲家では、AIは主に、依存関係の推奨、依存関係の競合解決、コードの品質改善を通じて、開発効率とコードの品質を改善します。 1。AIは、プロジェクトのニーズに応じて適切な依存関係パッケージを推奨できます。 2。AIは、依存関係の競合に対処するためのインテリジェントなソリューションを提供します。 3。AIはコードをレビューし、コードの品質を改善するための最適化の提案を提供します。これらの機能を通じて、開発者はビジネスロジックの実装にもっと集中できます。