ChatGPT は世界中で人気のあるトップモデルになる可能性があり、その背後にあるスーパーコンピューティングパワーが不可欠です。

データによると、ChatGPT の総計算電力消費量は約 3640PF 日です (つまり、1 秒あたり 1 京の計算が実行される場合、計算には 3640 日かかります)。

それでは、Microsoft が OpenAI 専用に構築したスーパーコンピューターはどのようにして誕生したのでしょうか?

月曜日、Microsoft は公式ブログに 2 つの記事を続けて投稿し、この超高価なスーパーコンピューターと Azure のメジャー アップグレードを個人的に解読し、数千の Nvidia の最新の強力な H100 グラフィックス カードとそれ以上の速度を実現しました。 InfiniBand ネットワーク相互接続テクノロジー。

#これに基づいて、Microsoft は最新の ND H100 v5 仮想マシンも正式に発表しました。具体的な仕様は次のとおりです。 NVIDIA H100 Tensor コア GPU は、次世代 NVSwitch および NVLink 4.0 を介して相互接続されています

当時、これが、AI が純粋言語を使用して人間が描写したあらゆる絵を作成できるようになり、人間がチャットボットを使用して詩、歌詞、書類、電子メール、メニュー...

このシステムを構築するには、OpenAI には、超大規模な計算を真にサポートできるような大量の計算能力が必要です。

しかし問題は、Microsoft にそれができるかということです。

結局のところ、当時は OpenAI のニーズを満たすことができるハードウェアはなく、Azure クラウド サービスにそのような巨大なスーパーコンピューターを構築することでシステムが直接クラッシュするかどうかは不明でした。 。

そこで、マイクロソフトは困難な調査を開始しました。

Microsoft の Azure ハイ パフォーマンス コンピューティングおよび人工知能のプロダクト リードであるニディ チャペル氏 (左) とシニア ディレクターのフィル ウェイマス氏Microsoft の戦略的パートナーシップ (右)

#OpenAI プロジェクトをサポートするスーパーコンピューターを構築するために、数億ドルを費やして数万個の Nvidia A100 チップを接続しましたAzure クラウド コンピューティング プラットフォーム上で統合し、サーバー ラックを改造しました。

さらに、このスーパーコンピューティング プラットフォームを OpenAI 用に調整するために、Microsoft は非常に熱心に OpenAI のニーズに細心の注意を払い、トレーニング時に最も重要なニーズを常に把握してきました。あい。

このような大規模なプロジェクトにはどれくらいの費用がかかりますか?マイクロソフトのクラウドコンピューティングおよび人工知能担当エグゼクティブバイスプレジデント、スコット・ガスリー氏は正確な金額は明らかにしなかったが、「おそらく」数億ドル以上だと述べた。

OpenAI の問題Microsoft の戦略的パートナーシップ担当幹部である Phil Waymouth 氏は、OpenAI トレーニング モデルに必要なクラウド コンピューティング インフラストラクチャの規模は業界で前例のないものであると指摘しました。の。

ネットワーク GPU クラスターのサイズは、業界の誰もがこれまでに構築しようとしたものを超えて急激に増加しています。

マイクロソフトが OpenAI との協力を決意した理由は、この前例のない規模のインフラストラクチャが歴史を変え、顧客に新しい AI と新しいプログラミング プラットフォームを生み出すと確信しているからです。実際に彼らの利益にかなうサービス。

今や、この数億ドルは明らかに無駄ではなかったようです。賭けは正しかったのです。

このスーパーコンピューター上で、OpenAI が学習できるモデルはますます強力になり、AI ツールの驚くべき機能が解放され、人類の第 4 次産業革命をほぼ開始した ChatGPT が誕生しました。

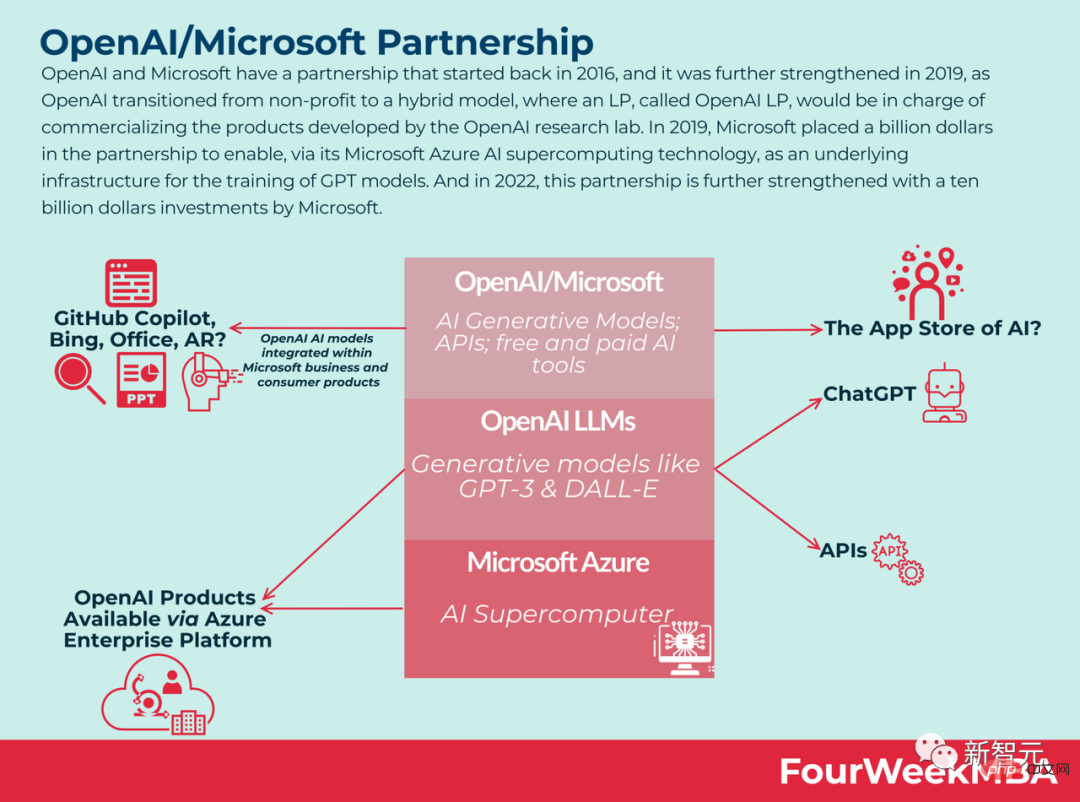

非常に満足し、Microsoft は 1 月初旬に OpenAI にさらに 100 億ドルを注ぎ込みました。

AI スーパーコンピューティングの限界を打ち破るという Microsoft の野心は功を奏したと言えるでしょう。この背景に反映されているのは、実験室研究からAI産業化への変化です。

現在、マイクロソフトのオフィス ソフトウェア帝国が形を作り始めています。

ChatGPT バージョンの Bing は休暇の手配を検索するのに役立ちます。Viva Sales のチャットボットはマーケティング担当者が電子メールを作成するのに役立ちます。GitHub Copilot は開発者がコードを書き続けるのに役立ちます。Azure OpenAI サービスを使用すると、次のことが可能になります。 OpenAI の大規模言語モデルにアクセスし、Azure のエンタープライズ レベルの機能にアクセスできるようになります。

実際、昨年 11 月、Microsoft は、Nvidia と提携して次のことを行うと正式に発表しました。 AI のトレーニングと拡張に必要な膨大なコンピューティング負荷を処理する、世界で最も強力な AI スーパーコンピューターの 1 つを構築します。

このスーパーコンピューターは、Microsoft の Azure クラウド インフラストラクチャに基づいており、数万個の Nvidia H100 および A100 Tensor コア GPU と、Quantum-2 InfiniBand ネットワーク プラットフォームを使用しています。

NVIDIA は声明で、このスーパーコンピューターを DALL-E や安定拡散などの生成 AI モデルの研究と加速に使用できると述べました。

AI 研究者は、より複雑な AI ワークロードを処理するためにより強力な GPU を使用し始めており、AI モデルの可能性がさらに高まっていると考えており、これらのモデルはニュアンスをよく理解しています。多くの異なる言語タスクを同時に処理するには十分です。

簡単に言うと、モデルが大きくなるほど、より多くのデータが得られ、トレーニングにかかる時間が長くなり、モデルの精度が向上します。

しかし、これらのより大規模なモデルは、すぐに既存のコンピューティング リソースの限界に達するでしょう。そして Microsoft は、OpenAI に必要なスーパーコンピューターがどのようなもので、どれくらいの大きさが必要かを理解しています。

これは明らかに、単に多数の GPU を購入して接続し、連携して動作できるようにすることを意味するものではありません。

Microsoft の Azure ハイ パフォーマンス コンピューティングおよび人工知能のプロダクト リードである Nidhi Chappell 氏は次のように述べています。「大規模なモデルをより長時間トレーニングできるようにする必要があります。つまり、最大のインフラストラクチャを構築するには、それを長期にわたって確実に実行できるようにする必要もあります。」

Microsoft は、これらすべてのマシンとチップを確実に冷却できるようにする必要がある、と Alistair Speirs 氏は述べています。 Azure のグローバル インフラストラクチャ担当ディレクター。例としては、涼しい気候では外気を使用し、暑い気候ではハイテク気化式クーラーを使用することが挙げられます。

さらに、すべてのマシンが同時に起動するため、Microsoft は電源との配置も考慮する必要があります。キッチンで電子レンジ、トースター、掃除機を同時にオンにすると何が起こるかに似ていますが、データセンター版です。

これらのブレークスルーを達成するための鍵は何でしょうか?

課題は、高スループット、低遅延の InfiniBand ネットワーク上で相互接続された、同じ場所に配置された何万もの GPU をどのように構築、運用、維持するかです。

この規模は、GPU やネットワーク機器のサプライヤーによるテストの範囲をはるかに超えており、まったく未知の領域です。この規模でハードウェアが壊れるかどうかは誰にもわかりません。

Microsoft Azure のハイパフォーマンス コンピューティングおよび人工知能製品の責任者である Nidhi Chappell 氏は、LLM のトレーニング プロセス中に、関係する大規模な計算が通常、クラスター内の数千の GPU に分割されると説明しました。

allreduce と呼ばれるステージでは、GPU は実行中の作業に関する情報を交換します。現時点では、次の計算ブロックが開始される前に GPU が計算を完了できるように、InfiniBand ネットワークを通じてアクセラレーションを実行する必要があります。

Nidhi Chappell 氏は、これらのジョブは数千の GPU にまたがるため、インフラストラクチャの信頼性を確保することに加えて、最適なパフォーマンスを達成するには非常に多くのシステム レベルの最適化が必要であると述べました。多くの世代の経験を通じてまとめられています。

いわゆるシステムレベルの最適化には、GPU やネットワーク機器を効果的に利用できるソフトウェアが含まれます。

Microsoft は、トレーニング コストと、トレーニングに必要なリソース要件と時間を削減しながら、数十兆のパラメータを使用してモデルをトレーニングする能力を向上させるために、過去数年間にわたってこのテクノロジを開発してきました。これらのモデルを本番環境で提供します。

Waymouth 氏は、Microsoft とパートナーも、GPU クラスターの稼働を維持するために必要なデータをどこまでプッシュできるかを確認するために、GPU クラスターの容量を徐々に増やし、InfiniBand ネットワークを開発していると指摘しました。冷却システム、無停電電源システム、バックアップ発電機などのインフラストラクチャ。

Microsoft AI プラットフォーム担当コーポレート バイス プレジデントのエリック ボイド氏は、大規模な言語モデルのトレーニングと AI イノベーションの次の波に最適化されたこの種のスーパーコンピューティング能力はすでに直接使用できると述べました。 Azure クラウド サービスで取得します。

マイクロソフトは OpenAI との協力を通じて多くの経験を蓄積しており、他のパートナーが同じインフラストラクチャを必要とする場合、マイクロソフトもそれを提供できます。

現在、Microsoft の Azure データ センターは、世界中の 60 以上の地域をカバーしています。

新しい仮想マシン: ND H100 v5

上記のインフラストラクチャに関して、Microsoft は改善を続けてきました。

本日、Microsoft は、最新の NVIDIA H100 Tensor コア GPU と NVIDIA Quantum-2 InfiniBand ネットワークを統合した、非常にスケーラブルな新しい仮想マシンを正式に発表しました。

マイクロソフトは、仮想マシンを通じて、あらゆる AI タスクの規模に合わせて拡張できるインフラストラクチャを顧客に提供できます。 Microsoft によると、Azure の新しい ND H100 v5 仮想マシンは、開発者に数千の GPU を呼び出しながら優れたパフォーマンスを提供します。

参考資料: https://www.php.cn/link/a7bf3f5462cc82062e41b3a2262e1a21

以上がChatGPTの超高価格と超計算の秘密を暴露!数万台の Nvidia A100 には Microsoft に数億ドルの費用がかかりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。