今後、どのように情報検索を行っていくのでしょうか?

ゲスト | ドゥ・ジチェン

企画 | 張鳳

企画 | 徐潔誠

# 検索エンジンが誕生してから 20 年以上が経ちますが、その形式や構造はあまり変わっていません。インターネット技術の継続的な発展により、今後の検索環境はより複雑かつ多様化し、ユーザーの情報入手方法も大きく変化し、単純なキーワードに代わって自然言語、音声、視覚などの多様な入力形式が登場することは避けられません。 ; 回答、高度な知識、分析結果、生成されたコンテンツなどの複数のモーダル コンテンツ出力が、単純な結果リストを置き換えます。インタラクション方法も、単一ラウンドの検索から複数ラウンドの自然言語インタラクションに移行する可能性があります。

それでは、新しい検索環境において、将来のインテリジェント検索テクノロジーはどのような特徴を示すのでしょうか?最近、51CTO が主催する AISummit Global Artificial Intelligence Technology Conference で、ヒルハウス人工知能大学院副学部長の Dou Zhicheng 氏は次のように述べました。中国人民大学「次世代インテリジェント検索技術」の基調講演を通じて、新世代インテリジェント検索技術の開発動向と核となる機能を聴衆と共有するとともに、インタラクティブ、マルチモーダル、説明可能な検索を実現、大規模モデル中心のインデックス解除検索やその他のテクノロジーが詳細に分析されています。この記事は、皆様に新たなインスピレーションをもたらすことを願って、Dou Zhicheng 氏のスピーチの内容を編集、整理したものです。

今後の検索の主な特徴

私たちは、将来の検索には少なくとも次の 5 つの特性がある可能性があります:

- 会話型、人々と検索エンジンは自然言語による複数ラウンドの対話です。

- パーソナライゼーション、 は、型にはまった方法で全員に同じ結果を与えるのではなく、さまざまなユーザーのニーズに応じてさまざまな結果をフィードバックします。

- マルチモーダル、返されるコンテンツと入力方法は、媒体または方法としてテキストを使用することに限定されない場合があります。

- 豊富な知識、 検索によって返される情報は、結果リストの形式だけでなく、さまざまな表示形式、さまざまな知識、物理的に表示されます。

- インデックスの削除,転置インデックスまたは密インデックスも、早急に大きな変更を加える必要があります。

会話型

今日の検索エンジンで一般的に使用されているモードは、ボックスに 1 つまたは 2 つの単語を入力して検索することです。将来の検索には、会話形式で検索エンジンと対話することが含まれる可能性があります。

従来の検索エンジンで使用されているキーワード検索方法では、キーワードを通じて探しているすべての核となる情報を記述したいと考えています。つまり、単一のクエリで完了し、この情報の必要性を正確に表現してください。しかし、より複雑な情報を表現する場合、キーワードではニーズを満たすのが実際には困難です。会話型検索では、複数回の対話を通じて情報ニーズを完全に表現できます。これは、人々がコミュニケーションを行う際の漸進的な情報対話方法とより一致しています。

この種の対話型検索を実現するには、システムまたはアルゴリズムに大きな課題が伴います。検索エンジンは、複数回の自然言語対話からユーザーの意図を正確に理解する必要があります。・・・と同時に、理解した意図とユーザーが欲しい情報を一致させる必要があります。

従来のキーワード検索と比較して、会話型検索では、ユーザーの真の検索意図を復元するために、より複雑なクエリの理解 (現在のクエリの省略や相互参照などを解決する必要性など) が必要です。 。最も簡単な方法は、すべての履歴クエリを結合し、事前トレーニングされた言語モデルを使用してエンコードすることです。

単純なスプライシング ダイアログの方法は単純ですが、ノイズが発生する可能性があります。すべての履歴クエリが現在のクエリの理解に役立つわけではないため、それに関連するクエリのみを選択します。依存関係コンテキスト。長さの問題も解決できます。

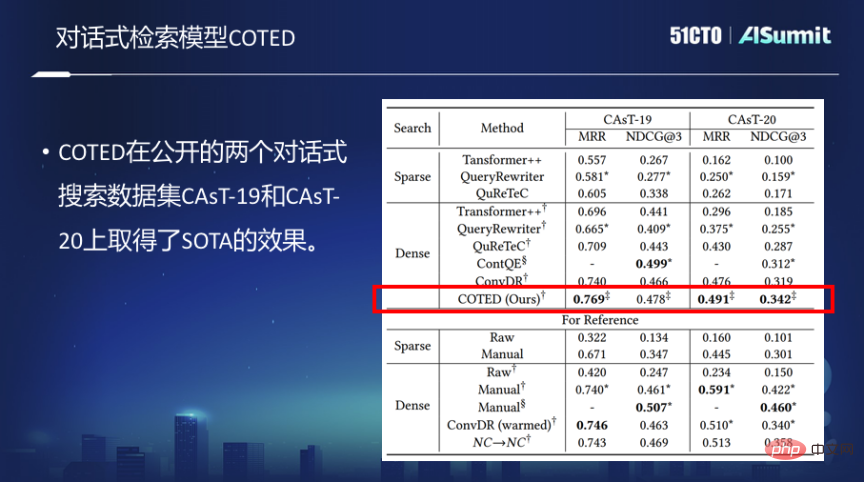

#会話型密検索モデル COTED上記の考え方に基づいて、主に次の 3 つの部分からなる会話型密検索モデル COTED を提案しました。

1. ダイアログ クエリ内の依存関係を特定することで、ダイアログ内のノイズを除去し、ユーザーの意図をより適切に予測できるようになります。

2. 対照学習に基づくデータ強化 (さまざまなノイズ状況の模倣) とノイズ除去損失関数により、モデルは無関係なコンテキストを無視することを学習し、それを最終的なマッチング損失関数ジョイントと組み合わせることができます。 、マルチタスク学習。

3. コース学習を通じてモデルのマルチタスク学習の学習の難しさを軽減し、最終的にモデルのパフォーマンスを向上させます。

ただし、会話型検索モデルのトレーニングに十分なデータは実際には非常に限られており、サンプルが限られている場合、会話型検索モデルの検索は困難になります。モデルのトレーニングは非常に難しいです。

この問題を解決するにはどうすればよいですか?出発点は、検索エンジンのログを会話型検索エンジンのトレーニング用に移行できるかどうかです。この考えに基づいて、大規模な Web 検索ログが会話型検索ログに変換され、変換されたデータに基づいて会話型検索モデルがトレーニングされます。しかし、この方法には 2 つの明らかな問題もあります:

第一に、従来の Web 検索はキーワード検索を使用し、会話型検索は自然言語の会話方法です。クエリ フォームが異なるため、クエリを使用できません。直接移行されました。次に、クエリ自体には多くのノイズが含まれているため、検索ログ内のユーザー データを会話型検索で使用する前に、クリーニング、フィルタリング、変換する必要があります。

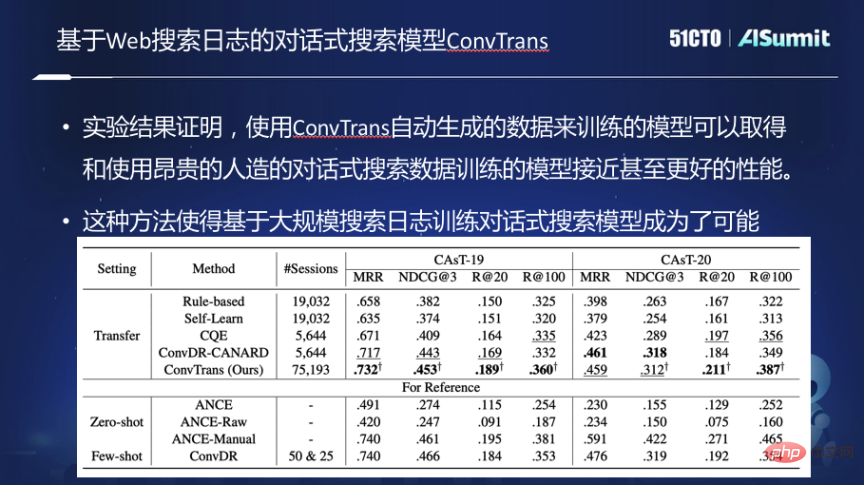

会話型検索学習モデル ConvTrans

これらの課題を解決するために、会話型検索学習モデル ConvTrans を作成し、以下の機能を実装しました。

まず、従来の Web 検索エンジンのログはグラフに整理され、クエリとクエリ、クエリとドキュメントの間の接続を確立することによってグラフが構築されます。グラフに基づいて、T5 に基づく 2 段階のクエリ書き換えモデルを使用して、キーワード クエリを質問の形式に書き換えます。書き換え後、グラフ内の各クエリは自然言語を使用して新しいクエリを表現し、グラフ上でランダム ウォークを実行して会話セッションを生成するサンプリング アルゴリズムを設計し、このデータに基づいて会話モデルをトレーニングします。

実験によると、この自動生成されたトレーニング データを使用してトレーニングされた会話型検索モデルは、高価な人工データや手動でラベル付けされたデータを使用した場合と同じ効果を達成でき、時間が経つにつれて自動生成されたデータのサイズが大きくなるにつれて、トレーニング データが増加すると、パフォーマンスは向上し続けます。このアプローチにより、大規模な検索ログに基づいて会話型検索モデルをトレーニングすることが可能になります。

会話型検索モデルは検索において大きな進歩を遂げましたが、この会話型手法は依然として受動的であり、検索エンジンは常に受動的でした。検索エンジンは、ユーザー入力を受け入れ、その入力に基づいて結果を返します。検索エンジンは、何を探しているのかをユーザーに積極的に尋ねることはありません。しかし、人と人とのコミュニケーションの過程で、質問されたとき、明確にするために率先して質問することがあります。

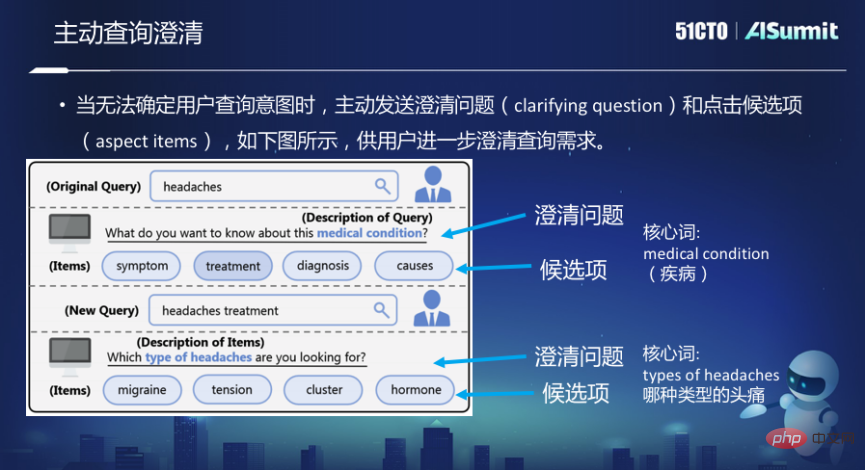

たとえば、Bing 検索で、クエリが「Headaches」の場合、頭痛になります。症状、治療、診断、原因や引き金など、「この病状について何を知りたいですか」、「この病気について何を知りたいですか」と尋ねます。 Headaches 自体は非常に広範なクエリであるため、この場合、システムは検索したい情報をさらに明確にしたいと考えています。

ここには 2 つの問題があります。1 つ目は、ユーザーに明確にしてもらいたい具体的な項目の候補です。 2 つ目は質問を明確にすることで、検索エンジンが率先してユーザーにこの質問を投げかけます。コアワードは問題を明確にする上で最も重要な部分です。

探索のこの側面では、最初に、クエリ ログとナレッジ ベースを通じてクエリが与えられたときに、いくつかの明確化候補を生成します。第二に、この説明質問のいくつかの核となる単語は、ルールに基づいて検索結果から予測できます。同時に、一部のデータにもラベルが付けられ、教師ありモデルを使用してテキスト ラベルが分類されます。 3 番目に、この注釈付きデータに基づいてエンドツーエンドの生成モデルをさらにトレーニングします。

パーソナライゼーション

パーソナライゼーションとは、今後の検索はユーザー中心になりますを指します。今日の検索エンジンは、誰が検索しても同じ結果を返します。これは、ユーザーの特定の情報ニーズを満たしていません。

現在のパーソナライズされた検索モデルは、まずユーザー履歴を通じてユーザーが精通している知識や情報を学習し、クエリに対してパーソナライズされたエンティティの曖昧さ回避を実行するモデルを採用しています。第 2 に、曖昧さのないクエリ エンティティによってパーソナライズされたマッチングが強化されます。

さらに、製品カテゴリに基づいたユーザーの多関心モデルの構築も調査しました。ユーザーはすべてのカテゴリにわたって何らかのブランド (仕様、モデル) 傾向を持っていると想定されますが、この傾向はあり得ません。 be simple. は 1 つまたは 2 つのベクトルによって特徴付けられます。ユーザーのショッピング履歴に基づいてナレッジ グラフを構築し、さまざまなカテゴリに対するさまざまな興味をナレッジ グラフを通じて学習し、最終的にはより正確にパーソナライズされた検索結果をプッシュできるようにする必要があります。

同じパーソナライズされた方法を使用してチャットボットを構築することもできます。中心となるアイデアは、ユーザーの過去の会話を通じてユーザーのパーソナライズされた興味と言語パターンを学習し、パーソナライズされた対話モデルをトレーニングすることです。 (エージェント)ユーザーが発言します。

マルチモーダル

今日の検索エンジンには、マルチモーダル情報を処理する際に実際にはかなりの制限があります。将来的には、ユーザーが取得する情報はテキストや Web ページだけでなく、写真、ビデオ、より複雑な構造情報も含まれる可能性があります。したがって、将来の検索エンジンは、マルチモーダルな情報を取得するためにまだ多くの作業を行う必要があります。

現在の検索エンジンには、クロスモーダル検索の理解や実行、つまり、テキストによる説明を与え、それに対応する画像を検索するという点では、まだ多くの欠陥があります。同様の検索が携帯電話に移行されると、制限はさらに大きくなります。

いわゆるマルチモーダルとは、探している言語、画像、写真、ビデオ、その他のモダリティが統一された空間にマッピングされ、写真を見つけることができることを意味します。テキストを通じて、テキストを検索するための画像、画像を検索するための画像など。

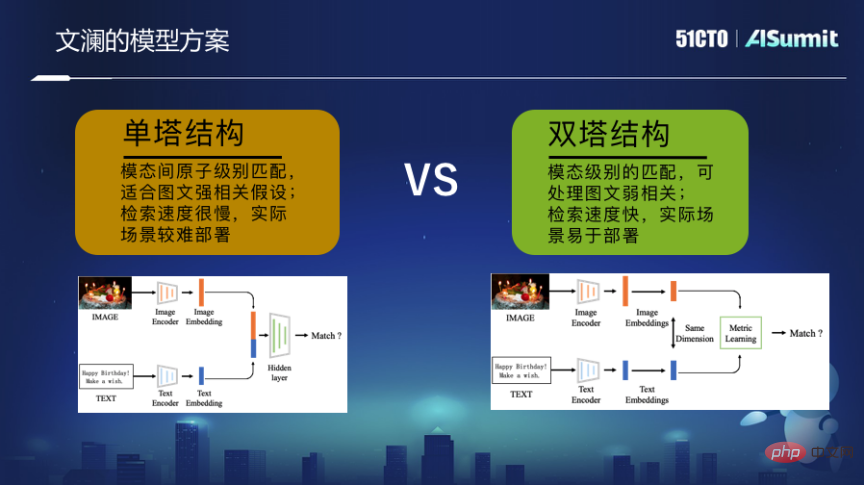

これに関して、私たちは大規模なマルチモーダル事前トレーニング モデル、Wenlan を作成しました。これは、大量のインターネット画像と近くのテキストの弱く教師された相関関係によってもたらされる情報に基づくトレーニングに焦点を当てています。ツインタワー モードを使用すると、最終的なトレーニングはピクチャ エンコーダとテキスト エンコーダです。これら 2 つのエンコーダはエンドツーエンドのマッチング最適化学習プロセスを通過するため、最終的な表現ベクトルは、絵の細かい粒子と文字の細かい粒子をつなぎ合わせます。

このクロスモーダル検索機能は、実際には、Web 検索エンジンを使用するときにユーザーにエンドツーエンドでより多くのスペースを提供するだけでなく、同時に、ソーシャルメディアであろうと、文化的および創造的なカテゴリーであろうと、創作などの多くのアプリケーションをサポートするために使用することもできます。

豊富な知識

現在、検索エンジンは Web ページを検索するのが一般的ですが、将来的には、検索エンジンが処理する単位は Web ページだけではなく、Web ページに基づいたものになるはずです。返された結果を含む単元も、ページごとのリストではなく、高度な知識である必要があります。多くの場合、ユーザーは実際に検索エンジンを使用して複雑な情報ニーズを満たしたいと考えているため、結果を 1 つずつ分析させるのではなく、検索エンジンが結果の分析に役立つことを望んでいます。

この考えに基づいて、詳細なテキスト分析を提供し、高度な知識を効率的かつ迅速に取得できる検索エンジンに相当する分析エンジンを構築しました。ユーザーが大規模な文書を読んで理解できるようにし、そこに含まれる重要な情報や知識を抽出、マイニング、要約するのを支援します。最後に、ユーザーはインタラクティブな分析プロセスを通じて、マイニングされた高度な知識を閲覧および分析して、ユーザーに提供できます。意思決定サポート付き。

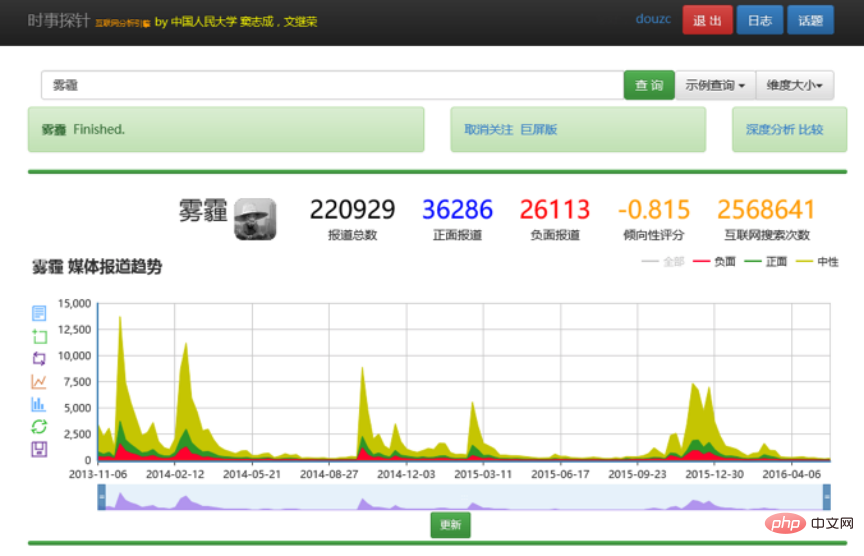

たとえば、ユーザーがヘイズに関連する情報を検索したい場合、「ヘイズ」と直接入力できます。豊富な知識モデルは、従来の検索エンジンが返す結果とは異なり、タイムライン上でのスモッグに関する情報の分布などをユーザーに伝えるタイムラインを返したり、スモッグや機関に関するサブトピックを要約したりすることもあります。どれに、どんなキャラクターがいるのか。もちろん、検索エンジンのように結果の詳細なリストを提供することもできます。

#分析とインタラクティブな分析を直接提供するこの機能は、ユーザーが複雑な情報を取得するのに役立ちます。ユーザーに提供されるのは、単なる検索結果のリストではなくなりました。もちろん、このようなインタラクティブな多次元知識分析は単なる表示方法であり、将来的にはさらに多くの方法が使用される可能性があります。

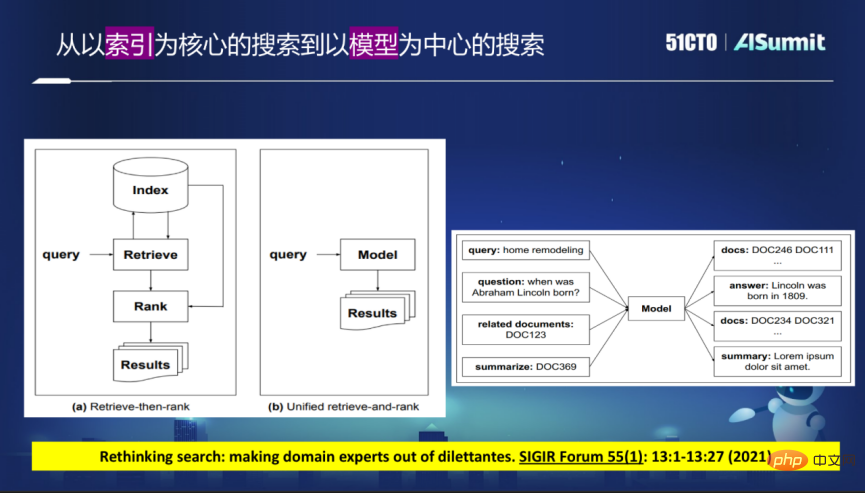

インデックスに移動

現在、検索エンジンはインデックス作成を中心とした段階的アプローチを広く採用しており、多数のインターネット Web ページから必要なコンテンツをクロールバックしてインデックスを構築します。逆インデックスまたは密ベクトルインデックス。ユーザーのクエリが来ると、まずリコールが実行され、リコール結果に基づいて絞り込みソートが実行されます。

このモデルは段階に分ける必要があるため、ある段階で問題がある場合、リコール段階で意図した結果が見つからないなど、多くの欠点があります。並べ替えの段階でどれだけ優れていたとしても、あまり良い結果が得られる可能性は低いです。

将来の検索エンジンでは、この構造が壊れる可能性があります。新しいアイデアは、大規模なモデルを使用して現在のインデックス スキーマを置き換えることであり、すべてのクエリはモデルを通じて満たされます。これにはインデックスを使用する必要がなくなり、このモデルを通じて目的の結果が直接フィードバックされます。

これに基づいて、結果のリストを直接提供したり、ユーザーが必要とする回答を直接提供したりできます。また、回答はモードはより適切に統合されています。インデックスを削除し、モデルを通じて結果を直接フィードバックするということは、モデルがドキュメント ID を直接返すか、直接返すことができることを意味します。モデル中心の検索を構築するには、ドキュメント ID をモデルに埋め込む必要があります。

概要

今日の検索エンジンは、入力としてキーワード、出力としてドキュメント リストという単純なモデルを広く使用しています。人々の複雑な情報取得ニーズを満たすには、すでにいくつかの問題があります。将来の検索エンジンは、会話型でパーソナライズされ、ユーザー中心であり、固定概念を打ち破ることができるものになります。同時に、マルチモーダルな情報を処理し、知識を処理し、知識を返すことができます。アーキテクチャ的には、将来的には転置インデックスや密ベクトルインデックスを用いた既存のインデックス中心モデルを確実に打破し、段階的にモデル中心モデルに移行していきます。

ゲスト紹介

Dou Zhicheng, 人民大学中国ヒルハウス人工知能研究所副所長、北京知源人工知能研究所「インテリジェント情報検索とマイニング」プロジェクトマネージャー。 2008 年にマイクロソフト リサーチ アジアに入社し、インターネット検索関連の業務に従事し、情報検索技術の研究開発で豊富な経験を積みました。彼は 2014 年に中国人民大学で教え始めました。彼の主な研究方向はインテリジェントな情報検索と自然言語処理です。情報検索に関する国際会議 (SIGIR 2013) で最優秀論文ノミネート賞、情報検索に関するアジア会議 (AIRS 2012) で最優秀論文賞、情報検索に関する全国学術会議 (AIRS 2012) で最優秀論文賞を受賞しています。 CCIR 2018、CCIR 2021)。 SIGIR 2019 (短い記事) のプログラム委員長、情報検索評価会議 NTCIR-16 のプログラム委員長、中国コンピュータ連盟ビッグデータ専門家委員会の副事務局長を務める。 。過去 2 年間、彼は主に、パーソナライズされた多様な検索ランキング、対話型および会話型の検索モデル、情報検索の事前トレーニング方法、検索および推奨モデルの解釈可能性、パーソナライズされた製品検索などに焦点を当ててきました。

以上が今後、どのように情報検索を行っていくのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G