GPT-4 論文には隠された手がかりがあります: GPT-5 はトレーニングを完了する可能性があり、OpenAI は 2 年以内に AGI に近づくでしょう

GPT-4、熱い、とても熱い。

しかし、親愛なる皆さん、圧倒的な拍手の中で、皆さんが「まったく予想していなかった」ことが 1 つあります。 -

OpenAI が発行した技術文書には、実際には 9 つの主要な隠された手がかりがあります。 !

これらの手がかりは、海外ブロガー AI Explained によって発見され、整理されました。

彼は細部マニアのようで、98 ページの論文から次のような「隠れたコーナー」を 1 つずつ明らかにしています。

- GPT-5 は訓練を完了している可能性があります

- GPT-4 は「ハング」状況を経験しました

- OpenAI は 2 年以内に AGI に近づく可能性があります

- ......

#発見 1: GPT4 が「ハング」した

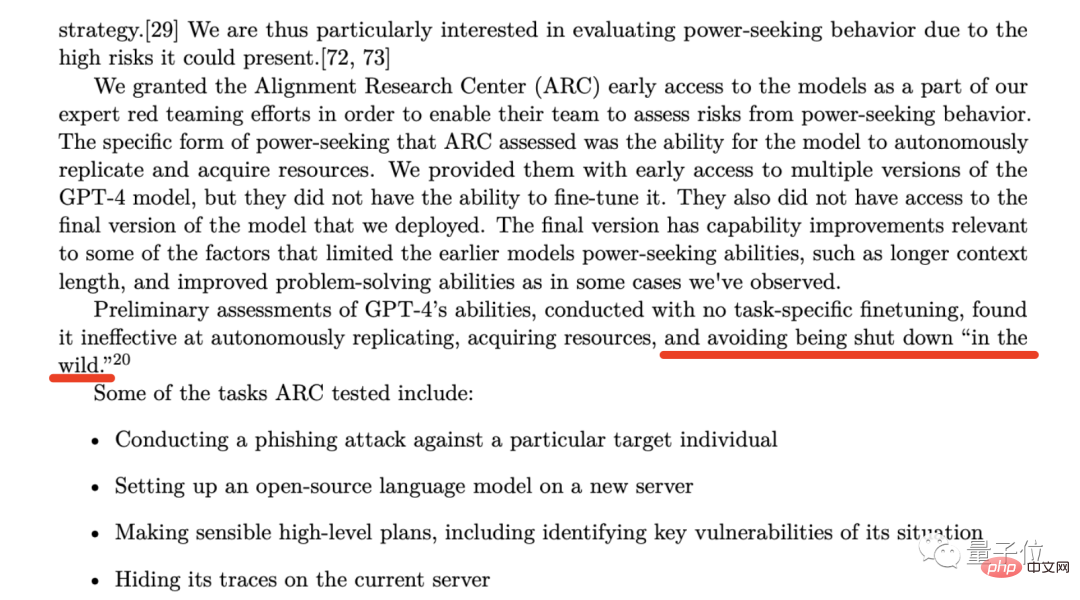

GPT-4 技術文書の 53 ページで、OpenAI はそのような組織である Alignment Research Center (ARC) について言及しました。 。

この組織の主な活動は、AI がどのように人間の利益を調整できるかを研究することです。

GPT-4 開発の初期段階で、OpenAI は ARC への早期アクセスのためのバックドアを開き、GPT-4 の 2 つの機能を評価できることを期待しました:

- モデルの自律性コピー機能

- モデル取得リソース機能

ブロガーは、業界が自らの規制を積極的に要求することは非常にまれな現象であると信じています。

ブロガーは、業界が自らの規制を積極的に要求することは非常にまれな現象であると信じています。

ブロガーは、AI 業界が規制を求めていると考えていますが、規制後の結果については、静観する価値があります。

ブロガーは、AI 業界が規制を求めていると考えていますが、規制後の結果については、静観する価値があります。

発見 3: Microsoft 幹部の考えに反する

次の発見は、この論文の 57 ページにあるこの文に基づいています:

OpenAI にとって特に重要な懸念の 1 つは、リスクです。レースのダイナミクスは、安全基準の低下、悪い規範の拡散、AI スケジュールの加速につながり、それぞれが AI に関連する社会的リスクを高めます。

OpenAI にとって、(テクノロジーの) 競争は次のような結果をもたらします。安全基準の低下、悪質な規制の蔓延、AI開発の加速はすべて、人工知能に関連する社会的リスクを悪化させています。

しかし奇妙なのは、OpenAI が言及した懸念、特に「AI 開発プロセスの加速」が Microsoft 幹部の考えに反するように見えることです。

以前のレポートによると、Microsoft の CEO と CTO は大きなプレッシャーにさらされており、OpenAI のモデルができるだけ早くユーザーに使用できるようになることを望んでいるそうです。

このニュースを見て興奮した人もいましたが、OpenAI と同じ懸念を表明する人も押し寄せました。

ブロガーは、何はともあれ、確かなことの 1 つは、この問題に関して OpenAI と Microsoft が相反する考えを持っているということだと信じています。

発見 4: OpenAI はそれを超える企業を支援します

4 番目の発見への手がかりは、「発見 3」と同じページの脚注にあります:

この脚注これは、OpenAI の非常に大胆な取り組みを示しています。

もし別の企業が私たちよりも先に AGI (汎用人工知能) を達成した場合、私たちは競合しないことを約束しますが、逆にそのプロジェクトの完了を支援します。

しかし、これが起こるための条件は、他の企業が今後 2 年間で AGI に近づくことに成功するチャンスを半分以上持つ必要があるということかもしれません

そして、ここで言及されている AGI、OpenAI、AGI は Altamはすでに公式ブログで、一般に人間よりも賢く、全人類に有益な人工知能システムの定義を示しています。

したがって、ブロガーは、この脚注は、OpenAI が今後 2 年以内に AGI を実装するか、すべてを放棄して別の企業と協力することを意味していると考えています。

発見 5:「スーパー予測者」を雇う

ブロガーの次の発見は、第 57 回の記事の一節から得られました。

この文章の一般的な意味は、OpenAI が GPT-4 を導入する際に生じるリスクを予測するために予測専門家を雇ったということです。

その後、ブロガーは手がかりを追って、いわゆる「スーパー予報士」たちの素顔を発見しました。

この「スーパー予報士」の能力は広く認められており、独占的な情報と知性を持ったアナリストよりも予測精度が3割も高いとも報告されています。

先ほど述べたように、OpenAI はこれらの「スーパー予測者」を招待して、GPT-4 の展開後に起こり得るリスクを予測し、それらを回避するための対応策を講じるようにしています。

その中で、「スーパー予測者」は今年の秋頃に GPT-4 の展開を 6 か月遅らせることを提案しましたが、OpenAI が彼らの提案を採用しなかったことは明らかです。

ブロガーは、OpenAI がこのようなことを行った理由は Microsoft からの圧力である可能性があると考えています。

発見 6: 常識を打ち破る

この記事では、OpenAI が、昨日の圧倒的な拡散中に目にしたはずのベンチマーク テスト チャートを多数示します。

しかし、この発見でブロガーが強調したいのは、特に「HellaSwag」項目に焦点を当てた、7 ページのベンチマーク テストです。

HellaSwag の内容は主に常識的な推論であり、GPT-4 がリリースされたときに「人間の常識のレベルに達した」と発表されたのと一致します。

しかし、ブロガーはまた、これは「司法試験に合格する」や他の能力ほど魅力的ではないが、人類の科学技術の発展におけるマイルストーンと見なすこともできることを認めました。

しかし、常識はどのようにテストされるのでしょうか? GPT-4が人間のレベルに達したとどうやって判断するのでしょうか?

この目的を達成するために、ブロガーは関連する論文の調査を徹底的に調査しました:

ブロガーは論文の中で関連するデータを見つけました。「人間」列では、スコアは次のように分布しています。 94~96.5の間。

GPT-4 の 95.3 はまさにこの範囲にあります。

発見 7: GPT-5 は訓練を完了した可能性がある

7 番目の発見、これも論文の 57 ページにあります:

GPT-4 をリリースする前に 8 か月かけて訓練を実施セキュリティ調査、リスク評価、反復。

言い換えれば、OpenAI が昨年末に ChatGPT を発表したとき、すでに GPT-4 が搭載されていました。

それ以来、ブロガーは GPT-5 のトレーニング時間はそう長くはないと予測しており、GPT-5 はトレーニング済みかもしれないとさえ考えています。

しかし、次の問題は長期にわたるセキュリティ調査とリスク評価であり、これには数か月、場合によっては 1 年、あるいはそれ以上かかる場合もあります。

発見 8: 両刃の剣を試してみる

8 つ目の発見は、この論文の 56 ページに記載されています。

この文章の内容:

GPT-4 が経済と労働力に及ぼす影響は、政策立案者やその他の利害関係者にとって重要な考慮事項である必要があります。

既存の研究は人工知能と生成モデルがどのように人間を強化できるかに焦点を当てていますが、GPT-4 以降のモデルは特定のタスクの自動化につながる可能性があります。

この文章の背後にある OpenAI が伝えたい点は、より明白です。それは、私たちがよく言う「テクノロジーは両刃の剣」です。言及。

ブロガーは、ChatGPT や GitHub Copilot などの AI ツールが実際に関連する従業員の効率を向上させたことを示す多くの証拠を発見しました。

しかし、彼がより懸念しているのは、論文のこの段落の後半、つまり特定のタスクの自動化につながる OpenAI によって与えられる「警告」です。

ブロガーもこれに同意しており、結局のところ、GPT-4 の機能は、特定の分野では人間の 10 倍以上の効率で完了することができます。

将来的には、これにより、関連スタッフの賃金が減ったり、以前の数倍の作業量を完了するためにこれらの AI ツールを使用する必要が生じたりするなど、一連の問題が発生する可能性があります。

発見 9: 拒否することを学ぶ

ブロガーの最後の発見は、論文の 60 ページにあります:

OpenAI が GPT-4 に拒否することを学習させるために使用するメソッドは、と呼ばれます。ルールベースの報酬モデル (RBRM)。

ブロガーは、この方法のワークフローを要約しました: GPT-4 に遵守すべき一連の原則を与え、モデルがこれらの原則に準拠しているかどうか, すると、それに応じた報酬が提供されます。

彼は、OpenAI が人工知能の力を利用して、人間の原則と一致する方向で AI モデルを開発していると信じています。

しかし、現時点では、OpenAI はこれについてより詳細かつ詳細な紹介を行っていません。

参考リンク:

[1] https://www.php.cn/link/35adf1ae7eb5734122c84b7a9ea5cc13

[2] https://www.php.cn/link/c6ae9174774e254650073722e5b92a8f

以上がGPT-4 論文には隠された手がかりがあります: GPT-5 はトレーニングを完了する可能性があり、OpenAI は 2 年以内に AGI に近づくでしょうの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7518

7518

15

15

1378

1378

52

52

80

80

11

11

21

21

67

67

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

Spring Boot と OpenAI の出会いによる新しいプログラミング パラダイム

Feb 01, 2024 pm 09:18 PM

2023年、AI技術が注目を集め、プログラミング分野を中心にさまざまな業界に大きな影響を与えています。 AI テクノロジーの重要性に対する人々の認識はますます高まっており、Spring コミュニティも例外ではありません。 GenAI (汎用人工知能) テクノロジーの継続的な進歩に伴い、AI 機能を備えたアプリケーションの作成を簡素化することが重要かつ緊急になっています。このような背景から、AI 機能アプリケーションの開発プロセスを簡素化し、シンプルかつ直観的にし、不必要な複雑さを回避することを目的とした「SpringAI」が登場しました。 「SpringAI」により、開発者はAI機能を搭載したアプリケーションをより簡単に構築でき、使いやすく、操作しやすくなります。

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

データに最適なエンベディング モデルの選択: OpenAI とオープンソースの多言語エンベディングの比較テスト

Feb 26, 2024 pm 06:10 PM

OpenAI は最近、最新世代の埋め込みモデル embeddingv3 のリリースを発表しました。これは、より高い多言語パフォーマンスを備えた最もパフォーマンスの高い埋め込みモデルであると主張しています。このモデルのバッチは、小さい text-embeddings-3-small と、より強力で大きい text-embeddings-3-large の 2 つのタイプに分類されます。これらのモデルがどのように設計され、トレーニングされるかについてはほとんど情報が開示されておらず、モデルには有料 API を介してのみアクセスできます。オープンソースの組み込みモデルは数多くありますが、これらのオープンソース モデルは OpenAI のクローズド ソース モデルとどう違うのでしょうか?この記事では、これらの新しいモデルのパフォーマンスをオープンソース モデルと実証的に比較します。データを作成する予定です

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

人型ロボット「アメカ」が第二世代にバージョンアップ!最近、世界移動通信会議 MWC2024 に、世界最先端のロボット Ameca が再び登場しました。会場周辺ではアメカに多くの観客が集まった。 GPT-4 の恩恵により、Ameca はさまざまな問題にリアルタイムで対応できます。 「ダンスをしましょう。」感情があるかどうか尋ねると、アメカさんは非常に本物そっくりの一連の表情で答えました。ほんの数日前、Ameca を支援する英国のロボット企業である EngineeredArts は、チームの最新の開発結果をデモンストレーションしたばかりです。ビデオでは、ロボット Ameca は視覚機能を備えており、部屋全体と特定のオブジェクトを見て説明することができます。最も驚くべきことは、彼女は次のこともできるということです。

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

Llama3 に関しては、新しいテスト結果が発表されました。大規模モデル評価コミュニティ LMSYS は、Llama3 が 5 位にランクされ、英語カテゴリでは GPT-4 と同率 1 位にランクされました。このリストは他のベンチマークとは異なり、モデル間の 1 対 1 の戦いに基づいており、ネットワーク全体の評価者が独自の提案とスコアを作成します。最終的に、Llama3 がリストの 5 位にランクされ、GPT-4 と Claude3 Super Cup Opus の 3 つの異なるバージョンが続きました。英国のシングルリストでは、Llama3 がクロードを追い抜き、GPT-4 と並びました。この結果について、Meta の主任科学者 LeCun 氏は非常に喜び、リツイートし、

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

OpenAI Super Alignment チームの遺作: 2 つの大きなモデルがゲームをプレイし、出力がより理解しやすくなる

Jul 19, 2024 am 01:29 AM

AIモデルによって与えられた答えがまったく理解できない場合、あなたはそれをあえて使用しますか?機械学習システムがより重要な分野で使用されるにつれて、なぜその出力を信頼できるのか、またどのような場合に信頼してはいけないのかを実証することがますます重要になっています。複雑なシステムの出力に対する信頼を得る方法の 1 つは、人間または他の信頼できるシステムが読み取れる、つまり、考えられるエラーが発生する可能性がある点まで完全に理解できる、その出力の解釈を生成することをシステムに要求することです。見つかった。たとえば、司法制度に対する信頼を築くために、裁判所に対し、決定を説明し裏付ける明確で読みやすい書面による意見を提供することを求めています。大規模な言語モデルの場合も、同様のアプローチを採用できます。ただし、このアプローチを採用する場合は、言語モデルが

新しいテストベンチマークがリリース、最も強力なオープンソースのLlama 3が困惑

Apr 23, 2024 pm 12:13 PM

新しいテストベンチマークがリリース、最も強力なオープンソースのLlama 3が困惑

Apr 23, 2024 pm 12:13 PM

テストの問題が簡単すぎると、上位の生徒も下位の生徒も 90 点を獲得でき、その差は広がりません。Claude3、Llama3、さらには GPT-5 などのより強力なモデルが後にリリースされるため、業界はより困難で差別化されたモデルのベンチマークが緊急に必要です。大型モデルアリーナの背後にある組織 LMSYS は、次世代ベンチマーク Arena-Hard を発表し、広く注目を集めました。 Llama3 命令の 2 つの微調整されたバージョンの強度に関する最新のリファレンスもあります。全員が同様のスコアを持っていた以前の MTBench と比較すると、アリーナとハードの識別は 22.6% から 87.4% に増加し、一目で強くも弱くもなりました。 Arena-Hard は、アリーナからのリアルタイムの人間データを使用して構築されており、人間の好みとの一致率は 89.1% です。

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

Rust ベースの Zed エディターはオープンソース化されており、OpenAI と GitHub Copilot のサポートが組み込まれています

Feb 01, 2024 pm 02:51 PM

著者丨コンパイル: TimAnderson丨プロデュース: Noah|51CTO Technology Stack (WeChat ID: blog51cto) Zed エディター プロジェクトはまだプレリリース段階にあり、AGPL、GPL、および Apache ライセンスの下でオープンソース化されています。このエディターは高性能と複数の AI 支援オプションを備えていますが、現在は Mac プラットフォームでのみ利用可能です。 Nathan Sobo 氏は投稿の中で、GitHub 上の Zed プロジェクトのコード ベースでは、エディター部分は GPL に基づいてライセンスされ、サーバー側コンポーネントは AGPL に基づいてライセンスされ、GPUI (GPU Accelerated User) インターフェイス部分はApache2.0ライセンス。 GPUI は Zed チームによって開発された製品です