VideoMAE: シンプルで効率的なビデオ自己教師付き事前トレーニングの新しいパラダイム

紙のリンク: https://arxiv.org/abs/2203.12602

コードと事前トレーニングの重みは Github でオープンソース化されています: https://github.com/MCG-NJU/VideoMAE

Directory1 . 背景の紹介

2. 研究の動機

3. 手法の紹介##4. VideoMAE実装の詳細

5. アブレーション実験##6. VideoMAEの重要な特徴##7. 主な結果

8. コミュニティの影響

9. 概要

背景紹介

ビデオ自己教師あり学習: ラベル情報を使用せず、設計により自己教師ありエージェントのタスクは、ビデオ データから時空間表現情報を学習することです。既存のビデオ自己教師あり事前トレーニング アルゴリズムは主に 2 つのカテゴリに分類されます: (1) CoCLR、CVRL などの対照学習に基づく自己教師あり手法。 (2) DPC、SpeedNet、Pace などの時系列関連エージェント タスクに基づく自己教師ありメソッド。

アクション認識: 指定されたトリミングされたビデオ (トリミングされたビデオ) を分類し、このビデオ内のキャラクターのアクションを識別します。現在の主流の方式は、2D ベース (TSN、TSM、TDN など)、3D ベース (I3D、SlowFast など)、および Transformer ベース (TimeSformer、ViViT、MViT、VideoSwin など) です。ビデオ分野の基本的なタスクとして、動作認識は、ビデオ分野全体の時空間特徴を抽出するために、ビデオ分野のさまざまな下流タスク (時間的動作検出、時空間動作検出など) のバックボーン ネットワーク (Backbone) としてよく使用されます。ビデオクリップレベルで。

アクション検出: このタスクでは、ビデオのアクションを分類してビデオ内のキャラクターのアクションを識別するだけでなく、スペース内の境界ボックスを使用することも必要です。ボックス) は、キャラクターの空間的な位置。アクション検出には、映画ビデオ分析、スポーツビデオ分析、その他のシナリオで幅広い応用シナリオがあります。

研究動機

2020年末に視覚的自己注意モデル(Vision Transformer)が提案されて以来、Transformerはコンピュータビジョンの分野で広く使用されてきました。一連のコンピューター ビジョン タスクのパフォーマンスの向上に貢献しました。

ただし、Vision Transformer は、トレーニングに大規模なラベル付きデータ セットを利用する必要があります。当初、オリジナルの ViT (Vanilla Vision Transformer) は、数億枚のラベル付き画像を使用した教師あり事前トレーニングによって優れたパフォーマンスを達成しました。現在の Video Transformer は通常、画像データでトレーニングされた Vision Transformer モデル (TimeSformer、ViViT など) に基づいており、大規模な画像データの事前トレーニングされたモデル (ImageNet-1K、ImageNet-21K、JFT など) に依存しています。 300Mなど)。 TimeSformer と ViViT はどちらも、ビデオ データ セットで Video Transformer モデルを最初からトレーニングしようとしましたが、満足のいく結果を達成できませんでした。したがって、他の事前トレーニング済みモデルや追加の画像データを使用せずに、Video Transformer、特にオリジナルの ViT (Vanilla Vision Transformer) をビデオ データセット上で直接効果的にトレーニングする方法は、依然として解決すべき緊急の問題です。既存のビデオ データセットは画像データセットと比較して比較的小さいことに注意してください。たとえば、広く使用されている Kinectics-400 データ セットには 200,000 以上のトレーニング サンプルしかなく、サンプル数は ImageNet-21K データ セットの約 1/50、JFT-300M データ セットの 1/1500 です。数桁の大きさのギャップ。同時に、画像モデルのトレーニングと比較して、ビデオ モデルのトレーニングの計算オーバーヘッドもはるかに高くなります。これにより、ビデオ データセットで Video Transformer をトレーニングすることがさらに困難になります。

最近、「マスキングと再構成」の自己教師ありトレーニング パラダイムは、自然言語処理 (BERT) と画像理解 (BEiT、MAE) において成功を収めています。したがって、この自己教師ありパラダイムを使用してビデオ データ セットで Video Transformer をトレーニングすることを試み、マスキングと再構成のプロキシ タスクに基づいたビデオ自己教師あり事前トレーニング アルゴリズム VideoMAE (Video MAE) を提案します。 )。 VideoMAE によって事前トレーニングされた ViT モデルは、Kinetics-400 や Something-Something V2 などの大規模なビデオ データ セットだけでなく、UCF101 や HMDB51 などの比較的小さなビデオ データ セットでも、他の方法よりも大幅に優れた結果を達成できます。

メソッドの紹介

MAE 概要

MAE は、マスキングと再構成のトレーニング タスクの自己教師あり予測のために、非対称エンコーダー/デコーダー アーキテクチャを採用しています。 224x224 解像度の入力画像は、まずサイズ 16 × 16 の重複しない視覚ピクセル ブロック (トークン) に分割されます。各ピクセルブロック(トークン)は、ブロック埋め込み(トークン埋め込み)操作によって高次元の特徴に変換されます。 MAE は、より高いマスク率 (75%) を使用して、一部のピクセル ブロック (トークン) をランダムにマスクします。マスキング操作の後、残りのピクセル ブロックは特徴抽出のためにエンコーダーに送信されます。その直後、エンコーダーによって抽出された特徴ブロックは、あらかじめ設定された学習可能なピクセル ブロック (学習可能なトークン) の別の部分と結合され、元の入力画像サイズと同じ大きさの特徴が形成されます。最後に、軽量デコーダを使用して、これらの特徴に基づいて元の画像を再構成します(実際の実験では、再構成の対象は正規化されたピクセル ブロック(正規化されたトークン)です。)

映像の特徴データ

##画像データと比較して、ビデオ データはフレーム数が多く、動き情報が豊富です。このセクションではまず、ビデオ データの特徴を見てみましょう。

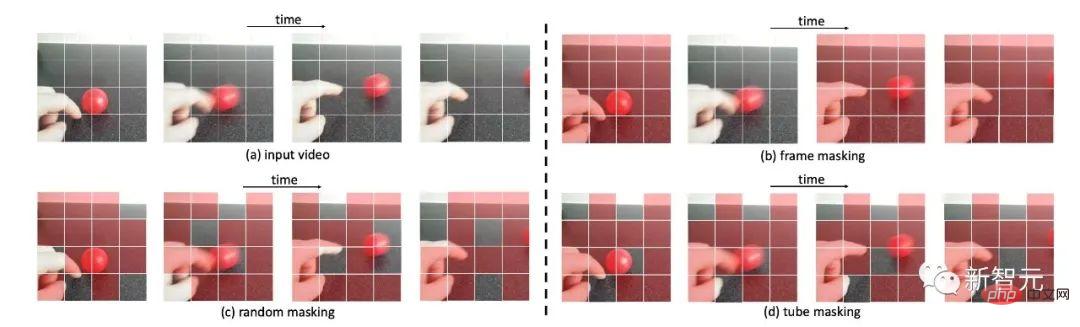

ビデオ データのさまざまなマスキング戦略の例

時間的冗長性ビデオ データには高密度の画像フレームが含まれており、これらの画像フレームに含まれる意味情報は時間の経過とともに非常にゆっくりと変化します。図に示すように、ビデオ内の高密度で連続したカラー画像フレームは非常に冗長であることがわかります。 MAE の実装プロセスでは 2 つの問題が発生します。まず、元のビデオの高密度フレーム レート (30 FPS など) が事前トレーニングに使用される場合、トレーニング効率が非常に低くなります。この設定ではネットワークに負担がかかるためです。データ内の静的な外観の特徴や、局所的に変化する動きの特徴にもっと注意を払う必要があります。第二に、ビデオの時間的冗長性により、ビデオ内の動きの特徴が大幅に薄められます。したがって、この状況により、マスクされたピクセル パッチを再構成するタスクが以下の場合に比較的簡単になります。通常のマスキング レート (例: 50% ~ 75%) これらの問題は、エンコーダとしての Backbone の事前トレーニングされたパフォーマンスに影響を与えます プロセスでモーション特徴を抽出します

時間的相関

ビデオは、時間の経過に伴う静止画像の進化によって生成されたものと見なすことができるため、ビデオ フレーム間には意味的な対応関係もあります。マスキング戦略が特別に設計されていない場合、この時間的相関関係は増加する可能性があります。具体的には、図に示すように、グローバル ランダム マスクまたはランダムにマスクされた画像フレームを使用する場合、ネットワークはビデオ内の時間的相関を利用して、「コピー」によってブロック再構成を実行できます。この場合、エージェント タスクをある程度完了することもできますが、VideoMAE が高レベルの抽象的な意味論ではなく、より低い意味論的な時間対応特徴のみを学習する可能性があります。ビデオ コンテンツの時空間推論能力などの情報 この状況を軽減するには、ネットワークがビデオ内の時空間特徴表現をより適切に学習できるように、再構築タスクをより困難にする新しいマスキング戦略を設計する必要があります。

#VideoMAE メソッドの紹介

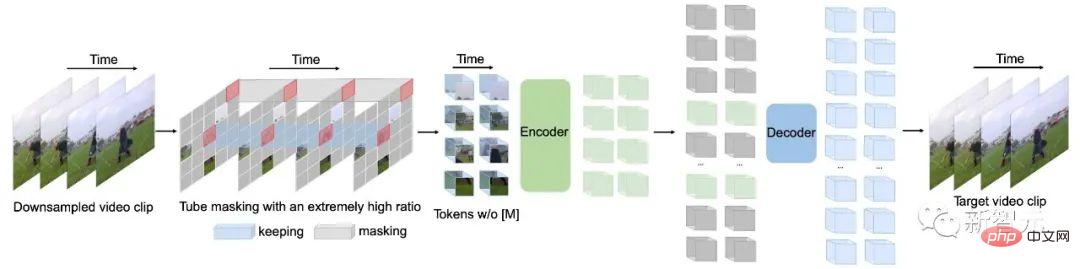

VideoMAE の全体的なフレームワーク

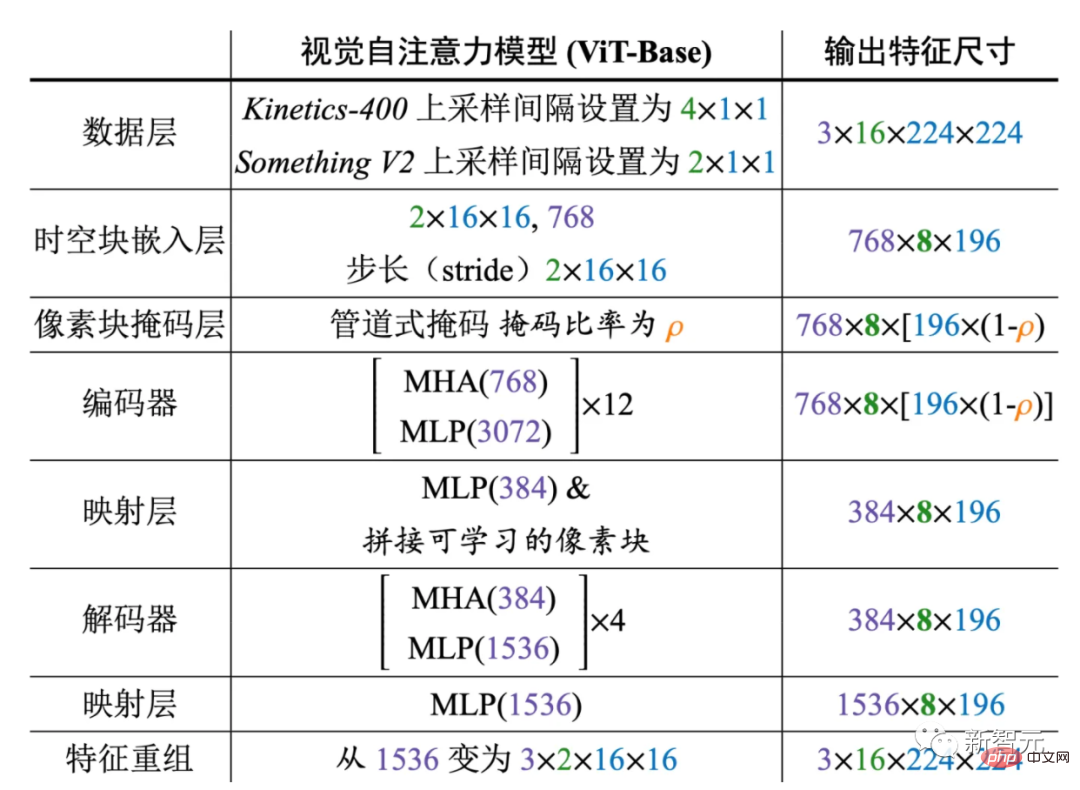

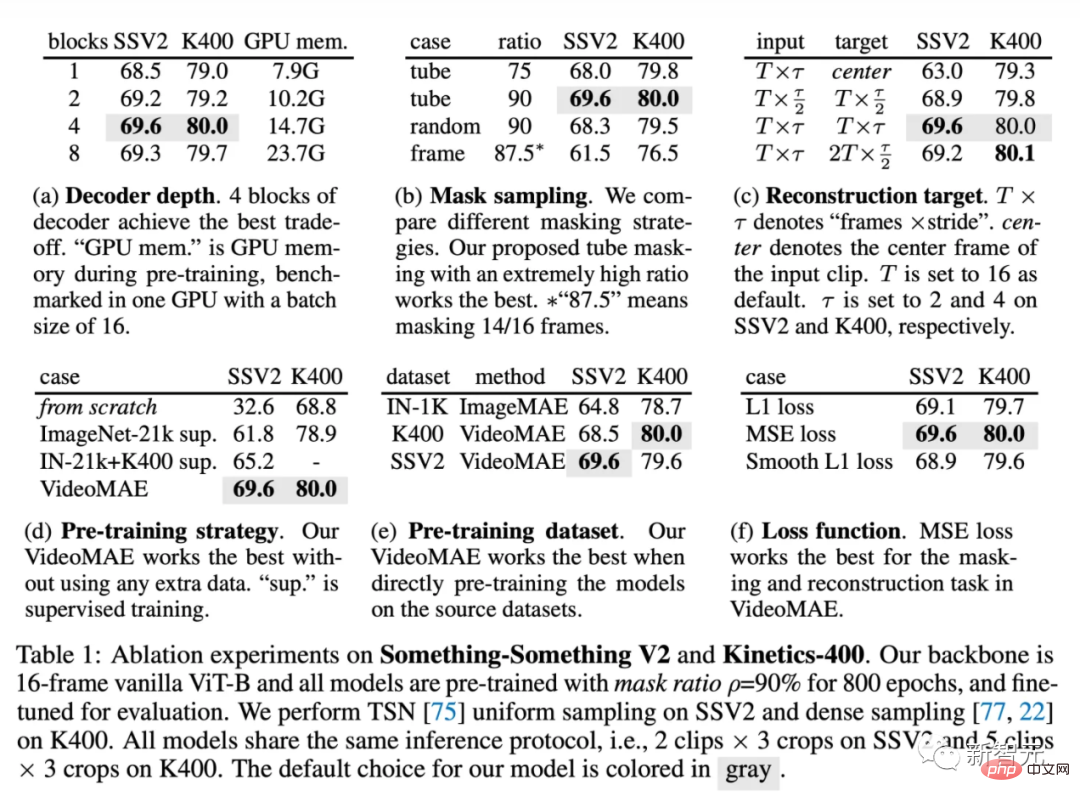

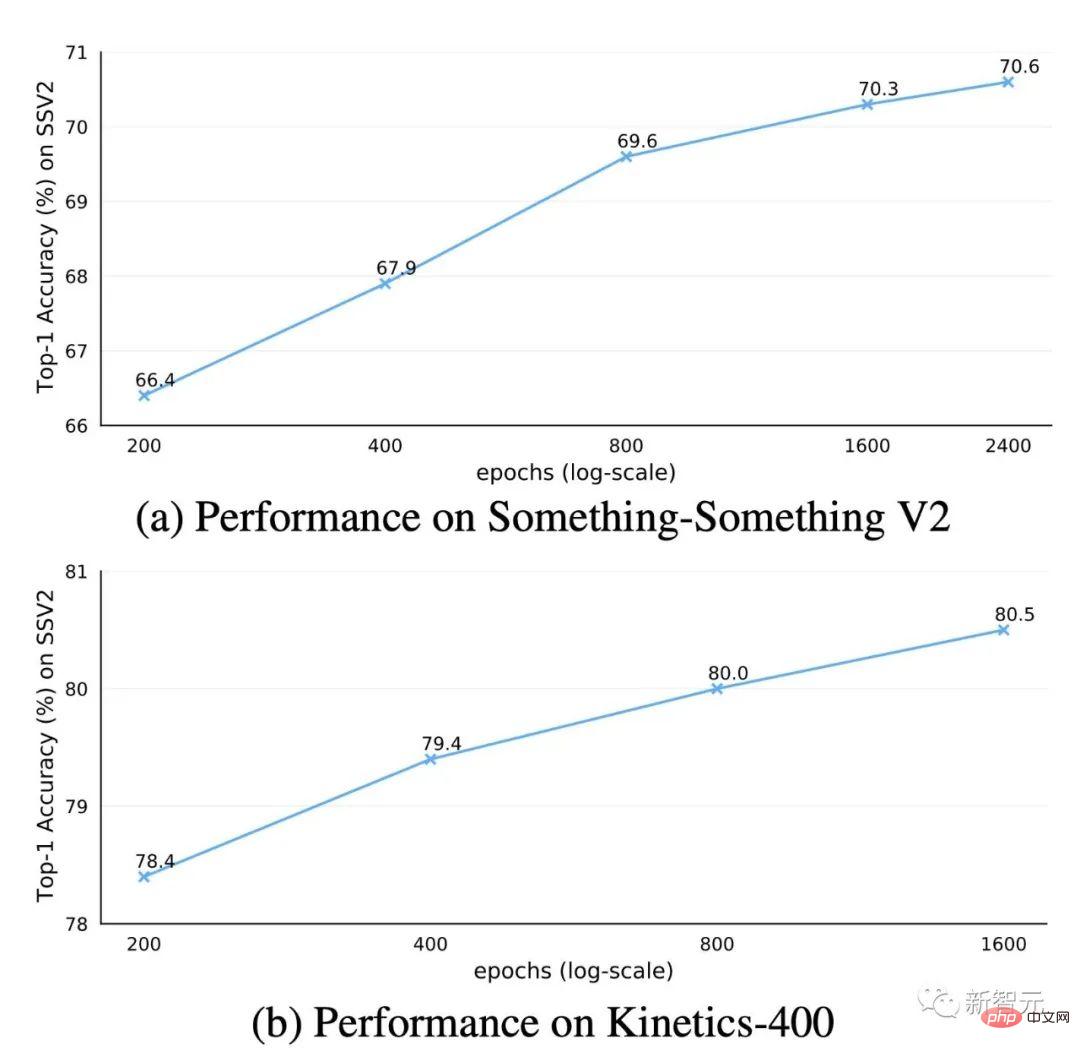

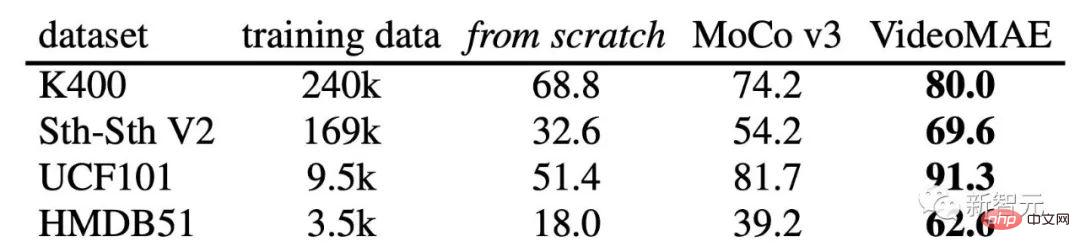

前の記事のビデオ事前トレーニング プロセスを解決するために マスキングと再構成タスクを使用するときに発生する可能性がある問題に対処するために、VideoMAE にいくつかの新しい設計を導入します。ビデオ内の密な連続フレームに存在するタイミング冗長性に関する以前の分析によると、VideoMAE サンプリング戦略のタイミング間隔を使用して、より効率的なビデオによる自己監視型の事前トレーニング。具体的には、$t$ の連続フレームで構成されるビデオ セグメントが、最初に元のビデオからランダムにサンプリングされます。次に、ビデオ クリップは、時間的に間隔をあけたサンプリングを使用してフレームに圧縮され、各フレームには エンコーダーに入力される前に、サンプリングされたビデオ クリップに対して、ピクセル ブロックが時空間の形式で処理されます。ジョイント埋め込み。具体的には、サイズ タイミング冗長性による問題解決と「情報漏洩」問題を解決するために時間的相関によって引き起こされる問題を解決するため、この方法では、自己教師付き事前トレーニングのプロセスでパイプライン マスキング戦略を採用することを選択します。パイプライン マスキング戦略は、単一フレームのカラー画像のマスキング方法をビデオ シーケンス全体に自然に拡張できます。つまり、異なるフレーム内の同じ空間位置にある視覚ピクセル ブロックがマスクされます。具体的には、パイプライン マスキング ポリシーは と表現できます。異なる時間 t は同じ値を共有します。このマスキング戦略を使用すると、同じ空間的位置にあるトークンが常にマスクされます。したがって、一部の視覚ピクセル パッチ (たとえば、さまざまなマスキング戦略のサンプル画像の 4 行目に指を含むピクセル パッチ) については、ネットワークは他のフレームで対応する部分を見つけることができません。この設計は、再構築プロセス中の「情報漏洩」のリスクを軽減するのに役立ち、VideoMAE が元のビデオ クリップから高レベルのセマンティック情報を抽出してマスクされたトークンを再構築できるようにします。 動画データは画像データに比べて冗長性が強く、情報密度が画像データに比べて非常に低いです。この機能により、VideoMAE は事前トレーニングに非常に高いマスク レート (例: 90% ~ 95%) を使用できるようになります。 MAE のデフォルトのマスク率は 75% であることに注意してください。実験結果は、非常に高いマスク レートを使用すると、事前トレーニング (視覚ピクセル ブロックの 5% ~ 10% のみがエンコーダーに入力される) を高速化できるだけでなく、モデルの表現能力とダウンストリームでの効果も改善できることを示しています。タスク 。 前の記事で述べたように、VideoMAE は非常に高いマスキング レートを使用し、非常に少数のトークンのみを保持します。エンコーダへの入力。遮蔽されていないトークンのこの部分の時空間特徴をより適切に抽出するために、VideoMAE は元の ViT をバックボーンとして使用することを選択し、同時にアテンション層 (つまり、次のモデル構造) で時空間共同自己注意を使用しました。元の ViT は変更されませんでした)。したがって、閉塞されていないすべてのトークンはセルフアテンション層で相互作用できます。時空間結合セルフアテンション メカニズムの #上の図は、VideoMAE で使用されるエンコーダーとデコーダーの具体的なアーキテクチャ設計を示しています (ViT-B を例にしています)。 4 つのダウンストリーム ビデオ アクション認識データセットと 1 つのアクション検出データセットで VideoMAE を評価します。これらのデータセットは、ビデオ内のモーション情報のさまざまな側面に焦点を当てています。 Kinetics-400 は、400 の異なるアクション カテゴリをカバーする約 300,000 のトリミングされたビデオ クリップを含む大規模な YouTube ビデオ データセットです。 Kinetics-400 データセットには主に日常生活のアクティビティが含まれており、一部のカテゴリはインタラクティブなオブジェクトやシーン情報と高度に相関しています。 Something-Something V2 データセットのビデオには主に、同じアクションを実行するさまざまなオブジェクトが含まれているため、このデータセットのアクション認識では、オブジェクトやシーンの情報よりもモーション属性に重点を置いています。トレーニング セットには約 170,000 のビデオ クリップが含まれており、検証セットには約 25,000 のビデオ クリップが含まれています。 UCF101 と HMDB51 は、2 つの比較的小さなビデオ アクション認識データセットです。 UCF101 のトレーニング セットには約 9500 個のビデオが含まれており、HMDB51 のトレーニング セットには約 3500 個のビデオが含まれています。実験中、最初に VideoMAE を使用してトレーニング セット上のネットワーク上で自己教師あり事前トレーニングを実行し、次にトレーニング セット上でエンコーダーの教師あり微調整 (ViT) を実行し、最後にモデルのパフォーマンスを評価しました。検証セット。アクション検出データセット AVA の場合、最初に Kinetics-400 データセットでトレーニングされたモデルをロードし、エンコーダーの教師あり微調整 (ViT) を実行します。 アブレーション実験 #デコーダの設計 #oMAE の重要なコンポーネント。異なる深さのデコーダを使用した実験結果を表 (a) に示します。 MAE とは異なり、VideoMAE のより深いデコーダーはより優れたパフォーマンスを達成でき、より浅いデコーダーは GPU メモリの使用量を効果的に削減できます。デコーダ層の数はデフォルトで 4 に設定されています。 MAE の経験的設計に従って、VideoMAE のデコーダのチャネル幅はエンコーダのチャネル幅の半分に設定されます (たとえば、ViT-B がエンコーダとして使用される場合、デコーダのチャネル幅は 384 に設定されます) )。 さまざまなマスキング戦略と、75% のマスキング率を使用したパイプライン マスキング戦略を比較します。表 (b) に示すように、グローバル ランダム マスキングおよびランダム マスキング画像フレームのパフォーマンスは、パイプライン マスキング戦略よりも劣ります。これは、パイプライン マスキング戦略により、ビデオ データのタイミング冗長性とタイミング相関性がある程度軽減されるためと考えられます。マスク率が 90% に増加すると、Something-Something での VideoMAE のパフォーマンスは 68.0% から 69.6% にさらに向上します。 VideoMAE のマスキング戦略とマスキング率の設計により、マスキングと再構築がより困難な代理タスクとなり、モデルに高レベルの時空間特徴の学習を強いることになります。 VideoMAE の再構成ターゲットをここで比較します。結果を表 (c) に示します。まず、ビデオ クリップの中央フレームのみが再構成ターゲットとして使用される場合、ダウンストリーム タスクにおける VideoMAE のパフォーマンスが大幅に低下します。同時に、VideoMAE はサンプリング間隔にも非常に敏感です。より高密度にパックされたビデオ クリップを再構築することを選択した場合、結果はデフォルトの時間的にダウンサンプリングされたビデオ クリップよりも大幅に低くなります。最後に、時間的にダウンサンプリングされたビデオ クリップからビデオ クリップ内のより密度の高いフレームを再構築しようとしましたが、この設定ではより多くのフレームをデコードする必要があり、トレーニングが遅くなり、あまり効果的ではなくなります。 VideoMAE の事前トレーニング戦略をここで比較します。結果を表 (d) に示します。以前の方法 (TimeSformer、ViViT) の実験結果と同様に、動き情報により敏感なデータセットである Something-Something V2 で ViT をゼロからトレーニングしても、満足のいく結果を得ることができません。大規模画像データセット (ImageNet-21K) で事前トレーニングされた ViT モデルを初期化として使用すると、より良い精度が得られ、32.6% から 61.8% に向上します。 ImageNet-21K および Kinetics-400 で事前トレーニングされたモデルを使用すると、精度がさらに 65.2% に向上しました。 VideoMAE を使用してビデオ データ セット自体から事前トレーニングされた ViT は、追加データを使用せずに最終的に 69.6% の最高のパフォーマンスを達成できます。 Kinetics-400 でも同様の結論に達しました。 VideoMAE の事前トレーニング データ セットをここで比較し、結果を表 (e) に示します。 )。まず、MAE の設定に従って、ViT は ImageNet-1K 上で 1600 エポックにわたって自己教師あり事前トレーニングされます。次に、2D ブロック埋め込みレイヤーは、I3D の戦略を使用して 3D 時空間ブロック埋め込みレイヤーにインフレートされ、ビデオ データセット上でモデルが微調整されます。このトレーニング パラダイムは、ゼロから教師付きでトレーニングされたモデルよりも優れたパフォーマンスを発揮します。次に、MAE 事前トレーニング モデルのパフォーマンスを、Kinetics-400 上で VideoMAE によって事前トレーニングされた ViT モデルと比較しました。 VideoMAE は MAE よりも優れたパフォーマンスを達成できることがわかります。ただし、どちらの事前トレーニング モデルも、Something-Something V2 データセット上で自己教師によってのみ事前トレーニングされた VideoMAE よりも優れたパフォーマンスを達成することはできませんでした。トレーニング前のデータセットとターゲットデータセットの間のドメインの違いが重要な問題である可能性があると分析できます。 VideoMAE Impact での事前トレーニングの合計ラウンド数 アブレーション実験では、VideoMAE 事前トレーニングの合計エポック数はデフォルトで 800 に設定されています。私たちは、Kinetics-400 および Something-Something V2 データセットのトレーニング前エポックの詳細な調査を実施しようと試みています。図の結果によると、より長い事前トレーニング エポックを使用すると、両方のデータセットで一貫したゲインが得られます。 さまざまなダウンストリームビデオアクション認識データセットでの VideoMAE と MoCov3 のパフォーマンスの比較 これまでの多くの研究でビデオ自己教師あり事前トレーニングに関する広範な研究が行われてきましたが、これらの方法は主に畳み込みニューラル ネットワークをバックボーンとして使用しており、ViT ベースのトレーニング メカニズムを研究する方法はほとんどありません。したがって、ビデオ自己教師あり事前トレーニングに対する ViT ベースの VideoMAE の有効性を検証するために、2 つの ViT ベースのトレーニング方法を比較しました: (1) ゼロからのモデルの教師ありトレーニング、(2) 対照学習方法 (MoCo) の使用v3) 自己教師付き事前トレーニングを実行します。実験結果によると、VideoMAE が他の 2 つのトレーニング方法よりも大幅に優れていることがわかります。たとえば、データ サイズが最も大きい Kinetics-400 データセットでは、VideoMAE は最初からトレーニングするよりも約 10% 精度が高く、MoCo v3 事前トレーニングの結果よりも約 6% 精度が高くなります。 VideoMAE の優れたパフォーマンスは、マスキングと再構成の自己監視パラダイムが ViT の効率的な事前トレーニング メカニズムを提供することを示しています。同時に、トレーニング セットが小さくなるにつれて、VideoMAE と他の 2 つのトレーニング方法の間のパフォーマンスの差がますます大きくなることは注目に値します。 HMDB51 データセットには約 3500 個のビデオ クリップしか含まれていないにもかかわらず、VideoMAE に基づく事前トレーニング済みモデルは依然として非常に満足のいく精度を達成できることは注目に値します。この新しい結果は、VideoMAE がデータ効率の高い学習器であることを示しています。これは、事前トレーニングに大量のデータが必要な対照学習とは異なります。 VideoMAE のデータ効率の高い機能は、ビデオ データが制限されているシナリオでは特に重要です。

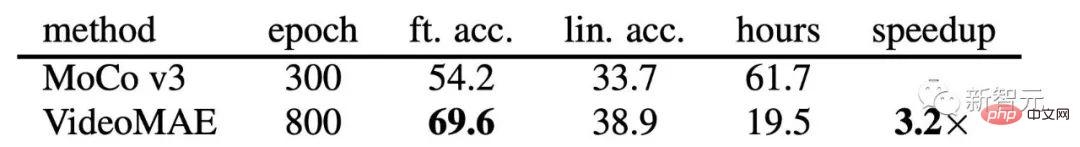

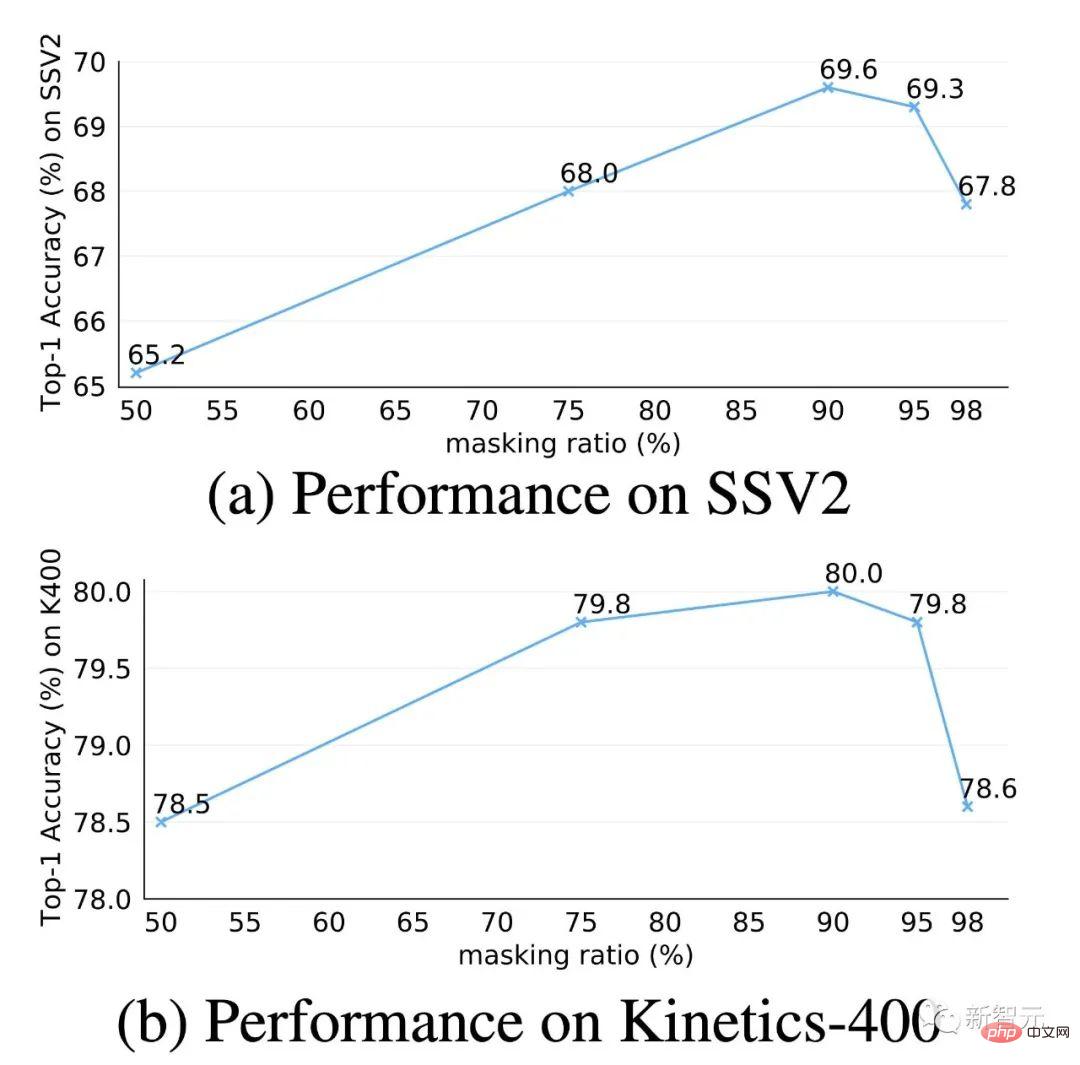

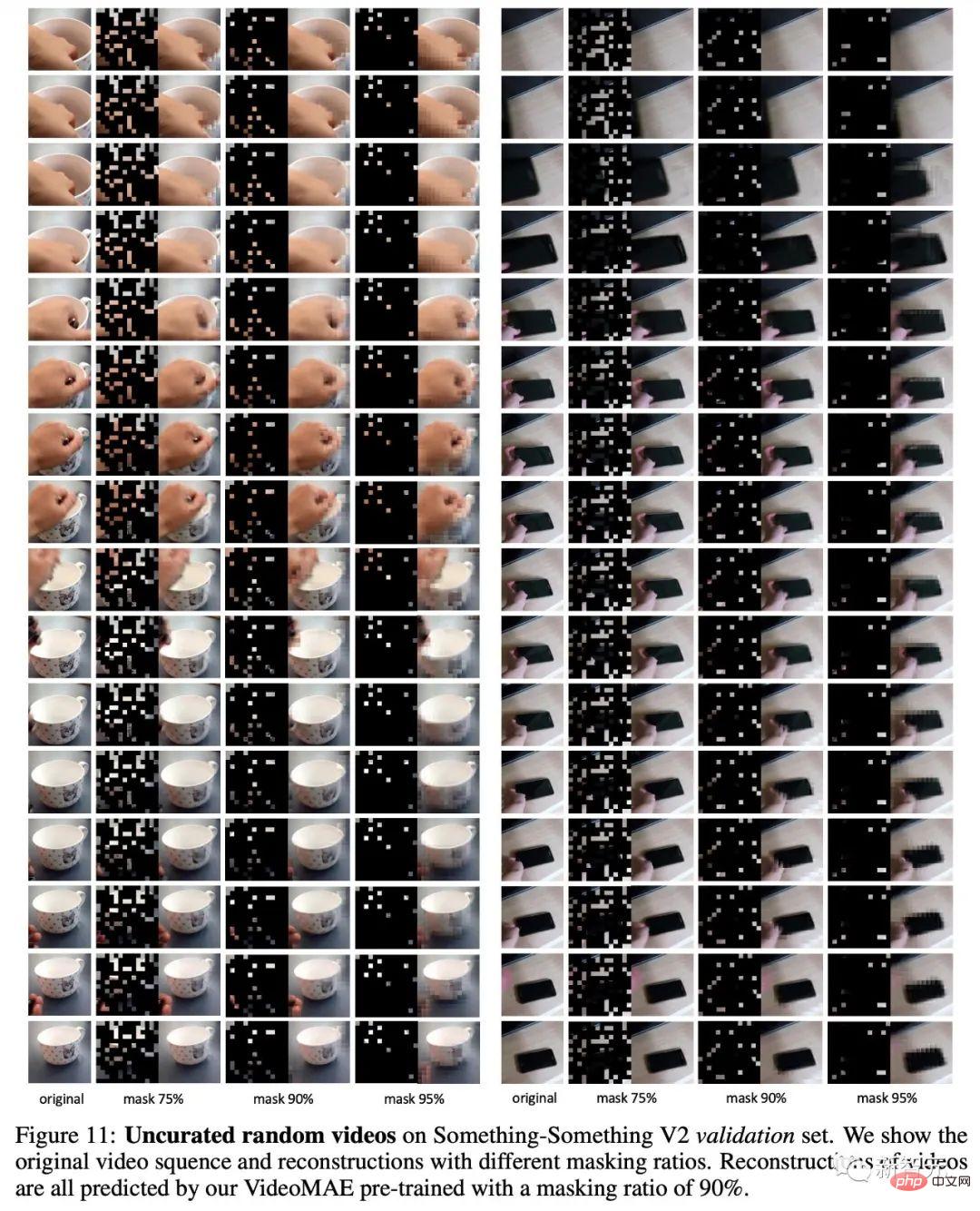

Something-SomethingV2 データセットにおける VideoMAE と MoCov3 の効率分析 ##Weさらに、VideoMAE を使用した事前トレーニングと MoCo v3 を使用した事前トレーニングの計算効率も比較しました。マスキングと再構築という非常に困難なプロキシ タスクにより、ネットワークは各反復で入力データの 10% しか観察できません (トークンの 90% がマスクされます)。そのため、VideoMAE はより多くのトレーニング ラウンドを必要とします。非常に高い割合のトークンが隠されており、この設計により、計算消費量と事前トレーニングの時間が大幅に節約されます。 800 ラウンドの VideoMAE 事前トレーニングには 19.5 時間しかかかりませんが、300 ラウンドの MoCo v3 事前トレーニングには 61.7 時間かかります。 非常に高いマスキング率 非常に高いマスク レートは、VideoMAE の中核となる設計の 1 つです。 Kinetics-400 および Something-Something V2 データセットでこの設計の詳細な調査を実施します。図の結果によると、マスク率が 95% と非常に高い場合でも、ネットワークはダウンストリームのビデオ動作認識タスク用のこれら 2 つの重要なデータセットで優れたパフォーマンスを示しています。この現象は、自然言語処理における BERT や画像における MAE とは大きく異なります。ビデオ データには時間的冗長性と時間的相関性が存在するため、VideoMAE は画像データや自然言語と比較して非常に高いマスク率で動作できます。 事前トレーニングされた VideoMAE の再構成例も視覚化します。この図から、VideoMAE が非常に高いマスク レートでも満足のいく再構成結果を生成できることがわかります。これは、VideoMAE がビデオの時空間特徴を学習して抽出できることを意味します。

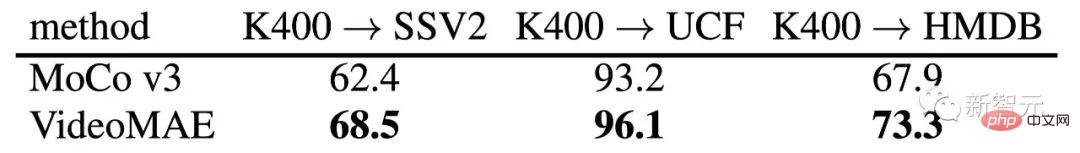

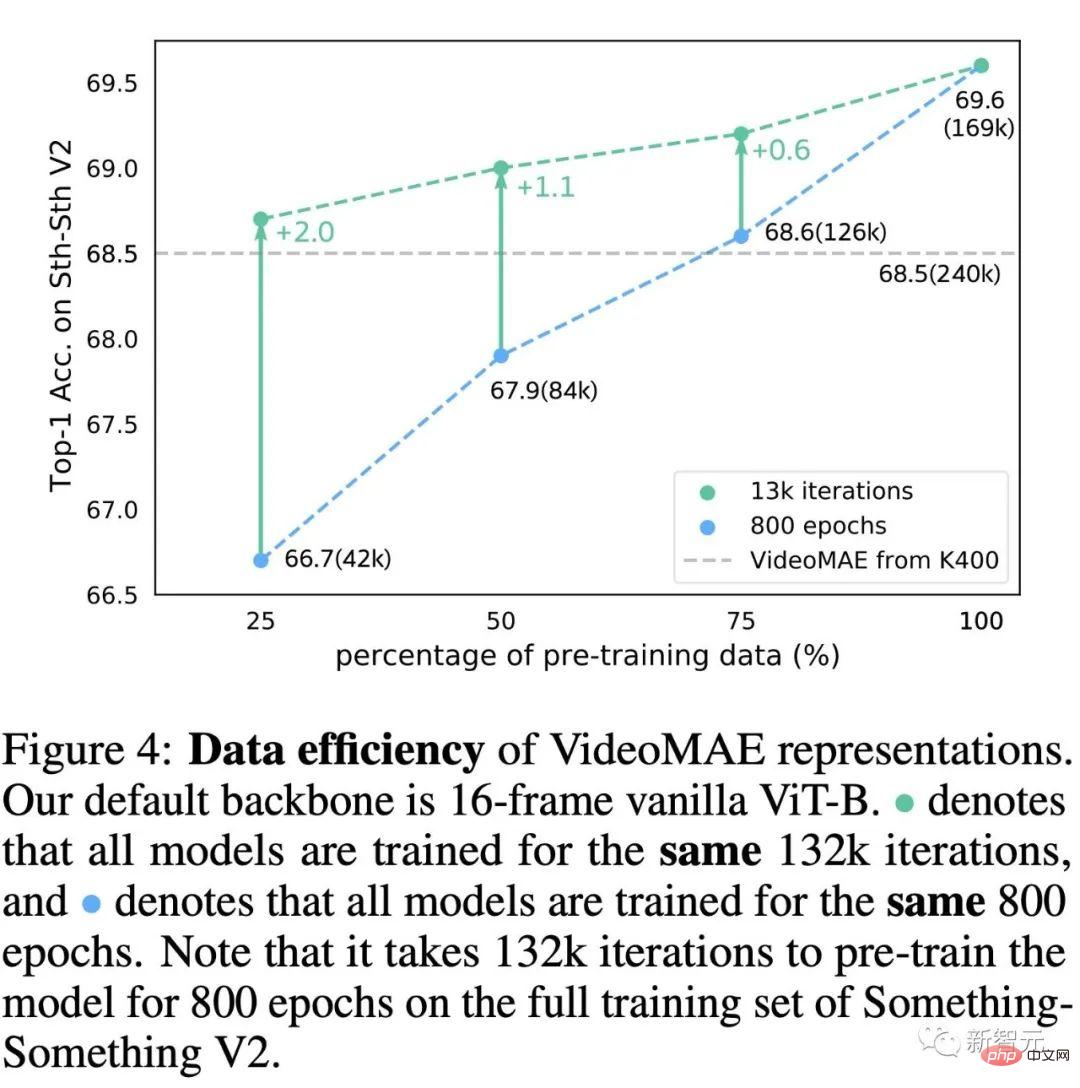

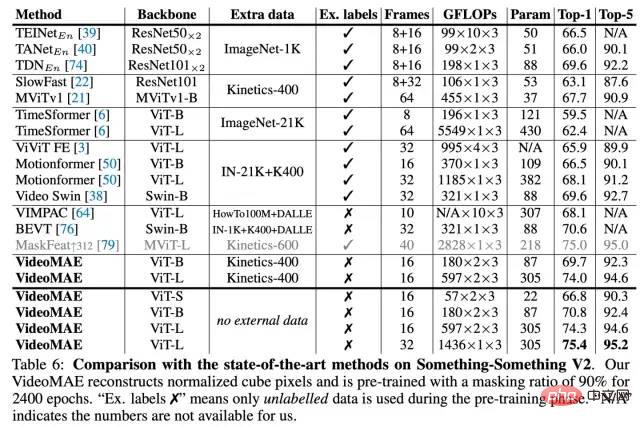

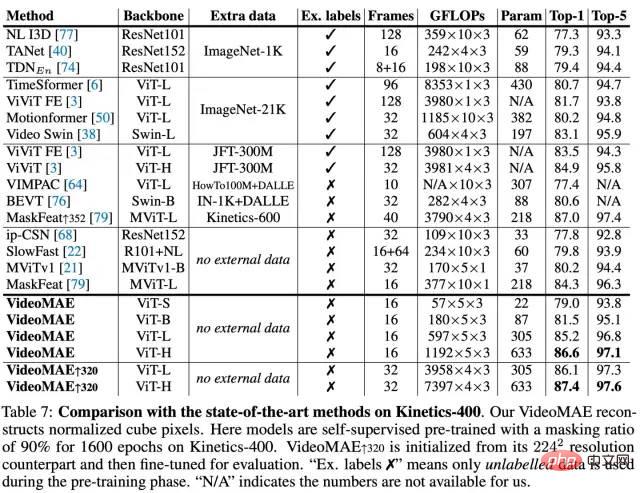

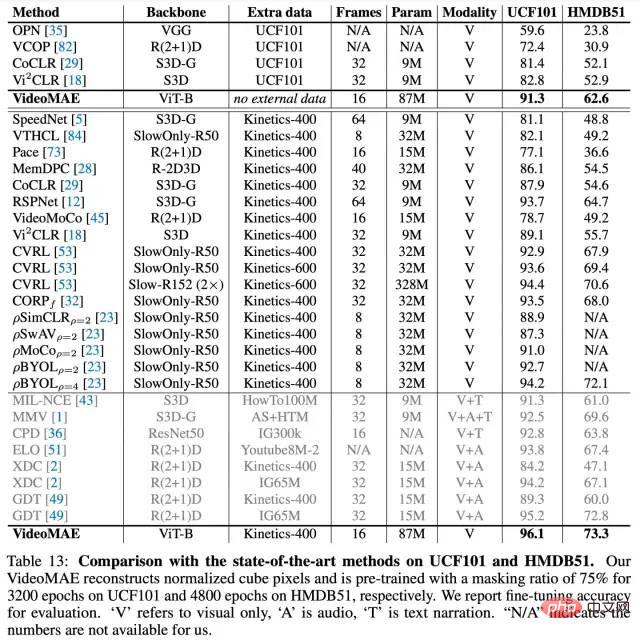

VideoMAE によって学習された機能をさらに研究するために、このセクションでは、事前トレーニングされた VideoMAE の一般化および転送機能を評価します。上の表は、Kinetics-400 データセットで事前トレーニングされた VideoMAE の Something-Something V2、UCF101、および HMDB51 データセットへの転送効果を示しています。同時に、この表には、MoCo v3 を使用して事前トレーニングされたモデルの移行能力も示されています。表の結果によると、VideoMAE を使用して事前トレーニングされたモデルの転送および汎化機能は、MoCo v3 に基づいて事前トレーニングされたモデルよりも優れています。これは、VideoMAE がより多くの転送可能な特徴表現を学習できることを示しています。 Kinetics-400 データセットで事前トレーニングされた VideoMAE は、UCF101 および HMDB51 データセットで直接事前トレーニングされた VideoMAE よりも優れたパフォーマンスを発揮します。しかし、Kinetics-400 データセットで事前トレーニングされたモデルは、Something-Something V2 データセットではあまり転送されません。 この不一致の理由をさらに調査するために、Something-Something V2 データセットで事前トレーニング ビデオの数を減らす実験を実施しました。探索プロセスには 2 つの実験が含まれます: (1) 事前トレーニングに同じ数のトレーニング ラウンド (エポック) を使用する、(2) 事前トレーニングに同じ数の反復 (反復) を使用する。図の結果から、事前トレーニング サンプルの数を減らす場合、より多くのトレーニング反復を使用するとモデルのパフォーマンスも向上することがわかります。たとえ 42,000 の事前トレーニングされたビデオのみが使用されたとしても、Something-Something V2 データセットで直接トレーニングされた VideoMAE は、240,000 のビデオ データを使用して事前トレーニングされた Kinetics-400 データセットよりも高い精度 (68.7) を達成できます。% 対 68.5%)。この発見は、ビデオの自己教師あり事前トレーニング中にドメインの違いが注意を払うもう 1 つの重要な要素であることを意味します。事前トレーニング データセットとターゲット データセットの間にドメインの違いがある場合、事前トレーニング データの品質がより重要になります。データ量よりも。同時に、この発見は、VideoMAE がビデオ自己教師あり事前トレーニング用のデータ効率の高い学習器であることを間接的に検証します。 Something-Something V2 データセットの実験結果 #Kinetics-400 データセットの実験結果 UCF101 および HMDB51 データセットの実験結果

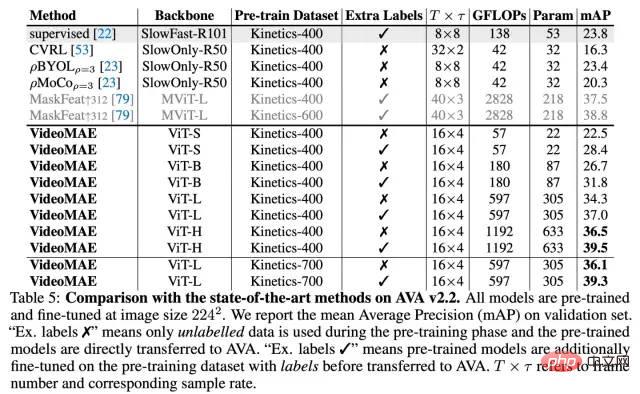

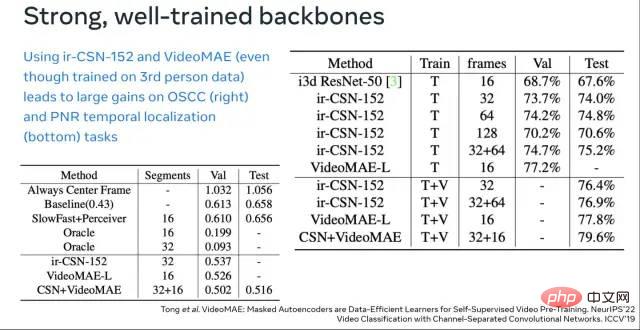

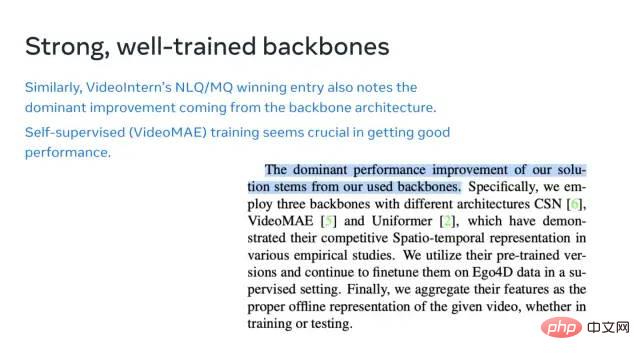

AVA v2.2 データセットの実験結果 従来のアクション分類タスクに加えて、ビデオ アクション検出のより高度な理解タスクにおける VideoMAE モデルの表現能力をさらに検証しました。実験には AVA v2.2 データセットを選択しました。実験では、Kinetics-400 データセットで事前トレーニングされたモデルが最初にロードされ、次に ViT が教師ありの方法で微調整されます。表から、VideoMAE によって事前トレーニングされた ViT モデルが AVA v2.2 データ セットで非常に良好な結果を達成できることがわかります。自己監視型の事前トレーニング済み ViT モデルを Kinetics-400 でさらに監視して微調整すると、アクション検出タスクでより良いパフォーマンスを発揮できます (3 mAP ~ 6mAP の改善)。これは、VideoMAE 自己教師あり事前トレーニング モデルのパフォーマンスが、上流のデータ セットで教師あり微調整を実行してから下流のタスクに移行することによってさらに向上できることも示しています。 今年 4 月に VideoMAE モデルとコードをオープンソース化し、コミュニティから継続的な注目と評価を得ました。 Paper with Code リストによると、VideoMAE は Something-Something V2[1] と AVA 2.2[2] でトップの座を占めています。半年(2022年3月末から現在まで)外部データを一切利用しない場合、Kinetics-400[3]、UCF101[4]、および HMDB51[5] データセットに対する VideoMAE の結果も、これまでのところ最高です。 https://huggingface.co/docs/transformers/main/en/model_doc/videomae #数か月前、VideoMAE のモデルが Hugging Face の Transformers 公式リポジトリに追加されました。これは、リポジトリに含まれる最初のビデオ理解モデルでした。それはある程度、私たちの仕事に対するコミュニティの認識も反映しています。私たちの研究が、Transformer ベースのビデオ事前トレーニングのためのシンプルで効率的なベースライン手法を提供し、その後の Transformer ベースのビデオ理解手法にインスピレーションを与えることを願っています。 https://github.com/open-mmlab/mmaction2/tree/dev-1.x/configs/recognition/videomae 現在のビデオ理解ウェアハウス MMAction2 は、VideoMAE モデルの推論もサポートしています。 終了したばかりの ECCV 2022 の第 2 回国際 Ego4D ワークショップでは、VideoMAE はすぐに誰もがゲームをプレイするのに役立つツールになりました。上海人工知能研究所は、この Ego4D チャレンジの複数のサブトラックで優勝しました。その中でも、VideoMAE は重要なバックボーンとして機能し、ソリューションに強力なビデオ機能を提供します。上の最初の図から、Kinetics-400 でのみ事前トレーニングされた VideoMAE (ViT-L) の効果が、IG-65M ビデオ データ セット (およそ Kinetics-400) の効果をすでに超えていることがわかることは注目に値します。事前トレーニングされた ir-CSN-152 でサンプル データを 300 回)。これは、VideoMAE 事前トレーニング済みモデルの強力な表現能力もさらに検証します。 私たちの仕事の主な貢献には、次の 3 つの側面が含まれます。 • 私たちは最初に提案しました。 VideoMAE、ViT マスキングと再構築に基づくビデオ自己監視型事前トレーニング フレームワーク。小規模なビデオ データ セットに対する自己教師ありの事前トレーニングでも、VideoMAE は依然として優れたパフォーマンスを達成できます。時間的冗長性と時間的相関によって引き起こされる「情報漏洩」問題を解決するために、我々は非常に高いマスキング率を持つチューブマスキングを提案します。実験によれば、この設計が VideoMAE の SOTA 効果を実現する究極の能力の鍵となります。同時に、VideoMAE の非対称エンコーダ/デコーダ アーキテクチャにより、事前トレーニング プロセスの計算消費量が大幅に削減され、事前トレーニング プロセスの時間が大幅に節約されます。 • VideoMAE は、自然かつ価値のある方法で、NLP と画像分野の経験をビデオ理解の分野に拡張することに成功し、マスキングと再構成に基づく単純なプロキシ タスクがビデオの自己教師付き事前トレーニングを提供できることを検証しました。 . シンプルですが非常に効果的な解決策です。 VideoMAE を使用した自己教師あり事前トレーニング後の ViT モデルのパフォーマンスは、ビデオ理解の分野の下流タスク (アクション認識、アクション検出など) でスクラッチからトレーニングしたり、対照的な学習方法を使用したりするよりも大幅に優れています。 • この実験では、NLP と画像理解に関するこれまでの研究では見落とされていた可能性のある 2 つの興味深い発見がありました。 (1) VideoMAE はデータ効率の高い学習器です。約 3,000 個のビデオしか含まれていないビデオ データ セット HMDB51 上でも、VideoMAE は自己教師ありの事前トレーニングを完了することができ、下流の分類タスクで他の方法をはるかに上回る結果を達成できます。 (2) ビデオの自己教師あり事前トレーニングの場合、事前トレーニング データ セットと下流のタスク データ セットの間に明らかなドメイン ギャップがある場合、ビデオ データの量よりも品質が重要になる可能性があります。 タイミング ダウンサンプリング

ピクセルが含まれます。特定の実験設定では、Kinetics-400 データセットと Something-Something V2 データセットのサンプリング間隔はそれぞれ 4 と 2 に設定されます。

ピクセルが含まれます。特定の実験設定では、Kinetics-400 データセットと Something-Something V2 データセットのサンプリング間隔はそれぞれ 4 と 2 に設定されます。 空間的および時間的ブロックの埋め込み

のビデオ クリップ内のサイズ

のビデオ クリップ内のサイズ  の視覚ピクセルは、1 つの視覚ピクセル ブロックとみなされます。したがって、

の視覚ピクセルは、1 つの視覚ピクセル ブロックとみなされます。したがって、 視覚ピクセル ブロックは、時空間ブロック埋め込み (キューブ埋め込み) レイヤーを通過した後、サンプリングされたビデオ クリップから取得できます。このプロセスでは、視覚ピクセル ブロックのチャネル次元もマッピングされます。この設計により、入力データの時空間次元サイズを削減でき、また、ビデオデータの時空間冗長性をある程度軽減することができます。

視覚ピクセル ブロックは、時空間ブロック埋め込み (キューブ埋め込み) レイヤーを通過した後、サンプリングされたビデオ クリップから取得できます。このプロセスでは、視覚ピクセル ブロックのチャネル次元もマッピングされます。この設計により、入力データの時空間次元サイズを削減でき、また、ビデオデータの時空間冗長性をある程度軽減することができます。 極めて高いマスキング率を実現するパイプラインマスキング戦略

時空共同セルフアテンション メカニズム

レベルの計算複雑さは、ネットワークの計算ボトルネックです。前の記事では、VideoMAE に非常に高いマスク率戦略が使用されましたが、これはマスクされていないトークン (10% など) がエンコーダーに入力されます。この設計により、

レベルの計算複雑さは、ネットワークの計算ボトルネックです。前の記事では、VideoMAE に非常に高いマスク率戦略が使用されましたが、これはマスクされていないトークン (10% など) がエンコーダーに入力されます。この設計により、 レベルの計算の複雑さの問題をある程度まで効果的に軽減できます。

レベルの計算の複雑さの問題をある程度まで効果的に軽減できます。

軽量デコーダは Vid

eマスク戦略

再構成ターゲット

事前トレーニング戦略

事前トレーニング データ セット

事前トレーニング ラウンド

VideoMAE の重要な機能

VideoMAE はデータ効率の高い学習者です

##VideoMAE におけるマスキング率の影響

VideoMAE および MoCov3 のパフォーマンス小規模なデータセットでの特徴転送機能の比較

コミュニティへの影響

以上がVideoMAE: シンプルで効率的なビデオ自己教師付き事前トレーニングの新しいパラダイムの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

20

20

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G