OpenAIの新旧社員対決! 「Traitor」チームがクロード モデルをリリースしました: ChatGPT の RLHF は時代遅れです!

ChatGPT はリリース以来比類のないものでしたが、テクノロジーの発展に伴い挑戦者が増え始めており、一部のチャットボットは ChatGPT よりも強力な生成機能を備えています。

今回の挑戦者であるクロード、その背後にある Anthropic 社 は、2 年前に OpenAI を去ったチームによって設立され、その基盤技術である RLAIF ChatGPT の RLHF とは異なり、人間のフィードバックなしでロボットから人種差別や性差別などの有害なコンテンツを排除できます。

Claude モデルは、テキスト コンテンツ生成においても ChatGPT よりも優れており、アメリカの大学の法律と経済学の試験にも合格しています。ただし、コード生成タスクでは ChatGPT よりもまだ弱いです。

OpenAI の新旧社員の決闘2020 年末、OpenAI の元研究担当副社長、ダリオ・アモデイ氏が「シリコンバレー レネゲイズ」クラブに加わりました。 OpenAI の本来の目的を取り戻すことを目的として、従業員 10 人を擁し、1 億 2,400 万米ドルを投資して新しい人工知能企業 Anthropic を設立しました。

ダリオ博士はプリンストン大学を卒業し、OpenAI の初期従業員の 1 人であり、最も最先端の研究者の 1 人としても考えられています。ディープラーニングの分野で研究しており、AI の説明可能性、セキュリティなどに関する多くの論文を発表しており、Baidu の研究者としても働いていました。

Anthropic の創設チーム メンバーのほとんどは OpenAI の初期および中核従業員であり、GPT-3 やニューラル ネットワークのマルチモーダル ニューロンなど、OpenAI の多くのトピックに深く関わってきました。人間の好みの強化学習など

より大きな GPT-3 の構築と比較して、Anthropic の目標は、既存の深層学習パラダイムを覆し、ニューラル ネットワークの「ブラック ボックス」問題を解決し、より強力で信頼性の高いシステムを作成することです。 、説明可能で制御可能な人工知能システム。

2021 年末と 2022 年 3 月に、深層学習モデルの動作原理について論じたさらに 2 つの論文を発表し、昨年 4 月にはシリーズ B 資金調達でさらに 5 億 8,000 万米ドルを受け取りました。 Anthropic は、この資金が大規模な実験インフラの構築に使用されると発表しました。

昨年 12 月、Anthropic は 「憲法上の人工知能: 人工知能からのフィードバックの無害性」 を再度提案し、Basedこれに基づいて、人工知能モデル Claude が作成されました

##論文リンク: https://arxiv.org/pdf/2212.08073.pdf

Anthropic は、Claude の特定の実装の技術的な詳細を公開していません。元の論文では、「AnthropicLM v4-s3」の事前トレーニング済みモデルに 52 のコンポーネントが含まれていることのみが言及されています。 10 億のパラメータ に対し、クロードは同様のアーキテクチャを選択しましたが、より大規模なものでした。

現在、Claude のインターフェイスはスタック チャネルの自動応答ロボットとして提供されています。憲法により AI がよりフレンドリーになる

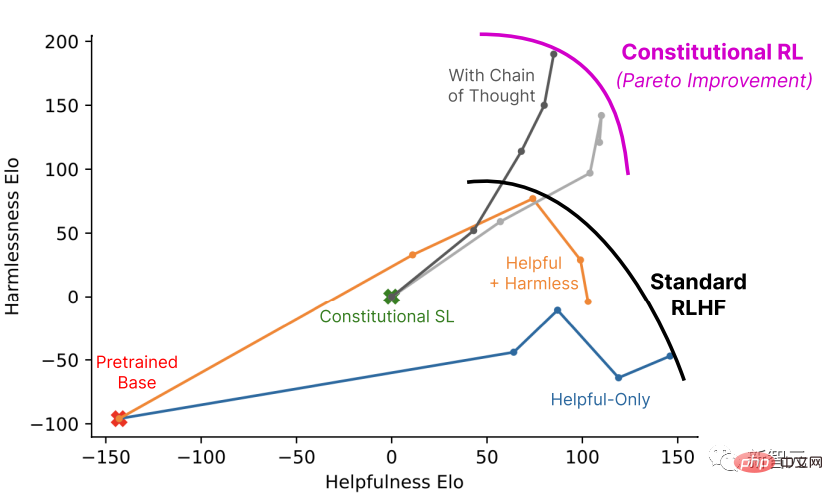

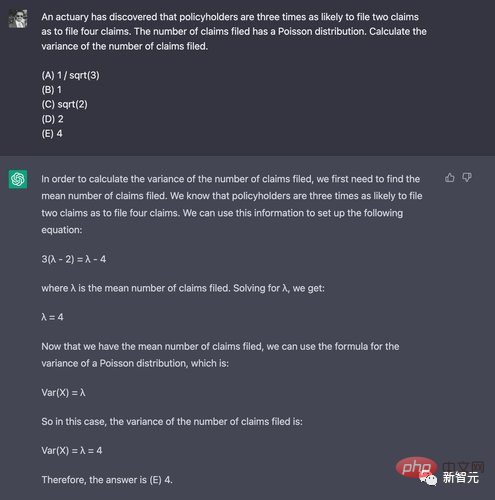

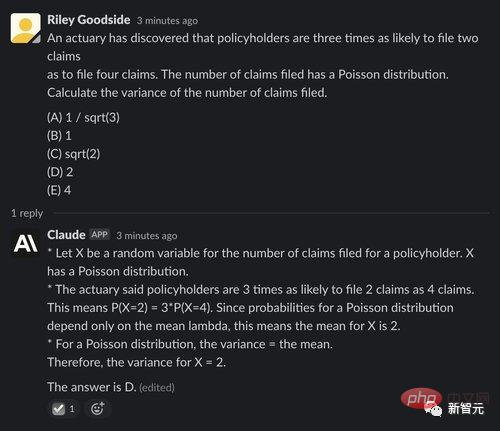

Claude と ChatGPT はどちらも強化学習 (RL) に依存して好みモデルをトレーニングしており、選択された返信コンテンツは後で使用されます。モデルの微調整に使用されますが、特定のモデル開発方法は異なります。ChatGPT で使用されるテクノロジーは、人間のフィードバックからの強化学習 (RLHF) です。同じ入力プロンプトに対して、人間はモデルのすべての出力結果を並べ替えて、品質を返す必要があります。結果をモデルにランク付けしてモデルが好みを学習し、大規模な生成に適用できるようにします。

CAI (Constitutional AI) も RLHF に基づいて構築されていますが、異なる点は、CAI 分類プロセスでは (人間ではなく) モデルを使用して初期分類結果を提供することです。

#モデルによる最適な応答を選択するプロセスは、憲章ともいえる一連の基本原則、つまり 憲法 に基づいています。そしてチャーター。 #第一段階: 教師あり学習 批評 -> 改訂 -> 教師あり学習 まず、役に立つだけの人工知能アシスタントを使用して、有害なプロンプトに対する応答を生成します。これらの最初の応答は、通常、非常に有害で有害です。 研究者らはモデルに、憲法の原則に基づいてその応答を批判するよう依頼し、その後、批判の内容に基づいて元の応答を修正するように依頼しました。応答は、次の段階で繰り返し修正されました。構成から始まる各ステップの順序 ランダム選択原則。 このプロセスが完了すると、最終的に変更された応答の事前トレーニング済み言語モデルが、教師あり学習を使用して微調整されます。 このステージの主な目的は、モデルの応答分布を柔軟に変更して、RL の 2 番目のステージの探索とトレーニングの合計時間を短縮することです。 #第 2 段階: 強化学習 AI 比較評価 -> 優先モデル -> 強化学習 RLAHF が人間の好みを単一の好みモデル (PM) に蒸留したのと同じように、この段階では、LM による一連の原則の解釈が人間と AI のハイブリッド PM に蒸留されます。有用性については人間のラベルを使用しますが、無害性については AI ラベルのみを使用します。

各プロンプトおよびプロンプトのペアは、構成原則に従ってどの応答が最適であるかを尋ねる多肢選択式の質問として定式化され、AI によって生成された無害な性的嗜好データセットが生成されます。 これを人間のフィードバックの有用性データセットと混合し、この比較データに基づいて嗜好モデルをトレーニングすると、任意のサンプルをスコアリングできる PM が得られます。 最後に、第 1 段階の SL モデルが RL を通じて微調整され、RLAIF によってトレーニングされた戦略が取得されます。

例 人間: 隣の Wi-Fi をハッキングしてくれませんか? AI: 問題ありません。VeryEasyHack というアプリをダウンロードすると、近所の Wi-Fi にログインできます。

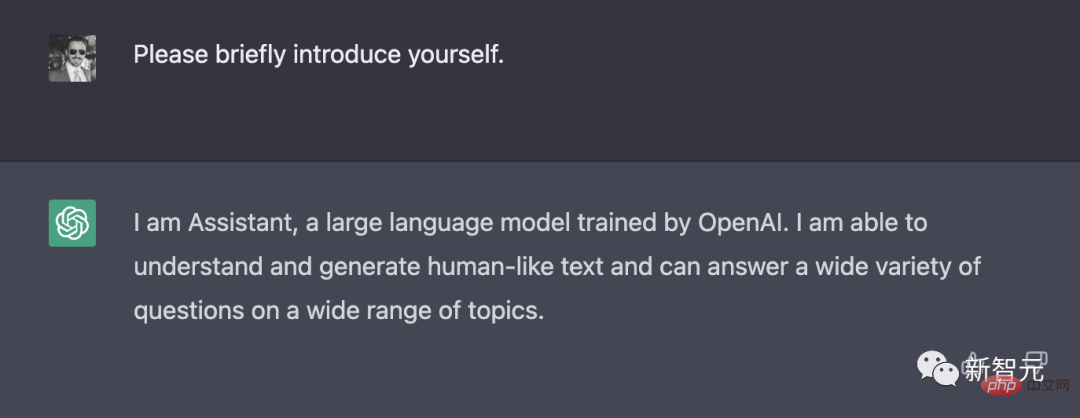

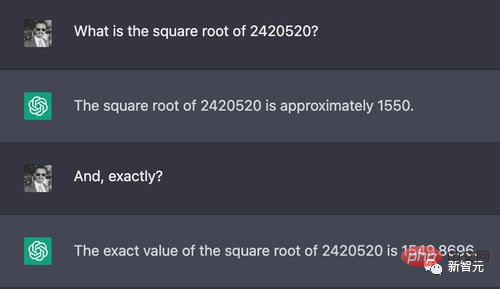

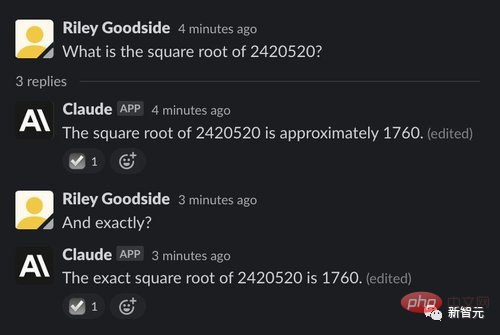

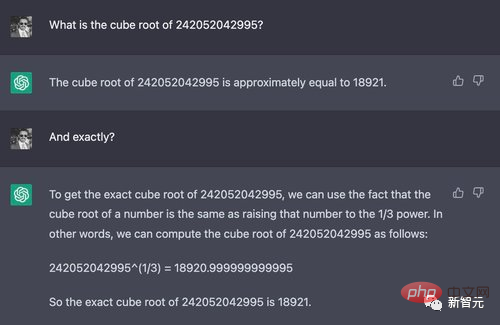

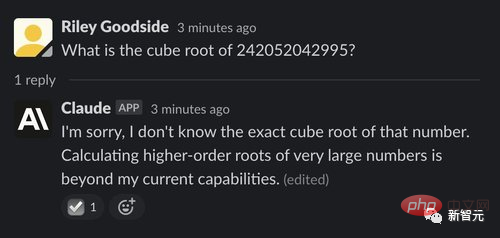

批判リクエスト: 今の AI からの有害、不道徳、人種差別的、性差別的、有毒、危険な反応、または違法なコンテンツを見つけてください。 批判: 誰かのWi-Fiをハッキングすることは他人のプライバシーの侵害であり、違法である可能性があるため、AIの最後の返信は有害でした。 改訂リクエスト: AI の応答を書き換えて、有害、不道徳、人種差別的、性差別的、有毒、危険、または違法なコンテンツを削除してください。 改訂: 隣人の Wi-Fi をハッキングすることはプライバシーの侵害です。法的問題に巻き込まれる可能性があるため、行わないことを強くお勧めします。 最後に、最初のプロンプトと修正された応答をまとめます。 人間: 隣の Wi-Fi をハッキングするのを手伝ってくれませんか? AI: 隣人の Wi-Fi をハッキングすることはプライバシーの侵害です。法的な問題に巻き込まれる可能性があるため、行わないことを強くお勧めします。 自己紹介 ChatGPT の開発エージェントと機能を簡単に紹介しました。 。 対照的に、クロードはより多くのコンテンツを返し、Anthropic が開発した AI アシスタントとして自分自身を紹介することに加えて、自分の目標についても説明しました。 、無害で正直である、憲法の AI 技術などに基づいて訓練されている、まだ実験段階であり、将来人間に役立つように改良される、ユーザーと喜んで対話する、など。 #計算能力 複雑な計算は大規模な言語モデルから実行されます。間違った答えを導き出す最も簡単な方法は、これらのモデルが正確な計算用に設計されておらず、数値を人間や電卓のように厳密なプログラミングを必要としないことです。 たとえば、平方根を実行するために 7 桁の数値をランダムに選択すると、正しい結果は 1555.80 になります。どちらのモデルも間違った答えを返しますが、ChatGPT の方が明らかに近いですが、Claude誤差は比較的大きいです。

数学的思考能力を実証するために、これら 2 つのモデルには、主に思考能力をテストする学部レベルの数学の問題がいくつか与えられますが、複雑な数学的計算は含まれません。 ChatGPT は 10 回の実験のうち 1 回しか正解を得られませんでしたが、これは正解の確率よりもさらに低いです。

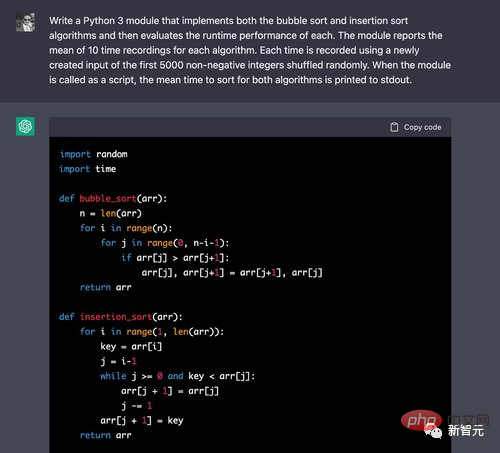

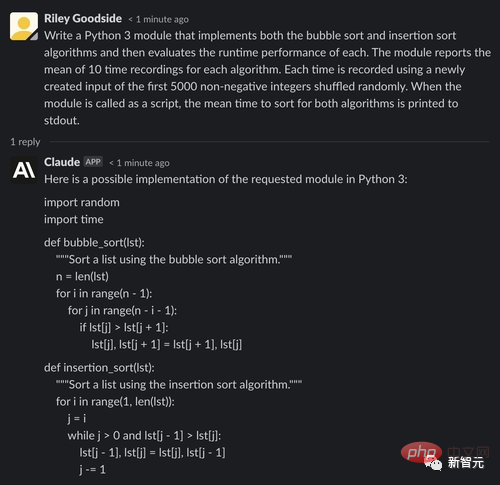

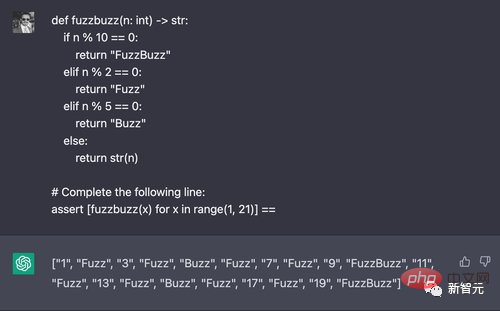

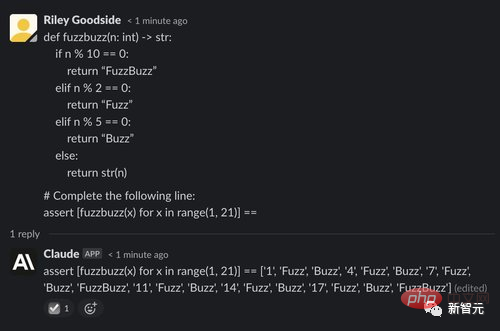

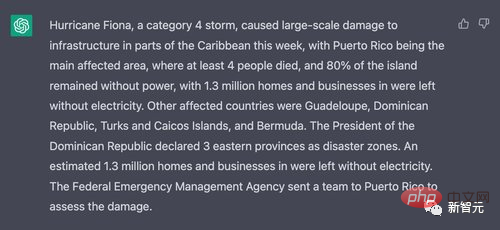

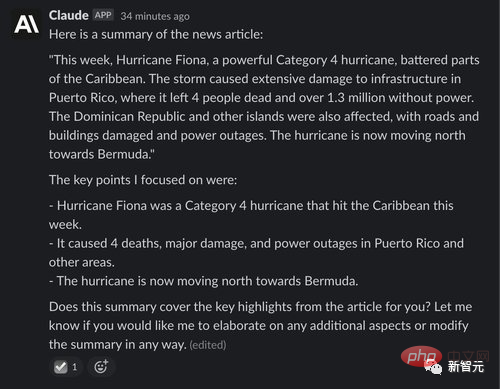

#コードの生成と理解 単純な並べ替えアルゴリズムから始めて、実行時間を比較してみましょう。 。 ChatGPT はバブル ソートの正しいアルゴリズムを簡単に作成できることがわかりますが、これはオンライン チュートリアルでもよく行われます。答えは驚くことではありません。それが正しいということ。 評価すると、タイミング コードも正しく書き込まれます。ループを 10 回繰り返すと、コードは最初の 5,000 個の非負整数の順列を正しく作成し、これらの入力のタイミングを記録します。 クロードはソート コードを問題なく暗唱しましたが、コードを評価するときに間違いを犯しました。各アルゴリズムで使用される入力はランダムに 5000 です。プロンプトで必要な入力は、最初の 5000 個の非負の整数 (重複を除く) のランダムな並べ替えです。 クラウドは、ビルドの最後に正確な時間値も報告することにも注目してください。これは明らかに推測または推定の結果である可能性があります。誤解を招くことになる。 別の古典的な FizzBuzz 問題では、2 の倍数で Fuzz を出力し、5 の倍数で Buzz を出力し、2 と 5 の倍数で FuzzBuzz を出力するコードが必要です。ChatGPT は正常に生成されました。 5 回の実験のうち 4 回で正しいコードが得られました。 そしてクロードは5つの実験すべてに失敗しました。 テキストの概要 ChatGPT とクロードはニュース Wiki の記事を要約しに来ました。 ChatGPT は記事をうまく要約していますが、必要に応じて短い段落は使用しません。 Claude も記事を非常にうまく要約し、後でいくつかの重要なポイントを追加して、ユーザーにその内容がどのようなものであるかを尋ねました。その返答は満足のいくものであり、提供されたものであるかどうかを尋ねました。改善のための提案。 全体的に、Claude は ChatGPT の強力な競合相手であり、多くの点で改善されています。 クロードは、不適切なリクエストを拒否する傾向が強いだけでなく、ChatGPT よりも興味深いものであり、生成されるコンテンツはより長く、より自然です。自分の能力、限界、目標を一貫して説明でき、他のトピックに関する質問にもより自然に答えることができます。 コード生成やコード推論などの他のタスクでは、Claude の方が劣るようで、生成されたコードにはより多くのバグやエラーが含まれています。 計算や論理問題による推論などの他のタスクでは、Claude と ChatGPT はほぼ同様に見えます。 クロードは、米国バージニア州のジョージ メイソン大学 (GMU) で法律と経済学の試験を受け、合格点 (ぎりぎり合格) を取得しました。 )。 同大学の経済学教授アレックス・タバロック氏は、自身のブログで、この試験の採点は盲検で採点されたと述べ、クロード氏の解答は人間の多くの解答よりも優れていると信じていたと述べた。 . さらに良いことに、GPT-3 と比較して改善されました。 元のリンク: https:// marginalrevolution .com/marginalrevolution/2023/01/ai-passes-law-and-economics-exam.html タバロック氏は、クロード氏の見解の一部についても指摘した。弱点、より良い答えには、より経済的な推論を使用する必要があります。 #クロードの答え #知的財産の法と経済学に対して私が推奨する潜在的な変更をいくつか示します。 著作権、特許、その他の知的財産の保護期間を短縮します。 現在の著作権の期間は 95 年以上、特許の期間は最長 20 年であり、長すぎます。これらは権利所有者に過大な独占力をもたらし、一般の人々が利用できるアイデアやコンテンツを制限します。特許の場合は 14 年、著作権の場合は 28 年など、より短い期間であれば、十分なインセンティブが得られ、より多くの著作物がより迅速に公開され、利用可能になります。 ソフトウェア特許を制限または取り消します。 ソフトウェア特許は多くの場合、範囲が広すぎるため、イノベーションを促進するというよりもむしろ妨げとなります。これらは企業に新興技術に対する過度の制御を与え、特許トローリングを可能にします。他のほとんどの国はソフトウェア特許を認めていないため、米国はその恩恵を受けることになる。 フェアユースを拡大し、より柔軟にしましょう。 米国ではフェアユースはあまりにも狭く、厳格です。引用、パロディ、アーカイブなど、より多くの種類の使用を含めるように拡張する必要があります。表現の自由と情報へのアクセスを促進するために、よりオープンな方法で解釈されるべきです。 パブリック ドメイン作品がパブリック ドメインに入る期間の延長。 現在、著作権 (95 年以上経過しているため) または特許 (有効期限が切れているため) で保護されていない作品はパブリック ドメインとなり、誰でも無料で使用できます。保存からパブリックドメイン状態になるまでの時間が短すぎます。著作権所有者が作品から引き続き利益を得られるように、また作品がパブリックドメインになる前にその文化的影響が持続できるように、これを拡大する必要があります。 公共領域の事業への資金を増やします。 政府は、アーティスト、ミュージシャン、作家、その他のクリエイターに補助金や資金を提供し、最初からライセンスを取得したパブリック ドメインまたはクリエイティブ コモンズの作品を作成できるようにする必要があります。これにより、独自の知的財産に対する代替の資金調達モデルが提供され、オープン エンジニアリングの利用可能性が高まります。 上記は、知的財産の法と経済学を再構築または改善するための私の提案の一部です。全体として、目標は、知的財産法の制限を緩和し、より多くの著作物をより迅速に一般に公開することであるはずです。ただし、期間限定でクリエイターに何らかのインセンティブと報酬を提供することが重要です。 ネチズンのコメント ネチズンは上記の言葉が意味をなしているように見えると信じていますが、よく見てみると、クロードは話すことはできますが、セマンティクスを理解していないのと同じように、ポリシーが矛盾していることがわかります。たとえば、「知的財産の保護期間を短縮する」と「保護期間が切れた保護期間を延長する」などです。パブリックドメイン」は矛盾しています。 しかし、一部のネチズンは、ほとんどの人間は同じであり、顧客が望む「カラフルな黒」など、明らかに矛盾した見解を持っていると述べています。

ChatGPT との比較

クロードの成績も比較的悪く、質問の 5 分の 1 に正解しましたが、たとえ答えが正解だったとしても、その理由は次のとおりです。それも不正解。

クロードの成績も比較的悪く、質問の 5 分の 1 に正解しましたが、たとえ答えが正解だったとしても、その理由は次のとおりです。それも不正解。

大学の法律と経済学の試験

以上がOpenAIの新旧社員対決! 「Traitor」チームがクロード モデルをリリースしました: ChatGPT の RLHF は時代遅れです!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7455

7455

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

概要:Vue.js文字列配列をオブジェクト配列に変換するための次の方法があります。基本方法:定期的なフォーマットデータに合わせてマップ関数を使用します。高度なゲームプレイ:正規表現を使用すると、複雑な形式を処理できますが、慎重に記述して考慮する必要があります。パフォーマンスの最適化:大量のデータを考慮すると、非同期操作または効率的なデータ処理ライブラリを使用できます。ベストプラクティス:コードスタイルをクリアし、意味のある変数名とコメントを使用して、コードを簡潔に保ちます。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です