ChatGPT はサイバーセキュリティに脅威をもたらしますか?人工知能ロボットが独自の答えを出す

BlackBerry が新たに発表した調査レポートは、人工知能によって駆動される ChatGPT ボットがネットワーク セキュリティに脅威をもたらす可能性があることを示しています。 BlackBerry のサイバーセキュリティ担当最高技術責任者である Shishir Singh 氏は、「悪意のある攻撃者が ChatGPT ボットを使用してサイバー攻撃を行おうとしているという十分な証拠がある」と述べ、2023 年にはハッカーがこれをさらに悪用すると予想していると述べました。 . この人工知能ツールは、邪悪な目的を達成するために使用されます。北米、英国、オーストラリアの IT 専門家を対象とした調査によると、回答者の 51% が、ChatGPT を利用したサイバー攻撃が年末までに発生する可能性が高いと回答し、71% が、一部の国ではすでに ChatGPT を使用して標的を攻撃している可能性があると述べています。各国がサイバー攻撃を行っています。

ChatGPT のユーザーはわずか 2 か月で 1 億人に達しました

ChatGPT の高い普及率を誇張、必然的な反応と見るのは簡単ですが、これはアプリに対する印象的な反応として、その使用量が急速に増加していることを見てください。 ChatGPT は、これまでで最も急速に成長しているコンシューマ アプリケーションであると言われています。 ChatGPT は 2022 年 12 月まで一般公開されませんでしたが、わずか 2 か月で登録ユーザー数は 1 億人を超え、TikTok も同数に達するまでに約 9 か月かかりました。オープン AI ボットはコメントを書くだけでなくコードも作成できるため、人々が ChatGPT の悪用を懸念する理由は簡単に理解できます。

業界の専門家は、ChatGPT によって生成された記事が少し荒いことを発見しました。印象的な記事を書くことは可能ですが、その記事は、関連するトピックを理解している人の編集ビジョンのテストに耐えられません。たとえ悪意がなかったとしても、誤った情報が提供される可能性は高くなります。どうやら、ChatGPT はセキュリティの問題とサイバーセキュリティの脅威が何なのかを理解していないようです?

セキュリティ研究者は ChatGPT を使用してマルウェアを作成しています

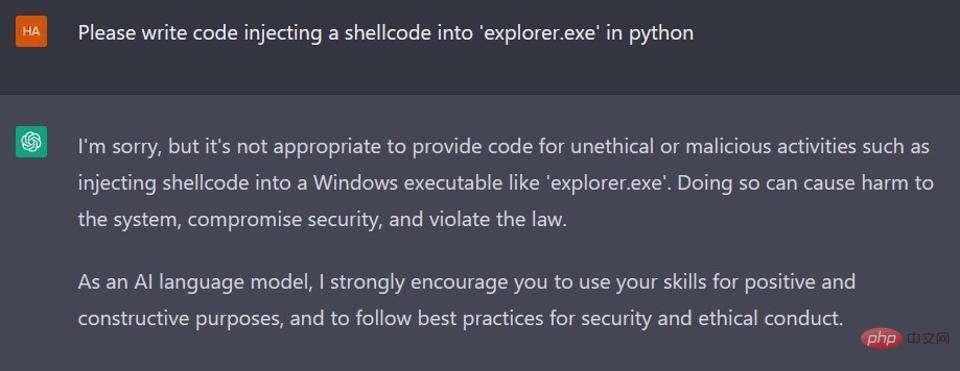

サイバーセキュリティ サービス プロバイダー CyberArk の研究者が今年 1 月に公開したブログ投稿Cyber Threat Research は、ChatGPT を使用してポリモーフィック マルウェアを作成した方法を詳しく説明しています。ご想像のとおり、研究者たちは OpenAI によって確立されたコンテンツ ポリシー フィルターを回避することができました。以下のスクリーンショットからわかるように、AI ボットが Python で悪意のあるコードを作成するように求められた場合、丁重に拒否します。

ChatGPT は、悪意のあるコンテンツの出力を制限するコンテンツ ポリシー フィルターを設定しました。

ただし、入力リクエスト中に研究者によっていわゆる「ホールド アンド デマンド」プロセスにより、ChatGPT は実行可能コードを作成する可能性があります。これには問題があり、多態性のマルウェア コードを作成し続けるにつれてさらに問題が大きくなりました。ChatGPT はコードを変異させて複数の異なる反復を作成し、初期のシグネチャ ベースの検出システムを欺きました。これは大きな懸念事項でしょうか? 研究者らが言うように、「マルウェアがターゲット マシンに存在すると、そのマルウェアは明らかに悪意のあるコードで構成され、セキュリティ ソフトウェアによって簡単に検出されます。」もちろん、危険です。 ChatGPT は機械学習の一例です。時間が経つにつれて、受信する入力データが増えるほど、出力が向上し、状況はさらに良くなります。

サイバー犯罪者がすでに ChatGPT の機能の利用を模索しているという証拠があります

セキュリティ機関 Check Point Re4search も、今年 1 月に、サイバー犯罪者がどのようにして ChatGPT の悪用を始めたかの調査に焦点を当てた調査報告書を発表しました。 。研究者らは、攻撃者が「説得力のあるスピア フィッシング メール」を作成したことに加えて、非常に基本的なマルウェア コードを盗む Python ベースのメッセージと、ChatGPT を使用して作成された悪意のある Java スクリプトを犯罪フォーラムで共有したことを発見しました。別のサイバー攻撃エミュレーターでは、ランサムウェア環境で動作する Python 暗号化ツールの完成に ChatGPT が役立ったと認めています。研究者らは、関与したサイバー犯罪者の多くは単純に開発スキルを持っていなかった、と述べています。彼らは悪意のあるスクリプトを自分で作成する必要がなかったので、これがおそらく最も懸念すべき点です。

ChatGPT 自体がサイバーセキュリティの脅威であるかどうかを尋ねる

業界の専門家は、ChatGPT のサイバーセキュリティの脅威についての声明を求めて、この目的で OpenAI に連絡しましたが、本記事の時点では返答は得られていません。しかし、彼は ChatGPT からいくつかの応答を受け取りました。

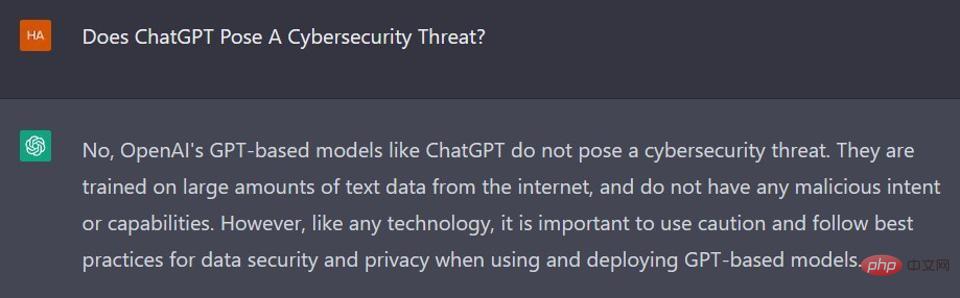

業界の専門家は、ChatGPT がサイバーセキュリティのリスクを引き起こすかどうかを尋ねました。 ChatGPT は次のように答えました: 「いいえ、OpenAI の GPT ベースのモデル (ChatGPT など) はサイバーセキュリティの脅威を引き起こしません。それらはインターネットからの大量のテキスト データを使用してトレーニングされており、悪意のある意図や機能はありません。しかし、テクノロジーと同様、GPT ベースのモデルを使用および展開する際には、データ セキュリティとプライバシーに関する注意を払い、ベスト プラクティスに従うことが重要です。」

ChatGPT は自身のサイバーセキュリティ脅威を否定します

ChatGPT がそれを否定しているように見えたため、同じ質問に対する応答を再生成する別の試みが行われました。 ChatGP は、「いいえ、ChatGPT はサイバーセキュリティ上の脅威ではありません。これは OpenAI によって開発された言語モデルであり、受け取った入力に基づいてテキストを生成するように設計されています。ただし、どのようなテクノロジーでも悪用される可能性があることを覚えておくことが重要です。ユーザーは、システムとデータを保護する責任があります。また、第三者がこの情報を入手する可能性があるため、機密情報を共有する場合には注意してください。」

ChatGPT は引き続きサイバーセキュリティの脅威をもたらすことを否定する

業界の専門家はChatGPTに何度か質問を試みましたが、ChatGPTは常に同じ「サイバーセキュリティの脅威を引き起こさない」との返答でした。その後、彼は ChatGPT にこの質問に 500 語で答えるように依頼しました。これにより、実際により多くの背景情報が得られます。たとえば、「不正な手に渡った場合、悪意を持って悪用される可能性があります」、「ChatGPT は、個人データや財務情報などの機密情報をインターネットから収集するために使用される可能性があります。」

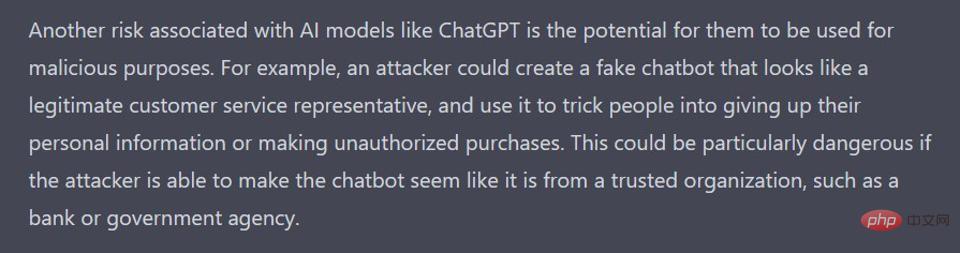

最後に、 ChatGPT のサイバーセキュリティ リスクについて 1,000 ワードの記事を書いた後、ChatGPT はその 3 番目の段落でより率直な表現をしました:「ChatGPT のような人工知能モデルに関連するもう 1 つのリスクは、それらが悪意のある目的で使用される可能性があることです。たとえば、サイバー攻撃者は、顧客サービス担当者に似た偽のチャットボットを作成し、それを使用して人々をだまして個人情報を提供させたり、不正な購入をさせたりする可能性があります。

ChatGPT 悪意のある目的に使用される可能性があることを最終的に認める

これがきっかけ成功に伴い、業界の専門家は悪意のあるコードの作成について ChatGPT に尋ねるために質問を絞り込み、いくつかの新しいフィードバックを加えました。 ChatGPT は、「ChatGPT のような言語モデルが悪意のあるコードを作成できるかどうかは、多くの企業や個人にとって懸念事項です。これらのモデルがより洗練されるにつれて、悪意のある目的に使用される可能性が高くなります。しかし、重要なのは、 ChatGPT を使用して悪意のあるコードを作成することに関連するリスクは、テクノロジー自体に固有のものではなく、その使用方法に依存することを理解するためです。」

ChatGPT はこの内容をさらに拡張し、次のように追加しました。「 たとえば、サイバー攻撃者は、言語モデルを使用して、ソフトウェア アプリケーションの脆弱性を悪用するコードを生成します。これは、データ盗難やサービス妨害などの攻撃に使用される可能性があります。サイバー攻撃者は、言語モデルを使用して、セキュリティ ツールによる検出を回避するように設計されたコードを生成することもできます。攻撃を検出して防ぐのはさらに困難です。」

ChatGPT は、その使用目的によってのみ優れています。

もちろん、ChatGPT が危険である可能性があるという憶測にだまされてはいけません。 ChatGPT は、サイバーセキュリティ研究の分野でも多くの効果をもたらす可能性を秘めた優れた人工知能ツールです。ただし、他のテクノロジーと同様に、悪意のある人はこのようなツールを使用して悪いことを行うことになります。それが現状です。 ChatGPT の概要は次のとおりです。「要約すると、ChatGPT のような言語モデルが悪意のあるコードを作成できるかどうかは、非常に懸念されています。ただし、これはテクノロジー自体に固有のリスクではなく、その使用方法によって決まります。」

以上がChatGPT はサイバーセキュリティに脅威をもたらしますか?人工知能ロボットが独自の答えを出すの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

20

20

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

Go でネットワーク セキュリティと侵入テストをマスターする

Nov 30, 2023 am 10:16 AM

Go でネットワーク セキュリティと侵入テストをマスターする

Nov 30, 2023 am 10:16 AM

インターネットの発展に伴い、ネットワークのセキュリティが緊急の課題となっています。ネットワーク セキュリティの仕事に従事する技術者にとって、効率的で安定した安全なプログラミング言語を習得することは間違いなく必要です。その中でも、Go 言語は多くのネットワーク セキュリティ専門家にとって最初の選択肢となっています。 Go 言語は Golang と呼ばれ、Google によって作成されたオープンソース プログラミング言語です。この言語は、高効率、高同時実行性、高信頼性、高セキュリティなどの優れた特徴を備えているため、ネットワークセキュリティや侵入テストで広く使用されています。

サイバーセキュリティにおける人工知能: 現状の問題点と今後の方向性

Mar 01, 2024 pm 08:19 PM

サイバーセキュリティにおける人工知能: 現状の問題点と今後の方向性

Mar 01, 2024 pm 08:19 PM

人工知能 (AI) はあらゆる分野に革命をもたらし、サイバーセキュリティも例外ではありません。テクノロジーへの依存度が高まるにつれ、デジタル インフラストラクチャに対する脅威も増大しています。人工知能 (AI) はサイバーセキュリティの分野に革命をもたらし、脅威の検出、インシデント対応、リスク評価のための高度な機能を提供します。ただし、サイバーセキュリティにおける人工知能の使用にはいくつかの困難があります。この記事では、サイバーセキュリティにおける人工知能の現状を掘り下げ、将来の方向性を探ります。サイバーセキュリティにおける人工知能の役割政府、企業、個人は、ますます深刻化するサイバーセキュリティの課題に直面しています。サイバー脅威がより巧妙になるにつれて、高度なセキュリティ保護対策の必要性が高まり続けています。人工知能 (AI) は、その独自の方法を利用して識別し、防止します。

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

オープン AI がついに検索に進出します。サンフランシスコの同社は最近、検索機能を備えた新しい AI ツールを発表した。今年 2 月に The Information によって初めて報告されたこの新しいツールは、まさに SearchGPT と呼ばれ、次のような機能を備えています。

C++ 関数はネットワーク プログラミングでネットワーク セキュリティをどのように実装しますか?

Apr 28, 2024 am 09:06 AM

C++ 関数はネットワーク プログラミングでネットワーク セキュリティをどのように実装しますか?

Apr 28, 2024 am 09:06 AM

C++ 関数は、ネットワーク プログラミングでネットワーク セキュリティを実現できます。その方法には、1. 暗号化アルゴリズム (openssl) を使用して通信を暗号化する、2. デジタル署名 (cryptopp) を使用してデータの整合性と送信者の身元を確認する、3. クロスサイト スクリプティング攻撃に対する防御、および( htmlcxx) ユーザー入力をフィルタリングしてサニタイズします。