ストレージと伝送効率を向上させるにはどうすればよいですか?パラメータを集中的に使用するマスク ネットワークは大きな効果を発揮します

近年、より複雑なタスクを処理するためにニューラルネットワークの大規模化が進んでおり、ニューラルネットワークをいかに効率的に記憶・伝送するかが非常に重要となっています。一方で、最近、宝くじ仮説 (LTH) の提案により、ランダム スパース ニューラル ネットワークが大きな可能性を示しており、この可能性を利用してネットワークの保存効率や伝送効率を向上させる方法も検討する価値があります。

ノースイースタン大学とロチェスター工科大学の研究者は、パラメーター効率の高いマスキング ネットワーク (PEMN) を提案しました。著者らはまず、限られた数の乱数によって生成されるランダム ネットワークの表現能力を調査します。実験によれば、ネットワークが限られた数の乱数から生成された場合でも、異なるサブネットワーク構造を選択することで優れた表現能力を維持できることがわかりました。

この探索的な実験を通じて、著者は必然的に、限られた数の乱数をプロトタイプとして使用し、一連のマスクと組み合わせてニューラル ネットワークを表現することを提案しました。限られた数の乱数とバイナリ マスクが占有するストレージ スペースはごくわずかであるため、著者はこれを使用してネットワーク圧縮の新しいアイデアを提案します。この論文は NeurIPS 2022 に採択されました。コードはオープンソース化されています。

- 文書アドレス: https://arxiv.org/abs/2210.06699

- ペーパーコード: https://github.com/yueb17/PEMN

2. 研究の動機/プロセス

上記の関連研究では、トレーニング可能性やユーザビリティなど、さまざまな角度からランダム スパース ネットワークの可能性を調査しました。表現力についても理解できます。この研究において、著者らは、乱数から生成されたニューラル ネットワークが重みをトレーニングせずにどの程度うまく表現できるかに興味を持っています。この問題の調査に続いて、著者らはパラメータ効率の高いマスキング ネットワーク (PEMN) を提案しました。当然のことながら、著者は PEMN を使用してネットワーク圧縮の新しいアイデアを提供し、PEMN の潜在的なアプリケーション シナリオを探索するための例として機能します。3. 乱数で構成されるニューラル ネットワークの表現能力を探索する

ランダム ネットワークが与えられた場合、著者はエッジ ポップアップ アルゴリズムを選択して、そのネットワークを探索するサブネットワークを選択します。表現力。違いは、ネットワーク全体をランダムに初期化する代わりに、プロトタイプを使用してランダム ネットワークを構築するための 3 つのパラメータ集約型ネットワーク生成戦略を著者が提案していることです。

- 1 層: ネットワーク内の繰り返し構造の重みをプロトタイプとして選択し、同じ構造を持つ他のネットワーク層を埋めます。

- 最大層パディング (MP): 最大数のパラメーターを持つネットワーク層をプロトタイプとして選択し、対応するパラメーターの量を切り詰めて他のネットワーク層を埋めます。

- ランダム ベクトル パディング (RP): 特定の長さのランダム ベクトルをプロトタイプとして選択し、それをコピーしてネットワーク全体に埋めます。

上図は、ConvMixer と ViT ネットワークを使用した CIFAR10 画像分類の実験結果を示しています。 Y 軸は精度、X 軸はさまざまな戦略を使用して取得されたランダム ネットワークです。として

実験結果によると、ランダム ネットワークに非常に限られた数の非反復乱数 (PR_1e-3 など) しか含まれていない場合でも、依然としてネットワークを維持できることがわかりました。選択したサブネットワークの表現。これまでのところ、著者はさまざまなランダム ネットワーク生成戦略を通じて、限られた数の乱数で構成されるニューラル ネットワークの表現能力を調査し、非反復乱数が非常に限られている場合でも、対応するランダム ネットワークは依然として表現できることを観察しました。データもしっかり。

同時に、これらのランダム ネットワーク生成戦略に基づいて、得られたサブネットワーク マスクと組み合わせて、著者は、パラメーター効率的マスキング ネットワーク (PEMN) と呼ばれる新しいニューラル ネットワーク タイプを提案しました。

4. 新しいネットワーク圧縮のアイデア

この記事では、PEMN の潜在的なアプリケーションを拡張する例としてニューラル ネットワーク圧縮を選択します。具体的には、この記事で提案するさまざまなランダム ネットワーク生成戦略では、プロトタイプを効率的に使用して、完全なランダム ネットワーク、特に最も粒度の細かいランダム ベクトル パディング (RP) 戦略を表現できます。

著者は、RP 戦略でランダム ベクトル プロトタイプと、対応するサブネット マスクのセットを使用して、ランダム ネットワークを表します。プロトタイプは浮動小数点形式で保存する必要がありますが、マスクはバイナリ形式でのみ保存する必要があります。 RP のプロトタイプの長さは非常に短くできるため (限られた数の非反復乱数には依然として強力な表現能力があるため)、ニューラル ネットワークを表現するオーバーヘッドは非常に小さくなります。つまり、浮動小数点数形式を次のように格納します。制限された長さ ランダムなベクトルとバイナリ形式のマスクのセット。サブネットワークの浮動小数点値を保存する従来のスパースネットワークと比較して、この論文はニューラルネットワークを効率的に保存および送信するための新しいネットワーク圧縮のアイデアを提案します。

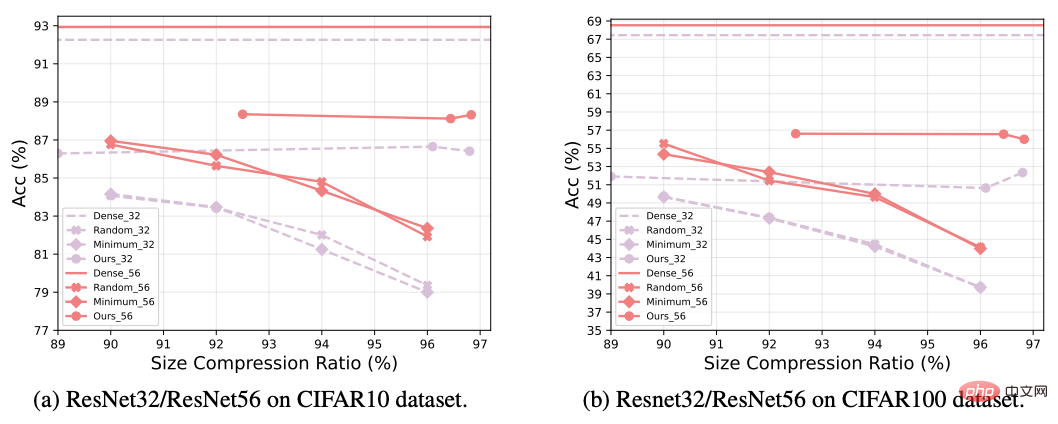

上の図では、著者は PEMN を使用してネットワークを圧縮し、従来のネットワーク プルーニング手法と比較しています。この実験では、ResNet ネットワークを使用して、CIFAR データ セットに対して画像分類タスクを実行します。一般に、新しい圧縮スキームは従来のネットワーク プルーニングよりも優れたパフォーマンスを示し、特に非常に高い圧縮率でも、PEMN は良好な精度を維持できることがわかりました。

5. 結論

最近ランダム ネットワークによって実証された可能性に触発されて、この論文では、ランダム ニューラル ネットワークを構築するためのさまざまなパラメーター集中戦略を提案し、次の問題を検討します。乱数を繰り返さずに生成されたランダム ニューラル ネットワークの表現可能性は限られており、パラメーター効率の良いマスキング ネットワーク (PEMN) が提案されています。著者は、PEMN をネットワーク圧縮シナリオに適用して、実際のアプリケーションでの可能性を探り、ネットワーク圧縮の新しいアイデアを提供します。著者らは、ランダム ネットワーク内に非常に限られた数の非反復乱数しか存在しない場合でも、サブネットワークの選択を通じて優れた表現能力を備えていることを示す広範な実験を提供しています。さらに、従来のプルーニング アルゴリズムと比較して、新しく提案された方法がより優れたネットワーク圧縮効果を達成できることを実験で示し、このシナリオにおける PEMN の応用可能性を検証しています。

以上がストレージと伝送効率を向上させるにはどうすればよいですか?パラメータを集中的に使用するマスク ネットワークは大きな効果を発揮しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7715

7715

15

15

1641

1641

14

14

1395

1395

52

52

1289

1289

25

25

1232

1232

29

29

ファーウェイは革新的なMEDストレージ製品を来年発売予定:ラック容量は10PBを超え、消費電力は2kW未満

Mar 07, 2024 pm 10:43 PM

ファーウェイは革新的なMEDストレージ製品を来年発売予定:ラック容量は10PBを超え、消費電力は2kW未満

Mar 07, 2024 pm 10:43 PM

このウェブサイトは3月7日、ファーウェイのデータストレージ製品ラインの社長である周岳峰博士が最近MWC2024カンファレンスに出席し、特にウォームデータ(WarmData)とコールドデータ(ColdData)用に設計された新世代のOceanStorArctic磁電ストレージソリューションをデモンストレーションしたと報じた。ファーウェイのデータストレージ製品ラインの社長である周岳峰氏は、一連の革新的なソリューションをリリースした 画像出典: このサイトに添付されているファーウェイの公式プレスリリースは次のとおりです: このソリューションのコストは磁気テープのコストより 20% 低く、そのコストは磁気テープのコストよりも 20% 低くなります。消費電力はハードディスクよりも90%低いです。外国のテクノロジーメディアのblocksandfilesによると、ファーウェイの広報担当者も磁気電子ストレージソリューションに関する情報を明らかにした:ファーウェイの磁気電子ディスク(MED)は磁気ストレージメディアの主要な革新である。初代ME

Vue3+TS+Vite 開発スキル: データを暗号化して保存する方法

Sep 10, 2023 pm 04:51 PM

Vue3+TS+Vite 開発スキル: データを暗号化して保存する方法

Sep 10, 2023 pm 04:51 PM

Vue3+TS+Vite 開発のヒント: データを暗号化して保存する方法 インターネット技術の急速な発展に伴い、データ セキュリティとプライバシー保護がますます重要になっています。 Vue3+TS+Vite 開発環境では、データをどのように暗号化して保存するかが、すべての開発者が直面する必要がある問題です。この記事では、開発者がアプリケーションのセキュリティとユーザー エクスペリエンスを向上させるのに役立つ、一般的なデータ暗号化とストレージのテクニックをいくつか紹介します。 1. データ暗号化 フロントエンド データ暗号化 フロントエンド暗号化は、データ セキュリティを保護するための重要な部分です。よく使われる

Windows 11 でキャッシュをクリアする方法: 画像付きの詳細なチュートリアル

Apr 24, 2023 pm 09:37 PM

Windows 11 でキャッシュをクリアする方法: 画像付きの詳細なチュートリアル

Apr 24, 2023 pm 09:37 PM

キャッシュとは何ですか?キャッシュ (カシェイと発音) は、頻繁に要求されるデータや命令を保存するために使用される特殊な高速ハードウェアまたはソフトウェア コンポーネントであり、Web サイト、アプリケーション、サービス、およびシステムのその他の側面をより高速に読み込むために使用できます。 。キャッシュにより、最も頻繁にアクセスされるデータがすぐに利用できるようになります。キャッシュ ファイルはキャッシュ メモリとは異なります。キャッシュ ファイルとは、複数のプログラムで必要になる可能性がある、PNG、アイコン、ロゴ、シェーダーなどの頻繁に必要なファイルを指します。これらのファイルは物理ドライブ領域に保存され、通常は隠されています。一方、キャッシュ メモリは、メイン メモリや RAM よりも高速なメモリのタイプです。 CPUに近く、RAMに比べて高速なため、データアクセス時間が大幅に短縮されます。

Ubuntu での Git インストール プロセス

Mar 20, 2024 pm 04:51 PM

Ubuntu での Git インストール プロセス

Mar 20, 2024 pm 04:51 PM

Git は、高速で信頼性が高く、適応性に優れた分散バージョン管理システムです。分散型の非線形ワークフローをサポートするように設計されており、あらゆる規模のソフトウェア開発チームに最適です。各 Git 作業ディレクトリは、すべての変更の完全な履歴を備えた独立したリポジトリであり、ネットワーク アクセスや中央サーバーがなくてもバージョンを追跡できます。 GitHub は、分散リビジョン管理のすべての機能を提供する、クラウド上でホストされる Git リポジトリです。 GitHub は、クラウド上でホストされる Git リポジトリです。 CLI ツールである Git とは異なり、GitHub には Web ベースのグラフィカル ユーザー インターフェイスがあります。これは、他の開発者との共同作業や、スクリプトへの変更の追跡などのバージョン管理に使用されます。

PHP と swoole はどのようにして効率的なデータのキャッシュとストレージを実現するのでしょうか?

Jul 23, 2023 pm 04:03 PM

PHP と swoole はどのようにして効率的なデータのキャッシュとストレージを実現するのでしょうか?

Jul 23, 2023 pm 04:03 PM

PHP と swoole はどのようにして効率的なデータのキャッシュとストレージを実現するのでしょうか?概要: Web アプリケーション開発では、データのキャッシュとストレージは非常に重要な部分です。 PHP と swoole は、データをキャッシュして保存するための効率的な方法を提供します。この記事では、PHP と swoole を使用して効率的なデータ キャッシュとストレージを実現する方法を紹介し、対応するコード例を示します。 1. swoole の紹介: swoole は、PHP 言語用に開発された高性能の非同期ネットワーク通信エンジンです。

sessionStorage を正しく使用して機密データを保護する方法

Jan 13, 2024 am 11:54 AM

sessionStorage を正しく使用して機密データを保護する方法

Jan 13, 2024 am 11:54 AM

sessionStorage を正しく使用して機密情報を保存する方法には、特定のコード サンプルが必要です。Web 開発でもモバイル アプリケーション開発でも、ユーザーのログイン資格情報や ID 番号などの機密情報を保存して処理する必要があることがよくあります。フロントエンド開発では、sessionStorage の使用が一般的なストレージ ソリューションです。ただし、sessionStorage はブラウザベースのストレージであるため、保存されている機密情報が悪意を持ってアクセスされ、使用されないように、いくつかのセキュリティ問題に注意を払う必要があります。

画面録画ファイルをロスレスで携帯電話に転送する方法_画面録画ビデオをコンピュータから携帯電話に圧縮せずに転送するチュートリアル

Mar 01, 2024 pm 09:53 PM

画面録画ファイルをロスレスで携帯電話に転送する方法_画面録画ビデオをコンピュータから携帯電話に圧縮せずに転送するチュートリアル

Mar 01, 2024 pm 09:53 PM

私たちの日常生活や仕事では、コンピューターデバイスとモバイルデバイスを使用してビデオファイルを相互に転送する必要がよくありますが、受信側のビデオファイルは、送信時のソフトウェアの圧縮によりぼやけやすくなります。この状況を回避するにはどうすればよいですか?また、ロスレスでファイルを別のデバイスに転送するにはどうすればよいですか? EV 画面録画ソフトウェアを使用すると、携帯電話に記録されたビデオ ファイルをロスレスかつ非圧縮の形式でコンピュータに転送して再生できます。以下のビデオで関連するチュートリアルをご覧いただけます。お役に立てれば幸いです。画面録画ファイルを携帯電話にロスレス転送する方法の最初のステップは、携帯電話に EV 画面録画ソフトウェアをダウンロードし、ホームページの「ツールキット」をクリックして「WiFi 転送」機能を見つけることです。 2番目のステップは諦めることです

人工知能テーブルを 1 つの記事で理解する: MindsDB から始める

Apr 12, 2023 pm 12:04 PM

人工知能テーブルを 1 つの記事で理解する: MindsDB から始める

Apr 12, 2023 pm 12:04 PM

この記事は WeChat 公開アカウント「情報時代に生きる」から転載したものであり、著者は情報時代に生きています。この記事を転載するには、情報時代の暮らしの公開アカウントまでご連絡ください。データベース操作に慣れている学生にとって、美しい SQL ステートメントを作成し、データベースから必要なデータを見つける方法を見つけることは日常的な操作です。機械学習に精通している学生にとって、データの取得、データの前処理、モデルの構築、トレーニング セットとテスト セットの決定、トレーニングされたモデルを使用して将来についての一連の予測を行うことは、日常的な操作でもあります。では、2 つのテクノロジーを組み合わせることはできるでしょうか?データはデータベースに保存されており、予測は過去のデータに基づく必要があることがわかります。データベース内の既存のデータを通じて将来のデータをクエリすると、次のようになります。