最近、AIGC が注目を集めているようで、その人気は依然として高いのですが、もちろん、その非常に有名な名前に加えて、その躍進も非常に目覚ましく、画像、ビデオ、さらには 3D モデルさえも、自然言語を入力すると自動生成されます。意外ですか?

しかし、オーディオと音響効果の分野では、AIGC の状況は少し悪いようです。その主な理由は、自由度の高いオーディオ生成は大量のテキストとオーディオのペア データに依存しており、長期的な波形モデリングには多くの困難があるためです。 上記の問題を解決するために、浙江大学と北京大学は共同で革新的なテキストからオーディオへの生成システム、すなわち Make-An-Audio を提案しました。自然言語の説明を入力として受け取ることができ、あらゆるモダリティ (テキスト、オーディオ、画像、ビデオなど) にすることができ、同時に説明に一致するオーディオ効果音を出力できます。大多数のネチズンはその制御性と一般化を高く評価しています。

デモビデオは、わずか 2 日で Twitter で 45,000 回再生されました。

2023 年の大晦日以降、Make-An-Audio や MusicLM などのオーディオ合成に関する記事が多数登場し、48 時間以内に 4 つの画期的な開発が行われました。

ユーザー コメント 1 ## 多くのネチズンは、AIGC 効果音合成が映画やショート ビデオ制作の未来を変えるだろうと述べています。

さらに多くのネチズンが投稿 このようなため息: 「必要なのは音声だけです...」

##ネットユーザーのコメント 4

##ネットユーザーのコメント 4

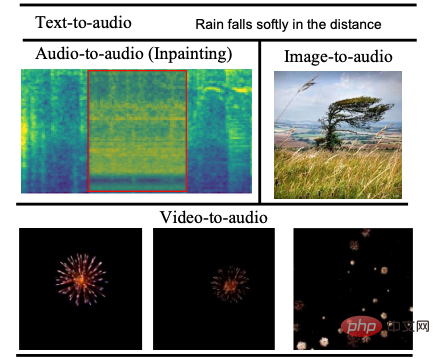

オーディオ効果の表示

早速、効果を見てみましょう。#テキスト 1: 風がマイクに吹き込みながら走るスピードボート

音声の変換 1音声:

00:0000:09 #テキスト 2: 花火が弾けて爆発する

##オーディオを変換 2Audio: #00:0000:09

破損したオーディオの修理で困ったことはありませんか? Make-An-Audio モデルが登場すると、これがずっと簡単になります。 #修理前

## オーディオ修理前

修理前の音声Audio:

00:0000:09##修理後

修理後のオーディオ

修理後のオーディオオーディオ:

00: 0000:09##絵を理解して効果音を生成する 、それは不可能ではありません。

#写真 1

オーディオの変換

オーディオの変換

画像をオーディオに変換Audio:

00:0000:09

画像 2

音声の変換

画像 音声の変換 2音声:

#00:0000:09

によるとビデオコンテンツは対応するサウンドエフェクトを生成します、このモデルもそれを簡単に行うことができます。 #ビデオ 1

## 変換オーディオ

ビデオ 1

オーディオ:

ビデオ 2オーディオを変換

##ビデオ 2オーディオ:

00:0000:09

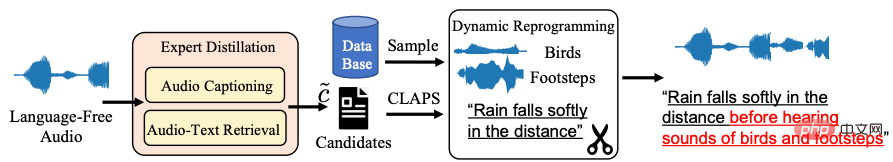

「インターネット有名人」モデルの魔法のような意味合いを徹底的に分析するには、まばらな音声自然言語データという客観的な問題に立ち返る必要があります。浙江大学と北京大学は共同で Volcano Voice を立ち上げました。チームは 2 つの主要大学と協力して、教師モデルを使用して、Distill-then-Reprogram テキスト強化戦略 を共同提案しました。音声の自然言語説明を取得し、ランダムな再編成サンプルを通じて動的トレーニングを取得します。

具体的には、Distill リンクでは、音声からテキストへの検索モデルと音声からテキストへの検索モデルを使用して、言語のない音声の自然言語記述の候補 (候補) を見つけます。候補テキストと音声の類似性を照合すると、音声の説明としてしきい値の下で最良の結果が得られます。この方法には強力な一般化があり、実際の自然言語はテスト段階でドメイン外のテキストを回避します。 「再プログラム段階では、チームは追加のイベントデータセットからランダムにサンプリングし、現在のトレーニングサンプルと組み合わせて、新しい概念の組み合わせと説明を取得し、さまざまなイベントの組み合わせに対するモデルの堅牢性を高めました」と研究チームは述べた。

抽出して再プログラムするテキスト強化戦略フレームワーク図

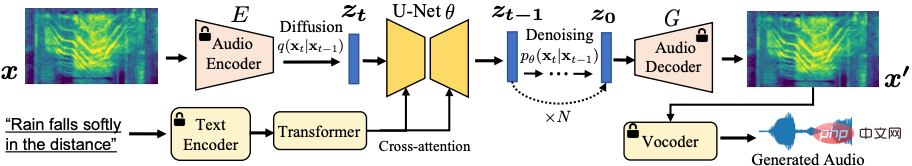

##上の図に示すように、自己教師あり学習は画像をオーディオ スペクトルに移行し、スペクトル オートエンコーダを使用して長いオーディオ シーケンスの問題を解決し、潜在的なデータに基づいた自己処理を完了しました。拡散生成モデル: 教師あり表現の予測により、長期波形の直接予測が回避されます。

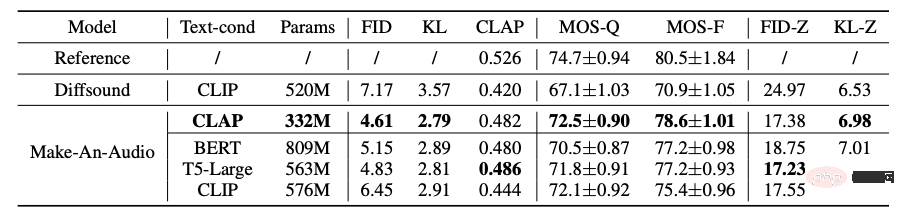

さらに、研究中にチームは、対照的な言語音声事前トレーニング (CLAP) と言語モデル (LLM) T5、BERT などを含む強力なテキスト条件戦略も調査し、CLAP の有効性と計算のしやすさを検証しました。テキスト表現、性別。同時に、生成された音声の評価にテキストと生成されたシーンの整合性を測定できる CLAP スコアを初めて使用し、主観的評価方法と客観的評価方法を組み合わせてモデルの有効性を検証しました。ベンチマーク データ セット テストでは、モデルが優れたゼロショット学習 (Zero-Shot) 一般化を備えていることなどが実証されています。

#魔法のモデルの応用の見通しについてどの程度知っていますか?

全体として、Make-An-Audio モデルは高品質で高度に制御可能なオーディオ合成を実現し、テキスト条件付きオーディオ モデル (finetune) を微調整するための「モダリティを残さない」ことを提案しています。任意のモーダル入力に対してオーディオ合成 (オーディオ/画像/ビデオ) のロックを解除できます。

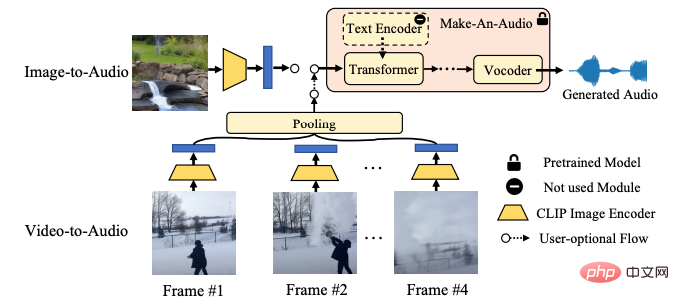

視覚的にガイドされたオーディオ合成の場合、Make-An-Audio は画像とテキストのジョイント スペースで CLIP テキスト エンコーダを条件付けし、直接合成できます。画像エンコーディングに基づいたオーディオ。

##Make-An-Audio Vision-Audio 合成フレームワーク図

##Make-An-Audio Vision-Audio 合成フレームワーク図

音声合成 AIGC は、将来の映画の吹き替え、ショート ビデオの作成、その他の分野で重要な役割を果たすことが予測されており、Make-An-Audio などのモデルの助けを借りて、誰でもそれが可能になる可能性があります。将来プロになるために 音響効果エンジニアは、テキスト、ビデオ、画像を使用して、いつでもどこでも本物のようなオーディオや音響効果を合成できます。ただし、Make-An-Audio は現段階では完璧ではなく、おそらく豊富なデータ ソースと避けられないサンプル品質の問題により、トレーニング プロセス中にテキスト コンテンツに準拠しない音声が生成されるなどの副作用が必然的に発生します。 Make-An-Audio は技術的には「アーティスト生成支援」と位置付けられていますが、AIGC 分野の進歩は確かに驚くべきものであるということは確かです。

Huoshan Voice は、長年にわたり ByteDance の主要な事業分野に、世界的に優れた AI 音声テクノロジー機能と、音声理解、音声合成、仮想数字を含むフルスタックの音声製品ソリューションを提供してきました。インタラクション、音楽検索、インテリジェント ハードウェアなど。 2017 年の設立以来、チームは業界をリードする AI インテリジェント音声テクノロジーの開発に注力し、より大きなユーザー価値を達成するために AI とビジネス シナリオの効率的な組み合わせを常に模索してきました。現在、その音声認識と音声合成は複数の言語と方言をカバーしており、さまざまなトップ AI カンファレンスで多くの技術論文が選ばれており、Douyin、Jianying、Feishu、Tomato Novels、Pico などのビジネスに最先端の音声機能を提供しています。ショートビデオ、ライブブロードキャスト、ビデオ作成、オフィスやウェアラブルデバイスなどの多様なシナリオに適しており、Volcano Engine を通じて外部企業にも公開されています。

以上がこの音声はインターネット上で急速に広まりました。ワンクリックでテキストや画像からリアルなサウンド効果を生成、AIGC がオーディオ業界に登場の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。