生成モデルと比較して、ロボット研究ではなぜ数年前と同じ古い手法が依然として使用されているのでしょうか?

ロボット工学の分野では目覚ましい進歩があり、これらの進歩は、将来ロボットがより多くのことを実行できることを示しています。しかし、厄介な点もあります。生成モデルに比べて、ロボットの進歩はまだ少し遅れており、特に GPT-3 などのモデルの登場により、この差はさらに顕著になっています。

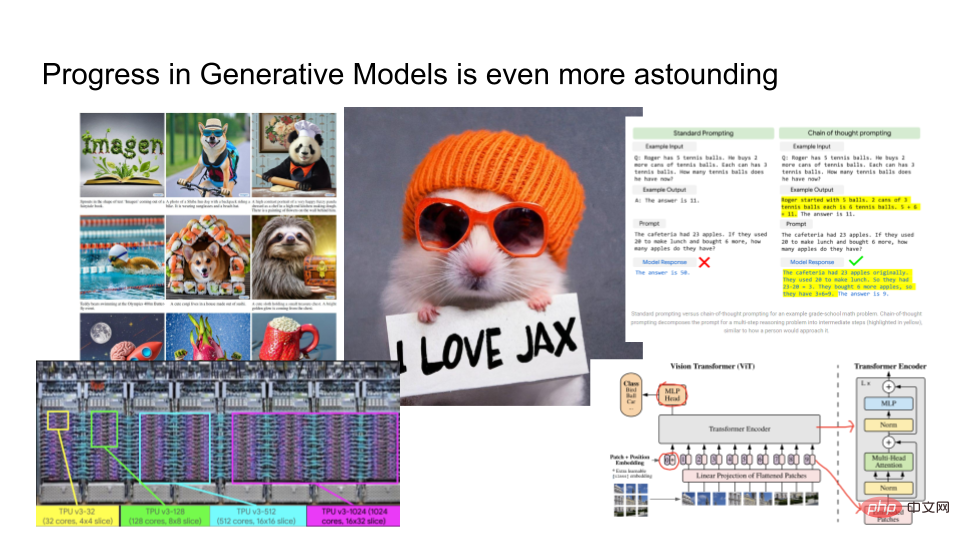

# 生成モデルは、驚くほど優れた結果を生成します。上図の左側はGoogleが立ち上げたImagenの出力結果です。 「オレンジ色の帽子をかぶったハムスターが、JAX を愛していると書かれた紙を持っている」などのテキストを指定すると、指定されたテキストに基づいて、Imagen が適切な画像をレンダリングします。さらに、Google は、ジョークがなぜ面白いのかなどを説明するために使用できる大規模な言語モデル PaLM もトレーニングしました。彼らは TPUv4 などの高度なハードウェアを使用してモデルをトレーニングし、コンピューター ビジョンの分野では、研究者はビジョン トランスフォーマーなどの非常に複雑なアーキテクチャを開発しています。

生成モデルは急速に発展していますが、ロボット技術と比較すると、この 2 つの関係は何でしょうか?

この記事では、ノルウェーのロボット企業「Halodi Robotics」の AI 担当副社長、エリック ジャン氏が「ロボットをより生成モデルに近づけるにはどうすればよいか?」を紹介します。 》。以下が記事の主な内容です。

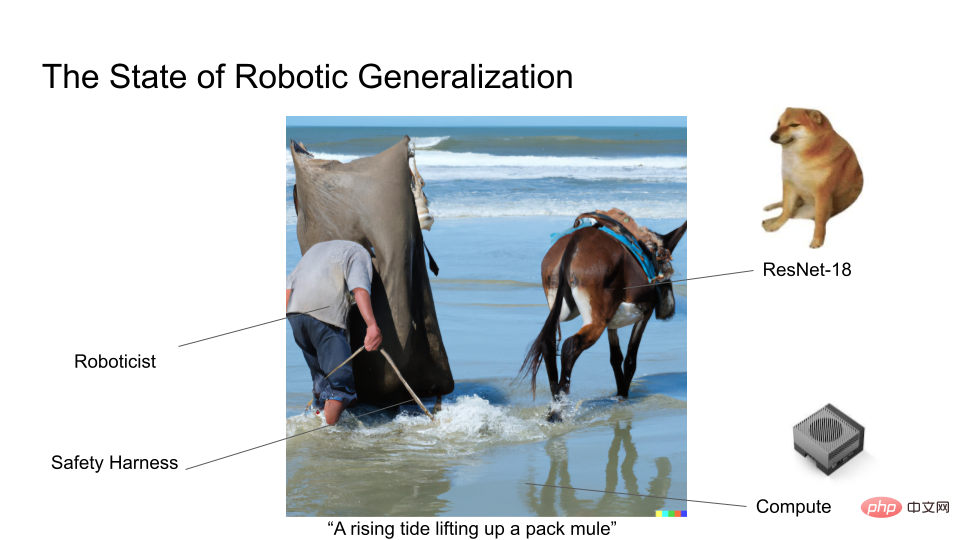

ロボット工学分野の専門家として、生成モデルの分野の進歩は少しうらやましい限りです。なぜなら、ロボット工学の分野では、ほとんどの研究者がおそらく 7 年前の深層学習アーキテクチャである ResNet18 をまだ使用しているからです。もちろん、生成モデルのように巨大なデータセットに基づいてモデルをトレーニングするわけではないため、注目を集めるロボット研究の取り組みはほとんどありません。

私たちはモラベックのパラドックスについて知っています: 認知タスクに比べて、ロボットの器用な操作は難しいです。ロボットに物体を拾わせたり、運んだりさせる操作は難しいと直感的に思われます。言葉を画像に変換したり、ジョークを説明したりすることほど印象的ではないようです。

まず、生成モデルを定義します。生成モデルは、単に画像をレンダリングしたり、一連のテキストを生成したりするだけではありません。これは、すべての確率的機械学習を理解するために使用できるフレームワークでもあります。生成モデルには 2 つの重要な質問があります:

#1. モデル化したいデータ カテゴリには何ビットがありますか?

2. モデルをどの程度うまく構築できますか?

AlexNet は 2012 年に画期的な進歩を遂げました。1000 のカテゴリを予測でき、Log2 (1000 クラス) は約 10 クラス ビットです。 AlexNet は、10 ビットの情報を含む画像ベースの生成モデルと考えることができます。モデリング タスクの難易度を MS-CoCo 字幕タスクにアップグレードすると、モデルには約 100 ビットの情報が含まれます。 DALLE または Imagen を使用してテキストから画像への画像生成を行う場合、これには約 1000 ビットの情報が含まれます。

通常、モデル化されるカテゴリが増えるほど、それらに含まれる条件付き確率を計算するためにより多くの計算能力が必要になります。これが、カテゴリの数が増えるとモデルが変化する理由です。 。モデルをトレーニングするにつれて、データの特徴を活用してより豊富な構造を学習できるようになります。このため、生成モデルと自己教師あり学習は、人間による広範なラベル付けを必要とせずに、大量の入力に対して深層学習を実行する一般的な方法となっています。

リッチ・サットン氏は、「苦い教訓」という記事で次のように指摘しました。人工知能の進歩のほとんどはこのコンピューティングブームの中で行われたようですが、人工知能の進歩はほとんどありませんでした。その他の面もございます。 Vision アルゴリズム、NLP、Yann LeCun の LeCake はすべて、このコンピューティング ブームの恩恵を受けています。

このトレンドは私たちにどのような啓蒙をもたらしてくれるでしょうか?より多くのデータを処理できる過剰にパラメータ化されたモデルがあり、そのモデルが強力なコンピューティング能力とトレーニング目標に加えて、ネットワーク内のすべての特徴をキャプチャできる場合、ディープ ラーニングはほぼ常に実現可能です。

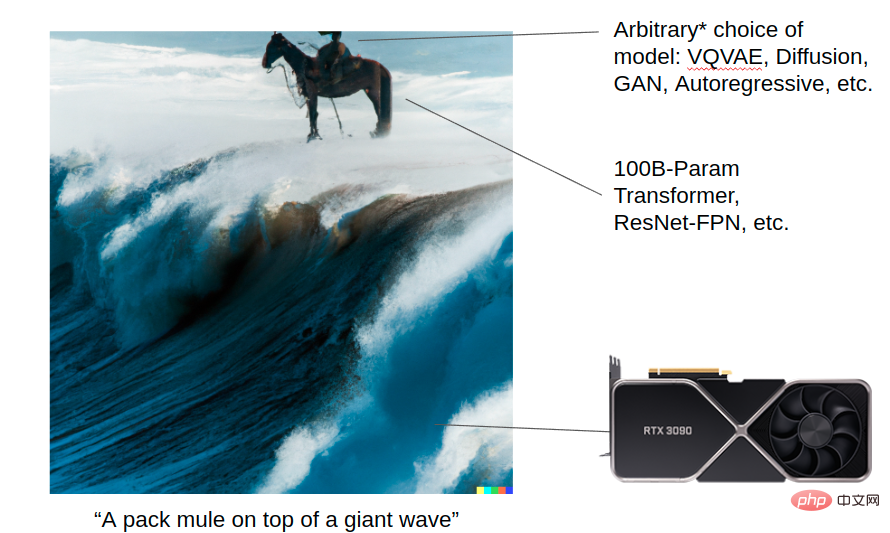

DALL-E 2 に画像を生成させます: 巨大な波に乗るラバ この画像は、コンピューティング ブームの助けを借りて、生成モデルがどのように驚異的な結果を達成できるかを示しています。強力なコンピューティング能力 (トランスフォーマー、Resnet など) があり、モデリングには VQVAE、拡散、GAN、自己回帰、その他のアルゴリズムを選択できます。各アルゴリズムの詳細は現在では重要ですが、将来コンピューターが十分に強力になったら、それらは重要ではなくなるかもしれません。しかし、長期的には、モデルのスケールと優れたアーキテクチャがこれらすべての進歩の基盤となります。

これに対し、下の図はロボット分野における一般化研究の現状を示しています。現在、多くのロボット研究者はまだ小さなモデルをトレーニング中であり、まだ Vision Transformer を使用していません。

ロボット研究に携わる人々は皆、ロボットが現実世界でもっと広く使われ、より大きな役割を果たすことを望んでいます。生成モデルの分野では、研究者が直面する問題は比較的少ないですが、ロボット研究の分野では、ロボットの展開の難しさやデータのノイズなど、生成モデルに携わる研究者が経験することのない問題に遭遇することがよくあります。

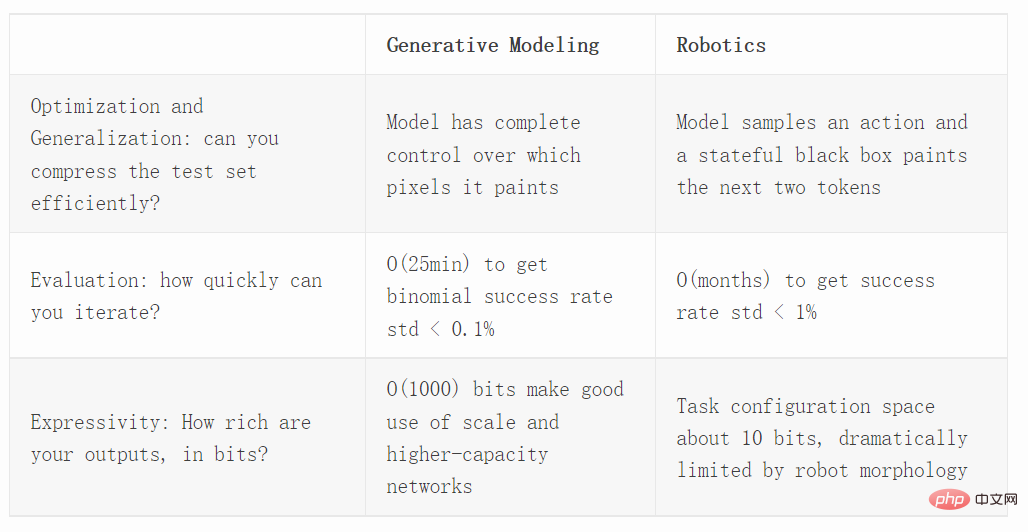

次に、最適化、評価、表現機能を含む 3 つの異なる側面から生成モデルとロボット工学を比較します。

最適化

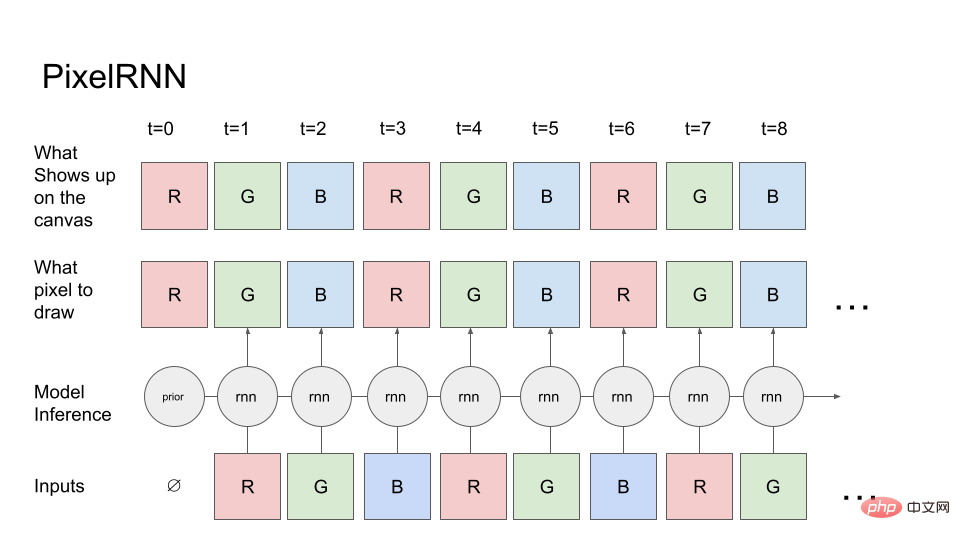

まず、単純な生成モデル PixelRNN を見てみましょう。

最初のピクセルの赤チャネルから開始して (赤チャネルの事前確率は既知です)、モデルはキャンバス (一番上の行) にどのピクセルが必要かを伝えます。描く。キャンバスは指示どおりに正確に描画するため、ピクセル値をキャンバスにコピーし、次にキャンバスをモデルに読み込んで次のチャネル (緑のチャネル) を予測します。次に、R および G キャンバス上の値が RNN にフィードバックされるなどして、最終的に RGBRGBRGB... シーケンスが生成されます。

実際の画像生成タスクでは、拡散またはトランスフォーマーを使用できます。ただし、簡単にするために、前方実行 RNN のみを使用します。

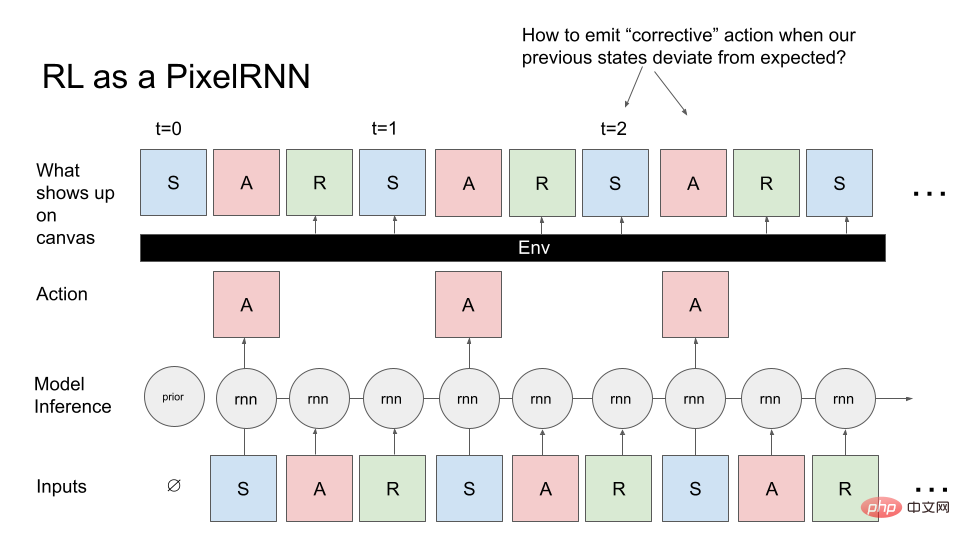

次に、一般的な制御問題を PixelRNN に変換しましょう。画像を生成する代わりに、状態、アクション、報酬のシーケンスである MDP (マルコフ決定プロセス) を生成したいと考えています。何らかのタスクを実行するエージェント (ロボットなど) に対応する MDP を生成したいと考えています。ここでも事前知識から開始し、モデルは強化学習 (RL) 環境の初期状態をサンプリングします。これはモデルへの最初の入力であり、RNN は最初のピクセル (A) をサンプリングし、キャンバスは指示どおりに A を生成します。ただし、画像の生成とは異なり、canvas は常に前の RNN 出力を返します。現在の操作では、次の 2 つのピクセル (R、S) が現在の環境によって決定されます。つまり、アクションと以前のすべての状態を受け入れ、R を計算します。なんとなくS。

RL 環境は、必要なものを直接描画するのではなく、RNN アクションを実行するペインタ オブジェクトとして考えることができます。キャンバス上に任意の複雑な関数を使用してピクセルを描画します。

これを、画像を描画した以前の PixelRNN と比較すると、必要な画像をサンプリングしようとするとブラック ボックスが存在するため、このタスクは明らかにより困難です。ブラックボックスではコンテンツの描画が困難になります。

描画プロセス中に遭遇する典型的な問題: 環境が予期しない状態を描画した場合、問題が発生します。つまり、元の状態に戻るために修正指示を発行する方法が問題になります。私たちが描こうとしているイメージ。さらに、画像生成とは異なり、実際には MDP 画像を順番に生成する必要があり、編集のために戻ることができないため、最適化の課題も生じます。

PPO のような RL 手法がどのように一般化されるかを理解したい場合は、制御されていない環境でベンチマークを行い、それを画像生成技術に適用し、最新の生成モデルと比較する必要があります。 Hinton と Nair の 2006 年の研究では、スプリング システムを使用して MNIST デジタル合成をモデル化しました。 DeepMind は、RL 手法を使用してこの画像合成作業の一部を複製します。

画像生成は、何千もの異なるシナリオにわたって一般化する必要性を強調しているため、最適化と制御を研究するための優れたベンチマークです。

Decision Transformer、Trajectory Transformer、Multi-Game Decision Transformer などの最近の研究では、逆さま RL テクノロジーが一般化に優れた効果を発揮することが示されています。では、アップサイドダウン RL 手法は、オンライン (PPO) またはオフライン RL アルゴリズム (CQL) とどのように比較されるのでしょうか?また、評価も簡単で、密度 (専門家の完全な観察の尤度モデル) を評価し、テストの尤度を測定するときに、特定の RL アルゴリズムの選択が多数の画像に一般化できるかどうかを検証できます。

評価

特定のタスクにおけるロボットの成功率を推定したい場合は、二項分布を使用できます。

二項分布の分散は p(1-p)/N、p はサンプル平均 (推定成功率)、N は試行回数です。最悪の場合、p=50% (最大分散) の場合、標準偏差を 1% 未満にするには 3000 個のサンプルが必要です。

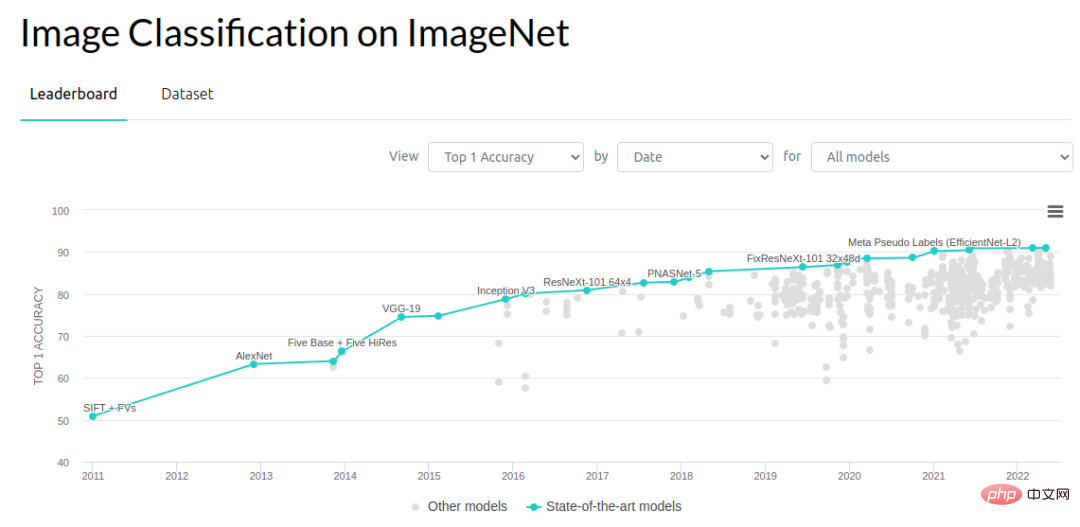

コンピュータ ビジョンの観点から見ると、0.1 ~ 1% の範囲の改善が進歩の重要な原動力となります。 ImageNet のオブジェクト認識問題は 2012 年以来大きく進歩しました。エラー率は 2012 年から 2014 年にかけて 3% 減少し、その後は年間約 1% ずつ減少しました。これを機能させる方法については、多くの人々が取り組んでいます。おそらく今年 (2022 年) がベンチマーク改善のボトルネックに達していると思われますが、2012 年から 2018 年の 7 年間に研究者たちは多くの進歩と成果を上げてきました。

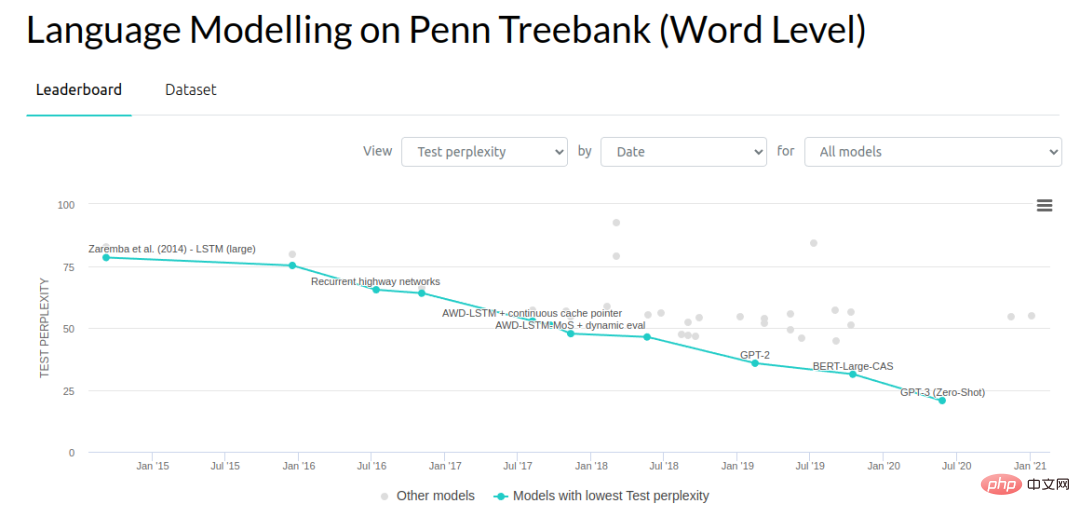

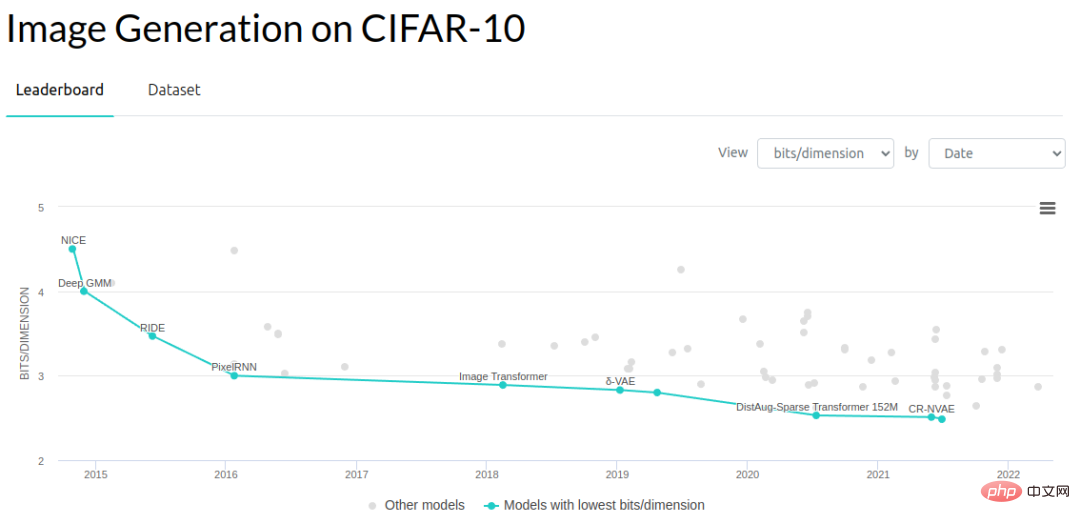

生成モデリングの他の分野では、研究者は言語モデルの複雑さと、生成モデリングが実行する画像の次元あたりのビット数を削減してきました。モデルは数値 (1 次元あたりのビット数) を指定できます。

#一般的なベンチマークの評価速度の大まかな比較は次のとおりです。 2012 ImageNet オブジェクト認識テスト セットには 150,000 個の画像が含まれています。画像あたりの推論速度を 10 ミリ秒と仮定し、各画像を連続して評価すると、各テスト例の評価に約 25 分かかります (バッチ処理が可能なため、実際の評価はさらに高速になります)。ただし、ここでは、評価操作を実行するロボットは 1 台だけであり、画像は継続的に処理する必要があると想定しています。

大量の画像があるため、標準誤差の推定値は 0.1% 以内で得られます。実際には、この分野で進歩するために 0.1% の標準誤差は必要ありません。おそらく 1% で十分です。

複雑さを評価するという点では、エンドツーエンドのパフォーマンスも重要な要素です。シミュレートされたタスクでニューラル ネットワークのエンドツーエンドのパフォーマンス評価を実行する方法を見てみましょう。 Habitat Sim は利用可能な中で最も高速なシミュレーターの 1 つであり、ニューラル ネットワーク推論と環境ステッピングの間のオーバーヘッドを最小限に抑えるように設計されています。シミュレーターは 1 秒あたり 10,000 ステップを実行できますが、ニューラル ネットワークのフォワード パスは約 10 ミリ秒であるため、このボトルネックにより、エピソードあたりの評価時間は 2 秒になります (一般的なナビゲーション エピソードが 200 ステップであると想定)。これは実際のロボットを実行するよりもはるかに高速ですが、単一のコンピューター ビジョン サンプルを評価するよりははるかに遅くなります。

ImageNet で行ったのと同様の多様性レベルでエンドツーエンドのロボット システムを評価する場合、通常の評価では、数十万の評価シナリオを処理するのに 1 週間かかります。各エピソードには実際に約 200 の推論パスがあるため、これは完全に合理的な比較ではありませんが、単一のエピソード内の画像を独立した検証セットとして扱うことはできません。他のエピソード メトリックがなければ、タスクが成功したかどうかだけがわかります。そのため、エピソード内のすべての推論は、二項推定の 1 つのサンプルにのみ寄与します。写真ではなく、何万ものエピソードに基づいて成功率を推定する必要があります。もちろん、他のポリシー評価方法を使用してみることもできますが、これらのアルゴリズムはそのまま使用できるほど信頼性が高くありません。

次の段階では、実際のロボットの現場評価を行います。現実の世界では、各エピソードの評価には約 30 秒かかります。10 人のオペレーターのチームが評価を実行し、各チームが 1 日あたり 300 のエピソードを完了できる場合、1 日あたり約 3000 の評価を実行できます。

モデルの評価に丸 1 日かかる場合、1 日に試せるアイデアは 1 つだけなので、生産性に大きな制限がかかります。そのため、パフォーマンスを段階的に 0.1% 向上させるような小さなアイデアや、非常に極端なアイデアに取り組むことはできなくなりました。私たちはパフォーマンスを大きく飛躍させる方法を見つける必要がありました。これは良さそうに見えますが、実際に行うのは困難です。

ロボット学習の反復プロセスを考慮すると、評価試行の数がトレーニング データをはるかに超えることがよくあります。数か月にわたる継続的な評価により、約数万のエピソードが生成されました。これはすでに、ほとんどのロボットによる深層学習のデモンストレーション データセットよりも大規模です。

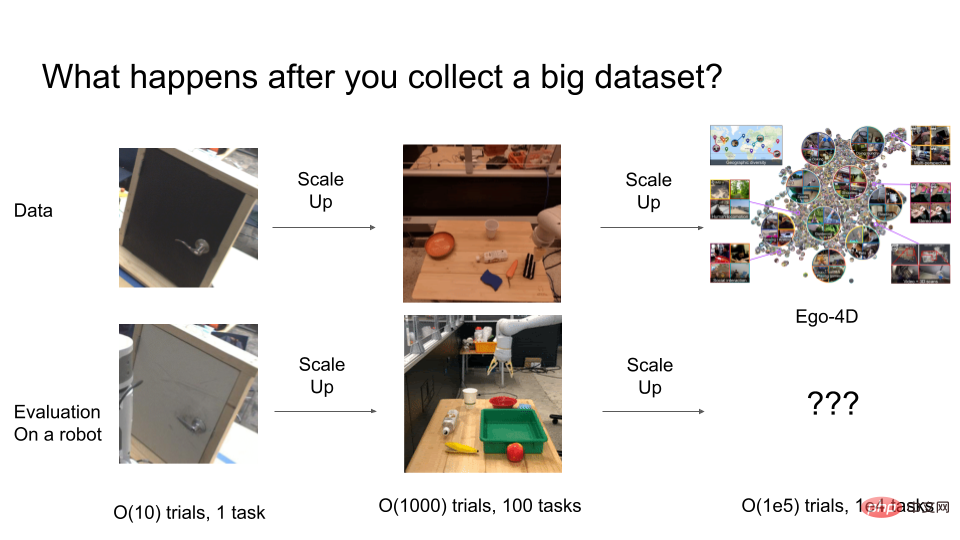

数年前、研究者たちはまだロボットアームでドアを開けるなどの問題を解決していましたが、これらの戦略は解決できませんでした。あまりうまく機能しません。良い一般化です。研究者は通常、約 10 エピソードのシーケンスで評価を実施します。しかし、実際には 10 ~ 50 回の試行では統計的な堅牢性を保証するのに十分ではありません。良い結果を得るには、最終評価のために実際に 1000 回を超える試行が実行される場合があります。

しかし、実験をさらに拡張するとどうなるでしょうか?最終的に O(100,000) の動作を持つ非常に一般的なロボット システムをトレーニングする必要がある場合、そのような一般的なシステムを評価するには何回の試行が必要になるでしょうか?ここで査定費用が非常に高額になります。

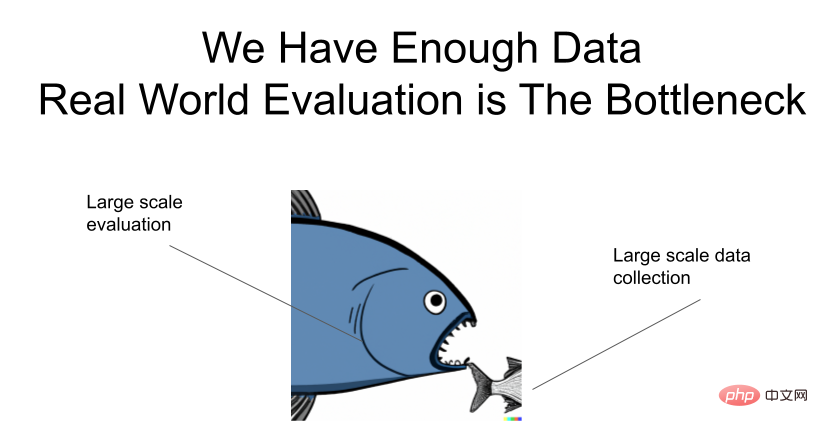

もう一度強調します。データは十分ですが、評価にはボトルネックがあります。

#評価を迅速化するにはどうすればよいですか?

ここでは、ユニバーサル ロボット システムの評価を迅速化する方法に関するアイデアをいくつか紹介します。

1 つのアプローチは、一般化問題とロボットを別々に研究することです。実際、深層学習コミュニティはすでにこれを達成しています。コンピュータービジョンと生成モデリングの研究者のほとんどは、実際のロボットでアイデアを直接テストすることはありませんが、モデルが強力な一般化機能を達成すれば、すぐにロボットに移植されると期待しています。コンピューター ビジョンの分野で開発された ResNets は、多くのロボットのビジュアル モーション モデリング オプションを大幅に簡素化します。研究者が別のニューラル ネットワーク アーキテクチャを試したいと思うたびに、実際のロボットで自分のアイデアをテストしなければならないとしたらどうなるかを想像してみてください。もう 1 つの成功事例は CLIPort です。これは、画像テキスト モデルの強力なマルチモーダル一般化機能を、把握計画の基礎となる幾何学的推論から切り離します。

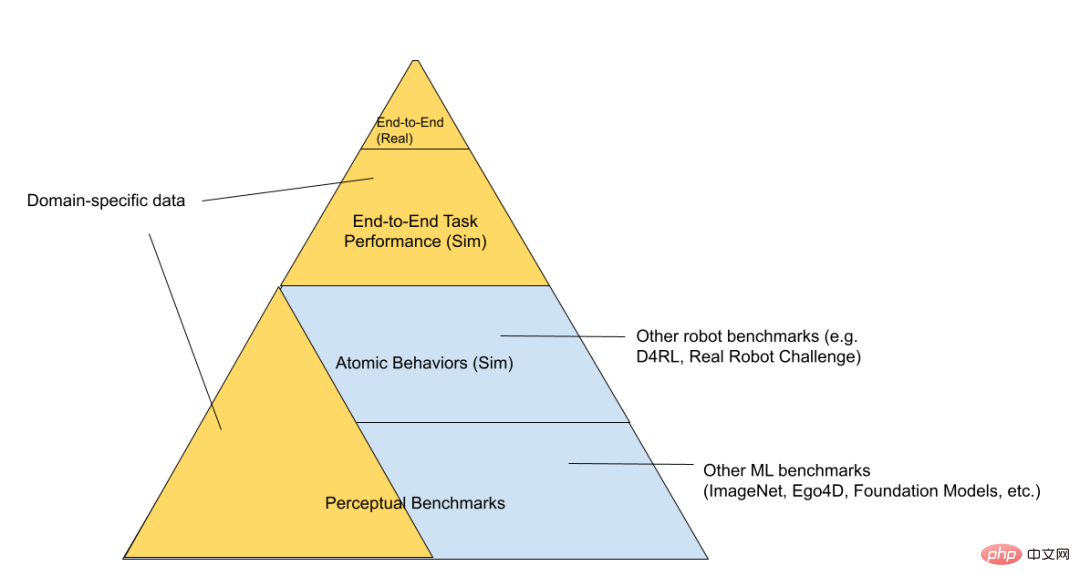

RL テクノロジー スタックはさらに、「模擬おもちゃ環境」、「模擬ロボット」、「本物のロボット」の 3 つの層に分けることができます (評価の難易度が高い順に並べています)。 。

ピラミッドの最下位には、Kaggle コンテストのベンチマークなどの一般的なベンチマークがあります。上に進むと、「ベア メタル」方法で問題を研究する一連の「おもちゃ制御問題」があります。シミュレータとニューラル ネットワークのみが実行され、バッテリー管理など、現実世界のロボットに関連するすべてのコードが実行されます。 、 存在しない。ピラミッドをさらに上に進むと、解決しようとしている問題により関連性の高い、より具体的な領域が表示されます。たとえば、「シミュレートされたロボット」と「実際のロボット」は同じタスクに使用され、同じ基礎となるロボット コードを再利用できます。シミュレートされたおもちゃ環境は、一般的なアルゴリズムを研究するために使用できますが、最終的なロボット工学の分野との重複は少なくなります。 「評価ピラミッド」の頂点には、私たちが解決しようとしている実際のロボットタスクがあります。このプロセスを直接繰り返すのは非常に時間がかかるため、誰もがここで費やす時間をできるだけ短くしたいと考えています。私たちは、下位レベルでトレーニングおよび評価された基本モデルが、トップレベルですべての評価を行わなくても、どのアイデアが機能するかを理解するのに役立つことを願っています。

同様に、この分野はすでにこの分離された方法で運用されています。ロボットへの貢献に興味のある人のほとんどは、必ずしもロボットを操作するとは限りません。彼らは、最終的にロボットに役立つ可能性のある視覚的表現とアーキテクチャをトレーニングする可能性があります。もちろん、デカップリングの欠点は、知覚ベースラインの改善が必ずしもロボットの能力の改善に対応するとは限らないことです。たとえば、mAP メトリクスはセマンティック セグメンテーションやビデオ分類の精度、さらにはロスレス圧縮ベンチマーク (理論的には最終的に寄与するはずです) を向上させていますが、表現目標の向上が実際に下流タスクの向上にどのようにマッピングされるのかはわかりません。したがって、実際のボトルネックがどこにあるのかを理解するには、最終的にはエンドツーエンドのシステムでテストする必要があります。

Google はかつて、「解絡表現の教師なし学習における一般的な仮定への挑戦」という素晴らしい論文を発表しました。彼らは、多くの完全に教師なし表現学習手法が下流で使用されないことを証明しました。大幅なパフォーマンスの向上をもたらします。ただし、重要な最終的な下流基準を使用してモデルの評価と選択を実行している場合を除きます。

論文アドレス: https://arxiv.org/pdf/1811.12359.pdf

評価コストを削減する別の方法このアプローチは、データ収集と評価プロセスの一貫性を確保することです。評価データと専門家の運用データの両方を同時に収集できます。特定の介入を通じて HG ダガー データを収集できるため、有用なトレーニング データを収集できます。同時に、エピソードごとの平均介入数から、その戦略が十分であるかどうかを大まかに知ることができます。また、二項メトリックの代わりにスカラー メトリックを観察することもできます。これは、これらのメトリックの各エピソードが 1 つの成功/失敗よりも多くの情報を生成するためです。

自律的なデータ収集に RL アルゴリズムを使用することは、評価とデータ収集を組み合わせるもう 1 つの方法ですが、この方法では手動でエピソードをスコアリングするか、慎重に設計された報酬関数を使用する必要があります。これらのアプローチはすべて、現実世界に多数のロボットを展開する必要がありますが、現実世界での継続的な反復では依然として行き詰まっています。

評価アルゴリズムを高速化する方法は、シミュレーションからリアルへの移行アルゴリズムを改善することです。多くのロボットを並行してシミュレートできるため、制約はありません。 Mohi Khansari 氏、Daniel Ho 氏、Yuqing Du 氏らは、「Task Consistency Loss」と呼ばれる手法を開発しました。これは、シムとリアルの表現を不変式に正規化するもので、シミュレーションにおける戦略の動作はリアルと同様になるはずです。シムで評価された戦略をリアルに移行するときは、シムでのより高いパフォーマンスのメトリクスが、実際にリアルでのより高いパフォーマンスのメトリクスにも対応していることを確認したいと考えています。 sim2real ギャップが小さいほど、シミュレーション実験の指標の信頼性が高くなります。

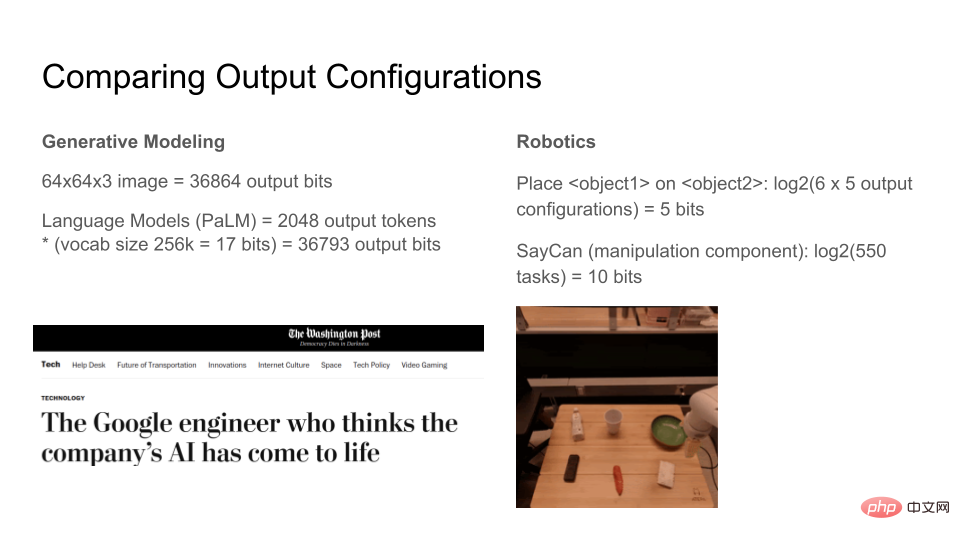

表現力

最新の生成モデルが出力できるビット数を見てみましょう。チャネルあたり 8 ビットの 64x64x3 RGB 画像は 36864 ビットです。言語モデルは任意の数のトークンを生成できますが、出力ウィンドウを 2048 トークンに固定すると、各トークンは 17 ビット、合計 36793 ビットになります。したがって、画像生成モデルとテキスト生成モデルの両方で約 37k ビットを合成できます。モデルの表現力が高まるにつれて、これらのモデルに対する人々の認識は質的に飛躍することになります。言語モデルは非常に表現力豊かであるため、部分的に意識されているのではないかと考え始めている人さえいます。

それに比べて、現在のロボットはどれほど表現力豊かなのでしょうか?ここでは、簡略化された現実世界の環境を設計します。テーブル上には 6 つのアイテムがあります。ロボットのタスクは、1 つのアイテムを別のアイテムの上に移動するか、特定のアイテムを輸送することです。合計 100 のタスクがあります。 log2(100) は約 7 ビットです。これは、「世界の状態を考慮して、ロボットは原子を N 状態の 1 つに移動できます。N は 7 ビットで表現できます。」を意味します。 Google の SayCan アルゴリズムは、単一のニューラル ネットワークで約 550 の操作を実行できます。これは、現在のロボット工学の深層学習標準からすると、合計わずか約 10 ビットで非常に優れています。

情報の定義が 2 つ間で異なるため、この比較は完全に合理的ではありません。ここでは、一連のタスクと相対的なタスクを測定する際の大まかな直感を提供するためにのみ提供されています。別の一連のタスクが複雑になると、何が重要かを理解する必要があります。

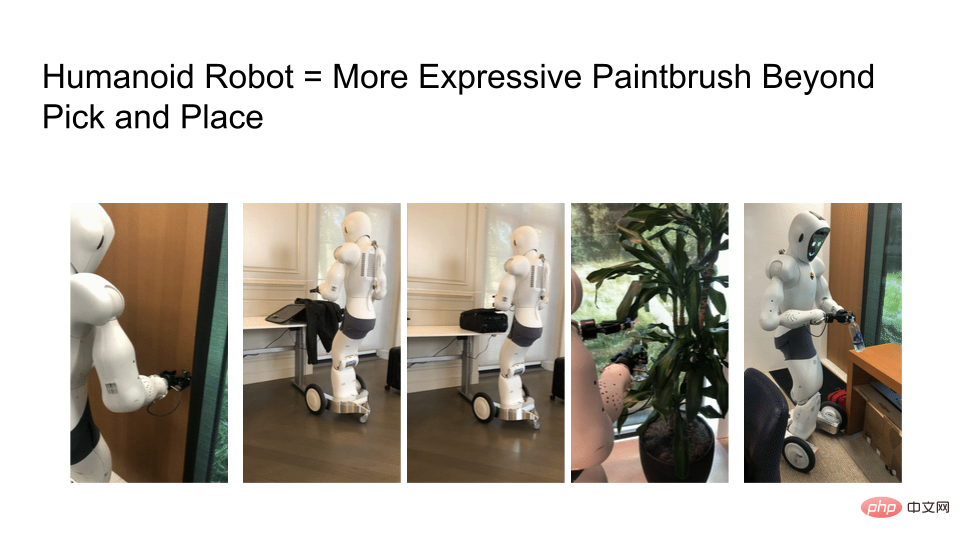

私たちが直面した課題の 1 つは、ロボットの機能がまだ制限されていることです。 Ego4D データセットを見ると、多くのタスクには両手が必要ですが、今日のほとんどのロボットは依然として車輪付きベースのシングルアームのモバイル マニピュレーターを使用しています。彼らは移動したり、どこへ行ったりすることもできず、明らかに私たちが持っているのは「ロボットアーム」だけであり、これでは多くの興味深いタスクが排除されます。

#もっと表現力豊かなロボットを研究する必要がありますが、ロボット学習アルゴリズムの表現力はハードウェアによって制限されます。下の写真は、ドアを開け、スーツケースに荷物を詰め、ジッパーを閉め、植物に水をやり、水筒のキャップをひっくり返すロボットの様子です。ロボット ハードウェアが実際の人間に近づくにつれて、人間中心の世界でできることの数は飛躍的に増加します。

ロボットの表現力が高まるにつれ、インターネット規模のトレーニング データだけでなく、インターネット規模の評価プロセスも必要になります。大規模言語モデル (LLM) の進歩を見ると、現在、チューニングや既存のモデルでできることとできないことについて検討した論文がたくさんあります。

たとえば、BigBench のベンチマークは一連のタスクをコンパイルし、これらのモデルから何が得られるかを尋ねます。 OpenAI は、インターネット ユーザーに DALLE-2 および GPT-3 モデルを評価する機会を提供します。 LLM モデルの詳細を 1 人の研究者が習得するのは難しいため、同社のエンジニアリング チームと製品チームは、ユーザーが参加する AI 実験から学ぶことができます。

最後に読者に質問ですが、ロボット分野における GPT-3 や DALLE-2 API に相当する技術は何ですか?この同等のテクノロジーを通じて、インターネット コミュニティの研究者はロボット研究に疑問を持ち、ロボットが実際に何ができるかを理解できるでしょうか?

最後に、表を使用して、最適化、評価、表現力の比較を要約します:

以上が生成モデルと比較して、ロボット研究ではなぜ数年前と同じ古い手法が依然として使用されているのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

20

20

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

ソフトウェア テクノロジの最前線に立つ UIUC Zhang Lingming のグループは、BigCode 組織の研究者とともに、最近 StarCoder2-15B-Instruct 大規模コード モデルを発表しました。この革新的な成果により、コード生成タスクにおいて大きな進歩が達成され、CodeLlama-70B-Instruct を上回り、コード生成パフォーマンス リストのトップに到達しました。 StarCoder2-15B-Instruct のユニークな特徴は、その純粋な自己調整戦略であり、トレーニング プロセス全体がオープンで透過的で、完全に自律的で制御可能です。このモデルは、高価な手動アノテーションに頼ることなく、StarCoder-15B 基本モデルの微調整に応じて、StarCoder2-15B を介して数千の命令を生成します。

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

翻訳者 | Li Rui によるレビュー | 今日、人工知能 (AI) および機械学習 (ML) モデルはますます複雑になっており、これらのモデルによって生成される出力はブラックボックスになっており、関係者に説明することができません。 Explainable AI (XAI) は、利害関係者がこれらのモデルがどのように機能するかを理解できるようにし、これらのモデルが実際に意思決定を行う方法を確実に理解できるようにし、AI システムの透明性、信頼性、およびこの問題を解決するための説明責任を確保することで、この問題を解決することを目指しています。この記事では、さまざまな説明可能な人工知能 (XAI) 手法を検討して、その基礎となる原理を説明します。説明可能な AI が重要であるいくつかの理由 信頼と透明性: AI システムが広く受け入れられ、信頼されるためには、ユーザーは意思決定がどのように行われるかを理解する必要があります

総合的にDPOを超える:Chen Danqi氏のチームはシンプルなプリファレンス最適化SimPOを提案し、最強の8Bオープンソースモデルも洗練させた

Jun 01, 2024 pm 04:41 PM

総合的にDPOを超える:Chen Danqi氏のチームはシンプルなプリファレンス最適化SimPOを提案し、最強の8Bオープンソースモデルも洗練させた

Jun 01, 2024 pm 04:41 PM

大規模言語モデル (LLM) を人間の価値観や意図に合わせるには、人間のフィードバックを学習して、それが有用で、正直で、無害であることを確認することが重要です。 LLM を調整するという点では、ヒューマン フィードバックに基づく強化学習 (RLHF) が効果的な方法です。 RLHF 法の結果は優れていますが、最適化にはいくつかの課題があります。これには、報酬モデルをトレーニングし、その報酬を最大化するためにポリシー モデルを最適化することが含まれます。最近、一部の研究者はより単純なオフライン アルゴリズムを研究しており、その 1 つが直接優先最適化 (DPO) です。 DPO は、RLHF の報酬関数をパラメータ化することで、選好データに基づいてポリシー モデルを直接学習するため、明示的な報酬モデルの必要性がなくなります。この方法は簡単で安定しています

Yolov10: 詳細な説明、展開、アプリケーションがすべて 1 か所にまとめられています。

Jun 07, 2024 pm 12:05 PM

Yolov10: 詳細な説明、展開、アプリケーションがすべて 1 か所にまとめられています。

Jun 07, 2024 pm 12:05 PM

1. はじめに ここ数年、YOLO は、計算コストと検出パフォーマンスの効果的なバランスにより、リアルタイム物体検出の分野で主流のパラダイムとなっています。研究者たちは、YOLO のアーキテクチャ設計、最適化目標、データ拡張戦略などを調査し、大きな進歩を遂げました。同時に、後処理に非最大抑制 (NMS) に依存すると、YOLO のエンドツーエンドの展開が妨げられ、推論レイテンシに悪影響を及ぼします。 YOLO では、さまざまなコンポーネントの設計に包括的かつ徹底的な検査が欠けており、その結果、大幅な計算冗長性が生じ、モデルの機能が制限されます。効率は最適ではありませんが、パフォーマンス向上の可能性は比較的大きくなります。この作業の目標は、後処理とモデル アーキテクチャの両方から YOLO のパフォーマンス効率の境界をさらに改善することです。この目的を達成するために

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。