ChatGPT の成功の背後にある技術的理由と、ライフ サイエンス分野における ChatGPT のインスピレーション

1950 年代には、一部の学者が人工知能 (Artificial Intelligence) の概念を提案しました。その目的は、コンピューターに人間の知能 (または人間の知能の一部) を持たせることでした。この分野では長年開発が続けられてきましたが、2012 年にディープラーニング技術が登場するまで、画期的な進歩はありませんでした。深層学習は主にモデル表現機能のボトルネックを解決します。画像理解、言語翻訳、音声認識、分子とタンパク質の結合立体構造予測、その他の技術など、私たちが直面するモデリングの問題はすべて非常に複雑な非線形問題ですが、深層学習の出現以前は、モデル表現能力が非常に弱く、不可能でした。これらの複雑な問題を正確に表現します。ディープラーニングテクノロジーは、理論的には、モデルを階層的に積み重ねることによって任意の深さのモデルを構築でき、モデル表現機能のボトルネックを突破し、音声認識、コンピュータービジョン、自然言語理解などの分野で画期的な進歩をもたらします。

#ディープラーニング技術の登場は、人工知能が新たな段階に入ったことを示しています 2012 年頃から始まったディープラーニングによる人工知能の波を 新世代の人工知能時代 (実際、音声認識分野におけるディープ ラーニングの応用は最も初期にまで遡ることができますが、その後のディープ ラーニングの進歩の多くは、コンピューター ビジョンの分野では、2012 年の AlexNet を出発点として使用します)。この期間は、ディープラーニングによって駆動される新世代の人工知能、つまりアノテーションデータ駆動型ディープラーニングモデルの最初の段階と考えることができ、モデルの表現能力が大幅に向上し、それによって人工知能テクノロジーが大幅に向上し、は、コンピュータ ビジョンと音声認識の分野で製品と商業的な成功を収めてきました。この段階の主な制限は、ラベル付きデータの量に大きく依存することです。モデル パラメーターの数が増えると、非常に多くのモデル パラメーターを解決するための制約として大量のトレーニング データが必要になります。注釈付きの大量のデータを取得するには非常にコストがかかり、1 億レベルに達すると改善が難しくなり、データによってサポートされる有効なモデル サイズも制限されます。 2012 年から 2015 年にかけて、コンピューター ビジョンが最も活発な分野であり、ResNet を含むさまざまなディープ ネットワーク モデルが登場しました。 2017年、重要な基礎作品『Transformer』が登場しました。 2019年、これまで大きな進歩を遂げられなかった自然言語処理(NLP)の分野において、BERTと呼ばれる研究が頭角を現し、十数種類の自然言語処理(NLP)タスクにおいて最高の結果を達成した。これらのタスク間の違いは非常に大きいため、BERT の研究が発表されると、すぐにこの分野全体の注目を集めました。 BERT は 自己教師あり事前トレーニング

と呼ばれるアイデアを採用しています。これは、データにラベルを付けずに、テキスト コーパス自体の制約のみ (たとえば、特定のテキストのみを使用する) を使用してモデルをトレーニングできます。特定の文の位置を学習できる(特定の修飾語を使用できる)ため、インターネット上に存在する高品質のコーパスを手動で調整することなく学習に使用できます。これにより、利用可能な学習データの量が突然大幅に増加し、大量のデータと相まってBERT モデルは過去のモデルよりもはるかに効果的であり、さまざまなタスクにわたって優れた汎用性を備えているため、NLP の分野におけるマイルストーンの 1 つとなっています。 実際、BERT が 2018 年に登場する前に、GPT (つまり GPT1.0) と呼ばれる別の作品があり、以前は自己教師あり事前トレーニングのアイデアが使用されていました。つまり、前のテキストを入力し、モデルが次のテキストを予測して出力するため、アノテーションなしで現場の高品質なコーパスを学習できます。 BERT と GPT はどちらも Transformer に基づいて開発されており、Transformer は徐々に AI 分野の一般的なモデルに発展しました。 GPT1.0の効果はすごいものではありません。 BERT の出現後間もなく、GPT はすぐに GPT2.0 をリリースしました。モデル サイズとトレーニング データ量が大幅に改善されました。一般的なモデル (つまり、トレーニングと直接テスト結果のための下流タスクなし) として、結果は以前のモデルよりも優れています。ほとんどのタスクに現在のものがあります。モデルがあります。ただし、BERT モデルは特徴表現において GPT2.0 モデルよりも多くの利点があり、トレーニングが容易であるため、現段階でこの分野で最も懸念されている作業は依然として BERT です。しかし 2020 年 7 月に GPT3.0 が判明し、1,700 億のパラメータで誰もが驚愕しました。さらに重要なのは、効果という点では、GPT3.0 はユニバーサル言語モデルとして機能します。世代を説明する簡単な説明を提供するだけで済みます。コンテンツに基づいて、再トレーニングすることなく、実行可能コードの生成、Web ページやアイコンの生成、記事やニュースの完成、プロンプトに従って詩や音楽を書くことができます。 GPT3.0 の登場後、GPT3.0 は業界から広く注目を集め、多くの開発者が GPT3.0 に基づいて多くの興味深いアプリケーションを作成してきました。 GPT3.0 は、最高かつ最も人気のあるテキスト生成モデルになりました。

自己教師あり事前トレーニング技術の出現後、新世代の人工知能は の第 2 段階、つまり自己教師あり事前トレーニング技術に発展したと考えることができます。学習テクノロジーにより、利用可能な学習データの数が数桁増加しました。 学習データの改良に伴い、モデルのサイズも数桁改善されました(有効なモデルは数千億の規模に達しました)。モデル効果の点では、これらのモデルは下流のタスク フィールドのデータに依存しなくなり、再トレーニングは自己教師付き事前トレーニング # に基づく一般的な大規模モデルの時代に入りました。

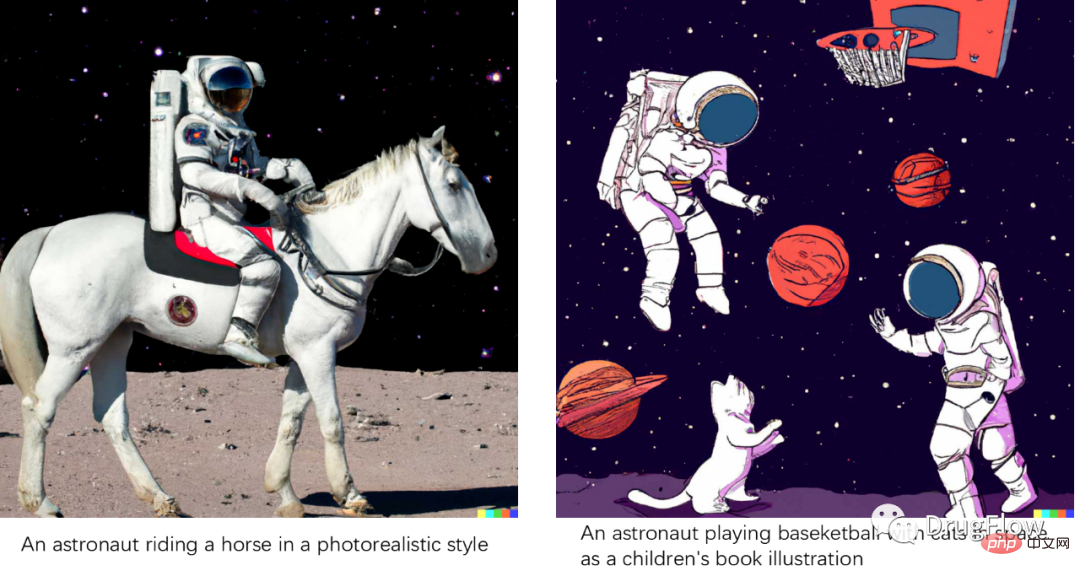

その後、GPT3.0 は、この分野の他の研究とともに、模型サイズの軍拡競争の波を引き起こしましたが、真に画期的なテクノロジーはほとんど出現しませんでした。モデルのサイズを増やすだけでは問題が根本的に解決されないことは誰もが認識しています。 GPT4.0などの後続作品の登場を誰もが心待ちにしていた矢先、GPTは丸2年も更新されていない。この期間中、人工知能の分野で最も活発な研究は主に、マルチモーダル統合モデルとコンテンツ生成という 2 つの側面に焦点を当てていました。マルチモーダル統合モデル。マルチモーダルまたはクロスモーダル統合モデルの構築を望み、テキスト、画像、音声などの異なるモーダル データを 1 つのモデルで均一に表現しようとします。これには、初期のクロスモーダル表現モデル CLIP とその後の A シリーズが含まれます。マルチモーダルな統一表現モデル。コンテンツ生成の分野では、技術レベルでは拡散モデルなどの基本モデルが登場し、拡散モデルと一連のバリアントモデルの発展によりAI生成コンテンツ(AIGC)の分野が形成されています。画像生成の分野から自然言語処理や生命科学の分野への広がりが非常に注目されていますが、一方で応用レベルでは、画像生成に基づく画像生成の分野で多くの大きな進歩が見られています。その中で最も代表的な作品がDALLE2である。入力されたテキストを基にしてモデルを作成することができる。記述によりリアルに見える画像が出力され、テキスト記述が現実を超えた場合でも、あたかも現実に見える画像を生成することが可能である。以下の図に示すように、テキストの説明に合理的に準拠しています。 DALLE2 のような一連の研究の成功は、一方ではテキストと画像の意味論間の対応をモデル化した大量のテキストと画像の対応データ (約数億ペア) によるものであり、他方ではGAN や VAE などのモデルを克服する拡散モデルには、学習の難しさや、生成された効果の詳細の保持が不十分であるなどの欠点があります。画像生成の効果は非常に素晴らしいため、多くの人が AI がすでにコンテンツを作成できると信じています。

図. DALLE2 生成効果

2022 年 11 月末、OpenAI は ChatGPT をリリースしました。 ChatGPT のリリース後、このチャットボットは非常に珍しく、しばしば驚くべき回答を返すことが誰もが気づきました。会話ロボットの分野では、Apple の Siri、Microsoft の Xiaobing Xiaona など、多くの会話ロボットが登場していますが、これらの一般的な会話システムのエクスペリエンスはあまり理想的ではなく、からかうために使用され、その後捨てられています。スマートスピーカーなどに用いられるコマンド実行型質疑応答ロボットのシステム枠組みは、ルール駆動型の対話管理システムをベースとしているが、手動ルールが多く、一般分野への拡張が困難である。は、単純で定型化された回答しか提供できませんが、一方で、複数ラウンドの対話の環境意味情報 (Context) を処理することはできません。技術的な観点から見ると、ChatGPT は元の主流の対話システムとはまったく異なり、システム全体が深層世代の大規模モデルに基づいており、与えられた入力に対して深層モデルによって処理され、抽象的な要約回答を直接出力します。製品体験の点でも、ChatGPT は過去のチャット システムをはるかに上回っています。一般的なチャットボットとして、ほぼあらゆる分野の質問に答えることができ、その精度は人間が使い続けたいレベルに達しており、複数回の対話シナリオでも非常に良好なエクスペリエンスを維持できます。

もちろん、ChatGPT は完璧ではありません。深層学習モデルとして、ChatGPT には 100% 正確であることができない欠陥があります。正確な回答が必要な一部の質問 (数学的な計算、論理的な計算など) については、推論、名前など) )、認識できるいくつかの明らかな間違いがあるでしょう。その後、いくつかの改良が加えられました。たとえば、情報の参照 Web リンクを提供する作品もあります。Facebook の最新の作品 ToolFormer では、生成されたモデルに特定のタスクを含めようとしています。一般的なモデルを使用する代わりに特定の API に計算を委ねることで、モデルが 100% 正確であることができないという問題を克服できると期待されています。この道が進めば、ディープ生成モデルが AGI のコア フレームワークになり、プラグインを通じて他のスキル API と統合されることが期待されます。

商業的には、ChatGPT は、Google などの検索エンジンが直面する課題について想像力をかき立てる一方で、自然言語理解に関連するさまざまな垂直製品への応用機会を誰もが目にしてきました。 ChatGPT が自然言語理解の分野で、検索レコメンデーションに匹敵する可能性のある新しいビジネス チャンスを生み出していることは疑いの余地がありません。

ChatGPT にはなぜこれほど驚くべき効果があるのでしょうか?主な理由の 1 つは、ChatGPT が大規模な生成モデル GPT3.5 に基づいて構築されているということです。GPT3.5 は、現在の自然言語理解分野におけるテキスト生成に最適なモデルであるはずです ( GPT3.5 は GPT3.0 よりも多く使用されます。より多くのデータとより大きなモデルを使用すると、より良い結果が得られます)。

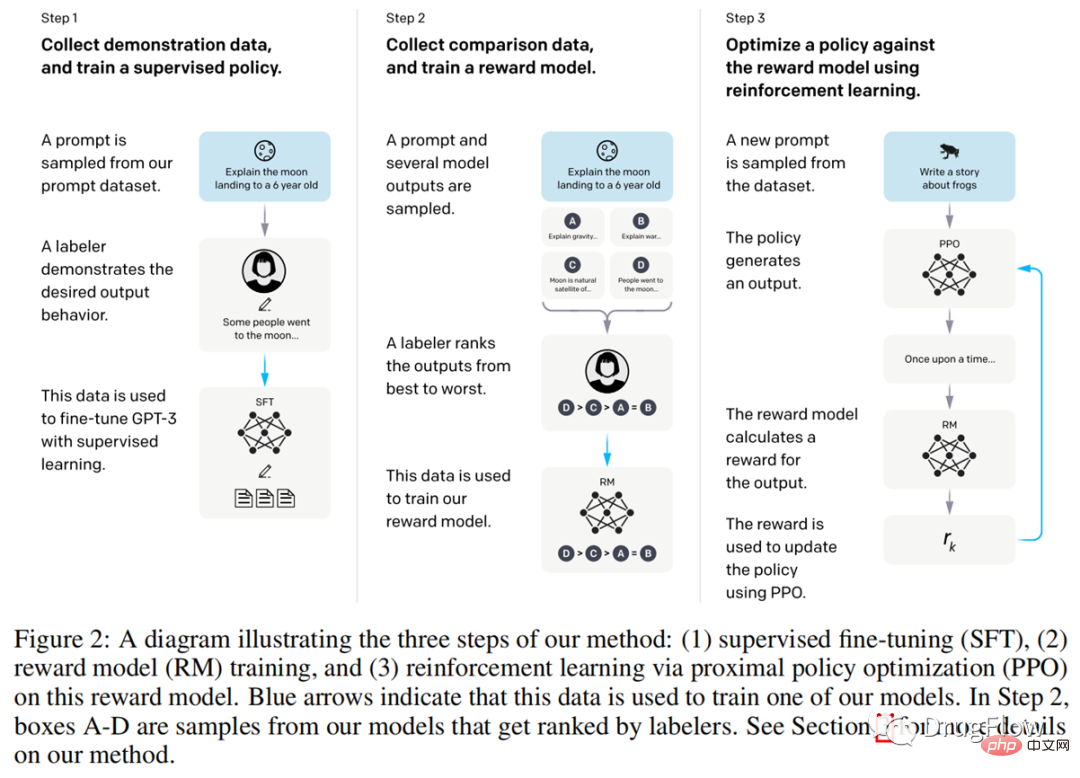

2 番目の主要な理由は、ヒューマン フィードバックに基づく強化学習テクノロジー、つまり Reinforcement Learning from Human Feedback (RLHF と略称) です。 。 OpenAI は ChatGPT に関する論文を発表しておらず、コードも公開していないため、一般的には、以前の記事 InstructGPT (https://arxiv.org/pdf/2203.02155.pdf) で開示されたテクノロジに最も類似していると考えられています。 )。以下の図に示すように、InstructGPT の説明によれば、最初のステップは、同じ質問に対するさまざまな回答に対するユーザーの嗜好データを収集することであり、2 番目のステップは、この嗜好データを使用して GPT モデルを再トレーニングすることです。監視情報の微調整について; 3 番目のステップは、さまざまな回答に対するユーザーの好みに応じてスコア関数をトレーニングすることです。ChatGPT の回答に対してスコアが与えられます。このスコアは、さまざまな回答に対するユーザーの好みを反映します。ステップは、このスコアリング関数を強化学習方法として使用することです。フィードバック (報酬) によって強化学習モデルがトレーニングされ、ChatGPT によって出力される最終的な回答は、ユーザーが好む回答に偏ったものになります。以上の処理により、ChatGPT は GPT3.5 に基づいてユーザー入力に対してより分かりやすい回答を出力します。

この新しいパラダイムは、人工知能の第 3 段階の中核となる駆動テクノロジーとなる可能性があります。つまり、最初は自己教師あり事前トレーニングの大規模モデルに基づいて、次に小規模なモデルに基づく強化学習テクノロジーと組み合わせられます。モデルを形成するための大量の高品質のデータ フィードバックと、さらなる技術的進歩を達成するためのデータの閉ループ フィードバック。

ChatGPT に関して、私たちの見解は次のとおりです。(1) ChatGPT はまさにこの研究の最高傑作です。時代 1 では、大規模なモデルを生成するための自己教師あり事前トレーニングと、少量の高品質データに基づく強化学習フィードバック戦略の結果に基づく AI の驚くべき効果を見てみましょう。これは、ある意味、私たちの認識を変えました。

(2) ChatGPT 関連技術は非常に大きな商業的価値を持っており、検索エンジンを含む多くの製品が再構築または破壊される機会に直面しており、これは間違いなく多くの新たなビジネス チャンスをもたらすでしょう。 NLP 分野全体が恩恵を受けるでしょう。

(3) 自己教師あり事前トレーニングに基づく生成大規模モデルと、少量の高品質データに基づく強化学習フィードバック戦略に基づく学習パラダイムが、今後、NLP分野を除く様々な分野の発展の原動力となるとともに、ライフサイエンス、ロボット工学、自動運転など様々な分野で新たな人工知能ブームを引き起こすことが期待されています。

(4) ChatGPT は、人工知能が人間の心を持っていることを証明するものではありません。ChatGPT が示す創造性と知性の一部は、自然言語理解コーパスに意味論と論理が含まれているためです。自然言語コーパスで訓練された生成モデルは、統計的な意味でこれらの対応関係を学習しており、知性を持っているように見えますが、実際には人間の心を持っていません。 ChatGPT は優れていますが、その知能が数歳の子供と同等であると言えるほど厳密ではありません。なぜなら、根本的に言えば、AI には人間が新しい知識を学習し、論理的推論、想像力、動作のフィードバックを実行する能力がまだ備わっていないからです。 ChatGPT のインテリジェンスと機能を過度に誇大宣伝すると、良質なコインが駆逐され、業界全体に悪影響を及ぼします。

(5) この分野では、中国の技術にはまだギャップがあります。過去 2 年間、GPT3.0 の効果を真に再現できるテキスト生成モデルは見つかりませんでした。GPT3 なしでは。 0 と 3.5、ChatGPT はありません。 GPT3、GPT3.5、ChatGPTなどの作品はオープンソースではなく、中国ではAPIすらブロックされているため、作品をコピーするのは現実的に困難です。もっと悲観的に言えば、ChatGPT の効果を再現したいほとんどのチームは成功しないでしょう。 (6) ChatGPT は、1 人か 2 人の研究者によって作られた画期的なアルゴリズムではなく、高度な概念に基づいた非常に複雑なアルゴリズム エンジニアリング システムの結果です。マッチング (OpenAI や DeepMind に類似)。純粋に研究志向のチームは成功しない可能性があり、ディープラーニングを十分に理解しておらず、エンジニアリング志向が強すぎるチームも成功しない可能性があります。このチームには次のものが必要です: 第一に、高価なディープ ラーニング トレーニングと人材採用をサポートするための十分なリソース サポート; 第二に、業界の大規模モデル チームのエンジニアリングを真に主導してきた専門家リーダー ChatGPT にはアルゴリズムの革新があるだけでなく、エンジニアリング システムの革新もあります。第三に、そしておそらく最も重要なことは、団結し、協力し、統一されたリーダーシップを持ち、論文の出版を追求しない組織が必要であるということです (緩い組織はアルゴリズムの革新には役立ちますが、工学的アルゴリズムの研究には役に立ちません)。素晴らしいエンジニアリングとアルゴリズムの才能の持ち主です。 (7) 私たちは ChatGPT の作成を追求するだけでなく、その背後にある技術革新も追求し続けます。つまり、大規模なモデルを生成するための自己教師あり事前トレーニングを精力的に開発し、少量の高品質データに基づく強化学習フィードバック戦略技術は、次世代ChatGPTの中核技術であるだけでなく、人工知能分野全体の進歩を促進する技術でもあります。最大の懸念は、投機やトレンドの追従による権力の分散により多くのリソースが浪費されること、あるいはChatGPTの過剰な宣伝が業界にダメージを与えることである。 (8) ChatGPT にはまだ改善の余地があり、注目と期待に値する唯一の技術ではありません。 AI に関する最も一般的な誤解は、その短期的なパフォーマンスを過大評価し、長期的なパフォーマンスを過小評価することです。 AIが中核的な推進力となる素晴らしい時代ですが、AIがすぐに万能になるわけではなく、長期的な努力が必要です。 ここでは、2012 年以来ディープラーニングによって引き起こされた新世代の人工知能の波における主要なテクノロジーの進化を簡単に要約します: (1 ) 第 1 段階での重要な進歩は、 ラベルが付いたデータ駆動型教師あり深層学習モデル # であり、モデル表現機能が大幅に向上し、それによって人工知能テクノロジーの大幅な進歩が促進されます。コンピュータ ビジョンと音声認識の分野における主な制限は、ラベル付きデータが比較的高価であるため、取得できるデータ量が制限され、その結果、データがサポートできる有効なモデル サイズが制限されることです。 #(2) 第 2 段階での重要な進歩は、ビッグデータによって駆動される一般的な大規模モデルの自己教師あり事前トレーニングです、自己教師あり事前トレーニング トレーニング テクノロジーにより、利用可能なトレーニング データが数桁改善され、モデル サイズの数桁の向上がサポートされ、データに依存する必要のないユニバーサル モデルになりました。再トレーニングのための下流のタスク フィールドです。この段階で、最も大きな進歩があり、最も活発なのは自然モデルです。言語理解の分野では、主な制限は、大規模なデータ トレーニングが必要であり、モデルが非常に大きいことです。トレーニングと使用にはコストがかかり、垂直シーン モデルを再トレーニングするのも非常に不便です。 (3) 第 3 段階はまだ確定していませんが、一定の傾向は見られます。 今後非常に重要な技術的鍵は、大規模モデルに基づいて、強化学習やプロンプトなどの手法を使用して、わずかな高負荷で大規模モデルの出力結果に大きな影響を与えることができるかどうかです。 -品質データ。この技術が普及すれば、自動運転、ロボット工学、ライフサイエンスなど、データ取得にコストがかかる分野が大きな恩恵を受けることになる。以前は、AI モデルの問題を改善したい場合は、大量のデータを収集してモデルを再トレーニングする必要がありました。オフラインでのインタラクションを必要とするロボットの分野で、事前にトレーニングされた大規模モデルに基づいて、実際のシーンで正しいアクションの選択と間違ったアクションの選択をロボットに通知することによってのみロボットの意思決定に影響を与えることができる場合、そのテクノロジーは無人運転とロボット工学の分野では、反復がより効率的になるでしょう。ライフサイエンスの分野において、ほんの少量の実験データのフィードバックがモデルの予測結果に大きな影響を与えることができれば、ライフサイエンス分野全体とコンピューティングの統合革命はさらに加速するでしょう。現時点では、ChatGPT は非常に重要なマイルストーンであり、これから多くの作業が必要になると思います。 私たちがより関心を持っている生命科学の分野に目を戻してみましょう。 ChatGPT によってもたらされた技術の進歩により、ほとんどの NLP 関連分野が改善されたため、ライフサイエンス分野における情報のクエリ、検索、抽出に関連する技術と製品が最初に恩恵を受けることになります。たとえば、将来、ライフ サイエンスの分野に会話型の垂直検索エンジンが登場する可能性はありますか? 専門家は、あらゆる質問 (病気、ターゲット、タンパク質など) をそれに質問できます。一方、判断 (それほど正確ではないかもしれませんが、おそらく正しいので、その分野を迅速に理解するのに役立ちます) は、特定のトピックに関する関連性の高い貴重な情報を提供することができ、間違いなく情報を大幅に改善します。専門家の処理効率。たとえば、患者が病気の知識や治療法について相談できるAI医師を構築することは可能でしょうか(技術的な限界があるため、AIは正確な答えを与えることができず、ましてや医師の代わりになることはできません)が、参考となる情報を多く提供できます。何をすべきかについての提案については、現在の検索エンジンよりもエクスペリエンスが大幅に向上していることは間違いありません。 ライフサイエンスの分野には、小分子とタンパク質の結合構造と親和性の予測、タンパク質とタンパク質の相互作用の予測、小分子の表現と特性予測など、重要な未解決の課題がまだ多くあります。 、タンパク質の物性予測、低分子生成、タンパク質設計、逆合成ルート設計などのタスク。現時点ではこれらの問題は完全には解決されていませんが、これらの課題がブレークスルーされれば、創薬、さらにはライフサイエンス分野全体が大きな変化を迎えることになるでしょう。 大規模モデルに基づく AIGC 分野と、専門家または実験的なフィードバックに基づく RLHF 分野は、ChatGPT の推進から恩恵を受け、間違いなく新たな技術進歩につながるでしょう。中でも、AIGC(人工知能コンテンツ生成)技術は、低分子生成とタンパク質設計の分野でこの1年で大きな進歩を遂げた。近い将来、以下のタスクが AIGC 生成技術の開発から大きな恩恵を受け、技術的ステップを生成すると予測します。 (1) 低分子生成および最適化技術。活性、創薬可能性、合成可能性などのさまざまな制約を考慮して、活性リガンド情報に依存するのではなく、タンパク質ポケット構造情報に基づいて小さなリガンド分子を生成する技術のこの部分は、AIGC分野の発展から大きな恩恵を受けるでしょう。 ## (2) 立体構造予測はある意味生成問題とみなすことができ、低分子やタンパク質結合立体構造予測タスクも AIGC 関連技術の開発から恩恵を受けるでしょう。 上記の AIGC 関連タスクと、活性予測、特性予測、合成ルート設計などを含むがこれらに限定されない、実験検証フィードバックを必要とするほぼすべてのタスク。 、RLHF テクノロジーから恩恵を受ける機会があり、配当がもたらされます。 もちろん、多くの課題があります。利用可能なデータ量に制限があるため、ライフ サイエンス分野で使用される現行世代のモデルはまだ比較的浅く、主に GNN などの浅い深層学習モデルが使用されます (GNN はメッセージ送信のスムーズさとレイヤー数によって制限されます) 3 層程度までしか使用できません。)、生成効果は十分な可能性を示していますが、それでも ChatGPT ほど驚くべきものではありません。専門家や実験のフィードバックに基づく強化学習技術は、実験データの生成速度や生成されるモデルの表現能力の不足によって限界があり、また、素晴らしい結果を提示するまでにはある程度の時間を要します。しかし、ChatGPT 技術の進化傾向から判断すると、十分に深く、十分に強力な表現能力を備えた大規模な生成モデルをトレーニングし、強化学習を使用して、少量の高レベルのデータに基づいて大規模なモデルの効果をさらに向上させることができれば、 -質の高い実験データや専門家のフィードバックがあれば、AIDDの分野に間違いなく革命が起こることが期待できます。 つまり、ChatGPT は自然言語理解の分野における技術進歩であるだけでなく、情報サービスとコンテンツ生成の分野における新たなビジネス トレンドの引き金となるでしょう。同時に、膨大なデータの深層生成技術と人間のフィードバックに基づく強化学習技術に基づく長期的な進歩の原動力となり、ライフサイエンスやその他の分野の急速な発展につながります。私たちは、AI テクノロジーの進歩と産業実装の新たな波をもたらします。

以上がChatGPT の成功の背後にある技術的理由と、ライフ サイエンス分野における ChatGPT のインスピレーションの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7486

7486

15

15

1377

1377

52

52

77

77

11

11

19

19

38

38

SQLに新しい列を追加する方法

Apr 09, 2025 pm 02:09 PM

SQLに新しい列を追加する方法

Apr 09, 2025 pm 02:09 PM

Alter Tableステートメントを使用して、SQLの既存のテーブルに新しい列を追加します。特定の手順には、テーブル名と列情報の決定、テーブルステートメントの変更、およびステートメントの実行が含まれます。たとえば、顧客テーブルに電子メール列を追加します(Varchar(50)):Alter Table Customersはメール(50)を追加します。

SQLに列を追加するための構文は何ですか

Apr 09, 2025 pm 02:51 PM

SQLに列を追加するための構文は何ですか

Apr 09, 2025 pm 02:51 PM

sqlに列を追加するための構文は、table table_name add column_name data_type [not null] [default default_value];です。 table_nameはテーブル名、column_nameは新しい列名、data_typeはデータ型であり、nullはnull値が許可されているかどうかを指定しない、デフォルトのdefault_valueがデフォルト値を指定します。

SQLクリアテーブル:パフォーマンスの最適化のヒント

Apr 09, 2025 pm 02:54 PM

SQLクリアテーブル:パフォーマンスの最適化のヒント

Apr 09, 2025 pm 02:54 PM

SQLテーブルクリアパフォーマンスを改善するためのヒント:削除の代わりにTruncateテーブルを使用し、スペースを解放し、ID列をリセットします。カスケードの削除を防ぐために、外部のキーの制約を無効にします。トランザクションカプセル化操作を使用して、データの一貫性を確保します。バッチはビッグデータを削除し、制限で行数を制限します。クリアリング後にインデックスを再構築して、クエリ効率を改善します。

sqlに列を追加するときにデフォルト値を設定する方法

Apr 09, 2025 pm 02:45 PM

sqlに列を追加するときにデフォルト値を設定する方法

Apr 09, 2025 pm 02:45 PM

新しく追加された列のデフォルト値を設定します。3つのテーブルステートメントを使用します。列の追加を指定し、デフォルト値を設定します:table table_name add column_name data_type default_valueを変更します。制約句を使用してデフォルト値を指定します。テーブルテーブルを変更する列列の追加column_name data_type constraint default_constraint default default_value;

削除ステートメントを使用して、SQLテーブルをクリアします

Apr 09, 2025 pm 03:00 PM

削除ステートメントを使用して、SQLテーブルをクリアします

Apr 09, 2025 pm 03:00 PM

はい、削除ステートメントを使用してSQLテーブルをクリアできます。手順は次のとおりです。クリアするテーブルの名前にtable_nameを置き換えます。

Redisメモリの断片化に対処する方法は?

Apr 10, 2025 pm 02:24 PM

Redisメモリの断片化に対処する方法は?

Apr 10, 2025 pm 02:24 PM

Redisメモリの断片化とは、再割り当てできない割り当てられたメモリ内に小さな自由領域の存在を指します。対処戦略には、Redisの再起動:メモリを完全にクリアしますが、サービスを割り当てます。データ構造の最適化:Redisに適した構造を使用して、メモリの割り当てとリリースの数を減らします。構成パラメーターの調整:ポリシーを使用して、最近使用されていないキー価値ペアを排除します。永続性メカニズムを使用します:データを定期的にバックアップし、Redisを再起動してフラグメントをクリーンアップします。メモリの使用量を監視する:問題をタイムリーに発見し、対策を講じる。

phpmyAdminはデータテーブルを作成します

Apr 10, 2025 pm 11:00 PM

phpmyAdminはデータテーブルを作成します

Apr 10, 2025 pm 11:00 PM

phpMyAdminを使用してデータテーブルを作成するには、次の手順が不可欠です。データベースに接続して、[新しいタブ]をクリックします。テーブルに名前を付けて、ストレージエンジンを選択します(InnoDB推奨)。列名、データ型、null値、その他のプロパティを許可するかどうかなど、列の追加ボタンをクリックして列の詳細を追加します。一次キーとして1つ以上の列を選択します。 [保存]ボタンをクリックして、テーブルと列を作成します。

Oracleデータベースの作成方法Oracleデータベースを作成する方法

Apr 11, 2025 pm 02:33 PM

Oracleデータベースの作成方法Oracleデータベースを作成する方法

Apr 11, 2025 pm 02:33 PM

Oracleデータベースを作成するのは簡単ではありません。根本的なメカニズムを理解する必要があります。 1.データベースとOracle DBMSの概念を理解する必要があります。 2。SID、CDB(コンテナデータベース)、PDB(プラグ可能なデータベース)などのコアコンセプトをマスターします。 3。SQL*Plusを使用してCDBを作成し、PDBを作成するには、サイズ、データファイルの数、パスなどのパラメーターを指定する必要があります。 4.高度なアプリケーションは、文字セット、メモリ、その他のパラメーターを調整し、パフォーマンスチューニングを実行する必要があります。 5.ディスクスペース、アクセス許可、パラメーター設定に注意し、データベースのパフォーマンスを継続的に監視および最適化します。 それを巧みに習得することによってのみ、継続的な練習が必要であることは、Oracleデータベースの作成と管理を本当に理解できます。