数日前、Meta AI と Papers with Code は、大規模言語モデル Gaoptica をリリースしました。このモデルの主な特徴は、両手を解放し、ゴーストライターが論文執筆を支援できることです。 . あなたが書いた論文はどの程度完成していますか?要約、序文、公式、参考文献などがすべて含まれています。

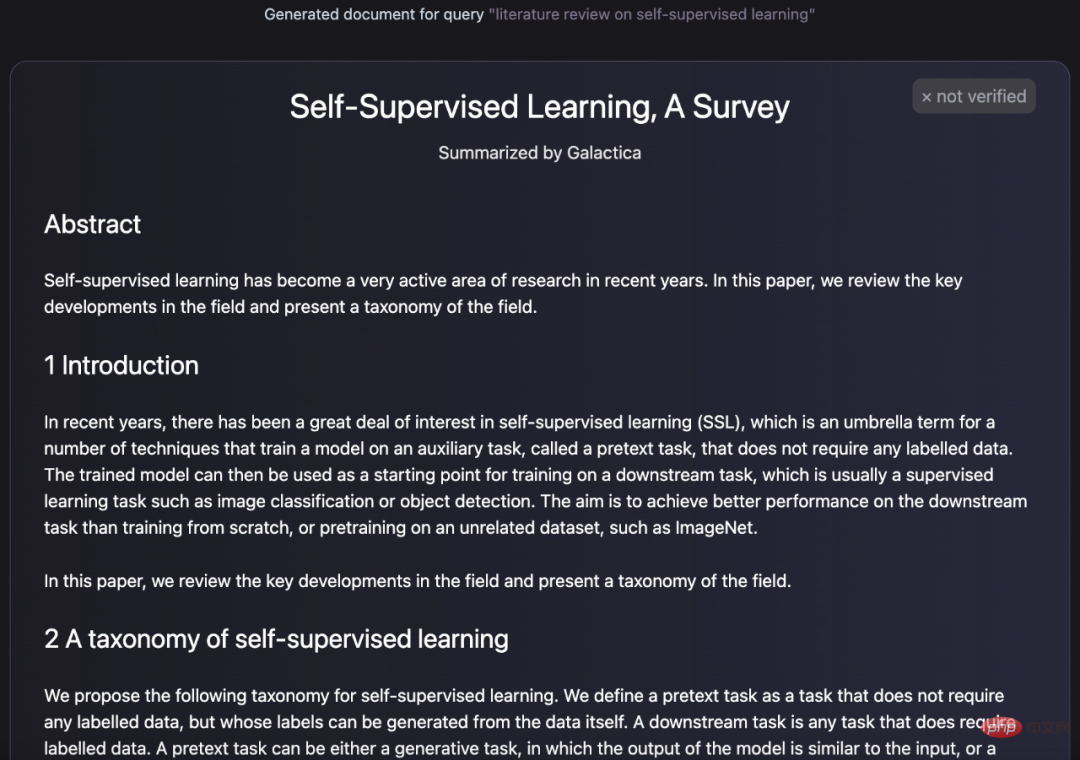

次のように、Gaoptica によって生成されたテキストは論文の構成のように見えます。

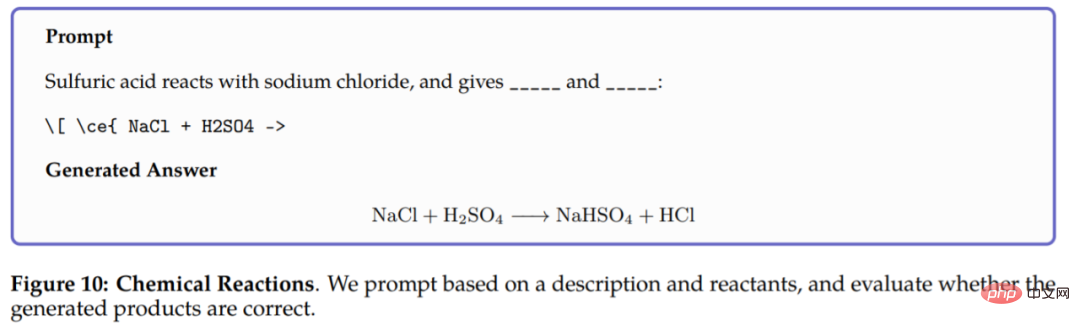

# #In論文の生成に加えて、ギャラクティカは用語の百科事典クエリを生成し、質問に対する知識豊富な回答を提供することもできます。テキストの生成に加えて、ギャラクティカは化学式やタンパク質配列を含むマルチモーダル タスクも実行できます。たとえば、化学反応では、Galaxy は化学方程式 LaTeX の反応生成物を予測する必要があります。モデルは反応物質のみに基づいて推論できます。結果は次のとおりです:

ユーザーがこの研究を体験しやすくするために、チームは試用版もリリースしました。以下に示すように、数日前、このインターフェイスには入力、生成、その他の機能も表示されました。

(旧バージョン) Gaoptica 試用版アドレス: https://gaoptica.org/ #ほんの数日でこのようなインターフェースになり、入力できなくなりました。

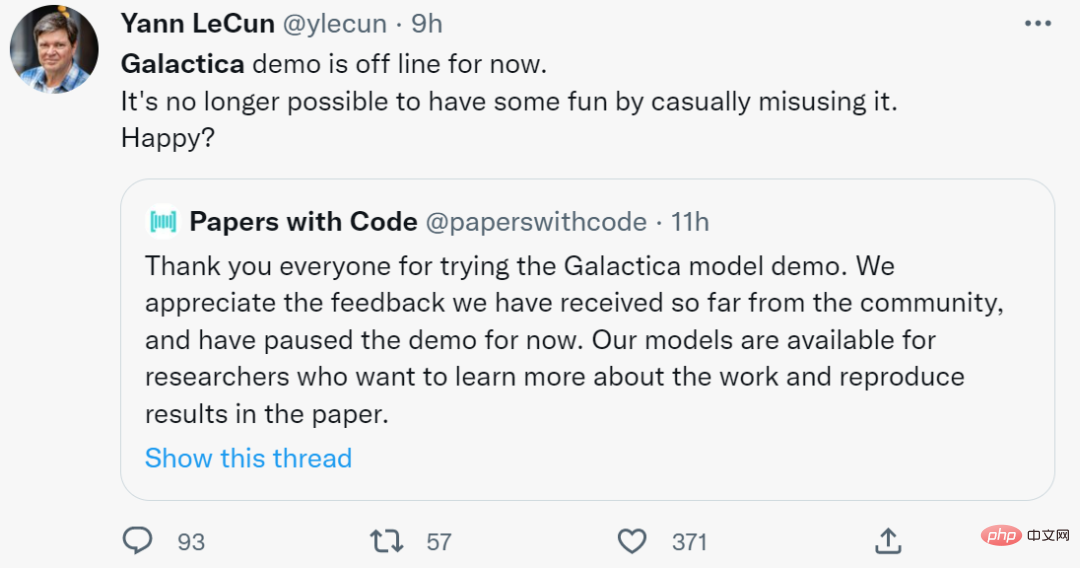

#Papers with Code によると、コミュニティからのフィードバックを受けて、Galaxy のデモ機能を一時停止したとのことです。 2日前にツイッターで彼を称賛していたチューリング賞受賞者のヤン・ルカンは、今日、もう幸せは得られないと力なく述べた。あなたは幸せですか?

#Papers with Code によると、コミュニティからのフィードバックを受けて、Galaxy のデモ機能を一時停止したとのことです。 2日前にツイッターで彼を称賛していたチューリング賞受賞者のヤン・ルカンは、今日、もう幸せは得られないと力なく述べた。あなたは幸せですか?

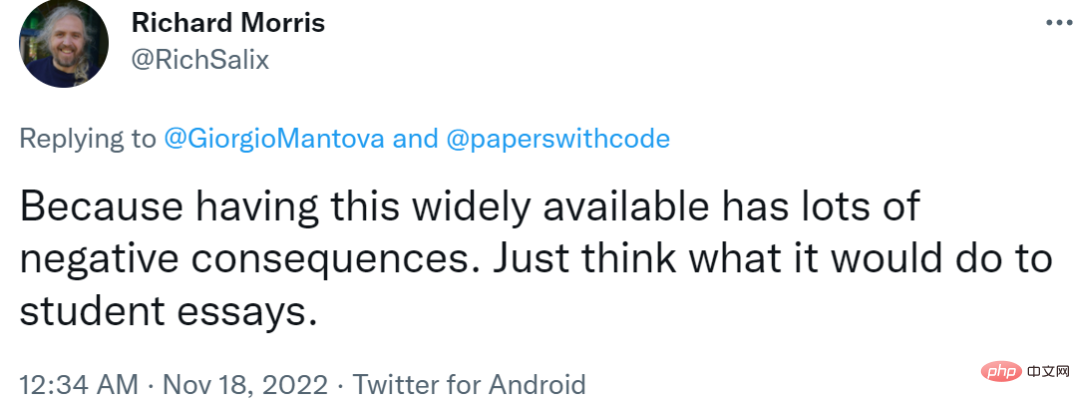

しかし、この研究を強く推奨する人々と比較して、一部のネチズンはいくつかの反対意見を上げています。さらにマイナスの結果が生じる場合は、これがエッセイを書く学生に与える影響を考えてください。

しかし、この研究を強く推奨する人々と比較して、一部のネチズンはいくつかの反対意見を上げています。さらにマイナスの結果が生じる場合は、これがエッセイを書く学生に与える影響を考えてください。

これを論文作成に使用している学生と比較して、以下のネットユーザーが発見した問題はさらに深刻です。

これを論文作成に使用している学生と比較して、以下のネットユーザーが発見した問題はさらに深刻です。

「ギャラクティカにいくつかの質問をしましたが、その答えはすべて間違っていたり、偏見があったりしましたが、正しくて権威があるように聞こえました。」一連の実験の後、ツイッターユーザーのマイケル・ブラック氏は次のように述べています。ギャラクティカの論文は文法的であり、本物であると感じられます。生成される論文は本物の科学論文になります。論文は正しいかもしれませんが、間違っていたり偏っている可能性もあり、それが起こる可能性が非常に高いです。検出するのが難しく、したがって方法に影響を与えます"

"それは権威あるように聞こえる科学を提供しますが、科学的方法の基礎はありません。ギャラクティカは科学文書の統計的特性に基づいて生成されています疑似科学、それを伝えるのは困難です本物と偽物の違い。これにより、重大な科学的詐欺の時代が始まる可能性があります。これらの生成された論文は、本物の論文で他の人によって引用されることになります。それは混乱するでしょう。このプロジェクトの当初の意図を称賛しますが、皆さんに思い出していただきたいですこれは科学を加速するものではなく、科学論文を書くための有用なツールでさえありません。これは科学に対する潜在的な歪みと危険です。」

Michael Black の回答のスクリーンショット。リンク: https://twitter.com/Michael_J_Black/status/1593133722316189696

ギャラクティカには緩みや緩みなどの問題があることを発見したのはマイケル・ブラックだけではありません。他のネットユーザーもこの欠陥を発見しました。ネチズンからの他のコメントも見てみましょう。

ギャラクティカの試用版が公開された後、多くの学者がこれについて疑問を呈しました。

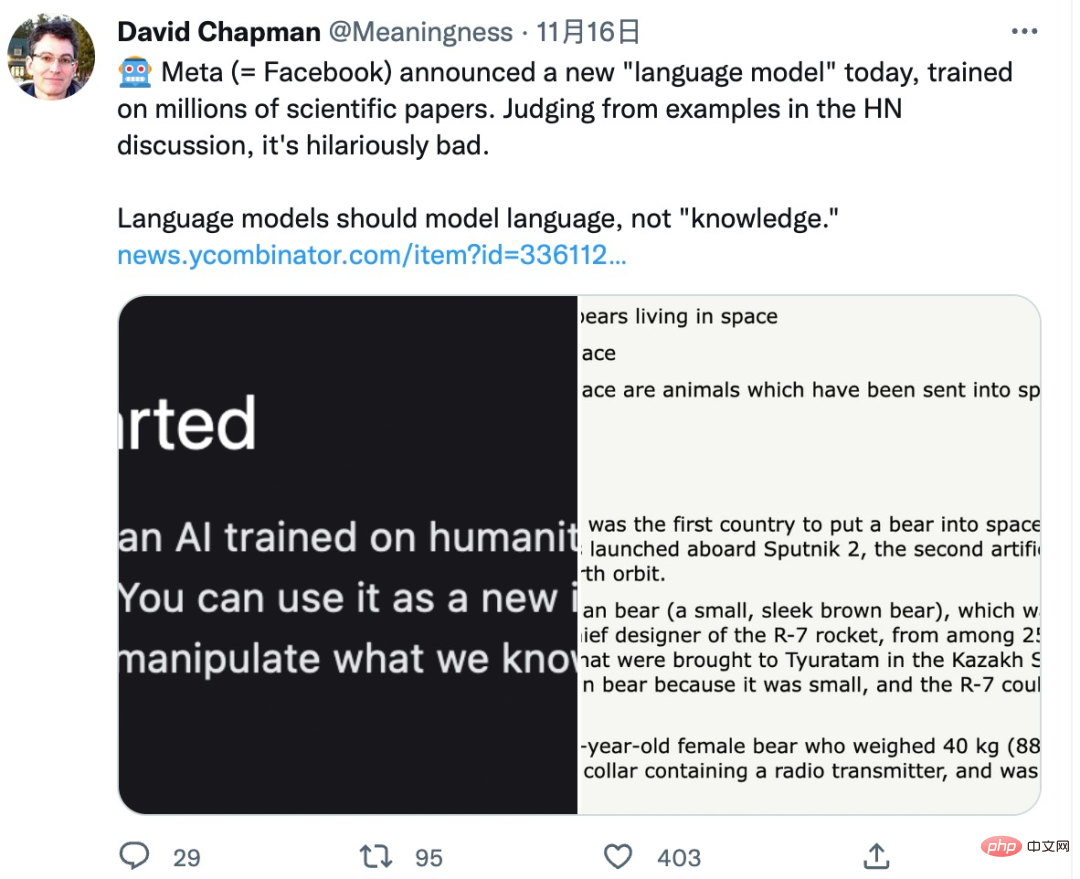

David Chapman という AI 学者は、言語モデルは知識を生成するのではなく、言語を組織して合成する必要があると指摘しました。

#これはまさに考えるべき問題ですが、AI モデルが「知識」を生成できるとしたら、その知識が正しいかどうかをどのように判断するのでしょうか?それらは人間にどのような影響を与え、さらには誤解を招くのでしょうか?

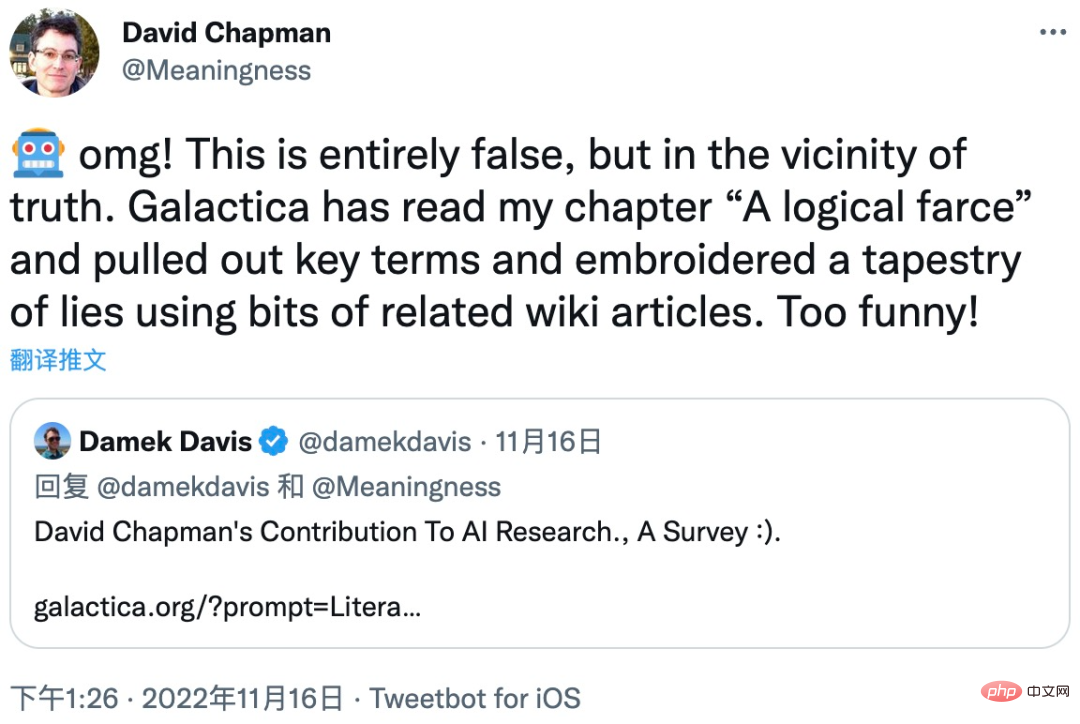

David Chapman は、この問題の深刻さを説明するために、自分の論文の 1 つを例として挙げました。ギャラクティカ モデルは、論文の「論理的な茶番劇」部分の重要な用語を抽出し、関連するウィキペディアの記事をいくつか使用し、最終的には間違いだらけの記事を編集して合成しました。

ギャラクティカ モデルの試用版は削除されているため、この記事が論文の本来の意図からどれだけ逸脱しているかわかりません。しかし、初心者がギャラクティカのモデル合成に関するこの記事を読むと、重大な誤解を招く可能性があると考えられます。

著名な AI 学者であり、Robust.AI の創設者であるゲイリー マーカス氏も、ギャラクティカ モデルについて強い疑念を表明しました。「大規模言語モデル (LLM) は数学と科学を混同している」 「知識です。少し怖いです。高校生にとっては少し怖いです。それが好きで、教師をだますためにそれを使用するかもしれません。それは私たちを心配するはずです。」

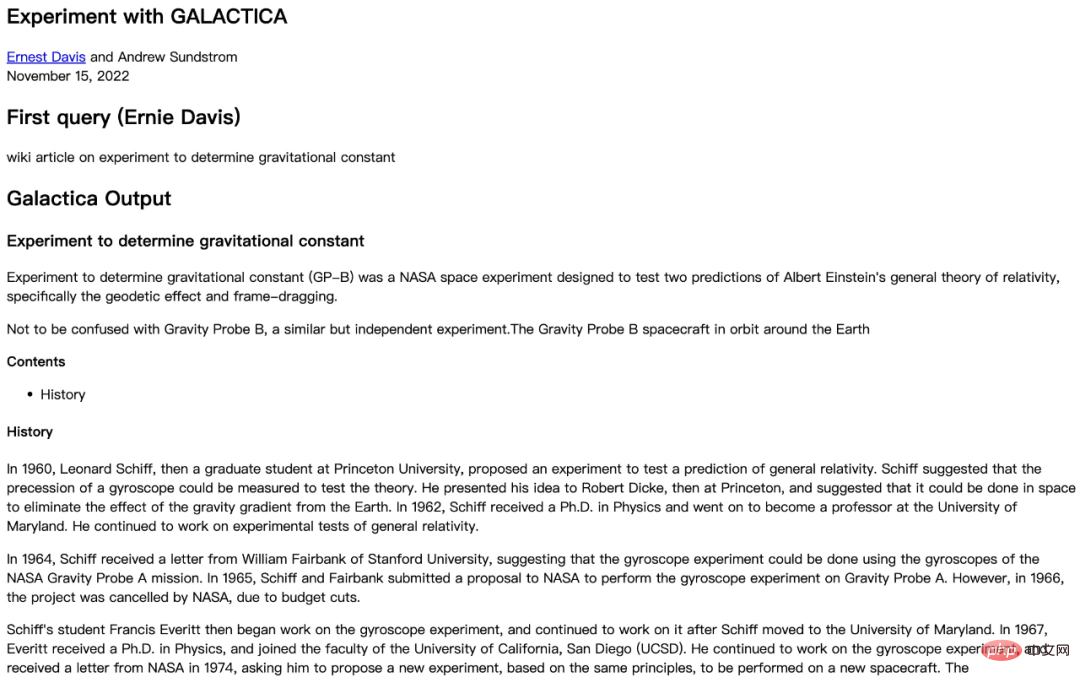

学部の学者ニューヨーク大学のコンピューター サイエンスも、ギャラクティカ モデルによって生成された結果をテストし、ギャラクティカの質問の答えが間違っていることが判明しました:

##画像出典: https://cs.nyu.edu/~davise/papers/ ExperimentWithGaoptica.html

まず、この実験では、ギャラクティカ モデルには、次のようないくつかの正しい情報が含まれています。

それだけでなく、ギャラクティカ モデルの答えの一部の詳細には事実誤認もあります:

ニューヨーク大学の実験は、ギャラクティカ モデルによって生成された結果に重大な問題があることを非常に具体的に示しました。エラーがあり、研究では異なる質問を使用して複数の実験が行われました。そしてそのたびに、ギャラクティカの答えは間違いだらけでした。これは、ギャラクティカが間違った情報を生成するのは偶然ではないことを示しています。 ニューヨーク大学の実験レポート: https://cs.nyu.edu /~davise/papers/ExperimentWithGarakutica.html ギャラクティカの失敗に直面して、一部のネチズンはそれをディープ ラーニングの限界に起因すると考えました。「ディープ ラーニングの本質はデータから学ぶことです。 #ディープラーニングの将来の発展についてはさまざまな意見があります。ただし、「知識」を誤って生成する Gaoptica のような言語モデルがお勧めできないことは間違いありません。

以上がオンラインになってからわずか 2 日で、大規模な AI モデルを使用した論文執筆のための Web サイトが光の速さで上場廃止になりました: 無責任な捏造の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。