リー・フェイフェイの2人の弟子が共同指導:「マルチモーダル・プロンプト」を理解できるロボットはゼロショットのパフォーマンスを2.9倍向上させることができる

人工知能の分野における次の開発の機会は、AI モデルに「身体」を装備し、現実世界と対話して学習することかもしれません。

既存の自然言語処理、コンピュータ ビジョン、および特定の環境で実行されるその他のタスクと比較すると、オープン フィールド ロボティクスは明らかに災害の可能性が高くなります。

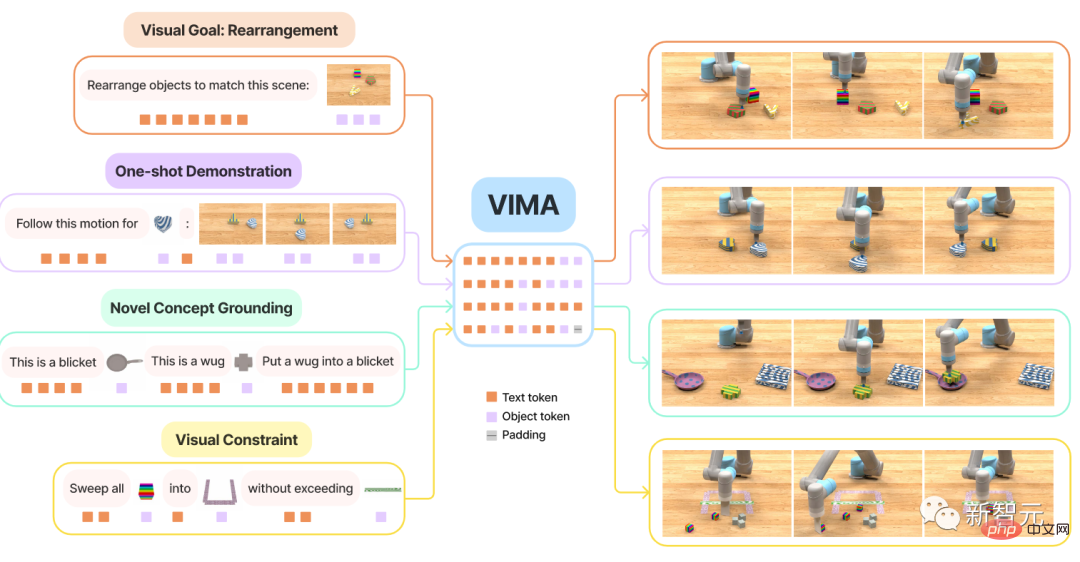

たとえば、プロンプトベースの学習では、単一の言語モデルで、コードの作成、要約の実行、プロンプトを変更するだけで、質問に答えることができます。

しかし、ロボット工学では、単一のサンプル デモンストレーションを模倣する、言語の指示に従う、または特定の視覚的な目標を達成するなど、さらに多くの種類のタスク仕様が存在します。通常、さまざまなタスクについて考慮され、それらは 特別に訓練されたモデル によって処理されます。

最近、NVIDIA、スタンフォード大学、マカレスター大学、カリフォルニア工科大学、清華大学、テキサス大学オースティン校の研究者が共同で、Transformer に基づく ユニバーサル ロボットを提案しました。インテリジェント エージェント VIMA は、マルチモーダル プロンプトを使用して、非常に高い 汎化パフォーマンスを実現し、多数のロボット操作タスクを処理できます。

紙のリンク: https://arxiv.org/abs/2210.03094

プロジェクト リンク: https://vimalabs.github.io/

## コード リンク: https://github.com/vimalabs/VIMA入力プロンプトは、

インターリーブされたテキストとビジュアル シンボルです。 VIMA をトレーニングして評価するために、研究者らは、マルチモーダル キューを含む手続き的に生成された何千もの画像、デスクトップ タスク、および 600,000 を超える専門家の軌跡を含む

新しいシミュレーション ベンチマーク データセットを提案します。は模倣学習に使用され、 4 つのレベルでモデルの汎化パフォーマンスを評価します。 同じサイズのモデルと同じ量のトレーニング データを使用し、最も困難なゼロショット汎化設定での VIMA のタスク成功率は現在の sota メソッド 2.9 の成功率です。回

。トレーニング データが 10 倍少ないにもかかわらず、VIMA は他の方法よりも 2.7 倍優れたパフォーマンスを発揮します。

現在、すべてのコード、事前トレーニングされたモデル、データセット、シミュレーションベンチマークは 完全にオープンソース

です。この論文の筆頭著者は、スタンフォード大学の修士 2 年生で、現在 NVIDIA Research Institute でインターンをしている Yunfan Jiang

です。 2020年にエディンバラ大学を卒業。彼の主な研究方向は、環境との相互作用を通じて学習する身体化人工知能 (身体化 AI) です。具体的な研究内容は、大規模な基本モデルを使用してオープンな身体化エージェントを実装する方法です。

論文には TwoMentors

TwoMentors

Zhu Yuke

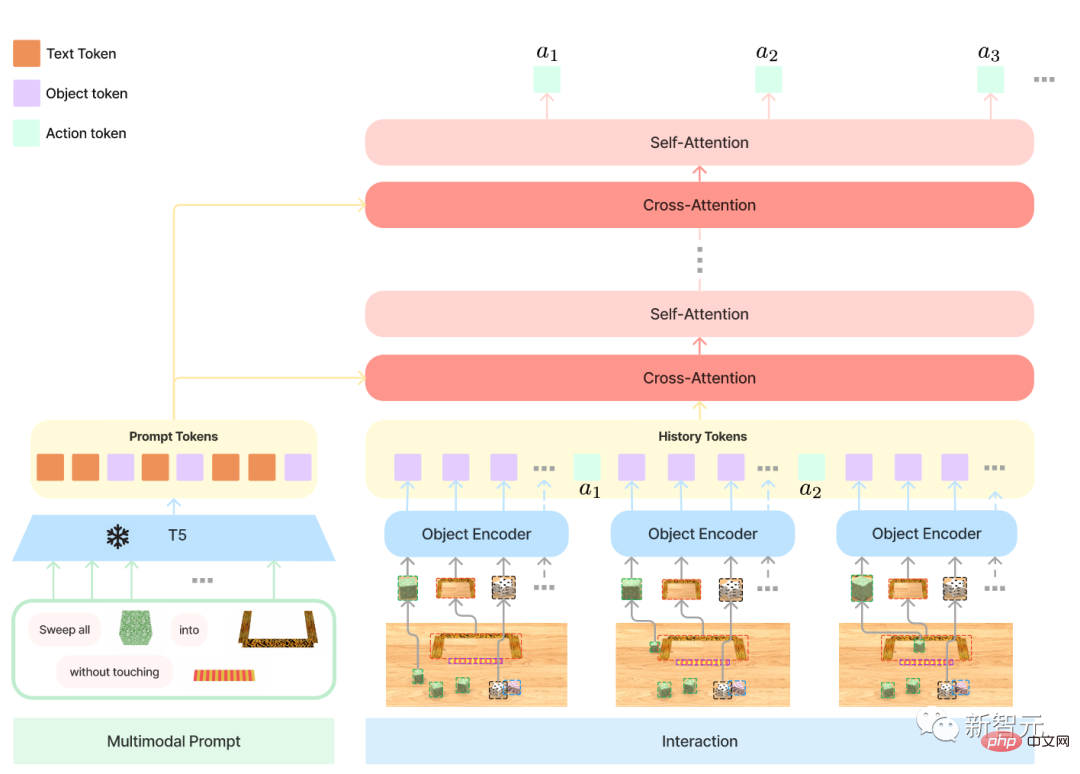

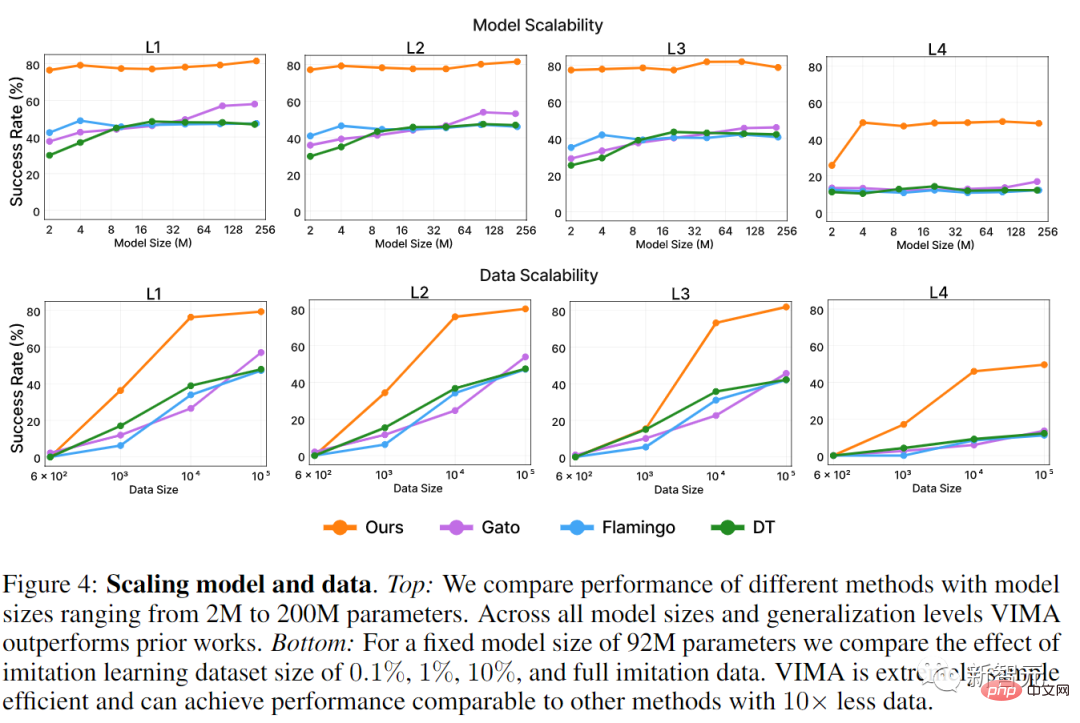

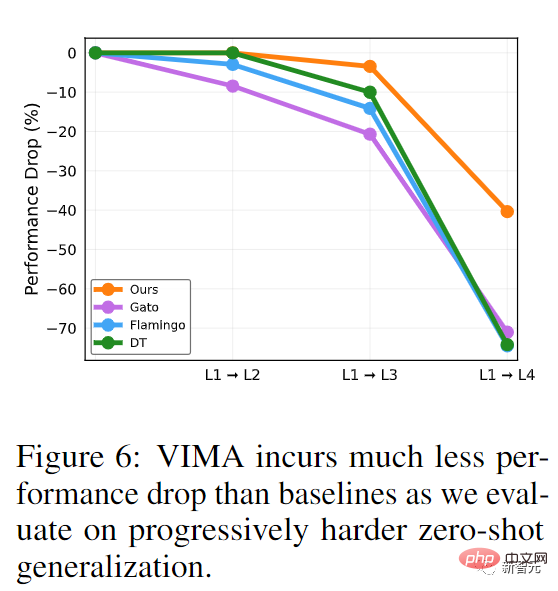

は、浙江大学を学士号を取得して卒業し、浙江大学とカナダのサイモン フレイザー大学で二重学位を取得しました。修士課程と博士課程の学生はスタンフォード大学でリー・フェイフェイ氏の指導の下で学び、2019年8月に博士号を取得した。 Zhu Yuke は現在、UT オースティン校コンピューター サイエンス学部の助教授、ロボット知覚学習研究所の所長、および NVIDIA 研究所の上級研究員を務めています。Fan Linxi は、リー フェイフェイの指導の下、スタンフォード大学で博士号を取得し卒業し、現在は NVIDIA AI の研究員です。主な研究方向は、一般的に機能する自律エージェントの開発であり、具体的な研究作業には、基本モデル、ポリシー学習、ロボット工学、マルチモーダル学習、および大規模システムが含まれます。 Transformer は、NLP の分野でマルチタスクにおいて非常に高いパフォーマンスを実現しました。質疑応答を完了できるのは 1 つのモデルだけです。翻訳とテキストを同時に表示、要約など さまざまなタスクを実装するためのインターフェイスは入力テキスト プロンプト内にあり、それによって特定のタスク要件が一般的な大規模モデルに渡されます。 このプロンプト インターフェイスは一般的なロボット エージェントでも使用できますか? 家事ロボットの場合、理想的には、「GET ME 」と入力するだけで、ロボットが画像に従ってカップを受け取ることができます。やって来る。 ロボットが新しいスキルを学習する必要がある場合は、ビデオのデモンストレーションを入力して学習するのが最善です。ロボットが見慣れないオブジェクトと対話する必要がある場合は、図だけで簡単に説明できます。 同時に、安全な展開を確保するために、ユーザーは 部屋に入らないでください などの視覚的な制約をさらに指定できます。 ##これらの機能を実現するために、VIMA モデルは主に 1、 形式の 3 つの部分で構成されています。マルチモーダル プロンプト 、ロボット 操作タスクはシーケンス モデリング問題に変換されます; 2. 新しい ロボット エージェント モデル 、複数の機能が可能です-タスク操作 3. エージェントのスケーラビリティと汎用性を体系的に評価するための、さまざまなタスクを使用した 大規模ベンチマーク まず、マルチモーダル プロンプトによってもたらされる柔軟性により、開発者は多数のタスク仕様をサポートするモデルを指定および構築できます。このペーパーでは主に 6 種類のタスクについて検討します。 1、単純なオブジェクト操作、タスク プロンプトは、 を 視覚的な目標到達を実現する、再配置などの目標設定を達成するためにオブジェクトを操作する; 新しい概念を受け入れる (小説)概念の基礎) 、プロンプトには、dax、blicket などの珍しい単語が含まれています。これらの単語は、プロンプト内の画像で説明し、指示の中で直接使用できます。これにより、エージェントの新しい単語の認識をテストできます。速度を知る; ワンショットビデオの模倣、ビデオデモンストレーションを見て、特定のオブジェクトが再現される方法を学ぶ; 視覚的な制約を満たす。ロボットは安全制限に違反しないようにオブジェクトを慎重に操作する必要があります。 視覚的推論(視覚的推論)、一部のタスクではエージェントが推論できる必要があります。たとえば、「すべてのオブジェクトを と同じテクスチャでコンテナに入れる」、または「」などの視覚的な記憶が必要です。 をコンテナに入れて、元の位置に戻します。" 相互に排他的ではないことに注意してください、たとえば、タスクによっては、デモビデオ (模倣) を通じて、これまでに見たことのない動詞 (新しい概念) が導入される場合があります。 #新しいベンチマーク VIM-BENCH マルチモーダル ロボット学習ベンチマーク VIMA-BENCH としていくつかのサポート データも用意しました。 シミュレーション環境(シミュレーション環境)では、既存のベンチマークは通常、特定のタスク仕様を目的としています。現時点では、豊富なマルチモーダル タスク スイートと包括的な A テストを提供できるベンチマークはありません。ターゲットを絞った方法でエージェントの機能を検出するプラットフォーム。 この目的を達成するために、研究者らは、Ravens ロボット シミュレーターを拡張して、オブジェクトとテクスチャの拡張可能なコレクションをサポートし、マルチモーダルなキューを構成し、多数のキューを手続き的に生成することで VIMA-BENCH を構築しました。タスク。 具体的には、VIMA-BENCH は、マルチモーダル プロンプト テンプレートを備えた 17 のメタタスクを提供し、これらを 1000 の独立したタスクにインスタンス化できます。各メタタスクは、上記の 6 つのタスク指定方法の 1 つ以上に属します。 VIMA-BENCH は、スクリプト化された Oracle エージェントを通じて大量の模倣学習データを生成できます。 観察とアクションでは、シミュレータの観察空間は、正面および上から見たビューからレンダリングされた RGB 画像で構成され、ベースラインのリアルなオブジェクトのセグメンテーションと境界ボックスも提供されます。オブジェクト中心モデルのトレーニング用。 VIM-BENCH は、前作からの高度なアクション空間を継承しており、具体的には「ピックアンドプレイス」「ワイプ」などの最も基本的な動作スキルで構成されています。終末効果は姿勢によって決まります。 シミュレータには、すべてのオブジェクトの正確な位置やマルチモーダル命令などの特権付きシミュレータ状態情報を使用できる スクリプト化された Oracle プログラム もあります。 基本的な説明そして専門家のデモンストレーション。 最後に、研究者らは、事前にプログラムされたオラクルによる模倣学習のための専門家の軌跡の大規模なオフライン データセットを生成しました。データセットにはメタタスクごとに 50,000 の軌跡が含まれており、合計で 650,000 の成功した軌跡になります。 また、評価を容易にするためにオブジェクト モデルとテクスチャのサブセットを保持し、17 のメタタスクのうち 4 つをゼロショット汎化テストに使用します。 VIMA-BENCH の各タスク規格には成功と失敗のみがあり、中間状態に対する報酬信号はありません。 テスト時に、研究者は物理シミュレーターでエージェント戦略を実行して成功率を計算しました。評価されたすべてのメタタスクの平均成功率が最終的に報告される指標となります。 評価プロトコルには 4 つのレベル が含まれており、体系的に エージェントの汎化能力を調査します 。各レベルはトレーニングの分布からさらに逸脱しています。したがって、厳密に言えば、一方のレベルはもう一方のレベルより難しいです。 1、配置の一般化 : トレーニング プロセス中は、すべてのプロンプトがそのまま表示されますが、テスト中は、デスクトップ上のオブジェクトの配置はランダムです。 2、組み合わせ一般化: すべてのマテリアル (形容詞) と 3 次元オブジェクト (名詞) はトレーニング中に表示されますが、一部の新しい組み合わせがトレーニング中に表示されます。テスト。 3. 新しいオブジェクトの一般化: テスト プロンプトとシミュレートされたワークスペースには、新しい形容詞とオブジェクトが含まれています。 #4、新しいタスクの一般化: テスト中の新しいプロンプト テンプレートを使用した新しいメタタスク マルチモーダル プロンプトには、合計 3 つの形式が含まれています: 1、Text、事前トレーニングされた T5 モデルを使用します。単語のセグメンテーションを実行し、ワード ベクトルを取得します。 2、デスクトップ シーン全体、最初にマスク R-CNN を使用してすべての独立したオブジェクトを識別します。各オブジェクトは境界ボックスで表され、画像表現をトリミングし、バウンディング ボー エンコーダと ViT をそれぞれ使用してエンコードします。 3、単一オブジェクトの画像も、ViT を使用してトークンを取得し、結果のシーケンスを事前トレーニングされた T5 エンコーダー モデルに入力します。 ロボット コントローラー、つまりデコーダーの入力は、プロンプト シーケンス上の複数のクロスアテンション レイヤー後の表現と軌跡です。 。 このような設計により、プロンプトへの接続が強化され、元のプロンプト トークンをより深く保持して処理できるようになり、コンピューティング効率が向上します。 テスト段階の 実験計画 は、主に 3 つの質問に答えることです: 1、VIMAマルチモーダル プロンプトを使用したさまざまなタスクにおける以前の SOTA Transformer ベースのエージェントとのパフォーマンスの比較; 2、モデル容量とデータ ボリュームのスケーリング プロパティにおける VIMA; ##3. ビジュアルワードセグメンタ、条件プロンプト、条件エンコーディングの違いが最終的な決定に影響します。 比較されるベースライン モデルには、Gato、Flamingo、Decision Transformer(DT) が含まれます。 最初に モデル スケーリング (モデル スケーリング) について、研究者は 2M から 200M のパラメーター サイズのすべてのメソッドをトレーニングし、エンコーダーのサイズは常に T5 ベースに維持されました。 VIMA は、あらゆるレベルでのゼロショット汎化評価において、他の作品よりも明らかに優れています。 Gato と Flamingo はより大きなサイズのモデルでパフォーマンスが向上しましたが、VIMA は依然としてすべてのモデルよりも優れています。 データ スケーリング (データ スケーリング) では、研究者は各手法のトレーニング データに 0.1%、1% を採用しました。 、10% および完全な模倣学習データセットに対するさまざまな実験では、VIMA は 10 倍のデータでトレーニングされた他の手法の L1 および L2 汎化指標を達成するために必要なデータは 1% だけです。 L4 指標では、トレーニング データのわずか 1% で、VIMA はすでに全量のデータでトレーニングされた他のモデルよりも優れています。 プログレッシブ汎化 (漸進的汎化) のパフォーマンス比較では、より困難な汎化タスクでは、Apply がありません。微調整。 VIMA モデルは、特に L1 から L2 および L1 から L3 でパフォーマンスの低下が最も少ないのに対し、他のモデルは 20% 以上低下しています。これは、VIMA がより一般化された戦略とより堅牢な表現を学習したことも意味します。 参考: https://arxiv.org/ abs /2210.03094ロボットとマルチモーダル プロンプト

以上がリー・フェイフェイの2人の弟子が共同指導:「マルチモーダル・プロンプト」を理解できるロボットはゼロショットのパフォーマンスを2.9倍向上させることができるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

107

107

飛び回ったり、口を開けたり、見つめたり、眉毛を上げたりする顔の特徴をAIが完璧に模倣し、ビデオ詐欺を防ぐことは不可能

Dec 14, 2023 pm 11:30 PM

飛び回ったり、口を開けたり、見つめたり、眉毛を上げたりする顔の特徴をAIが完璧に模倣し、ビデオ詐欺を防ぐことは不可能

Dec 14, 2023 pm 11:30 PM

これほど強力なAIの模倣能力では、それを防ぐことは本当に不可能です。 AIの発展は今ここまで進んでいるのか?前足で顔の特徴を浮き上がらせ、後ろ足で全く同じ表情を再現し、見つめたり、眉を上げたり、口をとがらせたり、どんなに大袈裟な表情でも完璧に真似しています。難易度を上げて、眉毛を高く上げ、目を大きく開き、口の形も歪んでいるなど、バーチャルキャラクターアバターで表情を完璧に再現できます。左側のパラメータを調整すると、右側の仮想アバターもそれに合わせて動きが変化し、口や目の部分がアップになります。同じです(右端)。この研究は、GaussianAvatars を提案するミュンヘン工科大学などの機関によるものです。

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

人型ロボット「アメカ」が第二世代にバージョンアップ!最近、世界移動通信会議 MWC2024 に、世界最先端のロボット Ameca が再び登場しました。会場周辺ではアメカに多くの観客が集まった。 GPT-4 の恩恵により、Ameca はさまざまな問題にリアルタイムで対応できます。 「ダンスをしましょう。」感情があるかどうか尋ねると、アメカさんは非常に本物そっくりの一連の表情で答えました。ほんの数日前、Ameca を支援する英国のロボット企業である EngineeredArts は、チームの最新の開発結果をデモンストレーションしたばかりです。ビデオでは、ロボット Ameca は視覚機能を備えており、部屋全体と特定のオブジェクトを見て説明することができます。最も驚くべきことは、彼女は次のこともできるということです。

AI はどのようにロボットをより自律的で順応性のあるものにすることができるのでしょうか?

Jun 03, 2024 pm 07:18 PM

AI はどのようにロボットをより自律的で順応性のあるものにすることができるのでしょうか?

Jun 03, 2024 pm 07:18 PM

産業オートメーション技術の分野では、人工知能 (AI) と Nvidia という無視できない 2 つの最近のホットスポットがあります。元のコンテンツの意味を変更したり、コンテンツを微調整したり、コンテンツを書き換えたり、続行しないでください。「それだけでなく、Nvidia はオリジナルのグラフィックス プロセッシング ユニット (GPU) に限定されていないため、この 2 つは密接に関連しています。」このテクノロジーはデジタル ツインの分野にまで広がり、新たな AI テクノロジーと密接に関係しています。「最近、NVIDIA は、Aveva、Rockwell Automation、Siemens などの大手産業オートメーション企業を含む多くの産業企業と提携に至りました。シュナイダーエレクトリック、Teradyne Robotics とその MiR および Universal Robots 企業も含まれます。最近、Nvidiahascoll

2か月後、人型ロボットWalker Sが服をたたむことができるようになった

Apr 03, 2024 am 08:01 AM

2か月後、人型ロボットWalker Sが服をたたむことができるようになった

Apr 03, 2024 am 08:01 AM

Machine Power Report 編集者: Wu Xin 国内版の人型ロボット + 大型模型チームは、衣服を折りたたむなどの複雑で柔軟な素材の操作タスクを初めて完了しました。 OpenAIのマルチモーダル大規模モデルを統合したFigure01の公開により、国内同業者の関連動向が注目を集めている。つい昨日、中国の「ヒューマノイドロボットのナンバーワン株」であるUBTECHは、Baidu Wenxinの大型モデルと深く統合されたヒューマノイドロボットWalkerSの最初のデモを公開し、いくつかの興味深い新機能を示した。 Baidu Wenxin の大規模モデル機能の恩恵を受けた WalkerS は次のようになります。 Figure01 と同様に、WalkerS は動き回るのではなく、机の後ろに立って一連のタスクを完了します。人間の命令に従って服をたたむことができる

柔軟かつ高速な 5 本の指を備え、人間のタスクを自律的に完了する初のロボットが登場、大型モデルが仮想空間トレーニングをサポート

Mar 11, 2024 pm 12:10 PM

柔軟かつ高速な 5 本の指を備え、人間のタスクを自律的に完了する初のロボットが登場、大型モデルが仮想空間トレーニングをサポート

Mar 11, 2024 pm 12:10 PM

今週、OpenAI、Microsoft、Bezos、Nvidiaが投資するロボット企業FigureAIは、7億ドル近くの資金調達を受け、来年中に自立歩行できる人型ロボットを開発する計画であると発表した。そしてテスラのオプティマスプライムには繰り返し良い知らせが届いている。今年が人型ロボットが爆発的に普及する年になることを疑う人はいないだろう。カナダに拠点を置くロボット企業 SanctuaryAI は、最近新しい人型ロボット Phoenix をリリースしました。当局者らは、多くのタスクを人間と同じ速度で自律的に完了できると主張している。人間のスピードでタスクを自律的に完了できる世界初のロボットである Pheonix は、各オブジェクトを優しくつかみ、動かし、左右にエレガントに配置することができます。自律的に物体を識別できる

この人型ロボットは魔法を使うことができます。春祭り祝賀プログラム チームに詳細を調べてもらいましょう

Feb 04, 2024 am 09:03 AM

この人型ロボットは魔法を使うことができます。春祭り祝賀プログラム チームに詳細を調べてもらいましょう

Feb 04, 2024 am 09:03 AM

瞬く間に、ロボットは魔法を使えるようになったのでしょうか?最初にテーブルの上の水スプーンを取り上げ、中には何も入っていないことを観客に証明したのが見られました。次に、卵のような物体を手に置き、水スプーンをテーブルに戻し、が「呪文を唱え」始めました… …再び水スプーンを拾ったそのとき、奇跡が起こりました。元々入っていた卵が消えて、飛び出してきたのがバスケットボールに… もう一度連続動作を見てみましょう: △ このアニメーションは一連の動作を2倍速で表示しており、スムーズに流れています。ビデオを 0.5 倍速で繰り返し再生すると、うまくいくでしょうか? 最後に、手の速度がもっと速ければ、敵から隠すことができるかもしれないという手がかりを発見しました。一部のネチズンは、ロボットの魔法のスキルが自分たちのものよりもさらに高いと嘆いていました。マグは私たちのためにこの魔法を実行してくれたのです。

未来を形作る 10 台の人型ロボット

Mar 22, 2024 pm 08:51 PM

未来を形作る 10 台の人型ロボット

Mar 22, 2024 pm 08:51 PM

以下の 10 種類の人型ロボットが私たちの未来を形作ります。 1. ASIMO: ホンダが開発した ASIMO は、最もよく知られている人型ロボットの 1 つです。身長 4 フィート、体重 119 ポンドの ASIMO には、高度なセンサーと人工知能機能が装備されており、複雑な環境をナビゲートし、人間と対話することができます。 ASIMO は多用途性を備えているため、障害を持つ人々の支援からイベントでのプレゼンテーションまで、さまざまなタスクに適しています。 2. Pepper: ソフトバンクロボティクスによって作成された Pepper は、人間の社会的パートナーになることを目指しています。表情豊かな顔と感情を認識する能力を備えた Pepper は、会話に参加したり、小売現場で手助けしたり、教育サポートを提供したりすることもできます。コショウ

Cloud Whale Xiaoyao 001 の掃除と掃き掃除ロボットには「頭脳」があります。 | 経験

Apr 26, 2024 pm 04:22 PM

Cloud Whale Xiaoyao 001 の掃除と掃き掃除ロボットには「頭脳」があります。 | 経験

Apr 26, 2024 pm 04:22 PM

掃除ロボットやモップ拭きロボットは、近年消費者の間で最も人気のあるスマート家電製品の 1 つです。操作の利便性、あるいは操作の必要がないことで、怠け者は手を解放し、消費者は日常の家事から「解放」され、好きなことにもっと時間を費やすことができるようになり、生活の質が向上します。この流行に乗って、市場に出回っているほぼすべての家電ブランドが独自の掃除ロボットや拭き掃除ロボットを製造しており、掃除ロボット市場全体が非常に活発になっています。しかし、市場の急速な拡大は必然的に隠れた危険をもたらします。多くのメーカーがより多くの市場シェアを急速に占有するために機械の海戦術を使用し、その結果、アップグレードポイントのない多くの新製品が生まれるとも言われています。まさに「マトリョーシカ」モデルです。ただし、すべての掃除ロボットやモップロボットがそうであるわけではありません。