ChatGPTを学ぶ、AI絵画に人間のフィードバックを導入するとどうなるか?

最近、ディープ生成モデルはテキスト プロンプトから高品質の画像を生成するという点で目覚ましい成功を収めています。その理由の 1 つは、ディープ生成モデルが LAION などの大規模 Web データセットに拡張されたことです。ただし、大規模なテキストから画像へのモデルがテキスト プロンプトと完全に一致する画像を生成することを妨げる、いくつかの重要な課題が残っています。たとえば、現在のテキストから画像へのモデルは、多くの場合、信頼性の高いビジュアル テキストを生成できず、組み合わせた画像の生成が困難です。

言語モデリングの分野に戻ると、人間のフィードバックから学ぶことは、「モデルの動作を人間の意図に合わせる」ための強力なソリューションになりました。このタイプの方法では、まず、モデル出力に対する人間のフィードバックを通じて、人間がタスクで何を重視しているかを反映するように設計された報酬関数を学習し、次に、強化学習アルゴリズム (近接ポリシー最適化 PPO など) を通じて学習した報酬関数を使用して言語を最適化します。モデル。このヒューマン フィードバック フレームワーク (RLHF) による強化学習は、大規模な言語モデル (GPT-3 など) と高度な人間の品質評価を組み合わせることに成功しました。

最近、言語分野における RLHF の成功に触発されて、Google Research とカリフォルニア州バークレーの研究者は、人間のフィードバックを使用してテキストを画像モデルに合わせる微調整方法を提案しました。 。

論文アドレス: https://arxiv.org/pdf/2302.12192v1.pdf

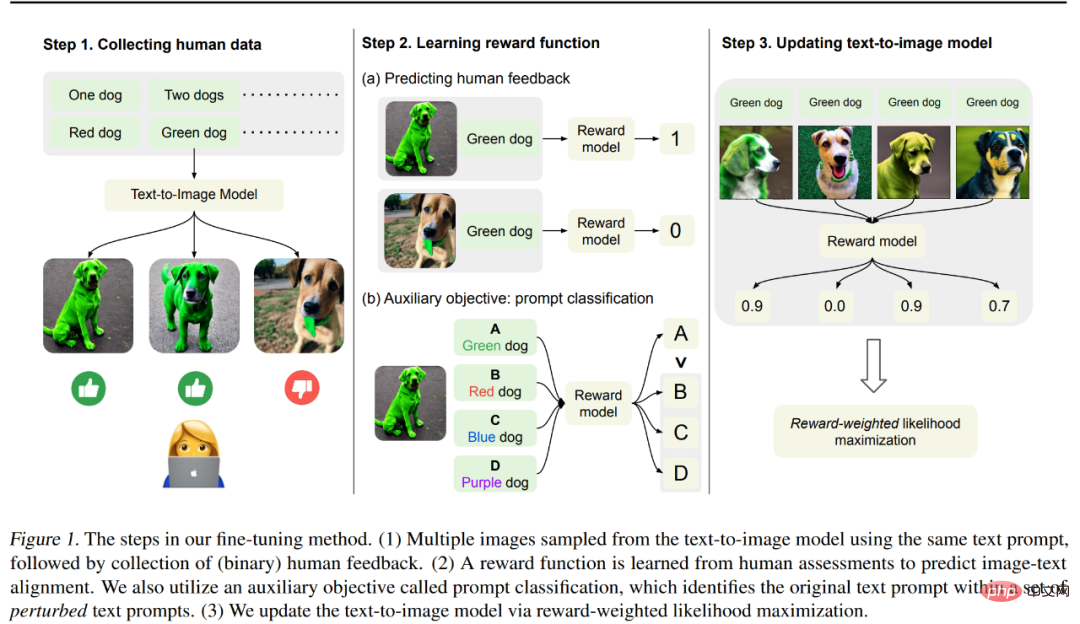

この記事の方法は次の図 1 に示されており、主に 3 つのステップに分かれています。

ステップ 1: まず、「画像モデル出力に対するテキストの位置合わせをテストするために設計された」一連のテキスト プロンプトからさまざまな画像を生成します。具体的には、事前トレーニング済みモデルのエラーが発生しやすいプロンプトを調べます。つまり、特定の色、番号、背景を持つオブジェクトを生成し、モデルの出力を評価するために使用されるバイナリの人的フィードバックを収集します。

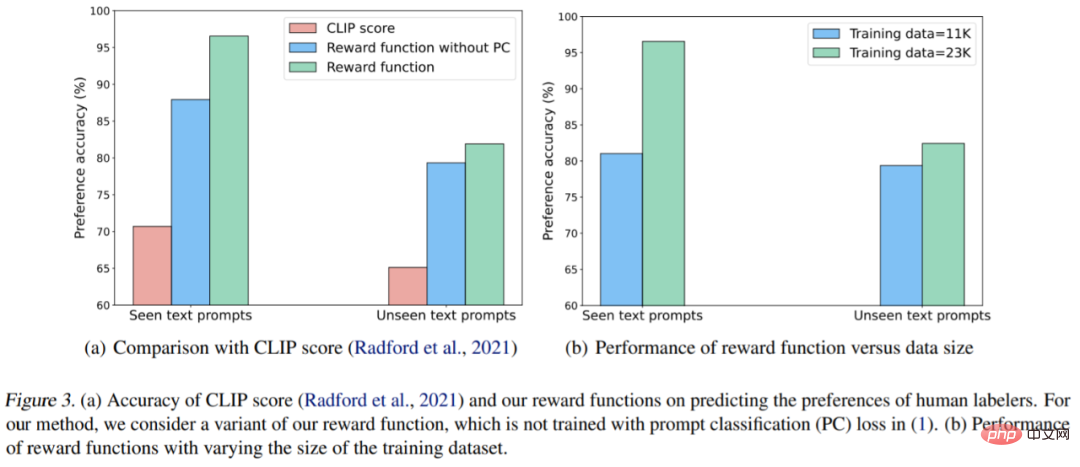

ステップ 2: 人間がラベル付けしたデータセットを使用して、画像とテキストのプロンプトが与えられた場合に人間のフィードバックを予測する報酬関数をトレーニングします。報酬学習のために人間のフィードバックをより効果的に使用するために、摂動されたテキスト プロンプトのセットの中から元のテキスト プロンプトを識別する補助タスクを提案します。この手法により、目に見えない画像やテキスト プロンプトに対する報酬関数の一般化が向上します。

ステップ 3: 報酬重み付け尤度最大化によってテキストから画像へのモデルを更新し、人間のフィードバックとより適切に調整します。最適化に強化学習を使用したこれまでの研究とは異なり、研究者らは半教師あり学習を使用してモデルを更新し、学習された報酬関数であるモデル出力の品質を測定しました。

研究者らは、27,000 個の画像とテキストのペアと人間のフィードバックを使用して安定拡散モデルを微調整しました。その結果は次のとおりです。微調整 後者のモデルでは、特定の色、量、背景を持つオブジェクトの生成が大幅に改善されました。画像の忠実度はわずかに低下しますが、画像とテキストの位置合わせが最大 47% 向上しました。

さらに、結合された生成結果が改善され、目に見えない色、数量、および背景プロンプトの組み合わせを考慮して、目に見えないオブジェクトをより適切に生成できるようになりました。彼らはまた、学習された報酬関数が、テストテキストプロンプトの CLIP スコアよりも人間のアライメント評価とよく一致していることも観察しました。

ただし、この論文の筆頭著者である Kimin Lee 氏は、この論文の結果は既存のテキストから画像へのモデルのすべての失敗モデルを解決したわけではないとも述べています。まだ多くの課題があります。彼らは、この研究が、ヴィンセント グラフ モデルを調整する際に人間のフィードバックから学習できる可能性を浮き彫りにすることを望んでいます。

手法の紹介

生成された画像をテキスト プロンプトと一致させるために、この研究では事前トレーニングされたモデルに対して一連の微調整を実行しました。そのプロセスを図 1 に示します。その上。まず、ビンセンチアン グラフ モデルのさまざまなパフォーマンスをテストするために設計されたプロセスである、一連のテキスト プロンプトから対応する画像が生成されました。次に、人間の評価者がこれらの生成された画像に対してバイナリ フィードバックを提供しました。次に、この研究では、人間のフィードバックを予測するために報酬モデルをトレーニングしました。テキスト プロンプトと画像を入力として使用し、最後に、報酬加重対数尤度を使用してヴィンセント グラフ モデルを微調整し、テキストと画像の位置合わせを改善します。

人間データの収集

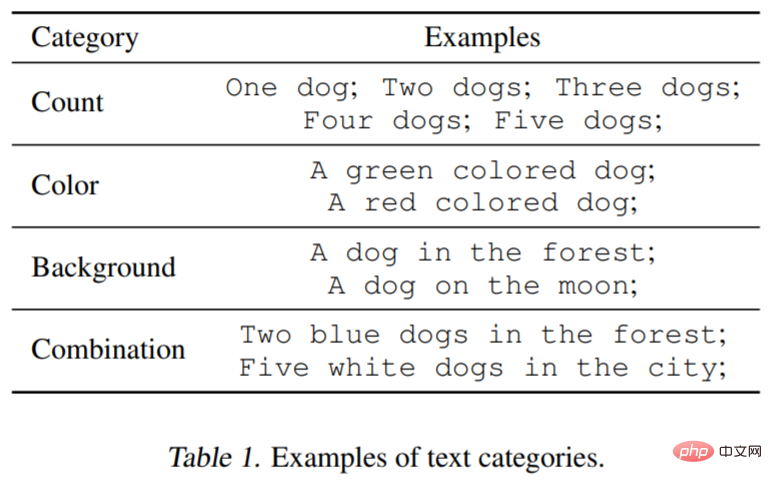

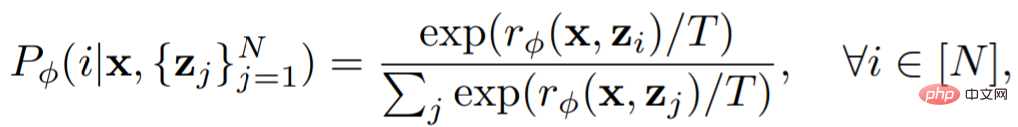

ヴィンセント グラフ モデルの機能をテストするために、研究では 3 つのカテゴリのテキストを検討しました。プロンプト: 指定された数、色、背景。この研究では、カテゴリーごとに、緑(色)と犬(量)など、物体を説明する各単語やフレーズを組み合わせてプロンプトを生成しました。さらに、この研究では 3 つのカテゴリーの組み合わせ (たとえば、都市で緑色に染まった 2 匹の犬) も考慮されました。以下の表 1 は、データセットの分類をわかりやすく示しています。各プロンプトは 60 枚の画像を生成するために使用され、モデルは主に Stable Diffusion v1.5 です。

#人間によるフィードバック

次のコメントが生成されました人間のフィードバック用の画像。同じプロンプトによって生成された 3 つの画像がラベラーに提示され、生成された各画像がプロンプトと一致しているかどうか、および評価基準の良し悪しを評価するように求められます。このタスクは比較的単純なので、バイナリ フィードバックで十分です。

報酬学習

画像とテキストの配置をより適切に評価するために、この研究では報酬関数を使用します

測定するには、この関数は画像 x とテキスト プロンプト z の CLIP 埋め込みをスカラー値にマッピングします。次に、人間のフィードバック k_y ∈ {0, 1} (1 = 良い、0 = 悪い) を予測するために使用されます。

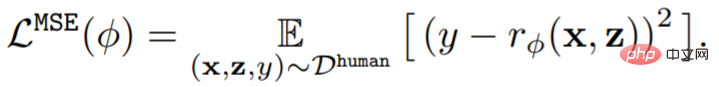

#平均二乗誤差 (MSE) を最小限に抑えてトレーニングする:

以前は、研究でした。データ拡張手法がデータ効率とモデル学習パフォーマンスを大幅に向上させることができることを示した研究では、フィードバック データセットを効果的に利用するために、単純なデータ拡張スキームと学習に報酬を与える補助損失を設計しました。この研究では、補助タスクで拡張プロンプトを使用します。つまり、分類報酬学習は元のプロンプトで実行されます。プロンプト分類子は、次のような報酬関数を使用します。

以前は、研究でした。データ拡張手法がデータ効率とモデル学習パフォーマンスを大幅に向上させることができることを示した研究では、フィードバック データセットを効果的に利用するために、単純なデータ拡張スキームと学習に報酬を与える補助損失を設計しました。この研究では、補助タスクで拡張プロンプトを使用します。つまり、分類報酬学習は元のプロンプトで実行されます。プロンプト分類子は、次のような報酬関数を使用します。

##補助損失は次のとおりです。

##最後のステップは、Vincent 図モデルを更新することです。モデルによって生成されるデータセットの多様性は制限されているため、過剰適合につながる可能性があります。これを軽減するために、この研究では次のようにトレーニング前の損失も最小限に抑えました。

実験結果

実験部分は、モデルの微調整に参加する人間のフィードバックの有効性をテストするように設計されています。実験で使用されたモデルは Stable Diffusion v1.5 です。データ セット情報は表 1 (上記を参照) と表 2 に示されています。表 2 は、複数の人間のラベラーによって提供されたフィードバックの分布を示しています。

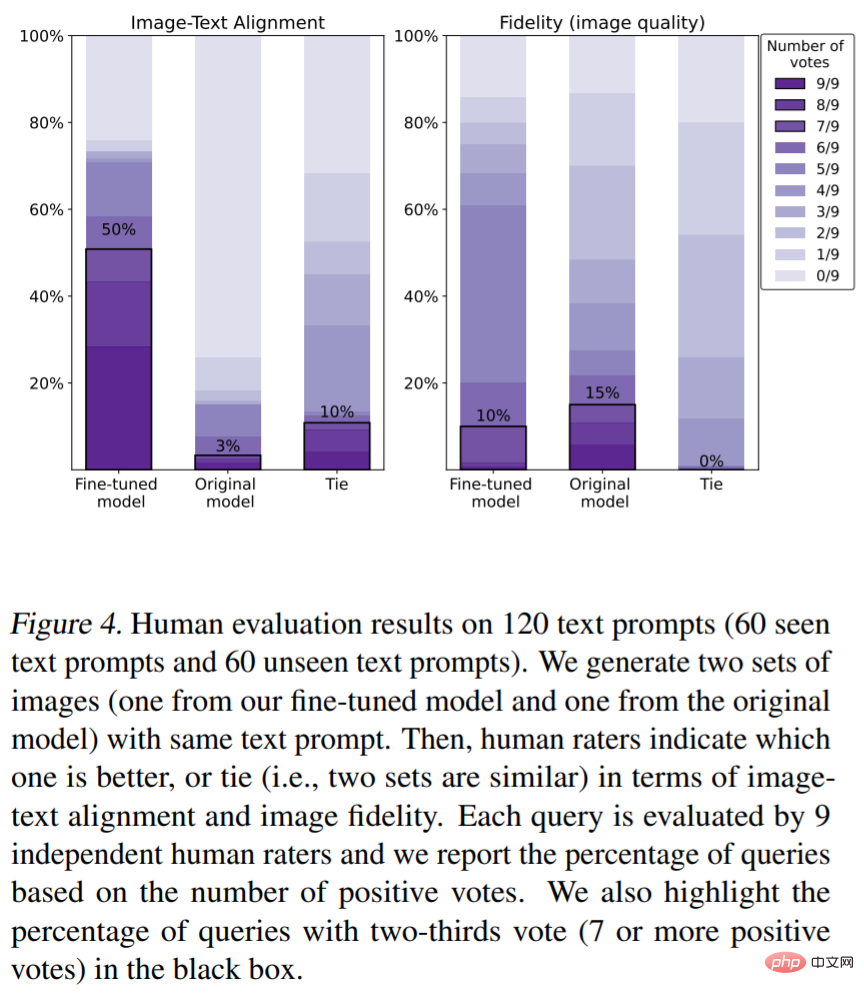

テキストと画像の配置に関する人間による評価 (評価指標は色、オブジェクトの数)。図 4 に示すように、私たちの手法は画像とテキストの位置合わせを大幅に改善しました。具体的には、モデルによって生成されたサンプルの 50% が少なくとも 3 分の 2 の賛成票を獲得しました (投票数は 7 票以上でした)。 . 票)、ただし、微調整すると画像の忠実度がわずかに低下します (15% 対 10%)。

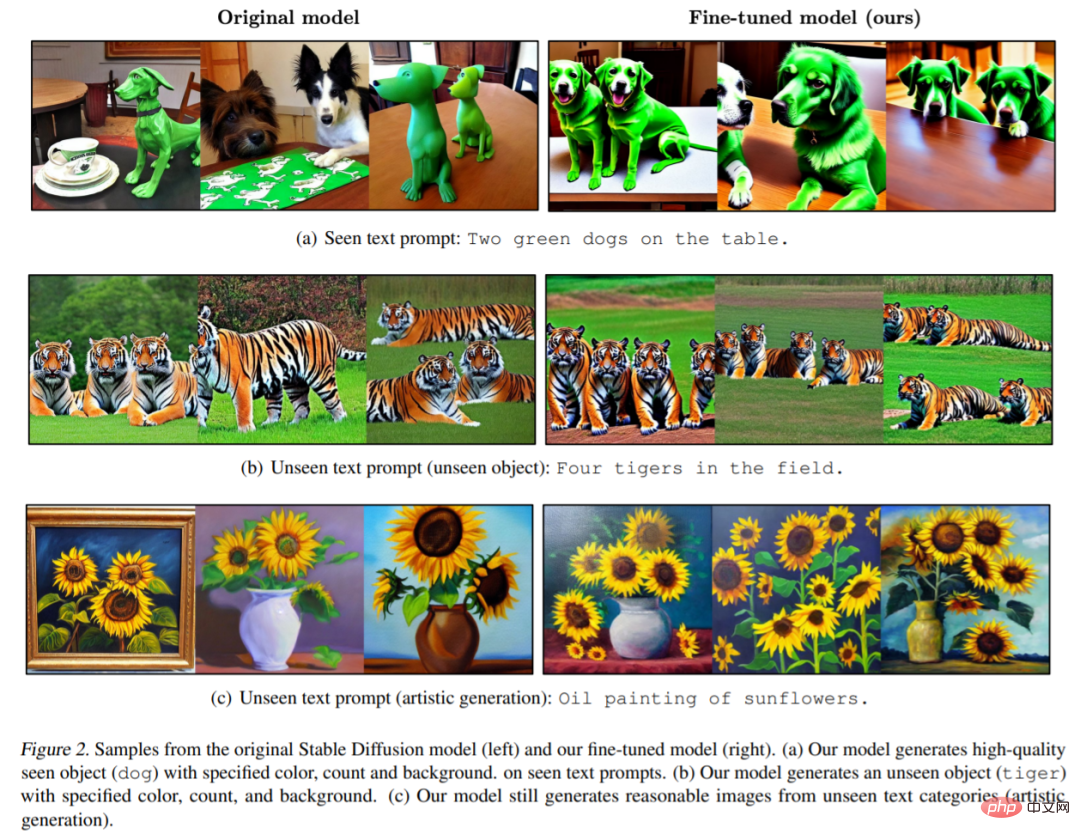

# 図 2 は、元のモデルと微調整されたモデルの画像の例を示しています。元のモデルが生成した画像には詳細 (色、背景、数など) が欠けていることがわかります (図 2 (a))。モデルによって生成された画像は、プロンプトで指定された色、数、背景に準拠しています。 。私たちのモデルは、非常に高品質の目に見えないテキスト プロンプト イメージも生成できることは注目に値します (図 2 (b))。

以上がChatGPTを学ぶ、AI絵画に人間のフィードバックを導入するとどうなるか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7537

7537

15

15

1380

1380

52

52

82

82

11

11

21

21

86

86

モデル、データ、フレームワークの詳細: 効率的な大規模言語モデルの 54 ページにわたる徹底的なレビュー

Jan 14, 2024 pm 07:48 PM

モデル、データ、フレームワークの詳細: 効率的な大規模言語モデルの 54 ページにわたる徹底的なレビュー

Jan 14, 2024 pm 07:48 PM

大規模言語モデル (LLM) は、自然言語理解、言語生成、複雑な推論などの多くの重要なタスクにおいて説得力のある能力を実証し、社会に大きな影響を与えてきました。ただし、これらの優れた機能には、大量のトレーニング リソース (左の図に示す) と長い推論時間 (右の図に示す) が必要です。したがって、研究者は効率の問題を解決するための効果的な技術的手段を開発する必要があります。さらに、図の右側からわかるように、Mistral-7B などのいくつかの効率的な LLM (LanguageModel) が、LLM の設計と展開にうまく使用されています。これらの効率的な LLM は、LLaMA1-33B と同様の精度を維持しながら、推論メモリを大幅に削減できます。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

著者の個人的な考えの一部 自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発に伴い、高品質のマルチビュー トレーニング データとそれに対応するシミュレーション シーンの構築がますます重要になってきています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分離できます。 さまざまな次元のロングテール シナリオ: 障害物データ内の近距離車両、車両切断中の正確な進行角、車線などラインデータ 曲率の異なるカーブやランプ・合流・合流などの撮影が難しいシーン。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。 3D 真の値 - 一貫性の高い画像: 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。これが私を導いた

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、

SD コミュニティの I2V アダプター: 設定不要、プラグアンドプレイ、Tusheng ビデオ プラグインと完全に互換性あり

Jan 15, 2024 pm 07:48 PM

SD コミュニティの I2V アダプター: 設定不要、プラグアンドプレイ、Tusheng ビデオ プラグインと完全に互換性あり

Jan 15, 2024 pm 07:48 PM

画像からビデオへの生成 (I2V) タスクは、静止画像を動的なビデオに変換することを目的としたコンピューター ビジョンの分野における課題です。このタスクの難しさは、画像コンテンツの信頼性と視覚的な一貫性を維持しながら、単一の画像から時間次元で動的な情報を抽出して生成することです。既存の I2V 手法では、多くの場合、この目標を達成するために複雑なモデル アーキテクチャと大量のトレーニング データが必要になります。最近、Kuaishou が主導した新しい研究成果「I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels」が発表されました。この研究では、革新的な画像からビデオへの変換方法を導入し、軽量のアダプター モジュールを提案します。

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。