自動推論は自然言語処理の分野において間違いなく大きな問題であり、モデルは与えられた前提と知識に基づいて効果的で正しい結論を導き出す必要があります。

NLPの分野は近年、大規模な事前学習済み言語モデルによる読解や質問応答など、さまざまな「自然言語理解」タスクにおいて極めて高いパフォーマンスを達成していますが、論理的推論におけるモデルのパフォーマンスは依然として遅れています。

昨年 5 月に「Chain of Thought (CoT)」が登場し、プロンプトに「ステップバイステップで考えてみましょう」と追加するだけで GPT の推論パフォーマンスが向上することがわかった研究者もいます。 -3 は大幅に改善されており、例えば MultiArith では推論精度が以前の 17.7% から 78.7%

に向上しましたが、CoT や選択推論などの手法では推論精度が向上しています。公理(公理)から順方向に証明過程(証明)を探索して最終的な結論(結論)を導き出すことですが、探索空間の組み合わせ爆発の問題があるため、推論連鎖が長くなると失敗率が高くなります。 。

最近、Google Research は、古典的な推論文献から得られた「後方推論の効率」を組み合わせた、後方連鎖アルゴリズム LAMBADA (言語モデル拡張バックワード チェーン) を開発しました。「前向き推論よりも大幅に高い」この結論は言語モデル (LM) に適用されます。

論文リンク: https://arxiv.org/abs/2212.13894

LAMBADA は推論しますこのプロセスは 4 つのサブモジュールに分解され、それぞれが少数のプロンプト言語モデル推論によって実装されます。

最終的に、LAMBADA は、特に問題に深さと正確な証明連鎖が必要な場合に、sota の現在の順推論方法と比較して、2 つの論理推論データセットで大幅なパフォーマンスの向上を達成しました。 LAMBADA のパフォーマンスの向上はより明らかです。

論理的推論、特に非構造化自然テキストに関する論理的推論は、自動知識発見の基本的な構成要素であり、さまざまな科学分野における将来の進歩の鍵となります。

多くの NLP タスクの開発は、事前トレーニングされた言語モデルの規模の拡大から恩恵を受けてきましたが、モデルのサイズを拡大しても、複雑な問題を解決する際の改善は非常に限られていることが観察されています。推論の問題。

古典的な文献には、2 つの主要な論理的推論方法があります:

1. 前方連鎖 (FC) )、つまり、以下から始まります。事実とルール、ターゲットのステートメントが証明または反証できるまで、新しい推論の作成と理論への追加を繰り返す;

2、後方への Backward Chaining (BC) は目標から開始し、サブ目標が事実に基づいて証明または覆されるまで、それを再帰的にサブ目標に分解します。

言語モデルを使用したこれまでの推論方法では、主に前方連鎖推論の考え方が採用されており、セット全体から事実とルールのサブセットを選択する必要がありました。 LM は広い空間での組み合わせ探索が必要なため難しいです。

さらに、いつ検索を停止して証明の失敗を宣言するかを決定することも FC では非常に難しく、場合によっては中間ラベルで特別にトレーニングされたモジュールが必要になることもあります。

実際、古典的な自動推論の文献は主に、後方連鎖推論または目標指向の検証戦略に焦点を当てています。

LAMBADA

LAMBADAとは「リバースチェーン技術によって強化された言語モデル」を意味し、研究者らが実験を行った結果、 BC はテキストベースの演繹的論理的推論により適しているということです。

BC は、サブセットを選択するために多数の組み合わせ検索を必要とせず、より自然な停止基準を備えています。

LAMBADA は、事実に関する自動推論、つまり「善良な人は赤い」などの自然言語の主張に主に焦点を当てています。これらの主張は一貫性がありますが、必ずしも真実に基づいているわけではありません。

ルールは自然言語ステートメントによって記述され、「if P then Q」という形式で書き換えることができます。たとえば、「粗暴で良い人は赤い」(粗暴で良い人) people are red) は、「If a person isrough and nice, then they are red」(人が粗暴でいい人なら、彼らは赤い)と書き換えることができます。

P はルールの前件と呼ばれ、Q はルールの後件と呼ばれます。

#理論理論 C は事実 F={f1, f2, . . , fn} と規則 R={r1, r2, . . , rm} で構成され、G はアイデアを表します事実とルールに基づいて証明または反証することを目的とします。 例 1、架空の人物とルールを使用した理論的な例 C F={"フィオナは良い人です","フィオナは良い人です"いい人" オナは荒い"}#R={"賢い人はいい人だ", "荒っぽい良い人は赤い", "いい人で赤いということは、彼はいい人だということだ"は丸いです" }。 上記の理論に基づいて、「フィオナは赤い?」などの目標を証明または反証したい場合があります。 #後方連鎖推論

ルールが目標に当てはまるかどうかは、論理の統一と呼ばれる操作によって決まります。

たとえば、例 1 の目標「フィオナは赤い?」の場合、2 番目のルールの結果は目標と同じなので適用できますが、結果は他の 2 つのルールは異なるため、適用されません。

例 1 の理論と目標を考慮すると、BC は「フィオナは赤い?」という目標から推論を開始します。

まず、BC は、目標が事実から証明できるか反証できるかを検証します。この目標を証明または反証する事実がないため、次にこの目標が何らかのルールの結果と一致するかどうかを確認すると、2 番目のルール「粗暴で善良な人々は赤い」と一致していることがわかります。

したがって、この目標は 2 つのサブ目標に分類できます。 1) フィオナは荒れていますか? 2) フィオナは良い人ですか? 。

両方のサブ目標は事実から証明できるため、BC は元の目標は証明できると結論付けます。

目標の場合、BC の結果は証明、否定、または不明のいずれかになります (たとえば、「フィオナは賢い?」という目標)。

テキストベースの推論に BC を使用するために、研究者は 4 つの LM ベースのモジュールを導入しました: ファクト チェック、ルール選択、目標分解そして契約書に署名します。

#ファクトチェック

理論の説明の事実セット F と目標 G が与えられると、目標は拒否されます)。 そのような事実が見つからない場合、G の真実は不明のままです。 ファクト チェックの実装には 2 つのサブモジュールが含まれています。最初のサブモジュールはターゲットに最も関連するファクトのセットからファクトを選択し、2 番目のサブモジュールはターゲットに最も関連性の高いファクトを検証します。この事実に基づいてターゲットを証明することも、反証することもできます。 ファクト選択サブモジュールは最初の試行では最良のファクトを決定できない可能性があるため、サブモジュールを 1 回呼び出してもターゲットの真実がまだ不明な場合は、選択したファクトを削除してからサブモジュールを再度呼び出すことができ、このプロセスを複数回繰り返すことができます。ルール選択

理論における一連のルール R と目標 G が与えられた場合、ルール選択モジュールルール r∈R は r の結果を G と一致させ、次にこれらのルールを使用して目標をサブ目標に分解します。 そのようなルールを決定できない場合、G の真実は不明のままです。 ルール選択には 2 つのサブモジュールも含まれています。最初のサブモジュールは各ルールの結果を (目標とは独立して) 決定し、2 番目のサブモジュールは結果と目標を取得します。ルールを入力として入力し、どれが目標に一致するかを判断します。 BC の再帰的な性質により、ルール選択モジュールは目標を証明する過程で複数回呼び出される可能性があることに注意してください。各ルールの識別結果はターゲットとは独立しているため、このサブモジュールを呼び出す必要があるのは 1 回だけです。目標の分解

ルール r と目標 G が与えられた場合、r の結果を G と一致させます。目標分解モジュールは、G を証明または反証できるように証明する必要があるサブ目標を決定します。 r の前件の証明に成功した場合、ゴールが証明されるか反証されるかは、ゴールの符号が r の結果の符号と一致するかどうかによって決まります。 たとえば、ゴール「フィオナは赤い?」の場合、ゴールの符号は 2 番目のルールの結果の符号と一致しており、ルールの先行詞が証明されているため、 、ゴールは証明されたと結論付けることができます。シンボリック整合性

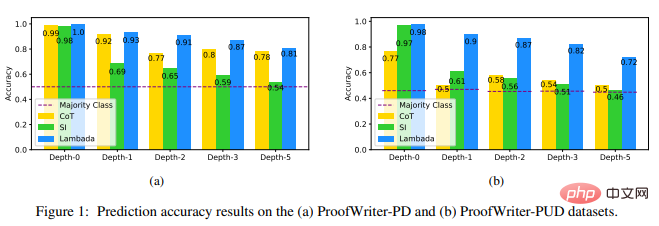

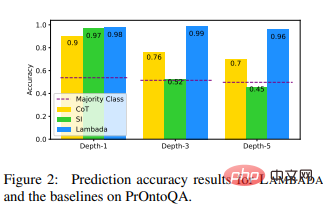

ルール r と目標 G が与えられると、シンボリック整合性モジュールは r の結果を検証します。シンボルがターゲットのシンボルと一致しているか不一致であるか。 実験部分研究者らは、明示的推論に基づくsotaニューラル推論手法である思考連鎖(CoT)と、sotaモジュール推論手法である選択推論(SI)を選択しました。 ) ベースライン モデルとの比較として。 実験データ セットは ProofWriter と PrOntoQA を使用します。これらのデータ セットは LM 推論にとって困難であり、最大 5 ホップのチェーン長を証明する必要があり、ターゲットを導き出すことができない例が含まれています。提示された理論、反駁できない例。

実験結果は、特に UNKNOWN ラベルを含む ProofWriter-PUD データセットにおいて、LAMBADA が他の 2 つのベースラインよりも大幅に優れていることを示しています (CoT と比較して 44% の相対的改善、深さ -5 での SI と比較して 44% の相対的改善、56% の改善)。そして、PrOntoQA のより深い深さでは (深さ -5 で CoT と比較して 37% の相対的改善、SI と比較して 113% の改善)。

これらの結果は、論理的推論における LAMBADA の利点を示し、また、後方連鎖 (LAMBADA では推論バックボーン) も示しています。 ) は、フォワードチェーン (SI のバックボーン) よりも良い選択である可能性があります。

これらの結果は、 UNKNOWN ラベルを扱うときの CoT メソッドの欠陥も明らかにしています。 PROVED または DISPROVED とラベル付けされた例とは異なり、 UNKNOWN とラベル付けされた例には、自然な思考の連鎖がありません。

より深い (3) 証明連鎖問題については、SI は 3 つのデータセットの多数派クラスの予測に近い予測を生成します。

2 値の場合は DISPROVED を過剰予測する傾向があり、3 値の分類の場合は UNKNOWN を過剰予測する傾向があるため、深度が低くなります。 PrOntoQA -5 のパフォーマンスは、その深さでは DISPROVED ラベルよりも PROVED ラベルの方が多いため、多数派クラスよりもさらに悪くなります。

ただし、研究者らは、ProofWriterPD データセットに対する CoT のパフォーマンスが依然として比較的高く、精度が低下していないことにも驚きました。

要約すると、LAMBADA はこれらのデータセットに対する推論精度が高く、誤った証拠のトレースを使用して正しい結論を見つける他の手法よりも有効な結論を導き出す可能性が高くなります。他の LM ベースのモジュール推論方法よりもクエリ効率が高くなります。

この実験の結果は、LMを使った推論に関する将来の研究には、後方連鎖または目標指向の戦略を含めるべきであることを強く示唆している、と研究者らは述べた。

参考:

https://arxiv.org/abs/2212.13894

以上が一歩ずつ考えるな! Googleの最新自然言語推論アルゴリズムLAMBADA:「逆連鎖推論」が答えの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。