AIに普遍的な機能を持たせるにはどうすればよいでしょうか?新しい研究: 寝かせる

ニューラル ネットワークは多くのタスクで人間を上回るパフォーマンスを発揮できますが、AI システムに新しい記憶を吸収するように依頼すると、以前に学習した内容を即座に忘れてしまう可能性があります。今回、新しい研究により、ニューラルネットワークが睡眠段階を通過し、この健忘症の予防に役立つ新しい方法が明らかになりました。

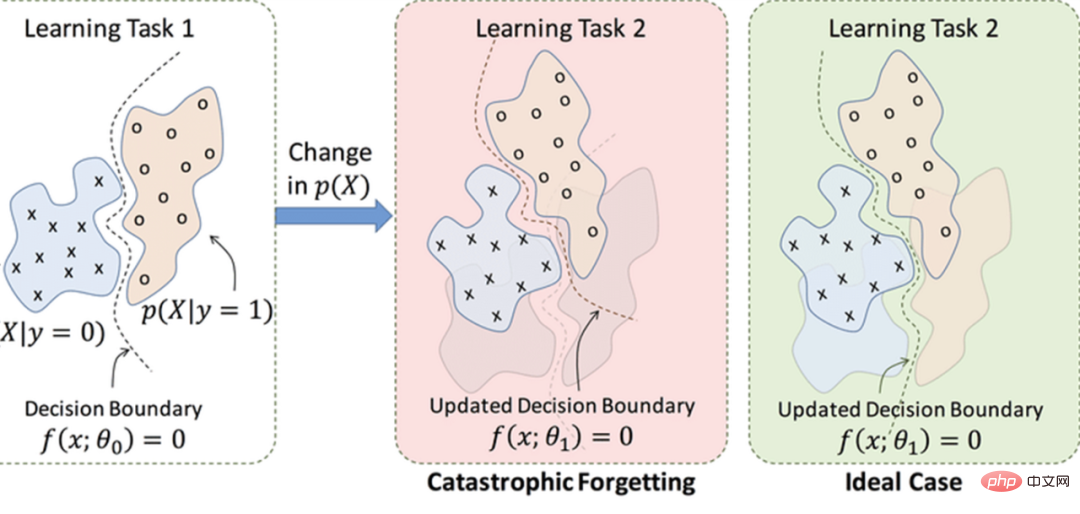

人工ニューラル ネットワークが直面する主な課題の 1 つは、「壊滅的な忘却」です。新しい仕事を学びに行くと、以前に学んだことを突然完全に忘れてしまう残念な傾向があります。

本質的に、ニューラル ネットワークによるデータの表現は、元のデータのタスク指向のデータ「圧縮」であり、新しく学習された知識が過去のデータを上書きします。

これは、人間のニューラル ネットワークと比較した現在のテクノロジーの最大の欠陥の 1 つです。対照的に、人間の脳は、新しいタスクを学習することができます。その寿命は、以前に記憶されたタスクを実行する能力には影響しません。その理由は完全にはわかっていませんが、人間の脳は学習ラウンドが睡眠に挟まれているときに最もよく学習することが長い研究で示されています。睡眠は明らかに、最近の経験を長期記憶バンクに組み込むのに役立ちます。

「記憶の再構成は、生物が睡眠段階を経る必要がある主な理由の 1 つである可能性があります」とカリフォルニア大学サンディエゴ校の計算神経科学者エリック・デラノイ氏は言う。

#AI も睡眠を学習できるのでしょうか?これまでの研究の中には、AI に睡眠をシミュレートさせることで壊滅的な健忘症に対処しようとしたものもあります。たとえば、ニューラル ネットワークが新しいタスクを学習するとき、インターリーブ トレーニングと呼ばれる戦略により、マシンが過去の知識を保持できるように、以前に学習した古いデータが同時にマシンに供給されます。このアプローチは以前、睡眠中の脳の働き、つまり常に古い記憶を再生する仕組みを模倣すると考えられていました。

しかし、科学者たちは、インターリーブトレーニングでは、何か新しいことを学習するたびに、古いスキルを学習するためにもともと使用していたすべてのデータをニューラルネットワークに供給する必要があるという仮説を立てていました。これには多くの時間とデータが必要なだけでなく、生物学的な脳が真の睡眠中に行うこととは異なるようです。生物には古いタスクを学習するために必要なすべてのデータを保持する能力も、時間もありません。寝ている間にすべてを再生します。

新しい研究で、研究者たちは壊滅的な物忘れの背後にあるメカニズムと、問題を防ぐ睡眠の有効性を分析しています。研究者らは、従来のニューラルネットワークを使用する代わりに、人間の脳に近い「スパイクニューラルネットワーク」を使用した。

人工ニューラル ネットワークでは、ニューロンと呼ばれるコンポーネントにデータが供給され、連携して顔の認識などの問題を解決します。ニューラル ネットワークは、シナプス (ニューロン間の接続) を繰り返し調整し、結果として生じる行動パターンがより適切に解決策につながるかどうかを確認します。時間が経つにつれて (継続的なトレーニング)、ネットワークは正しい結果を計算するのに最適なパターンを発見します。最後に、これらのモードをデフォルト モードとして採用します。これは、人間の脳の学習プロセスを部分的に模倣すると考えられています。

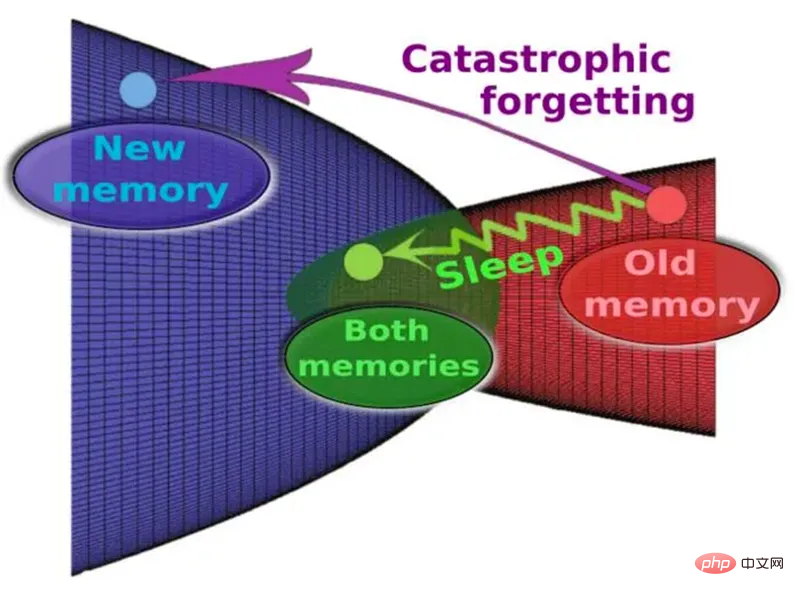

#この図は、抽象的なシナプス空間における記憶と、睡眠中と睡眠中以外のその進化を表しています。

人工ニューラル ネットワークでは、入力が変化するとニューロンの出力も連続的に変化します。対照的に、スパイキング ニューラル ネットワーク (SNN) では、ニューロンは、指定された数の入力信号の後でのみ出力信号を生成します。これは、実際の生物学的ニューロンの動作を忠実に再現するプロセスです。スパイキング ニューラル ネットワークはパルスをほとんど発しないため、一般的な人工ニューラル ネットワークよりも送信するデータが少なく、原理的に必要な電力と通信帯域幅が少なくなります。予想どおり、スパイク ニューラル ネットワークには、初期の学習プロセス中に壊滅的な忘却が発生するという特性があります。しかし、数回の学習ラウンドの後、一定期間が経過すると、セットは最初のタスクの学習に関与するニューロンが再活性化されます。これは、神経科学者が現在考えている睡眠プロセスに近いものです。

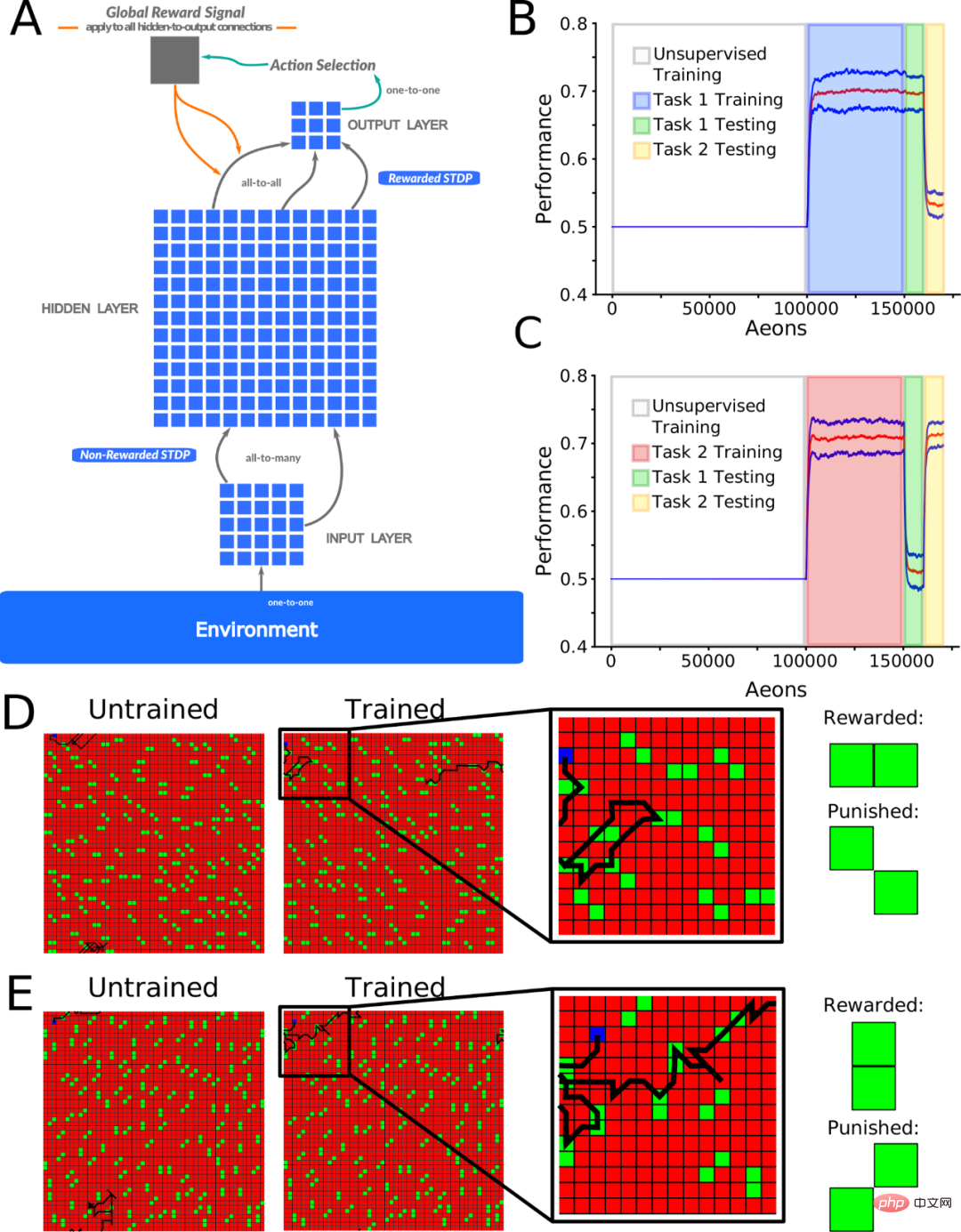

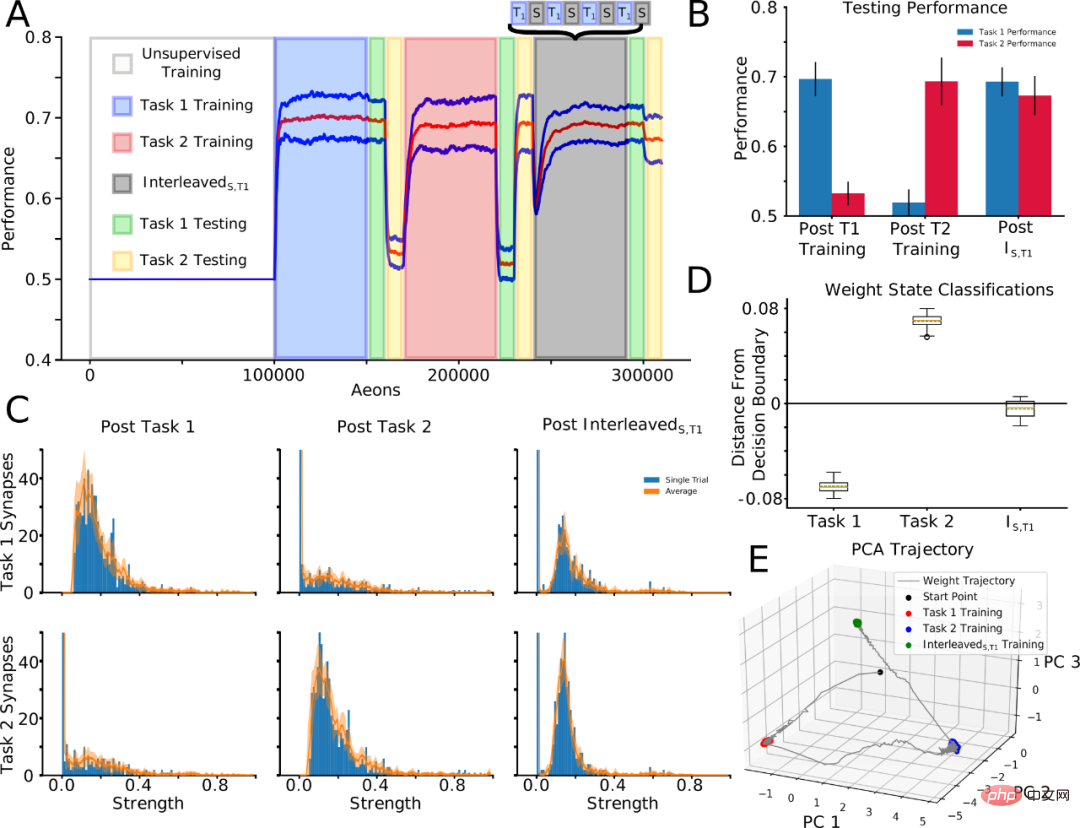

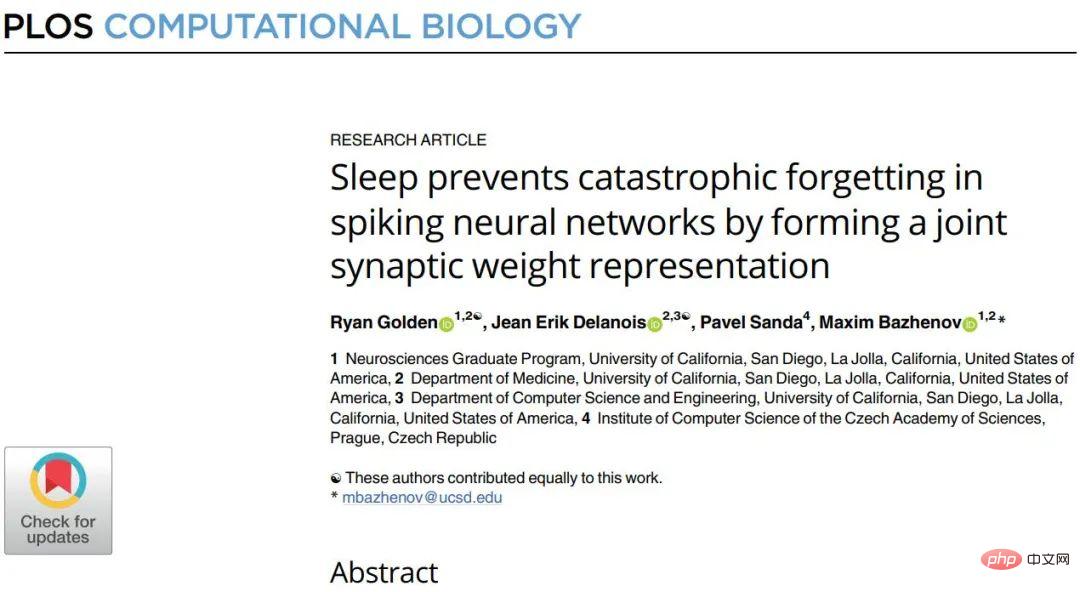

簡単に言うと、SNN を使用すると、以前に学習したメモリ トレースをオフライン処理スリープ中に自動的に再アクティブ化し、干渉することなくシナプスの重みを変更できます。 この研究では、強化学習を備えた多層 SNN を使用して、新しいタスクのトレーニングの期間と睡眠のような自律活動の期間をインターリーブすることで壊滅的な物忘れを回避できるかどうかを調査します。特に、この研究では、睡眠段階と同様に、新しいタスク中に強化学習を定期的に中断することで、壊滅的な物忘れを防止できることが示されました。 図 1A は、入力から出力までの信号をシミュレートするために使用されるフィードフォワード スパイキング ニューラル ネットワークを示しています。入力層 (I) と隠れ層 (H) の間にあるニューロンは教師なし学習 (報酬なし STDP を使用して実装) を受け、H 層と出力 (O) 層の間のニューロンは強化学習 (報酬付き STDP を使用して実装) を受けます。 STDP)。)。 教師なし学習により、隠れ層ニューロンは入力層のさまざまな空間位置からさまざまな粒子パターンを学習できますが、報酬 STDP により出力層ニューロンは検出された粒子に基づいて学習できます。入力レイヤー パーティクル パターン タイプのモーション決定。 #研究者らは、2 つの補完的な方法でネットワークをトレーニングしました。どちらのタスクでも、ネットワークは可能な限り多くの報酬を獲得することを目標に、報酬粒子パターンと罰粒子パターンを区別することを学習します。このタスクでは、確率 0.5 のパフォーマンスの尺度として、パターンの識別可能性 (ペナルティ パーティクルに対する消費された報酬の比率) が考慮されます。報告されたすべての結果は、異なるランダムなネットワーク初期化を用いた少なくとも 10 回の実験に基づいています。 トレーニング中と睡眠中のシナプスの重みのダイナミクスを明らかにするために、研究者らは次に「タスク関連」シナプス、つまり特定のタスクのトレーニング後の分布の上位 10% を追跡しました。シナプスを特定。最初にタスク 1 がトレーニングされ、次にタスク 2 がトレーニングされ、各タスクのトレーニング後にタスク関連のシナプスが特定されました。次に、トレーニング タスク 1 を再度継続しますが、睡眠時間とインターリーブします (インターリーブ トレーニング): T1→T2→InterleavedS,T1。タスク 1 - タスク 2 の連続トレーニングではタスク 1 が忘れられましたが、InterleavedS 後はタスク 1 が再学習され、タスク 2 も保持されました (図 4A および 4B)。 重要なのは、この戦略により、InterleavedS,T1 でのトレーニング後のシナプスの重みを、タスク 1 およびタスク 2 のみでのトレーニング後にタスク関連として特定されたシナプスの重みと比較できることです (図 4C)。 。タスク 1 のトレーニング後に形成されたタスク 1 関連のシナプスの分布構造 (図 4C、左上) は、タスク 2 のトレーニング後に破壊されました (中央上) が、InterleavedS、T1 トレーニング後に部分的に回復しました (右上)。タスク 2 トレーニング後のタスク 2 関連シナプスの分布構造 (中央下) は、タスク 1 トレーニング後 (左下) には存在しませんが、InterleavedS、T1 トレーニング後は部分的に保存されています (右下)。 この定性的パターンは、単一の試験内で明確に観察でき (図 4C、青いバー)、試験全体で一般化することもできる (図 4C、オレンジ色のワイヤー) ことに注意してください。したがって、sleep は、新しいシナプスをマージしながら、重要なシナプス # を保存できます。 図 4. 新しいタスクのトレーニングと睡眠を交互に繰り返すことで、新しいタスクに関連するシナプス情報の統合が可能になります。古いタスク情報。 「興味深いことに、睡眠中に人為的に記憶を再生して忘れないようにするために、初期の記憶に関連するデータを明示的に保存したわけではない」と研究の共著者であるサイード著者のパベル氏は述べた。サンダ氏は、チェコ科学アカデミーのコンピューターサイエンス研究所の計算神経科学者です。 壊滅的な物忘れを防ぐのに役立つ新しい戦略が発見されました。スパイクニューラルネットワークは、睡眠のような段階を経た後、両方のタスクを実行することができ、研究者らは、その戦略が古いタスクと新しいタスクに関連するシナプスパターンを保存するのに役立ったと考えています。 「私たちの研究は、生物学にヒントを得たソリューション開発の実用性を実証しています」と Delanois 氏は述べています。 研究者らは、彼らの発見がスパイクニューラルネットワークに限定されないことに注目しています。サンダ氏は、今後の研究で、睡眠に似た段階が「標準的な人工ニューラルネットワークにおける壊滅的な物忘れの克服」に役立つ可能性があることが示されたと述べた。 この研究は、11 月 18 日に PLOS Computational Biology 誌に掲載されました。 論文: 「睡眠は、結合シナプスの重み表現を形成することで、スパイクニューラルネットワークにおける壊滅的な物忘れを防ぐ」 #論文アドレス: https://journals.plos.org/ploscompbiol/article?id=10.1371/journal.pcbi.1010628

以上がAIに普遍的な機能を持たせるにはどうすればよいでしょうか?新しい研究: 寝かせるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7366

7366

15

15

1628

1628

14

14

1353

1353

52

52

1266

1266

25

25

1214

1214

29

29

C言語関数の返品値の種類は何ですか? C言語関数の返品値のタイプの概要?

Apr 03, 2025 pm 11:18 PM

C言語関数の返品値の種類は何ですか? C言語関数の返品値のタイプの概要?

Apr 03, 2025 pm 11:18 PM

c言語関数の返品値タイプには、int、float、double、char、void、およびポインタータイプが含まれます。 intは整数を返すために使用され、フロートとダブルはフロートを返すために使用され、charは文字を返します。 voidとは、関数が値を返さないことを意味します。ポインタータイプはメモリアドレスを返し、メモリの漏れを避けるように注意してください。構造またはコンソーシアムは、複数の関連データを返すことができます。

C言語は0から始まります

Apr 03, 2025 pm 08:24 PM

C言語は0から始まります

Apr 03, 2025 pm 08:24 PM

C言語学習を始めるのは少し難しいかもしれませんが、正しい方法を習得した後、基本をすばやくマスターして徐々にマスターします。このガイドでは、基本から高度なトピックまで、C言語のコアコンセプトを学ぶために段階的にガイドします。ディレクトリC言語の基本とデータ型ユーザー入力条件式省略略語スイッチステートメントC言語配列ネストされたループC言語関数構造ポインターC言語の基本とデータ型Cプログラムは標準構造に従い、複数のデータ型を使用して変数を定義します。基本的なプログラム構造は次のとおりです。#includeintmain(){printf( "hello、world!"); ret

C言語関数の概念

Apr 03, 2025 pm 10:09 PM

C言語関数の概念

Apr 03, 2025 pm 10:09 PM

C言語関数は再利用可能なコードブロックです。彼らは入力を受け取り、操作を実行し、結果を返すことができます。これにより、再利用性が改善され、複雑さが軽減されます。関数の内部メカニズムには、パラメーターの渡し、関数の実行、および戻り値が含まれます。プロセス全体には、関数インラインなどの最適化が含まれます。単一の責任、少数のパラメーター、命名仕様、エラー処理の原則に従って、優れた関数が書かれています。関数と組み合わせたポインターは、外部変数値の変更など、より強力な関数を実現できます。関数ポインターは機能をパラメーターまたはストアアドレスとして渡し、機能への動的呼び出しを実装するために使用されます。機能機能とテクニックを理解することは、効率的で保守可能で、理解しやすいCプログラムを書くための鍵です。

Cプログラマー&#の未定義の行動ガイド

Apr 03, 2025 pm 07:57 PM

Cプログラマー&#の未定義の行動ガイド

Apr 03, 2025 pm 07:57 PM

Cプログラミングで未定義の動作を調査する:詳細なガイドこの記事では、Cプログラミングの未定義の動作に関する電子書籍を紹介します。これは、Cプログラミングの最も困難であまり知られていない側面のいくつかをカバーする合計12の章です。この本は、C言語の入門的な教科書ではありませんが、C言語プログラミングに精通している読者を対象としており、未定義の行動のさまざまな状況と潜在的な結果を探ります。著者Dmitrysviridkin、編集者アンドレイ・カーポフ。 6か月間の慎重な準備の後、この電子書籍はついに読者と会いました。印刷バージョンも将来発売されます。この本はもともと11の章を含めることが計画されていましたが、作成プロセス中にコンテンツは継続的に豊かになり、最終的に12の章に拡張されました。

c-subscript 3 subscript 5 c-subscript 3 subscript 5アルゴリズムチュートリアルを計算する方法

Apr 03, 2025 pm 10:33 PM

c-subscript 3 subscript 5 c-subscript 3 subscript 5アルゴリズムチュートリアルを計算する方法

Apr 03, 2025 pm 10:33 PM

C35の計算は、本質的に組み合わせ数学であり、5つの要素のうち3つから選択された組み合わせの数を表します。計算式はC53 = 5です! /(3! * 2!)。これは、ループで直接計算して効率を向上させ、オーバーフローを避けることができます。さらに、組み合わせの性質を理解し、効率的な計算方法をマスターすることは、確率統計、暗号化、アルゴリズム設計などの分野で多くの問題を解決するために重要です。

ユニークな共有ライブラリの問題

Apr 03, 2025 pm 08:00 PM

ユニークな共有ライブラリの問題

Apr 03, 2025 pm 08:00 PM

問題の説明最近、自己構築されたC言語共有ライブラリをローカルプロジェクトにリンクしようとしたときにリンクエラーが発生し、リンクエラーが発生し、「未定義の参照」を促しました。エラーメッセージは次のとおりです。/bin/ld:/tmp/cchb7mj8.o:infunction`sdl_main':main.c :(。

エクササイズC:簡単な電話帳申請書の構築

Apr 03, 2025 pm 08:15 PM

エクササイズC:簡単な電話帳申請書の構築

Apr 03, 2025 pm 08:15 PM

C言語プログラミングを学ぶための最良の方法の1つは、それを練習することです。この記事では、最近完了したプロジェクト、つまり簡単な電話帳アプリケーションを一歩踏み出します。このアプリは、Cのファイル処理と基本的なデータ管理を実証しているため、連絡先を追加、表示、削除できます。以下は完全なコードです。#include#include //関数宣言voidaddcontact(charname []、charnumber []); voidviewcontacts(); voiddeletecontact(c

cでオブジェクト指向?ゼロからインターフェイスを実装します

Apr 03, 2025 pm 08:21 PM

cでオブジェクト指向?ゼロからインターフェイスを実装します

Apr 03, 2025 pm 08:21 PM

この記事では、C言語でのオブジェクト指向プログラミングでインターフェイスの概念をシミュレートする方法について説明します。車両価格の計算を例として取り、それぞれJavaとC言語で実装し、2つの言語の違いを比較し、C。javaの実装でインターフェイスの基本関数を実装する方法を示します。サンプルコードは次のとおりです。InterfaceVehicle{intprice();} classCarimplementsVehicle {privateFinalIntSpeed; publi