拡散 + ターゲット検出 = 制御可能な画像生成!中国チームは物体の空間位置を完全に制御するGLIGENを提案した

Stable Diffusion のオープンソース化により、画像生成に自然言語を使用することが徐々に一般的になってきましたが、AI が手を描けない、動作関係を理解できない、表現が難しいなど、AIGC の多くの問題も明らかになりました。オブジェクトの位置を制御します。

主な理由は、「入力インターフェイス」が自然言語のみを備えており、 画面の細かい制御ができないためです。

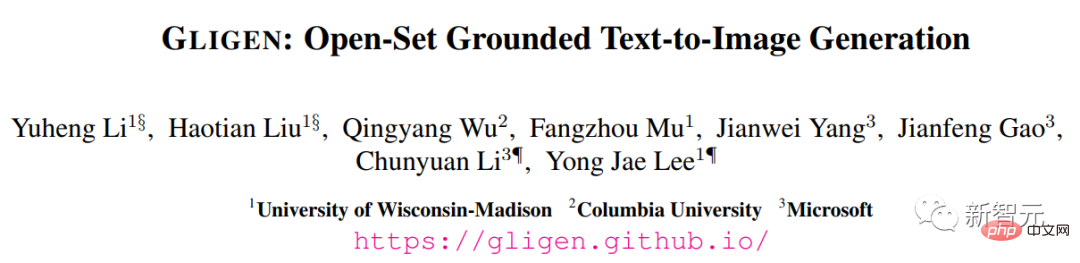

最近、ウィスコンシン大学マディソン校、コロンビア大学、マイクロソフトの研究ホットスポットが、既存の「事前トレーニング済み」を変換する条件として接地入力を使用するまったく新しい手法 GLIGEN を提案しました。 text to image」拡散モデルの機能が拡張されました。

# 論文リンク: https://arxiv.org/pdf/2301.07093.pdf

#プロジェクトのホームページ: https://gligen.github.io/#エクスペリエンスリンク: https://gligen.github.io/

## : //huggingface.co/spaces/gligen/demo

事前トレーニング済みモデルの大量の概念的知識を保持するために、研究者らは、このメカニズムは、オープンワールド画像生成の制御を実現するために、新しいトレーニング可能な層にさまざまな入力接地条件を注入します。

現在、GLIGEN は 4 つの入力をサポートしています。

(左上) テキスト エンティティ ボックス (右上) 画像エンティティ ボックス

(左下) 画像スタイル テキスト ボックス (右下) テキスト エンティティのキー ポイント

実験結果は、GLIGEN がCOCO および LVIS でのパフォーマンスが向上しています。ゼロショットのパフォーマンスは、現在の教師付きレイアウトから画像へのベースラインよりも大幅に優れています。

制御可能な画像生成拡散モデルが登場する前は、敵対的生成ネットワーク (GAN) が常に画像生成分野のリーダーであり、その潜在空間と条件付き「制御可能な動作」と「生成」の側面を徹底的に研究しました。

テキスト条件付き自己回帰モデルと拡散モデルは、より安定した学習目標とネットワークの画像とテキストのペアのデータへの大規模なアクセスのおかげで、驚くべき画質と概念範囲を示します。トレーニングしてすぐに抜け出すことができます。アートデザインと創作を支援するツールとして、サークルの一員として活動します。

しかし、既存の大規模なテキスト画像生成モデルは、「テキスト以外の」他の入力モードを条件とすることができず、正確な位置決めや参照画像を使用してテキスト画像を制御するという概念がありません。生成プロセス 能力は情報の表現を制限します。

たとえば、境界ボックス (境界

ボックス) やキーポイントを使用しながら、テキストを使用してオブジェクトの正確な位置を説明することは困難です。 (キーポイント)は簡単に実装できます。

修復、layout2img 生成などの一部の既存ツールはテキスト以外のモーダル入力を使用できますが、これらの入力が制御された text2img 生成のために結合されることはほとんどありません。

さらに、以前の生成モデルは通常、タスク固有のデータセットに基づいて独立してトレーニングされますが、画像認識の分野では、長年のパラダイムは「大規模な画像」から学習することです。データ」または「画像とテキストのペア」で事前トレーニングされた基本モデルを使用して、特定のタスク用のモデルの構築を開始します。

拡散モデルは、数十億の画像とテキストのペアでトレーニングされています。当然の疑問は、既存の事前トレーニングされた拡散モデルを基に構築できるか?、新しい条件付き入力モードを与えることができるか、ということです。

事前トレーニング済みモデルが持つ大量の概念的知識により、既存のテキスト画像生成よりも多くのデータを取得しながら、他の生成タスクでより良いパフォーマンスを達成できる可能性があります。モデルのコントロール。

GLIGEN上記の目的とアイデアに基づいて、研究者によって提案された GLIGEN モデルは入力としてテキスト タイトルを保持しますが、次のような他の入力モダリティも有効にします。グラウンディングのコンセプトとして バウンディングボックス、グラウンディング参考画像、そしてグラウンディング部分の要点。

###ここでの重要な問題は、新しい基礎情報を注入する方法を学習しながら、事前トレーニングされたモデルに大量の元の概念的知識を保持することです。

知識の忘却を防ぐために、研究者らは、元のモデルの重みをフリーズし、新しいグラウディング入力を吸収するために新しいトレーニング可能なゲート付きトランスフォーマー レイヤーを追加することを提案しました。以下では、例としてバウンディング ボックスを使用します。 。

コマンド入力

各下地テキスト エンティティは、左上隅と右下隅の座標値を含む境界ボックスとして表されます。

既存のlayout2img関連の作業には通常、概念辞書が必要であり、評価段階では近い集合エンティティ(COCOカテゴリなど)しか処理できないことに注意してください。画像の説明をエンコードするエンコーダは、トレーニング セット内の位置情報を他の概念に一般化できます。

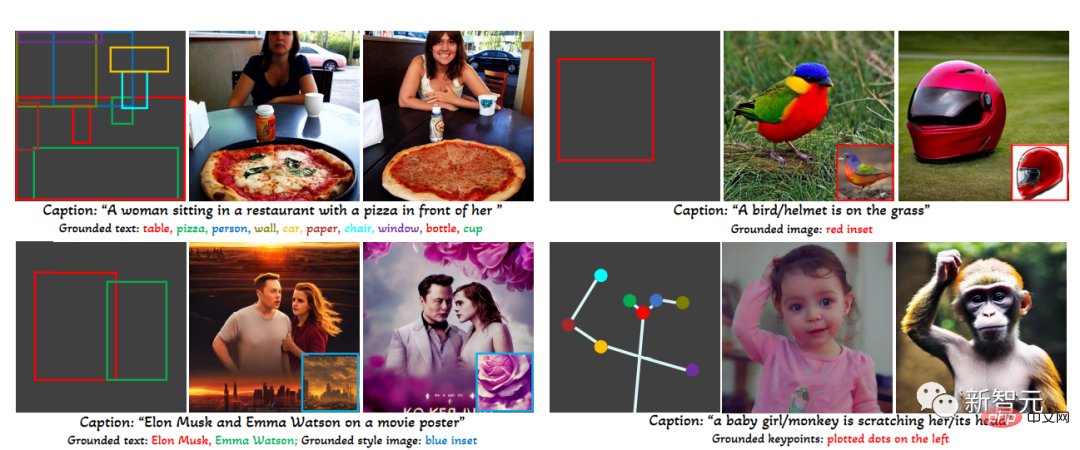

#トレーニング データ

# はグラウンディング画像の生成に使用されますトレーニング データには条件としてテキスト c と根拠となるエンティティ e が必要ですが、実際には、より柔軟な入力を考慮することでデータ要件を緩和できます。

#1 . グラウンディング データ

#各画像は、画像全体を説明するキャプションに関連付けられており、名詞エンティティはキャプションから抽出され、境界ボックスでラベル付けされます。名詞エンティティは自然言語のタイトルから直接取得されるため、より豊富な語彙をカバーでき、オープンワールド語彙の基礎生成に有益です。

2. 検出データ

名詞エンティティは、事前に定義された近接集合カテゴリです (たとえば、COCO では80 オブジェクト カテゴリ)、分類子なしガイドの空のタイトル トークンをタイトルとして使用することを選択します。検出データの量 (数百万レベル) は基礎データ (数千レベル) よりも大きいため、全体の学習データを大幅に増やすことができます。

3. 検出データとキャプション データ

名詞エンティティは検出データの名詞エンティティと同じです, 画像はテキスト タイトルのみで説明されていますが、名詞の実体がタイトルの実体と完全に一致していない場合があります。たとえば、タイトルではリビング ルームの大まかな説明のみが示され、シーン内のオブジェクトについては言及されていませんが、検出の注釈はオブジェクト レベルの詳細を提供します。

ゲート アテンション メカニズム

研究者 目標は、既存の大規模な言語画像生成モデルに新しい空間ベースの機能を与える#大規模な拡散モデルは、ネットワーク規模の画像テキストで事前にトレーニングされており、必要な知識を取得します。多様で複雑な言語命令に基づいてリアルな画像を合成します。事前トレーニングは費用がかかり、パフォーマンスも良好であるため、新しい機能を拡張しながら、この知識をモデルの重みに保持することが重要です。これは、新しいモジュールを適応させて新しい機能に対応させることで実現できます。時間。

実験では、サンプリング ステップの前半では完全なモデル (すべてのレイヤー) を使用し、後半では元のレイヤー (ゲート トランスフォーマー レイヤーなし) のみを使用することも証明されました。結果は接地状態をより正確に反映し、より高い画質を得ることができます。

実験部分

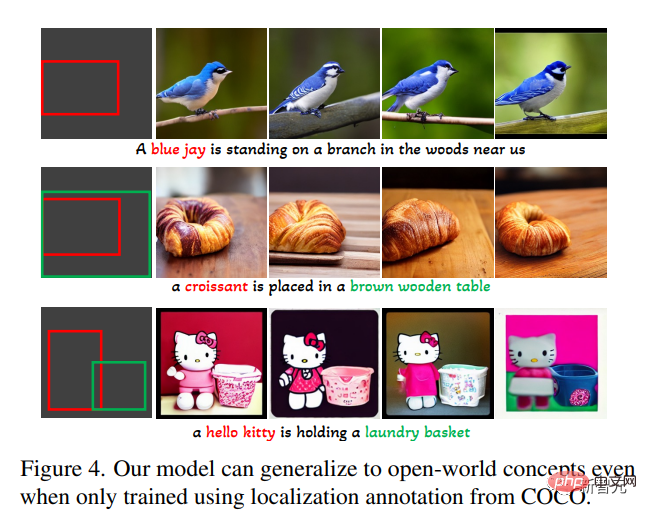

オープンセットのグラウンデッドテキストから画像への生成タスクでは、まずCOCO (COCO2014CD)の基本的なアノテーションのみをトレーニングに使用し、GLIGENがアノテーション以外の基本的なエンティティを生成できるかどうかを評価します。 COCOカテゴリーです。

GLIGEN は、「アオカケス」、「クロワッサン」、または新しい概念などの新しい概念を学習できることがわかります。 「茶色の木のテーブル」などのオブジェクト属性。この情報はトレーニング カテゴリには表示されません。

研究者らは、これは、GLIGEN のゲート型自己注意が、次の相互注意層のタイトル内の接地されたエンティティに対応する視覚的特徴を再配置することを学習し、一般化機能が得られたためであると考えています。これら 2 つのレイヤーの共有テキスト スペース。

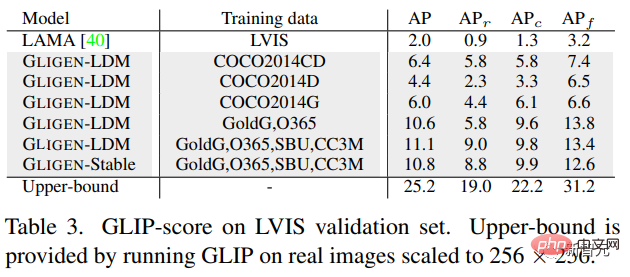

実験では、1203 個のロングテール オブジェクト カテゴリを含む LVIS 上でのこのモデルのゼロショット生成パフォーマンスも定量的に評価されました。 GLIP を使用して、生成された画像から境界ボックスを予測し、GLIP スコアという名前の AP を計算します。それを、layout2img タスク用に設計された最先端のモデル

# と比較します。

# と比較します。

##GLIGEN モデルは COCO アノテーションのみでトレーニングされていますが、教師ありベースラインよりもはるかに優れていることがわかります。これはおそらく、ゼロからトレーニングされたベースラインは学習から始めるのが難しいためです。注釈は限られていますが、GLIGEN モデルは事前トレーニングされたモデルの大量の概念的知識を利用できます。

この文書全体:

1. 新しい text2img 世代既存の text2img 拡散モデルに新しい接地制御性を与えるメソッドが提案されています;

2. 事前に訓練された重みを保持し、学習により新しい位置レイヤーを徐々に統合することで、モデルは次のことを実現しますオープンワールドのグラウンディングされた text2img 生成とバウンディング ボックス入力、つまり、トレーニングでは観察されなかった新しい位置決め概念が統合されています;3.layout2img タスクにおけるこのモデルのゼロショット パフォーマンス以前の最先端レベルよりも大幅に優れており、大規模な事前トレーニング済み生成モデルが下流タスクのパフォーマンスを向上させることができることを証明しています

以上が拡散 + ターゲット検出 = 制御可能な画像生成!中国チームは物体の空間位置を完全に制御するGLIGENを提案したの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7681

7681

15

15

1639

1639

14

14

1393

1393

52

52

1286

1286

25

25

1229

1229

29

29

Windows 11でデスクトップの背景の最近の画像履歴をクリアする方法

Apr 14, 2023 pm 01:37 PM

Windows 11でデスクトップの背景の最近の画像履歴をクリアする方法

Apr 14, 2023 pm 01:37 PM

<p>Windows 11 ではシステムの個人設定が改善され、ユーザーが以前に行ったデスクトップの背景の変更の最近の履歴を表示できるようになりました。 Windows システム設定アプリケーションの個人設定セクションに入ると、さまざまなオプションが表示されます。背景の壁紙の変更もその 1 つです。ただし、システムに設定されている背景壁紙の最新の履歴を確認できるようになりました。これを見るのが嫌で、この最近の履歴を消去または削除したい場合は、この記事を読み続けてください。レジストリ エディターを使用してこれを行う方法の詳細を学ぶのに役立ちます。 </p><h2>レジストリ編集の使用方法

i7-7700 が Windows 11 にアップグレードできない場合の解決策

Dec 26, 2023 pm 06:52 PM

i7-7700 が Windows 11 にアップグレードできない場合の解決策

Dec 26, 2023 pm 06:52 PM

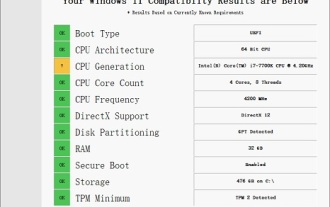

i77700 のパフォーマンスは win11 を実行するのに完全に十分ですが、ユーザーは i77700 を win11 にアップグレードできないことがわかります。これは主に Microsoft によって課された制限が原因であるため、この制限をスキップする限りインストールできます。 i77700 は win11 にアップグレードできません: 1. Microsoft が CPU バージョンを制限しているためです。 2. win11 に直接アップグレードできるのは、Intel の第 8 世代以降のバージョンのみです 3. i77700 は第 7 世代として、win11 のアップグレードのニーズを満たすことができません。 4. ただし、i77700はパフォーマンス的にはwin11を快適に使用するのに完全に可能です。 5. したがって、このサイトの win11 直接インストール システムを使用できます。 6. ダウンロードが完了したら、ファイルを右クリックして「ロード」します。 7. ダブルクリックして「ワンクリック」を実行します。

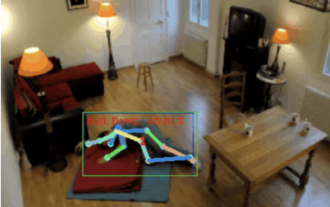

転倒検知、骨格点人間動作認識に基づき、コードの一部はChatgptで完成

Apr 12, 2023 am 08:19 AM

転倒検知、骨格点人間動作認識に基づき、コードの一部はChatgptで完成

Apr 12, 2023 am 08:19 AM

こんにちは、みんな。今日は転倒検知プロジェクトについてお話ししたいと思います。正確に言うと、骨格点に基づく人間の動作認識です。大きく3つのステップに分かれています:人体認識、人体骨格点動作分類プロジェクトのソースコードがパッケージ化されています。入手方法については記事の最後を参照してください。 0. chatgpt まず、監視対象のビデオ ストリームを取得する必要があります。このコードは比較的固定されており、chatgpt で記述したコードを直接 chatgpt に完成させることができますが、問題なくそのまま使用できます。しかし、後のビジネス タスク (メディアパイプを使用して人間のスケルトン ポイントを特定するなど) になると、chatgpt によって指定されたコードは正しくありません。 chatgpt はビジネスロジックから独立したツールボックスとして使用できると思います。

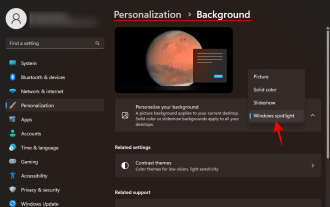

Windows スポットライトの壁紙画像を PC にダウンロードする方法

Aug 23, 2023 pm 02:06 PM

Windows スポットライトの壁紙画像を PC にダウンロードする方法

Aug 23, 2023 pm 02:06 PM

窓は決して美観を無視するものではありません。 XP の牧歌的な緑の野原から Windows 11 の青い渦巻くデザインに至るまで、デフォルトのデスクトップの壁紙は長年にわたってユーザーの喜びの源でした。 Windows スポットライトを使用すると、ロック画面やデスクトップの壁紙に使用する美しく荘厳な画像に毎日直接アクセスできるようになります。残念ながら、これらの画像は表示されません。 Windows スポットライト画像の 1 つが気に入った場合は、その画像をダウンロードして、しばらく背景として保存できるようにする方法を知りたいと思うでしょう。知っておくべきことはすべてここにあります。 Windowsスポットライトとは何ですか? Window Spotlight は、設定アプリの [個人設定] > から利用できる自動壁紙アップデーターです。

Python で画像セマンティック セグメンテーション テクノロジを使用するにはどうすればよいですか?

Jun 06, 2023 am 08:03 AM

Python で画像セマンティック セグメンテーション テクノロジを使用するにはどうすればよいですか?

Jun 06, 2023 am 08:03 AM

人工知能技術の継続的な発展に伴い、画像セマンティックセグメンテーション技術は画像分析分野で人気の研究方向となっています。画像セマンティック セグメンテーションでは、画像内のさまざまな領域をセグメント化し、各領域を分類して、画像の包括的な理解を実現します。 Python はよく知られたプログラミング言語であり、その強力なデータ分析機能とデータ視覚化機能により、人工知能技術研究の分野で最初に選択されます。この記事では、Python で画像セマンティック セグメンテーション技術を使用する方法を紹介します。 1. 前提知識が深まる

MIT の最新傑作: GPT-3.5 を使用して時系列異常検出の問題を解決する

Jun 08, 2024 pm 06:09 PM

MIT の最新傑作: GPT-3.5 を使用して時系列異常検出の問題を解決する

Jun 08, 2024 pm 06:09 PM

今日は、MIT が先週公開した記事を紹介します。GPT-3.5-turbo を使用して時系列異常検出の問題を解決し、時系列異常検出における LLM の有効性を最初に検証しました。プロセス全体に微調整はなく、GPT-3.5-turbo は異常検出に直接使用されます。この記事の核心は、時系列を GPT-3.5-turbo が認識できる入力に変換する方法とその設計方法です。 LLM が異常検出タスクを解決できるようにするためのプロンプトまたはパイプライン。この作品について詳しく紹介していきます。画像用紙タイトル:Large languagemodelscanbeゼロショタノマリデテ

iOS 17: 写真でワンクリックトリミングを使用する方法

Sep 20, 2023 pm 08:45 PM

iOS 17: 写真でワンクリックトリミングを使用する方法

Sep 20, 2023 pm 08:45 PM

iOS 17 の写真アプリを使用すると、Apple は写真を仕様に合わせて簡単にトリミングできるようになります。その方法については、読み続けてください。以前の iOS 16 では、写真アプリで画像をトリミングするにはいくつかの手順が必要でした。編集インターフェイスをタップし、トリミング ツールを選択し、ピンチでズームするジェスチャまたはトリミング ツールの角をドラッグしてトリミングを調整します。 iOS 17 では、Apple がありがたいことにこのプロセスを簡素化し、写真ライブラリで選択した写真を拡大すると、画面の右上隅に新しい切り抜きボタンが自動的に表示されるようになりました。クリックすると、選択したズームレベルで完全なトリミングインターフェイスが表示されるので、画像の好きな部分をトリミングしたり、画像を回転したり、画像を反転したり、画面比率を適用したり、マーカーを使用したりできます。

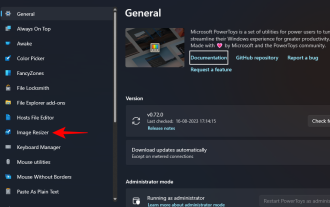

Windows で PowerToys を使用して画像のサイズを一括変更する方法

Aug 23, 2023 pm 07:49 PM

Windows で PowerToys を使用して画像のサイズを一括変更する方法

Aug 23, 2023 pm 07:49 PM

日常的に画像ファイルを扱う必要がある人は、プロジェクトや仕事のニーズに合わせて画像ファイルのサイズを変更する必要があることがよくあります。ただし、処理する画像が多すぎる場合、画像を個別にサイズ変更すると、多くの時間と労力がかかる可能性があります。この場合、PowerToys のようなツールは、画像サイズ変更ユーティリティを使用して画像ファイルのサイズをバッチで変更するのに役立ちます。 Image Resizer 設定をセットアップし、PowerToys を使用して画像のバッチ サイズ変更を開始する方法は次のとおりです。 PowerToys を使用して画像のサイズをバッチ変更する方法 PowerToys は、日常業務のスピードアップに役立つさまざまなユーティリティと機能を備えたオールインワン プログラムです。そのユーティリティの 1 つは画像です